Jak provést AI audit viditelnosti: Kompletní metodika

Naučte se kompletní metodiku krok za krokem pro provedení AI auditu viditelnosti. Zjistěte, jak měřit zmínky o značce, citace a viditelnost napříč ChatGPT, Perp...

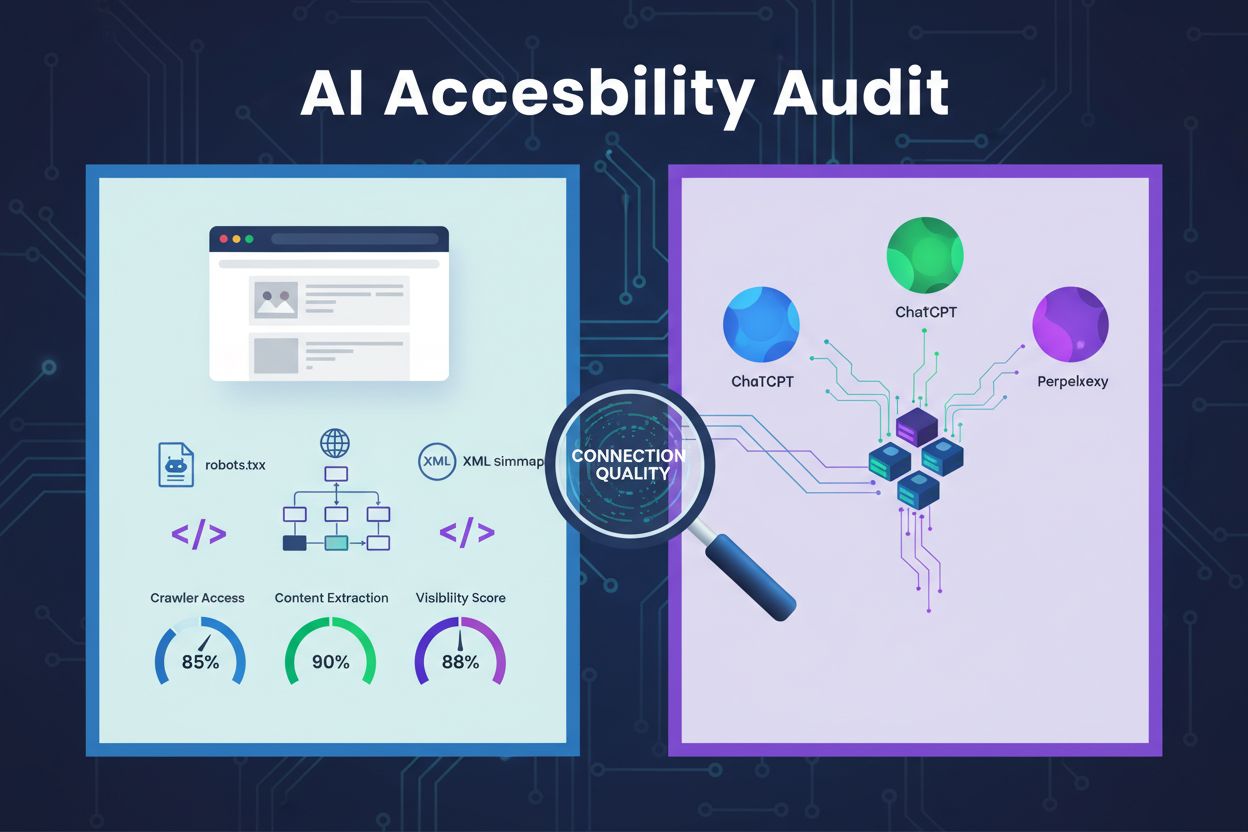

Technická revize architektury webu, konfigurace a struktury obsahu za účelem zjištění, zda AI roboti mohou efektivně přistupovat k obsahu, rozumět mu a extrahovat jej. Hodnotí konfiguraci robots.txt, XML sitemap, prolezitelnost webu, vykreslování JavaScriptu a schopnost extrakce obsahu, aby bylo zajištěno zviditelnění na AI-poháněných vyhledávacích platformách jako ChatGPT, Claude a Perplexity.

Technická revize architektury webu, konfigurace a struktury obsahu za účelem zjištění, zda AI roboti mohou efektivně přistupovat k obsahu, rozumět mu a extrahovat jej. Hodnotí konfiguraci robots.txt, XML sitemap, prolezitelnost webu, vykreslování JavaScriptu a schopnost extrakce obsahu, aby bylo zajištěno zviditelnění na AI-poháněných vyhledávacích platformách jako ChatGPT, Claude a Perplexity.

Audit přístupnosti pro AI je technická revize architektury vašeho webu, konfigurace a struktury obsahu za účelem zjištění, zda AI roboti mohou efektivně přistupovat k vašemu obsahu, rozumět mu a extrahovat jej. Na rozdíl od tradičních SEO auditů, které se zaměřují na pozice klíčových slov a zpětné odkazy, audity přístupnosti pro AI zkoumají technické základy, které umožňují systémům jako ChatGPT, Claude a Perplexity objevovat a citovat váš obsah. Tento audit hodnotí klíčové součásti včetně konfigurace robots.txt, XML sitemap, prolezitelnosti webu, vykreslování JavaScriptu a schopnosti extrakce obsahu, aby byl váš web plně viditelný v AI-poháněném vyhledávacím ekosystému.

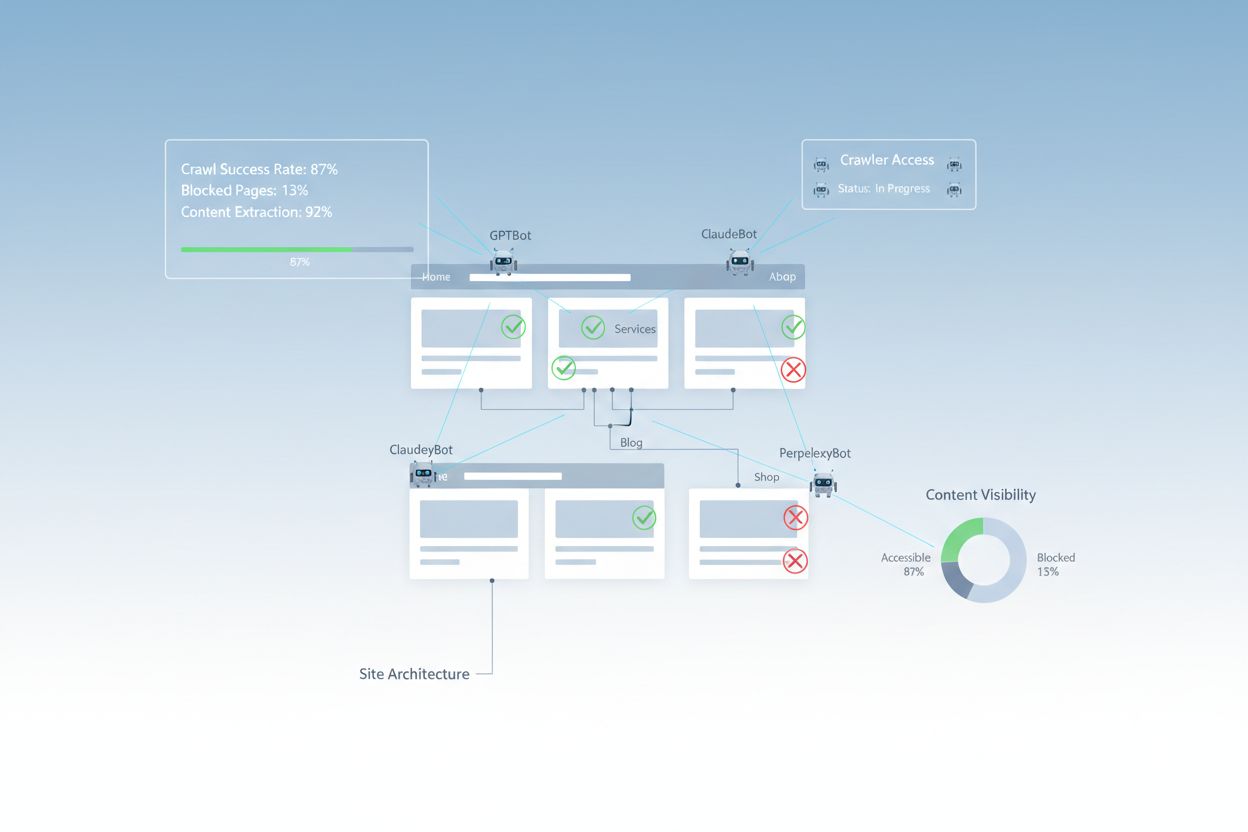

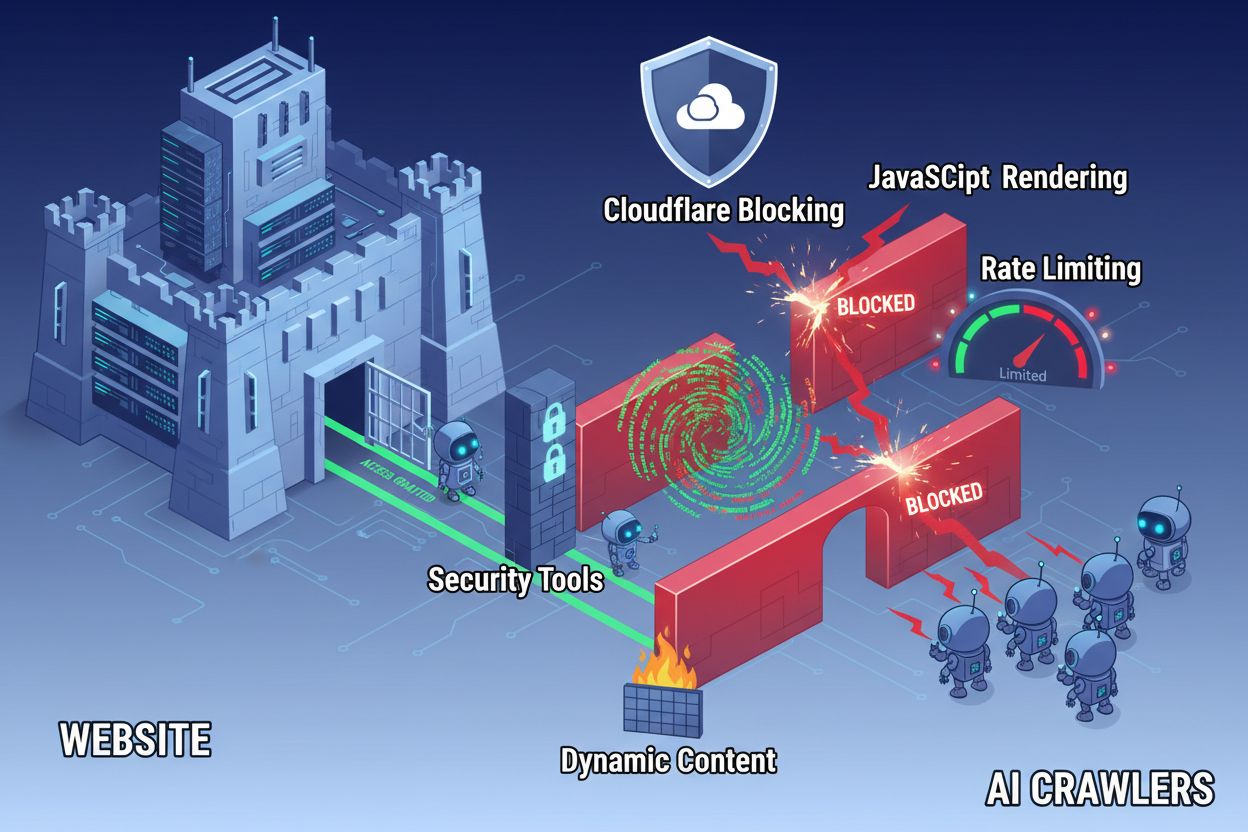

Navzdory pokroku v webových technologiích čelí AI roboti významným překážkám při pokusu o přístup k moderním webům. Hlavní problém spočívá v tom, že mnoho současných webů silně spoléhá na vykreslování JavaScriptu k dynamickému zobrazování obsahu, ale většina AI robotů neumí JavaScript spouštět. To znamená, že přibližně 60–90 % obsahu moderních webů zůstává pro AI systémy neviditelné, přestože se v prohlížečích uživatelů zobrazuje bez problémů. Navíc bezpečnostní nástroje jako Cloudflare blokují AI roboty ve výchozím nastavení a považují je za potenciální hrozby místo legitimních indexovacích robotů. Výzkumy ukazují, že 35 % podnikových webů nechtěně blokuje AI roboty, což znemožňuje objevení a citování hodnotného obsahu AI systémy.

Běžné překážky bránící přístupu AI robotů:

Komplexní audit přístupnosti pro AI zkoumá více technických a strukturálních prvků ovlivňujících interakci AI systémů s vaším webem. Každá součást má specifickou roli při určování, zda se váš obsah stane viditelným pro AI-poháněné vyhledávací platformy. Auditní proces zahrnuje testování prolezitelnosti, ověření konfiguračních souborů, posouzení struktury obsahu a sledování skutečného chování robotů. Systematickým vyhodnocením těchto komponent můžete identifikovat konkrétní překážky a zavést cílená řešení pro zlepšení své AI viditelnosti.

| Součást | Účel | Dopad na AI viditelnost |

|---|---|---|

| Konfigurace robots.txt | Řídí, které roboty mohou přistupovat k vybraným sekcím webu | Kritický – Špatná konfigurace zcela blokuje AI roboty |

| XML sitemapy | Navigují roboty k důležitým stránkám a struktuře obsahu | Vysoký – Pomáhá AI systémům upřednostnit a objevit obsah |

| Prolezitelnost webu | Zajišťuje přístupnost stránek bez přihlašování či složité navigace | Kritický – Blokované stránky jsou pro AI systémy neviditelné |

| Vykreslování JavaScriptu | Určuje, zda je dynamický obsah viditelný pro roboty | Kritický – Bez prerenderingu může být přehlédnuto 60–90 % obsahu |

| Extrakce obsahu | Hodnotí, jak snadno mohou AI systémy obsah číst a chápat | Vysoký – Špatná struktura snižuje pravděpodobnost citace |

| Konfigurace bezpečnostních nástrojů | Spravuje pravidla firewallu a ochrany ovlivňující přístup robotů | Kritický – Příliš restriktivní pravidla blokují legitimní AI roboty |

| Implementace schema markup | Poskytuje strojově čitelný kontext o obsahu | Střední – Zlepšuje pochopení a pravděpodobnost citace AI |

| Struktura interního prolinkování | Vytváří sémantické vztahy mezi stránkami | Střední – Pomáhá AI chápat autoritu a relevanci témat |

Váš soubor robots.txt je hlavním nástrojem pro řízení toho, kteří roboti mohou přistupovat na váš web. Umístěný v kořenovém adresáři domény obsahuje jednoduché textové direktivy určující, zda mají roboti povolení přistupovat do specifických sekcí webu. Pro přístupnost vůči AI je správné nastavení robots.txt zásadní, protože chybná pravidla mohou zcela zablokovat hlavní AI roboty jako GPTBot (OpenAI), ClaudeBot (Anthropic) a PerplexityBot (Perplexity). Klíčem je explicitně povolit tyto roboty při zachování bezpečnosti blokováním škodlivých botů a chráněných oblastí.

Příklad konfigurace robots.txt pro AI roboty:

# Povolení všech AI robotů

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Blokace citlivých oblastí

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemapy

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

Tato konfigurace explicitně povoluje hlavní AI roboty k přístupu k vašemu veřejnému obsahu a zároveň chrání administrativní a privátní sekce. Direktivy Sitemap pomáhají robotům efektivně najít vaše nejdůležitější stránky.

XML sitemap funguje jako mapa pro roboty, která uvádí URL, jež chcete indexovat, a poskytuje metadata ke každé stránce. Pro AI systémy jsou sitemapy zvláště hodnotné, protože pomáhají pochopit strukturu webu, upřednostnit důležitý obsah a objevit stránky, jež by jinak mohly být přehlédnuty běžným procházením. Na rozdíl od tradičních vyhledávačů, které mohou strukturu webu odvodit z odkazů, AI roboti značně těží z explicitního návodu, které stránky jsou klíčové. Dobře strukturovaná sitemap s vhodnými metadaty zvyšuje pravděpodobnost, že váš obsah bude objeven, pochopen a citován AI systémy.

Příklad struktury XML sitemap pro optimalizaci pro AI:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Vysoce prioritní obsah pro AI roboty -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

Atribut priority signalizuje AI robotům, které stránky jsou nejdůležitější, zatímco lastmod ukazuje aktuálnost obsahu. To pomáhá AI systémům efektivně rozdělit crawl kapacity a pochopit hierarchii obsahu.

Kromě konfiguračních souborů mohou přístupu AI robotů bránit i další technické překážky. Vykreslování JavaScriptu zůstává nejzásadnějším problémem, protože moderní webové frameworky jako React, Vue a Angular vykreslují obsah dynamicky až v prohlížeči, takže AI roboti často vidí prázdné HTML. Cloudflare a podobné bezpečnostní nástroje navíc často AI roboty blokují ve výchozím nastavení, protože jejich vyšší počet požadavků vnímají jako potenciální útok. Omezení rychlosti může znemožnit kompletní indexaci, zatímco složitá architektura webu a dynamické načítání obsahu dále komplikují přístup robotů. Naštěstí existuje řada řešení, jak tyto bariéry překonat.

Řešení pro zlepšení přístupu AI robotů:

AI systémy potřebují váš obsah nejen zpřístupnit, ale také mu porozumět. Extrakce obsahu označuje schopnost AI robotů efektivně číst, chápat a získávat smysluplné informace z vašich stránek. Tento proces výrazně závisí na sémantické HTML struktuře, tedy na správné hierarchii nadpisů, popisných textech a logickém uspořádání. Pokud je váš obsah dobře strukturovaný s jasnými nadpisy (H1, H2, H3), popisnými odstavci a logickým tokem, AI systémy snáze identifikují klíčové informace a pochopí kontext. Navíc schema markup poskytuje strojově čitelná metadata, která AI systémům explicitně sdělují, o čem váš obsah je, což výrazně zvyšuje šanci na pochopení a citaci.

Sémantická struktura také zahrnuje použití sémantických HTML prvků jako <article>, <section>, <nav> a <aside> místo obecných <div> tagů. To AI systémům pomáhá pochopit účel a důležitost jednotlivých částí obsahu. V kombinaci se strukturovanými daty jako FAQ schema, Product schema nebo Organization schema se váš obsah stává pro AI systémy výrazně přístupnějším a zvyšuje se pravděpodobnost zobrazení v AI-generovaných odpovědích.

Po implementaci vylepšení je potřeba ověřit, zda AI roboti skutečně mohou přistupovat k vašemu obsahu, a průběžně sledovat vývoj. Serverové logy dávají přímý důkaz o aktivitě robotů, ukazují, kteří roboti váš web navštívili, jaké stránky si stáhli a zda narazili na chyby. Google Search Console poskytuje přehled o tom, jak roboti Google interagují s vaším webem, zatímco specializované nástroje pro sledování AI viditelnosti monitorují, jak se váš obsah objevuje na různých AI platformách. AmICited.com konkrétně sleduje, jak AI systémy zmiňují vaši značku napříč ChatGPT, Perplexity i Google AI Overviews a dává přehled o tom, které stránky jsou citovány a jak často.

Nástroje a metody pro monitorování přístupu AI robotů:

Optimalizace webu pro přístup AI robotů vyžaduje strategický a průběžný přístup. Místo jednorázového projektu úspěšné organizace zavádějí kontinuální monitoring a procesy vylepšování. Nejefektivnější strategie kombinuje správnou technickou konfiguraci s optimalizací obsahu, aby byla připravena infrastruktura i samotný obsah.

Co dělat pro AI přístupnost:

Čemu se vyhnout při AI přístupnosti:

Nejúspěšnější strategie přístupnosti pro AI vnímá roboty jako partnery v distribuci obsahu, nikoliv jako hrozbu k blokování. Pokud je váš web technicky v pořádku, správně nakonfigurován a sémanticky jasný, maximalizujete pravděpodobnost, že AI systémy váš obsah objeví, pochopí a citují ve svých odpovědích uživatelům.

Audity přístupnosti pro AI se zaměřují na sémantickou strukturu, strojově čitelný obsah a vhodnost pro citace v AI systémech, zatímco tradiční SEO audity kladou důraz na klíčová slova, zpětné odkazy a pozice ve vyhledávačích. AI audity zkoumají, zda roboti mohou přistupovat k vašemu obsahu a rozumět mu, zatímco SEO audity se zaměřují na faktory ovlivňující pozice ve vyhledávání Google.

Zkontrolujte serverové logy na uživatelské agenty AI robotů jako GPTBot, ClaudeBot a PerplexityBot. Použijte Google Search Console ke sledování aktivity robotů, otestujte soubor robots.txt validačními nástroji a využijte specializované platformy jako AmICited ke sledování, jak AI systémy zmiňují váš obsah napříč různými platformami.

Nejčastějšími překážkami jsou omezení vykreslování JavaScriptu (AI roboti neumí spouštět JavaScript), blokování nástroji jako Cloudflare a bezpečnostními řešeními (35 % firemních webů blokuje AI roboty), omezení rychlosti, které brání důkladné indexaci, složitá architektura webu a dynamické načítání obsahu. Každá překážka vyžaduje jiné řešení.

Většina firem těží z povolení AI robotů, protože zvyšují viditelnost značky ve výsledcích vyhledávání poháněných AI a konverzačních rozhraních. Rozhodnutí ale závisí na vaší obsahové strategii, konkurenčním postavení a obchodních cílech. Pomocí robots.txt můžete selektivně povolit určité roboty a jiné zablokovat dle konkrétních potřeb.

Provádějte komplexní audit čtvrtletně nebo pokaždé, když výrazně změníte architekturu webu, obsahovou strategii či bezpečnostní nastavení. Průběžně sledujte aktivitu robotů pomocí serverových logů a specializovaných nástrojů. Aktualizujte robots.txt a sitemapy pokaždé, když spustíte nové části obsahu nebo změníte strukturu URL.

Robots.txt je hlavní mechanismus pro řízení přístupu AI robotů. Správná konfigurace explicitně povoluje hlavní AI roboty (GPTBot, ClaudeBot, PerplexityBot) a zároveň chrání citlivé oblasti. Špatně nastavený robots.txt může AI roboty zcela zablokovat, takže váš obsah bude pro AI systémy neviditelný bez ohledu na jeho kvalitu.

I když je technická optimalizace důležitá, AI viditelnost lze zvýšit i optimalizací obsahu – použitím sémantické HTML struktury, implementací schema markup, zlepšením interního prolinkování a zajištěním úplnosti obsahu. Technické bariéry jako vykreslování JavaScriptu a blokace bezpečnostními nástroji však obvykle vyžadují technická řešení pro plnou přístupnost pro AI.

Použijte analýzu serverových logů ke sledování aktivity robotů, Google Search Console pro statistiky procházení, validátory robots.txt pro ověření konfigurace, validátory schema markup pro strukturovaná data a specializované platformy jako AmICited ke sledování AI citací. Mnoho SEO nástrojů jako Screaming Frog nabízí také simulaci robotů pro testování přístupnosti pro AI.

Sledujte, jak ChatGPT, Perplexity, Google AI Overviews a další AI systémy zmiňují vaši značku s AmICited. Získejte aktuální přehled o své viditelnosti ve vyhledávání AI a optimalizujte svoji obsahovou strategii.

Naučte se kompletní metodiku krok za krokem pro provedení AI auditu viditelnosti. Zjistěte, jak měřit zmínky o značce, citace a viditelnost napříč ChatGPT, Perp...

Zjistěte, co je AI audit obsahu, jak se liší od tradičních auditů obsahu a proč je sledování přítomnosti vaší značky v AI vyhledávačích jako ChatGPT a Perplexit...

Zjistěte, jak provést audit přístupu AI crawlerů na váš web. Zjistěte, které boty vidí váš obsah a opravte blokace, které brání AI viditelnosti v ChatGPT, Perpl...