Jak nakonfigurovat robots.txt pro AI crawlery: Kompletní průvodce

Naučte se, jak nakonfigurovat robots.txt pro kontrolu přístupu AI crawlerů včetně GPTBot, ClaudeBot a Perplexity. Spravujte viditelnost své značky v odpovědích ...

Konfigurace robots.txt s pravidly user-agent specificky cílenými na AI crawlery. AI-specifický robots.txt umožňuje majitelům webových stránek kontrolovat, jak systémy umělé inteligence, velké jazykové modely a AI tréninkové boty přistupují a používají jejich obsah. Rozlišuje mezi různými typy AI crawlerů - tréninkovými crawlery, vyhledávacími crawlery a uživatelem spuštěnými fetchery - umožňujíc granulární kontrolu nad viditelností obsahu pro AI systémy. Tato konfigurace se stala kritickou, protože AI crawlery nyní tvoří přibližně 80 % botového provozu na mnoha webech.

Konfigurace robots.txt s pravidly user-agent specificky cílenými na AI crawlery. AI-specifický robots.txt umožňuje majitelům webových stránek kontrolovat, jak systémy umělé inteligence, velké jazykové modely a AI tréninkové boty přistupují a používají jejich obsah. Rozlišuje mezi různými typy AI crawlerů - tréninkovými crawlery, vyhledávacími crawlery a uživatelem spuštěnými fetchery - umožňujíc granulární kontrolu nad viditelností obsahu pro AI systémy. Tato konfigurace se stala kritickou, protože AI crawlery nyní tvoří přibližně 80 % botového provozu na mnoha webech.

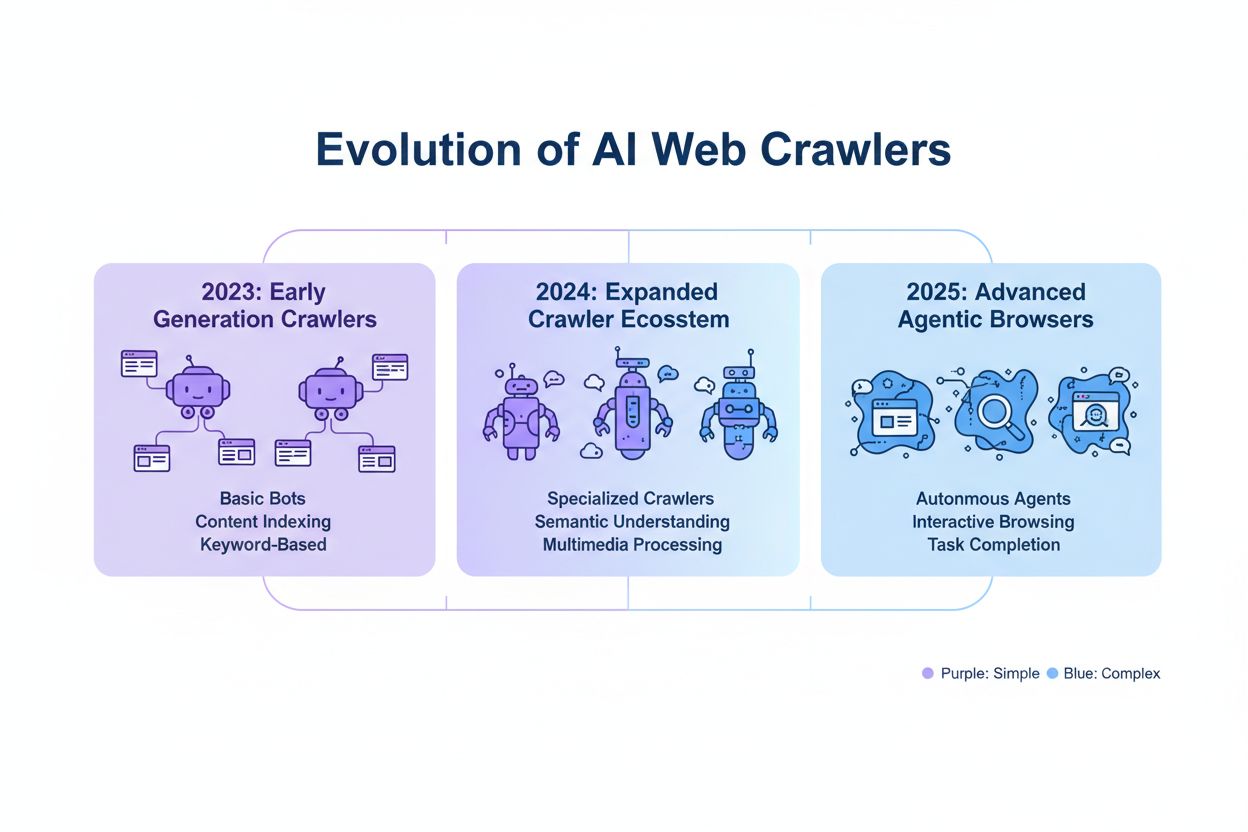

AI-specifická konfigurace robots.txt odkazuje na praxi vytváření cílených pravidel v souboru robots.txt specificky adresujících crawlery a tréninkové boty umělé inteligence, odlišně od tradičních crawlerů vyhledávačů jako Googlebot. Zatímco konvenční robots.txt se historicky zaměřoval na správu Googlebot, Bingbot a dalších vyhledávacích indexerů, vznik velkých jazykových modelů a AI tréninkových systémů vytvořil zcela novou kategorii botového provozu vyžadující oddělené strategie správy. Podle nedávných dat z listopadu 2025 AI crawlery nyní tvoří přibližně 80 % veškerého botového provozu na mnoha vydavatelských webech.

AI crawlery spadají do tří odlišných operačních kategorií, každá s různými charakteristikami, dopady na provoz a strategickými úvahami pro vydavatele. Tréninkové crawlery jsou navrženy ke sběru velkých objemů textových dat pro vývoj modelů strojového učení; typicky operují s vysokými požadavky na šířku pásma, generují významnou zátěž serveru a neposkytují žádný referenční provoz na oplátku. Vyhledávací a citační crawlery fungují podobně jako tradiční vyhledávače indexováním obsahu pro vyhledávání a poskytováním atribuce. Uživatelem spuštěné crawlery operují na vyžádání, když koncoví uživatelé explicitně požadují AI analýzu webové stránky.

| Kategorie crawleru | Účel | Objem provozu | Potenciál referralu | Riziko obsahu | Příklady |

|---|---|---|---|---|---|

| Tréninkový | Vývoj modelu | Velmi vysoký | Žádný | Velmi vysoké | GPTBot, ClaudeBot |

| Vyhledávací/Citační | Indexování obsahu a atribuce | Střední | Střední | Střední | OAI-SearchBot, Google AI |

| Uživatelem spuštěný | Analýza na vyžádání | Nízký | Nízký | Nízký | ChatGPT Web Browse, Claude |

Hlavní AI společnosti provozující crawlery zahrnují OpenAI, Anthropic, Google, Meta, Apple a Amazon, každá s odlišnými user-agent řetězci umožňujícími identifikaci v serverových logách a konfiguraci robots.txt. OpenAI provozuje více crawlerů: GPTBot (user-agent: GPTBot/1.0) pro sběr trénovacích dat, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) pro indexování vyhledávání a citací a ChatGPT-User (user-agent: ChatGPT-User/1.0) pro uživatelem spuštěné webové prohlížení.

Základní syntaxe pro AI-specifická pravidla robots.txt následuje standardní formát robots.txt s párováním user-agent a direktivami allow/disallow cílenými na specifické crawlery. Pro blokování GPTBot od OpenAI ze sběru trénovacích dat a zároveň povolení jejich vyhledávacího crawleru strukturujte robots.txt takto:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Pro granulární kontrolu můžete aplikovat pravidla specifická pro cestu, která blokují určité sekce a zároveň povolují jiné.

Rozhodnutí blokovat nebo povolit AI crawlery zahrnuje fundamentální kompromisy mezi ochranou obsahu a viditelností, které se významně liší na základě vašeho obchodního modelu a obsahové strategie. Blokování tréninkových crawlerů jako GPTBot zcela eliminuje riziko, že váš obsah bude použit k trénování proprietárních AI modelů bez kompenzace, ale také znamená, že se váš obsah neobjeví v AI-generovaných odpovědích.

Zatímco robots.txt poskytuje jasný mechanismus pro komunikaci politik crawlování, je fundamentálně doporučující a právně nevymahatelný. IP ověření a allowlisting představuje nejspolehlivější metodu vynucení. Pravidla firewallu a blokování na úrovni serveru poskytují nejsilnější mechanismus vynucení.

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Implementace efektivní AI-specifické konfigurace robots.txt vyžaduje komplexní přístup vyvažující ochranu obsahu s cíli strategické viditelnosti. Začněte s jasnou politikou ochrany obsahu definující, které kategorie obsahu vyžadují blokování versus které mohou být bezpečně vystaveny AI crawlerům. Implementujte vrstvenou blokovací strategii rozlišující mezi tréninkovými crawlery (typicky blokovat), vyhledávacími crawlery (typicky povolit s monitoringem) a uživatelem spuštěnými crawlery (typicky povolit). Kombinujte robots.txt s vynucením na úrovni serveru implementací pravidel firewallu a IP ověření pro váš nejcitlivější obsah. Používejte nástroje jako AmICited.com k monitorování viditelnosti vašeho obsahu napříč AI systémy a pochopení dopadu vašich blokovacích rozhodnutí na AI objevování a citace.

Tréninkové crawlery jako GPTBot a ClaudeBot sbírají data pro vývoj modelů a neposkytují žádný referenční provoz, což z nich činí vysoce rizikové pro ochranu obsahu. Vyhledávací crawlery jako OAI-SearchBot a PerplexityBot indexují obsah pro AI-poháněné vyhledávání a mohou posílat referenční provoz prostřednictvím citací. Většina vydavatelů blokuje tréninkové crawlery a zároveň povoluje vyhledávací crawlery k vyvážení ochrany obsahu a viditelnosti.

Google oficiálně uvádí, že blokování Google-Extended neovlivňuje pozice ve vyhledávání ani zahrnutí do AI Overviews. Nicméně někteří webmasteři hlásili obavy, proto po implementaci blokování sledujte výkon vyhledávání. AI Overviews v Google Search se řídí standardními pravidly Googlebot, nikoliv Google-Extended.

Ano, robots.txt je doporučující standard, nikoliv vymahatelný. Slušně se chovající crawlery od hlavních společností obecně respektují direktivy robots.txt, ale některé crawlery je ignorují. Pro silnější ochranu implementujte blokování na úrovni serveru prostřednictvím .htaccess nebo pravidel firewallu a ověřujte legitimní crawlery pomocí publikovaných rozsahů IP adres.

Přezkoumejte a aktualizujte svůj blocklist minimálně čtvrtletně. Nové AI crawlery se pravidelně objevují, proto měsíčně kontrolujte serverové logy k identifikaci nových crawlerů navštěvujících váš web. Sledujte komunitní zdroje jako projekt ai.robots.txt na GitHubu pro aktualizace o vznikajících crawlerech a user-agent řetězcích.

To závisí na vašich obchodních prioritách. Blokování tréninkových crawlerů chrání váš obsah před začleněním do AI modelů bez kompenzace. Blokování vyhledávacích crawlerů může snížit vaši viditelnost na AI-poháněných objevovacích platformách jako ChatGPT search nebo Perplexity. Mnoho vydavatelů volí selektivní blokování cílené na tréninkové crawlery a zároveň povolující vyhledávací a citační crawlery.

Kontrolujte serverové logy pro user-agent řetězce crawlerů a ověřte, že blokované crawlery nepřistupují k vašim stránkám s obsahem. Používejte analytické nástroje k monitorování vzorců botového provozu. Testujte svou konfiguraci pomocí Knowatoa AI Search Console nebo Merkle robots.txt Testeru k validaci, že vaše pravidla fungují podle očekávání.

Agentické browserové crawlery jako ChatGPT Atlas a Google Project Mariner fungují jako plně vybavené webové prohlížeče spíše než jednoduché HTTP klienty. Často používají standardní Chrome user-agent řetězce, čímž jsou nerozeznatelné od běžného browserového provozu. Blokování na základě IP se stává nezbytným pro kontrolu přístupu těchto pokročilých crawlerů.

AI-specifický robots.txt kontroluje přístup k vašemu obsahu, zatímco nástroje jako AmICited monitorují, jak AI platformy odkazují a citují váš obsah. Společně poskytují kompletní viditelnost a kontrolu: robots.txt spravuje přístup crawlerů a monitorovací nástroje sledují dopad vašeho obsahu napříč AI systémy.

AmICited sleduje, jak AI systémy jako ChatGPT, Claude, Perplexity a Google AI Overviews citují a odkazují na vaši značku. Kombinujte konfiguraci robots.txt s monitoringem AI viditelnosti k pochopení dopadu vašeho obsahu napříč AI platformami.

Naučte se, jak nakonfigurovat robots.txt pro kontrolu přístupu AI crawlerů včetně GPTBot, ClaudeBot a Perplexity. Spravujte viditelnost své značky v odpovědích ...

Zjistěte, které AI crawlery povolit nebo blokovat ve vašem robots.txt. Komplexní průvodce zahrnující GPTBot, ClaudeBot, PerplexityBot a 25+ AI crawlerů s ukázka...

Diskuze komunity o nastavení robots.txt pro AI crawlery jako GPTBot, ClaudeBot a PerplexityBot. Skutečné zkušenosti webmasterů a SEO specialistů s blokováním vs...