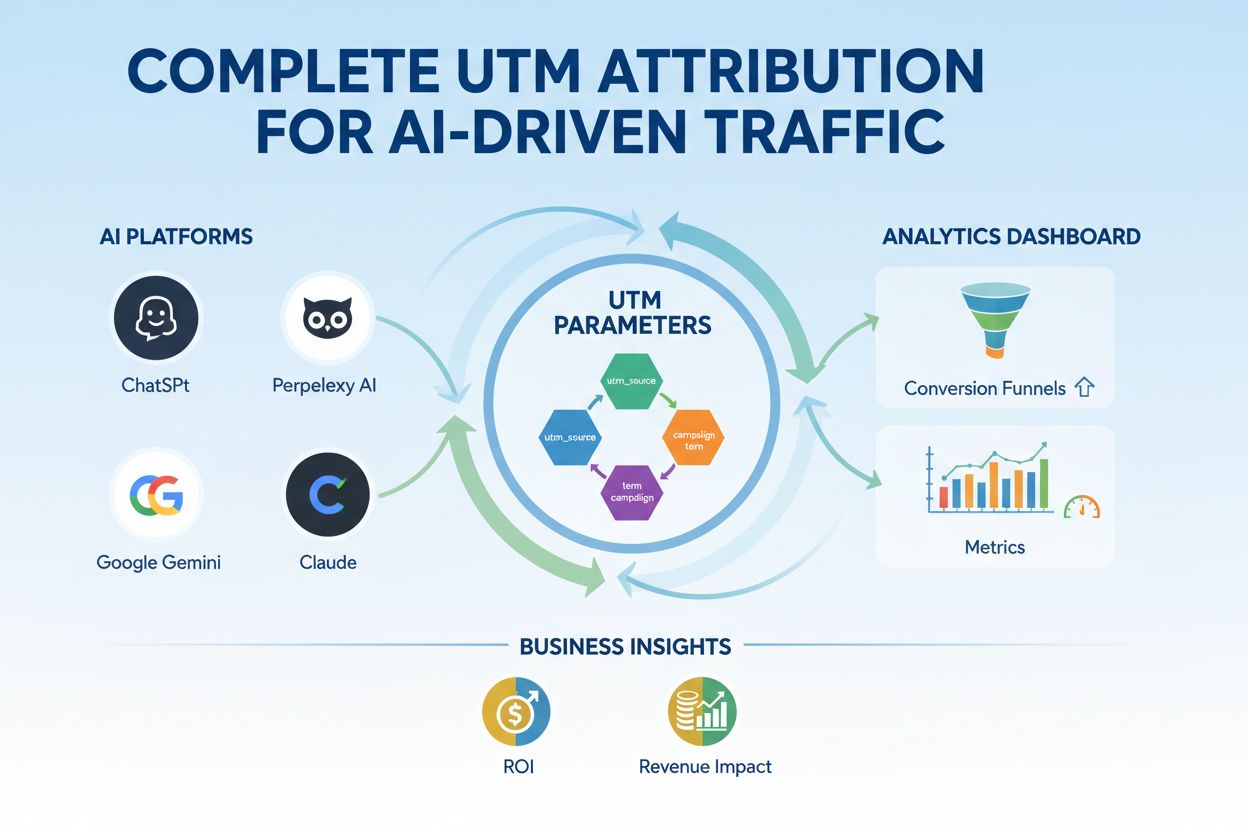

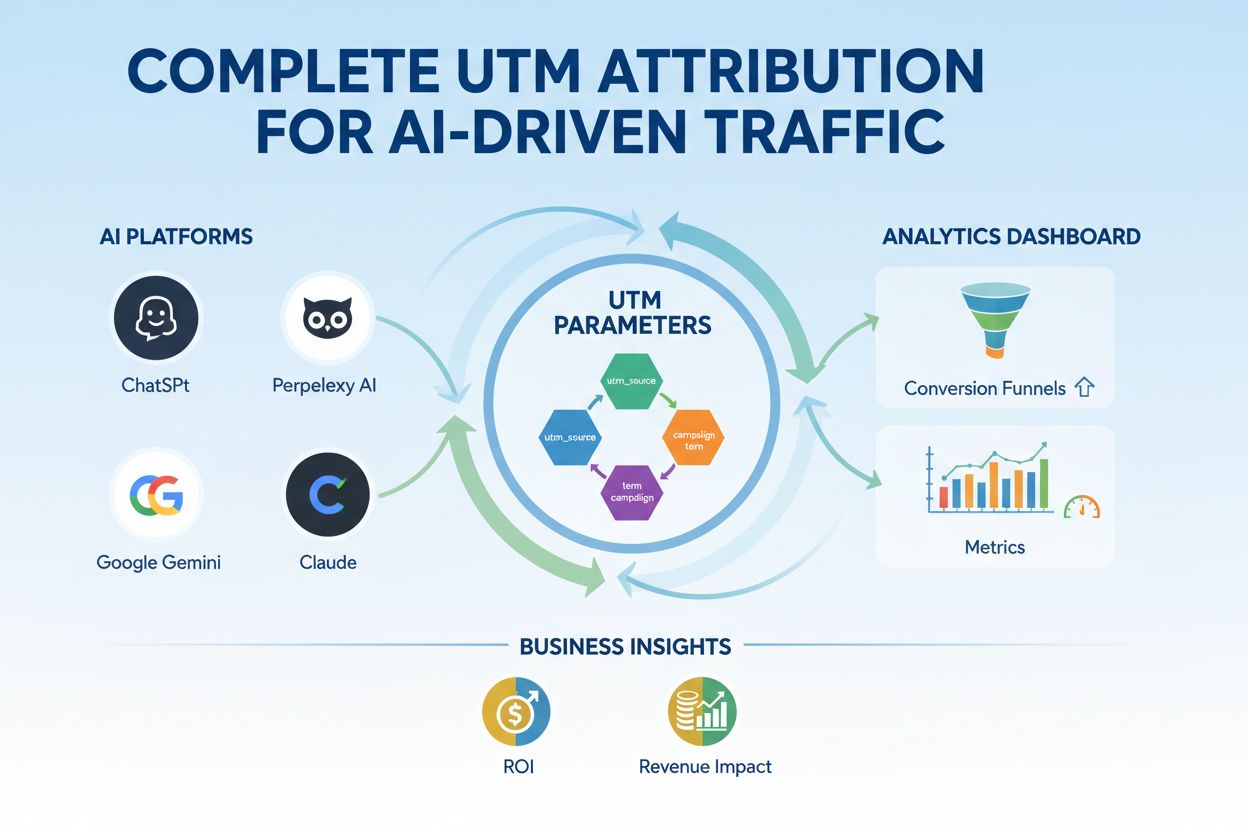

UTM parametry pro AI řízenou návštěvnost

Ovládněte UTM sledování pro AI platformy jako ChatGPT, Perplexity a Google Gemini. Naučte se nastavení, osvědčené postupy a jak přesně přiřazovat AI návštěvnost...

Parametry modelu jsou učitelné proměnné v AI modelech, jako jsou váhy a biasy, které se automaticky upravují během tréninku za účelem optimalizace schopnosti modelu přesně předpovídat a určují, jak model zpracovává vstupní data za účelem generování výstupů.

Parametry modelu jsou učitelné proměnné v AI modelech, jako jsou váhy a biasy, které se automaticky upravují během tréninku za účelem optimalizace schopnosti modelu přesně předpovídat a určují, jak model zpracovává vstupní data za účelem generování výstupů.

Parametry modelu jsou učitelné proměnné v modelech umělé inteligence, které se automaticky upravují během tréninkového procesu za účelem optimalizace schopnosti modelu přesně předpovídat a určují, jak model zpracovává vstupní data za účelem generování výstupů. Tyto parametry slouží jako základní „ovládací knoflíky“ systémů strojového učení a určují přesné chování a rozhodovací vzorce AI modelů. V kontextu hlubokého učení a neuronových sítí se parametry primárně skládají z vah a biasů—číselných hodnot, které řídí, jak informace procházejí sítí a jak silně různé prvky ovlivňují predikce. Cílem tréninku je najít optimální hodnoty těchto parametrů, které minimalizují chyby predikcí a umožní modelu dobře zobecnit na nová, neznámá data. Porozumění parametrům modelu je zásadní pro pochopení toho, jak fungují moderní AI systémy jako ChatGPT, Claude, Perplexity a Google AI Overviews a proč produkují různé výstupy na stejný vstup.

Koncept učitelných parametrů ve strojovém učení sahá až do počátků umělých neuronových sítí v 50. a 60. letech 20. století, kdy si výzkumníci poprvé uvědomili, že sítě mohou upravovat vnitřní hodnoty a učit se z dat. Praktické uplatnění parametrů však zůstávalo omezené až do zavedení zpětné propagace v 80. letech, která poskytla efektivní algoritmus pro výpočet úprav parametrů ke snížení chyb. S nástupem hlubokého učení v roce 2010 došlo k dramatickému nárůstu počtu parametrů. Rané konvoluční neuronové sítě pro rozpoznávání obrazů měly miliony parametrů, zatímco moderní velké jazykové modely (LLM) obsahují stovky miliard až biliony parametrů. Podle výzkumů Our World in Data a Epoch AI počet parametrů v klíčových AI systémech exponenciálně roste: GPT-3 má 175 miliard parametrů, GPT-4o asi 200 miliard a některé odhady uvádí, že GPT-4 může mít až 1,8 bilionu parametrů při započítání architektur typu mixture-of-experts. Toto dramatické škálování zásadně změnilo možnosti AI systémů a umožnilo jim zachycovat stále složitější vzory v jazyce, vizuálních a logických úlohách.

Parametry modelu fungují v rámci matematického rámce, kde každý parametr představuje číselnou hodnotu ovlivňující, jak model transformuje vstupy na výstupy. V jednoduchém lineárním regresním modelu parametry tvoří směrnice (m) a průsečík (b) v rovnici y = mx + b, kde tyto dvě hodnoty určují přímku nejlépe odpovídající datům. V neuronových sítích je situace násobně složitější. Každý neuron v jedné vrstvě přijímá vstupy z předchozí vrstvy, každý vstup násobí odpovídající vahou, sčítá tyto vážené vstupy, přidá bias a výsledek předá přes aktivační funkci na výstup. Tento výstup se pak stává vstupem do neuronů v další vrstvě, což vytváří kaskádu transformací řízených parametry. Během tréninku model využívá gradientní sestup a příbuzné optimalizační algoritmy ke zjištění, jak každý parametr upravit, aby se snížila ztrátová funkce—matematické měřítko chyby predikce. Gradient ztráty vzhledem k jednotlivým parametrům ukazuje směr a velikost potřebné úpravy. Díky zpětné propagaci tyto gradienty proudí zpět sítí a umožňují optimalizátoru aktualizovat všechny parametry současně koordinovaným způsobem. Tento iterativní proces pokračuje přes více trénovacích epoch, dokud se parametry nekonvergují k hodnotám, které minimalizují ztrátu na trénovacích datech a zároveň zajišťují dobrou zobecnitelnost na nová data.

| Aspekt | Parametry modelu | Hyperparametry | Vlastnosti (features) |

|---|---|---|---|

| Definice | Učitelné proměnné upravované během tréninku | Nastavení konfigurace před tréninkem | Charakteristiky vstupních dat používané modelem |

| Kdy se nastavují | Automaticky učené optimalizací | Ručně nastavované odborníky | Extrahované nebo vytvořené z původních dat |

| Příklady | Váhy, biasy v neuronových sítích | Rychlost učení, velikost batch, počet vrstev | Hodnoty pixelů v obrázcích, vektorová reprezentace slov v textu |

| Vliv na model | Určují, jak model mapuje vstupy na výstupy | Řídí tréninkový proces a strukturu modelu | Poskytují syrové informace, ze kterých se model učí |

| Optimalizační metoda | Gradientní sestup, Adam, AdaGrad | Grid search, náhodné hledání, Bayesovská optimalizace | Feature engineering, výběr vlastností |

| Počet ve velkých modelech | Miliardy až biliony (např. 200B v GPT-4o) | Typicky 5–20 klíčových hyperparametrů | Tisíce až miliony podle dat |

| Výpočetní náklady | Vysoké při tréninku; ovlivňují rychlost inference | Minimální výpočetní náklady na nastavení | Dány sběrem a předzpracováním dat |

| Přenositelnost | Lze přenášet pomocí fine-tuningu a transfer learningu | Nutno znovu ladit pro nové úlohy | Může vyžadovat přepracování pro nové domény |

Parametry modelu mají různé podoby v závislosti na architektuře a typu používaného modelu strojového učení. Ve konvolučních neuronových sítích (CNN) pro rozpoznávání obrázků zahrnují parametry váhy v konvolučních filtrech (též kernel), které detekují prostorové vzory jako hrany, textury a tvary v různých měřítkách. Rekurentní neuronové sítě (RNN) a long short-term memory (LSTM) sítě obsahují parametry řídící tok informací v čase, včetně parametrů bran určujících, které informace si pamatovat nebo zapomenout. Transformátorové modely, které pohánějí moderní velké jazykové modely, obsahují parametry v několika částech: váhy pozornosti určující, na které části vstupu se soustředit, váhy feed-forward sítě a parametry pro normalizaci vrstev. V pravděpodobnostních modelech jako Naive Bayes parametry definují podmíněné pravděpodobnostní rozdělení. Support vector machines využívají parametry určující pozici a orientaci rozhodovacích hranic v prostoru vlastností. Mixture of Experts (MoE) modely, použité v některých verzích GPT-4, obsahují parametry pro více specializovaných podsítí plus směrovací parametry určující, jaký expert zpracuje který vstup. Tato architektonická rozmanitost znamená, že povaha a počet parametrů se mezi typy modelů výrazně liší, avšak základní princip zůstává stejný: parametry jsou naučené hodnoty, které umožňují modelu plnit jeho úkol.

Váhy a biasy představují dva základní typy parametrů v neuronových sítích a tvoří základ toho, jak se tyto modely učí. Váhy jsou číselné hodnoty přiřazené spojům mezi neurony, které určují sílu a směr vlivu výstupu jednoho neuronu na vstup dalšího. Ve vrstvě s 1 000 vstupními a 500 výstupními neurony bude 500 000 parametrů vah—jeden pro každé spojení. Během tréninku se váhy upravují pro zvýšení či snížení vlivu konkrétních vlastností na predikce. Velká kladná váha znamená, že vlastnost silně aktivuje další neuron, záporná jej tlumí. Biasy jsou další parametry, jeden na neuron ve vrstvě, které poskytují konstantní posun k součtu vstupů před aplikací aktivační funkce. Matematicky, pokud neuron obdrží vážené vstupy, které se sečtou na nulu, bias umožní, aby neuron produkoval nenulový výstup, což poskytuje zásadní flexibilitu. Tato flexibilita umožňuje neuronovým sítím učit se složité rozhodovací hranice a zachycovat vzory, které by samotné váhy nezvládly. Ve modelu se 200 miliardami parametrů, jako je GPT-4o, tvoří drtivou většinu váhy v pozornostních mechanismech a feed-forward sítích, zatímco biasy tvoří menší, ale stále významnou část. Společně umožňují váhy a biasy modelu učit se složité vzory v jazyce, vizuálních datech nebo jiných doménách, které činí moderní AI systémy tak výkonnými.

Počet parametrů v modelu má zásadní vliv na jeho schopnost učit se složité vzory a na celkový výkon. Výzkumy opakovaně ukazují, že škálovací zákony regulují vztah mezi počtem parametrů, velikostí trénovacích dat a výkonem modelu. Modely s více parametry mohou reprezentovat složitější funkce a zachytit jemnější vzory v datech, což obecně vede k lepším výsledkům v náročných úlohách. GPT-3 se 175 miliardami parametrů předvedl pozoruhodné schopnosti málo-násobného učení, které menší modely nedokázaly. GPT-4o s 200 miliardami parametrů přináší další vylepšení v oblasti logického uvažování, generování kódu a multimodálního porozumění. Vztah mezi počtem parametrů a výkonem však není lineární a závisí zásadně na množství a kvalitě trénovacích dat. Model s příliš mnoha parametry vzhledem k datům se přeučí, zapamatuje si konkrétní příklady místo obecných vzorů a podává špatný výkon na nových datech. Naopak model s příliš málo parametry nemusí zachytit důležité vzory a dosahuje suboptimálního výkonu i na trénovacích datech. Optimální počet parametrů pro daný úkol závisí na složitosti úkolu, velikosti a diverzitě trénovacích dat i výpočetních omezeních. Výzkumy Epoch AI ukazují, že moderní AI systémy dosáhly pozoruhodného výkonu díky masivnímu škálování, přičemž některé modely obsahují biliony parametrů díky architekturám mixture-of-experts, kde nejsou všechny parametry aktivní při každém vstupu.

I když velké modely s miliardami parametrů dosahují působivého výkonu, výpočetní náklady na jejich trénink a nasazení jsou značné. To vedlo k výzkumu efektivního doladění parametrů, který umožňuje přizpůsobit předtrénované modely novým úlohám bez nutnosti upravovat všechny parametry. LoRA (Low-Rank Adaptation) je významná technika, která zamrzne většinu předtrénovaných parametrů a trénuje pouze malou sadu dodatečných nízko-rankových matic, čímž snižuje počet trénovatelných parametrů o řády, aniž by utrpěl výkon. Například při doladění modelu se 7 miliardami parametrů pomocí LoRA se trénuje pouze 1–2 miliony nových parametrů místo všech 7 miliard. Adapter moduly vkládají malé trénovatelné sítě mezi vrstvy zamrznutého modelu, přidávají pouze malý podíl parametrů a umožňují úlohovou adaptaci. Prompt engineering a učení v kontextu představují alternativní přístupy, které parametry vůbec nemění, ale využívají stávající parametry efektivněji díky promyšleným vstupům. Tyto efektivní přístupy demokratizovaly přístup k velkým jazykovým modelům a umožnily organizacím s omezenými zdroji přizpůsobit špičkové modely svým potřebám. Kompromis mezi efektivitou a výkonem je stále aktivní oblastí výzkumu, kde se hledá rovnováha mezi výpočetní úsporností a přesností pro konkrétní úlohy.

Porozumění parametrům modelu je klíčové pro platformy jako AmICited, které sledují, jak se značky a domény objevují ve výstupech AI napříč systémy jako ChatGPT, Perplexity, Claude a Google AI Overviews. Různé AI modely s odlišnými konfiguracemi parametrů produkují na stejný dotaz různé výstupy, což ovlivňuje, kde a jak je značka zmíněna. 200 miliard parametrů v GPT-4o je nastaveno jinak než parametry v Claude 3.5 Sonnet nebo modelech Perplexity, což vede k různorodosti generovaných odpovědí. Parametry naučené při tréninku na různých datech a s různými cíli způsobují, že modely mají odlišné znalosti, logiku a citační chování. Při monitorování zmínek značek v AI odpovědích pomáhá pochopit, že tyto rozdíly pramení z parametrických odlišností, a vysvětluje, proč je značka v jednom systému výrazně zastoupena a v jiném téměř ne. Parametry řídící mechanismy pozornosti určují, které části trénovacích dat jsou pro dotaz nejrelevantnější, což ovlivňuje citační vzorce. Parametry ve výstupních vrstvách určují, jak model strukturuje a prezentuje informace. Sledováním toho, jak různé AI systémy s různými parametry zmiňují značky, poskytuje AmICited vhled do toho, jak chování modelu ovlivněné parametry formuje viditelnost značky v krajině AI vyhledávání.

Budoucnost parametrů modelu je utvářena několika sbíhajícími se trendy, které zásadně změní návrh a nasazení AI systémů. Mixture of Experts (MoE) architektury představují významný posun, kdy modely obsahují více specializovaných podsítí (expertů) s vlastními parametry a směrovací mechanismus určuje, který expert zpracuje daný vstup. Tento přístup umožňuje škálovat modely na biliony parametrů při zachování výpočetní efektivity při inferenci, protože ne všechny parametry jsou aktivní pro každý vstup. GPT-4 údajně používá MoE architekturu se 16 experty, z nichž každý má 110 miliard parametrů, což dává celkem 1,8 bilionu parametrů, ale při inferenci se využívá jen zlomek. Řídké parametry a pruningové techniky se vyvíjejí k identifikaci a odstranění méně důležitých parametrů, což snižuje velikost modelu bez ztráty výkonu. Průběžné učení usiluje o efektivní aktualizaci parametrů při příchodu nových dat, což umožňuje modelům adaptovat se bez nutnosti kompletního přeškolení. Federované učení rozděluje trénování parametrů na více zařízení při zachování soukromí, takže organizace mohou těžit z velkého tréninku bez centralizace citlivých dat. Objevují se i malé jazykové modely (SLM) s miliardami místo stovek miliard parametrů, což naznačuje budoucnost, kde bude efektivita parametrů stejně důležitá jako jejich absolutní počet. Jak se AI systémy začleňují do klíčových aplikací, bude porozumění a řízení parametrů modelu stále důležitější pro zajištění bezpečnosti, férovosti a souladu s lidskými hodnotami. Vztah mezi počtem parametrů a chováním modelu zůstane středobodem AI výzkumu s dopady od výpočetní udržitelnosti až po interpretovatelnost a důvěryhodnost AI systémů.

Parametry modelu jsou vnitřní proměnné, které se učí během tréninku pomocí optimalizačních algoritmů, jako je gradientní sestup, zatímco hyperparametry jsou vnější nastavení, která se konfigurují před začátkem tréninku. Parametry určují, jak model mapuje vstupy na výstupy, zatímco hyperparametry řídí samotný proces učení, například rychlost učení a počet epoch. Například váhy a biasy v neuronových sítích jsou parametry, zatímco rychlost učení je hyperparametr.

Moderní velké jazykové modely obsahují miliardy až biliony parametrů. GPT-4o obsahuje přibližně 200 miliard parametrů, zatímco GPT-4o-mini má asi 8 miliard parametrů. Claude 3.5 Sonnet také operuje se stovkami miliard parametrů. Tyto obrovské počty parametrů umožňují modelům zachytit složité vzory v jazyce a generovat sofistikované, kontextově relevantní odpovědi napříč různými tématy.

Více parametrů zvyšuje kapacitu modelu učit se komplexní vzory a vztahy v datech. S dalším počtem parametrů mohou modely reprezentovat nuance a interakce, což vede k vyšší přesnosti na trénovacích datech. Existuje však kritická rovnováha: příliš mnoho parametrů vzhledem k množství dat vede k přeučení, kdy si model zapamatuje šum místo obecných vzorů, což zhoršuje výkon na nových, neznámých datech.

Parametry modelu se aktualizují pomocí zpětné propagace a optimalizačních algoritmů, jako je gradientní sestup. Během tréninku model provádí predikce, vypočítá ztrátu (chybu) mezi predikcemi a skutečnými hodnotami a pak spočítá gradienty, které ukazují, jak každý parametr přispěl k chybě. Optimalizátor následně upraví parametry ve směru, který snižuje ztrátu, a tento proces se opakuje přes více trénovacích iterací, dokud model nedosáhne optimálních hodnot.

Váhy určují sílu propojení mezi neurony v neuronových sítích a ovlivňují, jak silně vstupní prvky ovlivňují výstupy. Biasy fungují jako prahové hodnoty, umožňující aktivaci neuronů i v případě, že vážené vstupy jsou nulové, což poskytuje flexibilitu a umožňuje modelu učit se základní vzory. Společně tvoří váhy a biasy základní učitelné parametry, které umožňují neuronovým sítím aproximovat složité funkce a dělat přesné predikce.

Parametry modelu přímo ovlivňují, jak AI systémy jako ChatGPT, Perplexity a Claude zpracovávají a odpovídají na dotazy. Pochopení počtu a konfigurace parametrů vysvětluje, proč různé AI modely produkují různé výstupy na stejný podnět. Pro platformy pro sledování značky, jako je AmICited, je sledování vlivu parametrů na chování modelu klíčové pro předpovídání, kde se značka objeví v AI odpovědích a pro pochopení konzistence napříč různými AI systémy.

Ano, prostřednictvím transfer learningu lze parametry z předtrénovaného modelu přizpůsobit novým úlohám. Tento přístup, zvaný fine-tuning, zahrnuje úpravu naučených parametrů modelu na nových datech pro specifické aplikace. Metody efektivního doladění parametrů, jako je LoRA (Low-Rank Adaptation), umožňují selektivní aktualizaci parametrů, což snižuje výpočetní náklady a zachovává výkon. Tato technika se široce používá k přizpůsobení velkých jazykových modelů pro specializované domény.

Parametry modelu přímo ovlivňují výpočetní požadavky jak během tréninku, tak při inferenci. Více parametrů vyžaduje více paměti, výpočetního výkonu a času při tréninku i nasazení. Model se 175 miliardami parametrů (jako GPT-3) vyžaduje výrazně více výpočetních zdrojů než model se 7 miliardami parametrů. Tento vztah je klíčový pro organizace nasazující AI systémy, protože počet parametrů ovlivňuje náklady na infrastrukturu, latenci i spotřebu energie v produkčním prostředí.

Začněte sledovat, jak AI chatboti zmiňují vaši značku na ChatGPT, Perplexity a dalších platformách. Získejte užitečné informace pro zlepšení vaší AI prezence.

Ovládněte UTM sledování pro AI platformy jako ChatGPT, Perplexity a Google Gemini. Naučte se nastavení, osvědčené postupy a jak přesně přiřazovat AI návštěvnost...

Komplexní definice velkých jazykových modelů (LLM): AI systémy trénované na miliardách parametrů pro porozumění a generování jazyka. Zjistěte, jak LLM fungují, ...

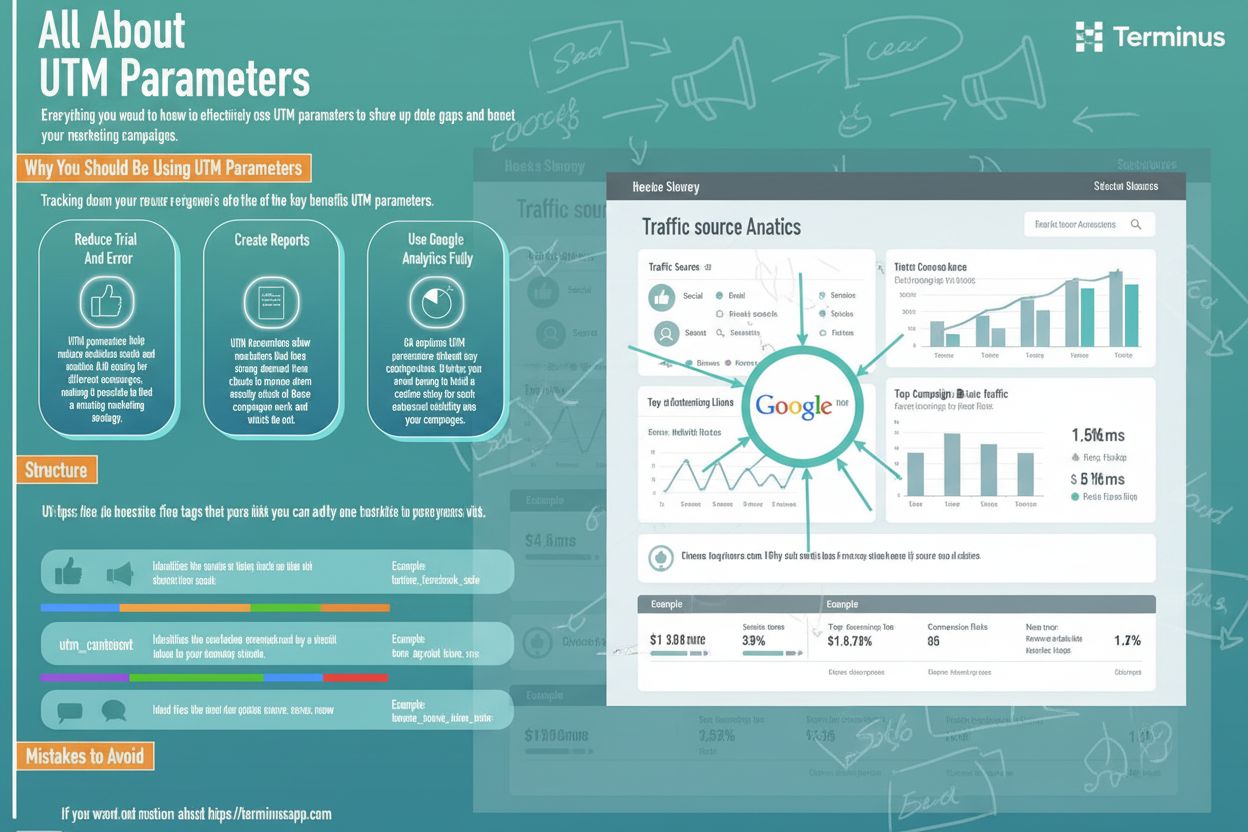

UTM parametry jsou značky URL, které sledují výkonnost marketingových kampaní. Zjistěte, jak utm_source, utm_medium, utm_campaign a další parametry pomáhají měř...