Detekce spamu

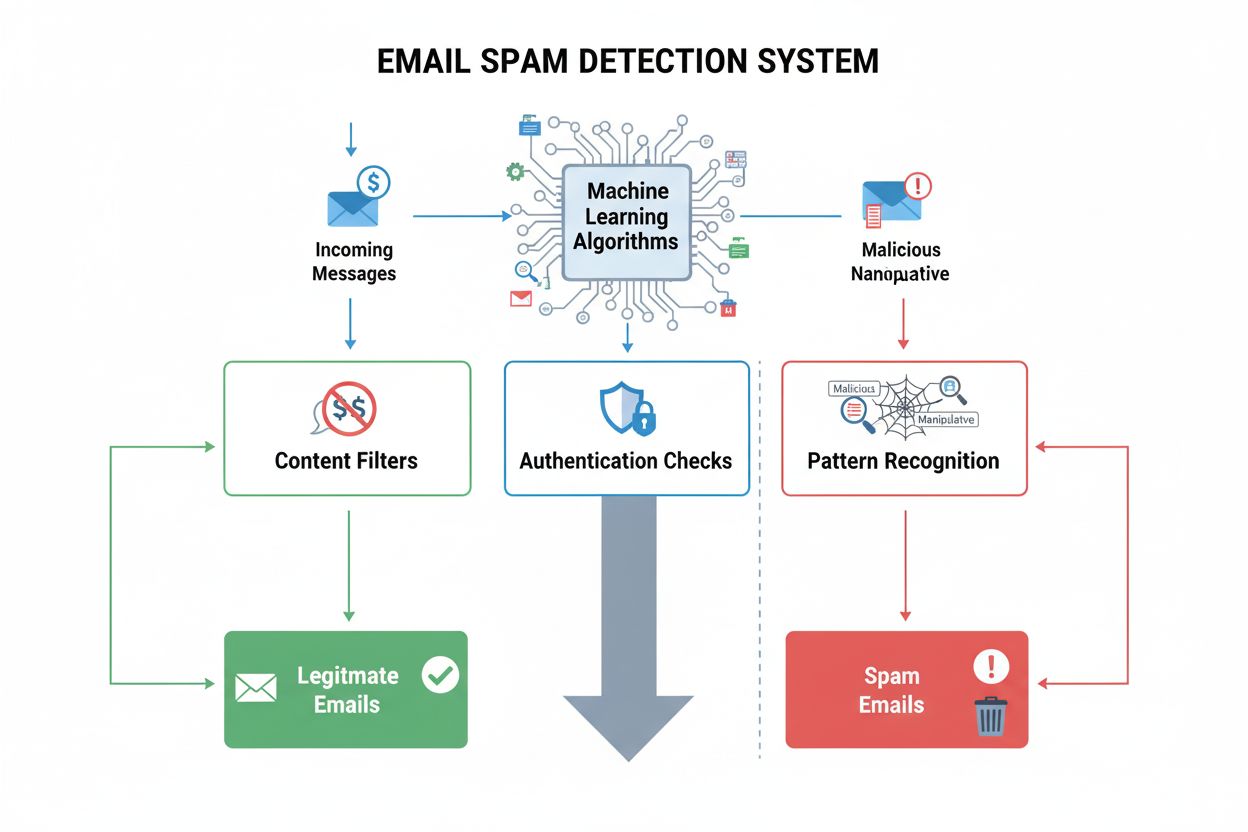

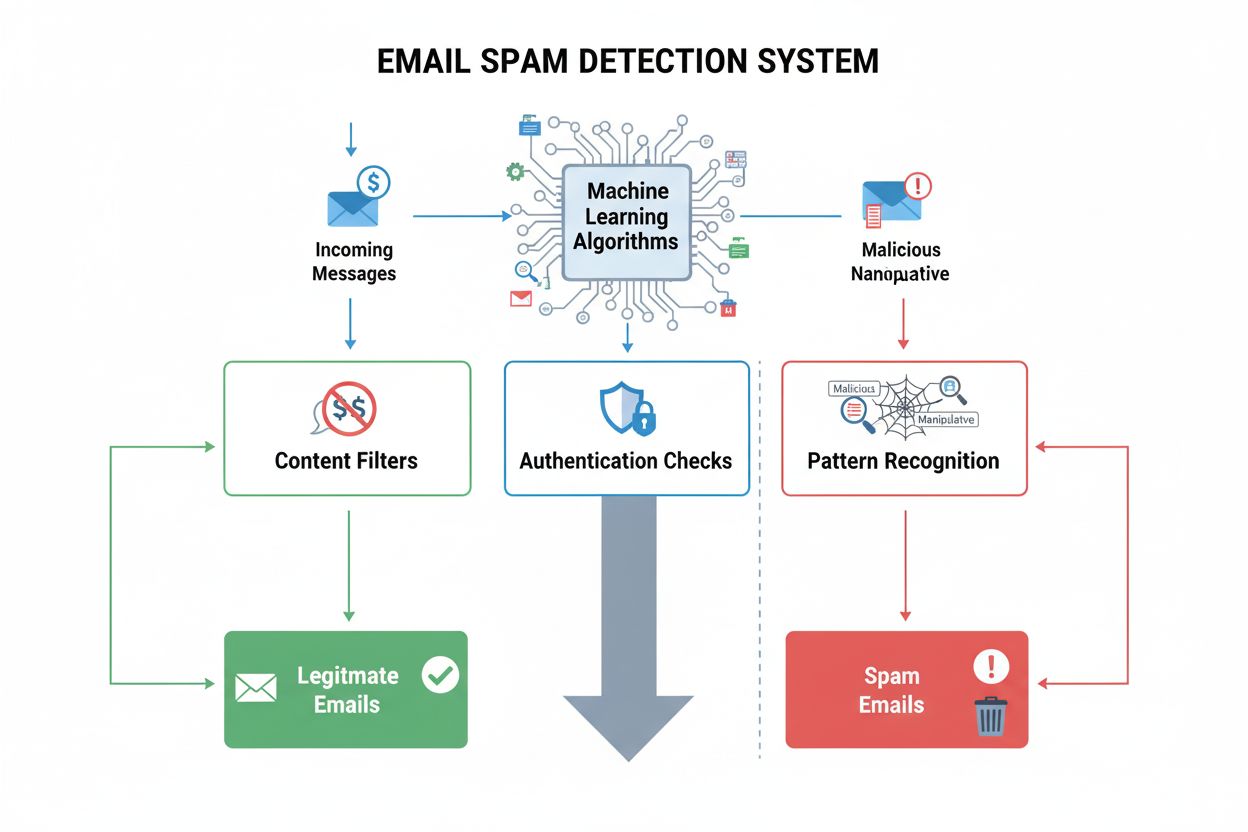

Detekce spamu identifikuje nechtěný, manipulativní obsah pomocí algoritmů strojového učení a behaviorální analýzy. Zjistěte, jak AI systémy filtrují spam v e-ma...

Spam ve vyhledávačích označuje záměrné manipulační taktiky používané k umělému ovlivnění pozic ve vyhledávačích pomocí klamavých technik, které porušují pravidla vyhledávačů. Tyto praktiky zahrnují nadměrné používání klíčových slov, maskování obsahu, farmy odkazů a skrytý text, které jsou navrženy tak, aby oklamaly algoritmy místo poskytování skutečné hodnoty uživatelům.

Spam ve vyhledávačích označuje záměrné manipulační taktiky používané k umělému ovlivnění pozic ve vyhledávačích pomocí klamavých technik, které porušují pravidla vyhledávačů. Tyto praktiky zahrnují nadměrné používání klíčových slov, maskování obsahu, farmy odkazů a skrytý text, které jsou navrženy tak, aby oklamaly algoritmy místo poskytování skutečné hodnoty uživatelům.

Spam ve vyhledávačích, známý také jako spamdexing, označuje záměrnou manipulaci s indexy vyhledávačů pomocí klamavých technik navržených tak, aby uměle zvýšily pozici webové stránky ve výsledcích. Tento pojem zahrnuje širokou škálu neetických praktik, které porušují pravidla vyhledávačů, včetně nadměrného používání klíčových slov, maskování obsahu, farm odkazů, skrytého textu a záludných přesměrování. Tyto taktiky upřednostňují oklamání algoritmů před skutečnou hodnotou pro uživatele, a tím zásadně narušují integritu výsledků vyhledávání. Když vyhledávače detekují na webu spam, obvykle uvalují postihy od snížení pozic až po úplné odstranění z indexu, což stránku učiní neviditelnou pro potenciální návštěvníky.

Spam ve vyhledávačích existuje již od počátků internetu, kdy byly vyhledávací algoritmy méně sofistikované a snadno zmanipulovatelné. V 90. letech a na začátku 21. století se techniky spamdexingu rychle rozšířily, protože správci webů zjistili, že mohou jednoduše zvyšovat pozice pomocí opakování klíčových slov a manipulací s odkazy. S vývojem vyhledávačů, zejména po zavedení PageRanku od Googlu a následných aktualizacích algoritmů jako Panda (2011) a Penguin (2012), se detekce a penalizace spamu staly mnohem pokročilejšími. Vznik SpamBrainu, systému prevence spamu založeného na AI od Googlu uvedeného v roce 2022, znamenal zásadní posun směrem k detekci spamu s využitím strojového učení. Dnes vyhledávače používají pokročilé algoritmy, které analyzují stovky faktorů pro hodnocení, což činí tradiční spamové taktiky převážně neúčinnými, ale zároveň otevírá prostor pro nové formy sofistikované manipulace.

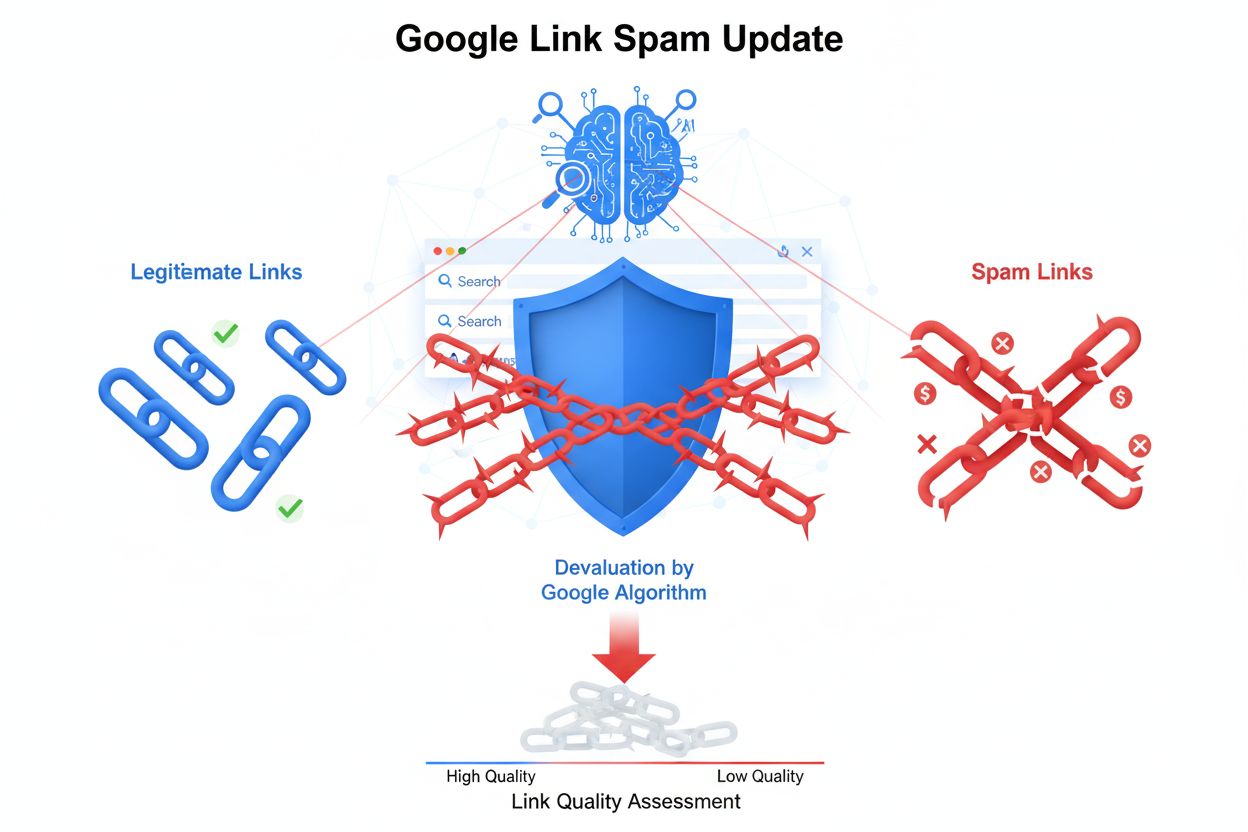

Nadměrné používání klíčových slov zůstává jednou z nejznámějších spamových taktik, která spočívá v nepřirozeném opakování cílových klíčových slov v obsahu stránky, meta značkách i skrytých prvcích. Tato praktika uměle zvyšuje hustotu klíčových slov bez poskytnutí smysluplných informací čtenářům. Maskování obsahu představuje ještě klamavější přístup, kdy je vyhledávačům zobrazován jiný obsah než běžným uživatelům, obvykle pomocí JavaScriptu nebo serverových technik, které rozpoznávají rozdíl mezi robotem a skutečným návštěvníkem. Farmy odkazů a Private Blog Networks (PBNs) tvoří další významnou kategorii spamu, kdy sítě nekvalitních webů vznikají pouze za účelem generování umělých zpětných odkazů na cílové stránky. Tyto sítě zneužívají faktu, že vyhledávače historicky přikládaly zpětným odkazům velkou váhu, ačkoliv moderní algoritmy již podobné umělé schémata úspěšně rozpoznávají a znehodnocují.

Záludná přesměrování manipulují uživatelským chováním tím, že návštěvníky po kliknutí z výsledků vyhledávání přesměrují na jiné URL, než jaké indexují vyhledávače – často na nerelevantní či škodlivý obsah. Skrytý text a odkazy zahrnují umisťování obsahu v barvě pozadí, extrémně malým písmem nebo mimo obrazovku – pro lidské návštěvníky jsou neviditelné, ale pro crawlery dostupné. Spam v komentářích a spam ve fórech využívá platformy s uživatelským obsahem k automatickému vkládání odkazů a propagačního obsahu do blogů, fór a sociálních sítí. Scraping obsahu znamená kopírování obsahu z jiných webů bez svolení či úprav a jeho opětovné publikování s cílem uměle navýšit objem obsahu a získat návštěvnost z vyhledávačů. Každá z těchto taktik představuje pokus o „obejití“ algoritmů namísto získání pozic legitimní cestou.

| Aspekt | Spam ve vyhledávačích (Black Hat) | Legitimní SEO (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Hlavní cíl | Manipulace algoritmů klamáním | Poskytnutí hodnoty uživatelům a přirozené získání pozic | Využití šedých zón v pravidlech |

| Kvalita obsahu | Nekvalitní, přeplněný klíčovými slovy nebo převzatý | Kvalitní, originální, uživatelsky zaměřený obsah | Smíšená kvalita, některé pochybné praktiky |

| Budování odkazů | Umělé odkazy z farem, PBN nebo hacknutých webů | Přirozené odkazy získané díky kvalitě obsahu | Nakoupené odkazy, reciproční výměny |

| Technické metody | Maskování, skrytý text, záludná přesměrování | Čistý HTML, správné meta značky, strukturovaná data | JavaScript přesměrování, doorway stránky |

| Uživatelská zkušenost | Špatná; obsah pro algoritmy, ne uživatele | Výborná; obsah pro uživatelskou spokojenost | Průměrná; některé ústupky UX |

| Postihy vyhledávačů | Manuální zásahy, vyřazení z indexu, pokles pozic | Žádné; trvalé zlepšování pozic | Možné postihy při odhalení |

| Dlouhodobá udržitelnost | Neudržitelná; postihy nevyhnutelné | Udržitelná; buduje trvalou autoritu | Riziková; závisí na odhalení |

| Doba obnovy | Měsíce až roky; některé výhody nevratné | N/A; není třeba obnovovat | Týdny až měsíce při odhalení |

SpamBrain představuje zásadní posun v boji vyhledávačů proti spamu díky využití umělé inteligence a strojového učení. Google jej spustil v roce 2022 a SpamBrain analyzuje vzorce na miliardách webů, aby s bezprecedentní přesností identifikoval znaky spamu. Systém funguje nepřetržitě a zkoumá jak on-page faktory (kvalitu obsahu, rozložení klíčových slov, strukturu stránky), tak off-page signály (profil odkazů, historii domény, vzorce chování uživatelů). Modely strojového učení SpamBrainu jsou trénovány na rozsáhlých datech známého spamu i legitimních webů, což umožňuje rozpoznat nové varianty spamu ještě před jejich masovým rozšířením. AI systém dokáže detekovat i sofistikované pokusy, které by pravidlové systémy přehlédly, včetně koordinovaných odkazových schémat, manipulace s obsahem a zneužití hacknutých webů. Google uvádí, že vylepšení SpamBrainu snížila výskyt nekvalitního, neoriginálního obsahu ve výsledcích vyhledávání přibližně o 45 % od jeho zavedení, což dokládá účinnost AI detekce spamu.

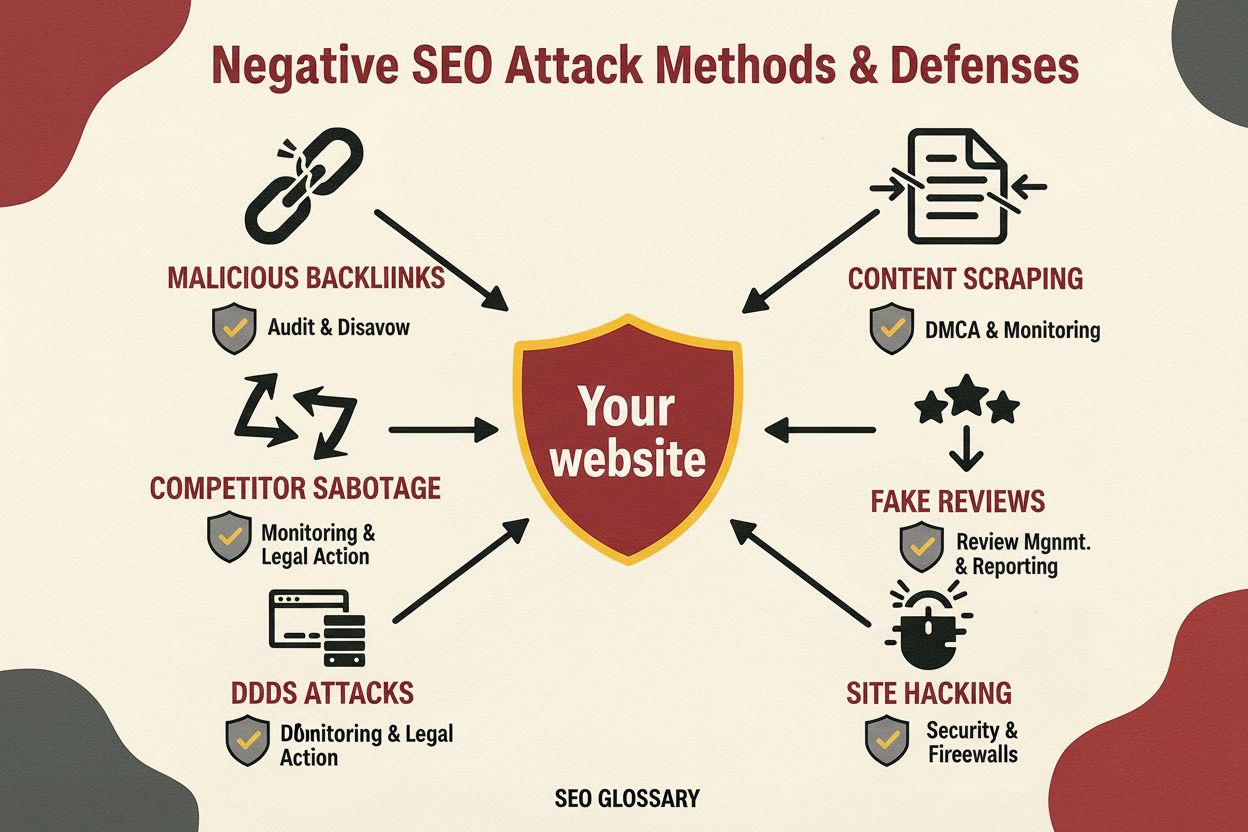

Masivní šíření spamu ve vyhledávačích přímo snižuje kvalitu a užitečnost výsledků pro koncové uživatele. Když se spamový obsah umístí na vysokých pozicích, uživatelé narážejí na nerelevantní, nekvalitní nebo zavádějící informace místo autoritativních zdrojů, které by skutečně odpovídaly na jejich dotazy. Tím je narušena důvěra ve vyhledávače a platformy musí investovat značné prostředky do detekce a odstraňování spamu. Přítomnost spamu navíc vytváří neférové konkurenční prostředí, kde mají legitimní firmy dočasně ztíženou možnost uspět proti webům používajícím neetické praktiky. Vyhledávače na šíření spamu reagují pravidelnými spamovými aktualizacemi – významnými vylepšeními systémů detekce spamu, které se ohlašují a sledují odděleně od hlavních aktualizací algoritmů. Například prosincová spamová aktualizace Googlu v roce 2024 se aplikovala globálně ve všech jazycích a její zavádění trvalo až týden, což ukazuje rozsah a četnost boje proti spamu. Neustálý závod mezi spamery a vyhledávači spotřebovává významné výpočetní zdroje a inženýrské úsilí, které by jinak mohlo být věnováno zvyšování kvality vyhledávání.

Weby přistižené při spamu ve vyhledávačích čelí široké škále následků – od algoritmických postihů přes manuální zásahy až po úplné vyřazení z indexu. Manuální zásahy představují nejpřímější reakci Googlu na spam, kdy lidský kontrolor identifikuje porušení a udělí konkrétní postih přes Google Search Console. Manuální zásahy informují provozovatele o konkrétním porušení – například nepřirozené odkazy, nadměrné používání klíčových slov nebo maskování obsahu – a obvykle znamenají výrazný pokles pozic nebo odstranění z výsledků vyhledávání. Algoritmické postihy nastávají, když automatizované systémy Googlu detekují vzorce spamu a sníží viditelnost webu bez zásahu člověka. Tyto postihy mohou být dočasné (trvají do odstranění spamu a opětovného procházení webu) nebo trvalé, pokud jsou porušení závažná či opakovaná. V krajních případech bývá web zcela vyřazen z indexu, tedy vůbec se nezobrazuje ve výsledcích Googlu, což znamená ztrátu organické viditelnosti. Obnova po manuálním zásahu vyžaduje komplexní nápravu, podrobnou dokumentaci provedených změn a podání žádosti o přehodnocení přes Google Search Console. Ani po úspěšné obnově však nelze získat zpět výhody dříve získané díky spamovým odkazům – ty jsou ztraceny natrvalo.

Vznik vyhledávacích systémů s umělou inteligencí jako ChatGPT, Perplexity, Google AI Overviews či Claude přináší nové rozměry problému spamu ve vyhledávačích. Tyto systémy spoléhají na webový obsah při generování odpovědí, což je činí zranitelnými vůči spamu a nekvalitnímu obsahu, který může ovlivnit jejich výstupy. Na rozdíl od tradičních vyhledávačů zobrazujících pořadí výsledků AI systémy syntetizují informace do přirozeného jazyka, a pokud je spam součástí trénovacích dat nebo retrieval mechanismů, může být jeho vliv násoben. Organizace jako AmICited vznikly právě proto, aby tento problém řešily – poskytují platformy pro monitoring AI promptů, které sledují, kde se značky a domény objevují v AI odpovědích. Tato schopnost je zásadní, protože spam v AI odpovědích může poškodit pověst a viditelnost značky jiným způsobem než tradiční výsledky vyhledávání. S tím, jak se AI systémy stávají běžným nástrojem pro vyhledávání informací, roste důležitost monitorování a prevence spamu v těchto nových paradigmách exponenciálně. Výzvou pro AI je rozlišit autoritativní zdroje od spamu při rozhodování, jaké informace do odpovědí zahrnout.

Organizace, které chtějí dlouhodobě uspět ve vyhledávačích, by měly zavést komplexní strategie pro vyhýbání se spamovým taktikám a dodržování pravidel vyhledávačů. Obsahová strategie by měla klást důraz na originální, kvalitní, uživatelsky zaměřený obsah, který přirozeně obsahuje relevantní klíčová slova bez umělého opakování či manipulace. Budování odkazů se má soustředit na získávání přirozených zpětných odkazů díky kvalitě obsahu, vztahům v oboru a legitimnímu outreachi, nikoliv nákupem odkazů nebo účastí na odkazových schématech. Technické SEO by mělo dbát na čistý HTML, správné meta značky, implementaci strukturovaných dat a transparentní přesměrování, která zachází stejně s vyhledávači i uživateli. Pravidelné audity obsahu, odkazů a technických prvků pomohou včas odhalit potenciální spamové problémy dříve, než dojde k postihům. Monitorovací nástroje by měly sledovat pozice klíčových slov, profily zpětných odkazů a viditelnost ve vyhledávačích pro detekci neobvyklých změn, které mohou signalizovat spam nebo útok konkurence. Optimalizace uživatelské zkušenosti zajistí, že obsah primárně slouží lidským návštěvníkům, zatímco SEO zůstává sekundárním cílem. Organizace by měly také nastavit jasné vnitřní zásady zakazující spam a vzdělávat tým o rizicích a důsledcích manipulačních pokusů.

Budoucnost detekce spamu ve vyhledávačích bude čím dál více stavět na pokročilé umělé inteligenci a strojovém učení, které dokážou v reálném čase identifikovat sofistikované pokusy o manipulaci. SpamBrain a podobné AI systémy se budou nadále vyvíjet tak, aby odhalily nové varianty spamu rychleji, než je spammeři dokáží vymyslet, což povede k akceleraci závodu mezi detekcí a obcházením pravidel. Integrace AI vyhledávacích systémů do hlavního proudu vyhledávání si vyžádá nové přístupy k detekci spamu přizpůsobené způsobu, jakým tyto systémy vyhledávají a syntetizují informace. Vyhledávače pravděpodobně zavedou pokročilejší analýzu uživatelského chování pro detekci spamu podle toho, jak skuteční uživatelé s obsahem pracují, nikoliv pouze podle technických signálů. Monitorování napříč platformami bude stále důležitější, protože spamové taktiky se budou zaměřovat na více vyhledávacích systémů najednou – tradiční vyhledávače, AI chatovací roboty i nové paradigmata vyhledávání. Rozmach generativního AI obsahu přináší nové spamové výzvy, protože automatizované systémy dokážou generovat věrohodně znějící, ale nekvalitní nebo zavádějící obsah ve velkém. Organizace jako AmICited sehrají stále klíčovější roli při monitoringu viditelnosti značek napříč různými systémy a včasné detekci spamových hrozeb. Nejúčinnější prevence spamu nakonec spojí pokročilou algoritmickou detekci s lidskou expertizou, mechanismy zpětné vazby uživatelů a spoluprací v oboru, aby byla zachována kvalita vyhledávání a důvěra uživatelů.

Spam ve vyhledávačích porušuje pravidla vyhledávačů a používá klamavé taktiky k manipulaci s pozicemi, zatímco legitimní SEO dodržuje white-hat praktiky, které poskytují skutečnou hodnotu uživatelům. Legitimní SEO se zaměřuje na tvorbu kvalitního obsahu, získávání přirozených zpětných odkazů a zlepšování uživatelské zkušenosti, zatímco spamové taktiky jako nadměrné používání klíčových slov a maskování obsahu se snaží oklamat algoritmy. Pravidla Googlu výslovně zakazují spamové taktiky a weby, které je používají, riskují manuální postihy nebo úplné vyřazení z výsledků vyhledávání.

Google používá **SpamBrain**, systém prevence spamu založený na umělé inteligenci, který nepřetržitě monitoruje weby z hlediska porušení zásad proti spamu. SpamBrain využívá algoritmy strojového učení k identifikaci vzorců spojených se spamem, včetně nepřirozených odkazových profilů, nadměrného používání klíčových slov, maskování obsahu a dalších klamavých technik. Systém analyzuje jak on-page, tak off-page faktory, signály uživatelského chování a metriky kvality obsahu, aby rozlišil legitimní obsah od spamu. Google také provádí manuální kontroly a přijímá uživatelská hlášení přes Search Console k identifikaci a penalizaci spamových webů.

Mezi hlavní spamové taktiky ve vyhledávačích patří **nadměrné používání klíčových slov** (přeplňování stránek klíčovými slovy), **maskování obsahu** (zobrazování odlišného obsahu vyhledávačům a uživatelům), **záludné přesměrování** (přesměrovávání uživatelů na jiné stránky, než vidí vyhledávače), **farmy odkazů** (sítě nekvalitních webů vytvořených pouze pro odkazování), **skrytý text a odkazy** (obsah neviditelný pro uživatele, ale viditelný pro crawlery) a **spam v komentářích** (automatizovaný spam v komentářích a fórech). Každá z těchto taktik se snaží manipulovat algoritmy vyhledávačů klamáním namísto poskytování skutečné hodnoty uživatelům.

Google uvaluje několik druhů postihů za spam ve vyhledávačích – od poklesů pozic až po úplné odstranění z indexu. Stránky mohou obdržet **manuální zásahy** přes Google Search Console, které označují konkrétní porušení, nebo mohou být ovlivněny algoritmickými aktualizacemi spamu, které automaticky sníží viditelnost. V závažných případech může být web zcela odstraněn z indexu Googlu a stát se neviditelným ve výsledcích vyhledávání. Obnova vyžaduje identifikaci a odstranění všech spamových prvků a následné zaslání žádosti o přehodnocení přes Search Console. Proces obnovy může trvat měsíce a některé výhody získané díky spamovým odkazům nelze získat zpět.

Spam ve vyhledávačích představuje významné výzvy pro vyhledávací systémy s umělou inteligencí, jako jsou **ChatGPT**, **Perplexity** a **Google AI Overviews**. Tyto systémy spoléhají na webový obsah při generování odpovědí a spamový obsah může znečistit jejich trénovací data nebo ovlivnit jejich výstupy. Platformy jako AmICited monitorují, kde se značky a domény objevují v AI odpovědích, a pomáhají organizacím sledovat, zda spam nebo nekvalitní obsah neovlivňuje jejich viditelnost. S rozšiřováním AI systémů je detekce spamu klíčová pro zajištění přesných a důvěryhodných informací pro uživatele.

Ano, weby se mohou z postihů za spam zotavit, ale proces vyžaduje komplexní nápravu. Provozovatelé musí identifikovat všechny spamové prvky – včetně nadměrného používání klíčových slov, nepřirozených odkazů, maskování obsahu a skrytého textu – a zcela je odstranit. Po vyčištění by měli podat žádost o přehodnocení přes Google Search Console s podrobnou dokumentací provedených změn. Obnova obvykle trvá několik měsíců, protože systémy Googlu potřebují čas na opětovné procházení a přehodnocení webu. Výhody, které byly získány díky spamovým odkazům, však již nelze obnovit a weby musí budovat autoritu legitimně prostřednictvím kvalitního obsahu a přirozeného získávání odkazů.

Monitorování spamu ve vyhledávačích je zásadní, protože spamový obsah může poškodit pověst značky a její viditelnost ve vyhledávání. Konkurenti mohou používat spamové taktiky cílené na vaši značku nebo může být váš web kompromitován a použit pro spam. Nástroje jako **AmICited** pomáhají organizacím sledovat zmínky o značce v AI vyhledávačích i tradičních vyhledávačích a identifikovat, zda se místo legitimních informací objevuje spam nebo nekvalitní obsah. Takové monitorování umožňuje včasnou detekci problémů se spamem a pomáhá udržovat integritu značky ve výsledcích vyhledávání i AI odpovědích.

Začněte sledovat, jak AI chatboti zmiňují vaši značku na ChatGPT, Perplexity a dalších platformách. Získejte užitečné informace pro zlepšení vaší AI prezence.

Detekce spamu identifikuje nechtěný, manipulativní obsah pomocí algoritmů strojového učení a behaviorální analýzy. Zjistěte, jak AI systémy filtrují spam v e-ma...

Zjistěte více o Google Link Spam Update, která znehodnocuje manipulativní zpětné odkazy. Pochopte, jak SpamBrain detekuje link spam, jaký má dopad na SEO a jaké...

Negativní SEO je praxe využívající neetické techniky k poškození pozic konkurentů. Zjistěte, jaké útoky hrozí, jak je rozpoznat a jak ochránit svůj web před sab...