Hvad AI Anser for Højkvalitetsindhold: Ud over Traditionelle Metrikker

Opdag hvordan AI-systemer vurderer indholdskvalitet ud over traditionelle SEO-metrikker. Lær om semantisk forståelse, faktuel nøjagtighed og kvalitetssignaler, ...

Opdag hvorfor datakvalitet betyder mere end mængde for AI-modeller. Lær strategier for ressourceallokering, omkostningsimplikationer og praktiske rammer for at optimere din investering i AI-træningsdata.

Den gængse opfattelse inden for maskinlæring har længe været, at “mere data altid er bedre.” Men nyere forskning udfordrer denne antagelse med overbevisende beviser for, at datakvalitet vægter langt tungere end mængde i forhold til AI-modellers præstation. Et arxiv-studie fra 2024 (2411.15821), der undersøgte små sprogmodeller, viste, at træningsdatakvalitet spiller en langt større rolle end den rene volumen, og afslører, at forholdet mellem datamængde og modelnøjagtighed er langt mere nuanceret end tidligere antaget. Omkostningerne er betydelige: Organisationer, der investerer tungt i dataindsamling uden at prioritere kvalitet, spilder ofte ressourcer på opbevaring, behandling og computerkraft, mens de oplever aftagende gevinster på modelpræstation.

Datakvalitet er ikke et entydigt begreb, men snarere en multidimensionel ramme, der omfatter flere centrale aspekter. Nøjagtighed henviser til, hvor korrekt data repræsenterer virkeligheden, og om labels er korrekt tildelt. Konsistens sikrer, at data følger ensartede formater og standarder på tværs af hele datasættet. Fuldstændighed måler, om al nødvendig information er til stede uden væsentlige huller eller manglende værdier. Relevans afgør, om data direkte adresserer det problem, AI-modellen er designet til at løse. Pålidelighed indikerer datakildens troværdighed og stabilitet over tid. Endelig repræsenterer støj uønskede variationer eller fejl, der kan vildlede modelleringen. Forståelsen af disse dimensioner hjælper organisationer med strategisk at prioritere deres dataudvælgelsesindsats.

| Kvalitetsdimension | Definition | Indvirkning på AI |

|---|---|---|

| Nøjagtighed | Korrekthed af labels og datarepræsentation | Påvirker direkte modellens forudsigelsesnøjagtighed; fejlmærkede data forårsager systematiske fejl |

| Konsistens | Ensartet formatering og standardiseret datastruktur | Muliggør stabil træning; inkonsekvenser forvirrer algoritmerne |

| Fuldstændighed | Tilstedeværelse af al nødvendig information uden huller | Manglende værdier reducerer effektiv træningsdata; påvirker generalisering |

| Relevans | Data adresserer direkte problemområdet | Meget relevant data overgår store mængder generisk data |

| Pålidelighed | Troværdighed af datakilder og stabilitet | Upålidelige kilder introducerer systematisk bias; påvirker robusthed |

| Støj | Uønskede variationer og målefejl | Kontrolleret støj øger robusthed; overdreven støj forringer præstation |

Jagten på store datamængder uden kvalitetssikring skaber en lang række problemer, der rækker langt ud over rene præstationsmålinger. Forskning af Rishabh Iyer viser, at eksperimenter med label-støj afslører dramatiske fald i nøjagtighed—fejlmærket data forringer aktivt modelpræstation snarere end blot at bidrage neutralt til træningen. Udover nøjagtighed står organisationer over for stigende opbevarings- og behandlingsomkostninger for datasæt, der ikke forbedrer resultaterne, samt betydelige miljøomkostninger fra unødvendigt computerforbrug. Medicinsk billedbehandling er et rystende eksempel: et datasæt med tusindvis af fejlmærkede røntgenbilleder kan træne en model, der selvsikkert begår farlige diagnosefejl, med risiko for patientens sikkerhed. Den falske økonomi ved at indsamle billig, lavkvalitetsdata bliver tydelig, når omkostninger til model-omtræning, fejlfinding og implementeringsfejl regnes med.

Domænespecifik kvalitet overgår konsekvent generisk volumen i praksisnære AI-applikationer. Forestil dig en sentimentklassifikator til film: Et nøje kurateret datasæt med 10.000 filmanmeldelser vil langt overgå et generisk sentimentdatasæt med 100.000 eksempler trukket fra finansnyheder, sociale medier og produktanmeldelser. Relevansen af træningsdata til det konkrete problemområde betyder langt mere end den rene mængde, da modeller lærer mønstre, der er specifikke for deres træningsfordeling. Når data mangler relevans for mål-applikationen, lærer modellen spuriøse sammenhænge og fejler i generalisering til virkelige brugssituationer. Organisationer bør prioritere mindre datasæt, der matcher problemområdet præcist, frem for at akkumulere store, generiske datasæt, der kræver omfattende filtrering og forbehandling.

Den optimale datastrategi ligger ikke i yderpunkterne, men i at finde “Guldhårs-zonen"—det punkt, hvor datamængde og kvalitet balanceres passende til det konkrete problem. For lidt data, selv hvis det er perfekt mærket, efterlader modellerne undertilpassede og ude af stand til at fange virkelighedens kompleksitet. Omvendt skaber for meget data med kvalitetsproblemer computer-spild og træningsinstabilitet. Arxiv-studiet illustrerer balancen konkret: minimal duplikering forbedrede nøjagtigheden med 0,87 % ved 25 % duplikering, mens overdreven duplikering ved 100 % førte til katastrofalt 40 % fald i nøjagtighed. Den ideelle balance afhænger af flere faktorer, herunder algoritmetype, problemkompleksitet, tilgængelige ressourcer og den naturlige variation i dit domæne. Datadistributionen bør afspejle den virkelige verdens variation snarere end at være kunstigt ensartet, da det lærer modellerne at håndtere den variation, de møder i produktion.

Ikke al ekstra data er lige god—forskellen mellem gavnlig forøgelse og skadelig forringelse er afgørende for en effektiv datastrategi. Kontrollerede forstyrrelser og forøgelseteknikker styrker modellens robusthed ved at lære algoritmer at håndtere virkelighedens variationer som lette rotationer, lysændringer eller mindre labelvariationer. MNIST-håndskrevne cifre illustrerer princippet: Modeller, der trænes med forøgede versioner (roterede, skalerede eller let forvrængede cifre), generaliserer bedre til håndskriftvariationer end modeller, der kun ser originalbilleder. Grov korruption—tilfældig støj, systematisk fejllabeling eller indsprøjtning af irrelevant data—nedbryder derimod præstationen og koster computerkraft. Den afgørende forskel er intentionen: forøgelse er tilsigtet og afspejler realistiske variationer, mens tilfældig data er vilkårlig støj, der forvirrer algoritmerne. Organisationer må kunne skelne mellem disse tilgange, når de udvider deres datasæt.

For organisationer med begrænsede ressourcer tilbyder aktiv læring en stærk løsning, der reducerer databehovet uden at gå på kompromis med modelpræstationen. I stedet for passivt at indsamle og mærke al tilgængelig data, identificerer aktiv lærings-algoritmer, hvilke uetiketterede eksempler der mest gavner modellens læring, og minimerer dermed den menneskelige mærkningsindsats. Denne tilgang gør det muligt at opnå stærk modelpræstation med væsentligt færre mærkede data ved at fokusere indsatsen på de mest betydningsfulde eksempler. Aktiv læring demokratiserer AI-udvikling ved at gøre det tilgængeligt for teams uden store mærkningsbudgetter, så de kan bygge effektive modeller med strategisk datavalgt fremfor rå volumen. Ved at lære effektivt med mindre data kan organisationer iterere hurtigere, sænke omkostninger og flytte ressourcer til kvalitetssikring fremfor endeløs dataindsamling.

Strategisk ressourceallokering kræver, at man grundlæggende prioriterer kvalitet over kvantitet i datastrategiske beslutninger. Organisationer bør investere i robuste datavaliderings-pipelines, der fanger fejl, før de sniger sig ind i træningsdatasæt, og implementere automatiske tjek for konsistens, fuldstændighed og nøjagtighed. Dataprofilværktøjer kan identificere kvalitetsproblemer i stor skala, afsløre mønstre i fejlmærkning, manglende værdier eller irrelevante eksempler, som bør håndteres før træning. Aktiv læring reducerer mængden af data, der kræver menneskelig gennemgang, mens de gennemsete eksempler er maksimalt informative. Kontinuerlig overvågning af modelpræstation i produktion afslører, om datakvalitetsproblemer resulterer i reelle fejl, hvilket muliggør hurtig feedback og forbedring. Den optimale strategi balancerer dataindsamling med grundig udvælgelse og erkender, at 1.000 perfekt mærkede eksempler ofte slår 100.000 støjende både på modelpræstation og totalomkostninger.

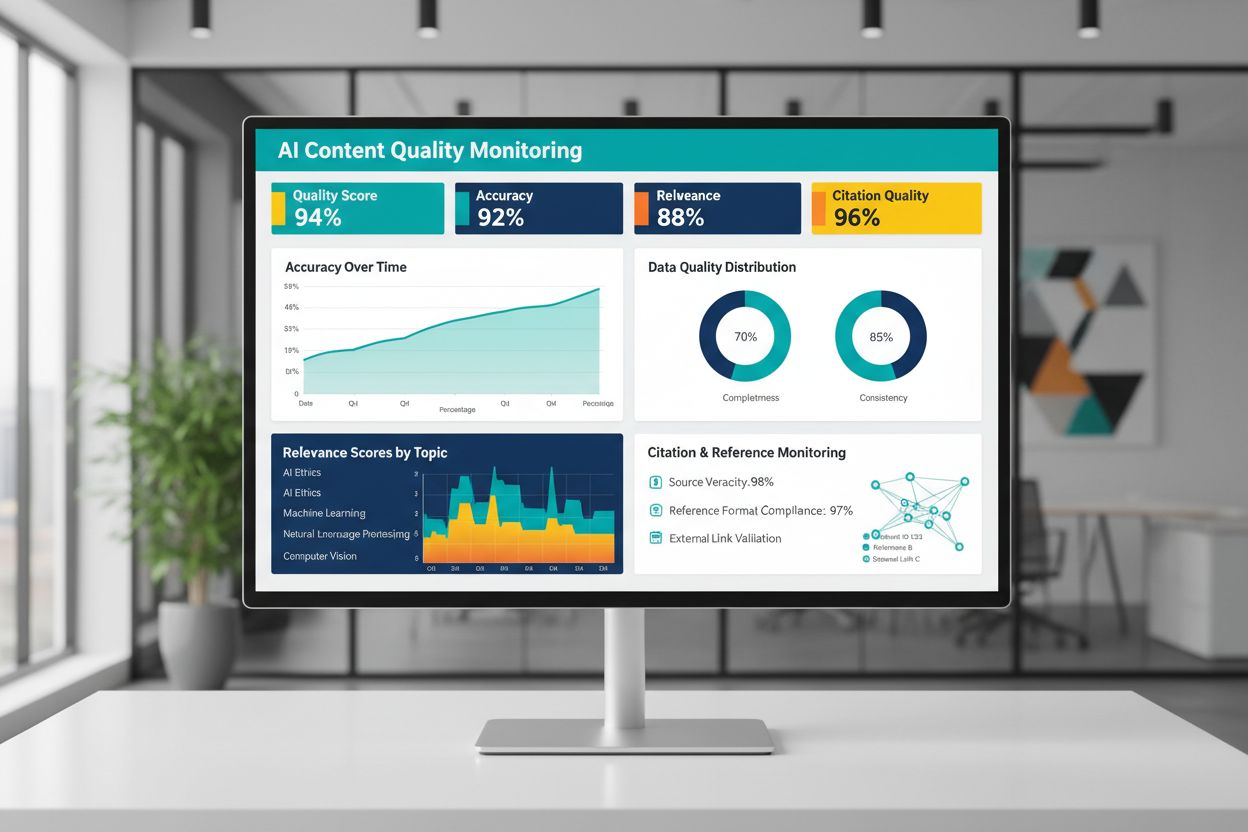

Kvaliteten af AI-genereret eller AI-trænet indhold afhænger grundlæggende af træningsdatakvaliteten, hvilket gør kontinuerlig overvågning af AI-outputs afgørende for at opretholde pålidelighed. Platforme som AmICited.com adresserer dette kritiske behov ved at overvåge AI-svar og spore citat-nøjagtighed—en direkte indikator for indholdskvalitet og troværdighed. Når AI-systemer trænes på data af lav kvalitet med dårlige referencer eller unøjagtig information, arver deres outputs disse fejl og kan sprede misinformation i stor skala. Overvågningsværktøjer bør spore ikke kun nøjagtighed, men også relevans, konsistens og tilstedeværelse af dokumentation for AI-systemernes påstande. Organisationer, der implementerer AI, skal etablere feedback-loops, der identificerer, når outputs afviger fra de forventede kvalitetsstandarder, så hurtig omtræning eller tilpasning af grunddata er mulig. Investeringen i overvågningsinfrastruktur betaler sig ved at fange kvalitetsforringelse tidligt, inden det påvirker brugere eller skader organisationens troværdighed.

At omsætte datakvalitetsprincipper til praksis kræver en struktureret tilgang, der starter med vurdering og fortsætter med måling og iteration. Start med at vurdere din nuværende baseline—forstå den eksisterende kvalitet af dine træningsdata via audits og profilering. Definér klare kvalitetsmål, der er tilpasset din konkrete brugssituation, hvad enten det er nøjagtighedstærskler, konsistensstandarder eller relevanskriterier. Implementér datagovernance-praksis, der fastlægger ejerskab, valideringsprocedurer og kvalitetsporte, før data kommer i træningspipelines. Begynd med mindre, nøje udvalgte datasæt i stedet for straks at behandle store volumener, så du kan etablere kvalitetsstandarder og processer i overskuelig skala. Mål forbedringer grundigt ved at sammenligne modelpræstation før og efter kvalitetsindsatser, så der skabes et evidensbaseret grundlag for fortsatte investeringer. Skalér gradvist, efterhånden som processerne forfines, og udvid dataindsamlingen først, når det er bevist, at kvalitetsforbedringer omsættes til reelle præstationsgevinster.

Nej. Ny forskning viser, at datakvalitet ofte betyder mere end mængde. Dårlig kvalitet, fejlmærket eller irrelevant data kan aktivt forringe modelpræstationen, selv i stor skala. Nøglen er at finde den rette balance mellem at have nok data til effektiv træning og samtidig opretholde høje kvalitetsstandarder.

Datakvalitet omfatter flere dimensioner: nøjagtighed (korrekte labels), konsistens (ensartet formatering), fuldstændighed (ingen manglende værdier), relevans (sammenhæng med dit problem), pålidelighed (troværdige kilder) og støjniveau. Definér metrikker specifikt til din brugssag og implementér valideringsporte, der fanger kvalitetsproblemer før træning.

Den ideelle størrelse afhænger af algoritmekompleksitet, problemtype og tilgængelige ressourcer. I stedet for at jagte maksimal størrelse, gå efter 'Guldhårs-zonen'—nok data til at opfange virkelighedens mønstre uden at blive tynget af irrelevante eller overflødige eksempler. Start småt med kurateret data og skalér gradvist baseret på præstationsforbedringer.

Dataforøgelse anvender kontrollerede forstyrrelser (rotationer, lette forvrængninger, lysvariationer), som bevarer den sande label, mens modellerne lærer at håndtere virkelighedens variationer. Dette adskiller sig fra tilfældig data—augmentation er tilsigtet og afspejler realistiske variationer, hvilket gør modellerne mere robuste mod driftsforhold.

Aktiv læring identificerer, hvilke uetiketterede eksempler der vil være mest informative for modellen at lære af, og reducerer dermed annoteringsbyrden markant. I stedet for at mærke al tilgængelig data, fokuserer du menneskelig indsats på de mest betydningsfulde eksempler og opnår stærk præstation med væsentligt mindre mærket data.

Prioritér kvalitet over mængde. Invester i datavaliderings-pipelines, profilværktøjer og governance-processer, der sikrer træningsdata af høj kvalitet. Forskning viser, at 1.000 perfekt mærkede eksempler ofte overgår 100.000 støjende i både modelpræstation og totalomkostninger.

Dårlig datakvalitet fører til flere omkostninger: model-omtræning, fejlfinding, implementeringsfejl, opbevaringsomkostninger og spildt computerkraft. I kritiske domæner som medicinsk billedbehandling kan træningsdata af lav kvalitet resultere i farlige fejl. Den falske økonomi ved billig, lavkvalitetsdata bliver tydelig, når de skjulte omkostninger medregnes.

Implementér løbende overvågning af AI-outputs, der sporer nøjagtighed, relevans, konsistens og kildekvalitet. Platforme som AmICited overvåger, hvordan AI-systemer refererer til information og sporer citat-nøjagtighed. Etabler feedback-loops, der forbinder produktionens præstation tilbage til træningsdatakvalitet for hurtig forbedring.

Følg med i, hvordan AI-systemer refererer til dit brand og sikr indholdets nøjagtighed med AmICiteds AI-overvågningsplatform. Forstå kvaliteten af AI-genererede svar om din virksomhed.

Opdag hvordan AI-systemer vurderer indholdskvalitet ud over traditionelle SEO-metrikker. Lær om semantisk forståelse, faktuel nøjagtighed og kvalitetssignaler, ...

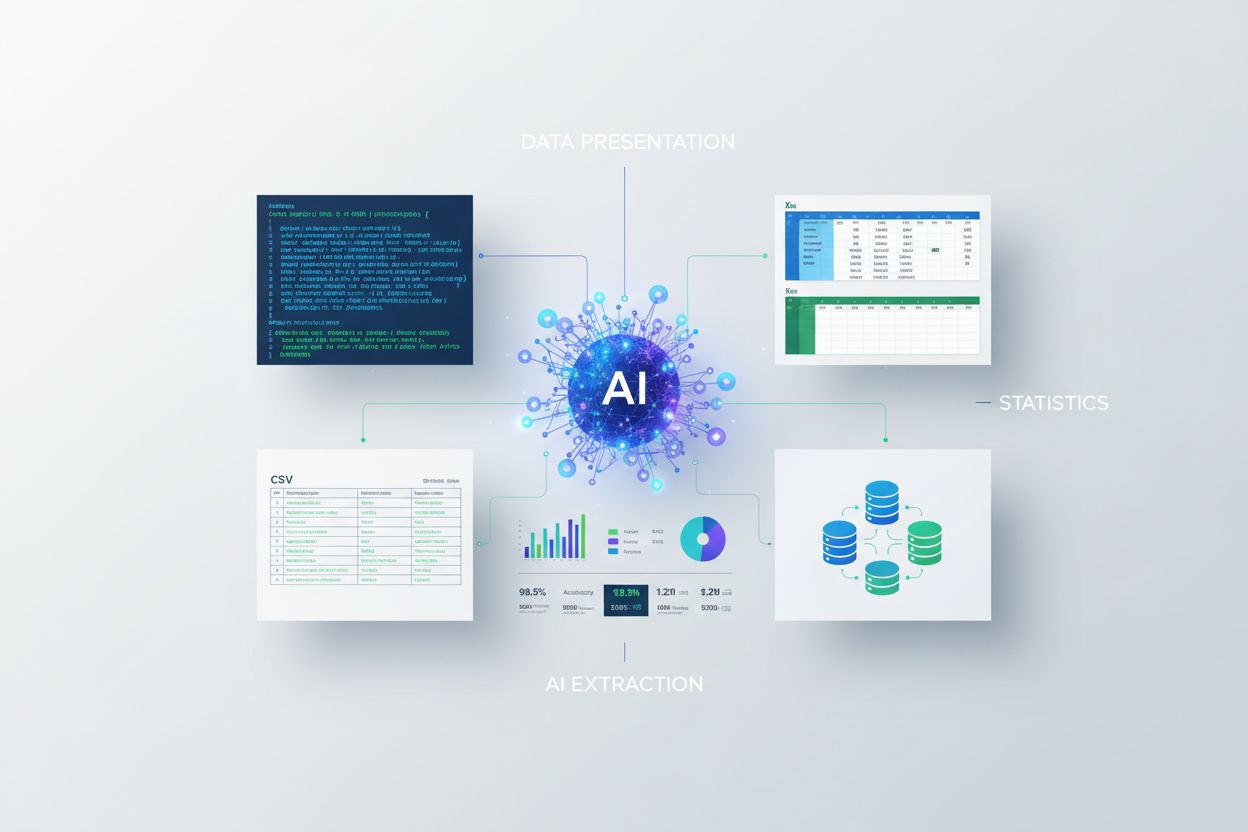

Lær hvordan du præsenterer statistik for AI-ekstraktion. Opdag bedste praksis for dataformatering, JSON vs CSV, og hvordan du sikrer at dine data er AI-klare ti...

Opdag hvorfor AI-trafik konverterer 23x bedre end organisk søgning. Lær at optimere til AI-platforme og mål reel ROI fra AI-drevne besøgende.