Udvikling af Promptbibliotek

Lær hvad udvikling af promptbibliotek er, og hvordan organisationer opbygger forespørgselskollektioner til at teste og overvåge brandets synlighed på tværs af A...

Lær hvordan du bygger og bruger prompt-biblioteker til manuel AI-synlighedstest. Gør-det-selv guide til at teste, hvordan AI-systemer henviser til dit brand på tværs af ChatGPT, Perplexity og Google AI.

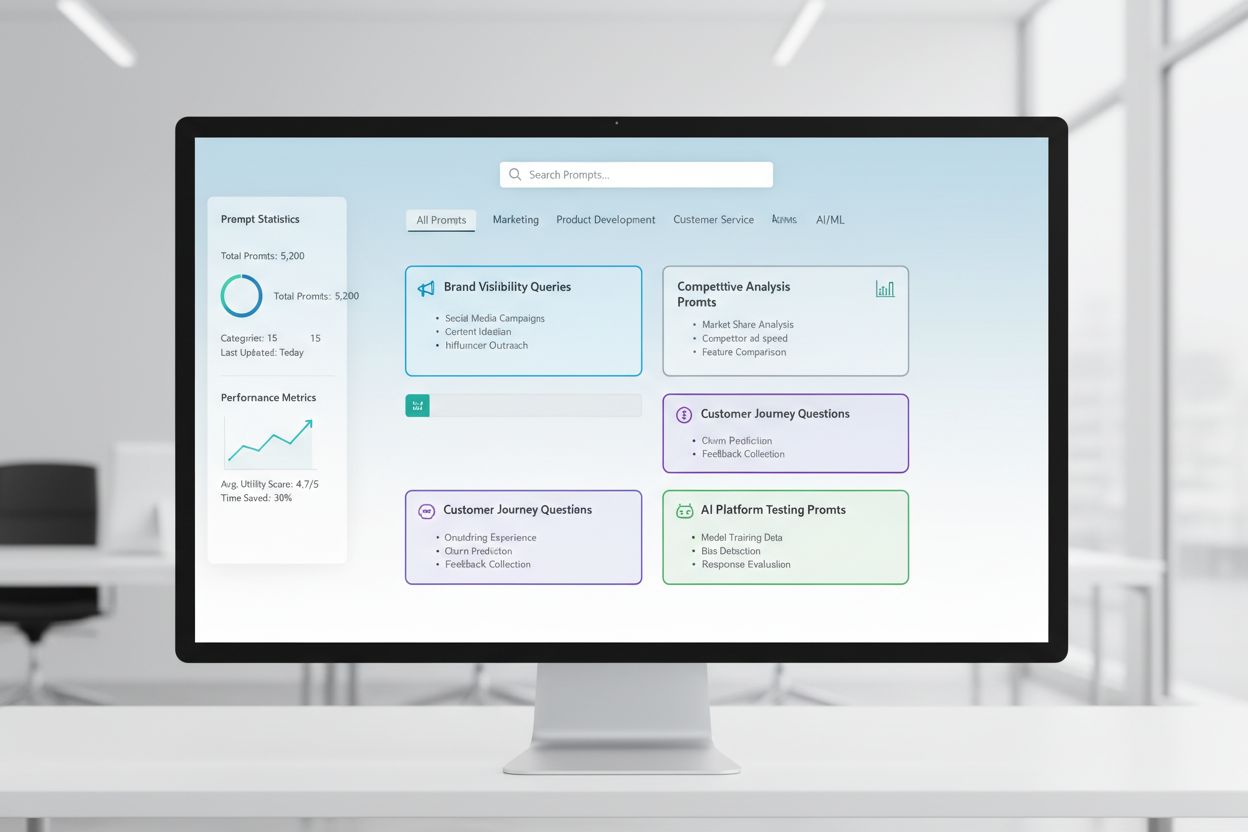

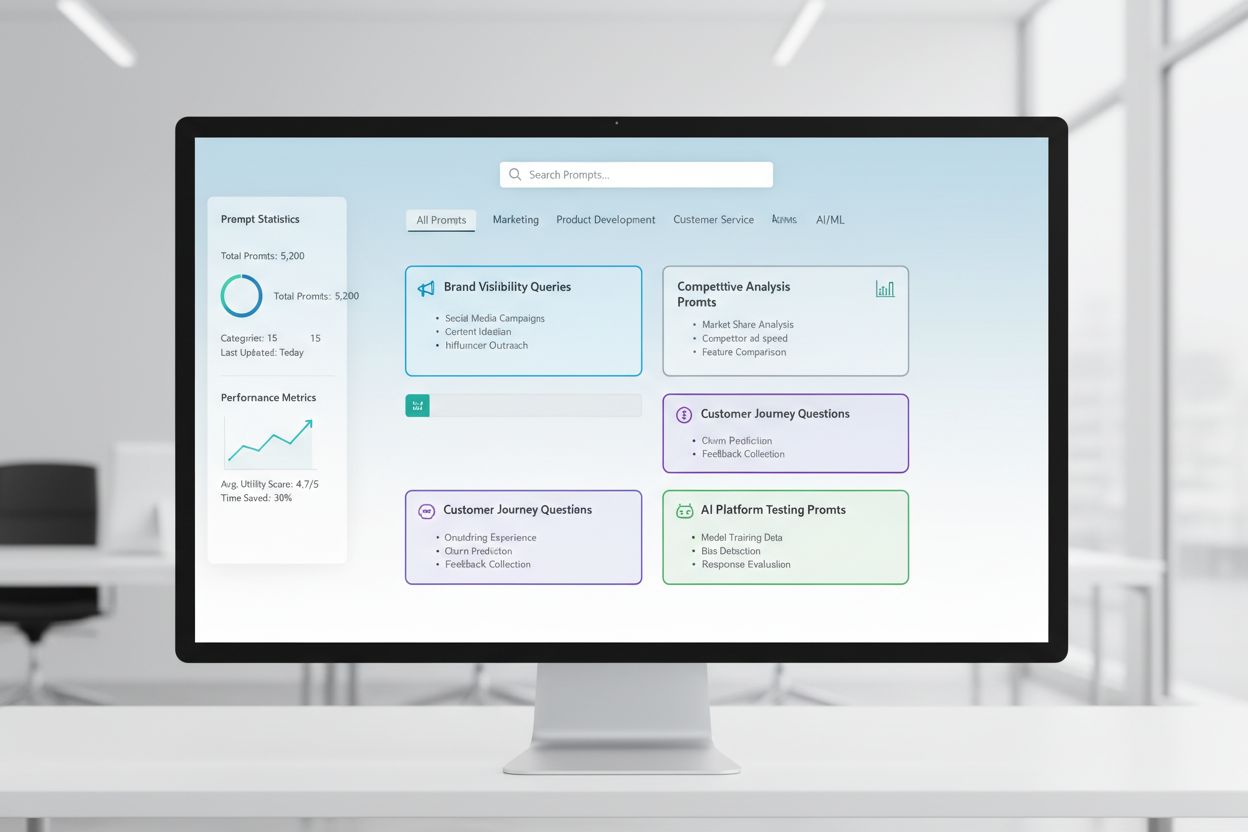

Et prompt-bibliotek er en kurateret, organiseret samling af testprompter, der er designet til systematisk at evaluere, hvordan AI-systemer reagerer på specifikke forespørgsler og scenarier. I konteksten af manuel AI-test fungerer disse biblioteker som dit grundlæggende værktøjssæt—et lager af omhyggeligt udformede prompter, der hjælper dig med at forstå præcis, hvordan forskellige AI-modeller håndterer dine brandnævnelser, citater, indholds-nøjagtighed og kontekstuel forståelse. AI-synlighedstest afhænger i høj grad af prompt-biblioteker, fordi de muliggør konsistent, gentagelig testning på tværs af flere platforme og tidsperioder, hvilket giver dig mulighed for at spore, hvordan dit indhold vises (eller ikke vises) i AI-genererede svar. I stedet for tilfældigt at teste med ad hoc-forespørgsler sikrer et velstruktureret prompt-bibliotek, at du systematisk dækker alle de scenarier, der er vigtige for din virksomhed, fra direkte brandsøgninger til indirekte kontekstuelle referencer. Denne strukturerede tilgang forvandler manuel testning fra en tilfældig proces til en strategisk, datadrevet metode, der afslører mønstre i AI-adfærd og hjælper dig med at forstå din faktiske synlighed på AI-landskabet.

Manuel AI-synlighedstest er den praktiske proces, hvor man direkte forespørger AI-systemer med forudbestemte prompter og nøje analyserer deres svar for at forstå, hvordan dit indhold, brand og citater bliver fremhævet eller udeladt. I modsætning til automatiserede overvågningssystemer, der kører kontinuerligt i baggrunden, giver manuel testning dig direkte kontrol over, hvad du tester, hvornår du tester det, og hvor dybt du analyserer resultaterne—hvilket gør det uvurderligt til udforskende test, forståelse af grænsetilfælde og undersøgelse af uventede AI-adfærd. Den væsentligste forskel ligger i arbejdets karakter: manuel testning er bevidst og undersøgende, så du kan stille opfølgende spørgsmål, teste variationer og forstå “hvorfor” bag AI-svarene, mens automatiseret overvågning udmærker sig ved konsistent, storskala sporing over tid. Manuel testning er især vigtig for AI-synlighed, fordi den hjælper dig med at fange nuancer, som automatiserede systemer kan overse—som om dit brand nævnes, men fejlagtigt tilskrives, om citater er nøjagtige men ufuldstændige, eller om kontekst forstås korrekt. Sådan sammenlignes disse tilgange:

| Aspekt | Manuel testning | Automatiseret overvågning |

|---|---|---|

| Omkostning | Lavere startinvestering; tidskrævende | Højere indledende opsætning; lavere løbende arbejde |

| Hastighed | Langsommere pr. test; øjeblikkelig indsigt | Langsommere at opsætte; hurtig, kontinuerlig sporing |

| Fleksibilitet | Meget fleksibel; let at dreje og udforske | Rigid; kræver foruddefinerede parametre |

| Nøjagtighed | Høj til kvalitativ analyse; underlagt menneskelig bias | Konsistent; fremragende til kvantitative målinger |

| Læringskurve | Minimal; alle kan starte testning | Stejlere; kræver teknisk opsætning og konfiguration |

Manuel testning udmærker sig, når du skal forstå hvorfor noget sker, mens automatiseret overvågning udmærker sig ved at spore hvad der sker i stor skala.

En robust struktur for prompt-bibliotek bør organiseres omkring de vigtigste dimensioner i din AI-synlighedsstrategi, hvor hver komponent tjener et specifikt testformål. Dit bibliotek bør indeholde prompter, der tester forskellige aspekter af, hvordan AI-systemer opdager og fremhæver dit indhold, og sikre en omfattende dækning af dit synlighedslandskab. Her er de væsentlige komponenter, ethvert prompt-bibliotek bør indeholde:

Når du bygger din teststrategi, skal du bruge prompter, der specifikt retter sig mod de dimensioner af AI-synlighed, der er vigtigst for din virksomhed—brandnævnelser, citeringsnøjagtighed og kontekstuel forståelse. De mest effektive testprompter er dem, der afspejler reel brugeradfærd og samtidig isolerer de specifikke variabler, du vil måle. For testprompter med fokus på brandnævnelser vil du have variationer, der tester direkte søgninger, indirekte referencer og komparative sammenhænge. Test af citeringsnøjagtighed kræver prompter, der naturligt udløser citater, og derefter variationer, der tester, om AI-systemet korrekt tilskriver information til dine kilder. Her er eksempler på prompter, du kan tilpasse til din egen testning:

"Hvad er de seneste udviklinger inden for [din branche]?

Angiv venligst dine kilder."

"Sammenlign [dit produkt] med [konkurrentens produkt].

Hvad er de vigtigste forskelle og fordele ved hver?"

"Forklar [dit ekspertiseområde].

Hvem er de førende eksperter eller virksomheder på dette område?"

Disse prompter er designet til naturligt at udløse de typer svar, hvor din synlighed betyder mest—når AI-systemer leverer information, laver sammenligninger eller identificerer autoritative kilder. Du kan lave variationer ved at ændre specificitetsniveau (bred vs. snæver), tilføje begrænsninger (kun nylig information, specifikke anvendelsestilfælde) eller ændre citeringskravene (med kilder, med links, med forfatternavne). Det vigtigste er ikke blot at teste, om dit indhold vises, men hvordan det vises og i hvilken kontekst, hvilket kræver prompter, der skaber realistiske scenarier, hvor din synlighed naturligt demonstreres.

Din AI-synlighedsstrategi skal tage højde for, at forskellige AI-platforme—ChatGPT, Perplexity, Google AI Overviews, Claude og andre—har fundamentalt forskellig træningsdata, hentemekanismer og svargenereringsmetoder, hvilket betyder, at din synlighed varierer markant på tværs af platforme. Test på tværs af platforme er afgørende, fordi en prompt, der viser dit indhold tydeligt i ét AI-system, kan give helt andre resultater i et andet, og forståelsen af disse platformspecifikke mønstre er essentiel for at udvikle en omfattende synlighedsstrategi. Når du tester på tværs af platforme, vil du bemærke, at Perplexity med sin realtids-søgeintegration ofte fremhæver nyere indhold og inkluderer flere eksplicitte citater end ChatGPT, som er afhængig af træningsdata med en videns-afskæring. Google AI Overviews, der er integreret direkte i søgeresultater, opererer under andre synlighedsregler og kan prioritere andre kilder end konverserende AI-systemer. Den praktiske tilgang er at vedligeholde et sæt kerneprompter, som du kører på alle platforme på en fastlagt tidsplan, så du ikke bare kan spore, om dit indhold vises, men hvor det vises, og hvordan platformsforskelle påvirker din synlighed. Dette tværplatformsperspektiv afslører, om dine synlighedsudfordringer er universelle (påvirker alle platforme) eller platformspecifikke (kræver målrettede strategier for bestemte systemer), hvilket fundamentalt ændrer, hvordan du bør gribe optimering an.

Effektiv testdokumentation forvandler rå testdata til handlingsorienteret indsigt, og det organisationssystem, du vælger, afgør, om dine testindsatser vokser i værdi over tid eller forbliver isolerede datapunkter. Den mest praktiske metode er at bruge et struktureret regneark eller dokumentationssystem, der ikke bare indfanger resultaterne, men også konteksten—inklusive den præcise prompt, der blev brugt, datoen for testen, den testede platform, hele AI-svaret og din analyse af, om dit indhold optrådte, og hvordan det blev præsenteret. Dit resultatsporingssystem bør indeholde kolonner for: promptkategori (brand, konkurrent, branche osv.), testet platform, om dit indhold optrådte, citeringsnøjagtighed (hvis relevant), position i svaret (første nævnelse, understøttende bevis osv.) og eventuelle kvalitative noter om svar-kvalitet eller relevans. Ud over de rå data skal du oprette skabeloner til almindelige testscenarier, så din dokumentation forbliver konsekvent over tid, hvilket gør det lettere at spotte trends og ændringer i AI-adfærd. Dokumentér ikke kun succeser, men også fejl og afvigelser—disse afslører ofte de vigtigste indsigter om, hvordan AI-systemer fungerer, og hvor din synlighedsstrategi skal justeres. Ved at opretholde denne disciplin i testmetodologi skaber du en historisk optegnelse, der viser, hvordan din synlighed har udviklet sig, hvilke ændringer i AI-systemer der har påvirket dine resultater, og hvilke optimeringsindsatser der faktisk har flyttet nålen.

Manuel AI-synlighedstest er sårbar over for flere systematiske fejl, der kan underminere dine resultater og føre til forkerte konklusioner om din faktiske synlighed. Den mest almindelige faldgrube er inkonsekvent formulering af prompter—at teste det samme koncept med lidt forskellig ordlyd hver gang, hvilket introducerer variabler, der gør det umuligt at spore, om ændringer i resultater skyldes AI-systemændringer eller dine egne testvariationer. For at undgå dette skal du oprette et hovedprompt-dokument, hvor hver prompt er låst og bruges identisk på tværs af alle testrunder; hvis du vil teste variationer, skal du oprette separate prompt-varianter med klare navngivningskonventioner. En anden kritisk fejl er utilstrækkelige stikprøvestørrelser og hyppighed—at teste én gang og drage konklusioner, i stedet for at erkende, at AI-svar kan variere afhængigt af tidspunkt, systembelastning og andre faktorer. Fastlæg en regelmæssig testkadence (ugentlig, to-ugentlig eller månedlig afhængig af dine ressourcer), og test hver prompt flere gange for at identificere mønstre frem for afvigelser. Bekræftelsesbias er en subtil men farlig faldgrube, hvor testere ubevidst tolker tvetydige resultater som bekræftelse af deres forventninger; imødegå dette ved at lade flere teammedlemmer gennemgå resultater uafhængigt og dokumentere objektive kriterier for, hvad der tæller som “dit indhold optræder.” Undgå også fejlen at teste i isolation—notér altid dato, tidspunkt og eventuelle kendte AI-systemopdateringer under test, for forståelsen af resultaternes kontekst er afgørende for fortolkning. Endelig betyder dårlig dokumentation af metode, at du ikke kan genskabe din test eller forklare dine resultater for interessenter; dokumentér altid præcist, hvordan du testede, hvad du målte, og hvordan du fortolkede resultater, så din testning er reproducerbar og forsvarlig.

Når din organisation vokser, og din AI-synlighedsstrategi bliver mere sofistikeret, skal du skalere fra individuel, ad hoc-testning til en struktureret teamtest-tilgang, der fordeler arbejdsbyrden, mens konsistens og kvalitet opretholdes. Nøglen til succesfuld skalering er at skabe klare testprotokoller og rolleafgrænsninger—udpeg, hvem der ejer hvilke platforme, hvilke promptkategorier og hvilke analyseansvar, så testningen bliver en koordineret teamindsats frem for dobbeltarbejde. Implementér en delt testkalender, hvor teammedlemmer kan se, hvad der er testet, hvornår og af hvem, hvilket forhindrer redundant testning og sikrer fuld dækning. Opret en test-tjekliste eller køreplan, som ethvert teammedlem kan følge for at udføre tests konsistent, inklusive specifikke instruktioner om, hvordan resultater dokumenteres, hvad man skal kigge efter i svarene, og hvordan man markerer afvigelser eller interessante fund. Samarbejdsværktøjer som delte regneark, projektstyringssystemer eller dedikerede testplatforme hjælper med at koordinere indsatser på tværs af teammedlemmer og skabe én samlet sandhedskilde for dine testdata. Når du skalerer, bør du overveje at rotere testansvar, så flere personer forstår din testmetodologi og kan bidrage, hvilket reducerer afhængigheden af enkeltpersoner. Regelmæssige teammøder, hvor I gennemgår testresultater, diskuterer fund og justerer jeres teststrategi baseret på erfaringer, sikrer, at den skalerede testindsats forbliver koordineret og strategisk i stedet for at blive en samling af løsrevne opgaver.

De mest avancerede AI-synlighedsstrategier anerkender, at manuelle og automatiserede tilgange supplerer hinanden snarere end konkurrerer, hvor hver metode udmærker sig i forskellige sammenhænge og tilsammen giver fuld synlighedsdækning. Manuel testning er dit undersøgende værktøj—her udforsker du, forstår nuancer, tester hypoteser og får dyb indsigt i, hvordan AI-systemer fungerer, og hvorfor din synlighed varierer på tværs af platforme og scenarier. Automatiserede overvågningsværktøjer som AmICited udmærker sig ved konsistent, storskala sporing over tid, hvor de kontinuerligt overvåger din synlighed på tværs af flere AI-platforme og advarer dig om ændringer, trends og afvigelser, som det ville være umuligt at fange manuelt. Den praktiske integrationsstrategi er at bruge manuel testning til at udvikle din testramme, forstå hvad der er vigtigt og undersøge afvigelser, mens du bruger automatiseret overvågning til kontinuerligt at spore de vigtige målepunkter og advare dig, når noget ændrer sig. For eksempel kan du manuelt teste en ny promptkategori for at forstå, hvordan AI-systemer reagerer, og når du har valideret, at det er en meningsfuld test, kan du tilføje den til din automatiske overvågning, så du får løbende sporing uden løbende manuelt arbejde. AmICited og lignende overvågningsværktøjer håndterer det rutineprægede, tidskrævende arbejde med at køre tests i en skala og hyppighed, der ville være upraktisk manuelt, og frigør dit team til at fokusere på højere værdiopgaver som analyse, strategi og optimering. Den ideelle arbejdsgang er: brug manuel testning til at opbygge dit prompt-bibliotek og din teststrategi, validér din tilgang og undersøg specifikke spørgsmål; brug automatiseret overvågning til kontinuerligt at spore dine vigtigste synlighedsmålepunkter; og brug indsigterne fra den automatiserede overvågning til at beslutte, hvad du skal teste manuelt næste gang. Denne integrerede tilgang sikrer, at du ikke bare tester manuelt i blinde, men opbygger en omfattende synlighedsstrategi, der kombinerer dybden af manuel undersøgelse med skalaen og konsistensen fra automatiseret overvågning.

Et prompt-bibliotek er en kurateret, organiseret samling af testprompter, der er designet til systematisk at evaluere AI-systemer på tværs af flere dimensioner. I modsætning til en enkelt prompt-skabelon indeholder et bibliotek snesevis af prompter organiseret efter kategori (brandnævnelser, konkurrent-sammenligninger, citater osv.), hvilket gør det muligt for dig at udføre omfattende test i stedet for isolerede tjek. Prompt-biblioteker er versioneret, dokumenteret og designet til genbrug og skalering på tværs af dit team.

Hyppigheden afhænger af dine ressourcer og hvor dynamisk din branche er. De fleste organisationer har fordel af ugentlig eller to-ugentlig test af kerneprompter for at fange væsentlige ændringer, med månedlige dybdegående tests af hele prompt-biblioteket. Hvis du er i en hurtigt bevægende branche eller for nylig har udgivet større indhold, bør du øge hyppigheden til ugentligt. Kombiner manuel testning med automatiserede overvågningsværktøjer som AmICited for kontinuerlig sporing mellem manuelle testcyklusser.

Ja, du bør bruge de samme kerneprompter på tværs af platforme for at sikre konsistens og sammenlignelighed. Du kan dog have brug for platformspecifikke variationer, fordi forskellige AI-systemer (ChatGPT, Perplexity, Google AI Overviews) har forskellige grænseflader, citeringsmekanismer og svarformater. Test dine kerneprompter identisk på tværs af platforme, og lav derefter platformspecifikke variationer for at tage hensyn til unikke funktioner eller begrænsninger i hvert system.

Spor om dit indhold vises (ja/nej), hvor det vises i svaret (første nævnelse, understøttende bevis osv.), citeringsnøjagtighed (hvis citeret) og svar-kvalitet. Dokumenter også datoen for testen, platformen, den præcise prompt der blev brugt, og eventuelle kvalitative observationer om, hvordan dit indhold blev præsenteret. Over tid afslører disse målepunkter mønstre i din synlighed og hjælper dig med at forstå, hvilke optimeringsindsatser der faktisk gør en forskel.

Din testning er omfattende, når du dækker alle hoveddimensioner af din synlighed: direkte brandsøgninger, konkurrent-sammenligninger, brancherelaterede emner, citeringsnøjagtighed og kontekstuel forståelse. En god tommelfingerregel er 20-30 kerneprompter, som du tester regelmæssigt, plus yderligere prompter til specifikke undersøgelser. Hvis du konsekvent opdager nye indsigter fra manuel testning, har du sandsynligvis brug for flere prompter. Hvis resultaterne bliver forudsigelige, er din dækning sandsynligvis tilstrækkelig.

For små organisationer eller indledende test kan du starte med interne ressourcer ved hjælp af gør-det-selv metoden beskrevet i denne guide. Når din testning vokser, bliver dedikerede ressourcer dog værdifulde. Overvej at ansætte eller udpege en person til at administrere dit prompt-bibliotek og udføre regelmæssige tests, hvis du har flere produkter, opererer i en konkurrencepræget branche eller har behov for hyppige testcyklusser. Alternativt kan du kombinere intern testning med automatiserede overvågningsværktøjer som AmICited for at fordele arbejdsbyrden.

Manuel testning er undersøgende og fleksibel—du styrer, hvad du tester, og kan udforske nuancer og grænsetilfælde. Automatiserede overvågningsværktøjer som AmICited kører kontinuerligt, sporer din synlighed på tværs af flere AI-platforme i stor skala og advarer dig om ændringer. Den ideelle tilgang kombinerer begge dele: Brug manuel testning til at udvikle din teststrategi og undersøge specifikke spørgsmål, mens automatiseret overvågning bruges til kontinuerlig sporing af nøglemålepunkter.

Du kan automatisere udførelsen af prompter ved hjælp af API'er (OpenAI, Anthropic osv.) til at sende dine prompter til AI-systemer og fange svar programmatisk. Analysen forbliver dog typisk manuel, fordi forståelse af kontekst og nuancer kræver menneskelig vurdering. Du kan også automatisere dokumentation og resultatsporing ved hjælp af regneark eller databaser. Den mest praktiske tilgang er at bruge automatiserede overvågningsværktøjer som AmICited til det rutineprægede arbejde, mens manuel testning reserveres til dybere analyse og undersøgelser.

Mens manuel testning er værdifuld, sikrer automatiseret overvågning kontinuerlig synlighed på tværs af alle AI-platforme. AmICited sporer, hvordan AI-systemer henviser til dit brand i realtid.

Lær hvad udvikling af promptbibliotek er, og hvordan organisationer opbygger forespørgselskollektioner til at teste og overvåge brandets synlighed på tværs af A...

Lær hvordan du opretter og organiserer et effektivt prompt-bibliotek for at spore dit brand på tværs af ChatGPT, Perplexity og Google AI. Trin-for-trin guide me...

Lær hvordan du tester din brands tilstedeværelse i AI-motorer med prompttestning. Opdag manuelle og automatiserede metoder til at overvåge AI-synlighed på tværs...