Data-drevet PR: Skab forskning, som AI ønsker at citere

Lær, hvordan du skaber original forskning og datadrevet PR-indhold, som AI-systemer aktivt citerer. Opdag de 5 egenskaber ved indhold, der er værd at citere, sa...

Lær hvordan proprietære undersøgelsesdata og originale statistikker bliver citatmagneter for LLM’er. Opdag strategier til at forbedre AI-synlighed og få flere citationer fra ChatGPT, Perplexity og Google AI Overviews.

Large Language Models opfinder ikke data – de henter dem fra verificerbare kilder. Når dit team publicerer unikke statistikker eller originale metoder, ejer I midlertidigt denne viden og giver LLM’er grund til at citere jer for at validere deres svar. Dette er fundamentet for det, IDX kalder “Autoritetens Flywheel”: et system, hvor proprietær forskning bliver jeres mest kraftfulde citatmagnet.

Mekanikken er enkel: AI-modeller vurderer kilder ud fra, om de kan verificere udsagn via flere kanaler. Når du udgiver original forskning, skaber du et vidensaktiv, der ikke findes andre steder på nettet. Denne unikhed tvinger LLM’er til at citere din kilde, hvis de vil inkludere disse data i deres svar. En kampagne for The Zebra, en forsikringsplatform, viser dette perfekt – kombinationen af proprietær forskning og Digital PR gav over 1.580 kvalitetsmedielinks og en stigning i organisk trafik på 354 %.

Ifølge ny forskning identificerede 48,6 % af SEO-eksperter Digital PR som den mest effektive link-building taktik for 2025. Men den reelle styrke ligger i, hvad der sker bagefter: Når dine proprietære data spredes på tværs af forskellige, højt rangerede domæner via Digital PR, bekræfter det din autoritet i flere viden-netværk samtidig. Denne multikanal-validering er præcis, hvad LLM’er leder efter, når de skal beslutte, om de vil citere dit brand.

Den vigtigste indsigt: Proprietære data skaber det, forskere kalder “midlertidigt vidensejerskab”. I modsætning til generisk indhold, der konkurrerer med tusinder af lignende artikler, er din originale forskning den eneste kilde til de specifikke data. Dette gør det mere sandsynligt, at LLM’er citerer dig, fordi det er den eneste måde at få informationen med i deres svar.

At forstå, hvordan LLM’er faktisk henter og udvælger kilder, er afgørende for at optimere til citationer. Disse systemer fungerer ikke som traditionelle søgemaskiner. I stedet arbejder de via to forskellige vidensveje: parametrisk hukommelse (viden lagret under træning) og hentet viden (real-time information hentet via Retrieval-Augmented Generation, RAG).

Parametrisk viden repræsenterer alt, hvad en LLM “ved” fra pre-træning. Denne viden er statisk og fastsat ved modellens trænings-cutoff. Ca. 60 % af ChatGPT-forespørgsler besvares udelukkende fra parametrisk viden uden at udløse websearch. Entiteter nævnt ofte på autoritative kilder under træning får stærkere neurale repræsentationer og bliver lettere husket. Wikipedia indhold udgør ca. 22 % af store LLM-træningsdata, hvilket forklarer, hvorfor Wikipedia-citationer er så almindelige i AI-genererede svar.

Hentet viden fungerer anderledes. Når en LLM har brug for aktuelle informationer, bruger den RAG-systemer, der kombinerer semantisk søgning (tætte vektorer) med keyword matching (BM25) via Reciprocal Rank Fusion. Forskning viser, at hybrid retrieval giver 48 % forbedring over enkeltmetode-tilgange. Systemet omrangerer derefter resultaterne med cross-encoder modeller, før de bedste 5-10 bidder indsættes i LLM’ens prompt som kontekst.

| Signal | Traditionel SEO-prioritet | LLM-citationsprioritet | Hvorfor det betyder noget |

|---|---|---|---|

| Domæneautoritet | Høj (kernefaktor) | Svag/neutral | LLM’er vægter indholdsstruktur over domænestyrke |

| Backlink-mængde | Høj (primært signal) | Svag/neutral | LLM’er vurderer kildetroværdighed anderledes |

| Indholdsstruktur | Medium | Kritisk | Klare overskrifter og svarblokke er essentielle for udtræk |

| Proprietære data | Lav | Meget høj | Unikke oplysninger tvinger citation |

| Brandets søgevolumen | Lav | Højeste (0,334 korrelation) | Indikerer reel autoritet og efterspørgsel |

| Aktualitet | Medium | Høj | LLM’er foretrækker nyligt opdateret indhold |

| E-E-A-T-signaler | Medium | Høj | Forfatterkredentialer og gennemsigtighed tæller |

Den afgørende forskel: LLM’er rangerer ikke sider – de udtrækker semantiske bidder. En side med dårlige traditionelle SEO-målinger, men krystalklar struktur og proprietære data, kan overgå en autoritetsside med vage formuleringer. Denne fundamentale ændring betyder, at din citatstrategi skal prioritere maskinlæsbarhed og klarhed i indhold over traditionelle link-building-målinger.

De metrics, der betyder noget for AI-synlighed, har fundamentalt ændret sig fra traditionelle SEO-signaler. I to årtier var domæneautoritet, backlinks og keywordrangeringer succeskriterierne. I 2025 er disse metrics næsten irrelevante for LLM-citationer. I stedet er der opstået et nyt hierarki baseret på, hvordan AI-systemer faktisk vurderer og vælger kilder.

Brandets søgevolumen er nu den stærkeste indikator for LLM-citationer, med en korrelationskoefficient på 0,334 – markant højere end nogen traditionel SEO-metric. Det giver intuitiv mening: Hvis millioner søger dit brandnavn, signalerer det reel autoritet og efterspørgsel. LLM’er genkender dette signal og vægter det tungt, når de skal beslutte, om de vil citere dig. Samtidig har backlinks svag eller neutral sammenhæng med AI-citationer, hvilket modsiger årtiers SEO-visdom.

Skiftet gælder også indholdsvurdering. At tilføje statistik til dit indhold øger AI-synlighed med 22 %. Inkludering af citater øger synlighed med 37 %. Original forskning citeres 3x oftere end generisk indhold. Dette er ikke marginale forbedringer – de repræsenterer fundamentale ændringer i, hvordan LLM’er vurderer kildekvalitet.

| Metrik | Tidligere fokus (før 2024) | Nyt fokus (2025+) | Indvirkning på LLM-citationer |

|---|---|---|---|

| Linkkvalitetsindikator | Domæneautoritetsscore (DA/DR) | Emnerelevans & redaktionel kontekst | Grounding og kildediversitet |

| Anchor text-strategi | Exact match keywords | Brand-/entitetsomtaler | Entitetsgenkendelse og konsistens |

| Indholdstype | Gæsteindlæg (volumen) | Original forskning/datajournalistik | 3x højere sandsynlighed for citation |

| Målmåling | Rangstigning | Citationsrate i AI Overviews | Troværdighed og autoritetsvalidering |

| Outreach-tilgang | Opnå links | Relationsopbygning/levering af værdi | Højere redaktionel kvalitet |

Matrixen afslører en afgørende indsigt: De brands, der vinder AI-synlighed, er ikke nødvendigvis dem med flest backlinks eller højest domæneautoritet. Det er brands, der skaber original forskning, opretholder konsistente brandsignaler og publicerer indhold struktureret til maskinudtræk. Konkurrencefordelen er flyttet fra linkmængde til indholdskvalitet og -unikhed.

Proprietære undersøgelsesdata spiller en unik rolle i AI-synlighedsstrategi. I modsætning til generiske branchedatarapporter, som LLM’er kan finde flere steder, kan dine originale undersøgelsesdata kun citeres fra din hjemmeside. Det giver en citatfordel, som konkurrenterne ikke kan kopiere, uanset hvor stærk deres backlink-profil er.

Undersøgelsesdata virker, fordi de leverer det, LLM’er kalder “grounding” – verificerbare beviser, der validerer udsagn. Når du siger, at “78 % af marketingchefer prioriterer AI-synlighed”, kan LLM’er citere din undersøgelse som bevis. Uden disse proprietære data ville samme udsagn være spekulativt, og LLM’er ville enten udelade det eller citere en konkurrents forskning i stedet.

De mest effektive undersøgelsesdata adresserer specifikke spørgsmål, din målgruppe stiller:

Effekten er målbar. Forskning viser, at tilføjelse af statistik øger AI-synlighed med 22 %, mens citater øger synlighed med 37 %. Original forskning citeres 3x oftere end generisk indhold. Disse multiplikatorer forstærkes, når du kombinerer flere typer proprietære data i et enkelt indholdsaktiv.

Nøglen er gennemsigtighed. LLM’er vurderer metode lige så nøje som resultater. Hvis din undersøgelsesmetode er solid, stikprøvestørrelsen er tilstrækkelig, og fundene præsenteres ærligt (også begrænsninger), vil LLM’er citere dig trygt. Hvis metode er vag eller resultater virker udvalgte, nedprioriterer LLM’er din kilde til fordel for mere gennemsigtige konkurrenter.

At publicere proprietære data er kun halvdelen af opgaven. Den anden halvdel er at strukturere dataene, så LLM’er let kan udtrække og citere dem. Indholdsarkitektur betyder lige så meget som selve dataene.

Start med direkte svar. LLM’er foretrækker indhold, der går direkte til svaret, ikke rejsen. I stedet for “Vi gennemførte en undersøgelse for at forstå marketingprioriteter, og her er hvad vi fandt”, skriv “78 % af marketingchefer prioriterer nu AI-synlighed i deres 2025-strategi.” Denne direkte struktur gør udtræk lettere og øger sandsynligheden for citation.

Optimal afsnitslængde for LLM-udtræk er 40-60 ord. Denne længde gør det muligt for LLM’er at hente en komplet tanke uden afbrydelse. Længere afsnit bliver delt op, hvilket kan koste kontekst. Kortere afsnit kan mangle nok information til at være brugbare.

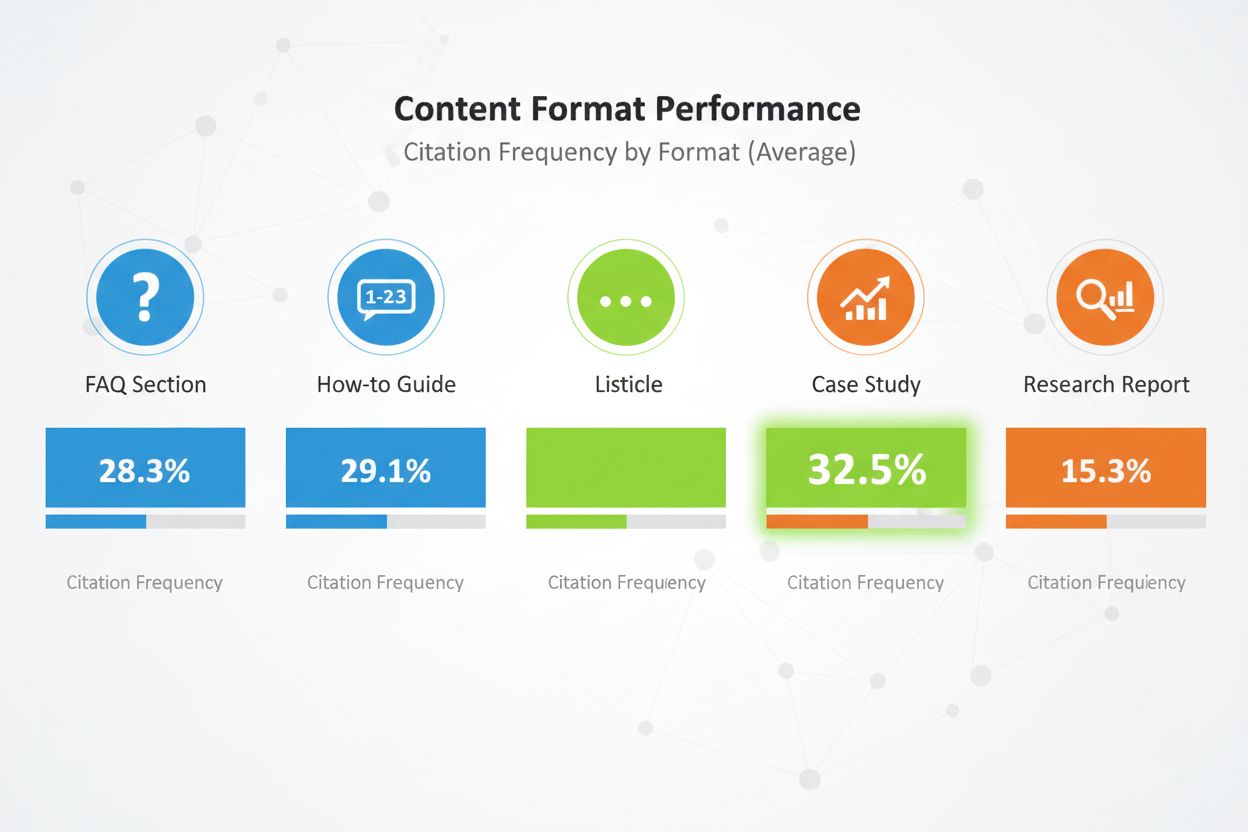

Indholdsformater betyder meget. Sammenlignende lister får 32,5 % af alle AI-citationer – højeste andel blandt formater. FAQ-sektioner klarer sig exceptionelt godt, fordi de matcher måden brugere spørger AI-systemer på. How-to-guides, casestudier og forskningsrapporter klarer sig også godt, men lister overgår konsekvent andre formater.

Strukturer indholdet med klar overskrifts-hierarki. Brug H2-overskrifter, der matcher sandsynlige søgeforespørgsler. Under hver H2, brug H3 for underemner. Dette hierarki hjælper LLM’er med at forstå indholdsstrukturen og udtrække relevante sektioner.

Implementer E-E-A-T-signaler overalt. Inkludér forfatterbiografier med kredentialer og reel erfaring. Link til tredjepartsvalidering af dine udsagn. Vær gennemsigtig om metode. Citer dine kilder. Disse signaler fortæller LLM’er, at dit indhold er troværdigt og værd at citere.

Brug semantisk HTML overalt. Strukturer data med korrekte <table>, <ul> og <ol> tags i stedet for CSS-styrede divs. Dette gør dit indhold lettere for AI at parse og opsummere. Inkludér schema markup (Article, FAQPage, HowTo) for at give ekstra kontekst om din indholdstype.

Opdater endelig dit indhold regelmæssigt. LLM’er foretrækker nyere indhold, især for tidsfølsomme data. Hvis din undersøgelse er fra 2024, opdater den i 2025. Tilføj “Sidst opdateret”-tidsstempler for at vise, at du aktivt vedligeholder indholdet. Det signalerer til LLM’er, at dine data er aktuelle og pålidelige.

At publicere proprietære data på din hjemmeside er nødvendigt, men ikke tilstrækkeligt. LLM’er opdager indhold via flere kanaler, og din distributionsstrategi afgør, hvor mange af dem, der bærer dine data.

Digital PR er den mest effektive distributionskanal for proprietære data. Når din forskning optræder i branchepublikationer, nyhedsmedier og autoritative blogs, skaber det mange citatmuligheder. LLM’er indekserer disse tredjepartsomtaler og bruger dem til at validere din oprindelige kilde. Et brand, der optræder på 4+ platforme, har 2,8x større sandsynlighed for at blive citeret i ChatGPT-svar sammenlignet med brands med begrænset platformtilstedeværelse.

Effektive distributionskanaler omfatter:

Hver kanal tjener et formål. Pressemeddelelser skaber opmærksomhed og sikrer mediedækning. Branchepublikationer giver troværdighed og når beslutningstagere. LinkedIn forstærkning rammer professionelle i stor skala. Reddit engagement viser community-tillid. Anmeldelsesplatforme giver strukturerede data, som LLM’er let kan parse.

Multiplikatoreffekten er stor. Når dine proprietære data optræder i flere autoritative kilder, ser LLM’er konsistente signaler på tværs af nettet. Denne konsistens øger tilliden til dine data og gør citation mere sandsynlig. En enkelt omtale på din hjemmeside kan blive overset. De samme data nævnt på hjemmeside, i pressemeddelelse, branchepublikation og anmeldelsesplatform bliver umulige at ignorere.

Timing betyder også noget. Distribuer dine proprietære data strategisk. Udgiv dem først på din hjemmeside med pressemeddelelse. Følg op med brancheplaceringer. Forstærk derefter via sociale kanaler og community-engagement. Denne trinvise tilgang skaber en bølge af synlighed frem for et enkelt spike.

At publicere proprietære data uden at måle effekten svarer til at køre annoncer uden at spore konverteringer. Du skal have indsigt i, om dine data rent faktisk får citationer og øger din AI-synlighed.

Start med at spore citationsfrekvens. Identificér 20-50 værdifulde køberspørgsmål, dine proprietære data besvarer. Spørg de største AI-platforme (ChatGPT, Perplexity, Claude, Google AI Overviews) månedligt med disse spørgsmål. Dokumentér, om dit brand nævnes, i hvilken position, og om citatet linker til din hjemmeside.

Udregn citationsfrekvens som procent: (Prompter hvor du nævnes) / (Samlede prompter) × 100. Sigt efter 30 %+ citationsfrekvens for dine kernekategorispørgsmål. Topbrands i konkurrenceprægede kategorier opnår 50 %+ citationsfrekvens.

Spor AI Share of Voice (AI SOV) ved at køre identiske prompter og beregne din procentandel af alle brandomtaler. Hvis dit brand nævnes i 3 ud af 10 AI-svar og konkurrenter i 2 hver, er din AI SOV 30 %. I konkurrenceprægede kategorier, sigt efter AI SOV, der overstiger din traditionelle markedsandel med 10-20 %.

Overvåg sentimentanalyse. Ud over blot at blive nævnt, spor om AI-systemer beskriver dit brand positivt, neutralt eller negativt. Brug værktøjer som Profound AI, der specialiserer sig i hallucinationsdetektion – identificering af, når AI giver falske eller forældede oplysninger om dit brand. Sigt efter 70 %+ positivt sentiment på tværs af AI-platforme.

Opsæt et Knowledge-Based Indicator (KBI) dashboard, der tracker:

Opdatér disse metrics månedligt. Kig efter tendenser fremfor enkelte datapunkter. En måned med lav citation kan være støj. Tre måneder med faldende citationer kræver undersøgelse og handling.

At tracke citationer af proprietære data manuelt er tidskrævende og fejlbehæftet. AmICited.com leverer infrastrukturen til at overvåge din AI-synlighed i stor skala, specielt designet til brands, der bruger proprietære data som citatstrategi.

Platformen overvåger, hvordan AI-systemer citerer din proprietære forskning på tværs af ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini og nye AI-platforme. I stedet for at spørge hver platform manuelt månedligt, automatiserer AmICited processen, kører dine målrettede prompter kontinuerligt og tracker citatmønstre i realtid.

Nøglefunktioner omfatter:

Platformen integrerer med dit eksisterende analytics-setup og føder AI-citationsdata ind i dine marketingdashboards sammen med traditionelle SEO-metrics. Dette samlede overblik hjælper dig med at forstå den fulde effekt af din proprietære datastrategi på brand-synlighed og pipeline-generering.

For brands, der tager AI-synlighed alvorligt, leverer AmICited den måleinfrastruktur, der gør optimering mulig. Du kan ikke forbedre det, du ikke kan måle, og traditionelle analytics-værktøjer var aldrig designet til at tracke LLM-citationer. AmICited udfylder dette hul og giver dig synligheden til at maksimere ROI på dine investeringer i proprietære data.

Selv velmenende proprietære datastrategier fejler ofte på grund af undgåelige fejl. At kende faldgruberne hjælper dig med at undgå dem.

Den mest almindelige fejl er at gemme data bag “Kontakt Salg”-formularer. LLM’er kan ikke tilgå indhold bag lås, så de vil stole på ufuldstændige eller spekulative oplysninger fra fora. Hvis dine undersøgelsesfund er skjult, citerer LLM’er en Reddit-diskussion om dit produkt fremfor din officielle forskning. Udgiv nøglefund offentligt med gennemsigtig metode. Du kan låse detaljerede rapporter, mens du holder opsummerende data og indsigter offentlige.

Inkonsekvent terminologi på tværs af platforme skaber forvirring. Hvis din hjemmeside kalder dit produkt en “marketing automation platform”, mens din LinkedIn-profil kalder det “CRM software”, får LLM’er svært ved at danne sammenhængende forståelse af din forretning. Brug ensartet kategorisprog overalt. Definér dit terminologikort og anvend det på hjemmeside, LinkedIn, Crunchbase og andre platforme.

Manglende forfatterkredentialer underminerer tilliden. LLM’er vurderer E-E-A-T-signaler nøje. Hvis din undersøgelse mangler forfatterbiografier med reelle kredentialer, bliver den nedprioriteret. Inkludér detaljerede forfatterbiografier med relevant erfaring, certificeringer og tidligere publikationer. Link til forfatterprofiler på LinkedIn og andre platforme.

Forældede statistikker skader troværdigheden. Hvis din undersøgelse er fra 2023, men stadig citeres i 2025, bemærker LLM’er det. Opdatér din forskning regelmæssigt. Tilføj “Sidst opdateret”-tidsstempler. Gennemfør nye undersøgelser årligt for at holde data friske. LLM’er foretrækker aktuelle data, især for tidsfølsomme emner.

Uklar metode reducerer sandsynligheden for citation. Hvis din undersøgelsesmetode ikke er gennemsigtig, stiller LLM’er spørgsmålstegn ved validiteten af dine fund. Publicér din metode åbent. Forklar stikprøvestørrelse, udvælgelsesmetode, undersøgelsesperiode og eventuelle begrænsninger. Gennemsigtighed skaber tillid.

Keyword stuffing i dit proprietære datainhold fungerer dårligere i AI-systemer end i traditionel søgning. LLM’er detekterer og straffer kunstigt sprog. Skriv naturligt. Fokuser på klarhed og nøjagtighed fremfor keywordtæthed. Dit proprietære data bør læses som ægte forskning, ikke marketingtekst.

Tyndt indhold omkring dine proprietære data bliver aktivt straffet. En enkelt paragraf, der nævner dine undersøgelsesresultater, er ikke nok. Skab omfattende indhold, der udforsker implikationer, giver kontekst og besvarer opfølgende spørgsmål. Sigt efter 2.000+ ord substantielt indhold omkring hvert større proprietært dataaktiv.

Virkelige eksempler viser, hvor effektivt proprietære data kan være for AI-synlighed. Disse brands investerede i original forskning og så målbare resultater.

The Zebra’s Digital PR-succes: The Zebra, en forsikringssammenligningsplatform, kombinerede proprietær forskning med Digital PR og genererede 1.580+ kvalitetsmedielinks og en stigning i organisk trafik på 354 %. Ved at udgive original forskning om forsikringsbranchen og distribuere den via earned media blev The Zebra go-to-kilden for forsikringsdata. LLM’er citerer nu The Zebra’s forskning, når de besvarer spørgsmål om forsikringstrends og priser.

Tallys community-engagementstrategi: Tally, en online form builder, forbedrede sin AI-synlighed ved aktivt at engagere sig i community-fora og dele sin produkt-roadmap. I stedet for kun at publicere forskning, blev Tally en betroet stemme i de fællesskaber, hvor deres brugere befinder sig. Dette autentiske engagement gjorde ChatGPT til en af de største henvisningskilder og skabte markante ugentlige tilmeldingsstigninger. Ved at forankre GPT-4 i kuraterede, kontekstspecifikke beviser hævede Tally sin faktuelle nøjagtighed fra 56 % til 89 %.

HubSpots løbende forskningsprogram: HubSpot udgiver regelmæssige rapporter om marketingtrends, salgsperformance og best practice for kundeservice. Disse rapporter er blevet branchestandarder, som LLM’er ofte citerer. HubSpots engagement i kontinuerlig forskning har gjort brandet synonymt med marketingdata og -indsigt. Når LLM’er besvarer spørgsmål om marketingtrends, vises HubSpot-forskning konsekvent.

Disse casestudier har fælles elementer: original forskning, gennemsigtig metode, konsekvent distribution og løbende opdateringer. Ingen af disse brands levede på et enkelt forskningsprojekt. De byggede forskningsprogrammer, der løbende genererer nye proprietære data og sikrer en vedvarende citatfordel.

Læringen er klar: Proprietære data er ikke et engangstiltag. Det er en strategisk investering i at blive den autoritative kilde i din kategori. Brands, der satser på regelmæssig forskning, gennemsigtig metode og strategisk distribution, får løbende citationer fra LLM’er og bygger varige konkurrencefordele i AI-synlighed.

Du behøver ikke massive datasæt. Selv en fokuseret undersøgelse med 100-500 respondenter kan give værdifuld proprietær indsigt, som LLM'er vil citere. Nøglen er, at dataene er originale, metodikken er gennemsigtig, og resultaterne er handlingsorienterede. Kvalitet og unikhed betyder mere end kvantitet.

Kundetilfredshedsundersøgelser, branchetrendforskning, konkurrenceanalyse, brugeradfærdsstudier og markedsstørrelsesundersøgelser klarer sig alle godt. De bedste data besvarer specifikke spørgsmål, som din målgruppe stiller, og giver indsigt, som konkurrenterne ikke har.

Realtime-platforme som Perplexity kan citere friske data inden for uger. ChatGPT og andre modeller med sjældnere opdateringer kan tage 2-3 måneder. Konsistente, høj-kvalitets proprietære data viser typisk målbare stigninger i citationer inden for 3-6 måneder.

Nej. LLM'er kan ikke tilgå indhold bag lås, så de vil i stedet stole på ufuldstændige eller spekulative oplysninger fra fora. Udgiv nøglefund offentligt med gennemsigtig metode. Du kan låse detaljerede rapporter, mens du holder opsummerende data og indsigter offentligt tilgængelige.

Brug klart, konsekvent terminologi på alle platforme. Inkludér gennemsigtig metode i din forskning. Tilføj forfatteroplysninger og certificeringer. Link til tredjepartsvalidering. Brug schema markup til at strukturere dine data. Overvåg citationer månedligt og ret fejl hurtigt.

Ja. Original forskning får typisk backlinks og mediedækning, hvilket forbedrer traditionelle placeringer. Derudover skaber proprietære data indhold, der er mere omfattende og autoritativt, hvilket hjælper både med traditionel SEO og AI-synlighed.

Proprietære data er original forskning, du selv udfører. Generiske rapporter er bredt tilgængelige. LLM'er foretrækker proprietære data, fordi de er unikke og kun kan citeres fra din kilde. Det giver en citatfordel, som konkurrenterne ikke let kan kopiere.

Spor citationsfrekvens, AI Share of Voice, brandet søgevolumen og trafik fra AI-platforme. Sammenlign disse målinger før og efter udgivelse af proprietære data. Beregn værdien af AI-henvist trafik (typisk 4,4x højere konverteringsrate end traditionel organisk) for at bestemme ROI.

Overvåg hvordan AI-systemer citerer dine proprietære data på tværs af ChatGPT, Perplexity, Google AI Overviews og mere. Få realtidindsigt i din AI-synlighed og konkurrencepositionering.

Lær, hvordan du skaber original forskning og datadrevet PR-indhold, som AI-systemer aktivt citerer. Opdag de 5 egenskaber ved indhold, der er værd at citere, sa...

Fællesskabsdiskussion om brug af original forskning og undersøgelser til at forbedre AI-citater. Markedsførere deler erfaringer med at offentliggøre proprietære...

Lær, hvordan du bruger statistik og databaserede indsigter til at forbedre din brands synlighed i AI-søgemaskiner som ChatGPT, Perplexity og Google Gemini. Opda...