Hvilke indholdsformater får flest AI-citater? Dataanalyse

Opdag hvilke indholdsformater der citeres mest af AI-modeller. Analysér data fra 768.000+ AI-citater for at optimere din indholdsstrategi til ChatGPT, Perplexit...

Lær hvordan du tester indholdsformater for AI-citater ved hjælp af A/B-testmetodik. Opdag hvilke formater der giver den højeste AI-synlighed og citatrater på tværs af ChatGPT, Google AI Overviews og Perplexity.

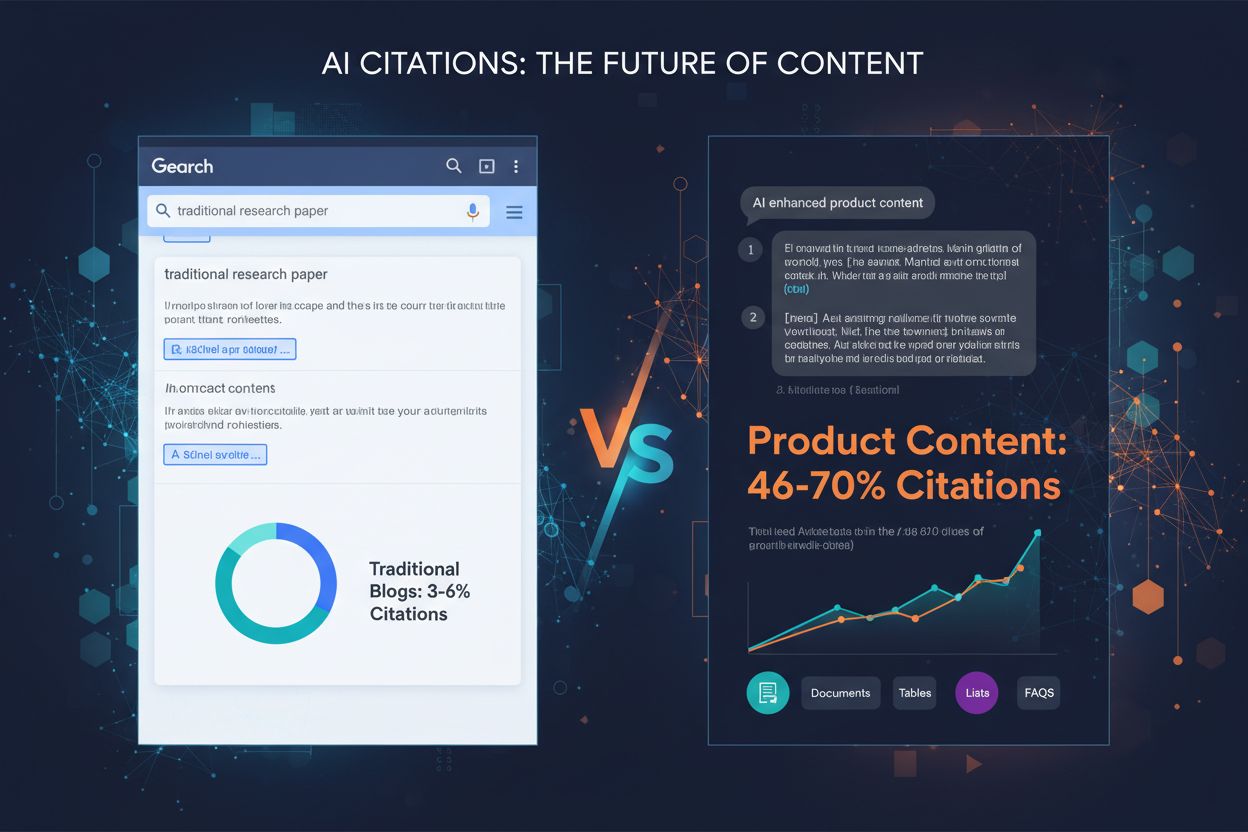

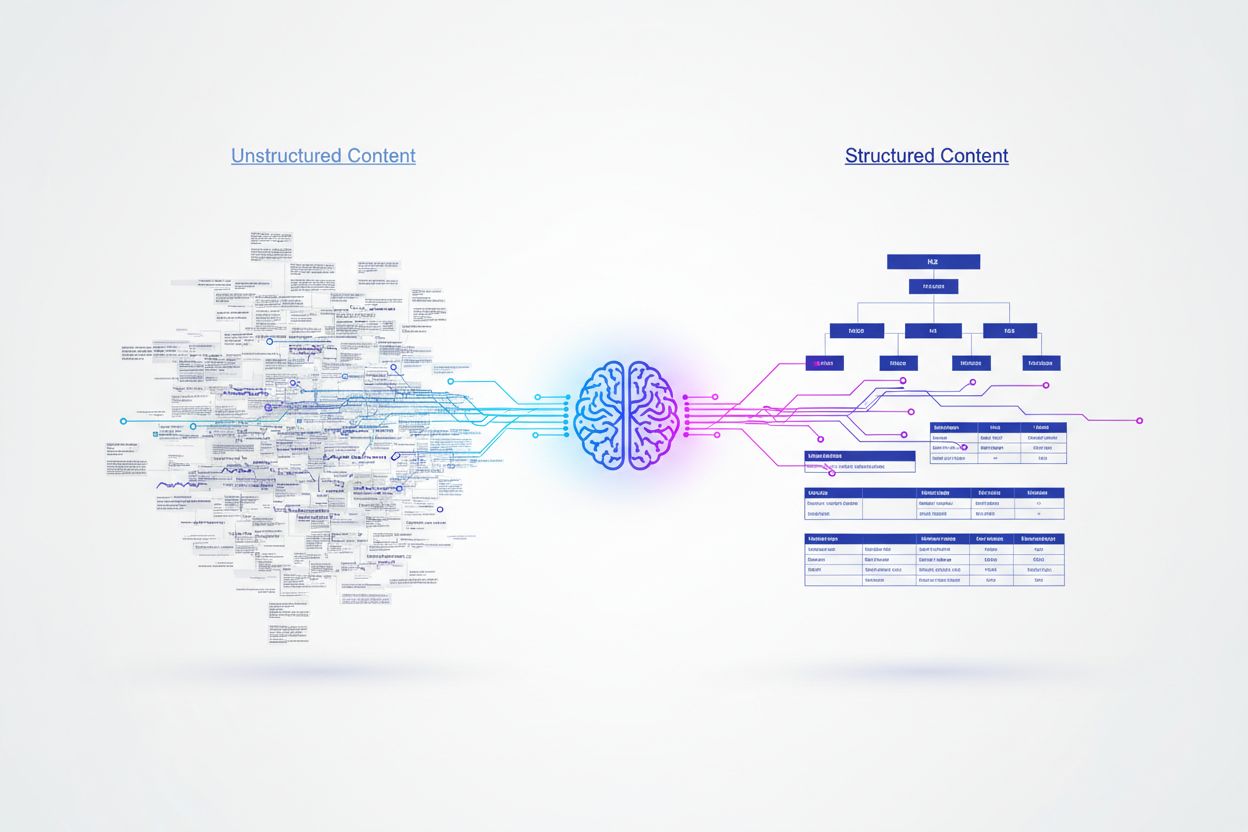

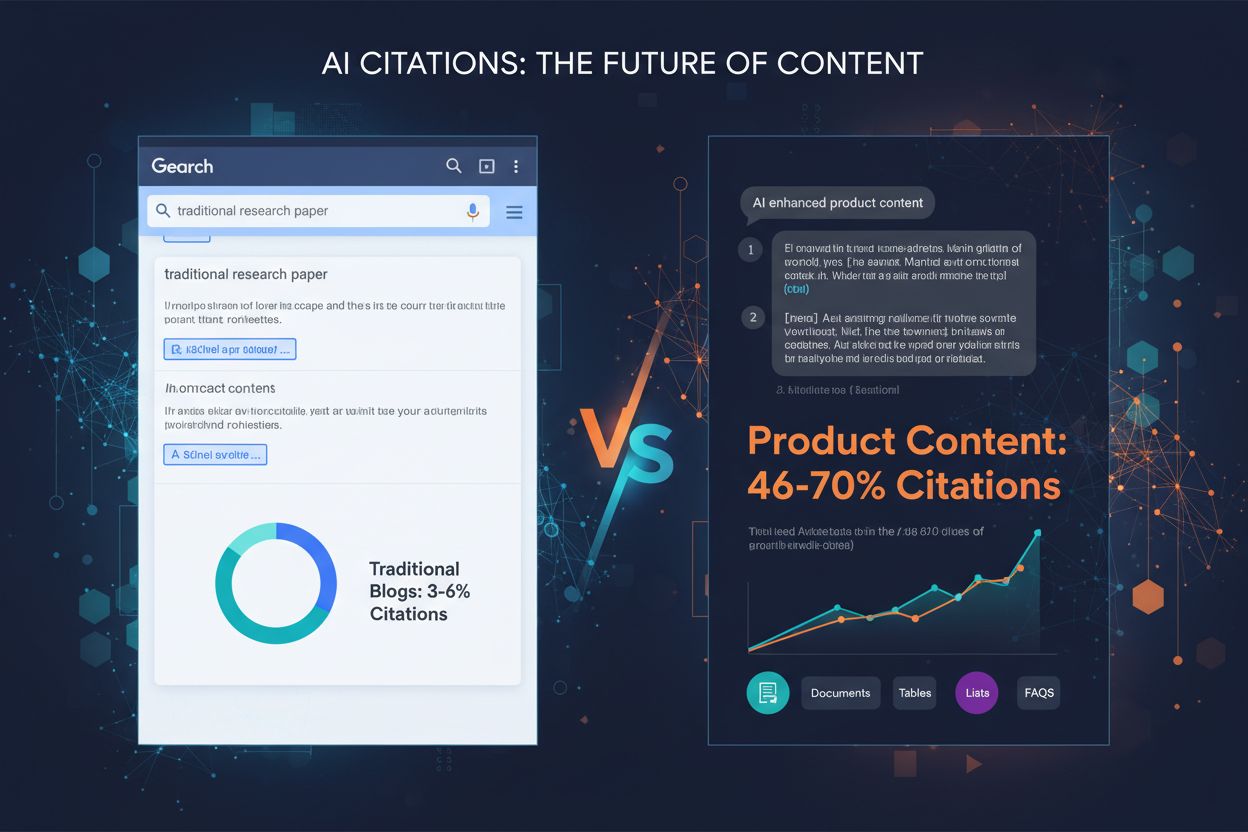

Kunstig intelligens behandler indhold fundamentalt anderledes end menneskelige læsere og er afhængig af strukturerede signaler for at forstå mening og udtrække information. Mens mennesker kan navigere gennem kreativ formatering eller tæt prosa, kræver AI-modeller klare organisatoriske hierarkier og semantiske markører for effektivt at kunne parse og forstå indholdets værdi. Forskning viser, at struktureret indhold med korrekt overskriftshierarki opnår citatrater, der er 156% højere end ustrukturerede alternativer, hvilket afslører et kritisk gab mellem brugervenligt og AI-venligt indhold. Denne forskel eksisterer, fordi AI-systemer er trænet på enorme datasæt, hvor velformet indhold typisk korrelerer med autoritative, pålidelige kilder. At forstå og teste forskellige indholdsformater er blevet essentielt for brands, der ønsker synlighed i AI-drevne søgeresultater og svarmotorer.

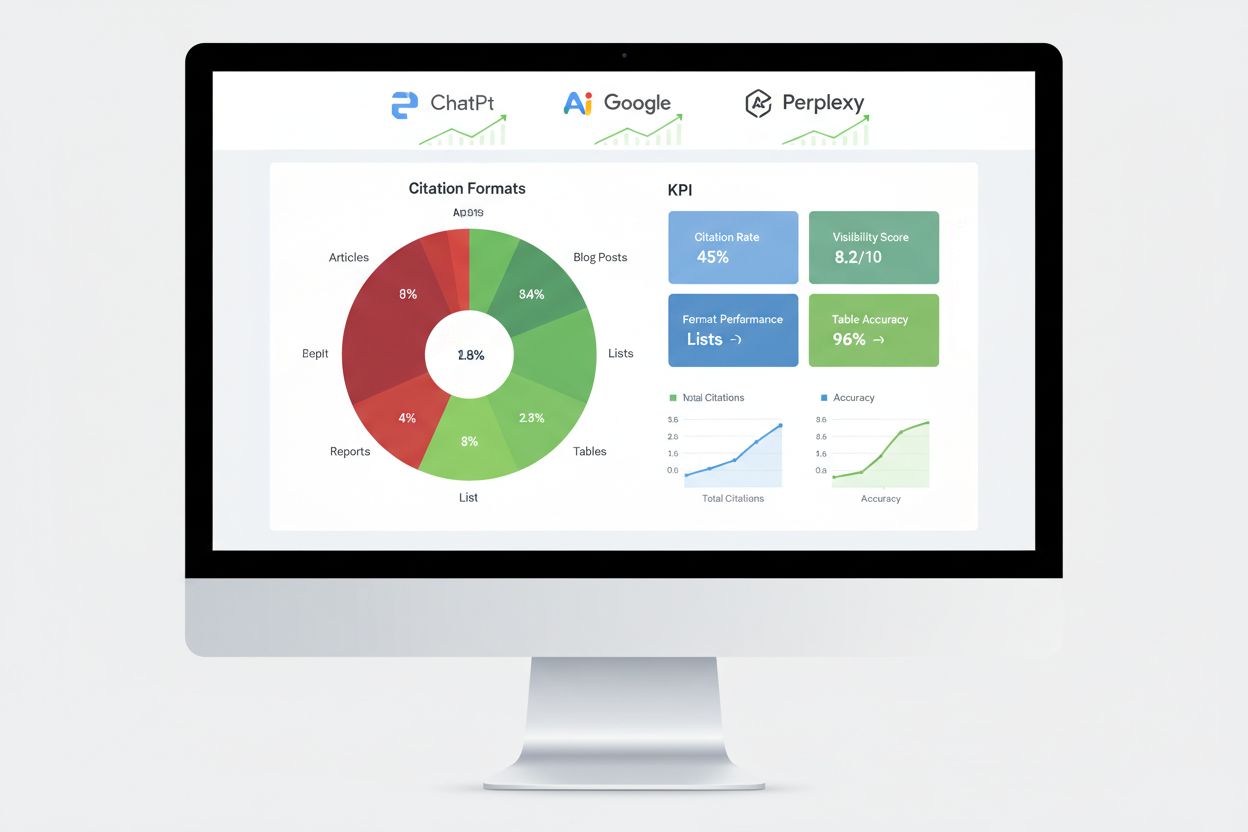

Forskellige AI-platforme viser tydelige præferencer for indholdskilder og -formater, hvilket skaber et komplekst landskab for optimering. Forskning, der analyserer 680 millioner citater på tværs af større platforme, afslører markante forskelle i, hvordan ChatGPT, Google AI Overviews og Perplexity indhenter deres information. Disse platforme citerer ikke blot de samme kilder – de prioriterer forskellige typer indhold baseret på deres underliggende algoritmer og træningsdata. At forstå disse platformspecifikke mønstre er afgørende for at udvikle målrettede indholdsstrategier, der maksimerer synlighed på tværs af flere AI-systemer.

| Platform | Mest citerede kilde | Citationsprocent | Foretrukket format |

|---|---|---|---|

| ChatGPT | Wikipedia | 7,8% af alle citater | Autoritative vidensbaser, encyklopædisk indhold |

| Google AI Overviews | 2,2% af alle citater | Community-diskussioner, bruger-genereret indhold | |

| Perplexity | 6,6% af alle citater | Peer-to-peer information, community-indblik |

ChatGPT’s markante præference for Wikipedia (47,9% af deres top 10-kilder) demonstrerer en bias mod autoritativt, faktuelt indhold med etableret troværdighed. Modsat viser både Google AI Overviews og Perplexity mere balancerede fordelinger, hvor Reddit dominerer deres citationsmønstre. Dette afslører, at Perplexity prioriterer community-drevet information med 46,7% af deres topkilder, mens Google fastholder en mere diversificeret tilgang på tværs af platformtyper. Dataene viser tydeligt, at én strategi ikke passer til alle – brands skal tilpasse deres tilgang alt efter, hvilke AI-platforme der er vigtigst for deres publikum.

Schema markup repræsenterer måske den mest betydningsfulde faktor for sandsynligheden for AI-citater, hvor korrekt implementeret JSON-LD markup opnår citatrater, der er 340% højere end identisk indhold uden struktureret data. Denne markante forskel skyldes, hvordan AI-motorer tolker semantisk betydning – struktureret data giver eksplicit kontekst, der fjerner tvetydighed fra indholdsfortolkningen. Når en AI-motor støder på schema markup, forstår den straks enhedsrelationer, indholdstyper og hierarkisk betydning uden udelukkende at skulle stole på naturlig sprogforståelse.

De mest effektive schema-implementeringer inkluderer Article-schema til blogindlæg, FAQ-schema til spørgsmål-og-svar-sektioner, HowTo-schema til vejledende indhold og Organization-schema til brandgenkendelse. JSON-LD-formatet overgår specifikt andre formater for struktureret data, fordi AI-motorer kan parse det uafhængigt af HTML-indholdet, hvilket muliggør renere dataudtræk og reduceret kompleksitet i behandlingen. Semantiske HTML-tags som <header>, <nav>, <main>, <section>, og <article> giver yderligere klarhed, der hjælper AI-systemer med at forstå indholdsstruktur og hierarki mere effektivt end basal markup.

A/B-test giver den mest pålidelige metode til at afgøre, hvilke indholdsformater der driver de højeste AI-citatrater i din specifikke niche. I stedet for at stole på generelle best practices, giver kontrollerede eksperimenter dig mulighed for at måle den faktiske effekt af formatændringer på dit publikum og din AI-synlighed. Processen kræver omhyggelig planlægning for at isolere variable og sikre statistisk gyldighed, men de opnåede indsigter retfærdiggør investeringen.

Følg denne systematiske A/B-testramme:

Statistisk signifikans kræver nøje opmærksomhed på stikprøvestørrelse og testvarighed. I AI-applikationer med sparsom data eller langhale-fordelinger kan det være udfordrende hurtigt at indsamle nok observationer. De fleste eksperter anbefaler at køre tests i mindst 2-4 uger for at tage højde for tidsmæssige variationer og sikre pålidelige resultater.

Forskning på tværs af tusindvis af AI-citater afslører klare præstationshierarkier blandt forskellige indholdsformater. Listebaseret indhold modtager 68% flere AI-citater end afsnitsbaserede alternativer, primært fordi lister giver diskrete, letparsbare informationsenheder, som AI-motorer nemt kan udtrække og syntetisere. Når de genererer svar, kan AI-platforme referere til specifikke listepunkter uden at skulle omstrukturere komplekse sætninger eller omskrive indholdet, hvilket gør listebaseret indhold yderst værdifuldt til citationsformål.

Tabeller demonstrerer enestående præstation med op til 96% nøjagtighed i AI-parsing, hvilket er markant bedre end prosabeskrivelser af identisk information. Tabelformet indhold gør det muligt for AI-systemer hurtigt at udtrække specifikke datapunkter uden kompleks tekstparsing, hvilket gør tabeller særligt værdifulde til faktuelle, sammenlignende eller statistiske oplysninger. Spørgsmål-og-svar-formater opnår 45% højere AI-synlighed sammenlignet med traditionelle afsnitsformater om samme emner, fordi Q&A-indhold afspejler, hvordan brugere interagerer med AI-platforme og hvordan AI-systemer genererer svar.

Sammenligningsformater (X vs Y) klarer sig også særdeles godt, fordi de tilbyder binære, letopsummerede strukturer, som AI-systemer kan udvide til underemner. Cases kombinerer fortælling med data, hvilket gør dem overbevisende for læsere og samtidig fortolkelige for AI gennem deres problem-løsning-resultat-struktur. Original forskning og ekspertindsigter får fortrinsret, fordi de leverer proprietære data, der ikke findes andre steder, og tilføjer troværdighedssignaler, som AI-systemer genkender og belønner. Den vigtigste indsigt er, at intet format virker universelt – den bedste tilgang kombinerer flere formater strategisk baseret på din indholdstype og de AI-platforme, du målretter mod.

Implementering af schema markup kræver forståelse for de forskellige typer og udvælgelse af dem, der er mest relevante for dit indhold. Til blogindlæg og artikler giver Article-schema omfattende metadata, herunder forfatter, udgivelsesdato og indholdsstruktur. FAQ-schema fungerer særdeles godt for spørgsmål-og-svar-sektioner, hvor spørgsmål og svar mærkes eksplicit, så AI-systemer kan udtrække dem pålideligt. HowTo-schema gavner vejledende indhold ved at definere sekventielle trin, mens Product-schema hjælper e-handelswebsites med at formidle specifikationer og priser.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "Hvad er det bedste indholdsformat til AI-citater?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Det bedste indholdsformat afhænger af din platform og målgruppe, men strukturerede formater som lister, tabeller og Q&A-sektioner opnår konsekvent højere AI-citatrater. Lister får 68% flere citater end afsnit, mens tabeller opnår 96% parseringsnøjagtighed."

}

}

]

}

Implementeringen kræver opmærksomhed på syntaksnøjagtighed – ugyldig schema markup kan faktisk skade dine AI-citationschancer i stedet for at forbedre dem. Brug Googles Rich Results Test eller Schema.org’s valideringsværktøjer til at verificere din markup, før du udgiver. Oprethold konsekvente formateringshierarkier med H2’ere til hovedafsnit, H3’ere til underpunkter og korte afsnit (maks. 50-75 ord), der fokuserer på ét enkelt koncept. Tilføj TL;DR-sammenfatninger i begyndelsen eller slutningen af afsnit for at give AI færdiglavede snippets, der kan stå alene som brugbare svar.

Måling af AI-motorydelse kræver andre metrics end traditionel SEO og fokuserer på citationstracking, svarinklusion og knowledge graph-omtale frem for positioner i søgeresultatet. Citationsovervågning på tværs af større platforme giver det mest direkte indblik i, om dine formattests lykkes, og viser hvilke indholdsdele, AI-systemer faktisk refererer til. Værktøjer som AmICited sporer specifikt, hvordan AI-platforme citerer dit brand på ChatGPT, Google AI Overviews, Perplexity og andre svarmotorer og giver indsigt i citationsmønstre og trends.

Væsentlige målemetoder inkluderer at spore featured snippet-capture rate, som indikerer indhold, AI-systemer finder særligt værdifuldt som direkte svar. Forekomster i knowledge panel signalerer, at AI-systemer anerkender dit brand som en autoritativ aktør, der fortjener dedikerede informationsvisninger. Voice search-resultater viser, om dit indhold optræder i konversations-AI-svar, mens generative engine-response rates måler, hvor ofte AI-systemer refererer til dit indhold i brugersvar. A/B-test af forskellige formattilgange leverer de mest pålidelige performance-data ved at isolere enkeltvariable og identificere specifikke effektfaktorer. Etabler baseline-metrics før ændringer implementeres, og overvåg ugentligt for at identificere trends og afvigelser, der kan indikere succesfulde eller mislykkede formatvariationer.

Mange organisationer, der tester formater, falder i forudsigelige fælder, som kompromitterer resultaterne og fører til forkerte konklusioner. Utilstrækkelige stikprøvestørrelser er den mest almindelige fejl – test med for få citater eller interaktioner fører til statistisk insignifikante resultater, der kan synes meningsfulde, men faktisk blot afspejler tilfældige udsving. Sørg for at indsamle mindst 100 citater pr. variation, før du drager konklusioner, og brug statistiske beregnere til at fastslå præcis nødvendig stikprøvestørrelse for dit konfidensniveau og effektstørrelse.

Forstyrrende variable introducerer bias, når flere faktorer ændres samtidigt, hvilket gør det umuligt at afgøre, hvilken ændring der forårsagede observerede forskelle. Hold alle elementer identiske undtagen det format, der testes – bevar de samme søgeord, længde, struktur og udgivelsestidspunkt. Tidsmæssig bias opstår, når der testes i atypiske perioder (helligdage, større nyhedsbegivenheder, ændringer i platformalgoritmer), hvilket forvrænger resultaterne. Kør tests i normale perioder og tag højde for sæsonvariation ved at teste i mindst 2-4 uger. Udvælgelsesbias opstår, når testgrupper adskiller sig på måder, der påvirker resultaterne – sørg for tilfældig tildeling af indhold til variationer. Fejltolkning af korrelation som kausalitet fører til forkerte konklusioner, hvis eksterne faktorer tilfældigt falder sammen med din testperiode. Overvej altid alternative forklaringer på observerede ændringer og valider resultater gennem flere testcyklusser, før du implementerer permanente ændringer.

Et teknologifirma, der testede indholdsformater for AI-synlighed, opdagede, at konvertering af deres produkt-sammenligningsartikler fra afsnitsformat til strukturerede sammenligningstabeller øgede AI-citater med 52% inden for 60 dage. Tabellerne gav klar, scanningsvenlig information, som AI-systemer kunne udtrække direkte, mens den oprindelige prosa krævede mere kompleks parsing. De bevarede identisk indholdslængde og søgeordsoptimering og isolerede formatændringen som den eneste variabel.

Et finansielt serviceselskab implementerede FAQ-schema på deres eksisterende indhold uden at omskrive noget, men blot ved at tilføje struktureret markup til eksisterende spørgsmål-og-svar-sektioner. Dette resulterede i en stigning på 34% i forekomster som featured snippets og en stigning på 28% i AI-citater inden for 45 dage. Schema markup ændrede ikke selve indholdet, men gjorde det betydeligt lettere for AI-systemer at identificere og udtrække relevante svar. Et SaaS-firma gennemførte multivariat test på tre formater samtidigt – lister, tabeller og traditionelle afsnit – for identisk indhold om deres produktfunktioner. Resultaterne viste, at lister overgik afsnit med 68%, mens tabeller opnåede den højeste nøjagtighed i AI-parsing, men lavere samlet citationsvolumen. Dette viste, at formateffektivitet varierer efter indholdstype og AI-platform, hvilket bekræfter, at test er essentielt i stedet for at stole på generelle best practices. Disse virkelige eksempler viser, at test af formater leverer mærkbare, betydelige forbedringer i AI-synlighed, når det udføres korrekt.

Landskabet for test af indholdsformater udvikler sig løbende, efterhånden som AI-systemer bliver mere sofistikerede og nye optimeringsteknikker opstår. Multi-armed bandit-algoritmer repræsenterer et markant fremskridt i forhold til traditionel A/B-test, idet de dynamisk justerer trafikfordeling til forskellige varianter baseret på realtidsperformance, i stedet for at vente på, at forudbestemte testperioder afsluttes. Denne tilgang reducerer tiden, det tager at identificere vindervarianter, og maksimerer performance under selve testperioden.

Adaptiv eksperimentering baseret på reinforcement learning muliggør, at AI-modeller løbende kan lære og tilpasse sig af igangværende eksperimenter og forbedre performance i realtid i stedet for gennem adskilte testcyklusser. AI-drevet automatisering i A/B-test bruger AI selv til at automatisere eksperimentdesign, resultatanalyse og optimeringsanbefalinger, så organisationer kan teste flere variationer samtidigt uden proportionalt øget kompleksitet. Disse nye tilgange lover hurtigere iterationer og mere avancerede optimeringsstrategier. Organisationer, der mestrer test af indholdsformater i dag, vil bevare konkurrencemæssige fordele, når disse avancerede metoder bliver standard, og positionere sig til at udnytte nye AI-platforme og udviklende citationsalgoritmer, før konkurrenterne omlægger deres strategier.

Det bedste indholdsformat afhænger af din platform og målgruppe, men strukturerede formater som lister, tabeller og Q&A-sektioner opnår konsekvent højere AI-citatrater. Lister får 68% flere citater end afsnit, mens tabeller opnår 96% parseringsnøjagtighed. Nøglen er at teste forskellige formater med dit specifikke indhold for at identificere hvad der virker bedst.

De fleste eksperter anbefaler at køre tests i mindst 2-4 uger for at tage højde for tidsmæssige variationer og sikre pålidelige resultater. Denne varighed giver dig mulighed for at indsamle tilstrækkeligt med datapunkter (typisk 100+ citater pr. variation) og tage højde for sæsonvariationer eller ændringer i platformens algoritmer, som kan forvrænge resultaterne.

Ja, du kan gennemføre multivariat test på tværs af flere formater samtidigt, men dette kræver omhyggelig planlægning for at undgå kompleksitet i fortolkningen af resultaterne. Start med enkle A/B-tests, hvor du sammenligner to formater, og gå derefter videre til multivariat test, når du forstår det grundlæggende og har tilstrækkelige statistiske ressourcer.

Du har typisk brug for mindst 100 citater eller interaktioner pr. variation for at opnå statistisk signifikans. Brug statistiske beregnere til at bestemme den nøjagtige stikprøvestørrelse, der er nødvendig for dit specifikke konfidensniveau og effektstørrelse. Større stikprøver giver mere pålidelige resultater, men kræver længere testperioder.

Start med at identificere den mest relevante schema-type for dit indhold (Article, FAQ, HowTo osv.), og brug derefter JSON-LD-format til at implementere det. Valider din markup med Googles Rich Results Test eller Schema.org's valideringsværktøjer, inden du udgiver. Ugyldig schema markup kan faktisk skade dine AI-citationschancer, så nøjagtighed er afgørende.

Prioritér ud fra din målgruppe og forretningsmål. ChatGPT foretrækker autoritative kilder som Wikipedia, Google AI Overviews foretrækker community-indhold som Reddit, og Perplexity lægger vægt på peer-to-peer information. Analysér hvilke platforme der driver mest relevant trafik til dit site og optimer for dem først.

Implementér løbende test som en del af din indholdsstrategi. Start med kvartalsvise format-testcyklusser, og øg derefter hyppigheden, efterhånden som du opbygger ekspertise og etablerer baseline-metrics. Regelmæssig test hjælper dig med at holde dig foran ændringer i AI-platformenes algoritmer og opdage nye formatpræferencer.

Spor forbedringer i citatrate, featured snippet-capture rate, forekomster i knowledge panel og generative engine-response rates. Etabler baseline-metrics før test, og overvåg derefter ugentlig for at identificere trends. En succesfuld test viser typisk 20%+ forbedring i din primære metric inden for 4-8 uger.

Spor hvordan AI-platforme citerer dit indhold på tværs af forskellige formater. Opdag hvilke indholdsstrukturer der giver mest AI-synlighed og optimer din strategi med reelle data.

Opdag hvilke indholdsformater der citeres mest af AI-modeller. Analysér data fra 768.000+ AI-citater for at optimere din indholdsstrategi til ChatGPT, Perplexit...

Fællesskabsdiskussion om hvorvidt tabeller og struktureret formatering forbedrer AI-citathyppigheden. Reelle testresultater fra marketingfolk, der eksperimenter...

Opdag hvorfor sammenligningsartikler er det mest effektive indholdsformat i AI-søgning. Lær, hvordan du optimerer sammenligningsindhold til ChatGPT, Perplexity ...