Sådan identificerer du søgeintention for AI-optimering

Lær hvordan du identificerer og optimerer for søgeintention i AI-søgemaskiner. Opdag metoder til at klassificere brugerforespørgsler, analysere AI SERP'er og st...

Lær hvordan store sprogmodeller fortolker brugerintention ud over nøgleord. Opdag forespørgselsudvidelse, semantisk forståelse, og hvordan AI-systemer afgør, hvilket indhold de citerer i svar.

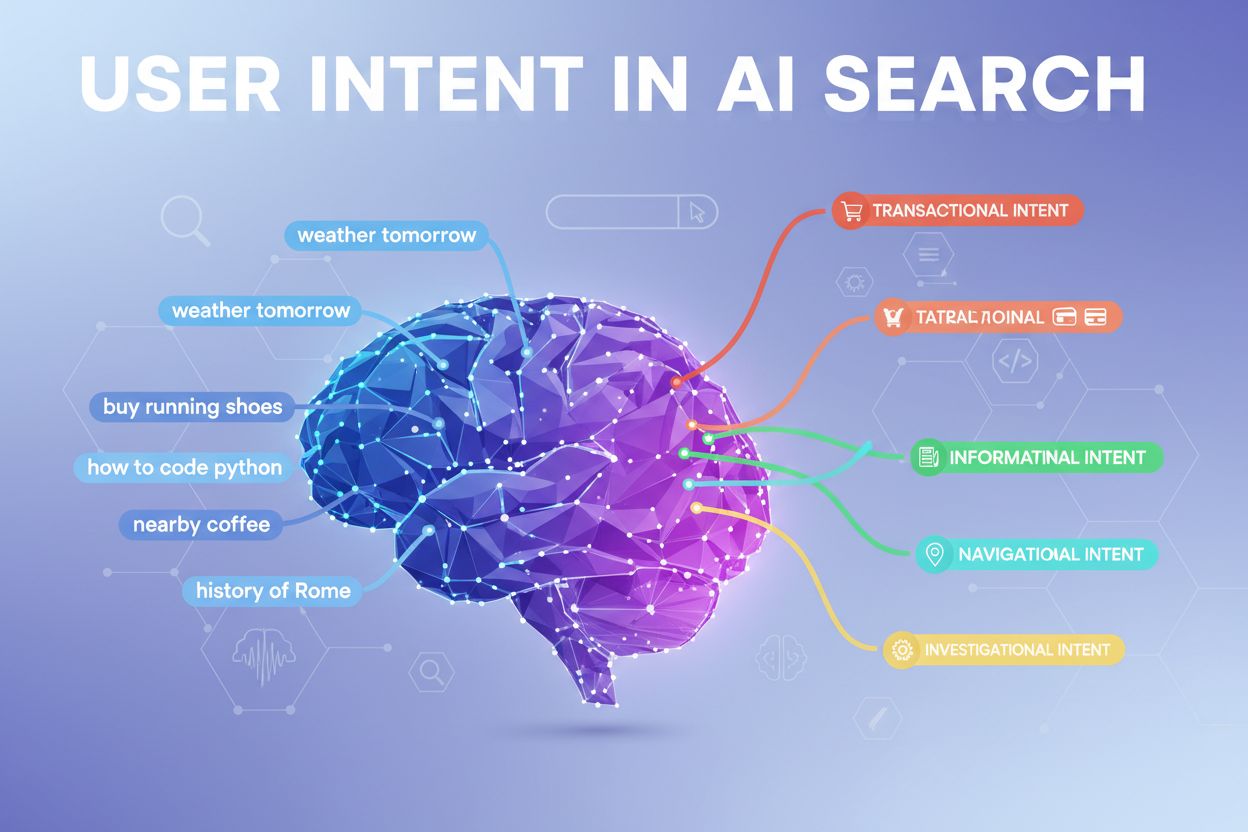

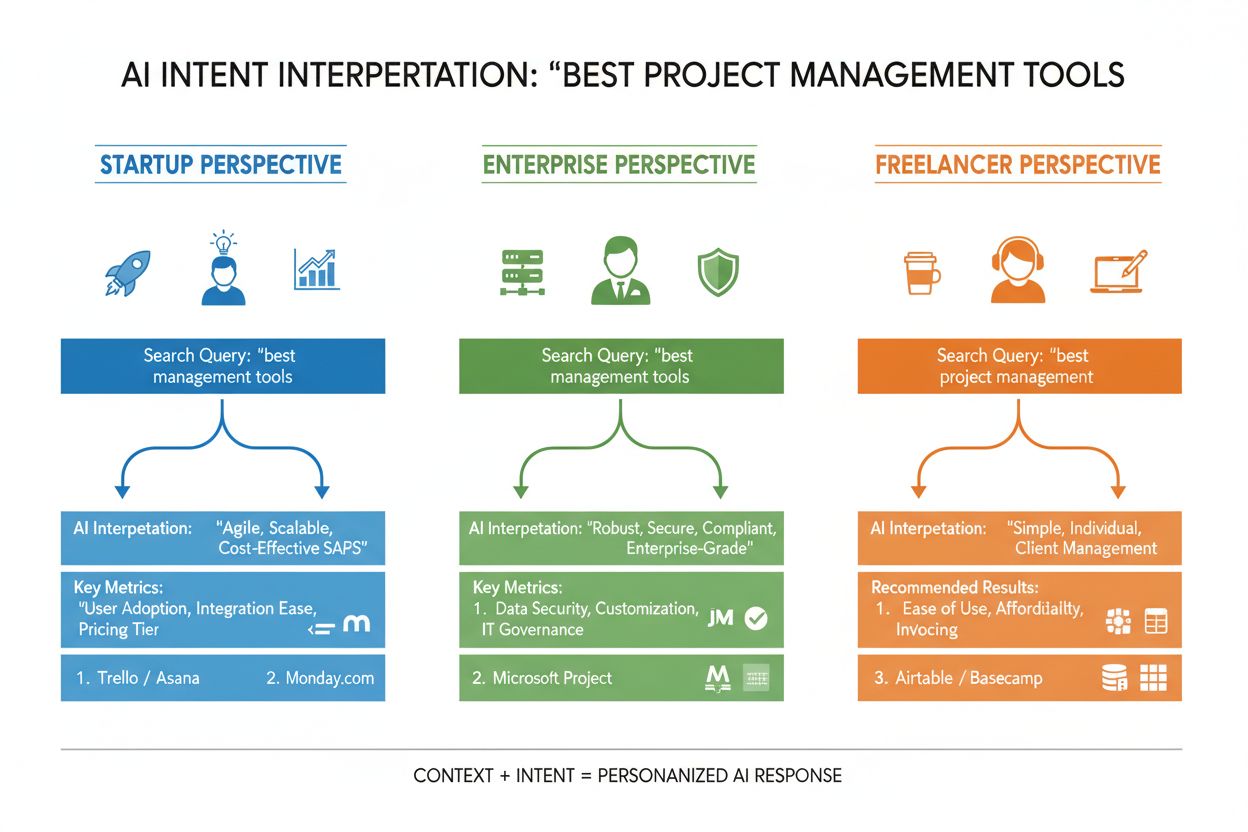

Brugerintention i AI-søgning henviser til det underliggende mål eller formål bag en forespørgsel, snarere end blot de nøgleord, nogen indtaster. Når du søger efter “bedste projektstyringsværktøjer”, kan du være på udkig efter en hurtig sammenligning, prisinformation eller integrationsmuligheder—og store sprogmodeller (LLM’er) som ChatGPT, Perplexity og Googles Gemini arbejder på at forstå, hvilket af disse mål du faktisk forfølger. I modsætning til traditionelle søgemaskiner, der matcher nøgleord med sider, fortolker LLM’er den semantiske betydning af din forespørgsel ved at analysere kontekst, formulering og relaterede signaler for at forudsige, hvad du virkelig ønsker at opnå. Dette skift fra nøgleords-matchning til intentionsforståelse er fundamentalt for, hvordan moderne AI-søgesystemer fungerer, og det afgør direkte, hvilke kilder der citeres i AI-genererede svar. Forståelse af brugerintention er blevet afgørende for brands, der søger synlighed i AI-søgeresultater, da værktøjer som AmICited nu overvåger, hvordan AI-systemer refererer til dit indhold baseret på intentionstilpasning.

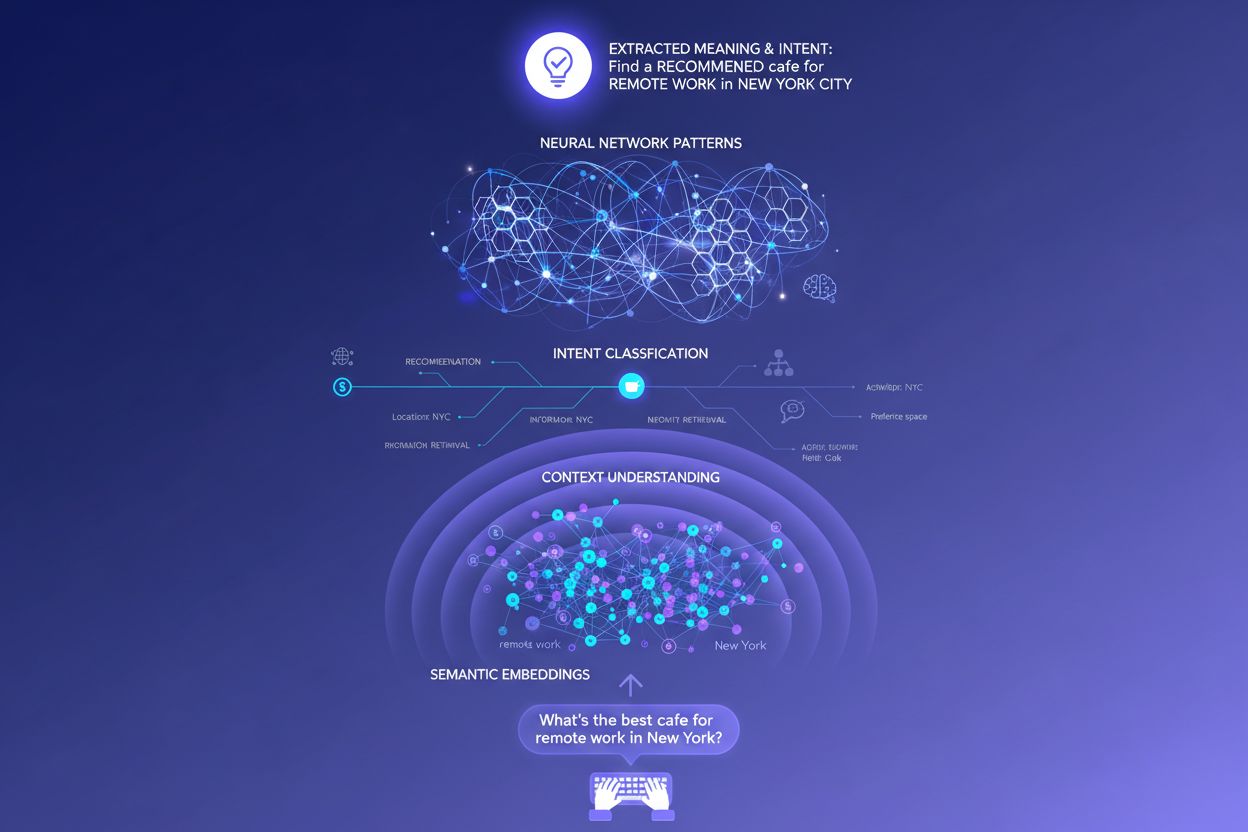

Når du indtaster en enkelt forespørgsel i et AI-søgesystem, sker der noget bemærkelsesværdigt bag kulisserne: modellen besvarer ikke blot dit spørgsmål direkte. I stedet udvider den din forespørgsel til snesevis af relaterede mikrospørgsmål, en proces forskere kalder “query fan-out”. For eksempel kan en simpel søgning som “Notion vs Trello” udløse underforespørgsler som “Hvilket er bedst til teamsamarbejde?”, “Hvad er prisforskellen?”, “Hvilket integrerer bedst med Slack?” og “Hvad er nemmest for begyndere?” Denne udvidelse gør det muligt for LLM’er at udforske forskellige vinkler af din intention og indsamle mere omfattende information, før de genererer et svar. Systemet evaluerer derefter passager fra forskellige kilder på et detaljeret niveau i stedet for at rangere hele sider, hvilket betyder, at et enkelt afsnit fra dit indhold kan blive udvalgt, mens resten af siden ignoreres. Denne passageniveau-analyse er grunden til, at klarhed og specificitet i hver sektion betyder mere end nogensinde før—et velstruktureret svar på en specifik underintention kan være grunden til, at dit indhold bliver trukket ind i et AI-genereret svar.

| Original forespørgsel | Underintention 1 | Underintention 2 | Underintention 3 | Underintention 4 |

|---|---|---|---|---|

| “Bedste projektstyringsværktøjer” | “Hvilket er bedst til fjernteams?” | “Hvad er prisen?” | “Hvilket integrerer med Slack?” | “Hvad er nemmest for begyndere?” |

| “Hvordan forbedrer man produktivitet” | “Hvilke værktøjer hjælper med tidsstyring?” | “Hvilke er dokumenterede produktivitetsmetoder?” | “Hvordan reducerer man forstyrrelser?” | “Hvilke vaner øger fokus?” |

| “AI-søgemaskiner forklaret” | “Hvordan adskiller de sig fra Google?” | “Hvilken AI-søgning er mest præcis?” | “Hvordan håndterer de privatliv?” | “Hvad er fremtiden for AI-søgning?” |

LLM’er vurderer ikke din forespørgsel isoleret—de opbygger det, forskere kalder en “brugerembedding”, en vektorbaseret profil, der fanger din udviklende intention ud fra din søgehistorik, placering, enhedstype, tidspunkt på dagen og endda tidligere samtaler. Denne kontekstuelle forståelse gør det muligt for systemet at personalisere resultater dramatisk: to brugere, der søger “bedste CRM-værktøjer”, kan modtage helt forskellige anbefalinger, hvis den ene er startup-stifter og den anden er enterprise-chef. Realtids-omrangering forfiner yderligere resultaterne baseret på, hvordan du interagerer med dem—hvis du klikker på bestemte resultater, bruger tid på specifikke sektioner eller stiller opfølgende spørgsmål, justerer systemet sin forståelse af din intention og opdaterer fremtidige anbefalinger tilsvarende. Denne adfærdsmæssige feedback-loop betyder, at AI-systemerne konstant lærer, hvad brugerne faktisk ønsker, ikke blot hvad de oprindelig indtastede. For indholdsskabere og marketingfolk understreger dette vigtigheden af at skabe indhold, der opfylder intention på tværs af flere brugerkontekster og beslutningsstadier.

Moderne AI-systemer klassificerer brugerintention i flere forskellige kategorier, som hver kræver forskellige typer indhold og svar:

LLM’er klassificerer automatisk disse intentioner ved at analysere forespørgselsstruktur, nøgleord og kontekstuelle signaler og vælger derefter det indhold, der bedst matcher den registrerede intentionstype. Forståelse af disse kategorier hjælper indholdsskabere med at strukturere deres sider, så de adresserer den specifikke intention, brugerne bringer til deres søgninger.

Traditionelle nøgleordsbaserede søgemaskiner fungerer gennem simpel streng-matchning—hvis din side indeholder de nøjagtige ord, som nogen søger, kan den blive rangeret. Denne tilgang fejler spektakulært med synonymer, omformuleringer og kontekst. Hvis nogen søger “billig projektstyringssoftware”, og din side bruger udtrykket “budgetvenlig opgavestyringsplatform”, kan traditionel søgning fuldstændigt misse forbindelsen. Semantiske embeddinger løser dette problem ved at omdanne ord og sætninger til matematiske vektorer, der fanger betydning frem for blot overfladetekst. Disse vektorer eksisterer i et højdimensionelt rum, hvor semantisk beslægtede begreber grupperes sammen, så LLM’er kan genkende, at “billig”, “budgetvenlig”, “prisgunstig” og “lavpris” alle udtrykker samme intention. Denne semantiske tilgang håndterer også langt mere komplekse og samtaleprægede forespørgsler bedre end nøgleords-matchning—en forespørgsel som “jeg er freelancer og har brug for noget simpelt men kraftfuldt” kan matches til relevant indhold, selvom den ikke indeholder traditionelle nøgleord. Det praktiske resultat er, at AI-systemer kan fremhæve relevante svar på vage, komplekse eller utraditionelle forespørgsler, hvilket gør dem markant mere nyttige end deres nøgleordsbaserede forgængere.

I den tekniske kerne af intentionsfortolkning ligger transformer-arkitekturen, et neuralt netværksdesign, der bearbejder sprog ved at analysere relationer mellem ord gennem en mekanisme kaldet “attention”. I stedet for at læse tekst sekventielt som et menneske evaluerer transformere, hvordan hvert ord relaterer til alle andre ord i en forespørgsel, hvilket gør dem i stand til at fange nuanceret betydning og kontekst. Semantiske embeddinger er de numeriske repræsentationer, der opstår fra denne proces—hvert ord, sætning eller begreb bliver omdannet til en talvektor, der koder dets betydning. Modeller som BERT (Bidirectional Encoder Representations from Transformers) og RankBrain bruger disse embeddinger til at forstå, at “bedste CRM til startups” og “top kundehåndteringsplatform for nye virksomheder” udtrykker lignende intention, selvom de bruger helt forskellige ord. Attention-mekanismen er særligt kraftfuld, fordi den gør det muligt for modellen at fokusere på de mest relevante dele af en forespørgsel—i “bedste projektstyringsværktøjer til fjernteams med begrænsede budgetter” lærer systemet at vægte “fjernteams” og “begrænsede budgetter” som kritiske intentionssignaler. Denne tekniske sofistikering er årsagen til, at moderne AI-søgning føles så meget mere intelligent end traditionelle nøgleordsbaserede systemer.

Forståelsen af, hvordan LLM’er fortolker intention, ændrer fundamentalt indholdsstrategien. I stedet for at skrive én omfattende guide, der forsøger at rangere på et enkelt nøgleord, adresserer succesfuldt indhold nu flere underintentioner i modulopdelte sektioner, der kan stå alene. Hvis du skriver om projektstyringsværktøjer, skal du i stedet for én stor sammenligning skabe adskilte sektioner, der besvarer “Hvilket er bedst til fjernteams?”, “Hvad er den mest overkommelige mulighed?”, og “Hvilket integrerer med Slack?"—hver sektion bliver et potentielt svar, som LLM’er kan udtrække og citere. Citeringsklar formatering betyder enormt meget: brug fakta frem for vage udsagn, medtag specifikke tal og datoer, og strukturer information, så det er let for AI-systemer at citere eller opsummere. Punktlister, klare overskrifter og korte afsnit hjælper LLM’er med at analysere dit indhold mere effektivt end tæt sammenpresset tekst. Værktøjer som AmICited gør det nu muligt for marketingfolk at overvåge, hvordan AI-systemer refererer til deres indhold på tværs af ChatGPT, Perplexity og Google AI, hvilket afslører, hvilke intentionstilpasninger der virker, og hvor der findes indholdshuller. Denne datadrevne tilgang til indholdsstrategi—optimering for, hvordan AI-systemer faktisk fortolker og citerer dit arbejde—repræsenterer et grundlæggende skift væk fra traditionel SEO.

Tag et e-handelseksempel: Når nogen søger “vandafvisende jakke under 200 kr.”, udtrykker de flere intentioner samtidigt—de ønsker information om holdbarhed, prisbekræftelse og produktanbefalinger. Et AI-system kan udvide dette til underforespørgsler om vandafvisende teknologi, prissammenligninger, brandanmeldelser og garantiinformation. Et brand, der adresserer alle disse vinkler i modulopdelt, velstruktureret indhold, har langt større sandsynlighed for at blive citeret i AI-genererede svar end en konkurrent med en generisk produktside. I SaaS-branchen kan samme forespørgsel “Hvordan inviterer jeg mit team til dette workspace?” optræde hundreder af gange i supportlogs og signalere et kritisk indholdshul. En AI-assistent, der er trænet på din dokumentation, kan have svært ved at besvare dette spørgsmål klart, hvilket fører til dårlig brugeroplevelse og reduceret synlighed i AI-genererede supportsvar. I nyheds- og informationssammenhænge vil en forespørgsel som “Hvad sker der med AI-regulering?” blive fortolket forskelligt afhængigt af brugerkonteksten—en politiker har måske brug for lovgivningsdetaljer, en erhvervsleder konkurrencemæssige implikationer, og en teknolog har brug for tekniske standarder. Succesfuldt indhold adresserer disse forskellige intentionskontekster eksplicit.

På trods af deres sofistikation står LLM’er over for reelle udfordringer i intentionsfortolkning. Tvetydige forespørgsler som “Java” kan referere til programmeringssproget, øen eller kaffen—selv med kontekst kan systemet fejlklassificere intentionen. Blandede eller lagdelte intentioner komplicerer yderligere: “Er denne CRM bedre end Salesforce, og hvor kan jeg prøve den gratis?” kombinerer sammenligning, evaluering og transaktionsintention i én forespørgsel. Kontekstvindues-begrænsninger betyder, at LLM’er kun kan tage et begrænset antal samtalehistorik med, så i lange samtaler kan tidlige intentionssignaler blive glemt. Hallucinationer og faktuelle fejl er fortsat en bekymring, især i domæner, der kræver høj nøjagtighed som sundhed, finans eller juridisk rådgivning. Privatlivshensyn spiller også ind—når systemerne indsamler flere adfærdsdata for at forbedre personaliseringen, skal de balancere intentionsnøjagtighed med brugerens privatliv. Forståelse af disse begrænsninger hjælper indholdsskabere og marketingfolk med at sætte realistiske forventninger til AI-søgesynlighed og erkende, at ikke alle forespørgsler fortolkes perfekt.

Intentionsbaseret søgning udvikler sig hurtigt mod mere sofistikeret forståelse og interaktion. Samtale-AI vil blive stadig mere naturlig, hvor systemerne fastholder konteksten over længere, mere komplekse samtaler, hvor intentionen kan skifte og udvikle sig. Multimodal intentionsforståelse vil kombinere tekst, billeder, stemme og endda video for at fortolke brugermål mere helhedsorienteret—forestil dig at bede en AI-assistent “find noget som dette”, mens du viser et foto. Zero-query search repræsenterer en ny grænse, hvor AI-systemer forudser brugerens behov, før de eksplicit udtrykkes, ved at bruge adfærdssignaler og kontekst til proaktivt at fremhæve relevant information. Forbedret personalisering vil gøre resultaterne stadig mere skræddersyede til individuelle brugerprofiler, beslutningsstadier og kontekstuelle situationer. Integration med anbefalingssystemer vil udviske grænsen mellem søgning og opdagelse, hvor AI-systemer foreslår relevant indhold, brugerne ikke vidste, de skulle søge efter. I takt med at disse muligheder modnes, vil den konkurrencemæssige fordel i stigende grad tilfalde brands og indholdsskabere, der forstår intention dybt og strukturerer deres indhold, så det tilfredsstiller intentionen på tværs af flere kontekster og brugertyper.

Brugerintention henviser til det underliggende mål eller formål bag en forespørgsel, snarere end blot de indtastede nøgleord. LLM'er fortolker semantisk betydning ved at analysere kontekst, formulering og relaterede signaler for at forudsige, hvad brugere reelt ønsker at opnå. Derfor kan samme forespørgsel give forskellige resultater afhængigt af brugerkontekst og beslutningsstadie.

LLM'er bruger en proces kaldet 'query fan-out' til at opdele en enkelt forespørgsel i snesevis af relaterede mikrospørgsmål. For eksempel kan 'Notion vs Trello' udvides til underforespørgsler om teamsamarbejde, prisfastsættelse, integrationer og brugervenlighed. Dette gør det muligt for AI-systemer at udforske forskellige vinkler af intentionen og indsamle omfattende information.

Forståelse af intention hjælper indholdsskabere med at optimere til, hvordan AI-systemer faktisk fortolker og citerer deres arbejde. Indhold, der adresserer flere underintentioner i modulopdelte sektioner, har større sandsynlighed for at blive udvalgt af LLM'er. Dette påvirker direkte synligheden i AI-genererede svar på tværs af ChatGPT, Perplexity og Google AI.

Semantiske embeddinger omdanner ord og sætninger til matematiske vektorer, der fanger betydning snarere end blot overfladetekst. Dette gør det muligt for LLM'er at genkende, at 'billig', 'budgetvenlig' og 'prisgunstig' udtrykker samme intention, selvom de bruger forskellige ord. Denne semantiske tilgang håndterer synonymer, omformulering og kontekst langt bedre end traditionel nøgleords-matchning.

Ja, LLM'er står over for udfordringer med tvetydige forespørgsler, blandede intentioner og kontekstbegrænsninger. Forespørgsler som 'Java' kan referere til programmeringssprog, geografi eller kaffe. Lange samtaler kan overskride kontekstvinduet, hvilket får tidlige intentionssignaler til at blive glemt. Forståelse af disse begrænsninger hjælper med at sætte realistiske forventninger til AI-søgesynlighed.

Brands bør skabe modulopdelt indhold, der adresserer flere underintentioner i adskilte sektioner. Brug citeringsklar formatering med fakta, specifikke tal og klar struktur. Overvåg hvordan AI-systemer refererer til dit indhold med værktøjer som AmICited for at identificere huller i intentionstilpasningen og optimere derefter.

Intention er opgavefokuseret—hvad brugere ønsker at opnå lige nu. Interesse er bredere, generel nysgerrighed. AI-systemer prioriterer intention, da det direkte afgør, hvilket indhold der vælges til svar. En bruger kan være interesseret i produktivitetsværktøjer generelt, men intentionen kan være at finde noget specifikt til fjernteam-samarbejde.

AI-systemer citerer kilder, der bedst matcher den registrerede intention. Hvis dit indhold tydeligt adresserer en specifik underintention med velstruktureret, faktuel information, er det mere sandsynligt at blive udvalgt. Værktøjer som AmICited sporer disse citeringsmønstre og viser, hvilke intentionstilpasninger der driver synlighed i AI-genererede svar.

Forstå hvordan LLM'er refererer til dit indhold på tværs af ChatGPT, Perplexity og Google AI. Spor intentionstilpasning og optimer for AI-synlighed med AmICited.

Lær hvordan du identificerer og optimerer for søgeintention i AI-søgemaskiner. Opdag metoder til at klassificere brugerforespørgsler, analysere AI SERP'er og st...

Lær hvad informationssøgningsintention betyder for AI-systemer, hvordan AI genkender disse forespørgsler, og hvorfor forståelse af denne intention er vigtig for...

Lær, hvordan du udfører effektiv promptforskning for AI-synlighed. Opdag metoder til at forstå brugerforespørgsler i LLM'er og spore dit brand på tværs af ChatG...