Hvordan håndterer AI-søgemaskiner duplikeret indhold? Er det anderledes end Google?

Fællesskabsdiskussion om, hvordan AI-systemer håndterer duplikeret indhold anderledes end traditionelle søgemaskiner. SEO-professionelle deler indsigt om indhol...

AI-dedupliceringslogik refererer til de automatiserede processer og algoritmer, som AI-systemer bruger til at identificere, analysere og eliminere redundante eller dublerede oplysninger fra flere kilder. Disse systemer anvender maskinlæring, naturlig sprogbehandling og teknikker til lighedsmatching for at genkende identisk eller meget lignende indhold på tværs af forskellige dataarkiver, hvilket sikrer datakvalitet, reducerer lageromkostninger og forbedrer beslutningsnøjagtigheden.

AI-dedupliceringslogik refererer til de automatiserede processer og algoritmer, som AI-systemer bruger til at identificere, analysere og eliminere redundante eller dublerede oplysninger fra flere kilder. Disse systemer anvender maskinlæring, naturlig sprogbehandling og teknikker til lighedsmatching for at genkende identisk eller meget lignende indhold på tværs af forskellige dataarkiver, hvilket sikrer datakvalitet, reducerer lageromkostninger og forbedrer beslutningsnøjagtigheden.

AI-dedupliceringslogik er en sofistikeret algoritmisk proces, der identificerer og fjerner dublerede eller næsten dublerede poster fra store datasæt ved hjælp af kunstig intelligens og maskinlæringsteknikker. Denne teknologi opdager automatisk, når flere poster repræsenterer den samme enhed – uanset om det er en person, et produkt, et dokument eller en oplysning – trods variationer i formatering, stavning eller præsentation. Hovedformålet med deduplikering er at opretholde dataintegritet og forhindre redundans, der kan forvride analyser, øge lageromkostninger og kompromittere nøjagtigheden af beslutningstagning. I en datadrevet verden, hvor organisationer dagligt behandler millioner af poster, er effektiv deduplikering blevet essentiel for driftsmæssig effektivitet og pålidelige indsigter.

AI-deduplicering anvender flere supplerende teknikker til at identificere og gruppere lignende poster med bemærkelsesværdig præcision. Processen starter med analyse af dataattributter – såsom navne, adresser, e-mailadresser og andre identificerende oplysninger – hvor disse sammenlignes med fastlagte lighedstærskler. Moderne deduplikeringssystemer bruger en kombination af fonetisk matching, streng-similaritetsalgoritmer og semantisk analyse til at fange dubletter, som traditionelle regelbaserede systemer kunne overse. Systemet tildeler lighedsscorer til potentielle match og samler poster, der overstiger den konfigurerede tærskel, i grupper, der repræsenterer den samme enhed. Brugerne bevarer kontrollen over inklusionniveauet for deduplikering og kan justere følsomheden ud fra deres specifikke brugssituation og tolerance over for falske positiver.

| Metode | Beskrivelse | Bedst til |

|---|---|---|

| Fonetisk lighed | Grupperer strenge, der lyder ens (fx “Smith” vs “Smyth”) | Navnevarianter, fonetisk forveksling |

| Stavningslighed | Grupperer strenge med lignende stavning | Tastefejl, mindre stavevariationer |

| TFIDF-lighed | Anvender algoritmen term frequency-inverse document frequency | Generel tekstmatching, dokumentsimilaritet |

Deduplikeringsmotoren behandler poster i flere omgange, hvor åbenlyse match identificeres først, inden mere subtile variationer undersøges. Denne lagdelte tilgang sikrer omfattende dækning og bevarer samtidig beregningsmæssig effektivitet – selv ved behandling af datasæt med millioner af poster.

Moderne AI-deduplikering udnytter vektorembedding og semantisk analyse til at forstå betydningen bag data i stedet for blot at sammenligne overfladiske karakteristika. Naturlig sprogbehandling (NLP) gør det muligt for systemer at forstå kontekst og intention, så de kan genkende, at “Robert”, “Bob” og “Rob” alle kan referere til samme person trods forskellige former. Fuzzy matching-algoritmer beregner redigeringsafstanden mellem strenge og identificerer poster, der kun adskiller sig med få tegn – afgørende for at opfange tastefejl og transskriptionsfejl. Systemet analyserer også metadata såsom tidsstempler, oprettelsesdatoer og ændringshistorik for at give yderligere tillidssignaler ved afgørelse af, om poster er dubletter. Avancerede implementeringer inkorporerer maskinlæringsmodeller trænet på mærkede datasæt, så nøjagtigheden hele tiden forbedres, efterhånden som der behandles mere data og gives feedback på deduplikeringsbeslutninger.

AI-dedupliceringslogik er blevet uundværlig i stort set alle sektorer, der håndterer datadrift i stor skala. Organisationer udnytter denne teknologi til at opretholde rene, pålidelige datasæt, der muliggør præcis analyse og informerede beslutninger. De praktiske anvendelser spænder over en lang række centrale forretningsfunktioner:

Disse anvendelser viser, hvordan deduplikering har direkte indflydelse på compliance, svindelforebyggelse og driftssikkerhed på tværs af brancher.

De økonomiske og driftsmæssige fordele ved AI-deduplikering er betydelige og målbare. Organisationer kan reducere lageromkostninger markant ved at eliminere redundant data – nogle implementeringer opnår 20-40% reduktion i lagerkrav. Forbedret datakvalitet fører direkte til bedre analyser og beslutninger, da analyser baseret på rene data giver mere pålidelige indsigter og prognoser. Forskning viser, at data science-specialister bruger ca. 80% af deres tid på datapreparation, hvor dublerede poster er en stor belastning – deduplikeringsautomatisering frigør værdifuld analysetid til arbejde med højere værdi. Studier viser, at 10-30% af posterne i typiske databaser indeholder dubletter, hvilket udgør en væsentlig kilde til ineffektivitet og fejl. Ud over besparelser styrker deduplikering compliance og overholdelse af regler ved at sikre korrekt journalføring og forhindre dublerede indsendelser, som kan udløse revisioner eller bøder. De driftsmæssige effektivitetsgevinster omfatter hurtigere forespørgsler, reduceret beregningsmæssig belastning og forbedret systempålidelighed.

På trods af sin avancerede karakter er AI-deduplikering ikke uden udfordringer og begrænsninger, som organisationer skal håndtere omhyggeligt. Falske positiver – at forskellige poster fejlagtigt identificeres som dubletter – kan føre til datatab eller sammenflettede poster, der burde forblive separate, mens falske negativer lader reelle dubletter slippe igennem uopdaget. Deduplikering bliver eksponentielt mere kompleks, når der arbejdes med multiformatdata fra forskellige systemer, sprog og datastrukturer, hver med unikke konventioner og kodningsstandarder. Privatlivs- og sikkerhedshensyn opstår, når deduplikering kræver analyse af følsomme personoplysninger, hvilket forudsætter robust kryptering og adgangskontrol for at beskytte data under matchingprocessen. Nøjagtigheden af deduplikeringssystemer er grundlæggende begrænset af kvaliteten af inputdata; garbage in, garbage out – og ufuldstændige eller korrupte poster kan forvirre selv de mest avancerede algoritmer.

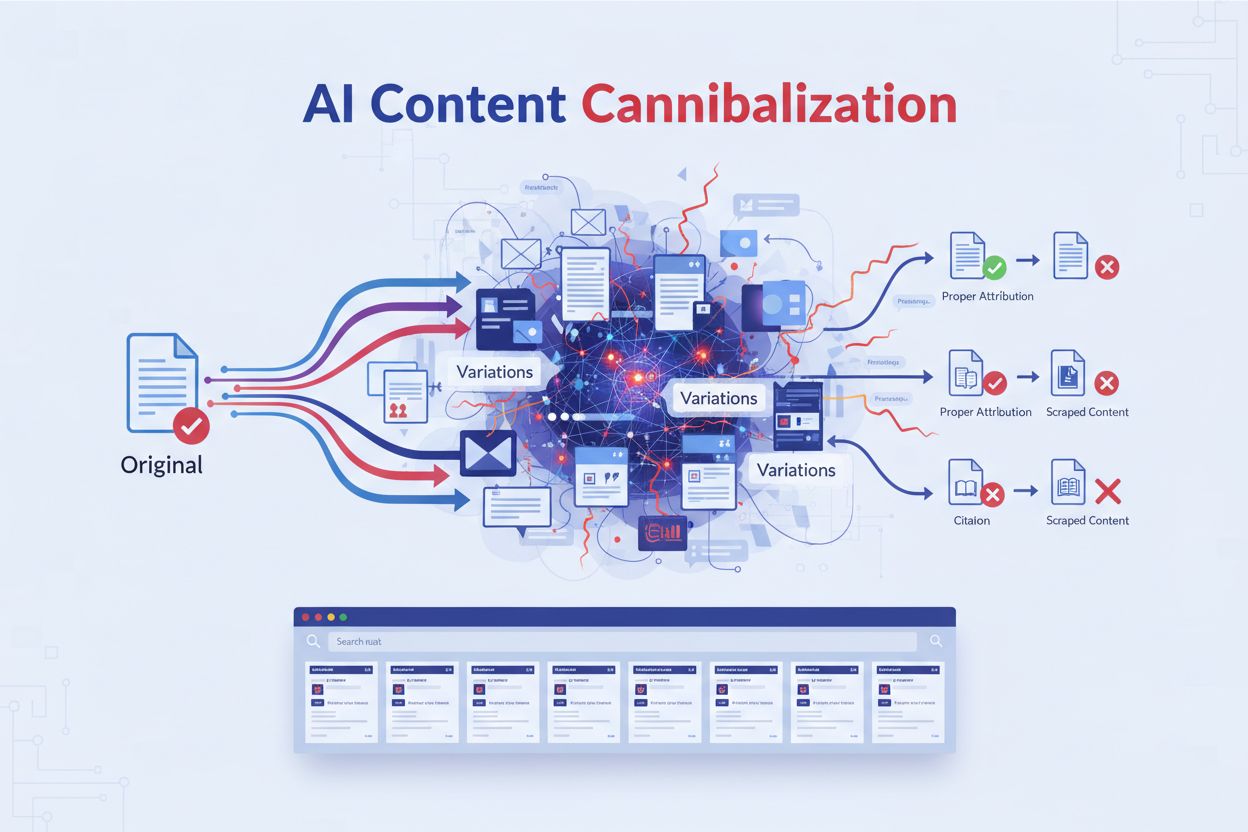

AI-deduplikering er blevet en kritisk komponent i moderne AI-svarovervågningsplatforme og søgesystemer, der samler information fra flere kilder. Når AI-systemer sammenfatter svar fra mange dokumenter og kilder, sikrer deduplikering, at den samme information ikke tælles flere gange, hvilket ellers ville oppuste tillidsscorer og forvride relevansrangeringer. Kildeangivelse bliver mere meningsfuld, når deduplikering fjerner redundante kilder, så brugerne kan se det reelle mangfoldige bevisgrundlag for et svar. Platforme som AmICited.com udnytter deduplikeringslogik til at levere transparent og nøjagtig kildeovervågning ved at identificere, når flere kilder reelt indeholder identisk information og konsolidere dem passende. Dette forhindrer, at AI-svar ser ud til at have større opbakning, end de faktisk har, og fastholder integriteten af kildeangivelse og svarenes troværdighed. Ved at filtrere dublerede kilder fra forbedrer deduplikering kvaliteten af AI-søgeresultater og sikrer, at brugerne får ægte mangfoldige perspektiver i stedet for gentagelser af samme information på tværs af kilder. Teknologien styrker til syvende og sidst tilliden til AI-systemer ved at give et renere og mere ærligt billede af det bevismateriale, der ligger til grund for AI-genererede svar.

AI-deduplikering og datakomprimering reducerer begge datamængden, men de fungerer forskelligt. Deduplikering identificerer og fjerner nøjagtige eller næsten ens poster, så kun én forekomst bevares, mens de andre erstattes af referencer. Datakomprimering derimod koder data mere effektivt uden at fjerne dubletter. Deduplikering fungerer på makroniveau (hele filer eller poster), mens komprimering fungerer på mikroniveau (enkeltbits og bytes). For organisationer med betydelige datadubletter giver deduplikering typisk større besparelser på lagerplads.

AI bruger flere avancerede teknikker til at fange ikke-nøjagtige dubletter. Fonetiske algoritmer genkender navne, der lyder ens (fx 'Smith' vs 'Smyth'). Fuzzy matching beregner redigeringsafstand for at finde poster, der kun adskiller sig med få tegn. Vektorembedding omdanner tekst til matematiske repræsentationer, der fanger semantisk betydning, hvilket gør det muligt for systemet at genkende omformuleret indhold. Maskinlæringsmodeller trænet på mærkede datasæt lærer mønstre for, hvad der udgør en dublet i specifikke sammenhænge. Disse teknikker arbejder sammen for at identificere dubletter trods variationer i stavning, formatering eller præsentation.

Deduplikering kan markant reducere lageromkostningerne ved at eliminere redundant data. Organisationer opnår typisk 20-40% reduktion i lagerkrav efter implementering af effektiv deduplikering. Disse besparelser akkumuleres over tid, efterhånden som nye data løbende deduplikeres. Ud over direkte besparelser på lageret reducerer deduplikering også udgifter til datastyring, backup-operationer og systemvedligeholdelse. For store virksomheder, der behandler millioner af poster, kan besparelserne løbe op i hundredtusindvis af kroner årligt, hvilket gør deduplikering til en investering med højt afkast.

Ja, moderne AI-deduplikeringssystemer kan fungere på tværs af forskellige filformater, men det kræver mere avanceret behandling. Systemet skal først normalisere data fra forskellige formater (PDF'er, Word-dokumenter, regneark, databaser osv.) til en sammenlignelig struktur. Avancerede løsninger bruger optisk tegngenkendelse (OCR) til scannede dokumenter og format-specifikke parser til at udtrække meningsfuldt indhold. Dog kan deduplikeringsnøjagtigheden variere afhængigt af formatets kompleksitet og datakvalitet. Organisationer opnår typisk de bedste resultater, når deduplikering anvendes på strukturerede data i ensartede formater, selvom krydsformat-deduplikering bliver stadig mere mulig med moderne AI-teknikker.

Deduplikering forbedrer AI-søgeresultater ved at sikre, at relevansrangeringer afspejler ægte mangfoldighed af kilder i stedet for variationer af samme information. Når flere kilder indeholder identisk eller næsten identisk indhold, konsoliderer deduplikering dem og forhindrer kunstig oppustning af tillidsscorer. Det giver brugerne et renere og mere ærligt billede af beviser, der understøtter AI-genererede svar. Deduplikering forbedrer også søgeydelsen ved at reducere mængden af data, systemet skal behandle, hvilket muliggør hurtigere forespørgsler. Ved at filtrere redundante kilder fra kan AI-systemer fokusere på reelt forskellige perspektiver og information, hvilket i sidste ende leverer resultater af højere kvalitet og større troværdighed.

Falske positiver opstår, når deduplikering fejlagtigt identificerer forskellige poster som dubletter og sammenfletter dem. For eksempel sammenfletning af poster for 'John Smith' og 'Jane Smith', som er forskellige personer, men deler efternavn. Falske positiver er problematiske, fordi de medfører permanent datatab – når poster først er sammenflettet, bliver det svært eller umuligt at gendanne de oprindelige oplysninger. I kritiske applikationer som sundhedsvæsen eller finansielle tjenester kan falske positiver have alvorlige konsekvenser, herunder forkerte sundhedsjournaler eller svigagtige transaktioner. Organisationer skal nøje kalibrere deduplikeringsfølsomhed for at minimere falske positiver og accepterer ofte nogle falske negativer (oversete dubletter) som et sikrere kompromis.

Deduplikering er afgørende for AI-indholdsovervågningsplatforme som AmICited, der sporer, hvordan AI-systemer refererer til brands og kilder. Ved overvågning af AI-svar på tværs af flere platforme (GPT'er, Perplexity, Google AI) forhindrer deduplikering, at samme kilde tælles flere gange, hvis den optræder i forskellige AI-systemer eller formater. Dette sikrer nøjagtig kildeangivelse og forhindrer oppustede synlighedsmålinger. Deduplikering hjælper også med at identificere, når AI-systemer reelt trækker på et begrænset sæt kilder, selvom det ser ud til, at beviserne er mangfoldige. Ved at konsolidere dublerede kilder giver indholdsovervågningsplatforme et klarere billede af, hvilke unikke kilder der faktisk påvirker AI-svar.

Metadata – information om data såsom oprettelsesdatoer, ændringstidspunkter, forfatteroplysninger og filegenskaber – spiller en afgørende rolle i dubletdetektion. Metadata hjælper med at fastslå posternes livscyklus og viser, hvornår dokumenter blev oprettet, opdateret eller tilgået. Disse tidsmæssige oplysninger hjælper med at skelne mellem legitime versioner af dokumenter i udvikling og egentlige dubletter. Forfatteroplysninger og tilknytning til afdelinger giver kontekst om postens oprindelse og formål. Adgangsmønstre viser, om dokumenter bruges aktivt eller er forældede. Avancerede deduplikeringssystemer integrerer metadataanalyse med indholdsanalyse og bruger begge signaler til mere præcist at afgøre dubletter og hvilken version der skal bevares som den autoritative kilde.

AmICited sporer, hvordan AI-systemer som GPT'er, Perplexity og Google AI refererer til dit brand på tværs af flere kilder. Sikr nøjagtig kildeangivelse og forhindre, at dubleret indhold forvrænger din AI-synlighed.

Fællesskabsdiskussion om, hvordan AI-systemer håndterer duplikeret indhold anderledes end traditionelle søgemaskiner. SEO-professionelle deler indsigt om indhol...

Lær hvordan kanoniske URL'er forhindrer problemer med dubleret indhold i AI-søgesystemer. Oplev bedste praksis for implementering af kanoniske tags for at forbe...

Lær hvad AI-indhold kannibalisering er, hvordan det adskiller sig fra duplikeret indhold, hvorfor det skader rangeringer, og strategier til at beskytte dit indh...