Panda-opdatering

Lær om Googles Panda-opdatering, algoritmeændringen fra 2011, der fokuserer på lavkvalitetsindhold. Forstå hvordan den fungerer, dens betydning for SEO, og stra...

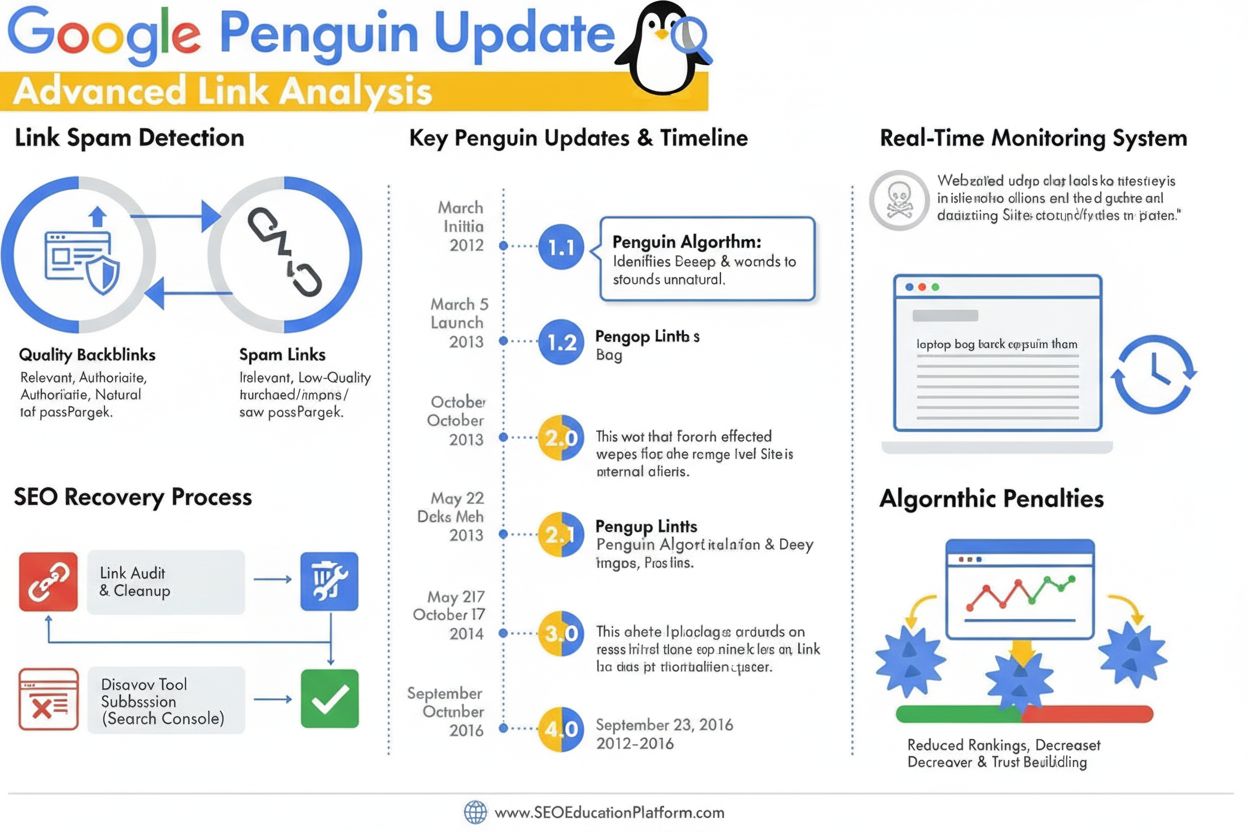

Penguin-opdateringen er en Google-algoritme, der er designet til at bekæmpe linkspam og manipulerende linkbuilding-praksis ved at identificere og nedvurdere lavkvalitets, unaturlige backlinks. Første gang lanceret i april 2012, udviklede den sig i 2016 til en realtids-algoritmekomponent, der løbende overvåger og justerer placeringer baseret på backlink-kvalitet og mønstre i linkskemaer.

Penguin-opdateringen er en Google-algoritme, der er designet til at bekæmpe linkspam og manipulerende linkbuilding-praksis ved at identificere og nedvurdere lavkvalitets, unaturlige backlinks. Første gang lanceret i april 2012, udviklede den sig i 2016 til en realtids-algoritmekomponent, der løbende overvåger og justerer placeringer baseret på backlink-kvalitet og mønstre i linkskemaer.

Penguin-opdateringen er en Google-algoritme, der er specielt designet til at bekæmpe linkspam og manipulerende linkbuilding-praksis ved at identificere, nedvurdere og straffe websites med unaturlige eller lavkvalitets backlink-profiler. Først officielt annonceret af Matt Cutts den 24. april 2012, repræsenterede Penguin-algoritmen Googles aggressive svar på det voksende problem med black-hat SEO-teknikker, der kunstigt oppustede søgeresultater gennem købte links, linkudvekslinger og andre vildledende metoder. Algoritmens primære mål er at sikre, at naturlige, autoritative og relevante links belønnes, mens manipulerende og spammy links nedgraderes eller ignoreres helt. I modsætning til indholdsorienterede opdateringer som Panda, der går efter lavkvalitetsindhold, vurderer Penguin specifikt kvaliteten og ægtheden af en hjemmesides indgående linkprofil og er blevet en kritisk del af Googles rangeringssystem igennem mere end et årti.

Penguin-opdateringen opstod i en kritisk periode inden for søgemaskineoptimering, hvor linkmængde spillede en uforholdsmæssigt stor rolle for søgeresultater. Før Penguin blev lanceret, kunne webansvarlige kunstigt forbedre deres placering ved at erhverve store mængder lavkvalitetslinks fra linkfarme, private blognetværk og andre spamkilder. Denne praksis skabte store problemer for Googles søgeresultater, da lavkvalitets websites og indhold dukkede op på fremtrædende pladser uden at have reel autoritet eller relevans. Matt Cutts, daværende leder af Googles webspam-team, forklarede på SMX Advanced 2012-konferencen: “Vi ser det som noget, der er designet til at tackle lavkvalitetsindhold. Det startede med Panda, og så opdagede vi, at der stadig var meget spam, og Penguin blev designet til at tackle dét.” Den første Penguin-lancering påvirkede mere end 3 % af alle søgeforespørgsler og blev en af de mest indflydelsesrige algoritmeopdateringer i Googles historie. Denne store indvirkning signalerede til SEO-branchen, at Google mente det alvorligt med at bekæmpe manipulerende linkpraksis og ville fortsætte med at udvikle sine algoritmer for at opretholde søgekvaliteten.

Penguin-algoritmen fungerer gennem avancerede maskinlærings- og mønstergenkendelsessystemer, der analyserer backlink-profiler for at identificere unaturlige linkmønstre. Algoritmen undersøger flere faktorer ved vurdering af linkkvalitet, herunder autoritet og relevans af domæner, der linker, den anvendte ankertekst, hastigheden af linkopbygning og den kontekstuelle relevans mellem det linkende site og målsitet. Penguin går specifikt efter linkskemaer, der dækker en bred vifte af manipulerende praksis, herunder købte links, gensidige linkudvekslinger, links fra private blognetværk (PBN’er), links fra lavkvalitets kataloger og links med overdreven nøgleordsfyldt ankertekst. Algoritmen vurderer også forholdet mellem højkvalitets- og lavkvalitetslinks i en hjemmesides backlink-profil og anerkender, at selv legitime websites lejlighedsvis modtager nogle lavkvalitetslinks. Men når andelen af spamlinks bliver uforholdsmæssigt høj, markerer Penguin sitet for potentielle justeringer af placering. En vigtig detalje ved Penguins design er, at den kun vurderer indgående links til en hjemmeside; den analyserer ikke udgående links fra sitet, men fokuserer udelukkende på kvaliteten af backlinks, der peger på et domæne.

Penguin-opdateringen gennemgik betydelig udvikling fra sin første lancering til flere iterationer, hvor den mest gennemgribende ændring skete i september 2016, da Penguin 4.0 blev frigivet. Indtil da kørte Penguin på en batchopdateringsplan, hvor Google annoncerede periodiske genopfriskninger, der genvurderede websites’ backlink-profiler og justerede placeringer derefter. Penguin 1.1 (marts 2012) og Penguin 1.2 (oktober 2012) var dataopdateringer, der gjorde det muligt for tidligere straffede sider at komme sig, hvis de havde renset deres linkprofiler. Penguin 2.0 (maj 2013) var en mere teknisk avanceret version, der påvirkede omkring 2,3 % af engelske forespørgsler og var den første iteration, der så ud over forsiden og kategori-topniveauet og undersøgte dybere site-strukturer for linkspam. Penguin 2.1 (oktober 2013) og Penguin 3.0 (oktober 2014) videreførte denne udvikling med gradvise forbedringer af opdagelsesevnen. Men frigivelsen af Penguin 4.0 ændrede fundamentalt, hvordan algoritmen fungerer, ved at integrere den i Googles kernealgoritme som en realtidskomponent. Det betød, at websites nu vurderes løbende, og placeringsjusteringer sker straks, når linkprofiler ændres, fremfor at vente på skemalagte opdateringer. Skiftet til realtidsbehandling ændrede også Penguins strafmekanisme fra deciderede placeringsstraffe til linknedvurdering, hvor spamlinks blot ignoreres frem for at medføre sitewide placeringsfald.

| Vurderingsfaktor | Højkvalitetslinks | Lavkvalitets-/spamlinks | Penguin-opdagelse |

|---|---|---|---|

| Linksources autoritet | Etablerede, betroede domæner med høj domæneautoritet | Nye domæner, lav DA-sider eller kendte spamnetværk | Analyserer domænehistorik, troværdighedssignaler og tematisk relevans |

| Ankertekst | Naturlige, varierede, kontekstuelt relevante fraser | Eksakt match-nøgleord, gentagelser, overoptimeret | Markerer unaturlige ankertekstmønstre og nøgleordsfyldning |

| Linkhastighed | Gradvis, organisk opbygning over tid | Pludselige stigninger eller unaturlige mønstre | Overvåger opbygningshastighed og konsistens |

| Kontekstuel relevans | Links fra tematisk relaterede, autoritative kilder | Links fra ikke-relaterede eller lavkvalitetskilder | Vurderer semantisk relevans mellem linker og målside |

| Linkplacering | Redaktionelle links i indhold, naturlig kontekst | Footer-links, sidebar-links eller linkfarm-placeringer | Vurderer linkplacering og kontekstuel integration |

| Linkende sites kvalitet | Højkvalitetsindhold, legitim forretningsprofil | Tyndt indhold, auto-genererede sider eller PBN’er | Undersøger generel sidekvalitet og indholdets ægthed |

| Nofollow-status | Korrekt brugt, hvor det er passende | Misbrugt eller mangler på betalte/promoverede links | Genkender korrekt brug af nofollow til ikke-redaktionelle links |

Penguin-opdateringen ændrede grundlæggende SEO-praksis ved at gøre linkkvalitet til en kritisk rangeringsfaktor og ved at afskrække udbredt brug af black-hat linkbuilding-teknikker. Før Penguin deltog mange SEO-bureauer og webansvarlige i aggressive linkkøbs-kampagner, linkudvekslinger og opbygning af PBN’er uden væsentlige konsekvenser. Algoritmens lancering skabte øjeblikkelig markedsforstyrrelse, og tusindvis af websites oplevede markante fald i placeringer og trafik. Dette tvang SEO-branchen til at tage mere etiske, white-hat metoder i brug med fokus på at opnå links gennem højkvalitetsindhold og ægte relationsopbygning. Penguin-straffen blev et advarende eksempel, der påvirkede, hvordan virksomheder arbejdede med linkbuilding, og førte til øgede investeringer i content marketing, public relations og brandopbygning som primære linkstrategier. Branchen har nu indset, at forståelse og overholdelse af Penguins krav er afgørende for langsigtet SEO-succes, og mange organisationer har implementeret backlink-audit og linkovervågning som standardpraksis. Algoritmen har også fremhævet vigtigheden af domæneautoritet, tematisk relevans og linkhastighed som vigtige målepunkter, SEO-specialister følger ved vurdering af linkmuligheder. Over 78 % af virksomheder bruger nu en form for AI-drevet indholdsovervågning eller linkanalyseværktøjer til at overvåge deres backlink-profiler og sikre overholdelse af Googles kvalitetsretningslinjer, hvilket direkte skyldes Penguins indflydelse på branchestandarder.

Genopretning fra en Penguin-nedgradering kræver en systematisk tilgang med backlink-audit, linkfjernelse og strategisk brug af Googles afvisningsværktøj. Første skridt er en omfattende audit af alle indgående links med Google Search Console og tredjepartsværktøjer som Ahrefs, SEMrush eller Moz, der giver detaljerede backlink-profiler og kvalitetsvurderinger. Webansvarlige skal derefter individuelt vurdere hvert domæne, der linker, for at afgøre, om linket er højkvalitets og naturligt eller repræsenterer en manipulerende praksis. For links, der tydeligt er spam eller lavkvalitet, anbefales det at kontakte webmasteren for det linkende site og anmode om fjernelse. Google anbefaler eksplicit ikke at betale for linkfjernelser, da det opretholder problemet med linkhandel. For links, der ikke kan fjernes via outreach, gør afvisningsværktøjet i Google Search Console det muligt at indsende en fil, der fortæller Google at ignorere bestemte links ved evaluering af sitet. Det er vigtigt at bemærke, at afvisning af et link også fjerner eventuel positiv værdi, det måtte have haft, så værktøjet bør kun bruges til reelt skadelige links. Når en afvisningsfil er indsendt, behandler Google den straks, men den faktiske effekt på placering afhænger af, hvornår Google genindekserer de afviste links. Da Penguin 4.0 kører i realtid, kan genopretning ske relativt hurtigt—nogle gange inden for dage eller uger—når der er taget tilstrækkelige korrigerende handlinger. Dog bør webansvarlige ikke forvente, at placeringerne vender tilbage til niveauet før straffen, da nogle af de placeringer kan have været kunstigt oppustet af de lavkvalitetslinks, der nu fjernes.

Efterhånden som AI-søgeplatforme som ChatGPT, Perplexity, Google AI Overviews og Claude bliver stadig vigtigere for synlighed af brands, bliver forståelsen af Penguins principper relevant ud over traditionelle søgeresultater. Disse AI-systemer citerer ofte autoritative kilder og højkvalitetswebsites, når de genererer svar, og websites med stærke backlink-profiler og rene linkhistorikker bliver oftere anerkendt som autoritative af AI-træningsdata og søgesystemer. Et website, der er straffet af Penguin for linkspam, kan ikke kun lide under lavere placering i Googles organiske søgeresultater, men kan også blive nedprioriteret af AI-systemer, der vurderer kilders troværdighed. Omvendt har websites med rene, højkvalitets backlink-profiler større sandsynlighed for at blive citeret som autoritative kilder i AI-genererede svar. Dette skaber et ekstra incitament til at overholde Penguin ud over traditionelle SEO-målinger. AmICited og lignende AI-overvågningsplatforme hjælper organisationer med at spore, hvordan deres domæner vises i AI-genererede svar, og giver indsigt i, om deres autoritet anerkendes på tværs af flere AI-søgesystemer. Skæringspunktet mellem Penguin-overholdelse og AI-citationssporing markerer en ny æra inden for digital markedsføring, hvor linkkvalitet påvirker både traditionel søgesynlighed og synlighed i nye AI-søgemiljøer.

Penguin-opdateringen udvikler sig fortsat, i takt med at Google forfiner sin forståelse af linkkvalitet og manipulerende praksis. Overgangen til realtidsbehandling i 2016 var et grundlæggende skifte i algoritmens funktion, men Google forbedrer fortsat sine opdagelsesmuligheder med maskinlæring og kunstig intelligens. Seneste udvikling i Googles SpamBrain-system, annonceret i 2022, markerer næste skridt i spambekæmpelse og inkorporerer avanceret AI til at identificere både sider, der køber links, og sider, der bruges til linkdistribution. Dette antyder, at fremtidige iterationer af linkspambekæmpelse vil blive endnu mere avancerede og gøre det sværere for manipulerende praksis at undgå opdagelse. Industriens bevægelse mod white-hat SEO og fortjent omtale vil sandsynligvis accelerere, efterhånden som Googles algoritmer bliver bedre til at skelne mellem naturlige og kunstige links. Desuden, efterhånden som AI-søgeplatforme får større betydning, bliver det vigtigt at vedligeholde rene backlink-profiler, ikke kun for Googles algoritme, men også for bredere anerkendelse som autoritativ kilde på tværs af flere AI-systemer. Organisationer, der prioriterer linkkvalitet, brandautoritet og indholdsekspertise, vil stå stærkere i både traditionelle og nye AI-søgninger. Penguin-opdateringens arv er ikke blot en specifik algoritme, men et grundlæggende skifte i, hvordan søgemaskiner og AI-systemer vurderer websiteautoritet, hvilket gør linkkvalitet til en permanent og stadigt vigtigere faktor for digital synlighed.

En Penguin-nedgradering er algoritmisk og sker automatisk, når Googles Penguin-algoritme opdager mønstre af linkspam, uden at manuel indgriben er nødvendig. En Penguin-straf (eller manuel handling) gives af Googles webspam-team efter menneskelig gennemgang og kræver en genovervejningsanmodning for at blive ophævet. Siden Penguin 4.0 blev realtid i 2016, kan man næsten straks komme sig over algoritmiske nedgraderinger, når der er taget korrigerende handling, mens manuelle straffe kræver eksplicit godkendelse fra Google.

Penguin-opdateringen bruger maskinlæringsalgoritmer til at analysere backlink-profiler og identificere mønstre af manipulerende linkbuilding, herunder købte links, linkudvekslinger, private blognetværk (PBN'er) og unaturlige ankertekstmønstre. Algoritmen vurderer forholdet mellem højkvalitets, naturlige links og lavkvalitets spamlinks, der peger på et website. Den undersøger også relevansen og autoriteten af de domæner, der linker, for at afgøre, om links ser kunstigt opnåede ud i stedet for redaktionelt fortjente.

Ja, genopretning er mulig gennem en flertrinsproces, der involverer backlink-audit, fjernelse af spamlinks og brug af Googles afvisningsværktøj for links, du ikke kan fjerne direkte. Da Penguin 4.0 kører i realtid, kan genopretning ske relativt hurtigt, når du har renset din linkprofil, og Google genindekserer disse sider. Dog er genopretning ingen garanti for at vende tilbage til tidligere placeringer, da nogle af de placeringer kan have været kunstigt oppustet af de lavkvalitetslinks, du fjerner.

Penguin straffer links fra linkfarme, betalte linknetværk, private blognetværk (PBN'er), gensidige linkudvekslinger og sider med unaturlige ankertekstmønstre. Den går også efter links fra lavkvalitets kataloger, kommentarspam, forumspam og links opnået gennem manipulerende praksis. Derudover markerer Penguin links fra højt autoritative sider, der ser ud til at være solgt eller placeret som advertorials uden korrekte nofollow-tags, da disse overtræder Googles retningslinjer for linkskemaer.

Siden Penguin 4.0 blev frigivet i september 2016, kører algoritmen kontinuerligt i realtid som en del af Googles kernealgoritme. Det betyder, at Google konstant vurderer backlink-profiler og justerer placeringer baseret på linkkvalitet uden at vente på planlagte opdateringer. Tidligere kørte Penguin på en batchopdateringsplan med opdateringer annonceret af Google, men realtidsbehandling har elimineret behovet for disse annonceringer og giver hurtigere genopretning, når problemer er løst.

Afvisningsværktøjet er en funktion i Google Search Console, der gør det muligt for webansvarlige at fortælle Google at ignorere bestemte backlinks ved evaluering af deres site. Det bruges som en sidste udvej, når du ikke direkte kan kontakte webansvarlige for at fjerne spamlinks. Ved at afvise lavkvalitetslinks forhindrer du dem i at påvirke dine placeringer negativt under Penguin-algoritmen. Dog giver afviste links heller ikke længere nogen positiv værdi, så det bør kun bruges på reelt skadelige links.

Den oprindelige Penguin-opdatering, der blev lanceret i april 2012, påvirkede over 3% af alle søgeforespørgsler ifølge Googles estimater. Efterfølgende opdateringer havde varierende indvirkning: Penguin 2.0 ramte cirka 2,3% af engelske forespørgsler, Penguin 2.1 ramte cirka 1% af forespørgslerne, og Penguin 3.0 ramte mindre end 1% af de engelske søgeforespørgsler. Disse procenter repræsenterer millioner af websites globalt og gør Penguin til en af de mest betydningsfulde algoritmeopdateringer i søgehistorien.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær om Googles Panda-opdatering, algoritmeændringen fra 2011, der fokuserer på lavkvalitetsindhold. Forstå hvordan den fungerer, dens betydning for SEO, og stra...

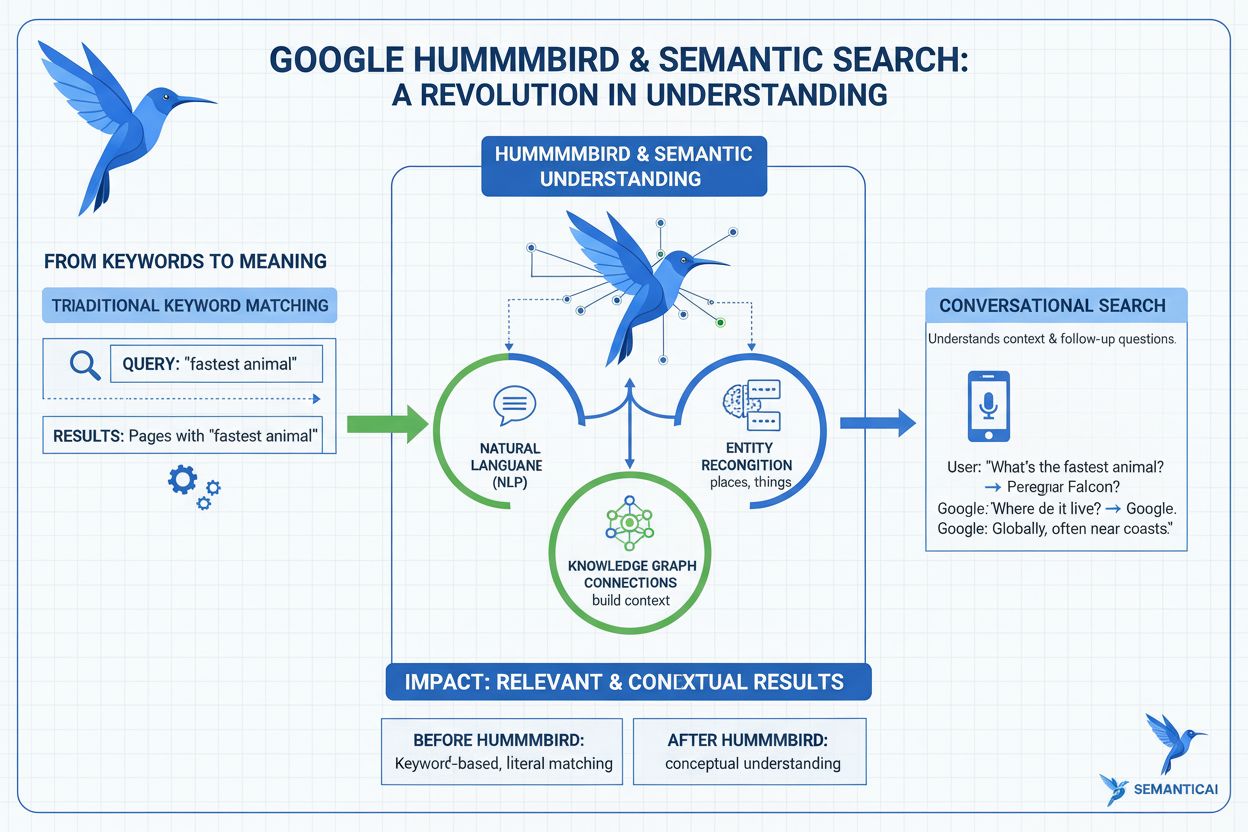

Lær hvad Hummingbird-opdateringen er, hvordan den revolutionerede semantisk søgning i 2013, og hvorfor det er vigtigt for AI-overvågning og brand-synlighed på t...

Lær hvad Google-algoritmeopdateringer er, hvordan de fungerer, og deres indvirkning på SEO. Forstå kerneopdateringer, spamopdateringer og ændringer i rangering....