Hvad er Perplexity Score i Indhold?

Lær hvad perpleksitet score betyder i indhold og sprogmodeller. Forstå hvordan det måler modellens usikkerhed, prædiktionsnøjagtighed og vurdering af tekstkvali...

Perpleksitets-score er en kvantitativ måleenhed, der viser usikkerheden eller forudsigeligheden af tekst fra en sprogmodel, beregnet som den eksponentialiserede gennemsnitlige negative log-sandsynlighed for forudsagte tokens. Lavere perpleksitets-scorer indikerer højere model-tillid og bedre tekstforudsigelse, mens højere scorer afspejler større usikkerhed ved forudsigelse af det næste ord i en sekvens.

Perpleksitets-score er en kvantitativ måleenhed, der viser usikkerheden eller forudsigeligheden af tekst fra en sprogmodel, beregnet som den eksponentialiserede gennemsnitlige negative log-sandsynlighed for forudsagte tokens. Lavere perpleksitets-scorer indikerer højere model-tillid og bedre tekstforudsigelse, mens højere scorer afspejler større usikkerhed ved forudsigelse af det næste ord i en sekvens.

Perpleksitets-score er en grundlæggende måleenhed i naturlig sprogbehandling, som kvantificerer usikkerheden eller forudsigeligheden af tekst genereret af sprogmodeller. Formelt defineret som den eksponentialiserede gennemsnitlige negative log-sandsynlighed for en sekvens, måler perpleksitets-score, hvor godt en sandsynlighedsmodel forudsiger et eksempel ved at beregne det gennemsnitlige antal lige sandsynlige ordvalg, en model overvejer, når den forudsiger det næste token. Måleenheden opstod i 1977 fra IBM-forskere, der arbejdede med talegenkendelse under ledelse af Frederick Jelinek, som ønskede at måle, hvor svært en statistisk model har ved forudsigelsesopgaver. I konteksten af moderne AI-systemer som ChatGPT, Claude, Perplexity AI og Google AI Overviews fungerer perpleksitets-score som en kritisk evalueringsmekanisme for at vurdere modeltillid og tekstgenereringskvalitet. Lavere perpleksitets-scorer indikerer, at en model er mere sikker på sine forudsigelser og tildeler højere sandsynligheder til korrekte ord, mens højere scorer afspejler større usikkerhed og forvirring om, hvilket ord der skal komme næste i en sekvens.

Konceptet perpleksitets-score opstod fra informationsteoriens principper etableret af Claude Shannon i 1940’erne og 1950’erne, som udviklede de matematiske grundlag for entropi og dens anvendelse på sprog. Shannons banebrydende arbejde om “Prediction and Entropy of Printed English” viste, at mennesker kan forudsige efterfølgende tegn i tekst med bemærkelsesværdig præcision, hvilket lagde det teoretiske grundlag for computerbaseret sprogmodellering. Gennem 1980’erne og 1990’erne blev perpleksitets-score den dominerende måleenhed for evaluering af n-gram-sprogmodeller, som var den førende tilgang før deep learning-revolutionen. Målingens popularitet fortsatte med fremkomsten af neurale sprogmodeller, rekurrente neurale netværk og transformerbaserede arkitekturer, hvilket gjorde den til en af de mest vedvarende evalueringsstandarder i NLP. I dag er perpleksitets-score fortsat udbredt sammen med nyere målinger som BERTScore, ROUGE og LLM-as-a-Judge-evalueringer, selvom forskere i stigende grad erkender, at den skal kombineres med andre målinger for en dækkende modelvurdering. Målingens levetid afspejler både dens matematiske elegance og praktiske anvendelighed, selvom moderne anvendelser har afsløret vigtige begrænsninger, der kræver supplerende evalueringsmetoder.

Det matematiske grundlag for perpleksitets-score hviler på tre sammenhængende koncepter fra informationsteorien: entropi, kryds-entropi og log-sandsynlighed. Entropi måler den gennemsnitlige usikkerhed i en enkelt sandsynlighedsfordeling og kvantificerer, hvor uforudsigeligt det næste ord er baseret på tidligere kontekst. Kryds-entropi udvider dette koncept ved at måle forskellen mellem den sande datafordeling og den forudsagte fordeling fra en model og straffer unøjagtige forudsigelser. Den formelle beregning af perpleksitets-score udtrykkes som: PPL(X) = exp{-1/t ∑ log p_θ(x_i|x_<i)}, hvor t repræsenterer det samlede antal tokens i en sekvens, og p_θ(x_i|x_<i) er den forudsagte sandsynlighed for det i’te token givet alle foregående tokens. Denne formel omdanner den gennemsnitlige negative log-sandsynlighed til en fortolkelig måleenhed ved at anvende eksponentialfunktionen, der reelt “ophæver” logaritmen og fører målingen tilbage til sandsynlighedsrummet. Den resulterende værdi repræsenterer den effektive forgreningsfaktor—det gennemsnitlige antal lige sandsynlige ordvalg, modellen overvejer ved hvert forudsigelsestrin. For eksempel betyder en perpleksitets-score på 10, at modellen i gennemsnit vælger mellem 10 lige sandsynlige muligheder for næste ord, mens en score på 100 indikerer, at modellen overvejer 100 mulige alternativer, hvilket afspejler væsentligt større usikkerhed.

| Måling | Definition | Måler | Fortolkning | Begrænsninger |

|---|---|---|---|---|

| Perpleksitets-score | Eksponentialiseret gennemsnitlig negativ log-sandsynlighed | Modelusikkerhed og tillid i forudsigelser | Lavere = mere sikker; Højere = mere usikker | Måler ikke nøjagtighed eller semantisk forståelse |

| Entropi | Gennemsnitlig usikkerhed i én sandsynlighedsfordeling | Medfødt uforudsigelighed af udfald | Højere entropi = mere uforudsigeligt sprog | Sammenligner ikke forudsagt vs. sand fordeling |

| Kryds-entropi | Forskel mellem sand og forudsagt sandsynlighedsfordeling | Hvor godt model-forudsigelser matcher actual data | Lavere = bedre overensstemmelse med sand fordeling | Udtrykkes i log-rum, mindre intuitiv end perpleksitet |

| BLEU-score | Præcision af n-gram-overlap mellem genereret og reference-tekst | Oversættelses- og opsummeringskvalitet | Højere = mere lig reference | Fanger ikke semantisk betydning eller flydende sprog |

| ROUGE-score | Recall af n-gram-overlap mellem genereret og reference-tekst | Opsummeringskvalitet og indholdsdækning | Højere = bedre dækning af referenceindhold | Begrænset til referencebaseret evaluering |

| Nøjagtighed | Procentdel korrekte forudsigelser eller klassifikationer | Korrekthed af modeloutput | Højere = flere korrekte forudsigelser | Måler ikke tillid eller usikkerhed |

| BERTScore | Kontekstuel lighed vha. BERT-embeddings | Semantisk lighed mellem genereret og reference-tekst | Højere = mere semantisk lig | Beregningstung; kræver reference-tekst |

Perpleksitets-score fungerer ved at vurdere, hvor godt en sprogmodel forudsiger hvert token i en sekvens givet alle foregående tokens. Når en sprogmodel behandler tekst, genererer den en sandsynlighedsfordeling over hele sit ordforråd for hver position, idet den tildeler højere sandsynligheder til ord, den anser for mere sandsynlige, og lavere til mindre sandsynlige ord. Modellen beregner log-sandsynligheden for det faktiske næste ord, der optræder i testdataene, og gennemsnittet af disse log-sandsynligheder findes over alle tokens i sekvensen. Dette gennemsnit gøres positivt (ganges med -1) for at gøre det til en positiv værdi og eksponentialiseres derefter for at transformere det fra log-rum til sandsynlighedsrummet. Den resulterende perpleksitets-score viser, hvor “overrasket” eller “forvirret” modellen er over den faktiske tekst—en lav score indikerer, at modellen tildelte høje sandsynligheder til de ord, der faktisk optrådte, mens en høj score indikerer, at modellen tildelte lave sandsynligheder til disse ord. I praktisk implementering med moderne transformer-modeller som GPT-2, GPT-3 eller Claude involverer beregningen tokenisering af inputtekst, gennemgang af modellen for at få logits (rå forudsigelsesscorer), konvertering af logits til sandsynligheder via softmax samt beregning af gennemsnitlig negativ log-sandsynlighed på tværs af gyldige tokens, mens padding-tokens maskeres. Sliding-window-strategien bruges ofte til modeller med faste kontekstlængder, hvor kontekstvinduet flyttes gennem teksten for at give maksimal tilgængelig kontekst til hver forudsigelse, hvilket giver mere nøjagtige perpleksitetsestimater end ikke-overlappende chunk-tilgange.

I erhvervs- og forskningsmæssige sammenhænge fungerer perpleksitets-score som en central kvalitetskontrolmåling for implementering og overvågning af sprogmodeller. Organisationer bruger perpleksitets-score til at identificere, hvornår modeller kræver retræning, finjustering eller arkitektoniske forbedringer, da forringelse i perpleksitet ofte indikerer fald i ydeevne. For AI-overvågningsplatforme som AmICited leverer perpleksitets-score kvantitative beviser for, hvor sikkert AI-systemer genererer svar om overvågede brands, domæner og URL’er på platforme som ChatGPT, Perplexity AI, Claude og Google AI Overviews. En model med konsekvent lav perpleksitet på brand-relaterede forespørgsler tyder på stabile, sikre citationsmønstre, mens stigende perpleksitet kan indikere usikkerhed eller inkonsistens i, hvordan AI-systemet refererer til specifikke enheder. Forskning viser, at cirka 78 % af virksomheder nu inkluderer automatiserede evalueringsmålinger, inklusiv perpleksitet, i deres AI-governance-rammer og anerkender, at forståelse af modeltillid er afgørende for højrisiko-anvendelser som medicinsk rådgivning, juridisk dokumentation og finansiel analyse. I disse domæner udgør et overdrevent selvsikkert, men forkert svar større risiko end et usikkert svar, der udløser menneskelig kontrol. Perpleksitets-score muliggør også realtids-overvågning under modeltræning og finjustering, så data scientists kan opdage overfitting, underfitting eller konvergensproblemer på få minutter i stedet for at vente på downstream-task-målinger. Målingens beregningseffektivitet—kræver kun et enkelt fremad-pass gennem modellen—gør den praktisk til kontinuerlig overvågning i produktionsmiljøer, hvor beregningsressourcer er begrænsede.

Forskellige AI-platforme implementerer perpleksitets-score-evaluering med forskellige metoder og i forskellige sammenhænge. ChatGPT og andre OpenAI-modeller evalueres med proprietære datasæt og evalueringsrammer, der måler perpleksitet på tværs af mange domæner, selvom specifikke scorer ikke offentliggøres. Claude, udviklet af Anthropic, bruger ligeledes perpleksitet som en del af deres omfattende evalueringssuite, og forskning antyder stærk ydeevne ved forståelse af lange kontekster, selvom perpleksitet har kendte begrænsninger ved langtidsafhængigheder. Perplexity AI, den søgefokuserede AI-platform, lægger vægt på realtidsinformationssøgning og citationsnøjagtighed, hvor perpleksitets-score hjælper med at vurdere, hvor sikkert systemet genererer svar med kildehenvisning. Google AI Overviews (tidligere SGE) bruger perpleksitetsmålinger til at vurdere sammenhæng og konsistens i svar, når information fra flere kilder sammenfattes. For AmICiteds overvågningsformål er forståelse af disse platforms-specifikke implementeringer afgørende, fordi hvert system kan tokenisere tekst forskelligt, bruge forskelligt ordforråd og benytte forskellige kontekstvinduesstrategier—alt sammen med direkte indvirkning på rapporterede perpleksitetsscorer. Et svar om et brand kan opnå perpleksitet på 15 på én platform og 22 på en anden—ikke pga. kvalitetsforskel, men på grund af arkitektoniske og forbehandlingsmæssige variationer. Dette understreger, hvorfor AmICited ikke kun følger absolutte perpleksitetsværdier, men også tendenser, konsistens og komparative målinger på tværs af platforme for at give meningsfuld indsigt i, hvordan AI-systemer omtaler overvågede enheder.

Implementering af perpleksitets-score-evaluering kræver nøje opmærksomhed på flere tekniske og metodiske forhold. For det første er tokeniseringskonsistens altafgørende—brug af forskellige tokeniseringsmetoder (tegn-, ord- eller subordniveau) giver vidt forskellige perpleksitetsscorer, hvilket gør tværmodel-sammenligninger problematiske uden standardisering. For det andet påvirker kontekstvinduesstrategi resultaterne betydeligt; sliding-window-tilgangen med stride-størrelse svarende til halvdelen af maksimum kontekstlængde giver typisk mere præcise perpleksitetsestimater end ikke-overlappende chunk-tilgange, dog på bekostning af øget beregning. For det tredje er datasætvalg kritisk—perpleksitetsscorer er datasætspecifikke og kan ikke meningsfuldt sammenlignes på tværs af forskellige testdatasæt uden omhyggelig normalisering. Best practices omfatter: fastsættelse af baseline-perpleksitet på standardiserede datasæt som WikiText-2 eller Penn Treebank til benchmarking; brug af ensartede forbehandlings-pipelines på tværs af alle modelvurderinger; dokumentation af tokeniseringsmetoder og kontekstvinduesstrategier i alle rapporterede resultater; kombination af perpleksitet med supplerende målinger som BLEU, ROUGE, faktuel nøjagtighed og menneskelig vurdering for helhedsorienteret vurdering; samt overvågning af perpleksitetstendenser over tid frem for kun enkeltmålinger. For organisationer, der implementerer perpleksitets-score i produktionsovervågning, kan automatiske alarmer ved forværret perpleksitet udløse undersøgelser af datakvalitet, modeldrift eller infrastrukturproblemer, før de påvirker slutbrugerne.

På trods af sin brede udbredelse og teoretiske elegance har perpleksitets-score betydelige begrænsninger, der forhindrer den i at fungere som eneste evalueringsmål. Mest kritisk er, at perpleksitets-score ikke måler semantisk forståelse eller faktuel nøjagtighed—en model kan opnå lav perpleksitet ved sikkert at forudsige almindelige ord og fraser, mens den genererer fuldstændig meningsløst eller faktuelt forkert indhold. Forskning fra 2024 viser, at perpleksitet ikke korrelerer godt med langsigtet forståelse, sandsynligvis fordi den kun vurderer næste-token-forudsigelse uden at opfange sammenhæng eller logisk konsistens på tværs af sekvenser. Tokeniseringsfølsomhed skaber endnu en udfordring; tegnbaserede modeller kan opnå lavere perpleksitet end ordmodeller, selvom tekstkvaliteten er dårligere, og forskellige subword-tokeniseringssystemer (BPE, WordPiece, SentencePiece) giver ikke-sammenlignelige scorer. Perpleksitet kan kunstigt sænkes ved at tildele høje sandsynligheder til almindelige ord, tegnsætning og gentagne tekststykker, hvilket ikke nødvendigvis forbedrer tekstkvalitet eller anvendelighed. Målingen er også meget følsom overfor datasætskarakteristika—perpleksitetsscorer på forskellige testdatasæt kan ikke sammenlignes direkte, og domænespecifik tekst giver ofte højere perpleksitet end generel tekst uanset modelkvalitet. Derudover betyder kontekstvinduesbegrænsninger i modeller med fast længde, at perpleksitetsberegninger måske ikke afspejler ægte autoregressiv dekomponering, især for længere sekvenser, hvor modellen mangler fuld kontekst til forudsigelser.

Fremtiden for perpleksitets-score i AI-evaluering udvikler sig mod integration med supplerende målinger fremfor udskiftning eller forældelse. I takt med at sprogmodeller vokser og bliver mere kompetente, erkender forskere i stigende grad, at perpleksitets-score skal kombineres med semantiske forståelsesmålinger, faktuelle nøjagtighedsmål og menneskelig vurdering for at give meningsfuld vurdering. Fremvoksende forskning udforsker kontekstafhængige perpleksitets-varianter, der bedre opfanger langtidssammenhænge og kohærens og derved adresserer en af målingens grundlæggende begrænsninger. Fremkomsten af multimodale AI-systemer, der behandler tekst, billeder, lyd og video samtidigt, driver udviklingen af generaliserede perpleksitetsrammer til brug ud over ren sprogmodellering. AmICited og lignende AI-overvågningsplatforme inkorporerer perpleksitet sammen med andre målinger for at følge ikke kun hvad AI-systemer siger om brands og domæner, men også hvor sikkert de siger det, så man kan opdage inkonsistens, hallucination og citation drift. Industriens brug af perpleksitetsbaseret overvågning accelererer, idet store AI-laboratorier og virksomheder implementerer løbende perpleksitetssporing som en del af deres model-governance-rammer. Fremtidige udviklinger vil sandsynligvis omfatte realtids-perpleksitets-dashboard, der advarer organisationer om modelnedbrud, tværplatforms-perpleksitets-normalisering, der gør det muligt at sammenligne på tværs af AI-systemer, og fortolkende perpleksitetsanalyse, der identificerer, hvilke tokens eller kontekster der driver høj usikkerhed. Efterhånden som AI-systemer bliver integreret i kritiske forretningsmæssige og samfundsmæssige funktioner, vil forståelse og overvågning af perpleksitets-score sammen med andre målinger forblive afgørende for at sikre pålidelig og troværdig AI-implementering.

Perpleksitets-score beregnes som PPL(X) = exp{-1/t ∑ log p_θ(x_i|x_

Perpleksitets-score måler modellens tillid og usikkerhed i forudsigelser, ikke korrekthed. En model kan have lav perpleksitet, men tage fejl, eller høj perpleksitet, men være korrekt. Nøjagtighedsmålinger vurderer, om forudsigelser er rigtige eller forkerte, mens perpleksitet kvantificerer, hvor sikker modellen er på sine forudsigelser, hvilket gør dem til komplementære evalueringsmetoder for omfattende modelvurdering.

Perpleksitets-score hjælper AI-overvågningsplatforme med at følge, hvor sikkert sprogmodeller som ChatGPT, Claude og Perplexity genererer svar om specifikke brands eller domæner. Ved at måle tekstforudsigelighed kan AmICited vurdere, om AI-systemer genererer konsistente, sikre citater eller usikre, variable omtaler af overvågede enheder, hvilket muliggør en bedre forståelse af AI-svarenes pålidelighed.

Perpleksitets-score måler ikke semantisk forståelse, faktuel nøjagtighed eller langsigtet sammenhæng. Den kan skævvrides af tegnsætning og gentagne tekststykker og er følsom overfor tokeniseringsmetoder og ordforrådsstørrelse. Forskning viser, at perpleksitet ikke korrelerer godt med langsigtet forståelse, hvilket gør den utilstrækkelig som eneste evalueringsmål uden supplerende målinger som BLEU, ROUGE eller menneskelig vurdering.

Forskellige sprogmodeller opnår varierende perpleksitetsscorer afhængigt af deres arkitektur, træningsdata og tokeniseringsmetoder. GPT-2 opnår cirka 19,44 i perpleksitet på WikiText-2 med ikke-overlappende kontekst, mens større modeller som GPT-3 og Claude typisk opnår lavere scorer. Perpleksitetsscorer kan ikke sammenlignes direkte på tværs af modeller pga. forskelle i ordforrådsstørrelse, kontekstlængde og forbehandling, hvilket kræver standardiserede evalueringsdatasæt for retfærdig sammenligning.

Perpleksitets-score er matematisk afledt af entropi- og kryds-entropibegreber fra informationsteorien. Mens entropi måler usikkerheden i en enkelt sandsynlighedsfordeling, måler kryds-entropi forskellen mellem den sande og den forudsagte fordeling. Perpleksitet anvender eksponentialfunktionen på kryds-entropi og konverterer den fra log-rum tilbage til sandsynlighedsrummet, så det bliver mere fortolkeligt som det effektive antal ordvalg, modellen overvejer.

Perpleksitets-score forbedres gennem større træningsdatasæt, længere kontekstvinduer, bedre tokeniseringsstrategier og mere sofistikerede modelarkitekturer. Finjustering på domænespecifikke data, øgede modelparametre og brug af sliding-window-evalueringsstrategier under vurdering kan sænke perpleksiteten. Forbedringer skal dog balanceres med andre målinger for at sikre, at modeller ikke kun genererer sikre, men også nøjagtige, sammenhængende og kontekstuelt passende tekster.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær hvad perpleksitet score betyder i indhold og sprogmodeller. Forstå hvordan det måler modellens usikkerhed, prædiktionsnøjagtighed og vurdering af tekstkvali...

Fællesskabsdiskussion om perplexity score i indhold og sprogmodeller. Forfattere og AI-eksperter diskuterer, om det har betydning for indholdsskabelse og optime...

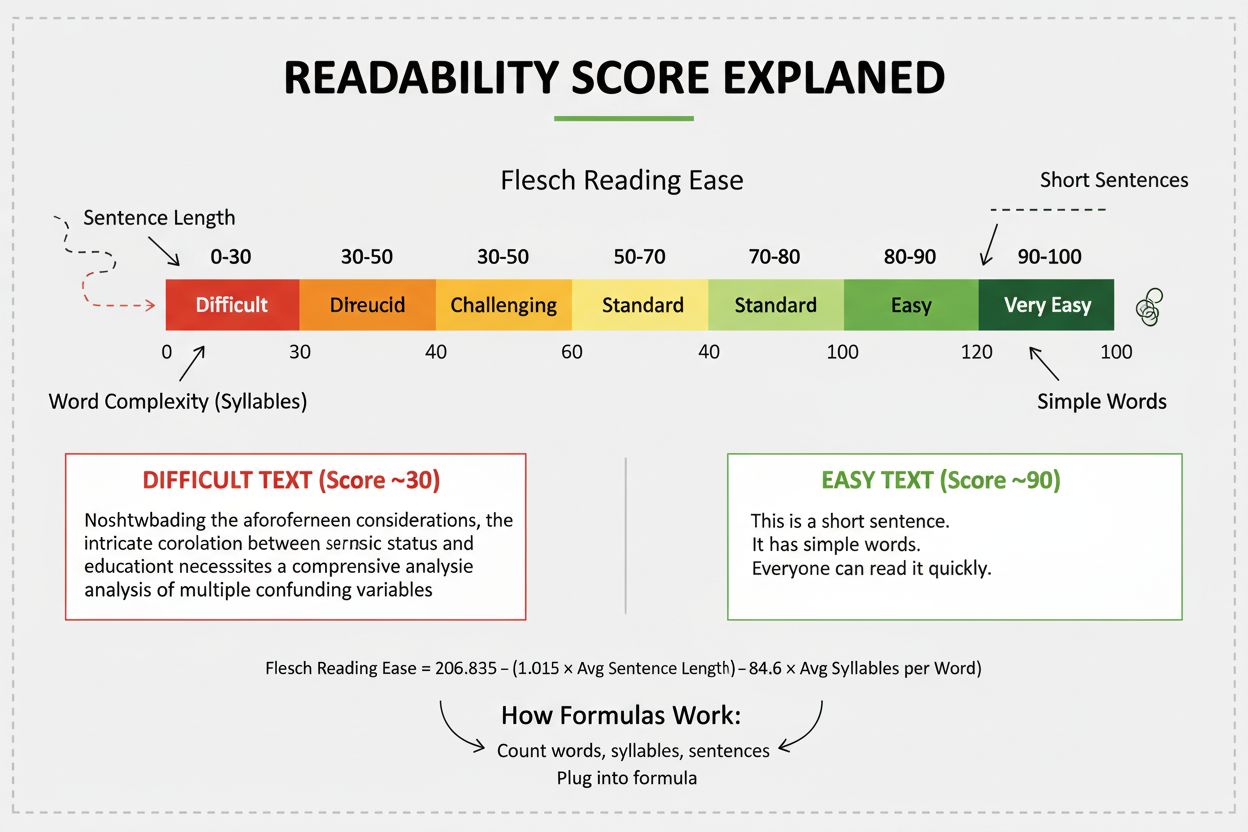

Læselighedsscore måler hvor svært indhold er at forstå baseret på sproglig analyse. Lær hvordan Flesch, Gunning Fog og andre formler påvirker SEO, brugerengagem...