Hvad er vektorsøgning, og hvordan fungerer det?

Lær, hvordan vektorsøgning bruger maskinlærings-embeddings til at finde lignende elementer baseret på betydning fremfor eksakte nøgleord. Forstå vektordatabaser...

Vektorsøgning er en metode til at finde lignende elementer i et datasæt ved at repræsentere data som matematiske vektorer og sammenligne dem med afstandsmål som cosinuslignendehed eller euklidisk afstand. Denne tilgang muliggør semantisk forståelse ud over nøgleords-matchning, så systemer kan opdage relationer og ligheder baseret på betydning frem for præcis tekstlig overensstemmelse.

Vektorsøgning er en metode til at finde lignende elementer i et datasæt ved at repræsentere data som matematiske vektorer og sammenligne dem med afstandsmål som cosinuslignendehed eller euklidisk afstand. Denne tilgang muliggør semantisk forståelse ud over nøgleords-matchning, så systemer kan opdage relationer og ligheder baseret på betydning frem for præcis tekstlig overensstemmelse.

Vektorsøgning er en metode til at finde lignende elementer i et datasæt ved at repræsentere data som matematiske vektorer og sammenligne dem ved hjælp af afstandsmål for at måle semantisk lighed. I modsætning til traditionel nøgleordsbaseret søgning, der afhænger af præcise tekstmatches, forstår vektorsøgning betydningen og konteksten bag data ved at omdanne det til højdimensionelle numeriske repræsentationer kaldet vektor-embeddings. Denne tilgang gør det muligt for systemer at opdage relationer og ligheder baseret på semantisk indhold snarere end overfladiske træk, hvilket gør det særligt effektivt til applikationer, der kræver kontekstuel forståelse. Vektorsøgning er blevet grundlaget for moderne AI-systemer og muliggør semantisk søgning, anbefalingsmotorer, anomali-detektion og retrieval-augmented generation (RAG) på tværs af platforme som ChatGPT, Perplexity, Google AI Overviews og Claude.

I sin kerne omdanner vektorsøgning data til numeriske repræsentationer, hvor nærhed i rummet angiver semantisk lighed. Hvert datapunkt – uanset om det er tekst, billede eller lyd – omdannes til en vektor, som i bund og grund er en talrække, der repræsenterer egenskaber eller betydning. For eksempel kan ordet “restaurant” repræsenteres som [0.2, -0.5, 0.8, 0.1], hvor hvert tal fanger forskellige aspekter af ordets semantiske betydning. Det grundlæggende princip er, at semantisk lignende elementer vil have vektorer placeret tæt på hinanden i dette højdimensionelle rum, mens forskellige elementer vil være langt fra hinanden. Denne matematiske struktur gør det muligt for computere at sammenligne begreber ud fra betydning frem for nøjagtige nøgleord, hvilket muliggør, at en søgning efter “bedste spisesteder” kan returnere resultater for “topvurderede restauranter”, selv uden præcist ordsammenfald.

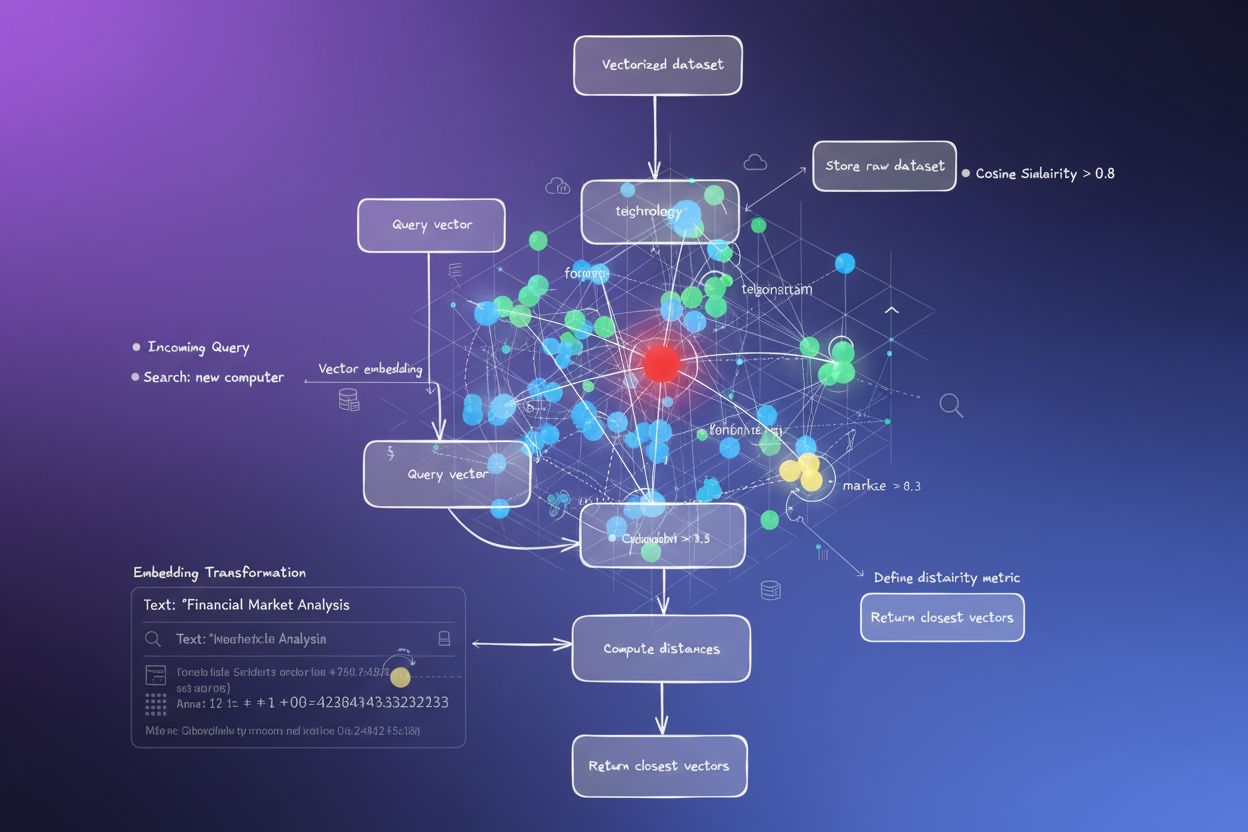

Processen med at omdanne data til vektorer kaldes embedding og udføres af maskinlæringsmodeller trænet på store datasæt. Disse modeller lærer at kortlægge lignende begreber til nærliggende placeringer i vektorrummet gennem eksponering for milliarder af eksempler. Almindelige embedding-modeller inkluderer Word2Vec, der lærer ordrelationer ud fra kontekst; BERT (Bidirectional Encoder Representations from Transformers), som fanger kontekstuel betydning; og CLIP (Contrastive Language-Image Pre-training), der håndterer multimodale data. De resulterende embeddings spænder typisk fra 100 til over 1.000 dimensioner og skaber en rig matematisk repræsentation af semantiske relationer. Når en bruger foretager en søgning, omdannes deres forespørgsel til en vektor med samme embedding-model, og systemet beregner dernæst afstande mellem forespørgselsvektoren og alle lagrede vektorer for at identificere de mest lignende elementer.

Vektorsøgning er afhængig af afstandsmål for at kvantificere, hvor ens to vektorer er. De tre primære mål er cosinuslignendehed, euklidisk afstand og prikprodukt-lignendehed, hver med deres egne matematiske egenskaber og anvendelsesområder. Cosinuslignendehed måler vinklen mellem to vektorer og spænder fra -1 til 1, hvor 1 angiver identisk retning (maksimal lighed) og 0 angiver ortogonale vektorer (ingen relation). Dette mål er særligt værdifuldt for NLP-applikationer, fordi det fokuserer på semantisk retning uafhængigt af vektorens størrelse, hvilket gør det ideelt til sammenligning af dokumenter i forskellige længder. Euklidisk afstand beregner den lige linje afstand mellem vektorer i et multidimensionelt rum og tager både størrelse og retning i betragtning. Dette mål er følsomt over for skala, hvilket gør det nyttigt, når vektorens størrelse indeholder meningsfuld information, som i anbefalingssystemer, hvor købsfrekvens har betydning.

Prikprodukt-lignendehed kombinerer aspekter fra begge mål, idet det tager højde for både størrelse og retning og samtidig tilbyder beregningsmæssig effektivitet. Mange store sprogmodeller bruger prikprodukt til træning, hvilket gør det til det passende valg for disse applikationer. Valget af det rigtige afstandsmål er kritisk – forskning viser, at brug af det samme mål, som blev brugt til at træne din embedding-model, giver de bedste resultater. For eksempel blev all-MiniLM-L6-v2-modellen trænet med cosinuslignendehed, så brug af cosinuslignendehed i dit indeks vil give de mest nøjagtige resultater. Organisationer, der implementerer vektorsøgning, skal nøje matche deres valgte afstandsmål med embedding-modellen og brugsscenariet for at sikre både nøjagtighed og ydeevne.

| Aspekt | Vektorsøgning | Nøgleordssøgning | Hybrid søgning |

|---|---|---|---|

| Matchningsmetode | Semantisk lighed baseret på betydning | Præcis ord- eller sætningsmatchning | Kombinerer både semantisk og nøgleords-matchning |

| Forespørgselsforståelse | Forstår hensigt og kontekst | Kræver at præcise nøgleord er til stede | Udnytter begge tilgange for omfattende resultater |

| Synonymhåndtering | Finder automatisk synonymer og relaterede udtryk | Overser synonymer medmindre eksplicit indekseret | Opfanger synonymer via begge metoder |

| Ydeevne ved vage forespørgsler | Fremragende – forstår hensigt | Dårlig – kræver præcise nøgleord | Meget god – dækker begge fortolkninger |

| Beregningomkostninger | Højere – kræver embedding og lignendehedsberegning | Lavere – simpel strengmatchning | Moderat – kører begge søgninger parallelt |

| Skalerbarhed | Kræver specialiserede vektordatabaser | Fungerer med traditionelle databaser | Kræver hybrid-kompatible systemer |

| Anvendelsesområder | Semantisk søgning, anbefalinger, RAG, anomali-detektion | Præcis frase-søgning, strukturerede data | Enterprise-søgning, AI-overvågning, brand-tracking |

| Eksempel | Søgning efter “sunde aftensmadsidéer” finder “nærende måltidsforberedelse” | Finder kun resultater med de præcise ord “sund” og “aftensmad” | Finder både præcise matches og semantisk relateret indhold |

Implementering af vektorsøgning involverer flere sammenhængende trin, der omdanner rå data til søgbare, semantiske repræsentationer. Første trin er dataindsamling og forbehandling, hvor rå dokumenter, billeder eller andre data renses og normaliseres. Dernæst kommer vektor-transformation, hvor en embedding-model omdanner hvert dataelement til en numerisk vektor, typisk på 100 til over 1.000 dimensioner. Disse vektorer lagres derefter i en vektordatabase eller indeksstruktur optimeret til højdimensionelle data. Når en søgeforespørgsel modtages, gennemgår den samme embedding-proces for at oprette en forespørgselsvektor. Systemet bruger dernæst afstandsmål til at beregne lighedsscorer mellem forespørgselsvektoren og alle gemte vektorer og rangerer resultater efter deres nærhed til forespørgslen.

For at gøre denne proces effektiv i stor skala anvender systemer Approximate Nearest Neighbor (ANN)-algoritmer som HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) eller ScaNN (Scalable Nearest Neighbors). Disse algoritmer bytter perfekt nøjagtighed for hastighed, hvilket muliggør søgninger på tværs af millioner eller milliarder af vektorer på millisekunder frem for sekunder. HNSW organiserer f.eks. vektorer i en flerlags-grafstruktur, hvor højere lag indeholder langtrækkende forbindelser for hurtig gennemgang, mens lavere lag indeholder korttrækkende forbindelser for præcision. Denne hierarkiske tilgang reducerer søgekompleksiteten fra lineær O(n) til logaritmisk O(log n), hvilket gør vektorsøgning i stor skala praktisk. Valget af algoritme afhænger af faktorer som datasæt-størrelse, forespørgselsvolumen, latenstidskrav og tilgængelige beregningsressourcer.

Vektorsøgning er blevet afgørende for AI-overvågningsplatforme som AmICited, der sporer brandomtaler på tværs af AI-systemer. Traditionel nøgleordsbaseret overvågning vil overse omformulerede omtaler, kontekstuelle referencer og semantiske variationer af brandnavne eller domæne-URL’er. Vektorsøgning gør det muligt for disse platforme at opdage, når dit brand nævnes i AI-genererede svar, selv når den præcise ordlyd er anderledes. Hvis dit domæne f.eks. er “amicited.com”, kan vektorsøgning identificere omtaler som “AI prompt overvågningsplatform” eller “brand synlighed i generativ AI” som kontekstuelt relateret til din virksomhed, selv uden eksplicitte URL-omtaler. Denne semantiske forståelse er afgørende for omfattende AI-citations-tracking på tværs af ChatGPT, Perplexity, Google AI Overviews og Claude.

Markedet for vektorsøgnings-teknologi oplever eksplosiv vækst, hvilket afspejler virksomhedernes anerkendelse af dens værdi. Ifølge markedsundersøgelser blev markedet for vektordatabaser vurderet til $1,97 milliarder i 2024 og forventes at nå $10,60 milliarder i 2032 med en årlig vækstrate (CAGR) på 23,38%. Derudover rapporterede Databricks en vækst på 186% i vektordatabaser-adoption bare det første år efter deres vektorsøgnings-public preview i december 2023. Denne hurtige adoption viser, at virksomheder i stigende grad anser vektorsøgning som kritisk infrastruktur for AI-applikationer. For organisationer, der overvåger deres tilstedeværelse i AI-systemer, giver vektorsøgning den semantiske forståelse, der er nødvendig for at fange alle meningsfulde omtaler – ikke kun præcise nøgleord.

Vektorsøgnings-ydeevne i stor skala afhænger i høj grad af sofistikerede indekseringsteknikker, der balancerer hastighed, nøjagtighed og hukommelsesforbrug. HNSW (Hierarchical Navigable Small World) er blevet en af de mest populære tilgange og organiserer vektorer i en flerlags-graf, hvor hvert lag indeholder gradvist kortere forbindelser. Algoritmen starter søgninger i det øverste lag med langtrækkende forbindelser for hurtig gennemgang og bevæger sig derefter ned gennem lag med stadig mere præcise forbindelser. Forskning viser, at HNSW opnår state-of-the-art ydeevne med recall på over 99%, mens den opretholder sub-millisekund forespørgsels-latenstid. Dog kræver HNSW betydelig hukommelse – benchmarks viser, at indeksering af 1 million vektorer med HNSW kan kræve 0,5 GB til 5 GB afhængigt af parametre, hvilket gør hukommelsesoptimering vigtig i store installationer.

IVF (Inverted File Index) tilbyder en alternativ tilgang ved at klynge vektorer og indeksere dem efter klyngecentroider. Denne teknik reducerer søgeområdet ved at fokusere på relevante klynger frem for at søge i alle vektorer. ScaNN (Scalable Nearest Neighbors), udviklet af Google Research, er optimeret specifikt til indre produkt-søgning og leverer fremragende ydeevne til anbefalingssystemer. Product Quantization (PQ) komprimerer vektorer ved at opdele dem i subvektorer og kvantisere hver for sig, hvilket reducerer hukommelsesforbrug med 10-100x på bekostning af en smule nøjagtighed. Organisationer, der implementerer vektorsøgning, skal nøje vælge indekseringsteknikker ud fra deres specifikke behov – om de prioriterer recall-nøjagtighed, søgehastighed, hukommelseseffektivitet eller en kombination. Feltet udvikler sig hurtigt med nye algoritmer og optimeringsteknikker, der løbende adresserer de beregningsmæssige udfordringer ved højdimensionale vektoroperationer.

Definitionen og anvendelsen af vektorsøgning udvikler sig kontinuerligt, efterhånden som AI-systemer bliver mere sofistikerede og virksomheder tager teknologien til sig. Fremtiden peger på hybrid-søgesystemer, der kombinerer vektorsøgning med traditionel nøgleordssøgning og avancerede filtreringsmuligheder. Disse hybridtilgange udnytter vektorsøgningens semantiske forståelse og bevarer samtidig præcisionen og genkendeligheden ved nøgleordsmatchning, hvilket giver overlegne resultater ved komplekse forespørgsler. Derudover er multimodal vektorsøgning på vej frem som en kritisk evne, der gør det muligt for systemer at søge på tværs af tekst, billeder, lyd og video samtidig ved hjælp af fælles embedding-rum. Denne udvikling vil muliggøre mere intuitive og omfattende søgeoplevelser på tværs af forskellige datatyper.

For organisationer, der overvåger deres tilstedeværelse i AI-systemer, har udviklingen inden for vektorsøgning store implikationer. Efterhånden som AI-platforme som ChatGPT, Perplexity, Google AI Overviews og Claude i stigende grad benytter vektorsøgning til indhentning og rangering af indhold, bliver det lige så vigtigt at forstå, hvordan dit brand optræder semantisk, som traditionel nøgleordssynlighed. Skiftet mod semantisk forståelse betyder, at brand-monitorering og AI-citations-tracking skal udvikle sig ud over simpel nøgleords-detektion og fange kontekstuelle omtaler og semantiske relationer. Organisationer, der investerer i forståelsen af vektorsøgning og dens applikationer, vil være bedre rustet til at optimere deres synlighed i generative AI-systemer. Sammenfaldet mellem vektorsøgningsteknologi og AI-overvågningsplatforme repræsenterer et grundlæggende skift i, hvordan brands forstår og håndterer deres tilstedeværelse i det AI-drevne informationslandskab.

Traditionel nøgleordssøgning leder efter præcise ordmatches i dokumenter, mens vektorsøgning forstår semantisk betydning og kontekst. Vektorsøgning omdanner tekst til numeriske repræsentationer kaldet embeddings, hvilket gør det muligt at finde relevante resultater, selv når de præcise nøgleord ikke matcher. For eksempel vil en søgning efter 'trådløse hovedtelefoner' med vektorsøgning også returnere resultater for 'Bluetooth ørepropper', fordi de deler lignende semantisk betydning, hvor nøgleordssøgning ville overse denne forbindelse.

Vektor-embeddings er numeriske repræsentationer af data (tekst, billeder, lyd), som omdannes til talrækker, der fanger semantisk betydning. De skabes med maskinlæringsmodeller som Word2Vec, BERT eller transformerbaserede modeller, der lærer at placere lignende begreber tæt på hinanden i et højdimensionelt rum. For eksempel vil ordene 'konge' og 'dronning' have embeddings placeret tæt, fordi de deler semantiske relationer, mens 'konge' og 'banan' vil være langt fra hinanden.

De tre primære afstandsmål er cosinuslignendehed (måler vinklen mellem vektorer), euklidisk afstand (måler den lige linje afstand), og prikprodukt-lignendehed (tager både størrelse og retning i betragtning). Cosinuslignendehed er mest almindelig til NLP-applikationer, fordi den fokuserer på semantisk retning uafhængigt af vektorens størrelse. Valget af mål bør matche det, der blev brugt til at træne dit embedding-model for optimal nøjagtighed.

Vektorsøgning gør det muligt for AI-overvågningsplatforme som AmICited at spore brandomtaler på tværs af AI-systemer (ChatGPT, Perplexity, Google AI Overviews, Claude) ved at forstå semantisk kontekst frem for præcise nøgleord. Det gør det muligt at opdage omformulerede omtaler, relaterede begreber og kontekstuelle referencer til dit brand, hvilket giver fuldt overblik over, hvordan dit domæne fremgår i AI-genererede svar på tværs af flere platforme.

ANN-algoritmer som HNSW (Hierarchical Navigable Small World) muliggør hurtige lighedssøgninger på tværs af millioner af vektorer ved at finde omtrentlige frem for præcise nærmeste naboer. Disse algoritmer bruger hierarkiske grafstrukturer til at reducere søgekompleksitet fra lineær til logaritmisk, hvilket gør vektorsøgning praktisk til store applikationer. HNSW organiserer vektorer i flerlags-grafer, hvor langtrækkende forbindelser findes på højere lag for hurtigere gennemgang.

Virksomheder genererer enorme mængder ustruktureret data (e-mails, dokumenter, supporthenvendelser), som traditionel nøgleordssøgning har svært ved at organisere effektivt. Vektorsøgning muliggør semantisk forståelse af disse data og driver applikationer som intelligent søgning, anbefalingssystemer, anomali-detektion og retrieval-augmented generation (RAG). Ifølge markedsundersøgelser forventes markedet for vektordatabaser at vokse fra $2,65 milliarder i 2025 til $8,95 milliarder i 2030, hvilket afspejler udbredelsen i virksomheder.

Vektordatabaser er specialiserede systemer optimeret til lagring, indeksering og forespørgsler på højdimensionelle vektordata. De implementerer effektive indekseringsteknikker som HNSW, IVF (Inverted File Index) og ScaNN for at muliggøre hurtige lighedssøgninger i stor skala. Eksempler inkluderer Milvus, Pinecone, Weaviate og Zilliz Cloud. Disse databaser håndterer den beregningsmæssige kompleksitet ved vektoroperationer, så organisationer kan bygge produktionsklare semantiske søge- og AI-applikationer uden at håndtere infrastrukturens kompleksitet.

Begynd at spore, hvordan AI-chatbots nævner dit brand på tværs af ChatGPT, Perplexity og andre platforme. Få handlingsrettede indsigter til at forbedre din AI-tilstedeværelse.

Lær, hvordan vektorsøgning bruger maskinlærings-embeddings til at finde lignende elementer baseret på betydning fremfor eksakte nøgleord. Forstå vektordatabaser...

Lær hvordan vektorembeddinger gør det muligt for AI-systemer at forstå semantisk betydning og matche indhold med forespørgsler. Udforsk teknologien bag semantis...

Semantisk søgning fortolker forespørgsels betydning og kontekst ved hjælp af NLP og maskinlæring. Lær hvordan det adskiller sig fra nøgleordssøgning, driver AI-...