KI-Crawler erklärt: GPTBot, ClaudeBot und mehr

Verstehen Sie, wie KI-Crawler wie GPTBot und ClaudeBot funktionieren, wo sie sich von traditionellen Such-Crawlern unterscheiden und wie Sie Ihre Website für Si...

Erfahren Sie, wie Sie strategische Entscheidungen zum Blockieren von KI-Crawlern treffen. Bewerten Sie Inhaltstyp, Traffic-Quellen, Geschäftsmodelle und Wettbewerbsposition mit unserem umfassenden Entscheidungsrahmen.

KI-Crawler sind zu einer bedeutenden Kraft im digitalen Ökosystem geworden und verändern grundlegend, wie Inhalte im Internet entdeckt, indexiert und genutzt werden. Diese automatisierten Systeme sind darauf ausgelegt, systematisch Websites zu durchsuchen, Daten zu extrahieren und sie in Machine-Learning-Modelle einzuspeisen, die von Suchmaschinen bis hin zu generativen KI-Anwendungen alles antreiben. Die Landschaft umfasst drei verschiedene Crawler-Typen: Data Scraper, die gezielt Informationen für kommerzielle Zwecke extrahieren, Suchmaschinen-Crawler wie Googlebot, die Inhalte für Suchergebnisse indexieren, und KI-Assistenten-Crawler, die Trainingsdaten für große Sprachmodelle sammeln. Beispiele sind OpenAI’s GPTBot, Anthropics Claude-Web und Googles AI Overviews Crawler – jeder mit unterschiedlichen Zwecken und Auswirkungen. Laut aktuellen Analysen haben bereits etwa 21 % der Top-1000-Websites irgendeine Form von KI-Crawler-Blockierung implementiert, was ein wachsendes Bewusstsein für die Notwendigkeit des Managements dieser automatisierten Besucher zeigt. Zu verstehen, welche Crawler auf Ihre Seite zugreifen und aus welchem Grund, ist der erste entscheidende Schritt, um fundiert zu entscheiden, ob Sie sie blockieren oder zulassen sollten. Der Einsatz ist hoch, denn diese Entscheidung beeinflusst direkt die Sichtbarkeit Ihrer Inhalte, Ihre Traffic-Muster und letztlich Ihr Geschäftsmodell.

Anstatt pauschal alle KI-Crawler zu blockieren oder zuzulassen, empfiehlt sich ein differenzierter Ansatz durch das BEDC-Framework – das steht für Geschäftsmodell (Business Model), Expositionsrisiko (Exposure Risk), Abhängigkeit von organischer Suche (Dependency on Organic Search) und Wettbewerbsposition (Competitive Position). Jeder dieser vier Faktoren hat je nach Website unterschiedliche Gewichtung und ergibt gemeinsam eine umfassende Entscheidungsmatrix, die der Komplexität moderner digitaler Publikation gerecht wird. Das Framework erkennt an, dass es keine Universallösung gibt – was für eine Nachrichtenredaktion funktioniert, kann für ein SaaS-Unternehmen völlig falsch sein, und was einer etablierten Marke nutzt, kann einem neuen Wettbewerber schaden. Durch die systematische Bewertung jedes Faktors verlassen Sie die emotionale Ebene und treffen stattdessen datenbasierte Entscheidungen im Einklang mit Ihren Unternehmenszielen.

| Faktor | Empfehlung | Zentrale Überlegung |

|---|---|---|

| Geschäftsmodell | Werbefinanzierte Seiten sollten vorsichtiger sein; Abomodelle können permissiver agieren | Umsatzabhängigkeit von direkter Nutzerbindung vs. Lizenzierung |

| Expositionsrisiko | Originäre Forschung und proprietäre Inhalte sollten blockiert werden; Masseninhalte können offener sein | Wettbewerbsvorteil durch einzigartige Erkenntnisse oder Daten |

| Abhängigkeit von organischer Suche | Hohe Abhängigkeit (>40% Traffic) spricht für Zulassen von Google-Crawlern, aber Blockieren von KI-Assistenten | Balance zwischen Sichtbarkeit in der Suche und Schutz vor KI-Training |

| Wettbewerbsposition | Marktführer können blockieren; neue Player profitieren von KI-Sichtbarkeit | First-Mover-Vorteil bei KI-Partnerschaften vs. Inhaltschutz |

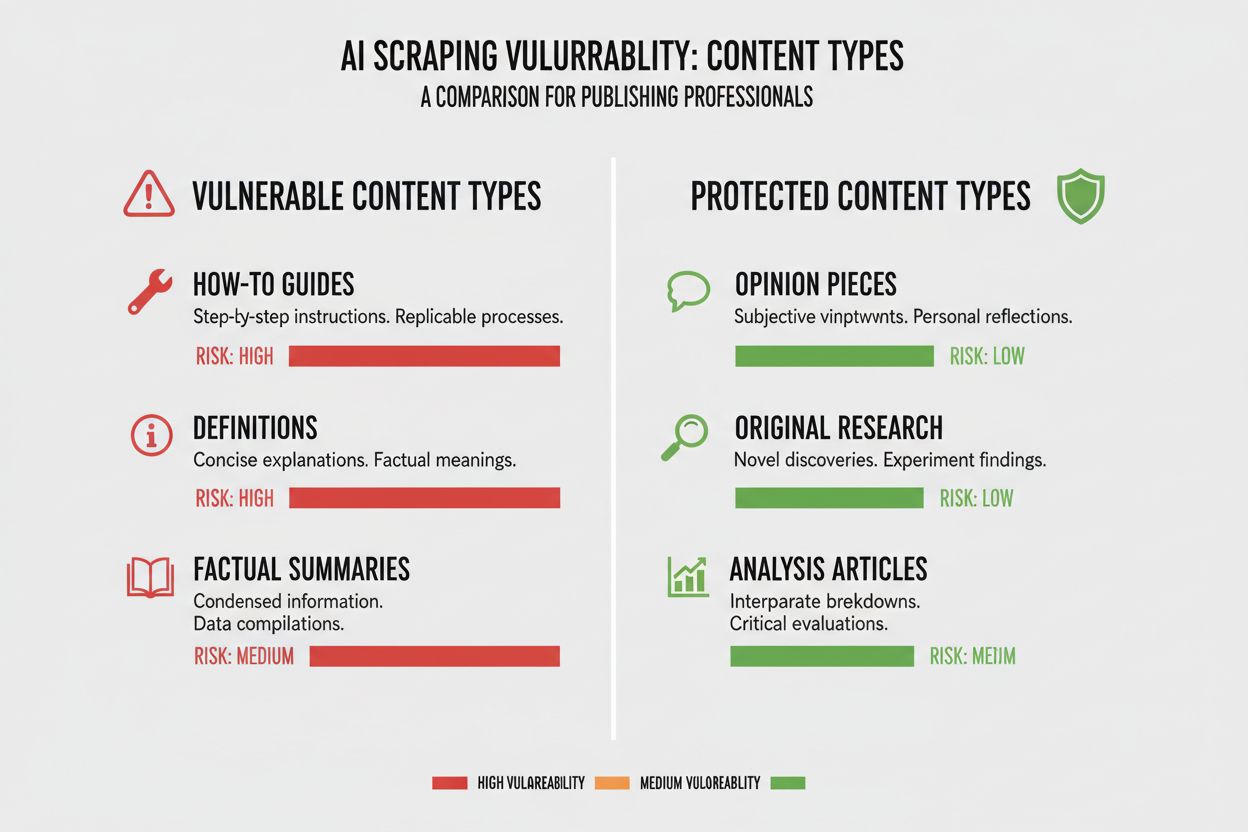

Verschiedene Inhaltstypen haben sehr unterschiedliche Verwundbarkeiten gegenüber KI-Crawling, und die Position Ihrer Inhalte in diesem Spektrum zu kennen, ist entscheidend für die richtige Entscheidung. Originäre Forschung und proprietäre Daten stellen Ihre wertvollsten Assets dar und verdienen stärksten Schutz, da KI-Modelle, die auf diesen Inhalten trainiert werden, direkt mit Ihrer Monetarisierungsstrategie konkurrieren können. Nachrichten und aktuelle Informationen nehmen eine Mittelstellung ein – ihr zeitkritischer Wert sinkt schnell, aber die Indexierung durch Suchmaschinen bleibt für Traffic wichtig, was einen Zielkonflikt zwischen Sichtbarkeit und Schutz vor KI-Training erzeugt. Masseninhalte wie Anleitungen, Tutorials und allgemeines Nachschlagewerk sind deutlich weniger verwundbar, da sie ohnehin überall verfügbar sind und selten Ihre Haupteinnahmequelle darstellen. Sprach- und multimediale Inhalte genießen einen natürlichen Schutz, weil aktuelle KI-Crawler aus Audio und Video wenig Wert extrahieren können – diese Formate sind somit von Natur aus sicherer vor KI-Training. Zeitlose Bildungsinhalte und Meinungsbeiträge liegen irgendwo dazwischen, sind für Suchtraffic wertvoll, aber weniger direkt von KI-Konkurrenz bedroht. Die zentrale Erkenntnis: Ihre Blockierstrategie sollte proportional zum Wettbewerbsvorteil Ihrer Inhalte sein – schützen Sie Ihre Kronjuwelen, bleiben Sie für Masseninhalte offen.

Ihre Abhängigkeit vom organischen Suchtraffic ist vermutlich der greifbarste Faktor in der KI-Crawler-Entscheidung, da sie das Verhältnis von Sichtbarkeit zu Schutz direkt quantifiziert. Websites, die mehr als 40 % ihres Traffics aus organischer Suche beziehen, stehen vor einer kritischen Einschränkung: Das Blockieren von KI-Crawlern bedeutet oft auch das Blockieren oder Einschränken von Google-Crawlern – mit verheerenden Auswirkungen auf Sichtbarkeit und Traffic. Der Unterschied zwischen Google-Extended (crawlt für KI-Training) und Googlebot (crawlt für Suchindexierung) ist hierbei entscheidend; theoretisch kann man einen zulassen und den anderen blockieren – was allerdings technisch komplex ist. Eine eindrucksvolle Fallstudie der New York Times zeigt die Dimension: Die Publikation erhielt rund 240.600 Besuche von KI-Crawlern in einem bestimmten Zeitraum – ein Hinweis auf die Bedeutung von KI-getriebenem Traffic für große Publisher. Die unbequeme Realität, sichtbar in Akamai-Daten: Das Blockieren von Crawlern führt zu 96 % weniger Referral-Traffic aus diesen Quellen – der Beitrag von KI-Crawlern zum Gesamttraffic ist also minimal verglichen mit klassischer Suche. Das Crawl-to-Referral-Verhältnis liegt bei den meisten KI-Crawlern extrem niedrig – oft generieren weniger als 0,15 % der gecrawlten Inhalte tatsächlich Rückbesuche –, sodass das Blockieren dieser Crawler kaum Einfluss auf Ihren Nutzertraffic hat. Für Websites mit hoher Suchabhängigkeit muss das Blockieren von KI-Crawlern gegen das Risiko abgewogen werden, versehentlich Suchmaschinen-Crawler zu blockieren – was weit gravierendere Folgen hätte.

Ihr Geschäftsmodell bestimmt maßgeblich den Umgang mit KI-Crawlern, denn verschiedene Monetarisierungsstrategien erzeugen verschiedene Anreize für Inhaltsverbreitung und -schutz. Werbefinanzierte Websites stehen im stärksten Spannungsfeld mit KI-Crawlern, da ihr Umsatz davon abhängt, dass Nutzer die Seite besuchen, um Werbung zu sehen – KI-Modelle, die Inhalte zusammenfassen, reduzieren den Anreiz zum Klick. Abomodell-Seiten können mit KI-Crawlern großzügiger sein, da ihre Einnahmen aus direkten Abos und nicht aus Anzeigen stammen – und etwas KI-Sichtbarkeit sogar neue Abonnenten bringen kann. Hybride Modelle, die Werbung, Abos und Affiliate-Einnahmen kombinieren, benötigen differenzierte Strategien – Crawler-Blockierung schützt Werbeumsätze, kann aber Affiliate-Chancen oder Abowachstum behindern. Eine aufkommende Chance ist das KI-Referral-Modell, bei dem Websites Einnahmen erzielen könnten, indem sie KI-Crawlern Zugriff gegen Attribution und Traffic-Referrals gewähren – ein Ansatz, der sich noch entwickelt, aber die Ökonomie der Inhaltsverbreitung verändern könnte. Für Publisher, die die Auswirkungen von KI-Crawlern verstehen wollen, bieten Tools wie AmICited.com unverzichtbare Monitoring-Funktionen, um zu sehen, wo Ihre Inhalte von KI-Systemen zitiert und verwendet werden und welchen Werttausch es tatsächlich gibt. Entscheidend ist, Ihr Geschäftsmodell so gut zu analysieren, dass Sie abschätzen können, wie KI-Crawler jeden Umsatzstrom beeinflussen – statt pauschal aus Prinzip zu entscheiden.

Wenn Sie beschlossen haben, bestimmte KI-Crawler zu blockieren, müssen Sie die Möglichkeiten und Grenzen der verfügbaren Tools kennen. Am gebräuchlichsten ist robots.txt – eine einfache Textdatei im Stammverzeichnis, die Crawler darüber informiert, welche Bereiche Ihrer Seite sie crawlen dürfen und welche nicht. Allerdings hat robots.txt eine entscheidende Schwäche: Sie ist freiwillig, Crawler können sie ignorieren – besonders aggressive oder böswillige Crawler tun das oft. Ein Beispiel, wie Sie bestimmte KI-Crawler in Ihrer robots.txt blockieren:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Über robots.txt hinaus sollten Sie folgende KI-Crawler blockieren:

Für einen robusteren Schutz setzen viele Unternehmen CDN-basiertes Blockieren über Dienste wie Cloudflare ein, die Traffic am Netzwerkrand blockieren, bevor er überhaupt Ihren Server erreicht – das erhöht Leistung und Sicherheit. Ein zweistufiger Ansatz aus robots.txt und CDN-Blocking bietet den besten Schutz, da er sowohl respektvolle Crawler abfängt, die robots.txt beachten, als auch aggressive, die sie ignorieren. Das Blockieren auf CDN-Ebene ist allerdings technisch anspruchsvoller und kann unbeabsichtigte Nebenwirkungen haben, wenn es nicht sorgfältig konfiguriert ist – es eignet sich daher besonders für Unternehmen mit eigenen technischen Ressourcen.

Die unbequeme Wahrheit beim Blockieren von KI-Crawlern ist, dass die tatsächlichen Auswirkungen auf den Traffic oft viel geringer sind als es die emotionale Debatte vermuten lässt – und die Daten zeichnen ein differenzierteres Bild, als viele Publisher erwarten. Laut aktueller Analyse machen KI-Crawler bei den meisten Publishern nur 0,15 % des Gesamttraffics aus – ein überraschend kleiner Wert angesichts der Aufmerksamkeit für dieses Thema. Das Wachstum der KI-Crawler-Anfragen ist jedoch rasant: Manche Berichte zeigen 7-faches jährliches Wachstum – der aktuelle Einfluss ist klein, aber die Dynamik steil. ChatGPT macht etwa 78 % des gesamten KI-Crawler-Traffics aus, OpenAI’s Crawler ist damit klar marktbeherrschend, gefolgt von weit kleineren Beiträgen anderer Unternehmen. Besonders aufschlussreich ist das Crawl-to-Referral-Verhältnis: Auch wenn KI-Crawler Millionen Seiten anfragen, führen sie zu echten Rückbesuchen meist in unter 0,15 % der Fälle – das Blockieren hat also kaum Einfluss auf Ihren Nutzertraffic. Das Blockieren von KI-Crawlern reduziert den Referral-Traffic um 96 %, aber da dieser ohnehin minimal war (meist unter 0,15 % des Gesamttraffics), ist die Nettoauswirkung auf Ihr Geschäft oft vernachlässigbar. Daraus ergibt sich ein Paradoxon: Das Blockieren von KI-Crawlern fühlt sich wie ein Zeichen gegen Content-Diebstahl an, doch die tatsächlichen Business-Auswirkungen sind oft so gering, dass sie kaum in Ihrer Analyse auffallen. Die entscheidende Frage ist nicht, ob das Blockieren Ihren Traffic schädigt – das tut es meist nicht –, sondern ob das Zulassen strategische Chancen oder Risiken erzeugt, die den minimalen Trafficbeitrag überwiegen.

Ihre Wettbewerbsposition bestimmt maßgeblich, wie Sie mit KI-Crawlern umgehen sollten, denn die optimale Strategie für einen Marktführer unterscheidet sich grundlegend von der für einen Newcomer. Dominante Marktteilnehmer wie die New York Times, das Wall Street Journal und große Nachrichtenportale können es sich leisten, KI-Crawler zu blockieren, weil ihre Markenbekanntheit und direkte Nutzerbeziehungen sie unabhängig von KI-Sichtbarkeit machen. Neue Player und Nischenpublisher haben eine andere Lage: Die Indexierung durch KI-Systeme und das Erscheinen in KI-generierten Zusammenfassungen kann eine der wenigen Möglichkeiten sein, Sichtbarkeit gegen etablierte Konkurrenten zu gewinnen. First-Mover-Vorteile in KI-Partnerschaften können bedeutend sein – Publisher, die früh günstige Konditionen mit KI-Unternehmen aushandeln, erhalten vielleicht bessere Attribution, Traffic oder Lizenzdeals als Nachzügler. Es gibt zudem einen Subventionseffekt: Wenn große Publisher KI-Crawler blockieren, greifen KI-Unternehmen verstärkt auf Inhalte derjenigen zurück, die offen sind – was diesen Publishern überproportionale KI-Sichtbarkeit verschaffen kann. So entsteht eine Wettbewerbssituation, in der Blockieren sogar schaden kann, wenn Wettbewerber zulassen und dadurch KI-Sichtbarkeit gewinnen. Zu wissen, wo Sie im Markt stehen, ist entscheidend, um vorherzusehen, wie sich Ihre Entscheidung im Konkurrenzumfeld auswirkt.

Die Entscheidung, KI-Crawler zu blockieren oder zuzulassen, sollte systematisch anhand konkreter Kriterien getroffen werden. Nutzen Sie diese Checkliste zur Entscheidungsfindung:

Inhaltsexpositions-Bewertung

Traffic-Analyse

Marktposition-Bewertung

Umsatzrisiko-Abschätzung

Über diese initiale Bewertung hinaus sollten Sie vierteljährliche Reviews Ihrer KI-Crawler-Strategie einplanen, da sich die Lage schnell ändert und die optimale Entscheidung von heute in einigen Monaten schon überholt sein kann. Nutzen Sie Tools wie AmICited.com, um zu verfolgen, wo Ihre Inhalte von KI-Systemen zitiert werden und bekommen Sie so konkrete Daten zum Werttausch Ihrer Inhalte. Die zentrale Erkenntnis: Diese Entscheidung ist nie endgültig – sie verlangt kontinuierliche Neubewertung und Anpassung, wenn sich die KI-Landschaft und Ihre Geschäftsbedingungen verändern.

Eine bedeutende neue Chance, die die gesamte KI-Crawler-Landschaft verändern könnte, ist Cloudflares Pay-per-Crawl-Feature. Es führt ein erlaubnisbasiertes Internetmodell ein, bei dem Website-Betreiber den KI-Crawler-Zugriff monetarisieren können, anstatt ihn nur zu blockieren oder zuzulassen. Dieser Ansatz erkennt an, dass KI-Unternehmen durch das Crawlen Ihrer Inhalte Wert schöpfen, und statt in einen Blockadekrieg zu gehen, könnten Sie stattdessen eine Vergütung für den Zugriff verhandeln. Das Modell basiert auf kryptografischer Verifikation, sodass nur autorisierte Crawler auf Ihre Inhalte zugreifen können – unbefugtes Scraping wird verhindert, während legitime KI-Unternehmen bezahlen. So entsteht granulare Kontrolle darüber, welche Crawler auf welche Inhalte zugreifen dürfen, sodass Sie hochwertige Inhalte monetarisieren und gleichzeitig Suchmaschinen und anderen nützlichen Crawlern Zugang gewähren. Das Pay-per-Crawl-Modell ermöglicht außerdem KI-Auditing, mit dem Sie genau sehen, welche Inhalte wann und von wem gecrawlt wurden – eine Transparenz, die traditionelle Blockieransätze nicht bieten. Für Publisher, die diese Strategie umsetzen, sind die Monitoring-Funktionen von AmICited.com besonders wertvoll, da Sie nicht nur sehen, wo Ihre Inhalte in KI-Systemen erscheinen, sondern auch prüfen können, ob Sie angemessen für deren Nutzung vergütet werden. Auch wenn dieses Modell noch im Entstehen ist und die Verbreitung derzeit begrenzt bleibt, stellt es einen deutlich differenzierteren Ansatz dar als die binäre Wahl zwischen Blockieren und Zulassen – einen, der den gegenseitigen Wert zwischen Publishern und KI-Unternehmen anerkennt und Ihre Interessen technisch wie vertraglich schützt.

Das Blockieren von KI-Crawlern verhindert, dass diese über robots.txt oder auf CDN-Ebene auf Ihre Inhalte zugreifen können, wodurch Ihre Inhalte davor geschützt werden, für das KI-Training verwendet zu werden. Das Zulassen von Crawlern bedeutet, dass Ihre Inhalte von KI-Systemen indexiert werden können und möglicherweise in KI-generierten Zusammenfassungen und Antworten erscheinen. Die Entscheidung hängt von Ihrem Inhaltstyp, Geschäftsmodell und Ihrer Wettbewerbsposition ab.

Das Blockieren von KI-Crawlern schadet Ihrem SEO nicht direkt, wenn Sie nur KI-spezifische Crawler wie GPTBot blockieren, während Sie Googlebot zulassen. Wenn Sie jedoch versehentlich Googlebot blockieren, werden Ihre Suchrankings erheblich leiden. Der Schlüssel ist eine granulare Steuerung, um nur KI-Trainings-Crawler zu blockieren und gleichzeitig Suchmaschinenzugriff zu erhalten.

Ja, Sie können robots.txt verwenden, um bestimmte Crawler anhand ihres User-Agent-Strings zu blockieren und andere zuzulassen. Sie könnten beispielsweise GPTBot blockieren und Google-Extended zulassen – oder umgekehrt. Dieser granulare Ansatz ermöglicht es Ihnen, Ihre Inhalte vor bestimmten KI-Unternehmen zu schützen und für andere sichtbar zu bleiben.

robots.txt ist ein freiwilliger Standard, der darauf baut, dass Crawler Ihre Anweisungen respektieren – einige KI-Unternehmen ignorieren ihn. Das Blockieren auf CDN-Ebene (wie bei Cloudflare) blockiert den Traffic am Netzwerk-Rand, bevor er Ihre Server erreicht und bietet so einen stärkeren Schutz. Ein zweistufiger Ansatz mit beiden Methoden bietet den besten Schutz.

Sie können Ihre Server-Logs nach User-Agent-Strings bekannter KI-Crawler wie GPTBot, CCBot und Claude-Web durchsuchen. Tools wie AmICited.com bieten Monitoring-Funktionen, mit denen Sie verfolgen können, wo Ihre Inhalte in KI-Systemen erscheinen und wie oft KI-Crawler darauf zugreifen.

Pay-per-Crawl ist ein aufkommendes Modell, bei dem KI-Unternehmen für den Zugriff auf Ihre Inhalte bezahlen. Es befindet sich zwar noch in einer Beta-Phase mit begrenzter Verbreitung, stellt aber einen potenziellen neuen Einnahmestrom dar. Die Tragfähigkeit hängt vom Volumen des KI-Crawler-Traffics und den Preisen ab, die KI-Unternehmen zu zahlen bereit sind.

Wenn ein KI-Crawler Ihre robots.txt-Anweisungen ignoriert, setzen Sie ein Blockieren auf CDN-Ebene über Dienste wie Cloudflare ein. Sie können Ihren Server auch so konfigurieren, dass er 403-Fehler an bekannte KI-Crawler-User-Agents zurückgibt. Bei wiederholten Verstößen ziehen Sie rechtliche Schritte oder die direkte Kontaktaufnahme mit dem KI-Unternehmen in Betracht.

Überprüfen Sie Ihre KI-Crawler-Strategie vierteljährlich, da sich das Umfeld schnell verändert. Überwachen Sie Veränderungen beim KI-Crawler-Traffic, neue Crawler am Markt und Verschiebungen Ihrer Wettbewerbsposition. Nutzen Sie Tools wie AmICited.com, um zu verfolgen, wie Ihre Inhalte von KI-Systemen genutzt werden, und passen Sie Ihre Strategie entsprechend an.

Verfolgen Sie, wo Ihre Inhalte in KI-generierten Antworten erscheinen, und verstehen Sie die Auswirkungen von KI-Crawlern auf Ihr Unternehmen mit der umfassenden Monitoring-Plattform von AmICited.com.

Verstehen Sie, wie KI-Crawler wie GPTBot und ClaudeBot funktionieren, wo sie sich von traditionellen Such-Crawlern unterscheiden und wie Sie Ihre Website für Si...

Erfahren Sie, welche KI-Crawler Sie in Ihrer robots.txt zulassen oder blockieren sollten. Umfassender Leitfaden zu GPTBot, ClaudeBot, PerplexityBot und 25+ KI-C...

Erfahren Sie, wie KI-Crawler Serverressourcen, Bandbreite und Leistung beeinflussen. Entdecken Sie echte Statistiken, Strategien zur Abschwächung und Infrastruk...