KI-Traffic-Konversionsraten: Warum Qualität über Quantität siegt

Entdecken Sie, warum KI-Traffic 23-mal besser konvertiert als organische Suche. Lernen Sie, wie Sie für KI-Plattformen optimieren und den tatsächlichen ROI von ...

Erfahren Sie, warum Datenqualität für KI-Modelle wichtiger ist als reine Menge. Lernen Sie Strategien zur Ressourcenallokation, Kostenaspekte und praktische Rahmenwerke zur Optimierung Ihrer Investition in KI-Trainingsdaten.

Die gängige Meinung im Machine Learning lautet seit Langem: „Mehr Daten sind immer besser.“ Doch aktuelle Forschung stellt diese Annahme mit überzeugenden Belegen infrage, dass Datenqualität weit mehr zählt als Quantität für die Leistung von KI-Modellen. Eine arxiv-Studie aus dem Jahr 2024 (2411.15821) zu kleinen Sprachmodellen zeigte, dass die Qualität der Trainingsdaten eine deutlich größere Rolle spielt als das bloße Volumen – das Verhältnis zwischen Datenmenge und Modellgenauigkeit ist also deutlich komplexer als bisher angenommen. Das hat erhebliche Kostenauswirkungen: Organisationen, die massiv in Datensammlung investieren, ohne auf Qualität zu achten, verschwenden Ressourcen für Speicherung, Verarbeitung und Compute, erzielen aber immer geringere Verbesserungen bei der Modellleistung.

Datenqualität ist kein monolithisches Konzept, sondern ein mehrdimensionales Rahmenwerk mit mehreren kritischen Aspekten. Genauigkeit beschreibt, wie korrekt Daten die Realität abbilden und ob Labels richtig vergeben sind. Konsistenz stellt sicher, dass Daten durchgehend einheitliche Formate und Standards aufweisen. Vollständigkeit misst, ob alle nötigen Informationen ohne große Lücken oder fehlende Werte vorliegen. Relevanz gibt an, ob die Daten das Problem direkt adressieren, das das KI-Modell lösen soll. Verlässlichkeit zeigt die Vertrauenswürdigkeit der Quelle und deren Stabilität über die Zeit. Schließlich steht Rauschen für unerwünschte Variationen oder Fehler, die das Modelltraining fehlleiten können. Wer diese Dimensionen versteht, kann die Datenkuratierung gezielt priorisieren.

| Qualitätsdimension | Definition | Einfluss auf KI |

|---|---|---|

| Genauigkeit | Korrektheit der Labels und Datenabbildung | Beeinflusst direkt die Zuverlässigkeit der Vorhersagen; falsche Labels erzeugen systematische Fehler |

| Konsistenz | Einheitliche Formatierung und standardisierte Datenstruktur | Ermöglicht stabiles Training; Inkonsistenzen verwirren Lernalgorithmen |

| Vollständigkeit | Vorhandensein aller nötigen Informationen ohne Lücken | Fehlende Werte verringern effektive Trainingsdaten; beeinträchtigt Generalisierung |

| Relevanz | Daten adressieren direkt den Problembereich | Hochrelevante Daten übertreffen große Mengen generischer Daten |

| Verlässlichkeit | Vertrauenswürdigkeit und Stabilität der Datenquellen | Unzuverlässige Quellen provozieren systematische Verzerrungen; schwächen Modellrobustheit |

| Rauschen | Unerwünschte Variationen und Messfehler | Geringes Rauschen stärkt Robustheit; zu viel verschlechtert Leistung |

Das Streben nach Datenmenge ohne Qualitätssicherung löst eine Kaskade von Problemen aus, die weit über reine Modellmetriken hinausgehen. Forschung von Rishabh Iyer zeigt, dass Labelrauschen zu dramatischen Genauigkeitseinbußen führt – falsch gelabelte Daten verschlechtern die Modellleistung aktiv, anstatt einfach neutrale Trainingsbeispiele zu bieten. Neben Genauigkeitsproblemen entstehen Unternehmen hohe Speicher- und Verarbeitungskosten für Datensätze, die die Modellleistung nicht verbessern, sowie erhebliche Umweltschäden durch unnötigen Compute-Aufwand. Die medizinische Bildgebung liefert ein ernüchterndes Beispiel: Ein Datensatz mit tausenden falsch gelabelten Röntgenbildern erzeugt ein Modell, das gefährliche Diagnosefehler mit hoher Zuversicht trifft und so Patienten schaden kann. Die trügerische Ersparnis billiger, minderwertiger Daten wird deutlich, wenn man die Kosten für erneutes Training, Debugging und Deploymentscheitern durch schlechte Trainingsdaten einrechnet.

Domänenspezifische Qualität übertrifft in der Praxis immer das generische Volumen. Ein Beispiel: Ein Sentiment-Klassifizierer für Filmrezensionen profitiert weitaus mehr von 10.000 sorgfältig kuratierten Rezensionen als von einem generischen Sentiment-Datensatz mit 100.000 Beispielen aus Finanznachrichten, Social Media und Produktbewertungen. Die Relevanz der Trainingsdaten für das konkrete Problem ist entscheidender als bloße Menge, denn Modelle lernen spezifische Muster aus ihrer Trainingsverteilung. Fehlt die Relevanz für die Zielanwendung, lernt das Modell Scheinzusammenhänge und kann nicht auf reale Szenarien verallgemeinern. Unternehmen sollten daher kleinere, exakt zugeschnittene Datensätze bevorzugen, anstatt riesige generische Mengen zu sammeln, die aufwendig gefiltert und vorverarbeitet werden müssen.

Die optimale Datenstrategie liegt nicht an einem Extrem, sondern in der Goldilocks-Zone – dort, wo Menge und Qualität passend zum Problem ausbalanciert sind. Zu wenig Daten, selbst wenn perfekt gelabelt, führen zu Underfitting und das Modell erkennt keine realen Muster. Zu viele Daten mit Qualitätsproblemen verursachen Rechenverschwendung und instabiles Training. Die arxiv-Studie zeigt das konkret: Minimale Duplikation verbesserte die Genauigkeit um 0,87 % bei 25 % Duplikaten, während exzessive Duplikation (100 %) zu einem katastrophalen 40 %-Genauigkeitsverlust führte. Die ideale Balance hängt von Algorithmus, Problemkomplexität, verfügbaren Ressourcen und der natürlichen Varianz im Zielbereich ab. Die Datenverteilung sollte reale Schwankungen widerspiegeln, statt künstlich gleichförmig zu sein – so lernt das Modell, mit Produktionsvariabilität umzugehen.

Nicht alle zusätzlichen Daten sind gleichwertig – der Unterschied zwischen förderlicher Augmentation und schädlicher Verschlechterung ist entscheidend. Gezielte Veränderungen und Augmentationstechniken stärken die Robustheit, indem sie Algorithmen auf reale Variationen wie leichte Drehungen, Beleuchtungswechsel oder kleine Label-Änderungen vorbereiten. Das MNIST-Datenset handgeschriebener Ziffern demonstriert dies: Modelle, die mit augmentierten (gedrehten, skalierten, leicht verzerrten) Bildern trainiert wurden, verallgemeinern besser auf reale Handschriften als solche, die nur Originaldaten sahen. Massive Verschlechterung – etwa Zufallsrauschen, systematische Fehl-Labels oder irrelevante Daten – verschlechtert die Leistung und verschwendet Ressourcen. Der Unterschied ist Absicht: Augmentation spiegelt realistische Variationen wider, während „Müll-Daten“ willkürliches Rauschen sind, das das Lernen stört. Organisationen sollten diese Ansätze bei der Datenerweiterung klar unterscheiden.

Gerade für Organisationen mit begrenzten Ressourcen bietet Active Learning eine wirkungsvolle Lösung, um den Datenbedarf zu senken und trotzdem die Modellleistung zu sichern oder zu verbessern. Statt passiv alle verfügbaren Daten zu labeln, identifizieren Active-Learning-Algorithmen jene ungelabelten Beispiele, die für das Modell am lehrreichsten wären – und verringern so den manuellen Aufwand drastisch. So lässt sich mit weniger gelabelten Daten eine hohe Modellgüte erreichen, weil menschliche Arbeit auf die wichtigsten Beispiele konzentriert wird. Active Learning demokratisiert KI-Entwicklung und macht sie Teams ohne großes Label-Budget zugänglich – sie bauen effektive Modelle durch strategische Datenauswahl statt schierer Masse. Effizientes Lernen mit weniger Daten beschleunigt Iterationen, spart Kosten und ermöglicht Investitionen in Qualitätssicherung statt endloser Datensammlung.

Eine strategische Ressourcenallokation bedeutet, Qualität systematisch vor Quantität zu stellen. Unternehmen sollten in belastbare Validierungspipelines investieren, die Fehler erkennen, bevor sie ins Trainingsset gelangen – mit automatischen Checks für Konsistenz, Vollständigkeit und Genauigkeit. Daten-Profiling-Tools machen Qualitätsprobleme im großen Stil sichtbar, etwa Fehl-Labels, fehlende Werte oder irrelevante Beispiele, die vor dem Training behoben werden sollten. Active-Learning-Implementierungen senken das Datenvolumen, das menschlich geprüft werden muss, und stellen sicher, dass geprüfte Beispiele möglichst informativ sind. Eine kontinuierliche Überwachung der Modellleistung im Produktiveinsatz zeigt, ob Qualitätsprobleme der Trainingsdaten zu realen Fehlern führen, und ermöglicht schnelle Feedback-Schleifen. Die optimale Strategie kombiniert Datensammlung mit sorgfältiger Kuratierung – im Wissen, dass 1.000 perfekt gelabelte Beispiele oft besser abschneiden als 100.000 verrauschte, sowohl bei Leistung als auch bei Kosten.

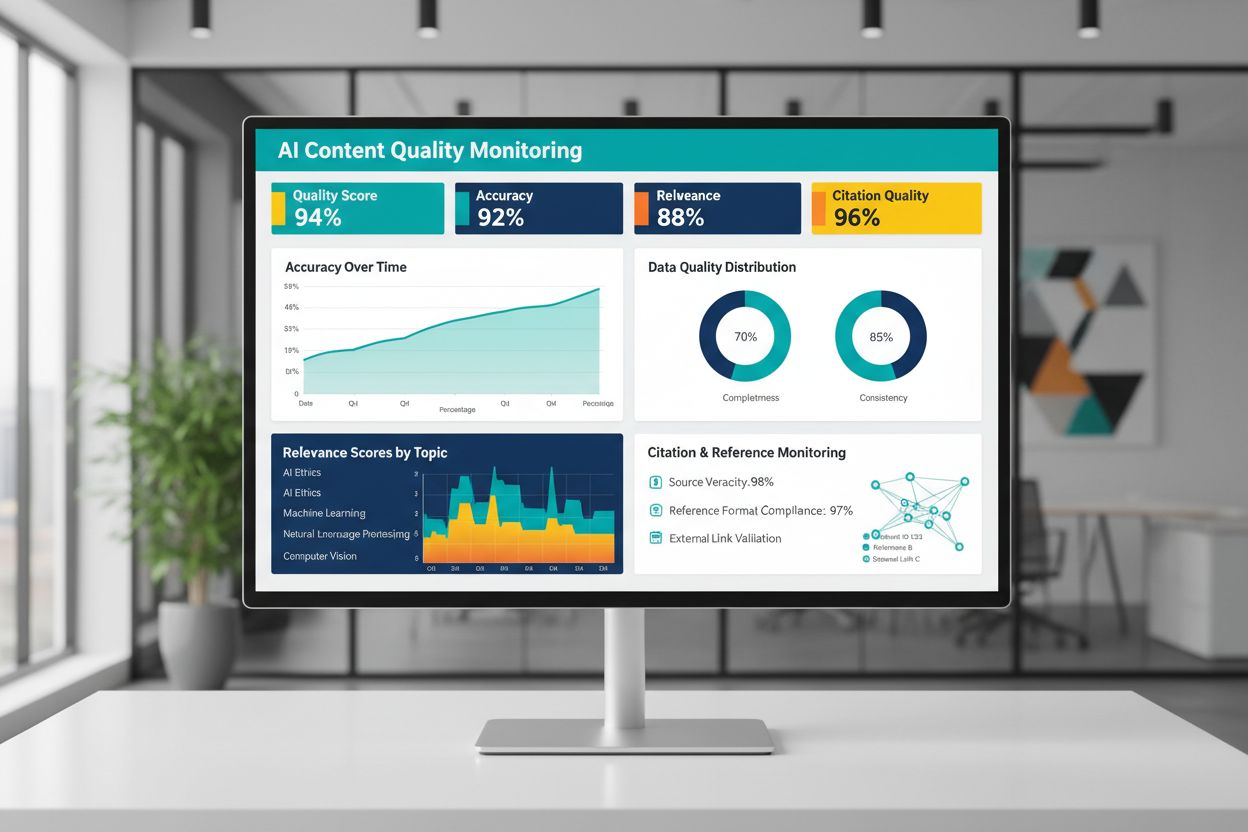

Die Qualität von KI-generierten oder -trainierten Inhalten hängt grundlegend von den Trainingsdaten ab – eine kontinuierliche Überwachung der KI-Ausgaben ist daher essenziell für Zuverlässigkeit. Plattformen wie AmICited.com begegnen diesem Bedarf, indem sie KI-Antworten überwachen und Zitiergenauigkeit nachverfolgen – ein direkter Indikator für Inhaltsqualität und Vertrauenswürdigkeit. Werden KI-Systeme mit mangelhaften Daten, schlechten Zitaten oder ungenauen Informationen trainiert, vererben sich diese Fehler in den Ausgaben und verbreiten sich potenziell großflächig. Monitoring-Tools sollten nicht nur Genauigkeit, sondern auch Relevanz, Konsistenz und belegende Nachweise für KI-Aussagen erfassen. Unternehmen müssen Feedback-Schleifen etablieren, die Abweichungen von Qualitätsstandards frühzeitig erkennen und rasches Nachtrainieren oder eine Korrektur der Daten ermöglichen. Die Investition in Überwachungsinfrastruktur zahlt sich aus, weil sie Qualitätsverschlechterungen auffängt, bevor Nutzer betroffen sind oder der Ruf leidet.

Um Grundsätze der Datenqualität in die Praxis umzusetzen, braucht es einen strukturierten Ansatz, der bei der Einschätzung beginnt und über Messung bis zur Iteration reicht. Starten Sie mit einer Bewertung Ihres Status quo – verschaffen Sie sich durch Audits und Profiling einen Überblick über die aktuelle Datenqualität. Definieren Sie klare Qualitätsmetriken passend zu Ihrem Anwendungsfall, etwa Genauigkeitsschwellen, Konsistenzstandards oder Relevanzkriterien. Etablieren Sie Data-Governance-Praktiken, die Verantwortlichkeiten, Validierungsprozesse und Qualitätsprüfungen vor der Aufnahme ins Trainingsset vorschreiben. Beginnen Sie mit kleineren, sorgfältig kuratierten Datensätzen, statt von Anfang an riesige Mengen zu verarbeiten – so können Sie Qualitätsstandards und Prozesse im überschaubaren Rahmen verankern. Messen Sie Verbesserungen konsequent, indem Sie die Modellleistung vor und nach Qualitätsmaßnahmen vergleichen und so eine evidenzbasierte Rechtfertigung für weitere Investitionen schaffen. Skalieren Sie erst, wenn Sie nachgewiesen haben, dass Qualitätsmaßnahmen echte Leistungsgewinne bringen.

Nein. Aktuelle Forschung zeigt, dass die Datenqualität oft wichtiger ist als Quantität. Schlecht qualifizierte, falsch gelabelte oder irrelevante Daten können die Modellleistung, selbst in großem Maßstab, aktiv verschlechtern. Entscheidend ist das richtige Gleichgewicht zwischen ausreichend Daten für effektives Training und hohen Qualitätsstandards.

Datenqualität umfasst mehrere Dimensionen: Genauigkeit (korrekte Labels), Konsistenz (einheitliche Formatierung), Vollständigkeit (keine fehlenden Werte), Relevanz (Bezug zum Problem), Verlässlichkeit (vertrauenswürdige Quellen) und Rauschanteil. Definieren Sie für Ihren Anwendungsfall spezifische Metriken und implementieren Sie Validierungsschritte, um Qualitätsprobleme vor dem Training zu erkennen.

Die ideale Größe hängt von der Komplexität des Algorithmus, dem Problemtyp und den verfügbaren Ressourcen ab. Streben Sie statt maximaler Größe lieber die 'Goldilocks-Zone' an – genug Daten, um reale Muster zu erfassen, ohne von irrelevanten oder redundanten Beispielen überflutet zu werden. Beginnen Sie klein mit kuratierten Daten und skalieren Sie schrittweise basierend auf Leistungsverbesserungen.

Datenaugmentation nutzt kontrollierte Veränderungen (Drehungen, leichte Verzerrungen, Lichtvariationen), die das wahre Label erhalten und das Modell auf reale Variabilität vorbereiten. Das unterscheidet sich von minderwertigen Daten – Augmentation ist gezielt und spiegelt realistische Abweichungen wider, wodurch Modelle robuster für produktive Umgebungen werden.

Active Learning identifiziert jene ungelabelten Beispiele, von denen das Modell am meisten lernen würde, und reduziert so den Annotierungsaufwand drastisch. Anstatt alle verfügbaren Daten zu labeln, konzentrieren Sie menschliche Arbeit auf die wichtigsten Beispiele und erzielen mit deutlich weniger gelabelten Daten starke Ergebnisse.

Setzen Sie Qualität vor Quantität. Investieren Sie in Datenvalidierungs-Pipelines, Profiling-Tools und Governance-Prozesse, die hochwertige Trainingsdaten sicherstellen. Studien zeigen: 1.000 perfekt gelabelte Beispiele übertreffen oft 100.000 verrauschte sowohl bei der Modellleistung als auch bei den Gesamtbetriebskosten.

Schlechte Daten verursachen zahlreiche Kosten: erneutes Modelltraining, Debugging, Ausfall bei der Bereitstellung, Speicher-Overhead und verschwendete Rechenleistung. In kritischen Bereichen wie medizinischer Bildgebung können minderwertige Trainingsdaten zu gefährlichen Fehlern führen. Die vermeintliche Ersparnis billiger Daten entpuppt sich, wenn man diese versteckten Kosten einrechnet.

Implementieren Sie eine kontinuierliche Überwachung der KI-Ausgaben hinsichtlich Genauigkeit, Relevanz, Konsistenz und Zitierqualität. Plattformen wie AmICited überwachen, wie KI-Systeme Informationen referenzieren und die Zitiergenauigkeit verfolgen. Etablieren Sie Feedback-Schleifen, die die Produktionsleistung mit der Trainingsdatenqualität verbinden, um schnelle Verbesserungen zu ermöglichen.

Verfolgen Sie, wie KI-Systeme Ihre Marke referenzieren und stellen Sie die Inhaltsgenauigkeit mit der KI-Überwachungsplattform von AmICited sicher. Verstehen Sie die Qualität KI-generierter Antworten über Ihr Unternehmen.

Entdecken Sie, warum KI-Traffic 23-mal besser konvertiert als organische Suche. Lernen Sie, wie Sie für KI-Plattformen optimieren und den tatsächlichen ROI von ...

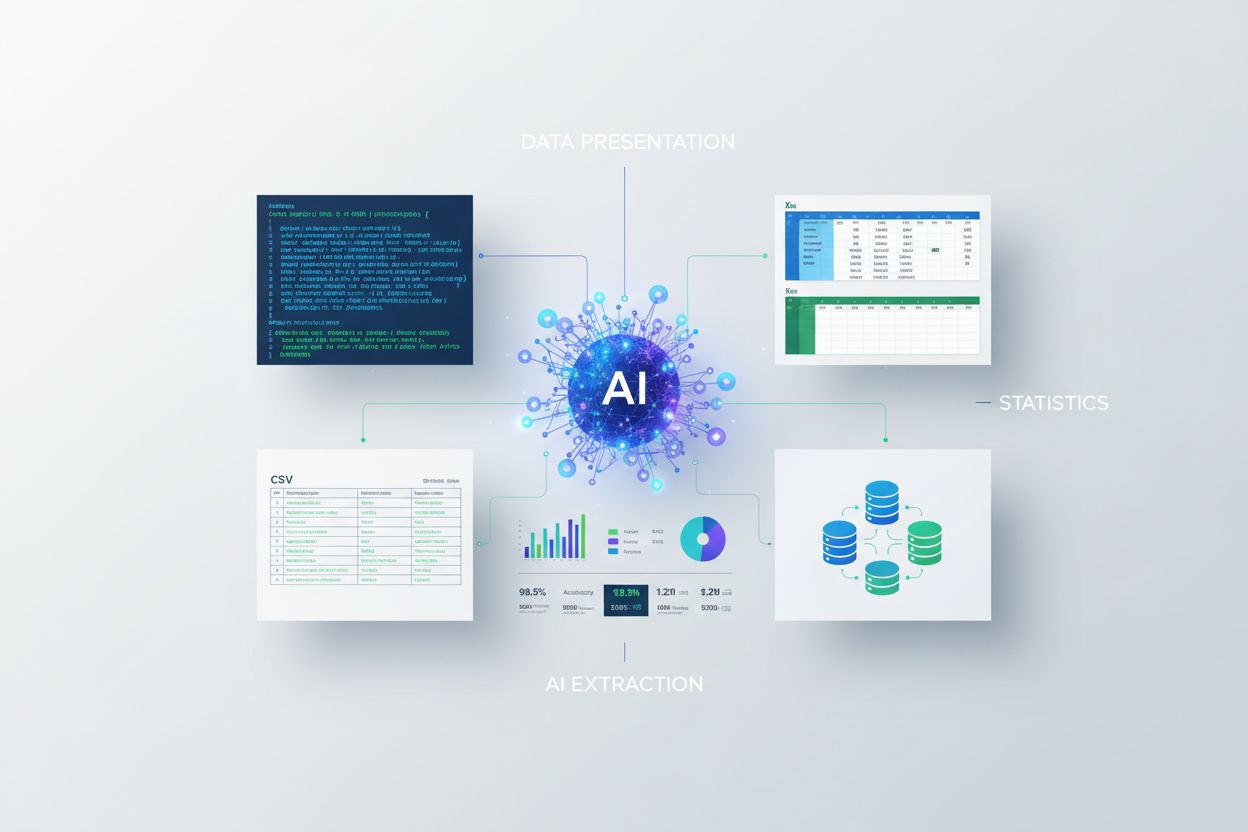

Erfahren Sie, wie Sie Statistiken für die KI-Extraktion präsentieren. Entdecken Sie Best Practices für Datenformate, JSON vs. CSV, und wie Sie Ihre Daten KI-ber...

Community-Diskussion darüber, wie Inhaltsaktualität KI-Suchergebnisse und Zitationen beeinflusst. Reale Daten zum Aktualitäts-Bias bei ChatGPT, Perplexity und G...