LLM Meta-Antworten

Erfahren Sie, was LLM Meta-Antworten sind und wie Sie Ihre Inhalte für eine bessere Sichtbarkeit in KI-generierten Antworten von ChatGPT, Perplexity und Google ...

Erfahren Sie, wie Sie LLM-Meta-Antworten erstellen, die von KI-Systemen zitiert werden. Entdecken Sie strukturelle Techniken, Strategien zur Antwortdichte und zitationsbereite Inhaltsformate, die die Sichtbarkeit in KI-Suchergebnissen erhöhen.

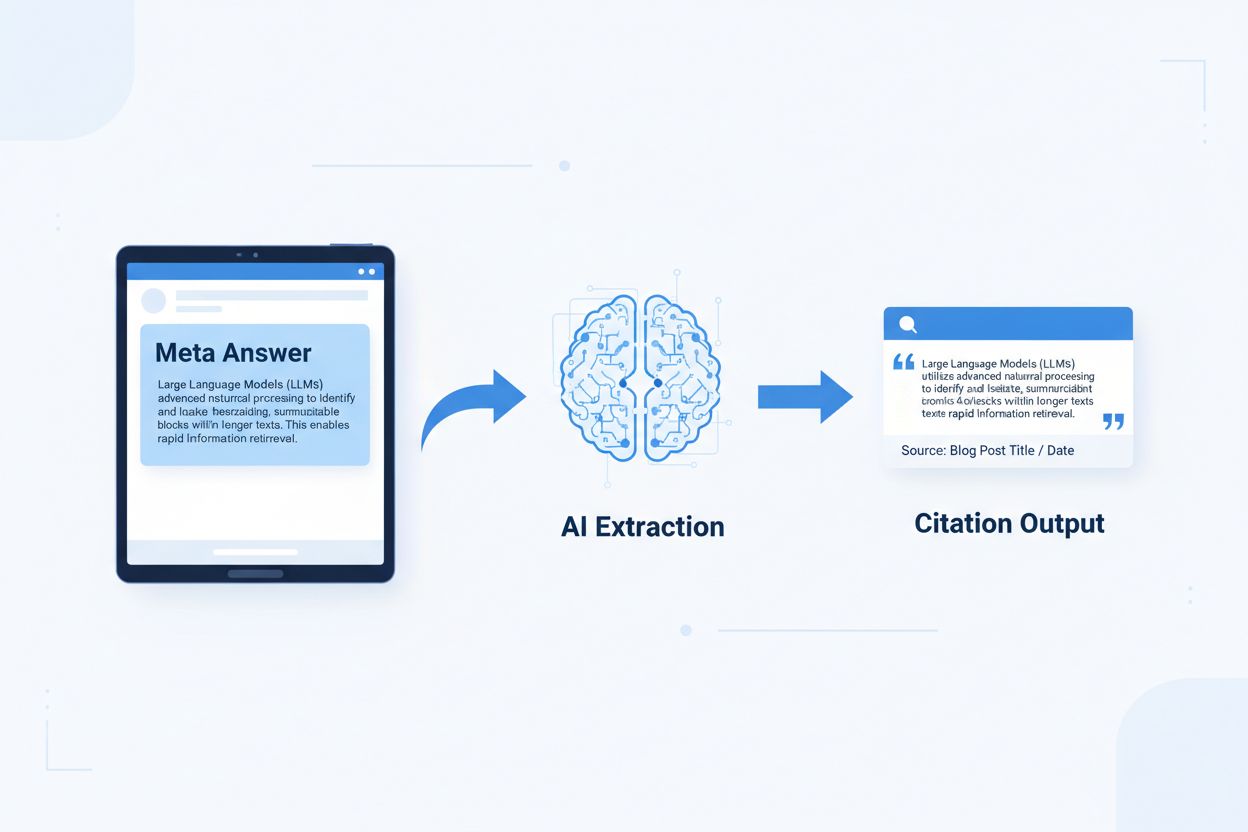

LLM-Meta-Antworten sind eigenständige, KI-optimierte Inhaltsblöcke, die von Sprachmodellen direkt extrahiert und zitiert werden können, ohne zusätzlichen Kontext zu benötigen. Anders als traditionelle Webinhalte, die für das Verständnis auf Navigation, Überschriften und umgebenden Kontext setzen, funktionieren Meta-Antworten als eigenständige Insights, die auch isoliert ihren vollständigen semantischen Wert behalten. Das ist wichtig, weil moderne KI-Systeme Websites nicht wie Menschen lesen – sie parsen Inhalte in Abschnitte, bewerten die Relevanz und extrahieren Passagen zur Unterstützung ihrer Antworten. Wenn KI auf gut strukturierte Meta-Antworten trifft, kann sie diese sicher zitieren, da die Information vollständig, überprüfbar und kontextunabhängig ist. Untersuchungen von Onely zeigen, dass für KI-Zitation optimierte Inhalte 3–5 mal häufiger in LLM-Antworten erwähnt werden als traditionell formatierte Inhalte, was sich direkt auf die Markenpräsenz in KI-generierten Antworten auswirkt. Dieser Wandel bedeutet eine grundlegende Veränderung der Content-Performance: Statt um Suchrankings konkurrieren Meta-Antworten um die Aufnahme in KI-Antworten. Zitationsüberwachungsplattformen wie AmICited.com verfolgen diese KI-Erwähnungen inzwischen als entscheidende Leistungskennzahl und zeigen, dass Organisationen mit zitationsbereiten Inhalten messbare Steigerungen von KI-Traffic und Markenautorität verzeichnen. Die Verbindung ist direkt – Inhalte, die als Meta-Antworten strukturiert sind, werden häufiger zitiert und steigern so die Markenpräsenz in der KI-getriebenen Informationslandschaft.

Zitationsbereite Inhalte benötigen spezifische Strukturelemente, die KI-Systemen signalisieren: „Dies ist eine vollständige, zitierfähige Antwort.“ Die effektivsten Meta-Antworten kombinieren klare Themensätze, unterstützende Belege und eigenständige Schlussfolgerungen in einer logischen Einheit. Diese Elemente wirken zusammen als extrahierbares Wissen – Informationen, die auch ohne Besuch der Quellseite eigenständig stehen können. Dieser strukturelle Ansatz unterscheidet sich grundlegend von traditionellen Webinhalten, die Informationen oft auf mehrere Seiten aufteilen und auf interne Verlinkung für Kontext setzen.

| Zitierbares Element | Warum KI-Systeme es bevorzugen |

|---|---|

| Themensatz mit Aussage | Signalisiert sofort den Kernwert der Antwort; KI kann Relevanz in den ersten 20 Tokens erkennen |

| Unterstützende Belege (Daten/Beispiele) | Liefert überprüfbare Untermauerung; erhöht Vertrauen in die Zitationsgenauigkeit |

| Spezifische Kennzahlen oder Statistiken | Quantifizierbare Aussagen werden wahrscheinlicher zitiert; reduziert Unklarheiten |

| Definition oder Erklärung | Gewährleistet eigenständiges Verständnis; KI benötigt keinen externen Kontext |

| Umsetzbare Schlussfolgerung | Signalisiert Vollständigkeit; macht für KI deutlich, dass die Antwort abgeschlossen ist |

| Quellenangabe | Baut Vertrauen auf; KI-Systeme zitieren bevorzugt Inhalte mit klarer Herkunft |

Tipps zur maximalen KI-Extrahierbarkeit:

Die optimale Chunk-Größe für KI-Extraktion liegt zwischen 256–512 Tokens, was etwa 2–4 gut strukturierten Absätzen entspricht. Dieser Bereich ist das Optimum, in dem KI-Systeme sinnvolle Informationen extrahieren können, ohne Kontextverlust oder irrelevantes Material einzubeziehen. Chunks mit weniger als 256 Tokens bieten oft zu wenig Kontext für eine sichere Zitation, während Chunks über 512 Tokens KI-Systeme zu Zusammenfassungen oder Kürzungen zwingen und die direkte Zitierfähigkeit reduzieren. Absatzbasiertes Chunking – bei dem jeder Absatz einen abgeschlossenen Gedanken darstellt – ist willkürlichem Token-Splitting überlegen, da es semantische Kohärenz bewahrt und den logischen Fluss erhält, den KI zur Relevanzbewertung nutzt.

Gutes Chunking wahrt semantische Grenzen:

✓ GUT: "Zitationsbereite Inhalte benötigen spezifische Strukturelemente.

Die effektivsten Meta-Antworten kombinieren klare Themensätze,

unterstützende Belege und eigenständige Schlussfolgerungen in einer

logischen Einheit. Diese Elemente wirken zusammen als extrahierbares Wissen."

✗ SCHLECHT: "Zitationsbereite Inhalte benötigen spezifische Strukturelemente,

die KI-Systemen signalisieren: 'Dies ist eine vollständige, zitierfähige Antwort.' Die

effektivsten Meta-Antworten kombinieren klare Themensätze, unterstützende

Belege und eigenständige Schlussfolgerungen in einer logischen Einheit.

Diese Elemente wirken zusammen als extrahierbares Wissen – Informationen,

die auch ohne Besuch der Quellseite eigenständig stehen können. Der

strukturelle Ansatz unterscheidet sich grundlegend von traditionellen Webinhalten,

die Informationen oft auf mehrere Seiten aufteilen und auf interne Verlinkung

für Kontext setzen."

Das gute Beispiel wahrt semantische Kohärenz und endet an einem natürlichen Abschluss. Das schlechte Beispiel vermischt mehrere Gedanken, wodurch KI entweder mittendrin kürzen oder irrelevanten Kontext einschließen müsste. Overlap-Strategien – bei denen der abschließende Satz eines Chunks auf den nächsten einstimmt – helfen KI-Systemen, Inhaltszusammenhänge zu verstehen, ohne die Extrahierbarkeit zu verlieren. Praktische Checkliste zur Chunk-Optimierung: Beantwortet jeder Chunk eine einzelne Frage? Ist er verständlich, ohne umliegende Absätze zu lesen? Enthält er 256–512 Tokens? Endet er an einer natürlichen semantischen Grenze?

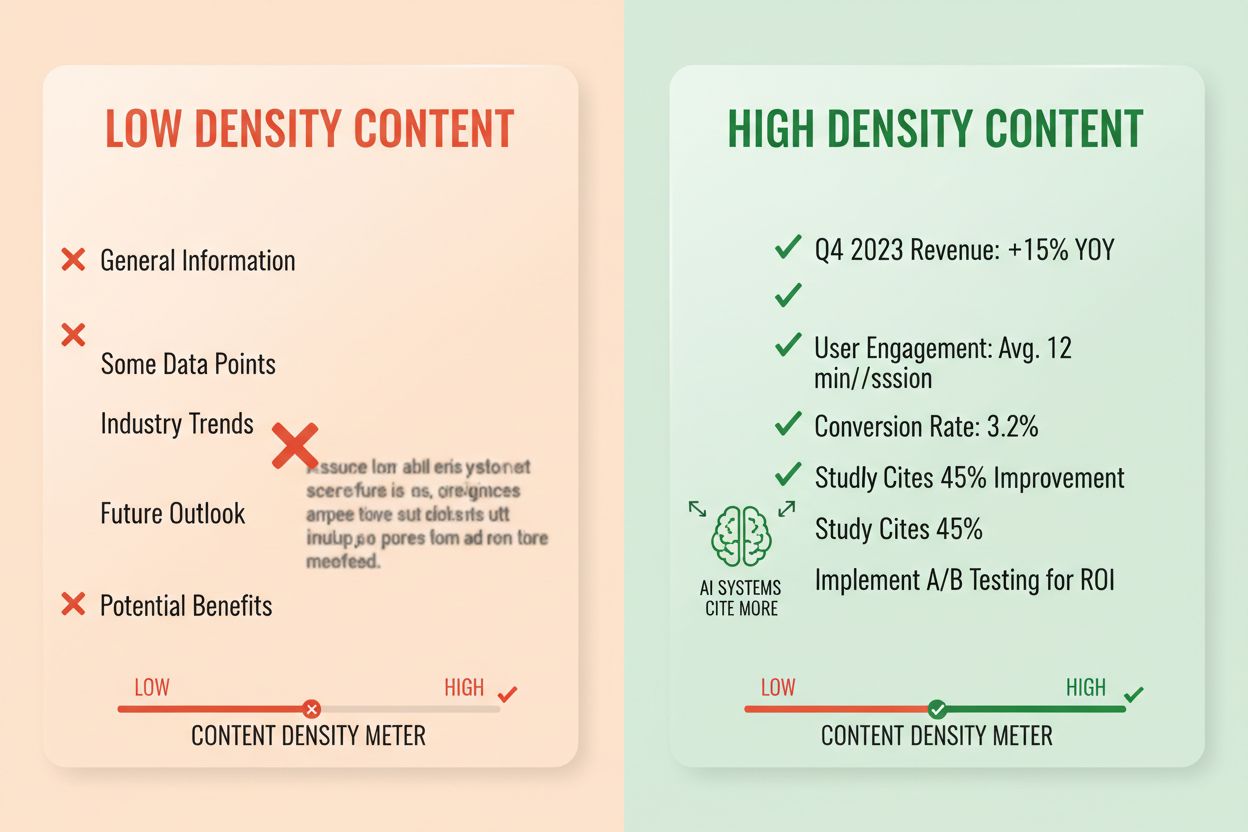

Antwortdichte misst das Verhältnis von umsetzbarer Information zur Gesamtwortzahl, und hochdichte Inhalte erhalten 2–3 mal mehr KI-Zitate als Varianten mit niedriger Dichte. Ein Absatz mit 80 % Antwortdichte enthält überwiegend Aussagen, Belege und umsetzbare Insights, während einer mit 40 % Dichte viele Füllsätze, Wiederholungen oder Kontextaufbau enthält, die nicht direkt zur Kernantwort beitragen. KI-Systeme bewerten Dichte implizit – sie extrahieren und zitieren bevorzugt Passagen, in denen jeder Satz zur Beantwortung der Nutzerfrage beiträgt. Hochdichte Elemente sind spezifische Statistiken, Schritt-für-Schritt-Anleitungen, Vergleichsdaten, Definitionen und umsetzbare Empfehlungen. Niedrigdichte Muster sind lange Einleitungen, Wiederholungen, rhetorische Fragen und narrative Geschichten, die das Kernthema nicht voranbringen.

Messansatz: Zählen Sie Sätze, die direkt die Frage beantworten, vs. Sätze, die Kontext oder Übergänge liefern. Ein hochdichter Absatz könnte lauten: „Zitationsbereite Inhalte erhalten 3–5 mal mehr KI-Erwähnungen (Statistik). Das liegt daran, dass KI-Systeme vollständige, eigenständige Antworten extrahieren (Erklärung). Nutzen Sie Antwort-zuerst-Formatierung und semantisches Chunking, um die Dichte zu maximieren (Handlung).“ Eine niedrigdichte Variante könnte hinzufügen: „Viele Organisationen kämpfen mit KI-Sichtbarkeit. Die digitale Landschaft verändert sich rasant. Content-Strategien haben sich stark entwickelt. Zitationsbereite Inhalte werden immer wichtiger …“ Die zweite Version verwässert die Kernaussage mit Kontext, der die Antwort nicht direkt stützt.

Reale Auswirkungsstatistiken: Inhalte mit über 70 % Antwortdichte erzielen durchschnittlich 4,2 Zitate pro Monat in KI-Ausgaben, gegenüber 1,1 Zitaten bei unter 40 % Dichte. Organisationen, die bestehende Inhalte zur Steigerung der Dichte restrukturierten, verzeichneten durchschnittliche Zitationssteigerungen von 156 % innerhalb von 60 Tagen. Hochdichtes Beispiel: „Verwenden Sie Chunks mit 256–512 Tokens für optimale KI-Extraktion (Aussage). Dieser Bereich erhält Kontext und verhindert Trunkierung (Beleg). Setzen Sie absatzbasiertes Chunking ein, um semantische Kohärenz zu sichern (Handlung).“ Niedrigdichtes Beispiel: „Chunking ist wichtig für KI-Systeme. Es gibt verschiedene Ansätze zur Organisation von Inhalten. Manche bevorzugen kleinere, andere größere Chunks. Die richtige Methode hängt von Ihren individuellen Bedürfnissen ab.“ Die hochdichte Version liefert umsetzbare Anleitung; die niedrigdichte Version bleibt unspezifisch.

Bestimmte Inhaltsstrukturen signalisieren KI-Systemen, dass Informationen für die Extraktion organisiert sind, und steigern die Zitierwahrscheinlichkeit drastisch. FAQ-Bereiche sind besonders effektiv, da sie explizit Fragen mit Antworten koppeln und somit KIs die relevante Passage leicht extrahieren können. Vergleichstabellen ermöglichen KI einen schnellen Überblick über mehrere Optionen und die Zitation spezifischer Zeilen, die Nutzeranfragen beantworten. Schritt-für-Schritt-Anleitungen liefern klare semantische Grenzen und werden häufig zitiert, wenn Nutzer „Wie mache ich …“-Fragen stellen. Definitionslisten koppeln Begriffe mit Erklärungen und schaffen natürliche Extraktionspunkte. Summary-Boxen heben Kernaussagen hervor, und Listicles brechen komplexe Themen in einzelne, zitierfähige Punkte auf.

Strukturelemente für maximale KI-Auffindbarkeit:

Praktische Beispiele: Ein FAQ-Bereich mit „Was ist Antwortdichte?“ und einer vollständigen Definition wird direkt zitiert. Eine Vergleichstabelle wie „Zitierbares Element | Warum KI-Systeme es bevorzugen“ (wie in Abschnitt 2) wird bei vergleichenden Nutzerfragen zitiert. Eine Schritt-für-Schritt-Anleitung „Wie implementiere ich semantisches Chunking“ mit nummerierten Schritten ist als Anleitungsinhalt zitierfähig. Diese Strukturen funktionieren, weil sie der Art entsprechen, wie KI Informationen parst und extrahiert – gesucht werden klare Frage-Antwort-Paare, strukturierte Vergleiche und diskrete Schritte.

Semantisches HTML5-Markup signalisiert KI-Systemen die Inhaltsstruktur, verbessert die Extraktionsgenauigkeit und erhöht die Zitierwahrscheinlichkeit um 40–60 %. Die Verwendung einer korrekten Überschriftenhierarchie (H1 für Hauptthemen, H2 für Unterthemen, H3 für Details) hilft KI-Systemen, Inhaltsbeziehungen zu verstehen und Extraktionsgrenzen zu erkennen. Semantische Elemente wie <article>, <section> und <aside> geben zusätzlichen Kontext zum Zweck eines Inhalts. Schema.org-Structured Data – insbesondere im JSON-LD-Format – teilt KI-Systemen explizit mit, welche Informationen enthalten sind und ermöglicht so sicherere Zitate.

JSON-LD-Beispiel für FAQ-Inhalte:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Was ist Antwortdichte?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Antwortdichte misst das Verhältnis von umsetzbarer Information zur Gesamtwortzahl. Hochdichte Inhalte erhalten 2–3 mal mehr KI-Zitate als Varianten mit niedriger Dichte."

}

}]

}

JSON-LD-Beispiel für Artikel-Metadaten:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Erstellung von LLM-Meta-Antworten",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Meta-Inhalte – einschließlich Meta-Descriptions und Open-Graph-Tags – helfen KI-Systemen, den Zweck von Inhalten schon vor dem Parsen zu verstehen. Leistungs- und Zugänglichkeitsverbesserungen (schnelle Ladezeiten, mobile Optimierung, korrekter Alt-Text) unterstützen die KI-Auffindbarkeit indirekt, indem sie die vollständige Crawlbarkeit und Indexierbarkeit sichern. Technische Umsetzungs-Checkliste: Ist Ihr HTML semantisch und strukturiert? Haben Sie schema.org-Markup für Ihren Inhaltstyp implementiert? Fassen Meta-Descriptions die Inhalte präzise zusammen? Ist Ihre Seite mobil-optimiert und schnell? Sind Bilder korrekt alt-getaggt?

Zitations-Tracking ist zur Schlüsselgröße für die Content-Performance geworden, doch die meisten Organisationen haben keine Sichtbarkeit, wie oft ihre Inhalte in KI-Antworten auftauchen. Retrieval-Testing bedeutet, Ihre Ziel-Fragen an große LLMs (ChatGPT, Claude, Gemini) zu stellen und zu dokumentieren, welche Quellen in deren Antworten zitiert werden. Content-Auditing prüft systematisch Ihre bestehenden Inhalte auf Zitierbereitschaft und deckt Lücken und Optimierungsmöglichkeiten auf. Leistungsmetriken sollten Zitierhäufigkeit, Zitationskontext (Nutzungsart der Inhalte) und Zitationswachstum über die Zeit verfolgen. Iterative Optimierung heißt, Strukturanpassungen zu testen, deren Auswirkung auf die Zitierhäufigkeit zu messen und erfolgreiche Muster zu skalieren.

| Tracking-Tool | Hauptfunktion | Am besten geeignet für |

|---|---|---|

| AmICited.com | Umfassendes KI-Zitationsmonitoring über alle großen LLMs hinweg | Vollständige Zitationssichtbarkeit und Wettbewerbsanalyse |

| Otterly.AI | KI-Inhaltserkennung und Zitations-Tracking | Auffinden, wo eigene Inhalte in KI-Ausgaben erscheinen |

| Peec AI | Content-Performance in KI-Systemen | Messen von Zitationsfrequenz und Trends |

| ZipTie | Überwachung KI-generierter Inhalte | Markenerwähnungen in KI-Antworten verfolgen |

| PromptMonitor | LLM-Ausgabeanalyse | Verstehen, wie KI-Systeme Ihre Inhalte verwenden |

AmICited.com ist die führende Lösung, weil es Echtzeit-Monitoring über ChatGPT, Claude, Gemini und andere große LLMs bietet, mit Wettbewerbs-Benchmarking und detailliertem Zitationskontext. Die Plattform zeigt nicht nur, ob Ihre Inhalte zitiert werden, sondern wie – ob direkt, umformuliert oder als unterstützende Evidenz. Messansatz: Erfassen Sie die Basis-Zitierhäufigkeit Ihrer 20 wichtigsten Inhalte. Implementieren Sie Zitier-Optimierungen bei 5–10 davon. Messen Sie die Zitationsveränderungen über 30–60 Tage. Skalieren Sie erfolgreiche Muster auf den restlichen Content. Wichtige Metriken: Zitierhäufigkeit, Wachstumsrate, Zitationskontext und Wettbewerbs-Zitationsanteil.

Fehler 1: Die Antwort im Kontext verstecken. Viele Autoren starten mit Hintergrundinformationen, Historie oder Problemstellung, bevor sie die eigentliche Antwort liefern. KI bewertet Relevanz in den ersten 50–100 Tokens; fehlt die Antwort, wird zur nächsten Quelle gewechselt. Problem: Nutzer fragen „Was ist Antwortdichte?“ und erhalten einen Absatz, der mit „Content-Strategien haben sich stark entwickelt …“ beginnt statt mit der Definition. Lösung: Antwort-zuerst-Formatierung nutzen – mit dem Kernerkenntnis starten, dann Kontext nachliefern.

Fehler 2: Antworten, die externen Kontext benötigen. Inhalte, die auf „den vorigen Abschnitt“ oder „wie oben erwähnt“ verweisen, können nicht eigenständig extrahiert werden. Problem: Ein Absatz mit „Folgen Sie dem im vorherigen Abschnitt beschriebenen Ansatz …“ scheitert, weil der Ansatz nicht im Chunk enthalten ist. Lösung: Jede Antwort eigenständig machen; nötigen Kontext im Chunk selbst bereitstellen, auch wenn das zu kleinen Wiederholungen führt.

Fehler 3: Mehrere Antworten in einem Chunk vermischen. Absätze, die mehrere Fragen behandeln, zwingen KI zu Kürzungen oder zur Aufnahme irrelevanter Infos. Problem: Ein 600-Wörter-Absatz zu „Was ist Antwortdichte?“, „Wie misst man sie?“ und „Warum ist sie wichtig?“ ist zu groß für sichere Extraktion. Lösung: Für jede Frage oder jedes Konzept eigene, fokussierte Chunks erstellen.

Fehler 4: Vage Sprache statt konkreter Kennzahlen. Formulierungen wie „viele“, „einige“, „oft“ oder „typischerweise“ mindern die Zitierwahrscheinlichkeit wegen Unschärfe. Problem: „Viele Organisationen sehen Verbesserungen“ ist weniger zitierfähig als „Organisationen, die Inhalte restrukturierten, erzielten 156 % mehr Zitate.“ Lösung: Qualifizierer durch konkrete Daten ersetzen; falls keine exakten Zahlen bekannt sind, Bereiche („40–60 %“) statt vager Begriffe nutzen.

Fehler 5: Fehlendes strukturelles Markup. Inhalte ohne HTML-Struktur, Überschriften oder schema.org-Markup sind für KI schwerer zu parsen und zu extrahieren. Problem: Ein Absatz ohne Überschrift, semantisches HTML und Schema-Markup wird als generischer Text behandelt, nicht als eigenständige Antwort. Lösung: Semantisches HTML5 nutzen, Überschriftenhierarchie einhalten und schema.org-Markup für den Inhaltstyp ergänzen.

Fehler 6: Zu kurze oder zu lange Antworten. Chunks unter 150 Tokens bieten zu wenig Kontext; Chunks über 700 Tokens werden gekürzt. Problem: Eine 100-Wörter-Antwort hat keine Belege; eine 1000-Wörter-Antwort wird über mehrere Extraktionen gesplittet. Lösung: 256–512 Tokens (2–4 Absätze) anstreben; Aussage, Beleg und Schluss in diesem Bereich unterbringen.

Entitätenkonsistenz – identische Terminologie für dasselbe Konzept im gesamten Inhalt – erhöht die KI-Zitierwahrscheinlichkeit, da sie Fachkenntnis signalisiert. Wenn Sie „Antwortdichte“ in einem Abschnitt definieren, verwenden Sie diesen Begriff durchgehend, statt zu „Informationsdichte“ oder „Inhaltsdichte“ zu wechseln. KI erkennt Entitätenkonsistenz als Expertise-Signal und zitiert Inhalte mit präziser, konsistenter Terminologie eher. Dies gilt für Produktnamen, Methodiknamen und technische Begriffe – Konsistenz stärkt das Zitationsvertrauen.

Fremdzitate und eigene Forschung erhöhen die Zitierhäufigkeit deutlich. Inhalte, die andere Autoritäten (mit korrekter Quellenangabe) zitieren, signalisieren Glaubwürdigkeit, und eigene Forschung oder proprietäre Daten machen Ihre Inhalte einzigartig zitierbar. Wenn Sie Statistiken aus eigenen Studien oder Kunden-Cases einbringen, erkennt KI dies als originären Insight, der anderswo nicht verfügbar ist. Organisationen mit eigener Forschung erzielen 3–4 mal mehr Zitate als reine Zusammenfassungen. Strategie: Führen Sie eigene Studien in Ihrer Branche durch, publizieren Sie die Ergebnisse mit Methodik und referenzieren Sie diese in Ihren Meta-Antworten.

Aktualitätssignale – Veröffentlichungsdaten, Aktualisierungsdaten und Hinweise auf aktuelle Ereignisse – helfen KI-Systemen, die Frische von Inhalten zu erkennen. Inhalte, die in den letzten 30 Tagen aktualisiert wurden, werden für Zitationen priorisiert, besonders bei sich schnell ändernden Themen. Fügen Sie Veröffentlichungsdaten ins schema.org-Markup und Aktualisierungsstempel bei jeder Überarbeitung ein. Strategie: Legen Sie einen regelmäßigen Content-Refresh fest; aktualisieren Sie Top-Inhalte alle 30–60 Tage mit neuen Statistiken, Beispielen oder erweiterten Erklärungen.

E-E-A-T-Signale (Experience, Expertise, Autorität, Vertrauenswürdigkeit) beeinflussen KI-Zitationsentscheidungen. Inhalte von anerkannten Experten, auf autoritativen Domains und mit Fachnachweis werden öfter zitiert. Integrieren Sie Autorenprofile mit Qualifikationen, publizieren Sie auf etablierten Domains und bauen Sie Backlinks von Branchenquellen auf. Strategie: Präsentieren Sie Expertenautoren, ergänzen Sie Qualifikationen in den Autorenbios und streben Sie Verlinkungen von anerkannten Fachpublikationen an.

Generative Brand Density – das Verhältnis von markenspezifischen Insights zu generischen Informationen – entscheidet, ob KI Sie oder Wettbewerber zitiert. Inhalte mit eigenen Frameworks, Methoden oder markenspezifischen Ansätzen werden häufiger zitiert, da sie einzigartig und nachvollziehbar sind. Generische Inhalte zu „Best Practices“ werden seltener zitiert als Inhalte zum „AmICited Citation Optimization Framework“. Organisationen mit hoher generativer Marken-Dichte erzielen 2–3 mal mehr Zitate als solche mit generischem Content. Strategie: Entwickeln Sie eigene Frameworks, Methoden oder Begriffe; verwenden Sie diese konsistent in Ihren Inhalten; machen Sie sie zum Kern Ihrer Meta-Antworten.

LLM-Meta-Antworten sind speziell für die KI-Extraktion und Zitation konzipiert, während Featured Snippets für die Anzeige in Googles Suchergebnissen optimiert sind. Meta-Antworten legen Wert auf eigenständige Vollständigkeit und semantische Kohärenz, wohingegen Featured Snippets auf Kürze und Keyword-Übereinstimmung fokussieren. Beide können in Ihren Inhalten koexistieren, aber Meta-Antworten erfordern eine andere strukturelle Optimierung.

Die optimale Länge liegt bei 256–512 Tokens, was ungefähr 2–4 gut strukturierten Absätzen bzw. 200–400 Wörtern entspricht. Dieser Bereich sorgt für ausreichend Kontext für eine sichere KI-Extraktion und verhindert Trunkierung. Kürzere Antworten bieten zu wenig Kontext; längere Antworten zwingen KI-Systeme zu Zusammenfassungen oder Splittung auf mehrere Extraktionen.

Ja, aber es erfordert eine Umstrukturierung. Prüfen Sie bestehende Inhalte auf Antwort-zuerst-Formatierung, semantische Kohärenz und eigenständige Vollständigkeit. Die meisten Inhalte können angepasst werden, indem Sie zentrale Insights an den Anfang stellen, Querverweise entfernen und sicherstellen, dass jeder Abschnitt eine vollständige Frage beantwortet, ohne externen Kontext zu benötigen.

Aktualisieren Sie leistungsstarke Inhalte alle 30–60 Tage mit neuen Statistiken, aktuellen Beispielen oder erweiterten Erklärungen. KI-Systeme bevorzugen Inhalte, die innerhalb der letzten 30 Tage aktualisiert wurden, insbesondere bei Themenbereichen, in denen sich Informationen häufig ändern. Fügen Sie Veröffentlichungsdaten und Update-Timestamps in Ihr schema.org-Markup ein.

Die Antwortdichte korreliert direkt mit der Zitierhäufigkeit. Inhalte mit einer Antwortdichte über 70 % erhalten durchschnittlich 4,2 Zitate pro Monat in KI-Ausgaben, im Vergleich zu 1,1 Zitaten bei Inhalten unter 40 % Dichte. Hochdichte Inhalte liefern umsetzbare Informationen ohne Füllwörter und sind daher für KI-Systeme wertvoller zu zitieren.

Nutzen Sie Zitationsüberwachungsplattformen wie AmICited.com, die Zitate über ChatGPT, Claude, Gemini und andere große LLMs hinweg verfolgen. Führen Sie manuelle Tests durch, indem Sie Ihre Ziel-Fragen an KI-Systeme stellen und dokumentieren, welche Quellen zitiert werden. Messen Sie die Basis-Zitierfrequenz, implementieren Sie Optimierungen und verfolgen Sie Veränderungen über 30–60 Tage.

Die Kernstruktur der Meta-Antwort bleibt plattformübergreifend konsistent, aber Sie können für plattformspezifische Präferenzen optimieren. ChatGPT bevorzugt umfassende, gut belegte Inhalte. Perplexity legt Wert auf aktuelle Informationen und klare Zitate. Google AI Overviews priorisiert strukturierte Daten und E-E-A-T-Signale. Testen Sie Varianten und überwachen Sie die Zitierleistung über verschiedene Plattformen hinweg.

AmICited bietet Echtzeitüberwachung Ihrer Inhaltszitate auf allen großen KI-Plattformen, zeigt genau, wo Ihre Meta-Antworten erscheinen, wie sie verwendet werden und den Wettbewerbs-Zitationsanteil. Die Plattform offenbart den Zitationskontext – ob Inhalte direkt zitiert, umformuliert oder als unterstützende Evidenz genutzt werden – und ermöglicht datengetriebene Optimierungsentscheidungen.

Sehen Sie genau, wo Ihre Inhalte von ChatGPT, Perplexity, Google AI Overviews und anderen KI-Systemen zitiert werden. Verfolgen Sie Zitationstrends, beobachten Sie Wettbewerber und optimieren Sie Ihre Content-Strategie mit AmICited.

Erfahren Sie, was LLM Meta-Antworten sind und wie Sie Ihre Inhalte für eine bessere Sichtbarkeit in KI-generierten Antworten von ChatGPT, Perplexity und Google ...

Erfahren Sie, wie Sie LLM-Quellseiten für strategische Backlinks identifizieren und gezielt ansprechen. Entdecken Sie, welche KI-Plattformen Quellen am häufigst...

Erfahren Sie, was Antwortvarianten sind und wie Sie Ihre Inhalte mit mehreren Formulierungen optimieren, um Zitate in KI-Systemen wie ChatGPT, Perplexity und Go...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.