E-E-A-T und KI-Suche: Warum die Markenautorität wichtiger ist denn je

Verstehen Sie E-E-A-T (Erfahrung, Expertise, Autorität, Vertrauenswürdigkeit) und warum es für die Sichtbarkeit in KI-Suchmaschinen wie ChatGPT, Perplexity und ...

Erfahren Sie, wie E-E-A-T-Signale LLM-Zitationen und KI-Sichtbarkeit beeinflussen. Lernen Sie, wie Erfahrung, Fachwissen, Autorität und Vertrauen die Auffindbarkeit von Inhalten in KI-gestützter Suche prägen.

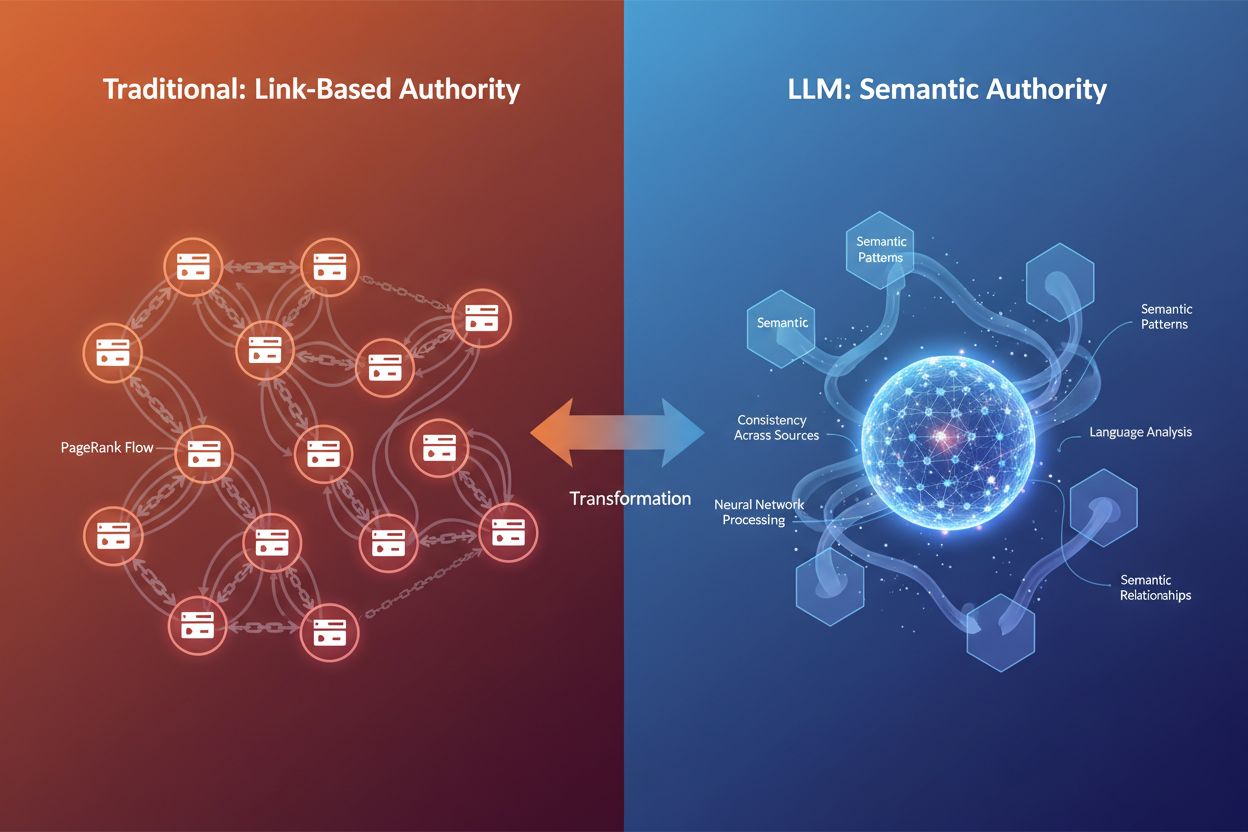

Die digitale Landschaft verändert sich grundlegend. Jahrzehntelang waren Backlinks das wichtigste Autoritätsmerkmal – je mehr hochwertige Links auf Ihre Seite verwiesen, desto autoritativer stuften Suchmaschinen Sie ein. Doch mit der Verbreitung großer Sprachmodelle (LLMs) wie ChatGPT, Claude und Gemini, die die Informationssuche und -bewertung neu gestalten, entwickelt sich auch das Autoritätsverständnis weiter. E-E-A-T – Erfahrung, Fachwissen, Autorität und Vertrauen – hat sich von einem sekundären SEO-Faktor zu einem grundlegenden Rahmen entwickelt, der die Sichtbarkeit sowohl in der klassischen Suche als auch auf KI-basierten Plattformen bestimmt. Entscheidend ist: Backlinks sind nicht mehr das einzige Autoritätsmerkmal, das darüber entscheidet, ob Ihre Inhalte von KI-Systemen zitiert werden. Stattdessen bewerten LLMs Autorität anhand semantischer Vielfalt, Konsistenz über verschiedene Quellen und der Tiefe des in Ihren Inhalten vermittelten Wissens. Dieser Wandel ist für Marken, die Sichtbarkeit in KI-Zitationssystemen wie Google AI Overviews, Perplexity und ChatGPT aufbauen wollen, von großer Bedeutung. Wenn AmICited analysiert, wie KI Ihre Marke auf diesen Plattformen erwähnt, werden Signale erfasst, die weit über das traditionelle Linkprofil hinausgehen. Die Frage lautet nicht mehr nur „Wer verlinkt auf Sie?“, sondern „Zeigen Ihre Inhalte echtes Fachwissen, und kann die KI ihnen so weit vertrauen, dass sie sie zitiert?“ Diese Unterscheidung zu verstehen ist für jeden, der Autorität im KI-getriebenen Suchumfeld aufbauen will, essenziell.

E-E-A-T steht für vier miteinander verbundene Dimensionen der Inhaltsglaubwürdigkeit, die jeweils eine besondere Rolle dabei spielen, wie sowohl Google als auch LLMs bewerten, ob Ihre Inhalte Sichtbarkeit verdienen. Schauen wir uns jede Säule im Kontext von KI-Zitationen genauer an:

Erfahrung bedeutet, dass Sie tatsächlich das gemacht haben, worüber Sie schreiben. Eine Produktbewertung von jemandem, der das Produkt sechs Monate lang genutzt hat, wiegt mehr als eine allgemeine Übersicht. Im KI-Zeitalter erkennen LLMs Erfahrungsinhalte durch Sprachmuster, die praktische Beteiligung signalisieren – spezifische Details, reale Beobachtungen und kontextuelle Nuancen, die nur jemand mit direkter Erfahrung einbringen kann.

Fachwissen ist nachweisbares Wissen, belegt durch Qualifikationen, Ausbildung oder nachgewiesene Erfahrung. Ein Finanzberater mit CFA-Zertifizierung, der über Anlagestrategien schreibt, genießt mehr Autorität als ein Lifestyle-Blogger, der sich im Finanzbereich versucht. Für LLMs zeigt sich Fachwissen durch konsequente Nutzung technischer Begriffe, logische Tiefe der Erklärung und die Fähigkeit, komplexe Unterthemen präzise zu behandeln.

Autorität entsteht durch externe Anerkennung – andere vertrauenswürdige Quellen zitieren Sie, verlinken auf Sie oder nennen Sie als Anlaufstelle. Traditionell wurde dies durch Backlinks gemessen. Im LLM-Kontext wird Autorität jedoch zunehmend durch den semantischen Fußabdruck gemessen – also wie häufig Ihre Marke oder Ihr Name im Zusammenhang mit Ihrem Thema in verschiedenen Quellen und Plattformen auftaucht.

Vertrauen ist das verbindende Element. Ohne Vertrauen brechen die anderen drei Säulen zusammen. Vertrauen entsteht durch Transparenz (klare Autorenschaft, Kontaktmöglichkeiten), Genauigkeit (faktische Inhalte mit korrekten Quellenangaben) und Sicherheit (HTTPS, professionelle Website-Infrastruktur). Google betont explizit, dass Vertrauen das wichtigste Mitglied der E-E-A-T-Familie ist, und LLMs gewichten Konsistenz und Zuverlässigkeit ebenso stark bei der Auswahl von Zitaten.

| Signal | Traditionelle SEO-Bewertung | LLM-Zitationsbewertung |

|---|---|---|

| Erfahrung | Autorenprofil, persönliche Anekdoten | Sprachmuster, die praktische Erfahrung anzeigen |

| Fachwissen | Qualifikationen, Backlinks von Autoritätsseiten | Semantische Tiefe, Fachterminologie, thematische Abdeckung |

| Autorität | Backlink-Profil, Domain-Autorität | Entity-Erkennung, plattformübergreifende Erwähnungen, semantische Autorität |

| Vertrauen | HTTPS, Seitenstruktur, Nutzerbewertungen | Konsistenz über Quellen, Faktenprüfung, Klarheit |

Der entscheidende Unterschied: Während die klassische SEO auf strukturelle Signale (Links, Domain-Metriken) setzt, bewerten LLMs E-E-A-T durch semantische und kontextuelle Analyse. So kann Ihre Seite Autorität aufbauen, ohne große Linkbuilding-Kampagnen – wenn echtes Fachwissen und Konsistenz erkennbar sind.

Große Sprachmodelle denken nicht wie klassische Suchmaschinen. Sie durchsuchen nicht das Web nach Backlinks oder prüfen Domain-Autoritätswerte. Sie funktionieren vielmehr als Wahrscheinlichkeitsmaschinen, die Muster in Sprache, Kontext und Informationskonsistenz erkennen. Wenn ein LLM entscheidet, ob es Ihre Inhalte zitiert, stellt es grundlegend andere Fragen als Googles Ranking-Algorithmus.

Mustererkennung statt struktureller Signale: Klassische Suchmaschinen prüfen Autorität durch externe Validierung – wer verlinkt auf Sie? LLMs hingegen erkennen Autorität sprachlich. Sie analysieren, ob Ihr Text Fachwissen durch korrekte Terminologie, logische Struktur, selbstbewussten Ton und die Fähigkeit, nuancierte Aspekte eines Themas zu behandeln, vermittelt. Eine Seite über Herzkrankheiten, die natürlich verwandte Begriffe wie „Cholesterin“, „Arterienverkalkung“ und „kardiovaskuläre Risikofaktoren“ einbindet, signalisiert einem LLM semantische Autorität – auch ganz ohne Backlink.

Semantische Relevanz und thematische Tiefe: LLMs bevorzugen Inhalte, die ein Thema umfassend aus verschiedenen Blickwinkeln behandeln. Wenn Sie einer KI eine Frage stellen, zerlegt das System Ihren Prompt in mehrere Suchanfragen („query fan-out“) und sucht dann nach Inhalten, die zu diesen erweiterten Anfragen passen. Inhalte, die ein Thema ganzheitlich abdecken – Unterthemen, Anschlussfragen, Kontext –, werden häufiger zitiert. Deshalb ist semantische Vielfalt heute eine neue Form der Autorität.

Konsistenz über Quellen: LLMs überprüfen Informationen in Millionen Dokumenten. Wenn Ihre Inhalte dem etablierten Konsens entsprechen und gleichzeitig eigene Erkenntnisse liefern, gelten sie als besonders autoritativ. Widersprechen Ihre Inhalte dagegen belegten Fakten ohne Beweis, kann KI sie als unzuverlässig abwerten. Das heißt: Sie können neue Ideen einbringen, sie müssen aber auf überprüfbaren Informationen basieren.

Wichtige Unterschiede bei der Autoritätsbewertung:

Das Fazit: LLMs erkennen Autorität über Bedeutung, nicht über Metriken. Das verändert grundlegend, wie Sie Inhalte für KI-Sichtbarkeit optimieren sollten.

Eine der auffälligsten Erkenntnisse aus der aktuellen Forschung zum Zitationsverhalten von LLMs ist die starke Aktualitätspräferenz auf allen großen Plattformen. Bei der Analyse von 90.000 Zitationen aus ChatGPT, Gemini und Perplexity mit aktiviertem Webzugriff zeigt sich: Die meisten zitierten URLs wurden wenige hundert Tage vor der LLM-Antwort veröffentlicht. Das ist kein Zufall – sondern so gewollt. LLMs sind darauf trainiert, dass aktuelle Inhalte oft mit Relevanz und Qualität einhergehen, vor allem bei zeitkritischen Themen.

Warum Frische im RAG-Retrieval zählt: Wenn LLMs Retrieval-Augmented Generation (RAG) benutzen – also das Web in Echtzeit durchsuchen, um Antworten zu belegen –, stellt das System die Frage: „Was ist die aktuellste, relevante Information?“ Aktualität steht hier für Zuverlässigkeit. Wer nach aktuellen Ereignissen, Markttrends oder neuen Forschungsergebnissen fragt, dem ist ein Artikel vom letzten Monat automatisch vertrauenswürdiger als einer von vor fünf Jahren. Ein Vorteil für Content-Creator, die ihre Seiten regelmäßig pflegen und aktualisieren.

Plattformspezifische Frische-Muster: Studien zeigen: Gemini bevorzugt frische Inhalte am stärksten, mit den meisten Zitaten aus Seiten, die in den letzten 0–300 Tagen veröffentlicht wurden. Perplexity liegt im Mittelfeld und zitiert einen ausgewogenen Mix aus frischen und etwas älteren Inhalten. OpenAI zeigt die größte Bandbreite im Alter der Quellen, holt aber auch viele aktuelle Inhalte. Ihre Optimierungsstrategie sollte also berücksichtigen, welche KI-Plattformen Ihre Zielgruppe nutzt.

Zeitkritische Themen brauchen aktive Updates: Für YMYL-Themen (Your Money or Your Life – Gesundheit, Finanzen, Recht) und dynamische Branchen ist Aktualität Pflicht. Ein Artikel zu Krypto-Regulierung aus 2021 wird 2025 kaum noch zitiert. Die Lösung: Systematische Pflege – Statistiken jährlich (in schnellen Branchen quartalsweise) aktualisieren, „zuletzt aktualisiert“-Angaben prominent platzieren und wichtige Datenpunkte bei neuen Entwicklungen anpassen. Das signalisiert KI und Menschen, dass Ihre Inhalte aktuell und vertrauenswürdig sind.

Die Daten zur Aktualitätspräferenz: Die Analyse von 21.412 URLs mit auslesbarem Veröffentlichungsdatum zeigt: Auf allen drei großen LLM-Plattformen erreichen Zitierungen ihren Höhepunkt bei Inhalten, die 0–300 Tage alt sind, und nehmen dann langsam ab. Sprich: Das erste Jahr eines Inhalts ist für die KI-Sichtbarkeit besonders entscheidend. Inhalte, die älter als drei Jahre sind, werden deutlich weniger zitiert, außer sie decken zeitlose Themen ab oder wurden kürzlich aktualisiert.

Auch wenn LLMs keine Domain-Autoritätswerte direkt prüfen, gibt es einen klaren Zusammenhang zwischen hoher Domain-Autorität und Zitierhäufigkeit. Die Analyse der 1.000 am häufigsten von ChatGPT zitierten Websites zeigt eindeutig: KI bevorzugt Seiten mit Domain Rating (DR) über 60, die meisten Zitate stammen von Domains mit DR 80–100. Das liegt aber eher indirekt daran, dass hochbewertete Seiten besser ranken und LLMs diese bei der Websuche öfter antreffen.

Der indirekte Autoritätseffekt: Die Beziehung zwischen Domain-Autorität und LLM-Zitationen funktioniert so: LLMs nutzen Suchsysteme, um Inhalte zu finden. Hochautoritative Seiten ranken dort besser. Deshalb erscheinen sie auch häufiger in den LLM-Ergebnissen. Es ist nicht so, dass LLMs Ihr Domain-Rating auslesen – vielmehr korreliert Autorität mit Suchsichtbarkeit, die wiederum mehr Zitationschancen bietet. Sprich: Klassisches SEO-Authority-Building durch hochwertige Backlinks bleibt wertvoll, auch im KI-Zeitalter.

Semantische Vielfalt als neues Autoritätssignal: Über Domain-Metriken hinaus erkennen LLMs Autorität durch semantische Vielfalt – also Tiefe und Breite der Themenabdeckung. Ein Artikel, der ein Thema umfassend behandelt, relevante Keywords natürlich einbindet, Unterthemen anspricht und Kontext liefert, signalisiert der KI Fachwissen. Zum Beispiel demonstriert ein Artikel über „Vorteile der Mittelmeerdiät“, der kulturelle Aspekte, gesundheitliche Effekte, Vergleiche mit anderen Diäten und häufige Fragen behandelt, mehr Autorität als eine generische Liste.

Beziehungen zwischen Entitäten und thematische Autorität: LLMs verwenden Entity-Recognition, um zu verstehen, wie Ihre Inhalte mit Wissensgraphen verbunden sind. Wenn Ihr Artikel über „Steve Jobs“ wiederholt auf Apple, Innovation, Führung und Produktdesign eingeht, verknüpft die KI diese Entitäten und bewertet Ihre Autorität höher. Deshalb sind strukturierte Daten und Schema-Markup so wichtig – sie helfen KI, Entitäten und Themenverbindungen besser zu erkennen.

Inhalte müssen erweiterte Anfragen abdecken: Wenn ein LLM eine Nutzeranfrage erhält, erweitert es diese oft zu mehreren verwandten Suchanfragen. Ihre Inhalte müssen also nicht nur die Hauptfrage, sondern auch deren Varianten abdecken. Fragt jemand „Woran erkennt man reife Avocados?“, sucht das LLM auch nach „Avocado-Reifezeichen“, „Wie lange reifen Avocados?“ und „Reife Avocados lagern“. Inhalte, die diese Perspektiven abdecken, werden häufiger zitiert.

Die E-E-A-T-Optimierung für LLM-Zitationen verlangt eine strategische, mehrschichtige Herangehensweise. Ziel ist es, Inhalte zu schaffen, die echtes Fachwissen zeigen und von KI-Systemen leicht erkannt und extrahiert werden. Hier ein praktischer Rahmen:

1. Qualifikationen und Fachwissen klar darstellen

Ihr Autorenprofil sollte umfassend und überprüfbar sein. Geben Sie konkrete Qualifikationen an (Zertifikate, Abschlüsse, Berufstitel), Berufserfahrung und praktische Beschäftigung mit dem Thema. Sagen Sie nicht nur „Marketing-Experte“, sondern „CMO mit 15 Jahren B2B-SaaS-Marketing-Erfahrung, unter anderem bei HubSpot und Salesforce“. Diese Präzision hilft LLMs, echtes Fachwissen zu erkennen. Ergänzen Sie jedes Content-Piece mit Autorenprofil und setzen Sie nach Möglichkeit Author-Schema-Markup ein.

2. Eigene Studien und Daten veröffentlichen

Eigene Forschung ist eines der stärksten Autoritätssignale. Wenn Sie Daten publizieren, die es nur bei Ihnen gibt – Umfragen, Benchmarks, Fallstudien – werden Sie zur Primärquelle. LLMs zitieren solche Quellen häufiger, weil sie einzigartigen Wert bieten. Die Ahrefs-Seite „How Much Does SEO Cost?“ (auf Basis einer Umfrage unter 439 Personen) wird deshalb so oft zitiert. Wichtig: Machen Sie Methodik und Stichprobengröße transparent.

3. Konsistente Autorität auf allen Plattformen

Ihre Autorität bemisst sich nicht mehr nur an Ihrer Website. LLMs analysieren auch Ihre Präsenz auf LinkedIn, in Fachmagazinen, bei Vorträgen und in Medien. Halten Sie Infos, Positionierung und Messaging überall konsistent. Wenn Ihr Name regelmäßig mit Ihrem Thema auf verschiedenen Plattformen auftaucht, stärkt das Ihre Autorität in den Augen der KI.

4. Richtiges Schema-Markup implementieren

Schema-Markup macht Ihre Expertise maschinenlesbar. Nutzen Sie Article-Schema für Veröffentlichungsdaten und Autor, FAQ-Schema für Frage-Antwort-Inhalte und Author-Schema für die Verknüpfung von Qualifikationen. Studien zeigen: 36,6 % der Suchbegriffe lösen Featured Snippets aus, die aus Schema-Markup stammen – und auch LLMs können so Inhalte besser auslesen.

5. Thematische Autorität mit Content-Clustern aufbauen

Publizieren Sie nicht einzelne Blogposts, sondern Content-Hubs, die ein Thema ganzheitlich abdecken. Verlinken Sie verwandte Artikel, behandeln Sie Unterthemen ausführlich und bauen Sie ein semantisches Netz auf, das Ihre Expertise belegt. Dieses Cluster-Modell stärkt die thematische Autorität für Suchmaschinen und LLMs.

6. Inhalte systematisch aktualisieren

Aktualität ist ein Rankingfaktor für Google und LLMs. Erstellen Sie einen Pflegeplan: Wichtige Seiten vierteljährlich prüfen, Statistiken jährlich auffrischen, „zuletzt aktualisiert“-Angabe gut sichtbar machen. So zeigen Sie: Ihre Inhalte bleiben aktuell und vertrauenswürdig.

7. Autoritative Quellen zitieren

Indem Sie andere seriöse Quellen zitieren, bauen Sie ein Vertrauensnetz auf. Verweisen Sie auf peer-reviewte Studien, Branchenreports und anerkannte Experten. Das stärkt Ihre Glaubwürdigkeit und hilft LLMs, die Zuverlässigkeit Ihrer Aussagen einzuordnen.

8. Offen über Grenzen sprechen

Echtes Fachwissen heißt auch, die eigenen Grenzen zu kennen. Wenn ein Thema außerhalb Ihres Fachgebiets liegt, sagen Sie das. Wenn Ihre Daten Einschränkungen haben, machen Sie das transparent. Diese Ehrlichkeit schafft Vertrauen – für Leser und KI-Systeme, die Ehrlichkeit und Differenzierung erkennen und schätzen.

E-E-A-T in der Theorie zu verstehen ist das eine; zu sehen, wie es praktisch funktioniert, das andere. Schauen wir uns an, warum bestimmte Inhalte besonders zitierfähig sind – und wie diese Prinzipien im Alltag wirken.

Das Muster zitierfähiger Inhalte: Die Ahrefs-Seite „How Much Does SEO Cost?“ ist ein Paradebeispiel für E-E-A-T-Optimierung für LLM-Zitationen. Sie beantwortet eine häufige, klare Frage direkt. Sie basiert auf eigener Forschung (439 Befragte), hat einen klaren Zeitstempel, differenziert Preise nach mehreren Kriterien (Freelancer vs. Agentur, Stunden- vs. Pauschalhonorar, Regionen). Die Inhalte sind scanbar mit klaren Überschriften, enthalten Datenvisualisierungen mit erklärendem Text und beleuchten das Thema aus verschiedenen Blickwinkeln. Der Autorenname zeigt relevante Qualifikationen und die Inhalte wurden gegengeprüft – ein zusätzliches Vertrauensmerkmal.

Was Inhalte zitierfähig macht: Typisch zitierfähige Inhalte teilen diese Eigenschaften: Sie beantworten konkrete Fragen knapp und ohne Fülltext, basieren auf überprüfbaren Daten oder Forschung, sind klar strukturiert und leicht extrahierbar, beleuchten ein Thema aus mehreren Perspektiven und zeigen durch Tiefe und Nuancen echtes Fachwissen. LLMs prüfen bei Zitationsauswahl: „Kann ich hier eine präzise, korrekte Antwort entnehmen? Ist die Quelle vertrauenswürdig? Gibt es einen einzigartigen Mehrwert?“

Strukturierte Formatierung als Zitationssignal: Inhalte mit klaren Überschriften, Bulletpoints, Tabellen und kurzen Absätzen werden häufiger zitiert. Das dient nicht nur der Lesbarkeit für Menschen, sondern der Extrahierbarkeit für KI. Erkennt das LLM die Kerninfos durch Struktur, steigt die Zitationswahrscheinlichkeit. Im Vergleich: Ein Textblock vs. ein klar gegliederter Artikel mit H2, H3 und Listen – die strukturierte Version wird deutlich öfter zitiert.

Themen aus mehreren Blickwinkeln abdecken: Wer ein Thema aus verschiedenen Perspektiven beleuchtet, erhöht die Zitationschancen. Ein Beitrag zu „Produktivität im Homeoffice“ kann Produktivität für unterschiedliche Rollen (Entwickler, Manager, Support), Zeitzonen, Wohnsituationen und Persönlichkeitstypen behandeln. So kann ein Artikel Dutzende verwandte Nutzerfragen beantworten – und die Zitationschance steigt massiv.

Zitationsmuster aus der Praxis: Studien von SearchAtlas mit 90.000 Zitaten in großen LLMs zeigen: Häufig zitierte Inhalte stammen meist von Seiten mit starker Domain-Autorität, aber auch von Nischenexperten mit tiefem Fachwissen. Reddit-Antworten und Substack-Artikel werden trotz schwacher Backlink-Profile oft zitiert, wenn sie authentisches Expertenwissen und klare Sprache bieten. Das beweist: Autorität entsteht zunehmend durch nachgewiesenes Wissen, nicht nur durch Link-Metriken.

E-E-A-T aufzubauen ist das eine, die Wirkung zu messen das andere. Klassische SEO-Kennzahlen wie Keyword-Rankings und Backlinks erfassen Ihre KI-Sichtbarkeit nur unvollständig. Sie brauchen neue Tools und Metriken, die für das KI-Zeitalter gemacht sind.

Manuelle Tests auf KI-Plattformen: Beginnen Sie mit eigenen Tests. Erstellen Sie eine Liste mit 10–20 Fragen, die Ihre Inhalte beantworten sollten, und testen Sie diese monatlich in ChatGPT, Perplexity, Claude und Gemini. Dokumentieren Sie, welche Quellen (Ihre und die der Konkurrenz) zitiert werden, verfolgen Sie Veränderungen und erkennen Sie Muster. Das kostet Zeit, liefert aber echte Einblicke. Nutzen Sie eine einfache Google-Tabelle zur Auswertung.

Analytics-Tracking für KI-Traffic: Die meisten Analytics-Tools weisen KI-Suchtraffic inzwischen separat aus. In Ahrefs Web Analytics (kostenlos in den Webmaster Tools) sehen Sie, welche Seiten KI-Traffic erhalten und wie sich dieser verhält. Wichtige Kennzahlen: Verweildauer, Absprungrate, Scrolltiefe, Conversionrate. Zwar macht KI-Traffic aktuell weniger als 1 % des Gesamttraffics aus, aber die Besucher zeigen oft höhere Absicht und Abschlussraten als klassischer Suchtraffic.

E-E-A-T-Effektivität messen: Statt direkter E-E-A-T-Scores beobachten Sie Proxy-Metriken: AI Overview-Zitationen (über Tools wie BrightEdge oder Authoritas), Suchvolumen Ihrer Marke, Erwähnungen in der Branche und Ranking-Stabilität bei Updates. Inhalte mit starken E-E-A-T-Signalen sind bei Core-Updates oft weniger volatil. Mit Tools wie dem LLM SEO E-E-A-T Score Checker erhalten Sie sogar eine direkte E-E-A-T-Bewertung nach Kategorien.

Monitoring im großen Stil: Für umfassendes Monitoring ohne manuellen Aufwand gibt es Tools wie Ahrefs Brand Radar – es überwacht Zitationen über 150 Millionen Prompts auf sechs großen KI-Plattformen. Sie sehen, wann und wo Sie zitiert werden, können nach Plattform und Thema filtern, Trends verfolgen und Wettbewerber vergleichen. So erkennen Sie Ihre KI-Sichtbarkeit und entdecken Chancen und Lücken.

Wichtige Kennzahlen: Überwachen Sie Zitationshäufigkeit (wie oft Sie zitiert werden), Zitationsvielfalt (über welche Themen und Plattformen), semantische Relevanz (wie gut passen die zitierten Inhalte zur Suchanfrage), Aktualität (Durchschnittsalter der Zitate) und Domain-Überschneidung (welche Wettbewerber werden zusammen mit Ihnen zitiert). Diese Werte spiegeln Ihre E-E-A-T-Wirkung im KI-Kontext wider.

Mit der wachsenden Bedeutung von E-E-A-T und LLM-Optimierung kursieren auch einige Missverständnisse. Hier die häufigsten Mythen im Faktencheck:

Mythos: „Backlinks sind tot“

Fakt: Backlinks bleiben wichtige Autoritätssignale, besonders für Google. Aber: Ihre relative Bedeutung sinkt. Sie sind nicht mehr die einzige Währung im SEO. Hochautoritative Seiten werden von LLMs weiterhin häufiger zitiert, vor allem weil sie besser ranken (LLMs recherchieren über Suchergebnisse). Die zentrale Erkenntnis: Backlinks sind weiterhin relevant, aber nur ein Puzzleteil – semantische Autorität, Aktualität und Fachwissen sind genauso wichtig.

Mythos: „E-E-A-T ist ein direkter Rankingfaktor“

Fakt: E-E-A-T ist kein direkter Rankingfaktor wie Keywords oder Ladezeit. Es ist vielmehr ein Rahmen, den Google über Quality Rater für die Algorithmusentwicklung nutzt. Die Optimierung für E-E-A-T bedeutet, zuerst für Menschen zu optimieren – also wirklich autoritative, vertrauenswürdige Inhalte zu schaffen. Die Rankingvorteile entstehen indirekt durch höhere Zufriedenheit und geringere Absprungraten.

Mythos: „KI erkennt Fake-Autorität langfristig immer“

Fakt: Das stimmt nur teilweise. LLMs lassen sich kurzfristig von Inhalten täuschen, die „autoritativ klingen“. Content-Farmen können mit gezielter Wortwahl und Struktur überzeugen. Doch echte Autorität überlebt die menschliche Prüfung, und je besser KI wird, desto besser erkennt sie echte Expertise. Besser: Bauen Sie echte Autorität auf, statt das System zu überlisten.

Mythos: „Für LLM-Zitationen braucht man riesige Backlinks“

Fakt: Hochautoritative Seiten werden häufiger zitiert, doch auch Nischenexperten mit wenigen Backlinks erscheinen regelmäßig in LLM-Zitationen. Entscheidend ist, echtes Fachwissen im eigenen Bereich zu zeigen. Ein spezialisierter Blog mit Tiefgang kann eine allgemeine Seite mit mehr Backlinks bei Nischenthemen übertreffen. Es zählen semantische Autorität und thematische Tiefe.

Mythos: „LLMs zitieren nur die Top-10-Suchergebnisse“

Fakt: Zwar stammen 52 % der AI Overview-Quellen aus den Top 10 der Suchergebnisse, aber auch außerhalb der Top 10 wird zitiert. Qualität und Vielfalt sind entscheidend. Ist Ihr Inhalt besonders relevant und autoritativ, wird er auch außerhalb der Top 10 zitiert – insbesondere, wenn er erweiterte Suchvarianten abdeckt oder einzigartigen Mehrwert bietet.

Die Definition von Autorität verändert sich in Echtzeit. Wer die Entwicklung versteht, kann wirksame Strategien für morgen aufbauen.

Vom Link- zum Bedeutungsranking: Die Zukunft der Autorität bewegt sich weg von „wer verlinkt auf Sie?“ hin zu „was bedeuten Ihre Inhalte?“. Dieser Wandel von strukturellen zu semantischen Signalen ist grundlegend. Klassisches SEO baute Autorität über Linkbuilding. Im KI-Zeitalter entsteht Autorität durch Fachwissen, semantische Vielfalt und konsistente Positionierung über Plattformen hinweg. Wer jetzt handelt, sichert sich frühzeitig einen Platz als Autorität.

Engagement-Metriken als Autoritätssignale: KI-Systeme werden immer besser darin, Nutzersignale als Autoritätssignale zu nutzen. Wie lange verweilen Nutzer auf Ihrer Seite? Kommen sie zurück? Teilen sie Inhalte? Solche Verhaltensdaten zeigen echten Mehrwert. Nutzererfahrung und Inhaltsqualität werden so zu direkten Autoritätsfaktoren, nicht nur zu indirekten Rankingsignalen.

Plattformübergreifende Konsistenz als Basis: Autorität ist nicht mehr auf Ihre Website beschränkt. Ihre Präsenz auf LinkedIn, in Fachjournalen, bei Vorträgen und in Medien zählt ebenfalls. KI erkennt, wenn Ihr Name, Ihre Marke oder Expertise konsistent mit Ihrem Thema verbunden werden. Das führt zu einem Verstärkungseffekt: Jede Erwähnung erhöht Ihre Autorität und steigert die Chance auf weitere Zitate.

Der Vorsprung durch frühe Investition in Autorität: Marken und Creator, die jetzt in E-E-A-T investieren, sichern sich einen Wissensvorsprung, bevor der Markt überfüllt ist. In zwei Jahren, wenn alle um KI-Sichtbarkeit kämpfen, sind die Pioniere bereits fest etabliert – wie in den frühen SEO-Jahren. Das Fenster für den Aufbau von Autorität in der KI-Suche ist noch offen, aber es schließt sich.

Vorbereitung auf die nächste Entwicklung: Mit der Weiterentwicklung der LLMs werden Autoritätssignale immer ausgefeilter. Wahrscheinlich gewinnen Echtzeit-Verifizierung, Konsens über mehrere Quellen und Nutzermetriken an Gewicht. Marken, die echte Expertise, Transparenz und Vertrauen pflegen, sind für alle künftigen Entwicklungen am besten gerüstet. Das Grundprinzip bleibt: Echtes Fachwissen und Vertrauen sind das Fundament von Autorität – im klassischen wie im KI-getriebenen Suchumfeld.

E-E-A-T steht für Erfahrung, Fachwissen, Autorität und Vertrauen. Es ist ein Rahmenwerk, das die Glaubwürdigkeit von Inhalten sowohl für die traditionelle Suche als auch für KI-Systeme bestimmt. LLMs nutzen E-E-A-T-Signale, um zu entscheiden, welche Quellen sie in ihren Antworten zitieren – das ist entscheidend für Ihre KI-Sichtbarkeit.

LLMs bewerten Autorität anhand semantischer Muster, Konsistenz über verschiedene Quellen und nachgewiesenem Fachwissen statt Backlinks. Sie erkennen Autorität linguistisch durch Fachterminologie, logische Tiefe und thematische Abdeckung. Bedeutende Seiten werden weiterhin häufiger zitiert, vor allem weil sie in den Suchergebnissen besser platziert sind, die LLMs für die Recherche verwenden.

Ja. Während größere Seiten Vorteile haben, tauchen Nischenexperten mit kleinerem Backlink-Profil regelmäßig in LLM-Zitationen auf. Entscheidend ist, echtes Fachwissen im eigenen Bereich durch semantische Vielfalt, thematische Tiefe und konsistente Positionierung zu demonstrieren. Ein spezialisierter Blog mit tiefgehendem Wissen kann allgemeine Seiten mit mehr Backlinks übertreffen.

E-E-A-T ist eine langfristige Strategie. Der Aufbau echter Autoritäts- und Vertrauenssignale dauert in der Regel Monate, nicht Wochen. Die Implementierung von strukturierten Daten und Autorenzuordnung kann jedoch schnellere Effekte haben. Besonders entscheidend ist das erste Jahr eines Inhalts für die KI-Sichtbarkeit – Zitationsraten sinken nach drei Jahren deutlich, wenn Inhalte nicht aktualisiert werden.

Backlinks bleiben wertvolle Autoritätssignale, sind aber nicht mehr die einzige Währung. Hochautoritative Seiten werden von LLMs häufiger zitiert, vor allem weil sie in den Suchergebnissen besser platziert sind. Der zentrale Punkt: Backlinks sind weiterhin wichtig, aber Teil eines größeren Puzzles, das heute auch semantische Autorität, Aktualität und nachgewiesenes Fachwissen umfasst.

Verfolgen Sie die Häufigkeit von KI-Zitationen, die Themen- und Plattformvielfalt der Zitate, semantische Relevanzwerte, Aktualitätsmetriken und Domain-Überschneidungen mit Wettbewerbern. Nutzen Sie Tools wie Ahrefs Brand Radar für umfassendes Monitoring über 150 Millionen Prompts hinweg oder testen Sie monatlich Ihre Zielanfragen manuell in ChatGPT, Perplexity, Claude und Gemini.

Nein, E-E-A-T ist kein direkter Rankingfaktor. Es handelt sich um ein Rahmenwerk, das beeinflusst, wie KI-Systeme die Inhaltsqualität bewerten. Die Optimierung für E-E-A-T bedeutet, wirklich autoritative, vertrauenswürdige Inhalte für den Menschen zu schaffen. Die Vorteile entstehen indirekt durch eine bessere Nutzererfahrung und höhere Zitationsraten.

Aktualität wird bei der Auswahl von LLM-Zitationen stark gewichtet. Studien zeigen, dass LLMs Inhalte, die innerhalb von 300 Tagen veröffentlicht wurden, deutlich häufiger zitieren. Bei zeitkritischen Themen ist ein Artikel vom letzten Monat vertrauenswürdiger als einer von vor fünf Jahren. Systematische Inhaltsaktualisierungen und gut sichtbare Angaben zum letzten Update sind essenziell für die KI-Sichtbarkeit.

Verfolgen Sie, wie Ihre Marke von ChatGPT, Perplexity, Google AI Overviews und anderen LLMs zitiert wird. Verstehen Sie Ihre E-E-A-T-Signale und optimieren Sie mit AmICited Ihre KI-Sichtbarkeit.

Verstehen Sie E-E-A-T (Erfahrung, Expertise, Autorität, Vertrauenswürdigkeit) und warum es für die Sichtbarkeit in KI-Suchmaschinen wie ChatGPT, Perplexity und ...

Erfahren Sie, wie Sie Wissen aus erster Hand und Erfahrungssignale für KI-Systeme wie ChatGPT, Perplexity und Google AI Overviews demonstrieren. Optimieren Sie ...

E-E-A-T (Erfahrung, Expertise, Autorität, Vertrauenswürdigkeit) ist Googles Rahmen zur Bewertung der Inhaltsqualität. Erfahren Sie, wie sich dies auf SEO, KI-Zi...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.