Visuelle Suche und KI: Bildoptimierung für die AI-Entdeckung

Erfahren Sie, wie visuelle Suche und KI die Bildentdeckung verändern. Optimieren Sie Ihre Bilder für Google Lens, AI Overviews und multimodale LLMs, um die Sich...

Erfahren Sie, wie Google Lens die visuelle Suche mit jährlich über 100 Milliarden Suchanfragen revolutioniert. Entdecken Sie Optimierungsstrategien, damit Ihre Marke in den Ergebnissen der visuellen Entdeckung erscheint und Shopping-Traffic abfängt.

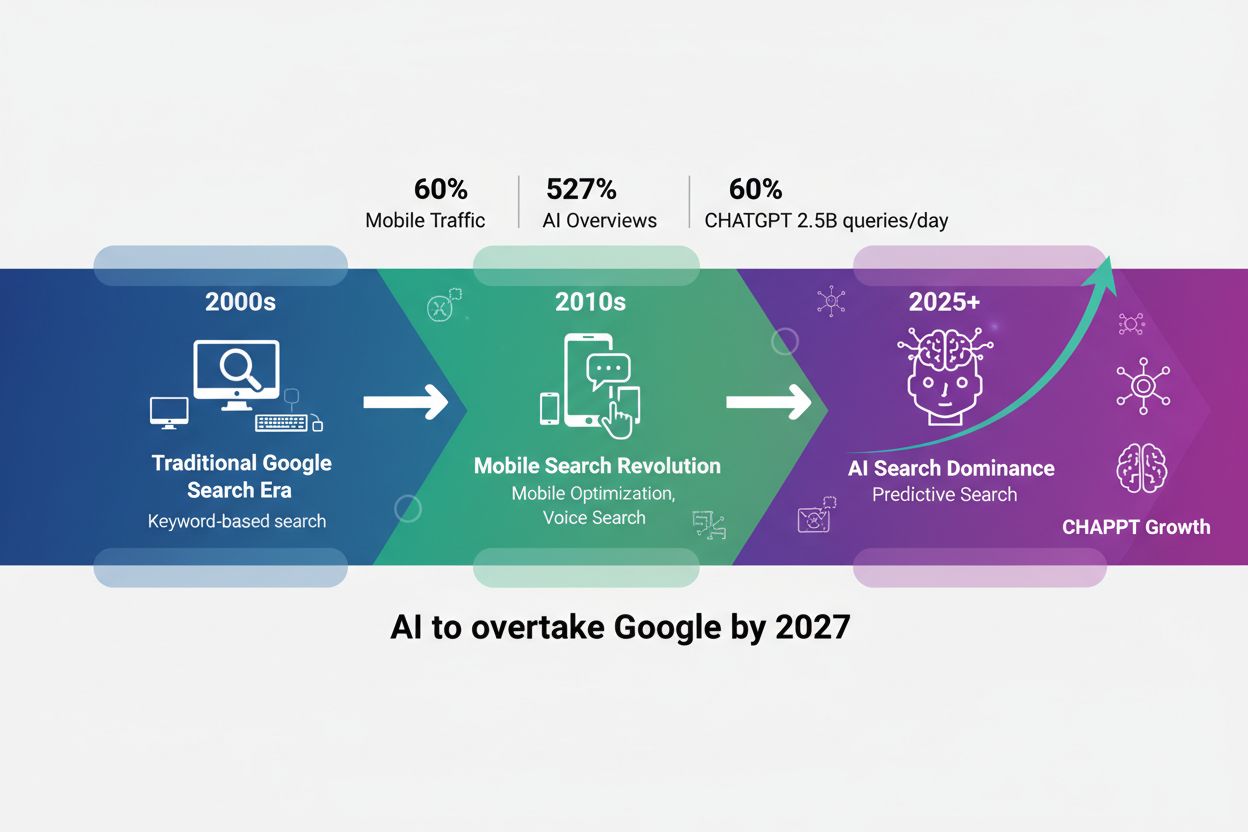

Die visuelle Suche hat die Art und Weise, wie Menschen online Informationen entdecken, grundlegend verändert – von textbasierten Suchanfragen hin zu Kamera-zentrierten Interaktionen. Google Lens, die führende Technologie von Google für visuelle Suche, ermöglicht inzwischen fast 20 Milliarden visuelle Suchanfragen pro Monat. Allein 2024 wurden über 100 Milliarden visuelle Suchen mithilfe von Lens und Circle to Search durchgeführt. Dieses explosive Wachstum spiegelt einen generellen Wandel im Nutzerverhalten wider: Immer mehr Menschen bevorzugen es, ihre Kamera auf etwas zu richten, das sie interessiert, anstatt eine Beschreibung einzutippen.

Die Reichweite der Plattform ist beeindruckend: 1,5 Milliarden Menschen nutzen Google Lens monatlich, wobei jüngere Nutzer im Alter von 18 bis 24 Jahren die höchsten Engagement-Raten zeigen. Besonders bedeutsam für Marken ist, dass jede fünfte dieser visuellen Suchen – rund 20 Milliarden Suchanfragen – mit einer direkten Kaufabsicht erfolgt. Das sind keine Anfragen aus bloßer Neugier; es handelt sich um potenzielle Kunden, die aktiv nach etwas suchen, das sie in der realen Welt gesehen haben.

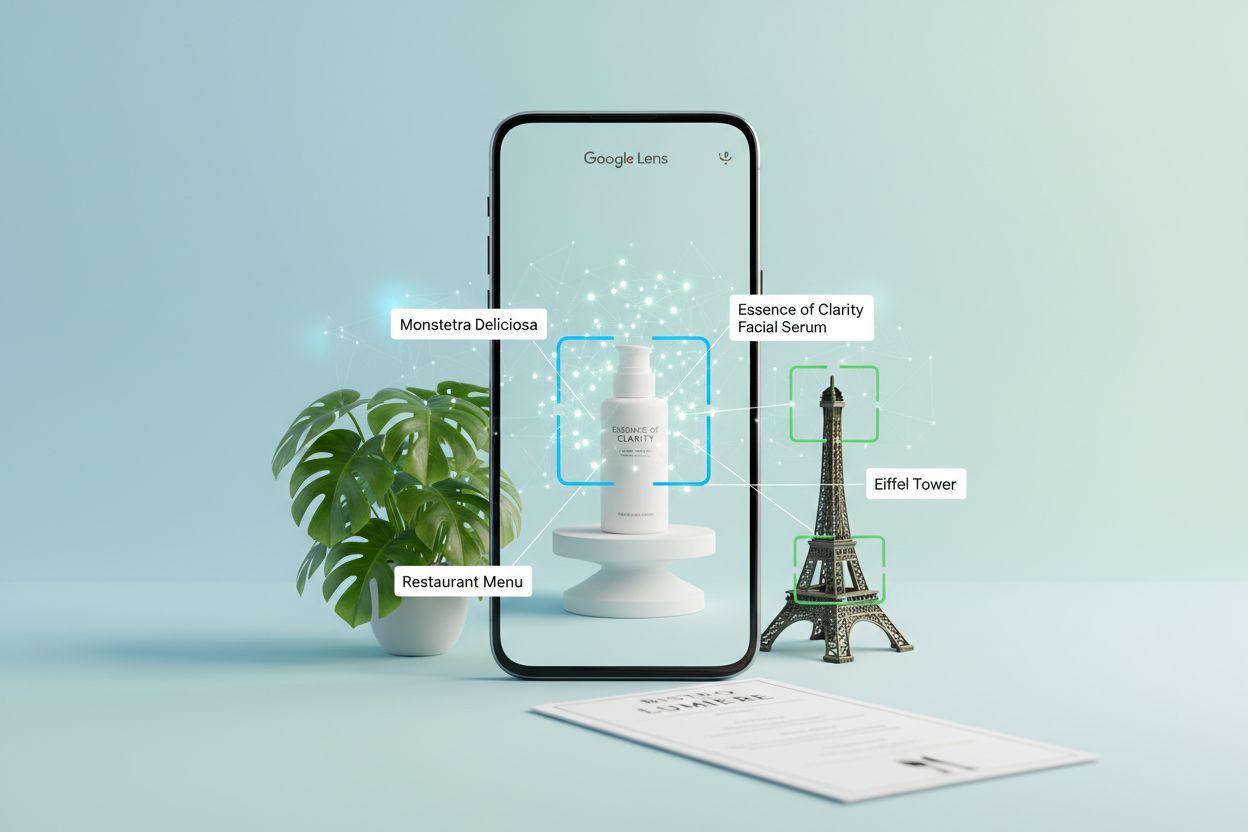

Im Kern nutzt Google Lens drei miteinander verbundene KI-Technologien, um visuelle Anfragen zu verstehen und zu beantworten. Convolutional Neural Networks (CNNs) bilden die Grundlage, indem sie Pixelmuster analysieren, um Objekte, Szenen und visuelle Zusammenhänge mit erstaunlicher Genauigkeit zu erkennen. Diese Deep-Learning-Modelle werden mit Milliarden gelabelter Bilder trainiert und können dadurch alles von Haushaltsgegenständen bis zu seltenen Pflanzenarten erkennen.

Optical Character Recognition (OCR) übernimmt die Texterkennung und -extraktion, sodass Lens Menüs, Schilder, Dokumente und handschriftliche Notizen lesen kann. Richten Sie Ihre Kamera auf eine Speisekarte in einer fremden Sprache oder ein Straßenschild, wandelt OCR den visuellen Text in digitale Daten um, die weiterverarbeitet und übersetzt werden können. Natural Language Processing (NLP) interpretiert anschließend diesen Text kontextuell und versteht nicht nur die vorhandenen Wörter, sondern auch deren Bedeutung im Zusammenhang mit Ihrer Anfrage.

Die eigentliche Stärke entsteht durch multimodale KI – die Fähigkeit, mehrere Eingabearten gleichzeitig zu verarbeiten. Sie können Ihre Kamera auf ein Produkt richten, eine Sprachfrage dazu stellen und erhalten eine KI-gestützte Antwort, die visuelles Verständnis mit Gesprächskontext kombiniert. Diese Integration schafft ein Sucherlebnis, das sich natürlich und intuitiv anfühlt.

| Merkmal | Traditionelle Textsuche | Google Lens |

|---|---|---|

| Eingabemethode | Getippte Keywords | Bild, Video oder Sprache |

| Erkennungsfähigkeit | Nur Keywords | Objekte, Text, Kontext, Beziehungen |

| Antwortgeschwindigkeit | Sekunden | Sofort |

| Kontextverständnis | Beschränkt auf Suchtext | Umfassender visueller Kontext |

| Echtzeitfähigkeit | Nein | Ja, mit Live-Kamera |

| Genauigkeit bei visuellen Inhalten | Gering (schwer zu beschreiben) | Hoch (direkte visuelle Übereinstimmung) |

Die praktischen Einsatzmöglichkeiten von Google Lens gehen weit über bloße Neugier hinaus. Beim Shopping fotografieren Nutzer Produkte, die sie im Geschäft, in sozialen Medien oder in Videos sehen, und finden sofort heraus, wo sie diese kaufen können und vergleichen Preise verschiedener Anbieter. Eine Kundin entdeckt ein Möbelstück bei Freunden, macht ein Foto davon und findet genau dieses Produkt zum Kauf – ohne den Moment zu verlassen.

Auch im Bereich Bildung ist der Nutzen groß, besonders in Entwicklungsländern. Schüler fotografieren Aufgaben aus Schulbüchern oder Unterrichtsmaterialien auf Englisch, lassen sie von Lens in ihre Muttersprache übersetzen und erhalten Hausaufgabenhilfe. So wird der Zugang zu Bildungsressourcen über Sprachbarrieren hinweg demokratisiert.

Reisen und Entdecken: Lens dient zur Identifikation von Sehenswürdigkeiten, Restaurantentdeckung und kulturellem Lernen. Touristen fotografieren unbekannte Architektur oder Schilder und erhalten sofort historische Kontexte und Informationen. Naturfreunde identifizieren Pflanzen, Tiere und Insekten bei Outdoor-Aktivitäten und verwandeln beiläufige Beobachtungen in Lernmomente.

Auch die Produktrecherche und der Vergleich sind nahtlos geworden. Jemand sieht eine Handtasche, die ihm gefällt, fotografiert sie – und Lens liefert nicht nur das exakte Produkt, sondern auch ähnliche Modelle in verschiedenen Preisklassen von Händlern in der Nähe. Diese Fähigkeit hat das Einkaufserlebnis grundlegend verändert, da sie den Weg von der Entdeckung bis zum Kauf vereinfacht.

Die Chance ist enorm: 20 Milliarden visuelle Suchen mit Kaufabsicht pro Jahr stellen einen riesigen Kanal dar, den die meisten Marken komplett ignorieren. Während Mitbewerber um Platzierungen in der AI Overview konkurrieren – einem überfüllten Raum, der von großen Publishern und etablierten Händlern dominiert wird – bleibt die visuelle Suche ein weitgehend unerschlossenes Feld, in dem es jetzt echte First-Mover-Vorteile gibt.

Marken, die für visuelle Entdeckung optimieren, verschaffen sich einen Wettbewerbsvorteil, der über traditionelle SEO hinausgeht. Wenn Ihr Produkt in den Google-Lens-Ergebnissen erscheint, konkurrieren Sie nicht mehr über Keywords oder Content-Qualität, sondern über visuelle Relevanz und Kontext. Ein Möbelhändler, dessen Produkte in Lens-Suchen nach „Nachttisch Queen Schlafzimmer“ erscheinen, erreicht Kunden genau in dem Moment, in dem sie kaufbereit sind – noch bevor sie überhaupt eine Suchmaschine aufsuchen.

Die Auswirkungen auf die Conversion sind enorm. Nutzer der visuellen Suche wissen bereits, was sie wollen – sie stöbern oder recherchieren nicht, sondern kaufen. Dieser traffic mit hoher Kaufabsicht konvertiert deutlich besser als klassischer Suchtraffic. Visuelle Suche reduziert zudem Hürden vor dem Kauf: Kunden sehen genau, wie ein Produkt im Kontext wirkt, verstehen dessen Dimensionen im Vergleich zu bekannten Objekten und treffen fundierte Kaufentscheidungen.

Auch der Timing-Vorteil ist greifbar. Die meisten Agenturen und Marken wissen bis heute nicht, dass visuelle Suche ein eigener Kanal ist. Unternehmen, die jetzt mit visueller Suchoptimierung beginnen, sichern sich Leads und Marktanteile, während die Konkurrenz noch an gestrigen Suchparadigmen festhält.

Die Optimierung für visuelle Entdeckung erfordert einen grundsätzlich anderen Ansatz als klassische Bild-SEO. Hier sind die wichtigsten Strategien:

Jedes dieser Elemente trägt dazu bei, wie Google Lens Ihren visuellen Content versteht und platziert. Je mehr Kontext Sie liefern, desto wahrscheinlicher erscheinen Ihre Produkte in relevanten visuellen Suchanfragen.

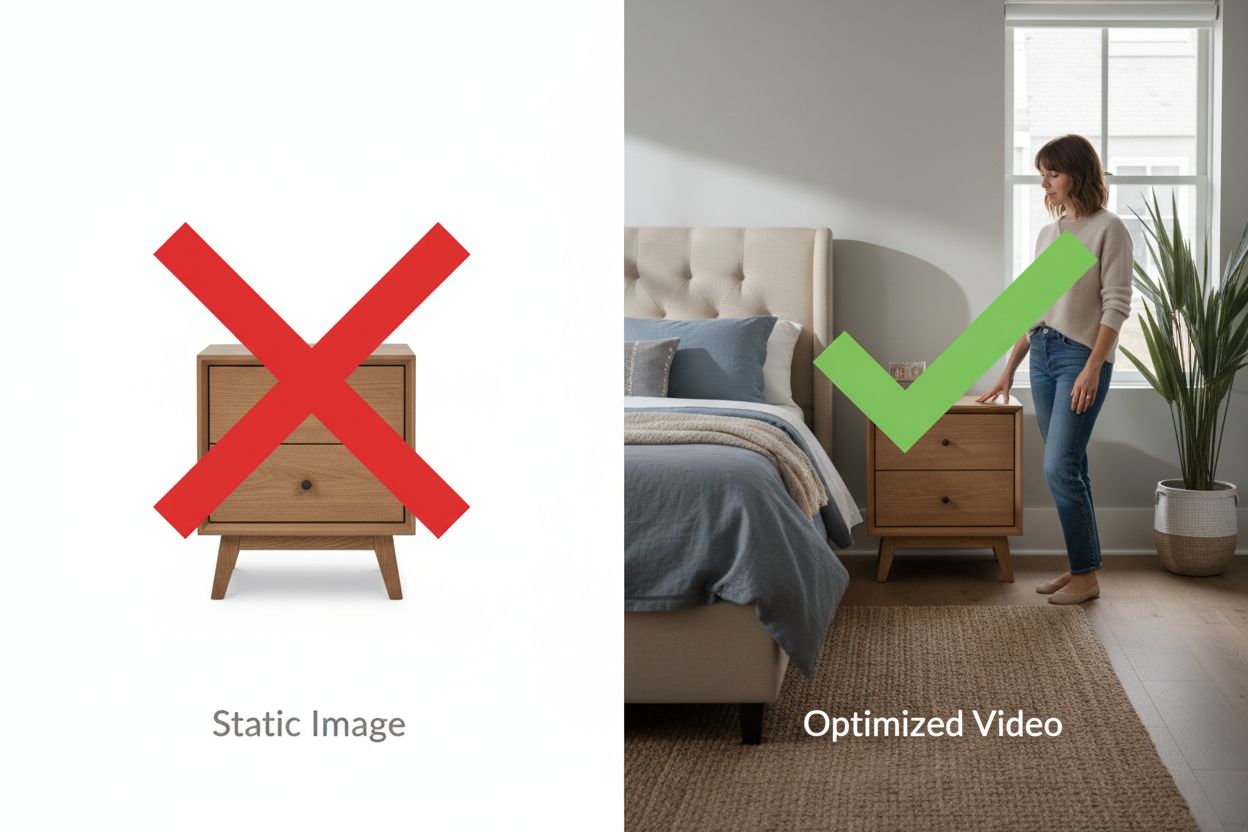

Statische Bilder sind Pflicht, aber Video ist Ihr Wettbewerbsvorteil in der visuellen Suche. Google Lens extrahiert Informationen aus Videoframes – ein 30-sekündiges Produktvideo generiert Dutzende entdeckbare Momente, die Fotos nicht bieten können.

Video zeigt Maßstab auf eine Weise, wie es Fotos nicht können. Zeigen Sie einen Nachttisch neben einem Queen-Size-Bett mit einer Person daneben, kann Lens die genauen Dimensionen durch räumliche Beziehungen ableiten. Zeigen Sie die Nutzung eines Produkts – eine wasserdichte Tasche im Regen, einen Stehschreibtisch mit zwei Monitoren, ein Zelt im Unwetter – bieten Sie Beweise, die Versprechen übertreffen.

Der Effekt auf die Conversion ist messbar. E-Commerce-Seiten, die Produktvideos hinzufügen, steigern die Konversionsrate um 20-40 %, weil Kunden die Produkte vor dem Kauf im eigenen Umfeld visualisieren können. Dieselben Videos werden in Google-Lens-Suchen gefunden und erschließen einen ganz neuen Traffic-Kanal.

Die technischen Anforderungen sind klar: 15-45 Sekunden lange Videos, die Produkte aus mehreren Perspektiven mit deutlichem Maßstabsbezug zeigen, direkt auf Ihrer Website hochgeladen (keine YouTube-Embeds für Produktseiten), mit beschreibenden Dateinamen und Schema-Markup. Sie brauchen keine Hollywood-Qualität – authentisches Smartphone-Material mit echtem Kontext schlägt oft sterile Studioaufnahmen, weil der Kontext wichtiger ist als die Produktionsqualität.

Die Optimierung für visuelle Suche erfordert eine strategische Herangehensweise. Beginnen Sie mit einem Audit Ihrer aktuellen visuellen Assets im Bildbereich der Google Search Console – die meisten Marken stellen fest, dass sie tausende Impressionen, aber kaum Klicks erhalten. Das zeigt ein riesiges Optimierungspotenzial.

Identifizieren Sie Ihre 50 wichtigsten Produkte nach Traffic und Umsatz und überprüfen Sie deren aktuellen visuellen Content. Welche Produkte haben mehrere Ansichten? Welche verfügen über Videos? Wo fehlen Lifestyle-Aufnahmen? Dieses Audit zeigt, wo Ihre Optimierungsmaßnahmen den höchsten ROI liefern. Erstellen Sie eine Content-Roadmap, die Produkte mit dem größten Suchvolumen und kommerzieller Absicht priorisiert.

Der Umsetzungsplan erstreckt sich über 60-90 Tage: Wochen 1-2 dienen der Planung und Priorisierung, Wochen 3-4 der Content-Erstellung – Produktvideos drehen, Lifestyle-Fotos machen, Demonstrationscontent produzieren. In den Wochen 5-6 erfolgt die technische Optimierung: Dateien umbenennen, Alt-Texte schreiben, Schema-Markup implementieren und Inhalte hochladen. Wochen 7-8 stehen im Zeichen von Monitoring und Optimierung – verfolgen Sie, welche Produkte und Content-Typen den meisten visuellen Suchtraffic generieren.

Überwachen Sie den Leistungsbericht in der Search Console gefiltert nach „Bild“-Suchtyp, um Ihren Fortschritt zu messen. Rechnen Sie mit 30-60 Tagen, bis deutliche Traffic-Steigerungen sichtbar werden – Google braucht Zeit, um Ihre neuen Inhalte zu crawlen und zu indexieren. Tracken Sie Conversions aus Bildersuche gezielt mit UTM-Parametern oder Kanalgruppierung in Google Analytics, um den ROI zu messen.

Googles Fahrplan für visuelle Suche entwickelt sich rasant weiter. Search Live, das 2025 ausgerollt wird, ermöglicht Echtzeit-Konversation mit der Suche – Sie können Ihre Kamera auf ein Gemälde richten, fragen „Welcher Stil ist das?“ und direkt nachhaken „Wer sind berühmte Künstler dieses Stils?“ – für ein nahtloses, konversationelles visuelles Sucherlebnis.

Multimodale KI-Fähigkeiten werden stetig besser, sodass Lens immer komplexere visuelle Anfragen versteht. Statt nur Objekte zu erkennen, versteht Lens jetzt Beziehungen, Kontexte und differenzierte Fragen zu dem, was Sie sehen. Die Erweiterung von Circle to Search bringt gestenbasierte visuelle Suche auf mehr Geräte und Plattformen und macht visuelle Entdeckung noch zugänglicher.

Die Integration im Google-Ökosystem vertieft die Möglichkeiten. Google Lens ist jetzt direkt in Chrome für Desktop eingebaut – visuelle Suche ist immer dann verfügbar, wenn Inspiration aufkommt. Mit der weltweiten Ausweitung dieser Fähigkeiten und der Integration auf weiteren Plattformen wird der Wettbewerbsvorteil früher Optimierung noch deutlicher.

Die Marken, die sich jetzt vorbereiten – ihren visuellen Content optimieren, Demonstrationsvideos erstellen und korrektes Schema-Markup implementieren – werden die Ergebnisse der visuellen Suche dominieren, während der Kanal weiter rasant wächst. Die Frage ist nicht, ob visuelle Suche für Ihr Geschäft relevant wird – sondern ob Sie sichtbar sind, wenn Kunden visuell nach Ihren Produkten suchen.

Google Lens ist Googles Technologie für visuelle Suche, die KI nutzt, um Objekte, Text und Szenen aus Bildern oder Videos zu erkennen. Es verwendet Convolutional Neural Networks (CNNs) zur Objekterkennung, Optical Character Recognition (OCR) zur Texterkennung und Natural Language Processing (NLP) zum Verstehen von Kontext. Nutzer können ihre Kamera auf etwas richten und Fragen dazu stellen und erhalten sofort KI-gestützte Antworten und weiterführende Informationen.

Die traditionelle Bildersuche basiert auf Keywords und Metadaten, um visuell ähnliche Bilder zu finden. Google Lens versteht den tatsächlichen Inhalt der Bilder – Objekte, Beziehungen, Kontext und Bedeutung – und ermöglicht so die Zuordnung von Produkten und Informationen anhand visueller Ähnlichkeit statt Textbeschreibungen. Das ist besonders effektiv für Dinge, die sich nur schwer in Worte fassen lassen, wie Möbel, Mode oder Sehenswürdigkeiten.

Google Lens verarbeitet jährlich über 100 Milliarden visuelle Suchanfragen, von denen 20 Milliarden eine direkte Kaufabsicht haben. Nutzer, die visuelle Suchen durchführen, suchen aktiv nach etwas, das sie gesehen haben, was diesen Traffic besonders wertvoll macht. Die Optimierung für visuelle Entdeckung fängt Kunden im Moment ihres Interesses ab, noch bevor sie eine Suchanfrage eintippen – das führt zu höheren Konversionsraten als herkömmlicher Suchtraffic.

Google Lens erfordert das Öffnen der App und das Aufnehmen oder Hochladen eines Bildes. Circle to Search ist eine gestenbasierte Funktion auf Android-Geräten, bei der Nutzer Objekte direkt auf dem Bildschirm einkreisen, antippen oder markieren können, ohne die App zu wechseln. Beide nutzen die gleiche Technologie für visuelle Suche, aber Circle to Search bietet eine schnellere und nahtlosere Erfahrung für Nutzer, die bereits Inhalte auf ihrem Smartphone betrachten.

Optimieren Sie für Google Lens, indem Sie mehrere Produktansichten bereitstellen, bekannte Größenreferenzen (Betten, Türen, Menschen) für den Maßstabsbezug einbauen, beschreibende Alt-Texte verfassen, Product- und Video-Schema-Markup implementieren, Lifestyle-Fotografie mit realen Anwendungsszenarien erstellen, saisonale Produkte online halten mit Ausverkauft-Kennzeichnungen und beschreibende Dateinamen verwenden. Jeder dieser Aspekte hilft Google Lens, Ihren visuellen Content besser zu verstehen.

Video ist ein Game-Changer für die visuelle Suche, da Google Lens Informationen aus Videoframes extrahiert und so aus einem einzigen Video mehrere entdeckbare Momente schafft. Videos veranschaulichen Maßstab, Funktionalität und reale Nutzung auf eine Weise, wie es statische Bilder nicht können. Produkte mit Demonstrationsvideos erzielen 20-40% höhere Konversionsraten und erscheinen häufiger in den Ergebnissen der visuellen Suche – Video ist also essenziell für den Wettbewerbsvorteil.

Rechnen Sie mit 30-60 Tagen, bis im Bildbereich der Google Search Console signifikante Traffic-Steigerungen sichtbar werden. Google benötigt Zeit, um Ihre neuen visuellen Inhalte neu zu crawlen und zu indexieren. Sie sollten jedoch bereits nach 30 Tagen eine Zunahme der Impressionen beobachten, was darauf hindeutet, dass Google Ihre optimierten Inhalte entdeckt und indexiert. Verbesserungen bei den Konversionen folgen üblicherweise innerhalb von 60-90 Tagen, sobald das Traffic-Volumen zunimmt.

Ja, Sie können visuellen Suchtraffic in Google Analytics verfolgen, indem Sie in der Leistungsübersicht der Google Search Console nach dem Suchtyp 'Bild' filtern. Für detailliertes Conversion-Tracking nutzen Sie UTM-Parameter auf Produktseiten oder erstellen Sie eine benutzerdefinierte Kanalgruppe für Bildersuch-Traffic. Überwachen Sie Kennzahlen wie Klickrate, Konversionsrate und durchschnittlichen Bestellwert speziell für Bildersuch-Traffic, um den ROI Ihrer Optimierungsmaßnahmen zu messen.

AmICited verfolgt, wie Google Lens, Circle to Search und andere KI-Tools Ihre Marke in den Ergebnissen der visuellen Entdeckung referenzieren. Erhalten Sie Einblicke in Ihre KI-Sichtbarkeit und optimieren Sie Ihre visuelle Content-Strategie.

Erfahren Sie, wie visuelle Suche und KI die Bildentdeckung verändern. Optimieren Sie Ihre Bilder für Google Lens, AI Overviews und multimodale LLMs, um die Sich...

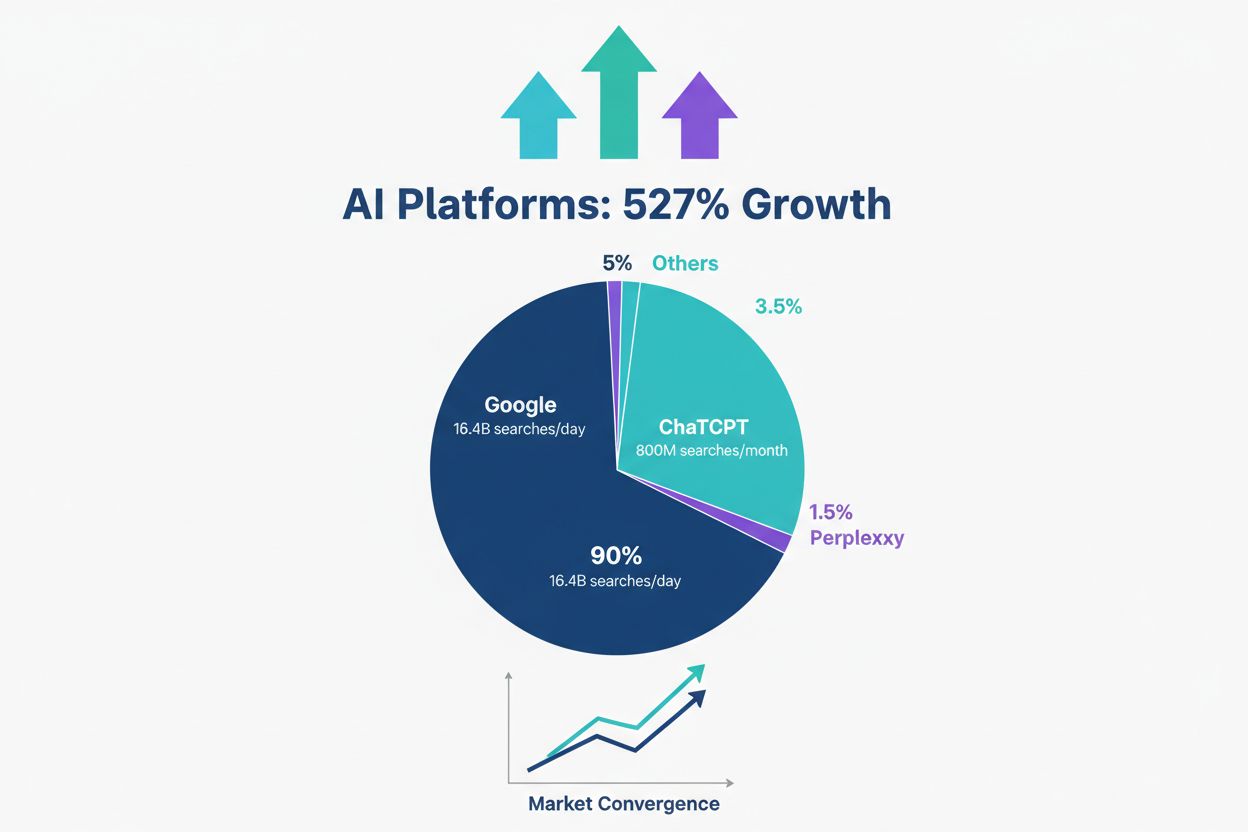

Erfahren Sie, wie KI-Suchplattformen wie ChatGPT und Perplexity die Suchlandschaft verändern. Entdecken Sie, wann KI das Konversionsvolumen von Google erreichen...

Entdecken Sie, wie die KI-Suche das SEO verändert. Lernen Sie die wichtigsten Unterschiede zwischen KI-Plattformen wie ChatGPT und der traditionellen Google-Suc...