Multimodale KI-Suche

Erfahren Sie, wie multimodale KI-Suchsysteme Text, Bilder, Audio und Video gemeinsam verarbeiten, um genauere und kontextuell relevantere Ergebnisse zu liefern ...

Meistern Sie die Optimierung für multimodale KI-Suche. Lernen Sie, wie Sie Bilder und Sprachanfragen für KI-gestützte Suchergebnisse optimieren, mit Strategien für GPT-4o, Gemini und LLMs.

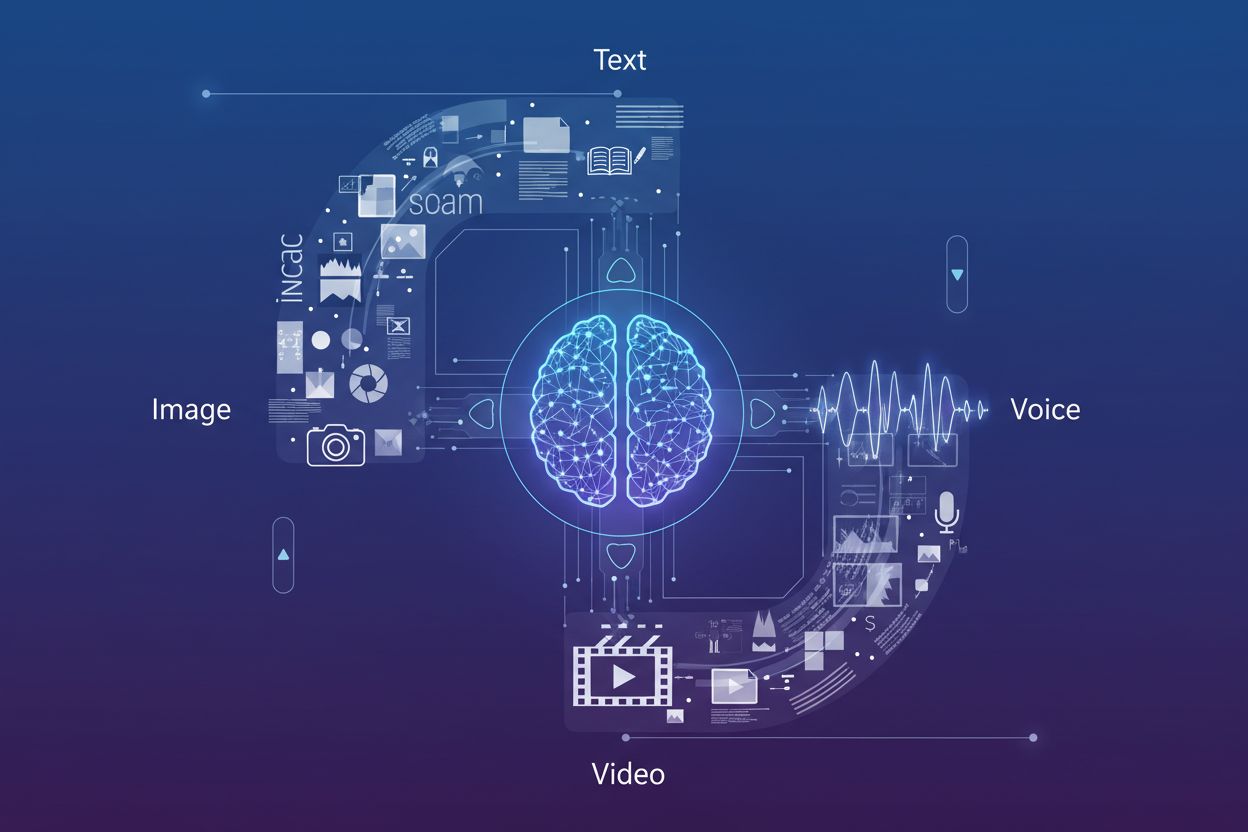

Multimodale KI-Suche stellt einen grundlegenden Wandel in der Art und Weise dar, wie Suchmaschinen Nutzeranfragen verarbeiten und verstehen, indem verschiedene Datentypen – Text, Bilder, Sprache und Video – in ein einheitliches Sucherlebnis integriert werden. Anstatt jede Modalität als separaten Kanal zu betrachten, nutzen moderne Suchsysteme heute multimodale KI-Modelle, die Informationen aus unterschiedlichen Formaten gleichzeitig analysieren und verknüpfen können. So entstehen kontextbezogenere und präzisere Ergebnisse. Diese Entwicklung von der einmodalen Suche (bei der Textanfragen Textantworten lieferten) hin zu integrierten multimodalen Systemen spiegelt wider, wie Nutzer natürlich mit Informationen interagieren: Sie kombinieren gesprochene Fragen mit visuellen Referenzen, laden Bilder als Kontext hoch und erwarten Ergebnisse, die verschiedene Inhaltstypen miteinander verknüpfen. Die Bedeutung dieses Wandels kann nicht hoch genug eingeschätzt werden: Er verändert grundlegend, wie Content-Ersteller ihre digitale Präsenz optimieren und wie Marken ihre Sichtbarkeit über Suchkanäle hinweg überwachen müssen. Multimodale Suchoptimierung zu verstehen, ist für Unternehmen, die wettbewerbsfähig in KI-gesteuerten Suchumgebungen bleiben wollen, keine Option mehr, sondern Pflicht.

Das Aufkommen fortschrittlicher multimodaler Modelle hat die Suchfunktionen revolutioniert. Mehrere führende Plattformen bieten inzwischen ausgefeilte Vision-Language-Modelle, die Inhalte aus mehreren Modalitäten gleichzeitig verarbeiten und verstehen können. Der Vergleich der wichtigsten Anbieter:

| Modellname | Entwickler | Hauptfunktionen | Am besten geeignet für |

|---|---|---|---|

| GPT-4o | OpenAI | Echtzeit-Bildanalyse, Sprachverarbeitung, 320ms Reaktionszeit | Komplexes visuelles Schlussfolgern, multimodale Konversationen |

| Gemini | Integrierte Suche, Video-Verständnis, Cross-Modal-Reasoning | Suchintegration, umfassende Inhaltsanalyse | |

| Claude 3.7 | Anthropic | Dokumentenanalyse, Bildinterpretation, nuanciertes Verständnis | Technische Dokumentation, detaillierte visuelle Analyse |

| LLaVA | Open-Source-Community | Leichtgewichtiges Vision-Language-Processing, effizientes Inferenzieren | Ressourcenbeschränkte Umgebungen, Edge-Einsatz |

| ImageBind | Meta | Cross-Modal-Embeddings, Audio-Visuelles Verständnis | Multimedia-Inhaltsverknüpfung, semantische Suche |

Diese Modelle bilden die Speerspitze der KI-Suchtechnologie und sind jeweils für unterschiedliche Anwendungsfälle und Einsatzszenarien optimiert. Organisationen müssen wissen, welche Modelle ihre Ziel-Suchplattformen antreiben, um Inhalte effektiv für die Auffindbarkeit zu optimieren. Die rasante Entwicklung dieser Technologien erfordert flexible und anpassungsfähige Sichtbarkeitsstrategien, um neuen Funktionen und Rankingfaktoren gerecht zu werden.

Die Bildsuch-Optimierung ist von zentraler Bedeutung, da sich visuelle Suchfunktionen rasant ausweiten – allein Google Lens verzeichnete 10 Millionen Besuche im Mai 2025 und zeigt damit das explosive Wachstum bildbasierter Suchanfragen. Um die Sichtbarkeit in Bildsuche-KI-Ergebnissen zu maximieren, sollten Content-Ersteller eine umfassende Optimierungsstrategie verfolgen:

Dieser vielschichtige Ansatz stellt sicher, dass Bilder nicht nur über die klassische Bildsuche, sondern auch über multimodale KI-Systeme auffindbar sind, die visuelle Inhalte im Kontext mit begleitendem Text und Metadaten analysieren.

Die Integration von Large Language Models in die Sprachsuche hat grundlegend verändert, wie Suchmaschinen gesprochene Anfragen interpretieren und beantworten. Sie gehen weit über einfache Keyword-Übereinstimmung hinaus hin zu ausgeprägtem kontextuellem Verständnis. Während die klassische Sprachsuche auf phonetischer Zuordnung und einfacher Sprachverarbeitung basierte, erfassen moderne LLM-gestützte Sprachsuchsysteme nun Intention, Kontext, Nuancen und Gesprächsmuster mit beeindruckender Genauigkeit. Das bedeutet: Die Optimierung für Sprachsuche darf sich nicht mehr nur auf exakte Keyword-Übereinstimmungen beschränken; stattdessen muss der Content so strukturiert sein, dass er die zugrunde liegende Intention hinter konversationalen Anfragen adressiert, wie sie Nutzer tatsächlich sprechen. Die Auswirkungen sind erheblich: Eine Nutzerfrage wie „Was ist der beste Weg, um einen undichten Küchenhahn zu reparieren?“ ist grundlegend anders als die getippte Suche „undichten Hahn reparieren“ – Inhalte müssen sowohl die Frage als auch den impliziten Wunsch nach einer Schritt-für-Schritt-Anleitung bedienen. Featured Snippets sind zur Hauptquelle für Sprachsuchantworten geworden, da Suchmaschinen prägnante, direkte Antworten bevorzugen, die ganz oben in den Suchergebnissen erscheinen. Dieses Hierarchie-Verständnis – dass Sprachsuchantworten aus Featured Snippets stammen – ist für jede Content-Strategie, die Sprachassistenten und sprachgesteuerte Geräte adressiert, essenziell.

Die Optimierung für konversationelle Anfragen erfordert eine grundlegende Umstrukturierung, weg von keywordgesättigten Absätzen hin zu natürlichen Frage-Antwort-Formaten, die dem tatsächlichen Sprachgebrauch der Menschen entsprechen. Inhalte sollten mit fragengestützten Überschriften aufgebaut sein, die häufige Nutzerfragen direkt adressieren, gefolgt von prägnanten, kompetenten Antworten, die sofortigen Mehrwert bieten, ohne dass Nutzer lange Texte durchsuchen müssen. Dieses Vorgehen entspricht der Arbeitsweise von Natural Language Processing-Systemen, die nach klaren Frage-Antwort-Paaren und direkten Aussagen suchen, die von Sprachassistenten vorgelesen werden können. Die Implementierung von strukturierten Daten, die Fragen und Antworten explizit kennzeichnen, hilft Suchmaschinen, den konversationalen Charakter Ihrer Inhalte zu erkennen, und erhöht die Wahrscheinlichkeit, für Sprachsuchergebnisse ausgewählt zu werden. Long-Tail-, konversationelle Phrasen sollten organisch in Ihre Inhalte integriert werden, statt sie gezwungen einzubauen. Ziel ist es, Inhalte zu erstellen, die beim Vorlesen natürlich klingen und gleichzeitig für KI-Systeme optimiert sind, die Informationen extrahieren. Diese Balance zwischen menschlicher Lesbarkeit und maschineller Interpretierbarkeit ist der Grundpfeiler effektiver Sprachsuch-Optimierung.

Die richtige Schema-Markup-Implementierung ist entscheidend, um multimodalen KI-Systemen zu signalisieren, was Ihre Inhalte darstellen und wie sie in verschiedenen Suchkontexten interpretiert werden sollen. Die effektivsten strukturierten Daten für multimodale Suche sind FAQ-Schema (markiert Frage-Antwort-Paare explizit für Sprachsuche), HowTo-Schema (liefert Schritt-für-Schritt-Anleitungen maschinenlesbar) und Local Business Schema (unterstützt standortbasierte multimodale Anfragen). Darüber hinaus sorgen Article-, Product- und Event-Schema dafür, dass Ihre Inhalte von KI-Systemen korrekt kategorisiert und verstanden werden. Mit dem Rich Results Test von Google sollte regelmäßig geprüft werden, ob Ihr Schema-Markup korrekt implementiert und von Suchsystemen erkannt wird. Das technische SEO-Fundament – saubere HTML-Struktur, schnelle Ladezeiten, mobile Optimierung und korrekte Canonical-Tags – gewinnt in multimodalen Suchumgebungen weiter an Bedeutung, da KI-Systeme Ihre Inhalte schnell und formatübergreifend erfassen müssen. Unternehmen sollten ihre gesamte Content-Bibliothek prüfen, um Potenziale für die Schema-Implementierung zu identifizieren, und zunächst Seiten mit hohem Traffic und Inhalten im Frage-Antwort- oder Anleitungsformat priorisieren.

Die Erfolgsmessung in der multimodalen Suche verlangt eine Verschiebung der Kennzahlen über den klassischen organischen Traffic hinaus, mit besonderem Fokus auf Featured Snippet-Impressionen, Sprachsuch-Engagement und Konversionsraten aus multimodalen Quellen. Die Google Search Console gibt Einblick in die Featured Snippet-Performance, zeigt, wie oft Ihre Inhalte auf Position Null erscheinen und welche Suchanfragen Ihre Snippets auslösen – Daten, die direkt mit der Sichtbarkeit in der Sprachsuche korrelieren. Mobile Engagement-Metriken gewinnen an Bedeutung, da Sprachsuche vorwiegend über mobile Geräte und Smart Speaker genutzt wird. Daher sind mobile Konversionsraten und Sitzungsdauer entscheidende KPIs für sprachoptimierte Inhalte. Analyseplattformen sollten so konfiguriert werden, dass Traffic aus Sprachassistenten und Bildsuche getrennt vom klassischen organischen Traffic erfasst wird, um zu erkennen, welche multimodalen Kanäle den wertvollsten Traffic liefern. Sprachsuch-Metriken sollten nicht nur das Traffic-Volumen, sondern auch die Konversionsqualität umfassen, da Sprachsuchende andere Absichten und Verhaltensmuster als Textsuchende haben. Die Überwachung markenbezogener Nennungen in AI Overviews und anderen KI-generierten Suchergebnissen liefert Erkenntnisse darüber, wie Ihre Marke in diesen neuen Suchformaten repräsentiert wird. Regelmäßige Audits Ihrer Featured Snippet-Performance, kombiniert mit der Analyse des Sprachsuch-Traffics, ergeben ein umfassendes Bild Ihrer multimodalen Suchsichtbarkeit und des ROI.

Die Entwicklung der multimodalen Suche weist auf immer ausgefeiltere KI-Suchtrends hin, die die Grenzen zwischen Suche, Surfen und direkter Aufgabenverarbeitung verwischen. AI Overviews verzeichnen bereits einen Nutzungsanstieg von über 10 %, da Anwender KI-generierte Zusammenfassungen immer stärker nutzen. Zukünftige Fähigkeiten umfassen agentische KI-Systeme, die im Namen der Nutzer handeln können – wie Reservierungen buchen, Einkäufe tätigen oder Termine vereinbaren – basierend auf multimodalen Anfragen, die Sprache, Bild und Kontextinformationen kombinieren. Personalisierung wird immer granularer, da KI-Systeme nicht nur verstehen, was Nutzer fragen, sondern auch deren Vorlieben, Standort, Kaufhistorie und Verhaltensmuster, um hyper-relevante Ergebnisse kanalübergreifend auszuliefern. Echtzeitsuchfunktionen werden ausgebaut, sodass Nutzer Fragen zu Live-Events, aktuellen Bedingungen oder Breaking News stellen können, mit der Erwartung sofortiger, akkurater Antworten aus mehreren Quellen. Die Videosuche wird sich als primäre Modalität etablieren, wobei KI-Systeme nicht nur Videometadaten, sondern auch den tatsächlichen Inhalt der Videos verstehen, sodass Nutzer gezielt nach bestimmten Momenten, Konzepten oder Informationen innerhalb von Videobibliotheken suchen können. Die Wettbewerbslandschaft wird zunehmend Marken begünstigen, die über alle Modalitäten hinweg optimiert sind, da Sichtbarkeit in einem Kanal (Featured Snippets, Bildsuche, Sprachsuche) durch cross-modale Rankingsignale direkt die Sichtbarkeit in anderen Kanälen beeinflusst.

Mit dem Siegeszug der multimodalen Suche hat sich das KI-Monitoring von der reinen Überwachung von Suchrankings zu einer umfassenden Marken-Zitaterfassung über Bildsuche, Sprachsuchergebnisse und KI-generierte Übersichten entwickelt. AmICited liefert entscheidende Einblicke, wie Ihre Marke in AI Overviews, Featured Snippets und Sprachsuchergebnissen erscheint – es wird nicht nur überwacht, ob Sie ranken, sondern auch, wie Ihre Marke von KI-Systemen, die Informationen aus mehreren Quellen zusammenführen, dargestellt und zitiert wird. Die Plattform verfolgt Bildzitate in visuellen Suchergebnissen und stellt sicher, dass Ihre visuellen Inhalte korrekt attribuiert und zu Ihrer Domain zurückverlinkt werden, um sowohl Ihre SEO-Autorität als auch die Markenpräsenz zu schützen. Sprachsuch-Nennungen werden über Smart Speaker und Sprachassistenten hinweg überwacht, sodass Sie wissen, wie Ihre Inhalte vorgelesen und Nutzern in sprachzentrierten Kontexten präsentiert werden, in denen klassische Klickmetriken nicht greifen. Da KI-generierte Suchergebnisse nun einen bedeutenden Anteil an Nutzerinteraktionen ausmachen, ist das Verständnis Ihrer Sichtbarkeit in diesen neuen Formaten entscheidend – AmICited bietet die Monitoring-Infrastruktur, um Ihre Präsenz über alle multimodalen Suchkanäle hinweg zu verfolgen, zu messen und zu optimieren. Für Marken, die ihre Wettbewerbsfähigkeit in der KI-gesteuerten Suchlandschaft sichern wollen, ist umfassendes multimodales Monitoring mit Plattformen wie AmICited keine Option mehr, sondern die Voraussetzung zum Verständnis und Schutz Ihrer digitalen Präsenz.

Multimodale KI-Suche integriert verschiedene Datentypen – Text, Bilder, Sprache und Video – in ein einheitliches Sucherlebnis. Moderne Suchsysteme nutzen heute multimodale KI-Modelle, die gleichzeitig Informationen über verschiedene Formate analysieren und verknüpfen können, was kontextbezogenere und genauere Ergebnisse ermöglicht als eine einmodale Suche.

Optimieren Sie Bilder, indem Sie hochwertige, originelle Bilder mit beschreibenden Dateinamen und umfassendem Alt-Text verwenden. Implementieren Sie Schema-Markup, bieten Sie kontextuellen Begleittext, zeigen Sie mehrere Blickwinkel desselben Motivs und komprimieren Sie Dateien für schnelle Ladezeiten. Diese Maßnahmen sorgen für Sichtbarkeit sowohl in der klassischen Bildsuche als auch in multimodalen KI-Systemen.

Featured Snippets sind die Hauptquelle für Sprachsuch-Antworten. Sprachassistenten entnehmen prägnante, direkte Antworten aus Position-Null-Ergebnissen auf den Suchergebnisseiten. Die Optimierung von Inhalten für Featured Snippets ist entscheidend für Sichtbarkeit und Ranking in der Sprachsuche.

Strukturieren Sie Inhalte mit fragengestützten Überschriften, die häufige Sprachabfragen direkt adressieren, gefolgt von prägnanten Antworten. Verwenden Sie eine natürliche, gesprächige Sprache und setzen Sie strukturiertes Daten-Markup (FAQ-Schema, HowTo-Schema) ein, damit KI-Systeme den konversationalen Charakter Ihrer Inhalte erkennen.

Zu den wichtigsten multimodalen Modellen zählen GPT-4o (OpenAI), Gemini (Google), Claude 3.7 (Anthropic), LLaVA (Open Source) und ImageBind (Meta). Jedes bietet unterschiedliche Fähigkeiten und Einsatzbereiche. Zu wissen, welche Modelle Ihre Ziel-Suchplattformen antreiben, hilft Ihnen, Inhalte effektiv zu optimieren.

Verfolgen Sie Featured Snippet-Impressionen in der Google Search Console, überwachen Sie mobile Engagement-Metriken, analysieren Sie Sprachsuch-Traffic getrennt von klassischem organischem Traffic und messen Sie Konversionsraten aus multimodalen Quellen. Überwachen Sie markenbezogene Nennungen in AI Overviews und prüfen Sie, wie Ihre Inhalte in verschiedenen Modalitäten erscheinen.

AmICited überwacht, wie Ihre Marke in AI Overviews, Featured Snippets, Bildsuchergebnissen und Sprachsuchantworten erscheint. Da KI-generierte Suchergebnisse zunehmend dominieren, ist umfassendes multimodales Monitoring unerlässlich, um Ihre digitale Präsenz über alle Suchkanäle hinweg zu verstehen und zu schützen.

Die Zukunft umfasst zunehmend ausgefeilte KI-Systeme mit agentischen Fähigkeiten, die im Namen der Nutzer handeln können, hyper-personalisierte Ergebnisse basierend auf Vorlieben und Verhalten, Echtzeitsuche für Live-Events und ausgereifte Videosuchfunktionen. Marken, die über alle Modalitäten hinweg optimiert sind, werden Wettbewerbsvorteile haben.

Verfolgen Sie, wie Ihre Marke in AI Overviews, Bildsuchergebnissen und Sprachsuchantworten erscheint. Erhalten Sie Echtzeit-Einblicke in Ihre Präsenz in der multimodalen Suche.

Erfahren Sie, wie multimodale KI-Suchsysteme Text, Bilder, Audio und Video gemeinsam verarbeiten, um genauere und kontextuell relevantere Ergebnisse zu liefern ...

Erfahren Sie, was multimodaler Inhalt für KI ist, wie er funktioniert und warum er wichtig ist. Entdecken Sie Beispiele für multimodale KI-Systeme und deren Anw...

Erfahren Sie, wie Sie Text, Bilder und Videos für multimodale KI-Systeme optimieren. Entdecken Sie Strategien zur Verbesserung von KI-Zitaten und Sichtbarkeit i...