PerplexityBot

Erfahren Sie mehr über PerplexityBot, den Web-Crawler von Perplexity, der Inhalte für die KI-Antwortmaschine indexiert. Verstehen Sie, wie er funktioniert, robo...

Vollständiger Leitfaden zum PerplexityBot-Crawler – erfahren Sie, wie er funktioniert, wie Sie den Zugriff steuern, Zitate überwachen und die Sichtbarkeit bei Perplexity AI optimieren. Lernen Sie Stealth Crawling-Bedenken und Best Practices kennen.

PerplexityBot ist der offizielle Webcrawler von Perplexity AI, der entwickelt wurde, um Websites für die KI-gestützten Suchergebnisse von Perplexity zu indexieren und anzuzeigen. Im Gegensatz zu einigen KI-Crawlern, die Daten zum Training großer Sprachmodelle sammeln, hat PerplexityBot einen speziellen Zweck: Er entdeckt, crawlt und verlinkt auf Websites, die relevante Antworten auf Nutzeranfragen bieten. Der Crawler arbeitet mit einer klar definierten User-Agent-Kennung (Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot)) und veröffentlicht seine IP-Adressbereiche öffentlich, sodass Website-Betreiber den Crawler-Traffic erkennen und steuern können. Zu verstehen, was PerplexityBot macht, ist für Website-Betreiber wichtig, die die Sichtbarkeit ihrer Inhalte in Perplexitys Antwort-Engine kontrollieren und gleichzeitig Transparenz darüber wahren möchten, wie ihre Seiten abgerufen werden.

PerplexityBot arbeitet wie ein Standard-Webcrawler und durchsucht kontinuierlich das Internet, um Webseiten zu entdecken und zu indexieren. Trifft er auf eine Website, liest er die robots.txt-Datei, um zu verstehen, auf welche Inhalte er zugreifen darf, und crawlt dann systematisch Seiten, um deren Inhalte zu extrahieren und zu indexieren. Diese indexierten Informationen fließen in den Suchalgorithmus von Perplexity ein, der sie nutzt, um zitierte Antworten auf Nutzeranfragen zu liefern. Tatsächlich betreibt Perplexity zwei unterschiedliche Crawler mit verschiedenen Zwecken, jeweils mit eigenem User-Agent und Verhaltensmustern. Den Unterschied zwischen diesen Crawlern zu kennen, ist entscheidend für Website-Betreiber, die ihre Zugriffsrichtlinien gezielt steuern möchten.

| Merkmal | PerplexityBot | Perplexity-User |

|---|---|---|

| Zweck | Indexiert Websites für Suchergebnisse und Zitate | Ruft bei Nutzeranfragen gezielt Seiten in Echtzeit ab |

| User-Agent-Kennung | PerplexityBot/1.0 | Perplexity-User/1.0 |

| robots.txt-Konformität | Respektiert robots.txt-Disallow-Direktiven | Ignoriert robots.txt meist (nutzerinitiierte Anfragen) |

| IP-Bereiche | Veröffentlicht unter perplexity.com/perplexitybot.json | Veröffentlicht unter perplexity.com/perplexity-user.json |

| Frequenz | Kontinuierliches, geplantes Crawling | Bei Bedarf, ausgelöst durch Nutzeranfragen |

| Anwendungsfall | Aufbau des Suchindex | Abruf aktueller Informationen für Antworten |

Die Unterscheidung zwischen diesen beiden Crawlern ist wichtig, da sie separat über robots.txt-Regeln und Firewall-Konfigurationen gesteuert werden können. Der reguläre Indexierungs-Crawler PerplexityBot respektiert Ihre robots.txt-Direktiven, während Perplexity-User diese möglicherweise umgeht, da er Inhalte als Reaktion auf eine konkrete Nutzeranfrage abruft. Beide Crawler veröffentlichen ihre IP-Adressbereiche öffentlich, sodass Website-Betreiber präzise Firewall-Regeln implementieren können, falls sie spezifischen Crawler-Traffic blockieren oder zulassen möchten.

Im Jahr 2025 veröffentlichte Cloudflare eine ausführliche Untersuchung, die aufdeckte, dass Perplexity nicht deklarierte Crawler einsetzte, um Website-Beschränkungen zu umgehen. Laut den Erkenntnissen wurden, wenn die deklarierten Crawler (PerplexityBot und Perplexity-User) über robots.txt oder Firewall-Regeln blockiert wurden, zusätzliche Crawler mit generischen Browser-User-Agents (wie Chrome auf macOS) und rotierenden IP-Adressen aus verschiedenen ASNs (Autonomous System Numbers) eingesetzt, um weiterhin auf gesperrte Inhalte zuzugreifen. Dieses Verhalten widerspricht den in RFC 9309 festgelegten Standards für Webcrawler, die Transparenz und Respekt gegenüber den Präferenzen der Website-Betreiber betonen. Die Untersuchung testete dies, indem neue Domains mit expliziten robots.txt-Disallow-Regeln erstellt wurden – dennoch lieferte Perplexity detaillierte Informationen über deren Inhalte, was auf den Einsatz nicht deklarierter Datenquellen oder Stealth Crawling-Techniken hindeutet.

Dies steht im deutlichen Gegensatz zum Vorgehen von OpenAI im Crawler-Management. OpenAIs GPTBot identifiziert sich klar, respektiert robots.txt-Direktiven und stellt das Crawling ein, wenn er blockiert wird – was beweist, dass transparentes, ethisches Crawler-Verhalten möglich und praktikabel ist. Die Erkenntnisse von Cloudflare werfen erhebliche Zweifel daran auf, ob Perplexitys erklärtes Bekenntnis zum Respektieren von Website-Präferenzen tatsächlich ernst gemeint ist – insbesondere für Website-Betreiber, die explizit verhindern wollen, dass ihre Inhalte von KI-Systemen indexiert oder zitiert werden. Für Betreiber, denen Inhaltskontrolle und Transparenz wichtig sind, unterstreicht diese Kontroverse, wie wichtig die Überwachung des Crawler-Verhaltens und der Einsatz mehrerer Schutzebenen (robots.txt, WAF-Regeln und IP-Blocking) sind, um ihre Präferenzen durchzusetzen.

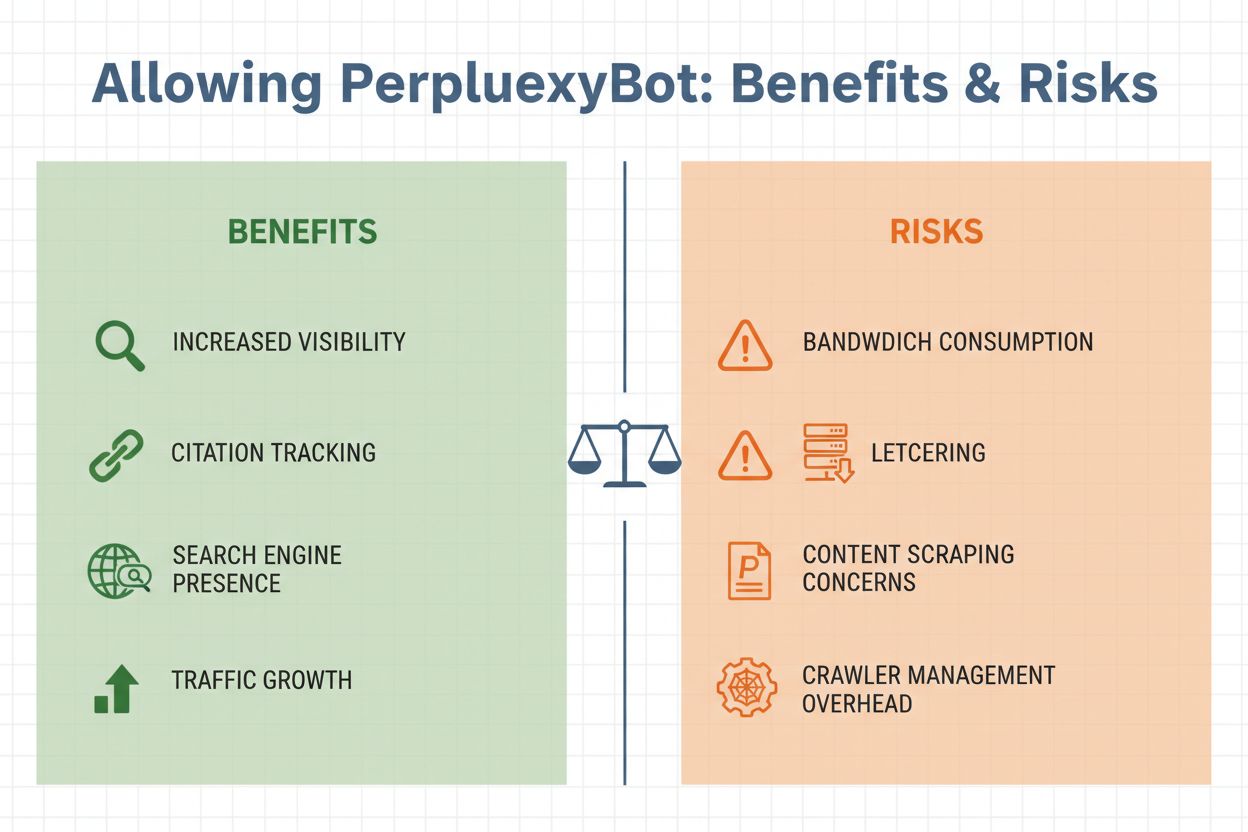

Ob Sie PerplexityBot auf Ihrer Website zulassen, hängt von der Abwägung mehrerer wichtiger Faktoren ab. Einerseits bringt die Zulassung des Crawlers erhebliche Vorteile: Ihre Inhalte werden für Zitate in Perplexitys Antworten verfügbar und können so Besucherströme generieren, wenn Nutzer Ihre Website in KI-generierten Ergebnissen entdecken. Andererseits bestehen berechtigte Bedenken hinsichtlich Bandbreitenverbrauch, Content-Scraping und Kontrollverlust darüber, wie Ihre Informationen verwendet werden. Die Entscheidung hängt letztlich von Ihren Geschäftszielen, Ihrer Content-Strategie und Ihrer Bereitschaft ab, KI-Systemen Zugriff auf Ihre Daten zu gewähren.

Wichtige Überlegungen zur Zulassung von PerplexityBot:

Das Management des Zugriffs von PerplexityBot ist unkompliziert und kann je nach technischer Infrastruktur und individuellen Anforderungen auf verschiedene Arten umgesetzt werden. Der gängigste Ansatz ist die Nutzung Ihrer robots.txt-Datei, mit der allen gutartigen Crawlern klar mitgeteilt wird, auf welche Inhalte sie zugreifen dürfen.

Um PerplexityBot in Ihrer robots.txt zuzulassen:

User-agent: PerplexityBot

Allow: /

Um PerplexityBot in Ihrer robots.txt zu blockieren:

User-agent: PerplexityBot

Disallow: /

Wenn Sie PerplexityBot den Zugriff auf bestimmte Verzeichnisse verwehren, andere aber erlauben möchten, können Sie detailliertere Regeln verwenden:

User-agent: PerplexityBot

Disallow: /admin/

Disallow: /private/

Allow: /public/

Für robusteren Schutz – insbesondere, wenn Sie sich wegen Stealth Crawling sorgen – implementieren Sie Firewall-Regeln auf WAF-Ebene (Web Application Firewall). Cloudflare WAF-Nutzer können eigene Regeln erstellen, um PerplexityBot durch eine Kombination aus User-Agent- und IP-Adress-Übereinstimmung zu blockieren:

AWS WAF-Nutzer sollten IP-Sets mit den veröffentlichten PerplexityBot-IP-Bereichen von https://www.perplexity.com/perplexitybot.json anlegen und Regeln erstellen, die sowohl das IP-Set als auch die PerplexityBot-User-Agent-Kennung abgleichen. Verwenden Sie immer die offiziellen, von Perplexity veröffentlichten IP-Bereiche, da diese regelmäßig aktualisiert werden und die maßgebliche Quelle für legitimen Crawler-Traffic sind.

Nachdem Sie Ihre PerplexityBot-Policy festgelegt haben, hilft die Überwachung der tatsächlichen Crawler-Aktivitäten dabei, zu prüfen, ob Ihre Regeln korrekt greifen und wie sich der Crawler auf Ihre Infrastruktur auswirkt. Sie können PerplexityBot-Anfragen in Ihren Server-Logs anhand der charakteristischen User-Agent-Kennung PerplexityBot/1.0 oder – bei Stealth Crawling – durch generische Browser-Kennungen identifizieren. Die meisten Webanalyse- und Serverlog-Analyse-Tools erlauben Ihnen, Traffic nach User-Agent zu filtern, sodass Sie PerplexityBot-Anfragen leicht isolieren und deren Muster analysieren können.

Zu überwachende Kennzahlen sind die Häufigkeit der Crawler-Besuche, die aufgerufenen Seiten und das verbrauchte Datenvolumen. Wenn Sie ungewöhnliche Muster bemerken – etwa ein schnelles Crawlen sensibler Seiten oder Anfragen von IP-Adressen außerhalb der veröffentlichten Bereiche von Perplexity – kann dies auf Stealth Crawling hindeuten. Über die reine Traffic-Überwachung hinaus bieten spezialisierte Tools wie AmICited.com tiefergehende Einblicke, wie Ihre Inhalte auf KI-Plattformen wie Perplexity tatsächlich zitiert werden. AmICited verfolgt Erwähnungen Ihrer Marke und Inhalte in KI-generierten Antworten, sodass Sie den tatsächlichen Einfluss der Zulassung von PerplexityBot messen und erkennen können, welche Ihrer Seiten für KI-Systeme besonders wertvoll sind. Diese Daten helfen Ihnen, fundierte Entscheidungen über zukünftige Crawler-Management-Policies und Content-Optimierungsstrategien zu treffen.

Ein effektives Management von PerplexityBot erfordert ein ausgewogenes Vorgehen, das Ihre Interessen schützt und den Wert KI-basierter Sichtbarkeit anerkennt. Erstens: Definieren Sie eine klare Policy basierend auf Ihren Geschäftszielen – entscheiden Sie, ob der potenzielle Traffic und die Markenpräsenz durch Perplexity-Zitate Ihre Bedenken hinsichtlich Bandbreite und Inhaltskontrolle überwiegen. Dokumentieren Sie diese Entscheidung in Ihrer robots.txt und informieren Sie Ihr Team, damit alle Ihre Crawler-Management-Strategie verstehen.

Zweitens: Setzen Sie einen mehrschichtigen Schutz um, falls Sie PerplexityBot blockieren möchten. Verlassen Sie sich nicht allein auf robots.txt, denn die Stealth Crawling-Kontroverse zeigt, dass einige Crawler diese Direktiven ignorieren können. Kombinieren Sie robots.txt-Regeln mit WAF-Regeln und IP-Blocking für einen Defense-in-Depth-Ansatz. Drittens: Bleiben Sie über das Crawler-Verhalten informiert, indem Sie Ihre Logs regelmäßig überwachen und Branchendiskussionen über KI-Crawler-Ethik und Transparenz verfolgen. Die Entwicklung ist rasant, und neue Crawler oder Taktiken können Anpassungen Ihrer Policy erfordern.

Nutzen Sie schließlich Monitoring-Tools gezielt, um die tatsächlichen Auswirkungen Ihrer Entscheidungen zu messen. Tools wie AmICited.com geben Einblick, wie KI-Systeme Ihre Inhalte zitieren, und helfen Ihnen zu verstehen, ob die Zulassung von PerplexityBot die erwarteten Sichtbarkeitsvorteile bringt. Wenn Sie den Crawler zulassen, hilft Ihnen dieses Wissen, Ihre Inhalte für KI-Zitate zu optimieren. Blockieren Sie ihn, bestätigt das Monitoring, dass Ihre Sperren greifen und Ihre Inhalte nicht auf anderem Wege in Perplexity-Ergebnissen erscheinen.

PerplexityBot agiert in einer dicht besetzten Landschaft verschiedener KI-Crawler, die alle unterschiedliche Zwecke und Transparenzstandards verfolgen. GPTBot von OpenAI gilt weithin als Vorbild für transparentes Crawler-Verhalten – er identifiziert sich klar, respektiert robots.txt-Direktiven und stoppt das Crawling bei Blockaden. Auch Googles Crawler für AI Overviews und andere KI-Features wahren Transparenz und respektieren Website-Präferenzen. Im Gegensatz dazu stellt das von Cloudflare dokumentierte Stealth Crawling von Perplexity eine bedenkliche Abweichung von diesen Standards dar.

Der zentrale Unterschied liegt in Transparenz und Respekt gegenüber den Präferenzen der Website-Betreiber. Gutartige Crawler wie GPTBot machen es Website-Betreibern leicht, ihr Verhalten zu verstehen und bieten klare Steuerungsmechanismen. Perplexitys Einsatz nicht deklarierter Crawler und IP-Rotation zur Umgehung von Beschränkungen untergräbt dieses Vertrauen. Für Website-Betreiber bedeutet das, besonders vorsichtig gegenüber den Aussagen von Perplexity zu sein und stärkere technische Kontrollen umzusetzen, wenn sie sicherstellen wollen, dass ihre Präferenzen tatsächlich respektiert werden. Während das KI-Crawler-Ökosystem reift, wird der Druck auf Unternehmen wie Perplexity steigen, transparentere und ethischere Praktiken zu übernehmen, die etablierten Webstandards entsprechen und die Autonomie von Website-Betreibern respektieren.

PerplexityBot ist der offizielle Webcrawler von Perplexity AI, der entwickelt wurde, um Websites zu indexieren und sie in den KI-gestützten Suchergebnissen von Perplexity anzuzeigen. Im Gegensatz zu einigen KI-Crawlern, die Daten zum Training sammeln, entdeckt und verlinkt PerplexityBot gezielt auf Websites, die relevante Antworten auf Nutzeranfragen bieten. Er arbeitet transparent mit einer veröffentlichten User-Agent-Kennung und IP-Adressbereichen.

Nein. Laut offizieller Dokumentation von Perplexity ist PerplexityBot dafür konzipiert, Websites in den Suchergebnissen von Perplexity anzuzeigen und zu verlinken. Er wird nicht eingesetzt, um Inhalte für KI-Grundlagenmodelle oder Trainingszwecke zu crawlen. Die einzige Funktion des Crawlers ist die Indexierung von Inhalten für die Aufnahme in die Antwortmaschine von Perplexity.

Sie können PerplexityBot mit Ihrer robots.txt-Datei blockieren, indem Sie 'User-agent: PerplexityBot' gefolgt von 'Disallow: /' hinzufügen, um jeglichen Zugriff zu verhindern. Für stärkeren Schutz implementieren Sie WAF-Regeln auf Cloudflare oder AWS WAF, die Anfragen mit dem PerplexityBot User-Agent und den IP-Bereichen blockieren. Seien Sie sich jedoch bewusst, dass Stealth Crawling diese Kontrollen umgehen kann.

Perplexity veröffentlicht offizielle IP-Adressbereiche für PerplexityBot unter https://www.perplexity.com/perplexitybot.json und für Perplexity-User unter https://www.perplexity.com/perplexity-user.json. Diese Bereiche werden regelmäßig aktualisiert und sollten die maßgebliche Quelle für Ihre Firewall- und WAF-Konfigurationen sein. Verwenden Sie immer die offiziellen Endpunkte statt veralteter IP-Listen.

PerplexityBot behauptet, robots.txt-Direktiven zu respektieren, aber eine Untersuchung von Cloudflare im Jahr 2025 fand Hinweise auf Stealth Crawling mit nicht deklarierten User-Agents und rotierenden IP-Adressen zum Umgehen von robots.txt-Beschränkungen. Während der deklarierte PerplexityBot-Crawler Ihre robots.txt-Regeln befolgen sollte, wird empfohlen, zusätzliche WAF-Schutzmaßnahmen zu implementieren, wenn Sie sicherstellen möchten, dass Ihre Präferenzen durchgesetzt werden.

Der Bandbreitenverbrauch variiert je nach Größe und Inhaltsvolumen Ihrer Website. PerplexityBot führt kontinuierliches, geplantes Crawling ähnlich wie der Google-Crawler durch. Websites mit hohem Traffic können einen messbaren Bandbreitenverbrauch feststellen. Sie können die tatsächliche Nutzung überwachen, indem Sie Ihre Server-Logs nach PerplexityBot-Anfragen filtern und das übertragene Datenvolumen analysieren, um festzustellen, ob dies Ihre Infrastruktur beeinflusst.

Ja. Sie können Perplexity manuell nach Anfragen zu Ihren Inhalten durchsuchen, um zu sehen, ob Ihre Website in Antworten zitiert wird. Für umfassendere Überwachung nutzen Sie Tools wie AmICited.com, das verfolgt, wie Ihre Marke und Inhalte auf KI-Plattformen einschließlich Perplexity erscheinen, und Ihnen Echtzeit-Einblicke in Ihre KI-Sichtbarkeit und Zitationsmuster bietet.

PerplexityBot ist der geplante Crawler, der kontinuierlich Websites für den Suchindex von Perplexity indexiert. Perplexity-User wird bei Bedarf ausgelöst, wenn Nutzer Fragen stellen und Perplexity bestimmte Seiten für Echtzeitinformationen abrufen muss. PerplexityBot respektiert robots.txt, während Perplexity-User diese in der Regel ignoriert, da es sich um nutzerinitiierte Anfragen handelt. Beide haben eigene User-Agent-Kennungen und IP-Bereiche.

Verfolgen Sie, wie Perplexity und andere KI-Plattformen Ihre Marke zitieren. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Sichtbarkeit und optimieren Sie Ihre Content-Strategie für maximale Wirkung in generativen Suchmaschinen.

Erfahren Sie mehr über PerplexityBot, den Web-Crawler von Perplexity, der Inhalte für die KI-Antwortmaschine indexiert. Verstehen Sie, wie er funktioniert, robo...

Erfahren Sie, was GPTBot ist, wie er funktioniert und ob Sie den Webcrawler von OpenAI zulassen oder blockieren sollten. Verstehen Sie die Auswirkungen auf Ihre...

Verstehen Sie, wie KI-Crawler wie GPTBot und ClaudeBot funktionieren, wo sie sich von traditionellen Such-Crawlern unterscheiden und wie Sie Ihre Website für Si...