Entwicklung von Prompt-Bibliotheken

Erfahren Sie, was Entwicklung von Prompt-Bibliotheken ist und wie Organisationen Abfragesammlungen aufbauen, um Markenpräsenz auf KI-Plattformen wie ChatGPT, Cl...

Erfahren Sie, wie Sie Prompt-Bibliotheken für manuelles AI-Visibility-Testing aufbauen und nutzen. DIY-Anleitung zum Testen, wie AI-Systeme Ihre Marke in ChatGPT, Perplexity und Google AI referenzieren.

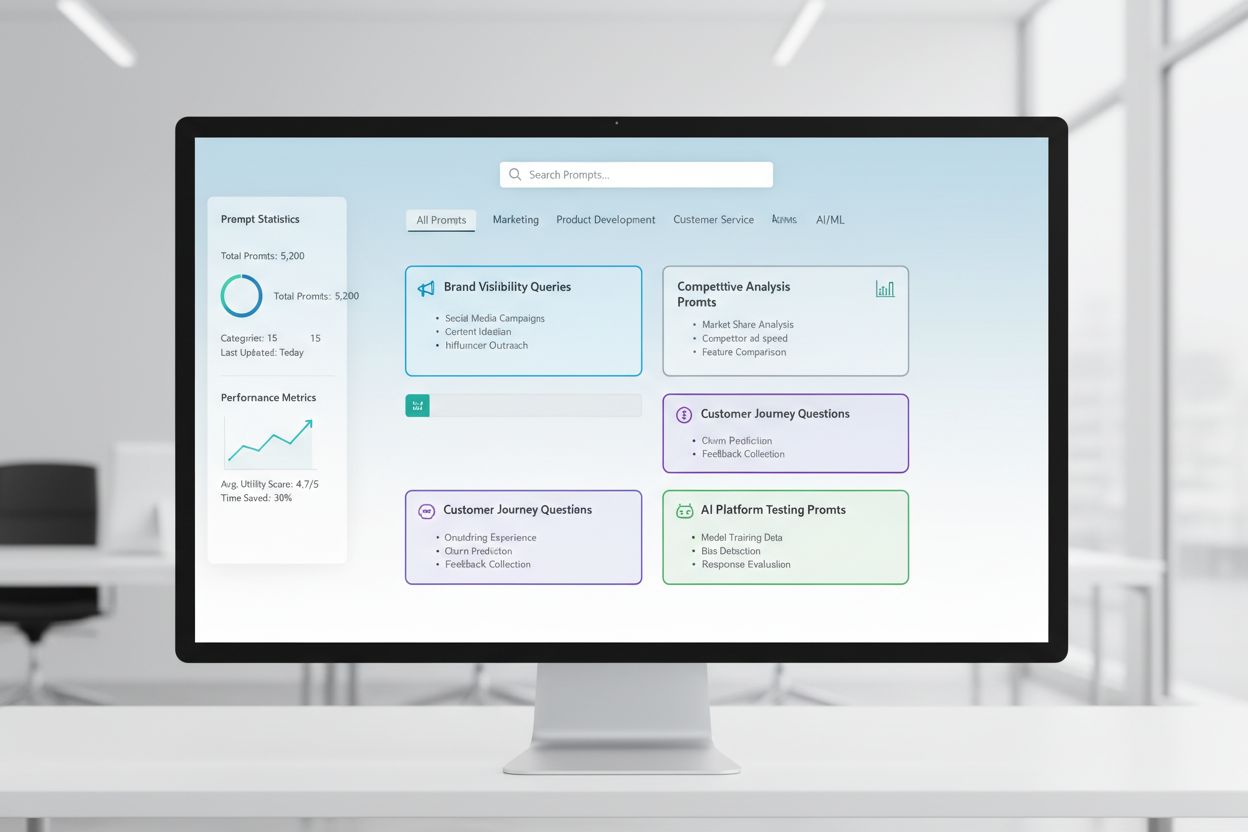

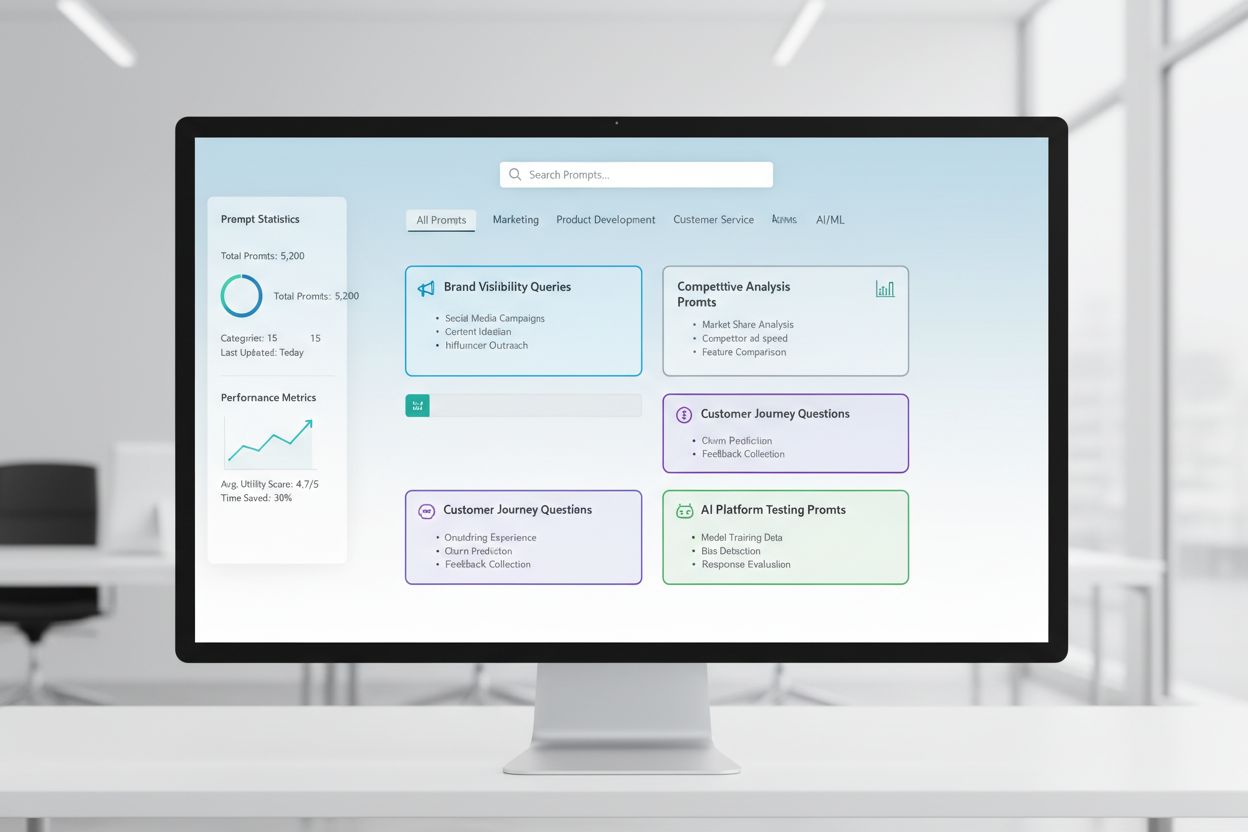

Eine Prompt-Bibliothek ist eine kuratierte, organisierte Sammlung von Testprompts, die dazu dient, systematisch zu evaluieren, wie AI-Systeme auf bestimmte Anfragen und Szenarien reagieren. Im Kontext des manuellen AI-Testings dienen diese Bibliotheken als Ihr grundlegendes Toolkit – ein Repository sorgfältig formulierter Prompts, mit denen Sie genau nachvollziehen können, wie verschiedene AI-Modelle Ihre Markenerwähnungen, Zitationen, Inhaltsgenauigkeit und das kontextuelle Verständnis handhaben. AI-Visibility-Testing stützt sich stark auf Prompt-Bibliotheken, weil sie konsistente, wiederholbare Tests über mehrere Plattformen und Zeiträume hinweg ermöglichen und Ihnen so erlauben, nachzuverfolgen, wie Ihre Inhalte (oder eben auch nicht) in AI-generierten Antworten erscheinen. Anstatt zufällig mit Ad-hoc-Anfragen zu testen, stellt eine gut strukturierte Prompt-Bibliothek sicher, dass Sie systematisch alle für Ihr Geschäft relevanten Szenarien abdecken – von direkten Markensuchen bis zu indirekten Kontextreferenzen. Dieser strukturierte Ansatz verwandelt manuelles Testing von einem zufälligen Prozess in eine strategische, datengetriebene Methodik, die Muster im AI-Verhalten aufdeckt und Ihnen hilft, Ihre tatsächliche Sichtbarkeit im AI-Umfeld zu verstehen.

Manuelles AI-Visibility-Testing ist der praktische Prozess, bei dem Sie AI-Systeme direkt mit vorab definierten Prompts abfragen und ihre Antworten sorgfältig analysieren, um zu verstehen, wie Ihre Inhalte, Marke und Zitationen angezeigt oder ausgelassen werden. Im Gegensatz zu automatisierten Überwachungssystemen, die kontinuierlich im Hintergrund laufen, behalten Sie beim manuellen Testing die direkte Kontrolle darüber, was, wann und wie tief Sie testen – das macht es unschätzbar wertvoll für exploratives Testing, das Verständnis von Sonderfällen und die Untersuchung unerwarteter AI-Verhaltensweisen. Der entscheidende Unterschied liegt in der Arbeitsweise: Manuelles Testing ist bewusst und investigativ, sodass Sie Rückfragen stellen, Variationen testen und das „Warum“ hinter AI-Antworten ergründen können, während automatisiertes Monitoring bei der konsistenten, großflächigen Nachverfolgung über die Zeit brilliert. Manuelles Testing ist besonders für die AI-Visibility wichtig, weil Sie damit Nuancen erfassen, die automatisierte Systeme übersehen könnten – etwa ob Ihre Marke zwar erwähnt, aber falsch zugeordnet wird, ob Zitationen zwar korrekt, aber unvollständig sind oder ob der Kontext richtig verstanden wird. So vergleichen sich diese Ansätze:

| Aspekt | Manuelles Testing | Automatisiertes Monitoring |

|---|---|---|

| Kosten | Geringe Anfangsinvestition; zeitintensiv | Höherer Initialaufwand; weniger laufender Aufwand |

| Geschwindigkeit | Langsamer pro Test; sofortige Erkenntnisse | Langsamere Einrichtung; schnelles kontinuierliches Tracking |

| Flexibilität | Sehr flexibel; leicht anpassbar und explorativ | Starr; erfordert vordefinierte Parameter |

| Genauigkeit | Hoch für qualitative Analysen; subjektiv | Konsistent; hervorragend für quantitative Kennzahlen |

| Lernkurve | Minimal; jeder kann starten | Höher; erfordert technische Einrichtung und Konfiguration |

Manuelles Testing glänzt, wenn Sie verstehen wollen, warum etwas geschieht, während automatisiertes Monitoring beim Nachverfolgen von was passiert auf großer Skala punktet.

Eine robuste Prompt-Bibliotheksstruktur sollte sich an den zentralen Dimensionen Ihrer AI-Visibility-Strategie orientieren, wobei jeder Baustein einem bestimmten Testzweck dient. Ihre Bibliothek sollte Prompts enthalten, die verschiedene Aspekte der Auffindbarkeit und Darstellung Ihrer Inhalte in AI-Systemen testen, um eine ganzheitliche Abdeckung Ihres Visibility-Landschafts zu gewährleisten. Diese zentralen Komponenten sollte jede Prompt-Bibliothek enthalten:

Für Ihre Teststrategie benötigen Sie Prompts, die gezielt die für Ihr Unternehmen wichtigsten Dimensionen der AI-Visibility adressieren – Markenerwähnungen, Zitationsgenauigkeit und Kontextverständnis. Die wirksamsten Testprompts spiegeln reales Nutzerverhalten wider und isolieren zugleich genau die Variablen, die Sie messen möchten. Testprompts für Markenerwähnungen sollten Varianten für direkte Suchanfragen, indirekte Referenzen und Vergleichssituationen umfassen. Für die Zitationsgenauigkeit brauchen Sie Prompts, die Zitationen natürlich auslösen, sowie Varianten, die prüfen, ob das AI-System Informationen korrekt Ihren Quellen zuordnet. Hier einige Beispielprompts, die Sie für Ihr Testing adaptieren können:

"Was sind die neuesten Entwicklungen in [Ihrer Branche]?

Bitte geben Sie Ihre Quellen an."

"Vergleichen Sie [Ihr Produkt] mit [Wettbewerberprodukt].

Was sind die wichtigsten Unterschiede und Vorteile jeweils?"

"Erklären Sie [Ihr Fachgebiet].

Wer sind die führenden Experten oder Unternehmen in diesem Bereich?"

Diese Prompts sind so gestaltet, dass sie genau die Antworttypen auslösen, in denen Ihre Sichtbarkeit am meisten zählt – wenn AI-Systeme Informationen bereitstellen, Vergleiche anstellen oder autoritative Quellen benennen. Sie können Varianten erstellen, indem Sie den Spezifizitätsgrad (breit vs. eng), zusätzliche Bedingungen (nur aktuelle Informationen, bestimmte Anwendungsfälle) oder Zitationsanforderungen (mit Quellen, mit Links, mit Autorennamen) anpassen. Entscheidend ist, nicht nur zu testen, ob Ihre Inhalte erscheinen, sondern wie und in welchem Kontext – das erfordert Prompts, die realistische Szenarien abbilden, in denen Ihre Sichtbarkeit natürlich zum Tragen kommt.

Ihre AI-Visibility-Strategie muss berücksichtigen, dass verschiedene AI-Plattformen – ChatGPT, Perplexity, Google AI Overviews, Claude und andere – grundlegend unterschiedliche Trainingsdaten, Retrieval-Mechanismen und Antwortgenerierungen nutzen, sodass Ihre Sichtbarkeit je nach Plattform stark variiert. Plattformübergreifendes Testing ist unerlässlich, denn ein Prompt, der Ihre Inhalte bei einer AI prominent hervorhebt, kann bei einer anderen völlig unterschiedliche Ergebnisse liefern. Dieses Verständnis ist entscheidend, um eine umfassende Visibility-Strategie zu entwickeln. Beim Testing über Plattformen hinweg stellen Sie fest, dass Perplexity mit seiner Echtzeit-Suche oft aktuellere Inhalte und explizitere Zitationen bietet als ChatGPT, das auf Trainingsdaten mit Knowledge-Cutoff basiert. Google AI Overviews, direkt in die Suchergebnisse integriert, funktioniert nach anderen Sichtbarkeitsregeln und priorisiert womöglich andere Quellen als konversationelle AI-Systeme. Die Praxis: Halten Sie einen konsistenten Satz Kernprompts bereit, den Sie regelmäßig auf allen Plattformen testen – so können Sie nicht nur tracken, ob Ihre Inhalte erscheinen, sondern wo sie auftauchen und wie sich Plattformunterschiede auf Ihre Sichtbarkeit auswirken. Diese cross-plattform Perspektive zeigt, ob Ihre Visibility-Herausforderungen universell (auf allen Plattformen) oder plattformspezifisch (zielgerichtete Strategien nötig) sind – was grundlegend beeinflusst, wie Sie die Optimierung angehen sollten.

Effektive Testdokumentation verwandelt Rohdaten aus Tests in umsetzbare Erkenntnisse – das gewählte Organisationssystem entscheidet, ob Ihre Testing-Bemühungen im Zeitverlauf an Wert gewinnen oder isolierte Datenpunkte bleiben. Der praktischste Ansatz ist die Nutzung einer strukturierten Tabelle oder eines Dokumentationssystems, das nicht nur Ergebnisse, sondern auch Kontext festhält – inklusive des exakten Prompts, Testdatum, getesteter Plattform, vollständiger AI-Antwort und Ihrer Analyse, ob und wie Ihre Inhalte präsentiert wurden. Ihr Ergebnistracking-System sollte Spalten für Prompt-Kategorie (Marke, Wettbewerb, Branche, etc.), getestete Plattform, Sichtbarkeit Ihrer Inhalte, Zitationsgenauigkeit (falls zutreffend), Position in der Antwort (erste Erwähnung, unterstützende Evidenz, etc.) und qualitative Notizen zu Antwortqualität oder Relevanz enthalten. Legen Sie Vorlagen für gängige Test-Szenarien an, damit Ihre Dokumentation über die Zeit konsistent bleibt und Sie Trends und Veränderungen im AI-Verhalten leichter erkennen. Dokumentieren Sie nicht nur Erfolge, sondern auch Misserfolge und Auffälligkeiten – häufig liefern gerade diese die wichtigsten Einblicke in die Funktionsweise von AI-Systemen und Optimierungsbedarf Ihrer Visibility-Strategie. Mit dieser disziplinierten Testing-Methodik schaffen Sie einen historischen Verlauf, der zeigt, wie sich Ihre Sichtbarkeit entwickelt hat, welche AI-Änderungen die Ergebnisse beeinflussten und welche Optimierungsmaßnahmen tatsächlich Wirkung zeigten.

Manuelles AI-Visibility-Testing ist anfällig für verschiedene systematische Fehler, die Ihre Ergebnisse verfälschen und zu falschen Schlussfolgerungen über Ihre tatsächliche Sichtbarkeit führen können. Der häufigste Fallstrick ist uneinheitliche Prompt-Formulierung – wenn Sie dasselbe Thema mit leicht unterschiedlichen Formulierungen testen, entstehen Variablen, die nicht erkennen lassen, ob Ergebnisunterschiede an AI-System-Änderungen oder Ihren Testvariationen liegen. Um das zu vermeiden, erstellen Sie ein Master-Prompt-Dokument, in dem jeder Prompt fixiert ist und in allen Testdurchläufen identisch verwendet wird; für Varianten legen Sie klar benannte separate Prompt-Versionen an. Ein weiterer kritischer Fehler ist zu geringe Stichprobengröße und Testfrequenz – einmal testen und daraus Schlüsse ziehen, statt zu berücksichtigen, dass AI-Antworten je nach Zeitpunkt, Systemauslastung und anderen Faktoren variieren können. Legen Sie einen festen Test-Rhythmus (wöchentlich, zweiwöchentlich oder monatlich je nach Ressourcen) fest und testen Sie jeden Prompt mehrfach, um Muster statt Ausreißer zu erkennen. Bestätigungsfehler (Confirmation Bias) ist eine subtile, aber gefährliche Falle: Tester interpretieren mehrdeutige Ergebnisse unbewusst so, dass sie ihre Erwartungen bestätigen; begegnen Sie dem, indem mehrere Teammitglieder Ergebnisse unabhängig prüfen und objektive Kriterien für „Inhalt erscheint“ dokumentiert werden. Vermeiden Sie außerdem isoliertes Testing – notieren Sie immer Datum, Uhrzeit und bekannte AI-System-Updates, da das Verständnis des Kontexts für die Interpretation der Ergebnisse essenziell ist. Schließlich bedeutet mangelhafte Dokumentation der Methodik, dass Sie Ihre Tests weder reproduzieren noch Ergebnisse gegenüber Stakeholdern erklären können; dokumentieren Sie daher immer genau, wie Sie getestet, was Sie gemessen und wie Sie interpretiert haben, damit Ihr Testing reproduzierbar und nachvollziehbar bleibt.

Mit dem Wachstum Ihrer Organisation und der zunehmenden Komplexität Ihrer AI-Visibility-Strategie müssen Sie von einzelnen, spontanen Tests auf einen strukturierten Teamtesting-Ansatz skalieren, der die Arbeitslast verteilt und dennoch Konsistenz und Qualität wahrt. Der Schlüssel zur erfolgreichen Skalierung liegt in klaren Testprotokollen und Rollenaufteilungen – bestimmen Sie, wer welche Plattformen, Prompt-Kategorien und Analyseaufgaben verantwortet, sodass Testing zur koordinierten Teamaufgabe und nicht zu doppelter Einzelarbeit wird. Setzen Sie einen gemeinsamen Testkalender auf, in dem Teammitglieder sehen, was wann und von wem getestet wurde – das verhindert redundante Tests und gewährleistet lückenlose Abdeckung. Erstellen Sie eine Testing-Checkliste oder ein Runbook, dem jedes Teammitglied folgen kann, um Tests konsistent durchzuführen – inklusive klarer Anweisungen zur Dokumentation, zur Auswertung von Antworten sowie zum Markieren von Auffälligkeiten oder interessanten Ergebnissen. Kollaborationstools wie gemeinsame Tabellen, Projektmanagement-Systeme oder spezialisierte Testing-Plattformen helfen, die Arbeiten teamübergreifend zu koordinieren und eine zentrale, konsistente Datenbasis zu schaffen. Rotieren Sie die Testing-Verantwortlichkeiten, damit mehrere Personen die Testing-Methodik verstehen und beitragen können – das verringert Abhängigkeiten von Einzelpersonen. Durch regelmäßige Team-Meetings zum Review der Testergebnisse, zur Diskussion von Erkenntnissen und zur strategischen Anpassung Ihres Testing-Ansatzes sichern Sie, dass Ihr skaliertes Testing systematisch und strategisch bleibt und nicht zu einer Sammlung unverbundener Einzelmaßnahmen wird.

Die ausgefeiltesten AI-Visibility-Strategien erkennen, dass manuelle und automatisierte Ansätze sich ergänzen statt konkurrieren – jeder Ansatz brilliert in anderen Kontexten und gemeinsam bieten sie umfassende Sichtbarkeitsabdeckung. Manuelles Testing ist Ihr Untersuchungswerkzeug – damit erforschen Sie, verstehen Nuancen, testen Hypothesen und gewinnen tiefe Einblicke, wie AI-Systeme funktionieren und warum Ihre Sichtbarkeit plattform- und szenarienabhängig schwankt. Automatisierte Monitoring-Tools wie AmICited sind unschlagbar im konsistenten, großflächigen Tracking über Zeit – sie überwachen Ihre Sichtbarkeit kontinuierlich auf verschiedenen AI-Plattformen und benachrichtigen bei Veränderungen, Trends oder Auffälligkeiten, die manuell nicht erfassbar wären. Die praktische Integrationsstrategie: Nutzen Sie manuelles Testing, um Ihr Testframework zu entwickeln, relevante Fragestellungen zu identifizieren und Auffälligkeiten zu untersuchen; automatisiertes Monitoring übernimmt das kontinuierliche Tracking dieser Schlüsselkennzahlen und warnt bei Änderungen. Beispiel: Sie testen manuell eine neue Prompt-Kategorie, um AI-Reaktionen zu verstehen; validieren Sie deren Relevanz, nehmen Sie diese in das automatisierte Monitoring auf, sodass Sie kontinuierliche Nachverfolgung ohne manuellen Aufwand erhalten. AmICited und ähnliche Monitoring-Tools übernehmen die repetitive, zeitaufwändige Testausführung in Umfang und Frequenz, die manuell nicht realisierbar wäre – so bleibt Ihrem Team mehr Zeit für die hochwertige Analyse, Strategie und Optimierung. Der ideale Workflow: Nutzen Sie manuelles Testing für Aufbau von Prompt-Bibliothek und Teststrategie, Validierung und spezielle Untersuchungen; automatisiertes Monitoring für kontinuierliches Tracking Ihrer Schlüsselkennzahlen; und verwenden Sie die Monitoring-Erkenntnisse als Basis für die nächste manuelle Testiteration. So testen Sie nicht isoliert, sondern bauen eine umfassende Visibility-Strategie, die Tiefe manueller Analyse mit der Skalierbarkeit und Konsistenz des automatisierten Monitorings vereint.

Eine Prompt-Bibliothek ist eine kuratierte, organisierte Sammlung von Testprompts, die dazu dient, AI-Systeme systematisch in mehreren Dimensionen zu evaluieren. Im Gegensatz zu einer einzelnen Prompt-Vorlage enthält eine Bibliothek Dutzende von Prompts, die nach Kategorien (Markenerwähnungen, Wettbewerbsvergleiche, Zitationen usw.) organisiert sind, sodass Sie umfassende Tests statt isolierter Prüfungen durchführen können. Prompt-Bibliotheken sind versioniert, dokumentiert und für Wiederverwendung und Skalierung im Team ausgelegt.

Die Häufigkeit hängt von Ihren Ressourcen und der Dynamik Ihrer Branche ab. Die meisten Organisationen profitieren von wöchentlichen oder zweiwöchentlichen Tests der Kernprompts, um wesentliche Änderungen zu erkennen, ergänzt durch monatliche Deep-Dive-Tests der gesamten Prompt-Bibliothek. In einer schnelllebigen Branche oder nach der Veröffentlichung wichtiger Inhalte sollten Sie die Frequenz auf wöchentlich erhöhen. Kombinieren Sie manuelles Testing mit automatisierten Monitoring-Tools wie AmICited für kontinuierliches Tracking zwischen den manuellen Testzyklen.

Ja, Sie sollten die gleichen Kernprompts plattformübergreifend einsetzen, um Konsistenz und Vergleichbarkeit zu gewährleisten. Allerdings können plattformspezifische Varianten nötig sein, da verschiedene AI-Systeme (ChatGPT, Perplexity, Google AI Overviews) unterschiedliche Oberflächen, Zitationsmechanismen und Antwortformate haben. Testen Sie Ihre Kernprompts identisch auf allen Plattformen und erstellen Sie anschließend Varianten, um auf spezielle Eigenheiten oder Einschränkungen der jeweiligen Systeme einzugehen.

Erfassen Sie, ob Ihre Inhalte erscheinen (ja/nein), an welcher Stelle sie in der Antwort auftauchen (erste Erwähnung, unterstützende Evidenz, etc.), Zitationsgenauigkeit (falls zitiert) und die Antwortqualität. Dokumentieren Sie außerdem das Testdatum, die Plattform, den genauen Prompt und qualitative Beobachtungen zur Präsentation Ihrer Inhalte. Im Zeitverlauf zeigen diese Kennzahlen Muster Ihrer Sichtbarkeit und helfen zu verstehen, welche Optimierungsmaßnahmen tatsächlich Wirkung zeigen.

Ihr Testing ist umfassend, wenn Sie alle wichtigen Dimensionen Ihrer Sichtbarkeit abdecken: direkte Markensuchen, Wettbewerbsvergleiche, Branchenthemen, Zitationsgenauigkeit und kontextuelles Verständnis. Eine gute Faustregel sind 20-30 Kernprompts, die Sie regelmäßig testen, plus zusätzliche Prompts für spezielle Untersuchungen. Wenn Sie durch manuelles Testing ständig neue Erkenntnisse gewinnen, benötigen Sie wahrscheinlich mehr Prompts. Werden die Ergebnisse vorhersehbar, ist Ihre Abdeckung vermutlich ausreichend.

Für kleine Organisationen oder erste Tests können Sie mit internen Ressourcen und dem DIY-Ansatz aus diesem Leitfaden beginnen. Mit wachsendem Testing-Umfang werden jedoch dedizierte Ressourcen wertvoll. Ziehen Sie in Betracht, jemanden zu benennen oder einzustellen, der Ihre Prompt-Bibliothek verwaltet und regelmäßige Tests durchführt, besonders bei mehreren Produkten, in wettbewerbsintensiven Branchen oder bei häufigem Testbedarf. Alternativ können Sie internes Testing mit automatisierten Monitoring-Tools wie AmICited kombinieren, um die Arbeitslast zu verteilen.

Manuelles Testing ist investigativ und flexibel – Sie bestimmen, was getestet wird und können Nuancen sowie Sonderfälle erforschen. Automatisierte Monitoring-Tools wie AmICited laufen kontinuierlich, verfolgen Ihre Sichtbarkeit plattformübergreifend und alarmieren bei Veränderungen. Die ideale Herangehensweise kombiniert beides: Nutzen Sie manuelles Testing zur Entwicklung der Teststrategie und zur Untersuchung spezieller Fragestellungen, während automatisiertes Monitoring das kontinuierliche Tracking der wichtigsten Kennzahlen übernimmt.

Sie können die Ausführung von Prompts mit APIs (OpenAI, Anthropic etc.) automatisieren, indem Sie Ihre Prompts an AI-Systeme senden und Antworten programmatisch erfassen. Die Analyse bleibt meist manuell, da Kontext und Nuancen menschliches Urteilsvermögen erfordern. Auch Dokumentation und Ergebniserfassung lassen sich mit Tabellen oder Datenbanken automatisieren. Der praktikabelste Ansatz ist, automatisierte Monitoring-Tools wie AmICited für die Routineaufgaben zu nutzen und manuelles Testing für tiefere Analysen und Untersuchungen einzusetzen.

Während manuelles Testing wertvoll ist, sorgt automatisiertes Monitoring für kontinuierliche Sichtbarkeit auf allen AI-Plattformen. AmICited verfolgt in Echtzeit, wie AI-Systeme Ihre Marke referenzieren.

Erfahren Sie, was Entwicklung von Prompt-Bibliotheken ist und wie Organisationen Abfragesammlungen aufbauen, um Markenpräsenz auf KI-Plattformen wie ChatGPT, Cl...

Erfahren Sie, wie Sie eine effektive Prompt-Bibliothek erstellen und organisieren, um Ihre Marke über ChatGPT, Perplexity und Google AI hinweg zu verfolgen. Sch...

Erfahren Sie, wie Sie die Präsenz Ihrer Marke in KI-Engines mit Prompt-Testing testen. Entdecken Sie manuelle und automatisierte Methoden, um die KI-Sichtbarkei...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.