Aufbau einer Prompt-Bibliothek für AI-Sichtbarkeits-Tracking

Erfahren Sie, wie Sie eine effektive Prompt-Bibliothek erstellen und organisieren, um Ihre Marke über ChatGPT, Perplexity und Google AI hinweg zu verfolgen. Sch...

Erfahren Sie, wie Sie effektive Prompt-Forschung für KI-Sichtbarkeit durchführen. Entdecken Sie die Methodik zum Verständnis von Nutzeranfragen in LLMs und zur Nachverfolgung Ihrer Marke in ChatGPT, Perplexity und Google AI Overviews.

Da große Sprachmodelle (LLMs) zunehmend in die Informationssuche der Nutzer integriert werden, ist KI-Sichtbarkeit zu einer entscheidenden Ergänzung der klassischen Suchmaschinenoptimierung geworden. Während Suchmaschinensichtbarkeit darauf abzielt, für Keywords bei Google, Bing und anderen Suchmaschinen zu ranken, adressiert KI-Sichtbarkeit, wie Ihre Marke, Produkte und Inhalte in Antworten von ChatGPT, Claude, Gemini und anderen KI-Systemen erscheinen. Im Gegensatz zu traditionellen Keywords mit messbarem Suchvolumen und vorhersehbaren Mustern sind Prompts von Natur aus konversationell, kontextabhängig und oft sehr spezifisch für individuelle Nutzerbedürfnisse. Zu verstehen, bei welchen Prompts Ihre Marke erscheint – und bei welchen nicht – ist essenziell, um in einer KI-getriebenen Informationslandschaft relevant zu bleiben. Aktuelle Daten zeigen, dass inzwischen über 40 % der Internetnutzer wöchentlich mit LLMs interagieren, mit zunehmender Verbreitung über alle Demografien und Branchen hinweg. Ohne Einblick in die Prompts, die Ihre Markennennung oder Wettbewerbspositionierung auslösen, bewegen Sie sich blind in einem Kanal, der zunehmend Kaufentscheidungen, Markenwahrnehmung und Kundenvertrauen beeinflusst.

Prompts lassen sich systematisch in fünf verschiedene Typen einteilen, die jeweils eigene Merkmale und geschäftliche Relevanz besitzen. Das Verständnis dieser Kategorien hilft Unternehmen zu priorisieren, welche Prompts überwacht werden sollten und wie man jede Kategorie optimiert.

| Prompt-Typ | Beschreibung | Beispielanfrage | Geschäftliche Auswirkung |

|---|---|---|---|

| Direkte Markenanfragen | Explizite Nennung Ihres Unternehmens, Produkts oder Markennamens | „Was sind die Funktionen von Slack?“ oder „Wie schneidet Salesforce im Vergleich zu HubSpot ab?“ | Kritisch für Markensteuerung; beeinflusst direkt Markenwahrnehmung und Wettbewerbsposition |

| Kategorie-/Lösungsanfragen | Fragen zu Produktkategorien oder Lösungstypen ohne Markennennung | „Was ist die beste Projektmanagement-Software?“ oder „Wie richte ich E-Mail-Marketing-Automatisierung ein?“ | Deckt Lücken im Marktverständnis auf; Chancen, in Lösungsvergleichen aufzutauchen |

| Problemlösungsanfragen | Nutzerfragen zur Lösung spezifischer Probleme oder Anwendungsfälle | „Wie kann ich die Teamzusammenarbeit verbessern?“ oder „Wie kann ich Kundeninteraktionen am besten verfolgen?“ | Weist auf Chancen mit hoher Intention hin; zeigt, wo Ihre Lösung echte Probleme adressiert |

| Vergleichsanfragen | Anfragen zum Vergleich mehrerer Lösungen oder Ansätze | „Vergleiche Asana vs Monday.com vs Jira“ oder „Was ist besser für Startups: Shopify oder WooCommerce?“ | Bestimmt Wettbewerbs-Sichtbarkeit; entscheidend, um bei Alternativen in die engere Auswahl zu kommen |

| How-to- und Bildungsanfragen | Anfragen nach Anleitungen, Tutorials oder erklärenden Inhalten | „Wie automatisiere ich meine Vertriebspipeline?“ oder „Was ist Customer Relationship Management?“ | Baut Autorität und Vertrauen auf; positioniert Ihre Marke als Vordenker in Ihrer Branche |

Jede Kategorie erfordert unterschiedliche Content-Strategien und Monitoring-Ansätze. Direkte Markenanfragen benötigen sofortige Aufmerksamkeit für eine korrekte Darstellung, während Problemlösungsanfragen die Chance bieten, Lösungskompetenz zu zeigen, bevor Wettbewerber genannt werden.

Die für Ihr Unternehmen relevanten Prompts zu identifizieren, verlangt einen vielseitigen Ansatz aus Nutzerforschung, Wettbewerbsanalyse und technischer Überwachung. Sieben umsetzbare Methoden zur Identifizierung von Prompts:

Kundeninterview-Analyse: Führen Sie strukturierte Interviews mit Kunden und Interessenten und zeichnen Sie die exakte Sprache auf, mit der sie Probleme, Lösungen und Entscheidungsfaktoren beschreiben. Transkribieren Sie diese Gespräche und extrahieren Sie wiederkehrende Formulierungen und Fragemuster, die zeigen, wie echte Nutzer über Ihre Kategorie denken. So identifizieren Sie authentische, hochintentionale Prompts, die in klassischer Keyword-Recherche oft fehlen.

Support-Ticket-Analyse: Analysieren Sie Ihr Kundensupport-System (z. B. Zendesk, Intercom), um die häufigsten Fragen sowie deren Formulierungen zu ermitteln. Support-Tickets spiegeln echte Nutzungsprobleme und Informationsbedarfe wider und sind damit wahre Fundgruben für die Prompt-Entdeckung. Kategorisieren und taggen Sie diese Fragen, um Muster und Prioritäten zu erkennen.

Wettbewerber-Prompt-Reverse-Engineering: Testen Sie manuell Wettbewerbernamen und -produkte in ChatGPT, Claude und Gemini und dokumentieren Sie, wie sie in den Antworten erscheinen und durch welche Prompts sie prominent werden. So erhalten Sie Einblick in die Wettbewerbslandschaft und sehen, bei welchen Prompts Sie aktuell verlieren. Notieren Sie die exakten Positionierungsformulierungen, die KI-Antworten zu Wettbewerbern nutzen.

Social Listening und Community-Monitoring: Überwachen Sie Reddit, Twitter, Discord, Slack-Communities und Branchenforen, in denen Ihre Zielgruppe Probleme und Lösungen diskutiert. Extrahieren Sie die exakte Nutzersprache für Fragen oder Bedarfsbeschreibungen. Diese Communities enthalten oft ungefilterte, authentische Prompts, die echte Nutzerintention widerspiegeln.

Suchanfragen-Expansion: Nutzen Sie klassische SEO-Tools (SEMrush, Ahrefs, Moz), um Suchanfragen mit hohem Volumen Ihrer Kategorie zu identifizieren und wandeln Sie diese in konversationelle Prompts um. Aus der Suchanfrage „bester CRM für kleine Unternehmen“ wird so beispielsweise der Prompt „Was ist das beste CRM für kleine Unternehmen?“. So schlagen Sie die Brücke von Ihrer Keyword-Recherche zur KI-Sichtbarkeit.

LLM-Natives Prompt-Testing: Testen Sie systematisch verschiedene Prompt-Varianten in mehreren LLMs und dokumentieren Sie, welche Versionen Ihre Marke hervorheben und welche nicht. Variieren Sie Formulierungen, Spezifität und Kontext. Erstellen Sie eine Testmatrix über Ihre wichtigsten Geschäftskategorien und verfolgen Sie, wie sich Antwortqualität und Markennennung verändern.

Input von Stakeholdern und Vertrieb: Binden Sie Vertriebs-, Marketing- und Produktteams ein, um Fragen zu dokumentieren, die Interessenten in Erstgesprächen stellen, Einwände sowie die Sprache, mit der Probleme beschrieben werden. Vertriebsteams haben direkten Einblick, wie Interessenten über Ihre Lösung und Alternativen denken. Fassen Sie diese Fragen in einer Master-Prompt-Liste zusammen, sortiert nach Verkaufsphase und Käuferpersona.

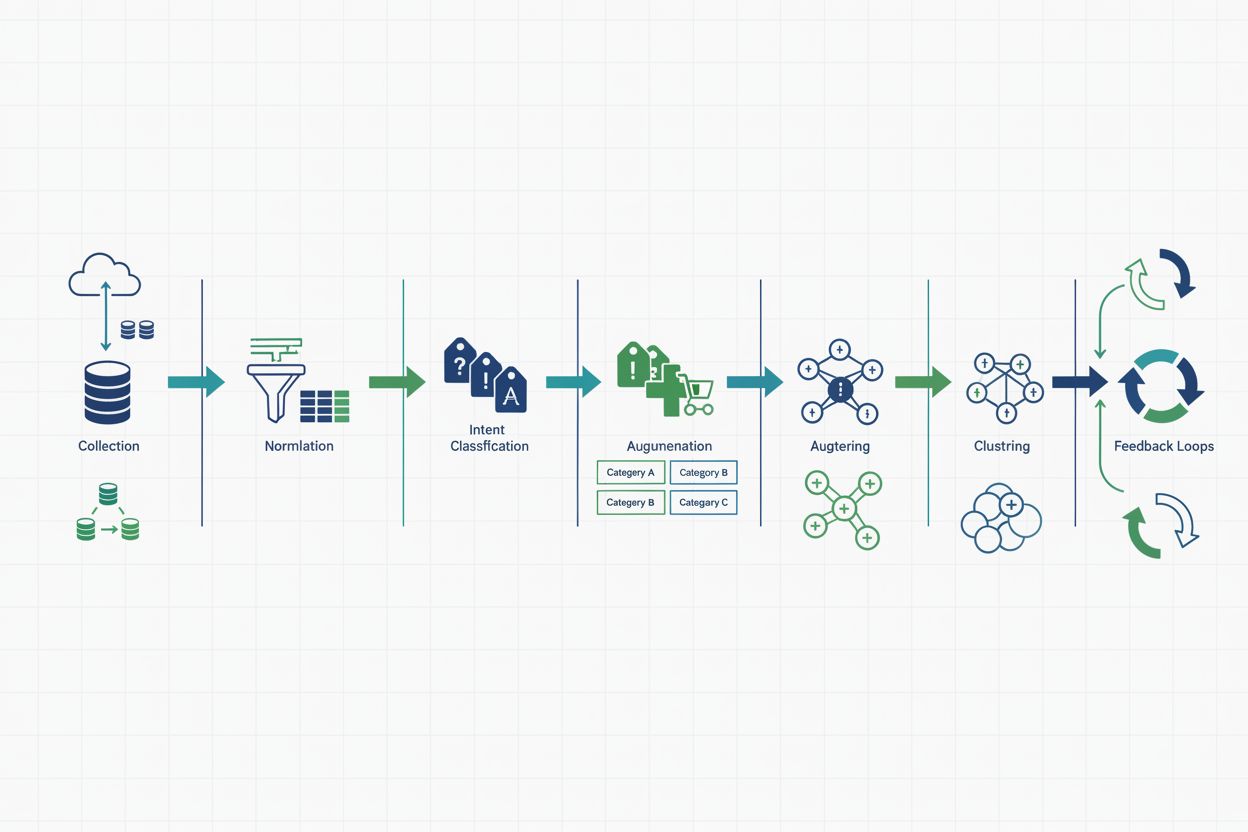

Effektive Prompt-Forschung benötigt einen strukturierten Lebenszyklus, der von der Rohdatensammlung bis hin zu umsetzbaren Erkenntnissen reicht. Der komplette LLM Query Analysis Lifecycle besteht aus sechs miteinander verbundenen Phasen: Erfassung und Governance legt fest, wie Prompts gesammelt, gespeichert und geschützt werden – unter Einhaltung von Datenschutz und interner Datenrichtlinien. Normalisierung standardisiert Roh-Prompts, entfernt Duplikate, korrigiert Tippfehler und fasst Varianten zu kanonischen Formen zusammen – z. B. gelten „ChatGPT“, „chat gpt“ und „openai chatgpt“ als dieselbe Entität. Intent-Klassifikation ordnet jeden Prompt einer vordefinierten Intent-Kategorie (Marke, Kategorie, Problemlösung, Vergleich, Bildung) zu – per manueller Prüfung und Machine-Learning-Modellen. Anreicherung ergänzt Prompts um Metadaten wie Quelle, Zeitstempel, Nutzersegment, LLM-Plattform und Antwortqualitätsmetriken. Clustering gruppiert ähnliche Prompts, um Themen, Trends und Prioritäten zu identifizieren. Schließlich verbinden Feedback-Loops die Erkenntnisse mit Produkt-, Content- und Marketingteams und ermöglichen kontinuierliche Verbesserung und Messung des Einflusses. Dieser Lebenszyklus verwandelt Rohdaten zu strategischer Intelligenz für Geschäftsentscheidungen.

Eine Intent-Taxonomie ist ein strukturiertes Rahmenwerk, das Prompts nach dem dahinterstehenden Nutzerbedürfnis oder Ziel einteilt. Über die fünf Prompt-Typen hinaus fügt die Intent-Taxonomie eine weitere Granularitätsebene hinzu, indem sie das jeweils angestrebte Geschäftsergebnis klassifiziert. Ein Prompt wie „Wie entscheide ich zwischen Salesforce und HubSpot?“ kann beispielsweise als Vergleichsintention (Prompt-Typ) mit Kaufintention (Geschäftsziel) klassifiziert werden – ein Hinweis auf eine wertvolle Gelegenheit, eine Kaufentscheidung zu beeinflussen. Weitere Intent-Klassifikationen sind Awareness-Intention (Nutzer recherchiert eine Kategorie), Troubleshooting-Intention (Nutzer hat ein Problem zu lösen), Validierungs-Intention (Nutzer bestätigt eine Entscheidung) und Erweiterungs-Intention (Bestandskunde prüft Zusatzfunktionen). Der Aufbau einer umfassenden Intent-Taxonomie erfordert Zusammenarbeit von Marketing, Vertrieb, Produkt und Customer Success – jeder bringt eigene Sichtweisen zu relevanten Prompts ein. Die Taxonomie ist die Basis für Priorisierung: Hochintentionale Prompts (z. B. mit Kauf- oder Problemlösungsdringlichkeit) verdienen sofortige Aufmerksamkeit und Optimierung, während Awareness-Stage-Prompts andere Content-Strategien erfordern können. Unternehmen, die eine Intent-Taxonomie implementieren, verbessern ihre Fähigkeit zur Priorisierung und Messung des Business-Impacts von Prompt-Forschung um 30–40 %.

Prompt-Forschung offenbart je nach Branche besondere Chancen und Herausforderungen mit eigenen Wettbewerbsdynamiken und Nutzerverhalten. Im E-Commerce beeinflussen Prompts wie „Welches ist das beste Laptop für Video-Editing unter 1.500 $?“ oder „Wie entscheide ich mich zwischen Nike- und Adidas-Laufschuhen?“ direkt die Kaufentscheidung; Marken, die in solchen Vergleichsprompts erscheinen, erzielen nachweislich mehr Traffic und Conversions. SaaS-Unternehmen profitieren vom Tracking von Problemlösungs-Prompts wie „Wie automatisiere ich mein E-Mail-Marketing?“ oder „Wie managt man Remote-Team-Projekte am besten?“ – wer hier in den Antworten auftaucht, positioniert seine Lösung als natürliche Antwort auf Kundenprobleme. Kundensupport-Organisationen nutzen Prompt-Forschung, um die häufigsten Fragen zu identifizieren, die Nutzer an LLMs stellen, bevor sie den Support kontaktieren. So können proaktiv Inhalte erstellt werden, die das Supportvolumen reduzieren – taucht z. B. „Wie setze ich mein Passwort zurück?“ häufig als Prompt auf, sorgt eine klare Doku dafür, dass Nutzer Antworten direkt in KI-Antworten finden. Regulierte Branchen (Finanzen, Gesundheit, Recht) müssen Prompts überwachen, um sicherzustellen, dass KI-Systeme korrekte, compliance-konforme Informationen liefern; eine Bank könnte feststellen, dass Prompts zu Hypothekenzinsen veraltete Infos liefern, was sofortige Kontaktaufnahme mit LLM-Anbietern erfordert. Marketing- und SEO-Agenturen nutzen Prompt-Forschung, um neue Content-Chancen und Wettbewerbslücken zu identifizieren; das Tracking zeigt, welche Themen in KI-Konversationen anziehen, bevor sie zu Mainstream-Suchtrends werden. Über alle Branchen hinweg wird Prompt-Forschung vom Monitoring zum strategischen Vorteil, wenn Unternehmen systematisch tracken, analysieren und handeln.

Effektive Prompt-Forschung im großen Maßstab verlangt eine technische Architektur, die Anfragen effizient sammelt, verarbeitet und analysiert. Die Architektur besteht meist aus vier Kernkomponenten: Event Collection-Systeme erfassen Prompts aus verschiedenen Quellen (Kundeninteraktionen, Support-Tickets, Social Listening, manuelles Testing) und leiten sie in eine zentrale Datenpipeline. Ein Data Warehouse (Snowflake, BigQuery, Redshift) speichert normalisierte Prompts mit umfangreichen Metadaten wie Quelle, Zeitstempel, Nutzersegment, LLM-Plattform und Antwortmerkmalen. Batch Processing-Jobs laufen nächtlich oder wöchentlich, um Intent-Klassifikation, Clustering und Trendanalysen per Regelwerk und Machine Learning durchzuführen. Real-Time Classification-Systeme markieren besonders wichtige Prompts (Wettbewerbsbedrohungen, Markennennungen, kritische Probleme) sofort und ermöglichen so schnelle Reaktionen. Wichtige Metriken sind Markennennungsrate (Anteil der Kategorietprompts mit Markennennung), Intent-Verteilung (Aufschlüsselung nach Intent-Typ), Wettbewerbspositionierung (wie oft Ihre Marke in Vergleichsprompts im Verhältnis zum Wettbewerb erscheint), Emerging Topics (neue Prompts mit wachsender Relevanz) und Antwortqualität (Genauigkeit und Relevanz der KI-Antworten mit Markenbezug). Dashboards sollten diese Metriken nach Geschäftsbereich, Produktlinie und Kundensegment aufschlüsseln, damit Stakeholder Chancen erkennen und Fortschritte Richtung Sichtbarkeitsziele verfolgen können.

Mit wachsender Prompt-Forschung gewinnt der Schutz der Privatsphäre und die Einhaltung ethischer Standards an Bedeutung. Nach dem Prinzip der Datenminimierung sollten Sie nur die für Ihre Analyse notwendigen Prompts erfassen und auf die Erhebung unnötiger Kontexte oder persönlicher Informationen verzichten. Bei der Sammlung von Prompts aus Kundeninteraktionen implementieren Sie eine PII-Erkennung und -Schwärzung (Persönlich identifizierbare Informationen), um Namen, E-Mail-Adressen, Telefonnummern und weitere sensible Daten automatisch vor der Speicherung zu entfernen. Retention Policies sollten klar regeln, wie lange Prompts gespeichert werden – viele Unternehmen wählen ein 12-monatiges Aufbewahrungsfenster und löschen ältere Daten, sofern kein geschäftlicher Grund für längere Aufbewahrung besteht. Zugriffskontrollen stellen sicher, dass nur autorisierte Teammitglieder Rohdaten einsehen können, wobei rollenbasierte Rechte den Zugriff nach Funktion und Notwendigkeit einschränken. Transparenz gegenüber Nutzern ist essenziell; wenn Sie Prompts aus Kundeninteraktionen sammeln, kommunizieren Sie dies klar in Datenschutzbestimmungen und AGB. Verantwortungsvolles Query Mining bedeutet auch, Manipulation oder Missbrauch von LLM-Systemen zu unterlassen – Ziel ist das Verstehen echter Nutzerbedürfnisse und die Optimierung der eigenen Präsenz, nicht die Ausnutzung von Schwachstellen oder Prompt-Injection-Attacken. Unternehmen, die Datenschutz und Ethik in der Prompt-Forschung priorisieren, stärken das Kundenvertrauen und mindern regulatorische Risiken.

Prompt-Entdeckung ist nur dann wertvoll, wenn daraus konkrete Maßnahmen und messbarer Einfluss entstehen. Feedback-Loops schließen heißt, klare Prozesse zu etablieren, wie Forschungsergebnisse bei Entscheidern landen und Veränderungen bewirken: Wenn die Analyse zeigt, dass ein Wettbewerber in 60 % der Vergleichsprompts genannt wird, Ihre Marke aber nur in 20 %, muss dies Content-Erstellung, Produktpositionierung oder Vertriebsinitiativen auslösen. Cross-Functional Alignment erfordert regelmäßige Abstimmung zwischen Marketing, Produkt, Vertrieb und Customer Success; monatliche oder quartalsweise Reviews der Prompt-Forschung stellen sicher, dass Erkenntnisse in die Strategie einfließen. Impact-Messung bedeutet, Frühindikatoren (Markennennungsrate, Intent-Verteilung, Antwortqualität) und Spätindikatoren (Traffic aus KI-Quellen, Conversion Rates, Kundenakquisitionskosten) zu verfolgen, um den Geschäftsnutzen zu quantifizieren. Beginnen Sie mit Quick Wins: Identifizieren Sie 5–10 wichtige Prompts, bei denen Ihre Marke unterrepräsentiert ist, und erstellen Sie gezielte Inhalte oder Kampagnen, um die Sichtbarkeit zu steigern. Legen Sie eine Prompt-Forschungs-Roadmap an, die Optimierungsmaßnahmen nach Business-Potenzial und Umsetzbarkeit priorisiert und Ressourcen auf die wichtigsten Prompts bündelt. Begreifen Sie Prompt-Forschung schließlich als kontinuierliche Disziplin, nicht als Einmalprojekt – mit der Entwicklung von LLMs und Veränderungen im Nutzerverhalten müssen sich auch Tracking und Optimierungsstrategien stetig weiterentwickeln. Unternehmen, die Prompt-Forschung als festen Bestandteil ihrer Sichtbarkeitsstrategie – neben SEO, Paid Search und Social Media – etablieren, sind bestens aufgestellt, um in einer KI-getriebenen Informationslandschaft erfolgreich zu sein.

Die Keyword-Recherche konzentriert sich auf Suchvolumen und Ranking-Schwierigkeit von Begriffen, die in Suchmaschinen verwendet werden, während die Prompt-Forschung die konversationellen, kontextabhängigen Anfragen untersucht, die Nutzer an LLMs stellen. Prompts sind in der Regel länger, spezifischer und haben kein messbares Suchvolumen. Prompt-Forschung erfordert das Verständnis der Nutzerintention in KI-Gesprächen, anstatt für Suchmaschinen-Algorithmen zu optimieren.

Überprüfen und aktualisieren Sie Ihre Prompt-Tracking-Liste vierteljährlich, da sich das Nutzerverhalten und die Fähigkeiten von LLMs weiterentwickeln. Überwachen Sie jedoch wöchentliche Echtzeit-Metriken, um aufkommende Trends oder Wettbewerbsbedrohungen frühzeitig zu erkennen. Beginnen Sie mit 20–30 Kernprompts und erweitern Sie diese auf Basis von Leistungsdaten und geschäftlichen Prioritäten.

Starten Sie mit ChatGPT (größte Nutzerbasis), Perplexity (KI-native Suche) und Google AI Overviews (in die Suche integriert). Erweitern Sie dann auf Claude, Gemini und weitere aufstrebende Plattformen, abhängig von Ihrer Zielgruppendemografie und Branche. Unterschiedliche Plattformen stellen Ihre Marke unterschiedlich dar, daher ist ein umfassendes Monitoring über mehrere Plattformen ideal.

Verfolgen Sie Frühindikatoren wie Marken-Nennungsrate, Sichtbarkeits-Score und Wettbewerbspositionierung in KI-Antworten. Messen Sie Spätindikatoren wie Traffic aus KI-Quellen, Conversion-Raten von KI-vermittelten Besuchern und Kundenakquisitionskosten. Vergleichen Sie diese Metriken vor und nach Optimierungsmaßnahmen, um den geschäftlichen Einfluss zu quantifizieren.

Tools wie AmICited, LLM Pulse und AccuRanker bieten automatisierte Prompt-Erkennung und -Verfolgung. Sie können auch SEO-Tools (SEMrush, Ahrefs) nutzen, um Suchanfragen zu identifizieren, die in Prompts umgewandelt werden können, und LLMs selbst verwenden, um passende Prompts für Ihre Geschäftskategorie vorzuschlagen.

Prompt-Forschung zeigt Content-Lücken und Chancen auf, indem sie sichtbar macht, welche Fragen Nutzer LLMs zu Ihrer Kategorie stellen. Nutzen Sie diese Erkenntnisse, um gezielte Inhalte für Prompts mit hoher Intention zu erstellen, bestehende Inhalte besser auf häufige Fragen auszurichten und neue Ressourcen für unterversorgte Themen zu entwickeln.

AI Overviews sind von Google KI-generierte Zusammenfassungen in den Suchergebnissen. Prompts, die AI Overviews auslösen, deuten auf Anfragen mit hoher Intention hin, bei denen KI-Sichtbarkeit entscheidend ist. Überwachen Sie, welche Keywords AI Overviews auslösen, und testen Sie diese anschließend als Prompts in anderen LLMs, um Ihre Sichtbarkeit im KI-Umfeld zu verstehen.

Entscheiden Sie, ob Sie alle Prompts auf eine Sprache normalisieren oder sprachspezifische Taxonomien pflegen. Nutzen Sie zuverlässige Spracherkennung, stellen Sie sicher, dass Ihre Analysetools Ihre wichtigsten Märkte unterstützen, und beziehen Sie Muttersprachler regelmäßig in Audits ein, um kulturelle Nuancen und regionale Varianten in der Anfrageformulierung zu erfassen.

Verstehen Sie, wie Ihre Marke in KI-generierten Antworten bei ChatGPT, Perplexity und Google AI Overviews erscheint. AmICited verfolgt Ihre Prompt-Performance und KI-Zitate in Echtzeit.

Erfahren Sie, wie Sie eine effektive Prompt-Bibliothek erstellen und organisieren, um Ihre Marke über ChatGPT, Perplexity und Google AI hinweg zu verfolgen. Sch...

Erfahren Sie bewährte Strategien, um die Sichtbarkeit Ihrer Marke in KI-Suchmaschinen wie ChatGPT, Perplexity und Gemini zu verbessern. Entdecken Sie Methoden z...

Schnellreferenz-Leitfaden zur Überwachung der KI-Sichtbarkeit. Verfolgen Sie Erwähnungen, Zitate und die Präsenz Ihrer Marke in ChatGPT, Google AI Overviews, Pe...