Welche KI-Crawler sollte ich zulassen? Vollständiger Leitfaden für 2025

Erfahren Sie, welche KI-Crawler Sie in Ihrer robots.txt zulassen oder blockieren sollten. Umfassender Leitfaden zu GPTBot, ClaudeBot, PerplexityBot und 25+ KI-C...

Erfahren Sie, wie Sie XML-Sitemaps für KI-Crawler wie GPTBot und ClaudeBot optimieren. Beherrschen Sie Sitemap-Best-Practices, um die Sichtbarkeit in KI-generierten Antworten und LLM-Indexierung zu verbessern.

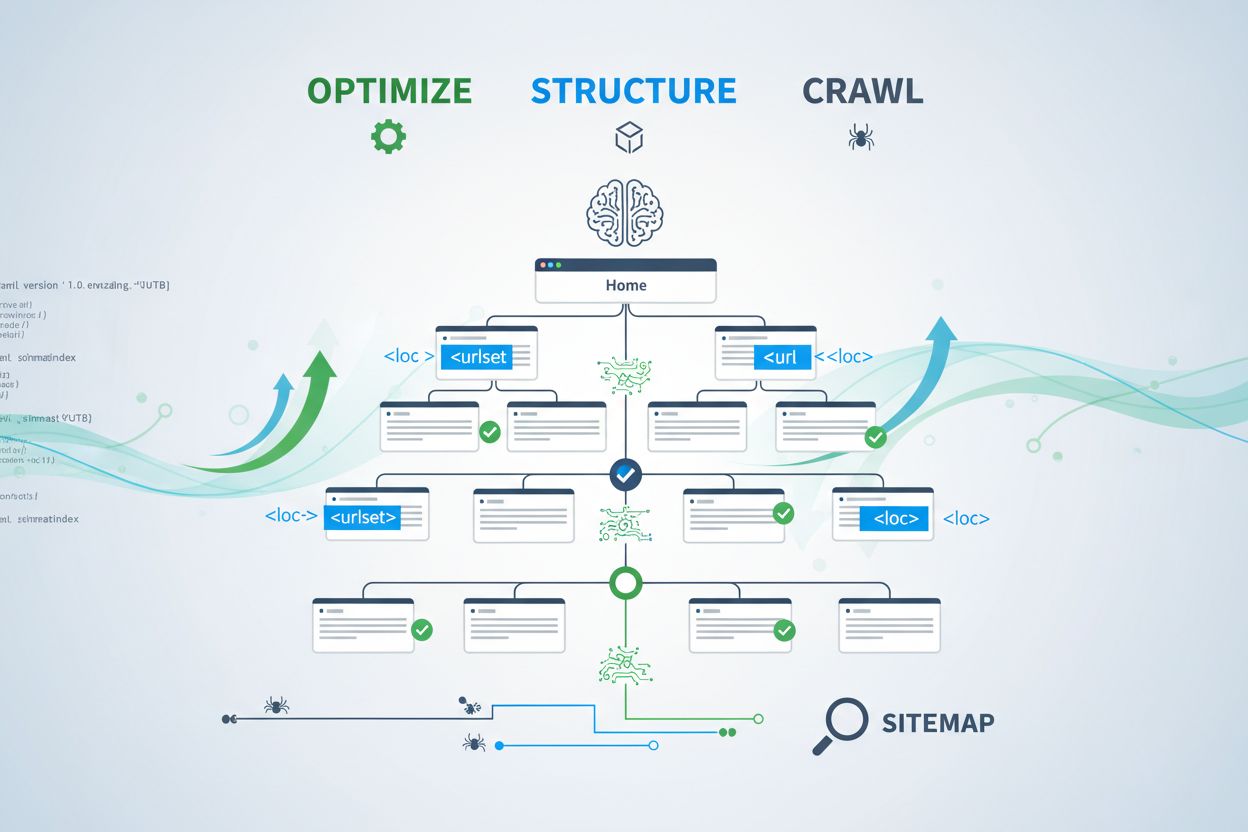

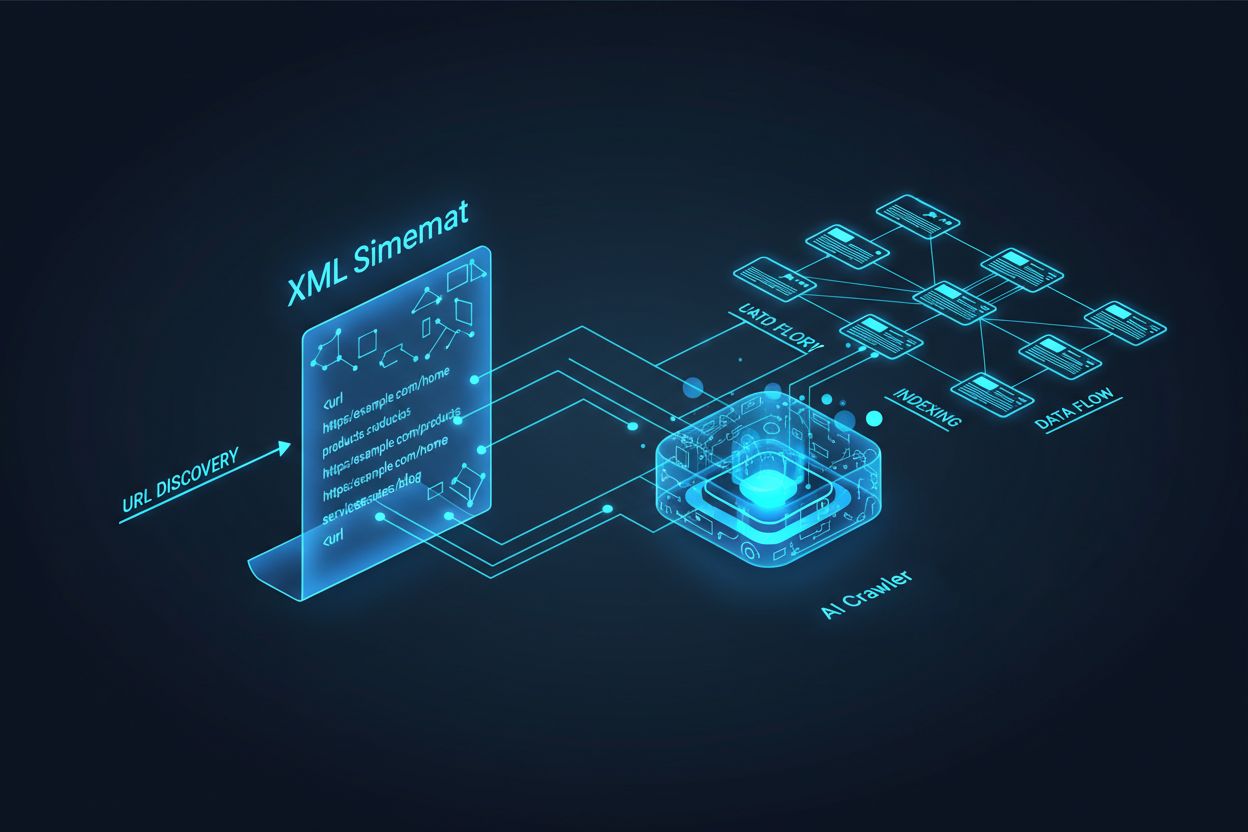

KI-Crawler wie GPTBot, ClaudeBot und PerplexityBot arbeiten grundsätzlich anders als herkömmliche Suchmaschinen-Bots. Während der Googlebot Seiten für das Ranking in Suchergebnissen indexiert, extrahieren KI-Crawler Wissen, um große Sprachmodelle zu trainieren und die konversationelle Suche sowie KI-generierte Antworten zu ermöglichen. Ohne eine richtig optimierte XML-Sitemap bleibt Ihr Inhalt für diese wichtigen Systeme unsichtbar – unabhängig davon, wie gut geschrieben oder autoritativ er ist. Betrachten Sie Ihre Sitemap als eine Landkarte, die KI-Systemen genau zeigt, wo sich Ihre wertvollsten Inhalte befinden und wie sie organisiert sind.

Die Unterscheidung zwischen klassischen Suchcrawlern und KI-Crawlern ist entscheidend, um zu verstehen, warum Sitemap-Optimierung wichtiger ist denn je. Traditionelle Suchmaschinen wie Google konzentrieren sich darauf, einzelne Seiten für bestimmte Keywords zu ranken, während KI-Crawler Wissensextraktion und semantisches Verständnis priorisieren. So unterscheiden sie sich:

| Aspekt | Klassische Crawler (Googlebot) | KI-Crawler (GPTBot, ClaudeBot) |

|---|---|---|

| Hauptzweck | Seiten in Suchergebnissen ranken | Wissen für LLM-Training und Echtzeit-Antworten extrahieren |

| Fokus | Metadaten, interne Links, Rankingsignale | Inhaltsstruktur, semantische Bedeutung, Faktendichte |

| Crawl-Priorität | Basierend auf PageRank und Aktualität | Nach Autorität, thematischer Relevanz und Wissenswert |

| Zitationswirkung | Steigert Traffic durch blaue Links | Bestimmt, ob Ihr Inhalt in KI-Antworten erscheint |

| JavaScript-Verarbeitung | Führt JavaScript aus und rendert es | Überspringt oft JavaScript; priorisiert servergerendertes HTML |

Diese grundlegenden Unterschiede bedeuten, dass alleinige Optimierung für klassisches SEO nicht mehr ausreicht. Ihre Sitemap muss nun zwei Zwecke erfüllen: klassischen Suchmaschinen die Seitenstruktur erklären und gleichzeitig KI-Systeme gezielt zu den wertvollsten Wissensinhalten führen.

Eine XML-Sitemap fungiert als Bauplan Ihrer Website und teilt Crawlern explizit mit, welche Seiten existieren und wie sie zur Gesamtstrategie passen. Für KI-Systeme erfüllen Sitemaps sogar eine noch wichtigere Funktion als für die klassische Suche. KI-Crawler nutzen Sitemaps, um die thematische Architektur Ihrer Seite zu erfassen, priorisierte Inhalte zu identifizieren und zu entscheiden, welche Seiten eine tiefere Analyse verdienen. Ist Ihre Sitemap umfassend und gut organisiert, können KI-Systeme Ihre Inhalte effizienter entdecken und für generative Antworten evaluieren. Umgekehrt erzeugt eine unvollständige oder veraltete Sitemap blinde Flecken, die verhindern, dass KI-Systeme Ihre wichtigsten Seiten je entdecken. Die Auswirkung ist direkt: Seiten, die nicht in der Sitemap sind, werden von KI-Systemen deutlich seltener zitiert – unabhängig von deren Qualität oder Relevanz.

Eine effektive Sitemap für KI-Crawler erfordert mehr, als einfach jede URL Ihrer Website aufzulisten. Ihre Sitemap sollte strategisch kuratiert und auf Seiten beschränkt sein, die echten Mehrwert für Nutzer und KI-Systeme bieten. Die wichtigsten Best Practices:

Eine gut strukturierte Sitemap fungiert als Qualitätsfilter und signalisiert KI-Systemen, dass Sie Ihre Inhalte kuratiert haben und jede enthaltene URL Aufmerksamkeit verdient. Dieser strategische Ansatz erhöht die Chance, in KI-generierten Antworten zitiert zu werden, erheblich.

Aktualität ist einer der stärksten Rankingfaktoren in KI-gestützten Suchsystemen. Wenn KI-Crawler entscheiden, welche Quellen sie in Antworten zitieren, wird die Frische der Inhalte stark gewichtet. Der lastmod-Zeitstempel in Ihrer XML-Sitemap ist das zentrale Signal, das KI-Systemen mitteilt, wann Ihr Inhalt zuletzt aktualisiert wurde. Veraltete oder fehlende Zeitstempel führen dazu, dass selbst autoritative Inhalte zugunsten aktuellerer Quellen abgewertet werden. Zeigt Ihre Sitemap, dass eine Seite seit Jahren nicht aktualisiert wurde, nehmen KI-Systeme an, die Informationen seien überholt und wählen stattdessen Konkurrenzinhalte. Umgekehrt signalisieren genaue lastmod-Zeitstempel, die echte Inhaltspflege widerspiegeln, dass Ihre Informationen aktuell und zuverlässig sind. Für zeitkritische Themen wie Preise, Vorschriften oder Branchentrends wird die Pflege exakter Zeitstempel noch wichtiger. Mit automatischen Updates über Ihr CMS stellen Sie sicher, dass jede Inhaltsänderung sofort in der Sitemap reflektiert wird und maximieren so Ihre Sichtbarkeit in KI-generierten Antworten.

Sitemaps laden Crawler ein, Ihre Inhalte zu indexieren, robots.txt-Dateien steuern, auf welche Teile Ihrer Seite Crawler zugreifen dürfen. Beide Dateien müssen im Einklang arbeiten, um Ihre KI-Sichtbarkeit zu maximieren. Ein häufiger Fehler ist, eine umfassende Sitemap zu erstellen, aber gleichzeitig KI-Crawler in der robots.txt zu blockieren – das schafft einen Widerspruch, der Crawler verwirrt und Ihre Sichtbarkeit verringert. Ihre robots.txt sollte große KI-Crawler wie GPTBot, ClaudeBot und PerplexityBot explizit zulassen. Sie können robots.txt gezielt nutzen, um nur die Seiten zu blockieren, die nicht indexiert werden sollen – z.B. Admin-Bereiche, Login-Seiten oder doppelte Inhalte. Wichtig ist, dass die robots.txt-Regeln mit Ihrer Sitemap-Strategie übereinstimmen: Befindet sich eine Seite in der Sitemap, sollte sie laut robots.txt auch zugänglich sein. Regelmäßige Audits beider Dateien helfen, Fehlkonfigurationen zu erkennen, die Ihre KI-Sichtbarkeit stillschweigend einschränken könnten.

Die effektivsten KI-Optimierungsstrategien behandeln Sitemaps und strukturierte Daten als komplementäre Systeme, die sich gegenseitig stärken. Wenn Ihre Sitemap eine Seite als wichtig hervorhebt und diese Seite relevante Schema-Auszeichnungen enthält, senden Sie KI-Crawlern konsistente Signale über Zweck und Wert der Seite. Wenn Ihre Sitemap beispielsweise einen How-to-Guide priorisiert, sollte diese Seite ein HowTo-Schema mit strukturierten Schritt-Informationen enthalten. Produktseiten in Ihrer Sitemap sollten Product-Schema mit Preis-, Verfügbarkeits- und Bewertungsdaten enthalten. Diese Ausrichtung schafft ein kohärentes Datenbild, das KI-Systeme leicht interpretieren und vertrauen können. Weichen Sitemap und strukturierte Daten voneinander ab, werden KI-Crawler unsicher über den tatsächlichen Zweck der Seite, was die Zitationswahrscheinlichkeit reduziert. Wenn Sie Ihre Sitemap-Strategie mit Ihrer Schema-Implementierung abstimmen, erzeugen Sie ein einheitliches Signal, das Ihre Chance auf Einbindung in KI-Antworten dramatisch erhöht.

Verschiedene Inhaltstypen erfordern unterschiedliche Sitemap-Strategien, um die KI-Sichtbarkeit zu maximieren. Blogartikel, Produktseiten, Leistungsbeschreibungen und FAQ-Inhalte erfüllen unterschiedliche Zwecke und sollten entsprechend optimiert werden:

| Inhaltstyp | Sitemap-Strategie | Empfohlenes Schema-Markup | Prioritätsüberlegungen |

|---|---|---|---|

| Blogartikel & Beiträge | Mit genauen Veröffentlichungs- und Aktualisierungsdaten aufnehmen | Article, NewsArticle, BlogPosting | Aktuelle, evergreen Inhalte priorisieren; lastmod regelmäßig aktualisieren |

| Produktseiten | Mit Lagerbestands-Updates aufnehmen; ggf. separate Produktsitemap | Product, Offer, AggregateRating | Bestseller und neue Produkte hervorheben; Preise häufig aktualisieren |

| Leistungsseiten | Mit Leistungsaktualisierungsdaten aufnehmen | Service, LocalBusiness, ProfessionalService | Kernleistungen priorisieren; Verfügbarkeit und Preise aktualisieren |

| FAQ-Seiten | Mit Inhaltsaktualisierungen aufnehmen | FAQPage, Question, Answer | Umfassende FAQs priorisieren; Antworten bei Änderungen aktualisieren |

| Videoinhalte | In Video-Sitemap mit Vorschaubild und Dauer aufnehmen | VideoObject, Video | Transkripte einbinden; Views und Engagement-Metriken aktualisieren |

| Bildinhalte | In Bild-Sitemap mit Beschriftungen aufnehmen | ImageObject, Product (für Produktbilder) | Alt-Text optimieren; beschreibende Bildunterschriften einfügen |

Dieser differenzierte Ansatz stellt sicher, dass jeder Inhaltstyp die passende Optimierung für KI-Discovery erhält. Durch die Anpassung Ihrer Sitemap-Strategie an Ihren Content-Mix maximieren Sie die Wahrscheinlichkeit, dass KI-Systeme Ihre wertvollsten Inhalte finden und zitieren.

Der llms.txt-Standard, vorgeschlagen Ende 2024, stellt einen experimentellen Ansatz dar, um KI-Systemen die Website-Struktur verständlich zu machen. Anders als XML-Sitemaps ist llms.txt eine Markdown-basierte Datei, die ein menschenlesbares Inhaltsverzeichnis Ihrer Seite liefert. Sie listet die wichtigsten Seiten und Ressourcen in einem Format auf, das Sprachmodelle leichter parsen und verstehen können. Obwohl das Konzept vielversprechend ist, deuten aktuelle Erkenntnisse darauf hin, dass llms.txt im Vergleich zu klassischen XML-Sitemaps nur geringe Auswirkungen auf die KI-Sichtbarkeit hat. Große KI-Crawler wie GPTBot und ClaudeBot verlassen sich weiterhin hauptsächlich auf XML-Sitemaps für URL-Discovery und Aktualitätssignale. Statt Ihre XML-Sitemap zu ersetzen, sollte llms.txt als ergänzendes Tool betrachtet werden, das KI-Systemen zusätzlichen Kontext liefern kann. Wenn Sie llms.txt implementieren, achten Sie darauf, dass es Ihre Sitemap-Strategie ergänzt und konzentrieren Sie sich zuerst darauf, Ihre XML-Sitemap mit genauen Zeitstempeln und strategischer Content-Kuration zu perfektionieren.

Auch gut gemeinte Websites machen oft kritische Sitemap-Fehler, die ihre KI-Sichtbarkeit still und leise begrenzen. Diese Fehler zu kennen und zu vermeiden, ist entscheidend, um Ihre Präsenz in KI-generierten Antworten zu maximieren:

Die Behebung dieser häufigen Fehler kann Ihre KI-Sichtbarkeit sofort verbessern. Starten Sie mit einem Audit Ihrer aktuellen Sitemap anhand dieser Checkliste und beheben Sie identifizierte Probleme.

Eine optimierte Sitemap zu erhalten, erfordert fortlaufende Überwachung und Validierung. Verschiedene Tools helfen Ihnen, die Wirksamkeit Ihrer Sitemap für KI-Crawler zu sichern. Die Google Search Console bietet integrierte Sitemap-Validierung und zeigt, wie viele URLs Google aus Ihrer Sitemap indexiert hat. Screaming Frog SEO Spider ermöglicht es, Ihre gesamte Seite zu crawlen und das Ergebnis mit Ihrer Sitemap abzugleichen, um fehlende oder fehlerhafte URLs zu identifizieren. XML-Sitemap-Validatoren prüfen Ihre Sitemap auf Syntax und stellen sicher, dass sie dem XML-Sitemap-Protokoll entspricht. In großen Unternehmen bieten SEO-Plattformen wie Semrush und Ahrefs Sitemap-Analysefunktionen, die Änderungen über die Zeit verfolgen. Regelmäßige Audits – idealerweise monatlich – helfen, Probleme frühzeitig zu erkennen, bevor sie sich auf Ihre KI-Sichtbarkeit auswirken. Setzen Sie Kalendererinnerungen, um Ihre Sitemap immer dann zu überprüfen, wenn Sie wesentliche Inhaltsänderungen vornehmen, neue Bereiche starten oder Ihre Seitenarchitektur anpassen.

Zu verstehen, wie KI-Crawler mit Ihrer Sitemap interagieren, erfordert aktive Überwachung und Analyse. Ihre Server-Logs enthalten wertvolle Daten darüber, welche KI-Crawler Ihre Seite besuchen, wie häufig sie crawlen und welche Seiten sie priorisieren. Durch die Analyse dieser Logs können Sie Muster erkennen und Ihre Sitemap gezielt optimieren. Tools wie AmICited.com helfen Ihnen, zu überwachen, wie oft Ihre Inhalte von KI-Systemen wie ChatGPT, Claude, Perplexity und Googles AI Overviews zitiert werden – und liefern so direktes Feedback zur Effektivität Ihrer Sitemap. Google Analytics lässt sich so konfigurieren, dass Referral-Traffic von KI-Systemen nachverfolgt wird und Ihnen zeigt, welche Seiten die meiste KI-Sichtbarkeit generieren. Durch die Korrelation dieser Daten mit Ihrer Sitemap-Struktur erkennen Sie, welche Inhaltstypen und Themen bei KI-Systemen besonders ankommen. Dieser datengesteuerte Ansatz ermöglicht es, Ihre Sitemap-Strategie kontinuierlich zu verfeinern und gezielt Inhalte zu priorisieren, die die meisten KI-Zitate und Sichtbarkeit generieren.

Über die grundlegende Sitemap-Optimierung hinaus gibt es fortgeschrittene Strategien, die Ihre KI-Sichtbarkeit deutlich steigern können. Separate Sitemaps für unterschiedliche Inhaltstypen – etwa Blog-, Produkt- oder Video-Sitemaps – erlauben typenspezifische Optimierung. Dynamische Sitemap-Generierung, bei der sich die Sitemap in Echtzeit mit Inhaltsänderungen aktualisiert, sorgt dafür, dass KI-Crawler stets Ihre aktuellsten Inhalte sehen. Für große Unternehmensseiten mit Tausenden von Seiten helfen Sitemap-Hierarchien und strategische Priorisierung, dass KI-Crawler sich auf Ihre wertvollsten Inhalte konzentrieren. Manche Organisationen erstellen KI-spezifische Sitemaps, die ausschließlich die autoritativsten und zitationswürdigsten Seiten hervorheben und so KI-Systemen signalisieren, welche Seiten besonders beachtet werden sollten. Die Integration Ihrer Sitemap-Strategie in Ihr Content-Management-System sorgt dafür, dass Optimierung automatisch geschieht und nicht auf manuellen Aktualisierungen basiert. Diese fortgeschrittenen Ansätze erfordern mehr technisches Know-how, können aber bei komplexen Content-Landschaften die KI-Sichtbarkeit signifikant steigern.

Die Landschaft der KI-Crawler entwickelt sich rasant weiter; ständig tauchen neue Crawler auf und Standards wie llms.txt werden zunehmend übernommen. Ihre Sitemap-Strategie zukunftssicher zu gestalten, bedeutet, Flexibilität in Ihre Systeme einzubauen und über Branchenentwicklungen informiert zu bleiben. Implementieren Sie Sitemap-Generierungssysteme, die neue Crawler-Anforderungen einfach integrieren, ohne manuelle Neu-Konfiguration zu erfordern. Verfolgen Sie Ankündigungen großer KI-Unternehmen zu neuen Crawlern und passen Sie Ihre robots.txt- und Sitemap-Strategien entsprechend an. Berücksichtigen Sie den langfristigen Wert von KI-Sichtbarkeit versus Inhaltskontrolle – während manche Organisationen KI-Crawler blockieren, zeichnet sich ab, dass KI-Zitate zunehmend für die Markenpräsenz an Bedeutung gewinnen. Entwickeln Sie klare Richtlinien, wie Ihr Unternehmen den Zugriff von KI-Crawlern und die Nutzung Ihrer Inhalte steuern will. Wenn Sie Ihre Sitemap als ein lebendiges Dokument betrachten, das sich gemeinsam mit der KI-Landschaft weiterentwickelt, bleibt Ihr Content auch künftig auffindbar und zitierbar, während sich Such- und Discovery-Mechanismen weiter verändern.

Sie sollten Ihre Sitemap aktualisieren, wann immer Sie neue Inhalte veröffentlichen oder wesentliche Änderungen an bestehenden Seiten vornehmen. Idealerweise implementieren Sie eine automatisierte Sitemap-Generierung, sodass Aktualisierungen sofort erfolgen. Für Websites mit häufigen Inhaltsänderungen sind tägliche Updates empfehlenswert. Für statische Seiten reichen monatliche Überprüfungen aus.

Die meisten großen KI-Crawler wie GPTBot und ClaudeBot respektieren robots.txt-Direktiven, aber nicht alle tun dies. Die beste Praxis ist, KI-Crawler explizit in Ihrer robots.txt-Datei zuzulassen, anstatt sich auf das Standardverhalten zu verlassen. Überwachen Sie Ihre Server-Logs, um zu überprüfen, ob sich Crawler wie erwartet verhalten.

XML-Sitemaps sind maschinenlesbare Dateien, die alle Ihre URLs mit Metadaten wie lastmod-Zeitstempeln auflisten. llms.txt ist ein neuerer Markdown-basierter Standard, der entwickelt wurde, um KI-Systemen ein menschenlesbares Inhaltsverzeichnis bereitzustellen. XML-Sitemaps sind derzeit für die KI-Sichtbarkeit wichtiger, während llms.txt als ergänzend betrachtet werden sollte.

Überprüfen Sie Ihre Server-Logs auf User Agents wie 'GPTBot', 'ClaudeBot', 'PerplexityBot' und 'Google-Extended'. Sie können auch Tools wie AmICited.com verwenden, um zu überwachen, wie oft Ihre Inhalte von KI-Systemen zitiert werden, was auf erfolgreiches Crawlen und Indexieren hinweist.

Ja, das Erstellen separater Sitemaps für Blogs, Produkte, Videos und Bilder ermöglicht es Ihnen, typenspezifische Optimierungsstrategien anzuwenden. Dies hilft auch KI-Crawlern, Ihre Inhaltsstruktur klarer zu verstehen und kann die Crawleffizienz bei großen Websites verbessern.

XML-Sitemaps sollten maximal 50.000 URLs pro Datei enthalten. Für größere Websites verwenden Sie Sitemap-Indizes, um mehrere Sitemap-Dateien zu organisieren. KI-Crawler können große Sitemaps verarbeiten, aber die Aufteilung in logische Abschnitte verbessert die Crawleffizienz und erleichtert die Verwaltung.

Lastmod-Zeitstempel signalisieren KI-Crawlern die Aktualität von Inhalten. Aktualität ist ein starker Rankingfaktor in KI-Systemen, daher helfen genaue Zeitstempel Ihren Inhalten, bei Zitaten zu konkurrieren. Verwenden Sie immer automatisierte Systeme, um Zeitstempel nur dann zu aktualisieren, wenn sich Inhalte tatsächlich ändern – setzen Sie niemals manuell falsche Zeitstempel.

Ja, eine schlecht gepflegte Sitemap kann Ihre KI-Sichtbarkeit erheblich beeinträchtigen. Fehlerhafte Links, veraltete URLs, ungenaue Zeitstempel und unvollständige Abdeckung verringern Ihre Chancen, von KI-Systemen zitiert zu werden. Regelmäßige Audits und Wartung sind unerlässlich, um Ihre KI-Sichtbarkeit zu schützen.

Verfolgen Sie, wie oft Ihre Inhalte von ChatGPT, Claude, Perplexity und Google AI Overviews zitiert werden. Optimieren Sie Ihre Sitemap-Strategie basierend auf echten KI-Zitationsdaten.

Erfahren Sie, welche KI-Crawler Sie in Ihrer robots.txt zulassen oder blockieren sollten. Umfassender Leitfaden zu GPTBot, ClaudeBot, PerplexityBot und 25+ KI-C...

Erfahren Sie, wie Sie den Zugang von KI-Crawlern zu Ihrer Website prüfen. Entdecken Sie, welche Bots Ihre Inhalte sehen können, und beheben Sie Blocker, die die...

Erfahren Sie, wie Sie Ihre Website für eine optimale KI-Crawler-Indexierung strukturieren, einschließlich semantischem HTML, Seitenarchitektur, Inhaltsorganisat...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.