Transparenz bei der KI-Rangfolge

Erfahren Sie, was Transparenz bei der KI-Rangfolge bedeutet, warum sie für Content-Ersteller und Nutzer wichtig ist und wie verschiedene KI-Plattformen wie Perp...

Erfahren Sie wesentliche Best Practices für AI-Transparenz und Offenlegung. Entdecken Sie Verhaltens-, verbale und technische Offenlegungsmethoden, um Vertrauen aufzubauen und die Einhaltung neuer AI-Vorschriften sicherzustellen.

AI-Transparenz ist zu einer entscheidenden Notwendigkeit geworden in einer Ära, in der künstliche Intelligenz alles von der Inhaltserstellung bis zu Einstellungsentscheidungen und Finanzempfehlungen beeinflusst. Während AI-generierte Inhalte digitale Plattformen überfluten, stehen Organisationen zunehmend unter Druck, offenzulegen, wann und wie sie diese Technologien nutzen – nicht nur aus rechtlicher Verpflichtung, sondern als grundlegende Voraussetzung, um Vertrauen und Glaubwürdigkeit gegenüber ihrem Publikum zu wahren. Besonders hoch sind die Einsätze für Marken und Content-Ersteller, da Verbraucher zunehmend wissen wollen, ob die konsumierten Informationen auf menschlicher Expertise oder algorithmischer Generierung beruhen. Ohne transparente Offenlegungspraktiken riskieren Organisationen, das über Jahre aufgebaute Vertrauen zu verlieren – mit potenziellen Imageschäden, behördlichen Strafen und Vertrauensverlust beim Publikum. Die Beziehung zwischen Transparenz und Glaubwürdigkeit ist wechselseitig: Organisationen, die ihren AI-Einsatz proaktiv offenlegen, zeigen Integrität und Respekt gegenüber ihren Stakeholdern und positionieren sich als ehrliche Akteure in einer zunehmend AI-getriebenen Welt.

Die Verbreitung AI-generierter Inhalte hat ein tiefgreifendes Vertrauensparadoxon geschaffen: Das Publikum hat Schwierigkeiten, authentische, menschlich geschaffene Werke von ausgefeilten AI-Alternativen zu unterscheiden, während die Transparenz über den AI-Einsatz branchenübergreifend uneinheitlich bleibt. Diese Verwirrung untergräbt den fundamentalen Vertrag zwischen Erstellern und Konsumenten, wonach das Publikum die wahre Herkunft der Inhalte erfahren möchte. Werden AI-generierte Inhalte ohne Offenlegung präsentiert, verletzt dies diese stillschweigende Vereinbarung – und schafft eine Dichotomie von “echt vs. gefälscht”, die über reine Authentizitätsfragen hinausgeht und Themen wie Täuschung, Manipulation und informierte Zustimmung berührt. Das Paradoxon verschärft sich, weil einige AI-generierte Inhalte hinsichtlich Qualität und Stil von menschlichen Werken nicht zu unterscheiden sind, sodass visuelle oder stilistische Hinweise als Herkunftsindikator unzuverlässig werden. Transparenz ist wichtig, weil sie dieses Paradoxon löst und dem Publikum die nötigen Informationen gibt, um fundierte Entscheidungen über die konsumierten und vertrauten Inhalte zu treffen. Organisationen, die klare Offenlegungspraktiken einführen, verwandeln potenziellen Skeptizismus in Vertrauen und zeigen, dass sie nichts zu verbergen und alles durch ehrliche Kommunikation zu gewinnen haben.

Das regulatorische Umfeld rund um AI-Offenlegung entwickelt sich rasant, und verschiedene Rechtsräume setzen Anforderungen um oder schlagen sie vor, die Organisationen sorgfältig beachten müssen. Der EU AI Act, eines der umfassendsten Rahmenwerke, schreibt vor, dass AI-generierte oder stark AI-bearbeitete Inhalte entweder sichtbar oder auf Metadatenebene offengelegt werden müssen – mit spezifischen Vorgaben insbesondere für Hochrisiko-AI-Systeme und Transparenzpflichten für Entwickler. In den USA hat die FTC gewarnt, dass das Versäumnis, Nutzungsbedingungen und Datenschutzerklärungen hinsichtlich AI-Einsatz zu aktualisieren, als irreführende Praxis gelten kann, während bundesstaatliche Regelungen – insbesondere das neue Frontier Model Disclosure Law in Kalifornien – erhöhte Transparenz- und Berichtspflichten für Entwickler großer AI-Systeme festlegen. Urheberrechts- und geistige Eigentumsaspekte fügen eine weitere Komplexität hinzu, da Organisationen offenlegen müssen, ob Trainingsdaten urheberrechtlich geschütztes Material enthielten und wie AI-Systeme trainiert wurden. Darüber hinaus gelten GDPR- und CCPA-Anforderungen auch für AI-Systeme, die personenbezogene Daten verarbeiten, und verlangen von Organisationen, automatisierte Entscheidungsfindung offenzulegen und Einzelpersonen sinnvolle Informationen über AI-Verarbeitung bereitzustellen. Die folgende Tabelle fasst zentrale regulatorische Anforderungen in wichtigen Rechtsräumen zusammen:

| Rechtsraum | Regulierung | Zentrale Anforderungen | Inkrafttreten |

|---|---|---|---|

| Europäische Union | EU AI Act | Offenlegung für Hochrisiko-AI; Transparenzberichte; Metadaten-Kennzeichnung für AI-generierte Inhalte | Staffelweise (2024–2026) |

| USA (Bund) | FTC-Richtlinien | Datenschutzerklärung aktualisieren; AI-Einsatz offenlegen; irreführende Praktiken vermeiden | Laufend |

| Kalifornien | AI Frontier Model Law | Standardisierte Offenlegung; Berichtspflichten; Sicherheitsmaßnahmen | 2025 |

| Europäische Union | GDPR | Automatisierte Entscheidungsfindung offenlegen; Informationen zur AI-Verarbeitung bereitstellen | Laufend |

| USA (Bundesstaaten) | CCPA & Ähnliche | Datenverwendung in AI-Systemen offenlegen; Opt-out-Möglichkeiten anbieten | Je nach Bundesstaat |

| International | Urheberrechtliche Überlegungen | Quellen der Trainingsdaten offenlegen; Urheberrecht bei AI-Ergebnissen berücksichtigen | Im Entstehen |

Organisationen, die in mehreren Rechtsräumen tätig sind, sollten Offenlegungspraktiken umsetzen, die die strengsten Anforderungen erfüllen – denn die Einhaltung eines Standards übertrifft oft das Mindestmaß anderer.

Verhaltenssignale sind die subtilste, aber kraftvolle Form der AI-Offenlegung. Sie wirken über Präsentation, Stil, Stimme und kreative Entscheidungen, die das Publikum unbewusst verarbeitet, wenn es die Authentizität von Inhalten bewertet. Solche Signale umfassen charakteristische Muster im Schreibstil, Konsistenz der Stimme, visuelle Kompositionsentscheidungen, Avatar- oder Persona-Merkmale sowie die generelle “Fidelity” der Urheberrepräsentation – im Kern: das Maß, in dem der Inhalt echte menschliche Persönlichkeit und Entscheidungsfindung widerspiegelt. Beispielsweise zeigt AI-generierter Text oft bestimmte Muster im Satzbau, der Wortwahl und im logischen Fluss, die sich von menschlichen Texten unterscheiden, während AI-generierte Bilder subtile Inkonsistenzen in Beleuchtung, Anatomie oder Hintergrund aufweisen können, die geschulte Beobachter erkennen. Das Konzept der Creator Fidelity ist hier zentral: Das Publikum entwickelt Erwartungen, wie ein bestimmter Ersteller klingt, aussieht und sich präsentiert – Abweichungen davon können auf AI-Einsatz hindeuten. Allein auf Verhaltenssignale zu setzen ist jedoch problematisch, da AI-Systeme rasant besser darin werden, menschliche Merkmale zu imitieren, und das Publikum nicht zu AI-Forensikern werden kann. Verhaltenssignale sollten daher explizite Offenlegungsmethoden ergänzen, nicht ersetzen – als zweite Transparenzebene, die klare, direkte Kommunikation über AI-Nutzung verstärkt.

Verbale Offenlegungsstrategien bieten explizite, direkte Kommunikation über den AI-Einsatz mittels sprachbasierter Signale, die keine Zweifel über Herkunft und AI-Beteiligung lassen. Diese Methoden sind entscheidend, da sie einen klaren, dokumentierten Offenlegungsnachweis schaffen und sicherstellen, dass das Publikum eindeutige Informationen zum AI-Einsatz erhält. Organisationen können verbale Offenlegung auf verschiedene, sich ergänzende Weise umsetzen:

Die Geeignetheit jeder Methode hängt vom Kontext ab: Labels eignen sich für Social Media und visuelle Inhalte, Wasserzeichen für Video und Audio, Bylines für journalistische und kreative Werke, Offenlegungsfelder für längere Inhalte, Danksagungen für komplexe Projekte. Organisationen sollten Offenlegungsmethoden wählen, die zum Inhaltsformat und zu den Erwartungen ihres Publikums passen – Offenlegung sollte nicht zu übersehen und trotzdem nicht störend sein.

Technische Signale und Metadaten liefern maschinenlesbare, standardisierte Informationen über AI-Beteiligung und ermöglichen die automatisierte Erkennung, Überprüfung und Nachverfolgung von AI-generierten Inhalten in digitalen Ökosystemen. Diese Methoden nutzen eingebettete Daten und kryptografische Verfahren, um dauerhafte, manipulationssichere Nachweise über Ursprung und Bearbeitungsgeschichte von Inhalten zu schaffen. Die IPTC-Standards, jüngst um AI-spezifische Metadaten erweitert, erlauben es Erstellern, strukturierte Informationen über AI-Einsatz direkt in Bilddateien einzubetten – inklusive Angaben, welche AI-Systeme genutzt, welche Bearbeitungen vorgenommen und welche menschlichen Modifikationen durchgeführt wurden. C2PA (Coalition for Content Provenance and Authenticity) ist ein aufkommender Industriestandard, der kryptografische Signaturen und Inhaltsnachweise nutzt, um überprüfbare Herkunftsketten digitaler Inhalte zu schaffen und es dem Publikum ermöglicht, Inhalte bis zur Ursprungsquelle zurückzuverfolgen und alle Bearbeitungen einzusehen. Diese technischen Ansätze beheben eine zentrale Schwäche menschlich lesbarer Offenlegung: Sie schaffen dauerhafte, überprüfbare Nachweise, die nicht leicht entfernt oder verändert werden können, und erlauben es automatisierten Systemen, AI-generierte Inhalte in großem Maßstab zu identifizieren und zu kennzeichnen. Organisationen sollten für hochwertige Inhalte C2PA-Credentials einsetzen, IPTC-Metadaten in Bilder und Medien einbetten und eine detaillierte Digital Source Type-Dokumentation führen, die AI-Beteiligung im gesamten Content-Lifecycle nachverfolgt. Der Vorteil technischer Signale liegt in ihrer Dauerhaftigkeit und Überprüfbarkeit – die Herausforderung besteht darin, dass Publikum und Plattformen diese Signale verstehen und respektieren.

Erfolgreiche AI-Offenlegung erfordert die Institutionalisierung von Transparenzpraktiken entlang des gesamten Content-Erstellungsprozesses – Offenlegung wird so von einer Nebensache zu einem Grundpfeiler der Inhaltsgovernance. Organisationen sollten strukturierte Content-Frameworks einführen, die AI-Beteiligung in jeder Phase – von Recherche und Entwurf über Bearbeitung bis zur Veröffentlichung – dokumentieren, sodass Offenlegungsinformationen nahtlos durch Content-Management-Systeme fließen. Automatisierung und Workflow-Integration sind hierbei essenziell: Content-Management-Systeme sollten Pflichtfelder für AI-Offenlegung, automatische Hinweise zur Dokumentation des AI-Einsatzes vor Veröffentlichung und Freigabeworkflows enthalten, die die Vollständigkeit der Offenlegung prüfen, bevor Inhalte live gehen. Offenlegung wird so zu einer Qualitätskontrolle und nicht zu einem optionalen Zusatz – ähnlich wie Faktenprüfung, juristische Prüfung oder Marken-Compliance. Organisationen sollten zudem klare Richtlinien definieren, was als AI-Einsatz gilt, der offengelegt werden muss (z. B. muss AI-gestützte Recherche offengelegt werden? Was ist mit AI-gestützter Bearbeitung?), um Konsistenz im Team zu gewährleisten und Offenlegungslücken zu vermeiden. Ebenso wichtig sind Schulung und Dokumentation: Content-Ersteller brauchen klare Anleitungen, wie sie AI-Nutzung je nach Inhaltstyp und Plattform angemessen offenlegen. Durch die Integration der Offenlegung in Modelle und Workflows wird Transparenz von einer Compliance-Bürde zu einer Standardprozedur, die sowohl Organisation als auch Publikum schützt.

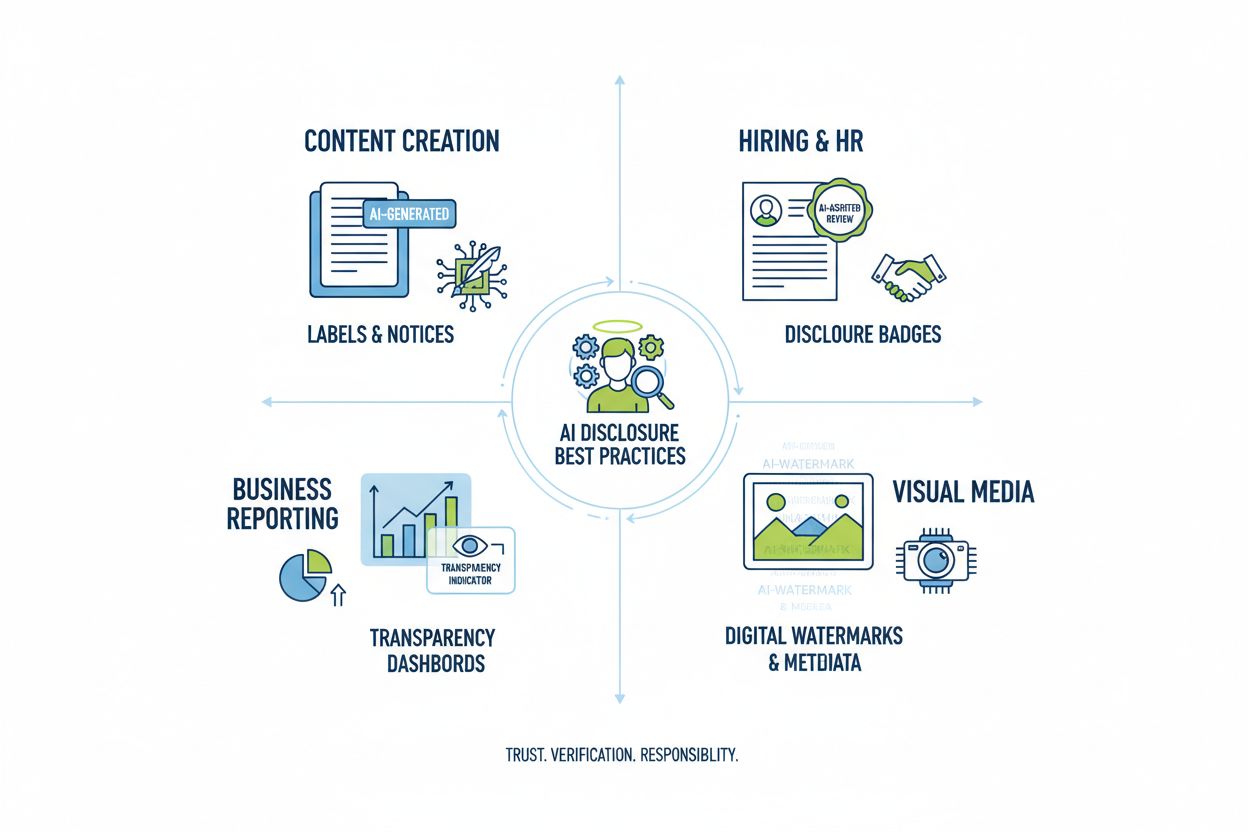

Je nach Einsatzgebiet erfordert AI angepasste Offenlegungsansätze, die Kontext, Publikumserwartung und regulatorische Vorgaben berücksichtigen. In der Inhaltserstellung (Artikel, Social Media, Marketingtexte) sollten klare Labels oder angepasste Autorenzeilen AI-Beteiligung kennzeichnen, ergänzt um Offenlegungsfelder, die eingesetzte AI-Tools und menschliche Einflussnahme erklären – besonders wichtig bei Nachrichten und redaktionellen Inhalten, wo das Publikum die Herkunft kennen möchte. Einstellung und Recruiting erfordern die strengste Offenlegung: Bewerber müssen wissen, wenn AI ihre Unterlagen prüft oder vorsortiert, und detailliert erfahren, wie AI-Entscheidungen getroffen werden und welche menschliche Überprüfung folgt. Reporting und Analyse (Finanzberichte, Marktstudien, Datenanalysen) sollten technische Offenlegungen und Metadaten enthalten, die AI-gestützte Analysen kennzeichnen – besonders, wenn AI Ergebnisse beeinflusst hat. Visuelle Inhalte (Bilder, Videos, Grafiken) erfordern sowohl sichtbare Wasserzeichen als auch Metadaten-Offenlegung, da das Publikum AI-generierte Visuals nicht zuverlässig erkennt – entscheidend bei Nachrichtenfotos, Produktbildern und überall, wo Authentizität die Kauf- oder Vertrauensentscheidung beeinflusst. Kundenkommunikation (Chatbots, automatisierte Antworten, Kundenservice) sollte AI-Beteiligung zu Beginn klar kennzeichnen und die Möglichkeit zum Kontakt mit einem Menschen bieten. Organisationen sollten ihren AI-Einsatz in diesen Kontexten prüfen und Offenlegungspraktiken proportional zur Sensibilität und Wirkung umsetzen – Transparenzanforderungen variieren je nach Einfluss der AI-Entscheidungen auf das Publikum.

Die Zukunft der AI-Offenlegung hängt von branchenweiter Standardisierung und der Entwicklung interoperabler Rahmenwerke ab, die konsistente, vergleichbare Transparenz über Organisationen und Plattformen hinweg ermöglichen. Neue Standards wie C2PA, IPTC-Metadaten und das AI Risk Management Framework des NIST bieten grundlegende Strukturen, doch für eine breite Einführung braucht es koordinierte Anstrengungen von Technologieplattformen, Content-Erstellern, Regulatoren und Verbänden. Der EU AI Act und ähnliche Regulierungen treiben die Standardisierung voran, indem sie bestimmte Offenlegungsformate und Informationskategorien vorschreiben – dies erhöht den Druck, branchenweit gemeinsame Standards zu übernehmen, statt individuelle Lösungen. Brancheninitiativen wie die ethischen AI-Leitlinien der PRSA und verschiedene Transparenz-Reporting-Frameworks zeigen wachsenden Konsens zu Offenlegungs-Best Practices, wenngleich die freiwillige Übernahme noch uneinheitlich ist. Der nächste entscheidende Schritt ist der Übergang von freiwilligen zu verpflichtenden Standards, ähnlich wie FDA-Nährwerttabellen Transparenz bei Lebensmitteln standardisiert haben. Monitoring- und Visibility-Plattformen – wie AmICited.com – spielen in diesem Ökosystem eine immer wichtigere Rolle, indem sie verfolgen, wie AI Marken und Inhalte in AI-generierten Antworten referenziert, und Organisationen Einblick geben, wie ihre Arbeit in AI-Ergebnissen erscheint und ob Attribution und Offenlegung korrekt erfolgen. Je ausgereifter und allgegenwärtiger AI-Systeme werden, desto wichtiger wird die Fähigkeit, AI-Offenlegungen zu überwachen, zu verifizieren und zu auditieren, um Vertrauen in digitale Informationsökosysteme zu bewahren. Organisationen, die heute in robuste Offenlegungspraktiken und Monitoring investieren, sind am besten darauf vorbereitet, die sich wandelnde Regulierungslandschaft zu meistern und das Vertrauen ihres Publikums in einer AI-zentrierten Zukunft zu erhalten.

Verhaltensoffenlegung nutzt Präsentationsentscheidungen (Stil, Stimme, Avatar), um AI-Beteiligung zu signalisieren. Verbale Offenlegung nutzt explizite Erklärungen, Labels und Wasserzeichen. Technische Offenlegung bettet maschinenlesbare Metadaten und kryptografische Signaturen ein. Jede Methode dient unterschiedlichen Zielgruppen und Kontexten, und Organisationen sollten mehrere Methoden kombinieren, um umfassende Transparenz zu erreichen.

Gesetzliche Anforderungen variieren je nach Rechtsraum. Der EU AI Act schreibt Offenlegung für Hochrisiko-AI-Systeme vor. Die FTC verlangt Offenlegung, wenn der AI-Einsatz Verbraucherentscheidungen beeinflussen könnte. Landesgesetze wie das AI Frontier Model Law in Kalifornien legen Berichtspflichten fest. Das Urheberrecht verlangt Offenlegung von AI-generierten Inhalten. Organisationen sollten juristischen Rat für spezifische Anforderungen ihrer Region einholen.

AI-generierte Bilder sollten sowohl sichtbare Wasserzeichen als auch Metadaten-Offenlegung enthalten. Sichtbare Wasserzeichen sollten erkennbar, aber nicht störend sein und die AI-Generierung klar anzeigen. Metadaten sollten IPTC-Digital Source Type-Informationen und, sofern verfügbar, C2PA-Credentials beinhalten. Bildunterschriften und Offenlegungsfelder sollten explizit angeben, dass die Bilder AI-generiert sind, besonders bei Nachrichten-, Produkt- oder Werbeinhalten.

IPTC-Standards bieten strukturierte Metadatenfelder zur Dokumentation des AI-Einsatzes in Bildern und Mediendateien. Sie ermöglichen die automatisierte Erkennung und Nachverfolgung von AI-generierten Inhalten über Plattformen hinweg. IPTC-Digital Source Type-Kategorien umfassen 'Trainiertes algorithmisches Medium', 'Komposit-Synthetisch' und 'Algorithmisches Medium'. Diese Standards sind wichtig, weil sie dauerhafte, überprüfbare Nachweise für AI-Beteiligung schaffen, die nicht leicht entfernt oder verändert werden können.

Unternehmen sollten ein AI-Audit durchführen, um alle AI-Anwendungsfälle zu identifizieren, Offenlegungspolitiken entsprechend geltender Vorschriften implementieren, Offenlegung in Content-Management-Workflows integrieren, Teams zu Offenlegungspflichten schulen und die Einhaltung regelmäßig überwachen. Die Beratung durch Rechtsexperten, die mit AI-Vorschriften in Ihrer Region vertraut sind, ist unerlässlich, da die Anforderungen regional stark variieren.

Zu den Konsequenzen zählen behördliche Strafen (FTC-Bußgelder, Verstöße gegen Landesgesetze), Reputationsschäden und Vertrauensverlust beim Publikum, rechtliche Haftung wegen Urheberrechtsverletzungen oder Täuschung sowie mögliche Klagen betroffener Parteien. Organisationen, die AI-Nutzung nicht offenlegen, riskieren die Glaubwürdigkeit, für deren Aufbau sie Jahre benötigt haben – proaktive Offenlegung ist eine strategische Investition in langfristiges Vertrauen.

Verschiedene Stakeholder benötigen unterschiedliche Informationsniveaus. Allgemeine Zielgruppen benötigen einfache, klare Hinweise auf AI-Beteiligung. Regulierungsbehörden benötigen detaillierte technische Dokumentation und Compliance-Nachweise. Journalisten und Content-Ersteller brauchen spezifische Informationen zu AI-Tools und menschlicher Kontrolle. Kunden müssen verstehen, wie AI ihre Erfahrung beeinflusst. Format und Detailgrad der Offenlegung sollten auf die Bedürfnisse und Erwartungen der jeweiligen Zielgruppe zugeschnitten werden.

C2PA (Coalition for Content Provenance and Authenticity) bietet kryptografische Credentials zur Inhaltsverifikation. IPTC-Standards ermöglichen das Einbetten von Metadaten in Bildern. Content-Management-Systeme integrieren zunehmend AI-Offenlegungsfelder. Monitoring-Plattformen wie AmICited.com verfolgen AI-Referenzen und Sichtbarkeit. Branchenleitfäden von PRSA, NIST und anderen bieten Orientierung. Die Einführung dieser Tools und Standards beschleunigt sich, da Vorschriften strenger werden.

Verfolgen Sie, wie AI-Systeme Ihre Marke über GPTs, Perplexity und Google AI Overviews hinweg referenzieren. Stellen Sie sicher, dass Ihre Inhalte in AI-generierten Antworten ordnungsgemäß zugeordnet und sichtbar sind.

Erfahren Sie, was Transparenz bei der KI-Rangfolge bedeutet, warum sie für Content-Ersteller und Nutzer wichtig ist und wie verschiedene KI-Plattformen wie Perp...

Erfahren Sie, wie Sie umfassende KI-Visibility-Reports erstellen, die Führungskräfte verstehen. Verfolgen Sie Marken-Erwähnungen in ChatGPT, Perplexity und Goog...

Entdecken Sie die Zukunft des KI-Sichtbarkeits-Monitorings: Von Transparenzstandards bis hin zu regulatorischer Compliance. Erfahren Sie, wie Marken sich auf di...