Perplexity AI-Optimierung: Wie Sie in Echtzeit-Suchergebnissen zitiert werden

Erfahren Sie, wie Sie Ihre Inhalte für Perplexity AI optimieren und in Echtzeit-Suchergebnissen zitiert werden. Entdecken Sie zitierfähige Content-Strategien, t...

Ich habe Perplexity intensiv genutzt und versucht, zu rekonstruieren, wie es funktioniert. Es ist eindeutig anders als sowohl klassische Suchmaschinen als auch ChatGPT.

Was mir aufgefallen ist:

Mein Architektur-Verdacht:

Was ich verstehen möchte:

Suche nach Leuten, die Perplexitys Architektur im Detail untersucht haben.

Daniel, deine Architektur-Vermutung ist ziemlich nah dran. Hier ein paar Details:

Die Vier-Phasen-Pipeline:

| Phase | Funktion | Technologie |

|---|---|---|

| Abfrageverarbeitung | Intent-Erkennung, Entitäten-Extraktion | NLP + Tokenisierung |

| Informationsabruf | Webindex nach relevanten Dokumenten durchsuchen | Semantische Suche + APIs |

| Antwortgenerierung | Aus abgerufenen Inhalten synthetisieren | LLM (GPT-4, Claude) |

| Verfeinerung | Faktencheck, Formatierung, Folgefragen vorschlagen | Nachbearbeitung |

Phase 1: Abfrageverarbeitung

Nicht nur Schlagwort-Extraktion:

Beispiel: “Neueste Entwicklungen im Quantencomputing” →

Phase 2: Abruf

Verwendet semantische Suche, nicht nur Schlagwortabgleich. Ein Dokument über “künstliche neuronale Netze” kann für die Abfrage “Deep Learning” gefunden werden, weil die semantische Bedeutung ähnlich ist.

Der semantische Suchteil ist interessant. Verwendet es also Embeddings, um konzeptuell verwandte Inhalte zu finden und nicht nur Schlagwortübereinstimmungen?

Und bei der Antwortgenerierung – werden mehrere Quellen gleichzeitig verarbeitet oder nacheinander?

Embedding-basierter Abruf:

Ja, genau. Der Ablauf:

Mehrquellenverarbeitung:

Perplexity verarbeitet Quellen parallel, nicht nacheinander:

Abgerufene Dokumente (5-10 Quellen)

↓

Parallele Extraktion relevanter Passagen

↓

Passagen-Ranking nach Relevanz

↓

Kombinierter Kontext + Anfrage → LLM

↓

Synthese der Antwort mit Inline-Zitaten

Das Zitiermechanismus:

Während das LLM jede Aussage generiert, wird die Quellenzuordnung mitgeführt. Deshalb erscheinen Zitate inline – das Modell verfolgt, welche Quelle welche Aussage stützt.

Konfliktlösung:

Wenn Quellen widersprechen, macht Perplexity oft:

Die LLM-Schicht verdient mehr Analyse.

Modellwahl:

Perplexity nutzt mehrere LLMs:

Wie das LLM zitierte Antworten generiert:

Das LLM kopiert nicht einfach Text. Es:

Beispiel-Transformation:

Quelle 1: “Quantencomputer verwenden Qubits, die im Überlagerungszustand existieren können.” Quelle 2: “Zu den wichtigsten Playern zählen IBM, Google und IonQ.” Quelle 3: “Jüngste Durchbrüche zeigen Prozessoren mit über 1000 Qubits.”

Perplexity-Antwort: “Quantencomputer nutzen Qubits, die sich in Überlagerungszuständen befinden [1]. Branchenführer IBM, Google und IonQ [2] haben kürzlich Durchbrüche erzielt, darunter Prozessoren mit über 1000 Qubits [3].”

Die Synthese erstellt neuen Text und erhält gleichzeitig die genaue Zuordnung der Quellen.

Für Content Creators – das ist wichtig, um zitiert zu werden:

Quellenauswahl-Faktoren:

| Faktor | Gewichtung | So optimieren Sie |

|---|---|---|

| Relevanz | Sehr hoch | Beantworten Sie Fragen direkt |

| Glaubwürdigkeit | Hoch | Autorenangaben, institutioneller Hintergrund |

| Aktualität | Hoch | Aktualisierte Daten, frische Inhalte |

| Klarheit | Hoch | Strukturierte, extrahierbare Formate |

| Domain-Autorität | Mittel | Bauen Sie den Ruf Ihrer Seite auf |

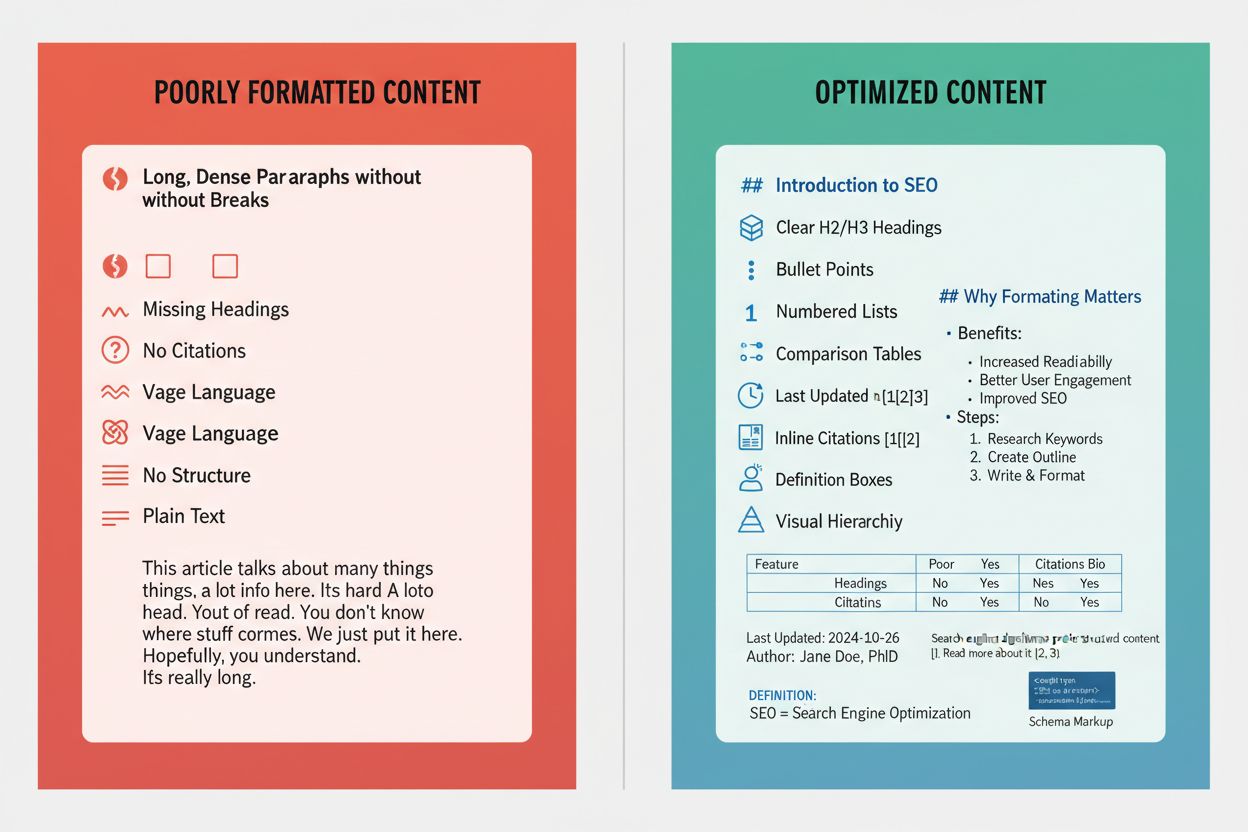

Format, das zitiert wird:

Perplexity extrahiert Informationen am besten aus:

Was übersprungen wird:

Quick Search vs. Pro Search – der technische Unterschied:

Quick Search:

Pro Search:

Die Zerlegung:

Pro Search zerlegt komplexe Anfragen in Teilabfragen:

“Bestes CRM für Healthcare-Startups mit HIPAA-Compliance” wird zu:

Jede Teilabfrage holt andere Quellen, dann werden die Ergebnisse kombiniert.

Halluzinationsvermeidung bei Perplexity:

Wie Halluzinationen reduziert werden:

Die Einschränkung:

Perplexity kann trotzdem halluzinieren, wenn:

Vergleich zu ChatGPT:

| Aspekt | Perplexity | ChatGPT |

|---|---|---|

| Echtzeit-Abruf | Ja | Eingeschränkt (Plugins) |

| Zitat erforderlich | Immer | Optional |

| Wissenstand | Keiner (live) | Trainingsdatum |

| Halluzinationsrisiko | Geringer | Höher |

Die erzwungene Zitiermechanik ist Perplexitys wichtigste Verteidigung gegen Halluzinationen.

Das Kontextgedächtnis-System:

Innerhalb einer Sitzung:

Perplexity merkt sich den Gesprächsverlauf:

Beispiel: F1: “Was sind die neuesten Entwicklungen im Quantencomputing?” F2: “Wie verhält sich das im Vergleich zum klassischen Computing?”

Bei F2 erkennt Perplexity, dass sich “das” auf Quantencomputing aus F1 bezieht.

Der Aufmerksamkeitsmechanismus:

Nutzt Attention-Gewichte, um zu bestimmen, welcher vorherige Kontext relevant für die neue Anfrage ist. Nicht alles wird weitergegeben – nur kontextuell Relevantes.

Die Einschränkung:

Das Gedächtnis ist nur sitzungsbasiert. Schließen Sie das Gespräch = Kontext verloren. Keine dauerhafte Personalisierung über Sitzungen hinweg.

Das ist eine Datenschutzentscheidung, keine technische Begrenzung.

Der Fokusmodus wird unterschätzt, wenn es um das Verständnis der Perplexity-Architektur geht:

Verfügbare Fokusbereiche:

| Fokus | Quellenpool | Am besten für |

|---|---|---|

| Alle | Gesamtes Web | Allgemeine Anfragen |

| Akademisch | Forschungsarbeiten | Wissenschaftliche Fragen |

| Nur Reddit | Community-Meinungen | |

| YouTube | Videoinhalte | Anleitungen, Tutorials |

| Nachrichten | Nachrichtenseiten | Aktuelle Ereignisse |

| Schreiben | (keine) | Kein Abruf, reine Generierung |

Was das zeigt:

Der Fokusmodus zeigt, dass Perplexity den Abruf auf bestimmte Quellenpools beschränken kann. Das bedeutet:

Für die Optimierung:

Wer akademische Zitate möchte – sicherstellen, dass Forschung in wissenschaftlichen Datenbanken indexiert ist. Wer allgemeine Zitate möchte – auf web-auffindbare Inhalte setzen.

Dieser Thread hat die letzten Lücken in meinem Verständnis geschlossen. Hier mein aktualisiertes Architekturdiagramm:

Perplexity Live-Suche Pipeline:

Nutzeranfrage

↓

Phase 1: Abfrageverarbeitung

├── NLP-Tokenisierung

├── Intent-Klassifikation

├── Entitäten-Extraktion

├── Abfrageumformulierung (mehrere Teilabfragen)

↓

Phase 2: Informationsabruf

├── Semantische Suche (embedding-basiert)

├── API-Aufrufe zum Webindex

├── Quellenfilterung (Fokusmodus)

├── Passagenextraktion

├── Relevanzranking

↓

Phase 3: Antwortgenerierung

├── Kontextfenster-Befüllung

├── LLM-Synthese (GPT-4/Claude)

├── Inline-Zitierungs-Tracking

├── Konfliktlösung

↓

Phase 4: Verfeinerung

├── Faktencheck mit Quellen

├── Kohärenzbewertung

├── Vorschläge für Folgefragen

├── Zitatformatierung

↓

Endausgabe (Antwort + Zitate + Vorschläge)

Wichtige Erkenntnisse:

Für Content-Optimierung:

Um bei Perplexity zitiert zu werden:

Vielen Dank an alle für den technischen Deep Dive.

Get personalized help from our team. We'll respond within 24 hours.

Überwachen Sie, wann Perplexity Ihre Domain in seinen Live-Suchantworten zitiert. Verstehen Sie, wie die Plattform Ihre Inhalte entdeckt und verwendet.

Erfahren Sie, wie Sie Ihre Inhalte für Perplexity AI optimieren und in Echtzeit-Suchergebnissen zitiert werden. Entdecken Sie zitierfähige Content-Strategien, t...

Erfahren Sie, wie Sie Inhalte für maximale Aufnahme in Perplexity-Zitaten formatieren. Beherrschen Sie zitierfähige Inhalte, Schema-Markup und Zitierstrategien,...

Perplexity AI ist eine KI-basierte Antwortmaschine, die Echtzeit-Websuche mit LLMs kombiniert, um zitierte, genaue Antworten zu liefern. Erfahren Sie, wie es fu...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.