Wie indexieren KI-Engines Inhalte? Der komplette Prozess erklärt

Erfahren Sie, wie KI-Engines wie ChatGPT, Perplexity und Gemini Webinhalte mithilfe fortschrittlicher Crawler, NLP und maschinellem Lernen indexieren und verarb...

Ich versuche, die technischen Unterschiede zwischen traditioneller Suchindexierung und KI-“Indexierung” zu verstehen.

Mein bisheriges Verständnis:

Was ich verstehen muss:

Ich suche technische Tiefe, nicht nur oberflächliche Erklärungen.

Ich erkläre die technische Architektur.

Zwei Mechanismen für KI-Inhaltszugriff:

1. Trainingsdaten (historisch)

Funktionsweise:

Implikationen:

2. RAG-Retrieval (Echtzeit)

Funktionsweise:

Technischer Ablauf:

Anfrage → Einbettung → Vektorsuche →

Dokumentenabruf → Neu-Ranking →

Kontext-Erweiterung → Generierung → Antwort

Implikationen:

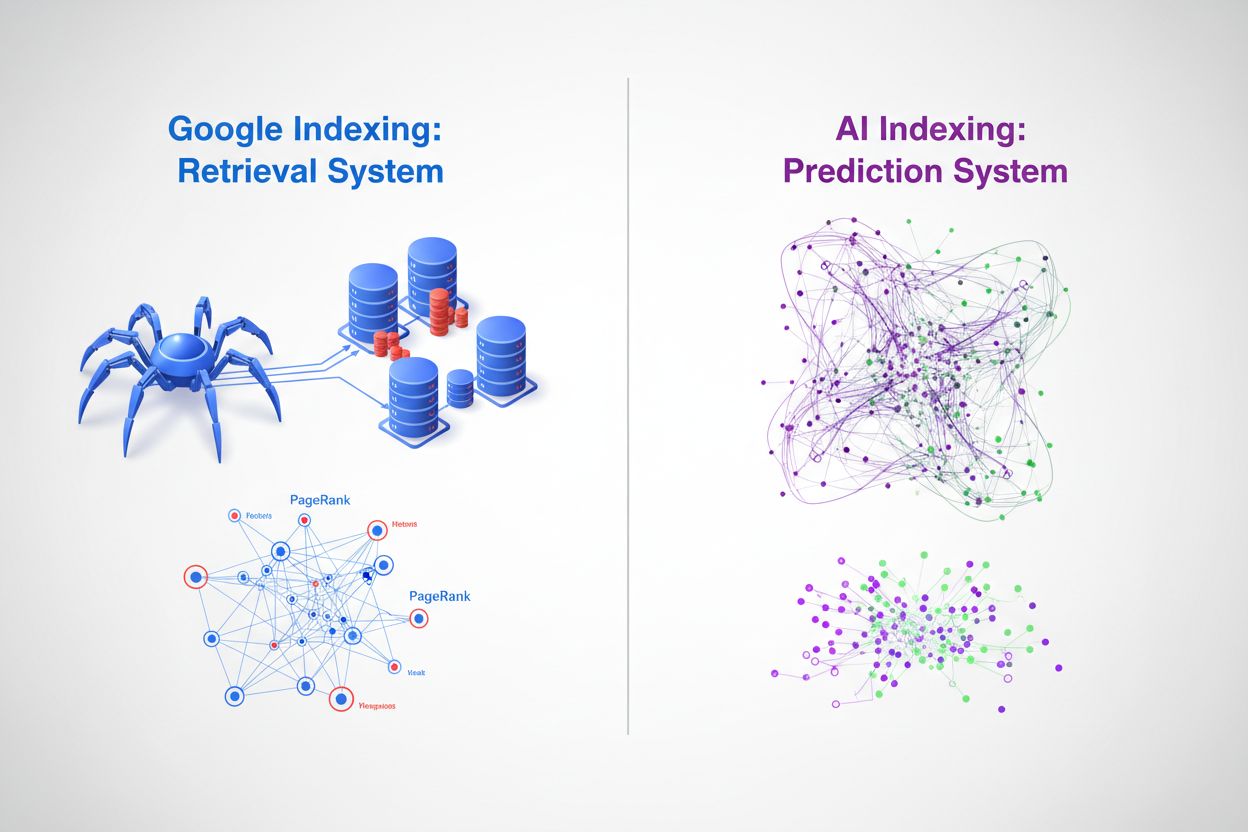

Der Hauptunterschied zu Google:

Google: Crawlen → Indexieren → Seiten ranken → Links anzeigen RAG: Anfrage → Suchen → Passagen abrufen → Antwort synthetisieren

KI ruft ab und synthetisiert. Google rankt und verlinkt.

Jede Plattform hat unterschiedliche Infrastruktur:

ChatGPT (mit Browsing):

Perplexity:

Claude:

Google Gemini / KI-Überblick:

Die praktische Auswirkung:

Ihre Inhalte im Google-Index helfen für:

Aber Sie brauchen auch:

Ergänzung technischer Tiefe zum Retrieval-Prozess.

Wie RAG-Retrieval tatsächlich funktioniert:

Schritt 1: Anfrageverarbeitung

"Was ist das beste CRM für Kleinunternehmen?"

↓

Tokenisieren → Einbetten → Anfrage-Vektor

Schritt 2: Vektorsuche

Anfrage-Vektor wird mit Dokumenten-Vektoren verglichen

Semantische Ähnlichkeitsscores

Top-K relevante Dokumente werden abgerufen

Schritt 3: Neu-Ranking

Erste Ergebnisse werden neu bewertet

Autoritätssignale berücksichtigt

Aktualität gewichtet

Endgültiges Ranking wird erstellt

Schritt 4: Kontext-Erweiterung

Abgerufene Passagen werden zum Prompt hinzugefügt

Quellen-Metadaten bleiben erhalten

Tokenlimits werden verwaltet

Was Ihren Abruf beeinflusst:

Der Indexierungsunterschied:

Google: Seitenbasiertes Ranking mit Hunderten von Signalen RAG: Passagenbasiertes Retrieval mit semantischem Matching

Ihre Seite kann bei Google #1 ranken, aber von RAG nicht abgerufen werden, wenn:

Technische Umsetzungsperspektive.

Sicherstellen, dass KI-Systeme auf Ihre Inhalte zugreifen können:

Robots.txt:

User-agent: GPTBot

Allow: /

User-agent: ClaudeBot

Allow: /

User-agent: PerplexityBot

Allow: /

User-agent: Google-Extended

Allow: /

Serverseitiges Rendering:

KI-Crawler führen JavaScript meist nicht gut aus. Wenn Ihre Inhalte per JS geladen werden:

Antwortzeiten:

KI-Crawler sind weniger geduldig als Google. Optimieren Sie auf:

Strukturierte Daten:

Hilft KI-Systemen, Inhalte zu verstehen:

{

"@type": "Article",

"headline": "...",

"author": { ... },

"datePublished": "...",

"dateModified": "..."

}

Die Überprüfung:

Server-Logs auf KI-Crawler-Aktivität prüfen:

Wenn Sie keine Crawl-Anfragen sehen, blockiert etwas die Bots.

Wie die Content-Struktur das KI-Retrieval beeinflusst.

Die Realität der Passagen-Extraktion:

KI-Systeme lesen keine ganzen Seiten. Sie extrahieren Passagen, die Anfragen beantworten. Ihre Content-Struktur bestimmt, was extrahiert wird.

Gut für die Extraktion:

## Was ist GEO?

GEO (Generative Engine Optimization) ist die Praxis,

Inhalte so zu optimieren, dass sie in KI-generierten

Antworten zitiert werden. Es geht darum, Zitationen

zu erhalten statt Rankings.

Saubere Passage, leicht zu extrahieren und zu zitieren.

Schlecht für die Extraktion:

## Die Entwicklung des digitalen Marketings

In den letzten Jahren, mit dem technologischen Fortschritt,

gab es viele Veränderungen, wie Unternehmen ihre Online-Sichtbarkeit

angehen. Ein neuer Bereich, manchmal GEO oder generative

Engine-Optimierung genannt, stellt einen Wandel im Denken dar,

wie Inhalte entdeckt werden...

Versteckte Antwort, schwer zu extrahieren.

Technische Struktur-Empfehlungen:

Schema für Passagen:

Erwägen Sie FAQ-Markup mit Schema – explizite Frage-/Antwortstruktur, die KI auslesen kann:

{

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Was ist GEO?",

"acceptedAnswer": {

"@type": "Answer",

"text": "GEO ist..."

}

}]

}

Performance-Faktoren für KI-Crawling.

Was ich aus Log-Analysen gelernt habe:

KI-Crawler-Verhalten:

Die entscheidenden Zahlen:

| Metrik | Google-Toleranz | KI-Crawler-Toleranz |

|---|---|---|

| TTFB | 500ms+ okay | 200ms ideal, 300ms max |

| Vollständige Ladung | 3-4s | 2s bevorzugt |

| 429er | Wiederholt | Möglicherweise kein Retry |

| 503er | Wartet und wiederholt | Bricht oft ab |

Empfehlungen:

Das Infrastruktur-Argument:

Wenn KI-Crawler nicht zuverlässig auf Ihre Inhalte zugreifen können, sind Sie schlicht nicht im Retrieval-Pool.

Brücke zwischen Google-Indexierung und KI-Retrieval.

Google-Indexierung hilft der KI, weil:

Aber Google-Indexierung reicht nicht, weil:

Technische Checkliste:

Für Google (traditionell):

Für KI-Retrieval (zusätzlich):

Beides machen.

Google-Indexierung ist notwendig, aber nicht ausreichend für KI-Sichtbarkeit.

Dieser Thread hat das technische Umfeld geklärt.

Meine wichtigsten Erkenntnisse:

Zwei Mechanismen für KI-Inhalte:

RAG-Retrieval-Prozess:

Wesentliche Unterschiede zu Google:

Technische Anforderungen:

To-dos:

Danke für die technische Tiefe!

Get personalized help from our team. We'll respond within 24 hours.

Überprüfen Sie, ob KI-Systeme Ihre Inhalte finden und zitieren. Verstehen Sie Ihre Sichtbarkeit in ChatGPT, Perplexity und anderen KI-Plattformen.

Erfahren Sie, wie KI-Engines wie ChatGPT, Perplexity und Gemini Webinhalte mithilfe fortschrittlicher Crawler, NLP und maschinellem Lernen indexieren und verarb...

Entdecken Sie die grundlegenden Unterschiede zwischen KI-Indexierung und Google-Indexierung. Erfahren Sie, wie LLMs, Vektor-Embeddings und semantische Suche die...

Community-Diskussion darüber, wie KI-Engines Inhalte indexieren. Echte Erfahrungen von technischen SEOs mit dem Verständnis des Verhaltens von KI-Crawlern und d...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.