Lazy Loading

Lazy Loading verschiebt das Laden nicht-kritischer Ressourcen, bis sie benötigt werden. Erfahren Sie, wie diese Optimierungstechnik die Seitenladegeschwindigkei...

Erfahren Sie, wie Lazy Loading KI-Crawler und Antwortmaschinen beeinflusst. Entdecken Sie Best Practices, um sicherzustellen, dass Ihre Inhalte für KI-Systeme sichtbar bleiben und gleichzeitig eine schnelle Seitenperformance gewährleistet ist.

Lazy Loading ist eine Performance-Optimierungstechnik, bei der das Laden nicht-kritischer Ressourcen aufgeschoben wird, bis sie tatsächlich benötigt werden. Wenn es falsch implementiert wird, kann es die Fähigkeit von KI-Crawlern, Ihre Inhalte zu indexieren, erheblich beeinträchtigen und Ihre Website möglicherweise vor KI-Suchmaschinen, ChatGPT, Perplexity und anderen KI-Antwortgeneratoren verbergen.

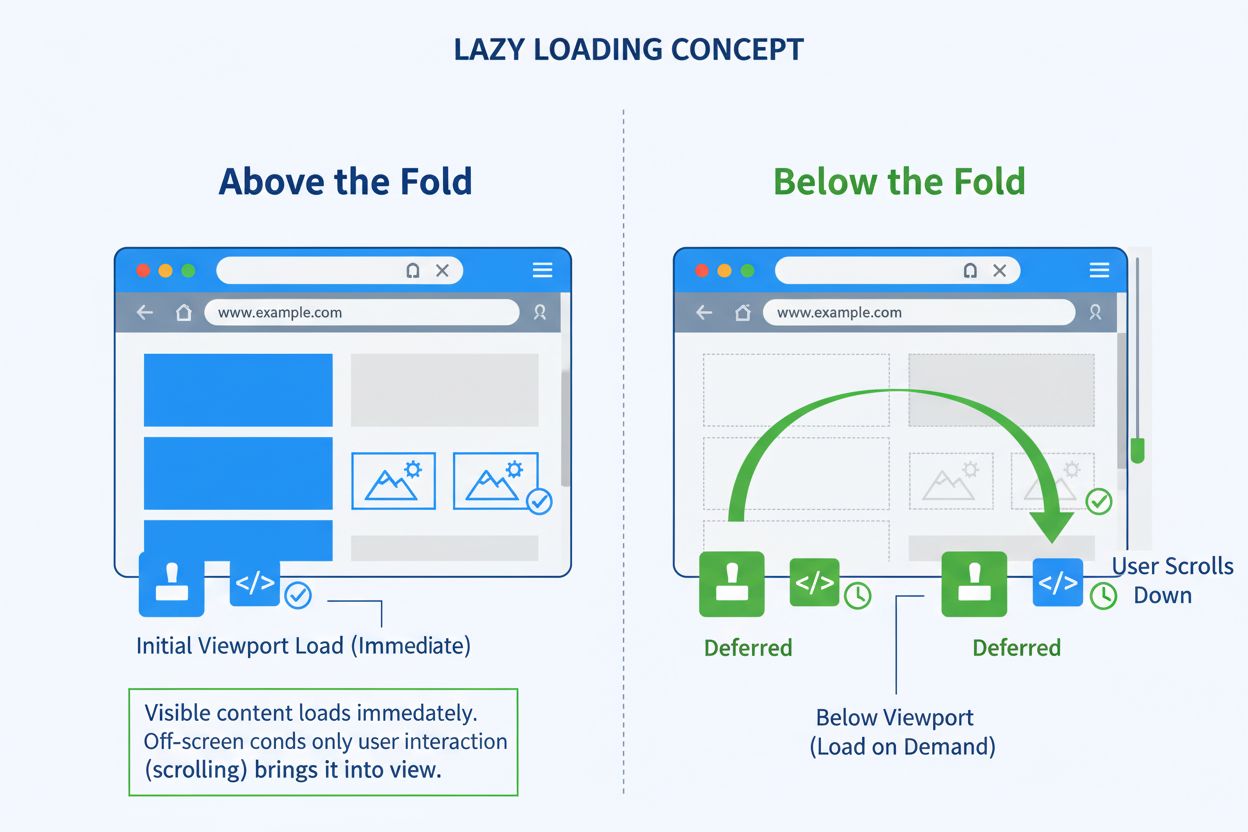

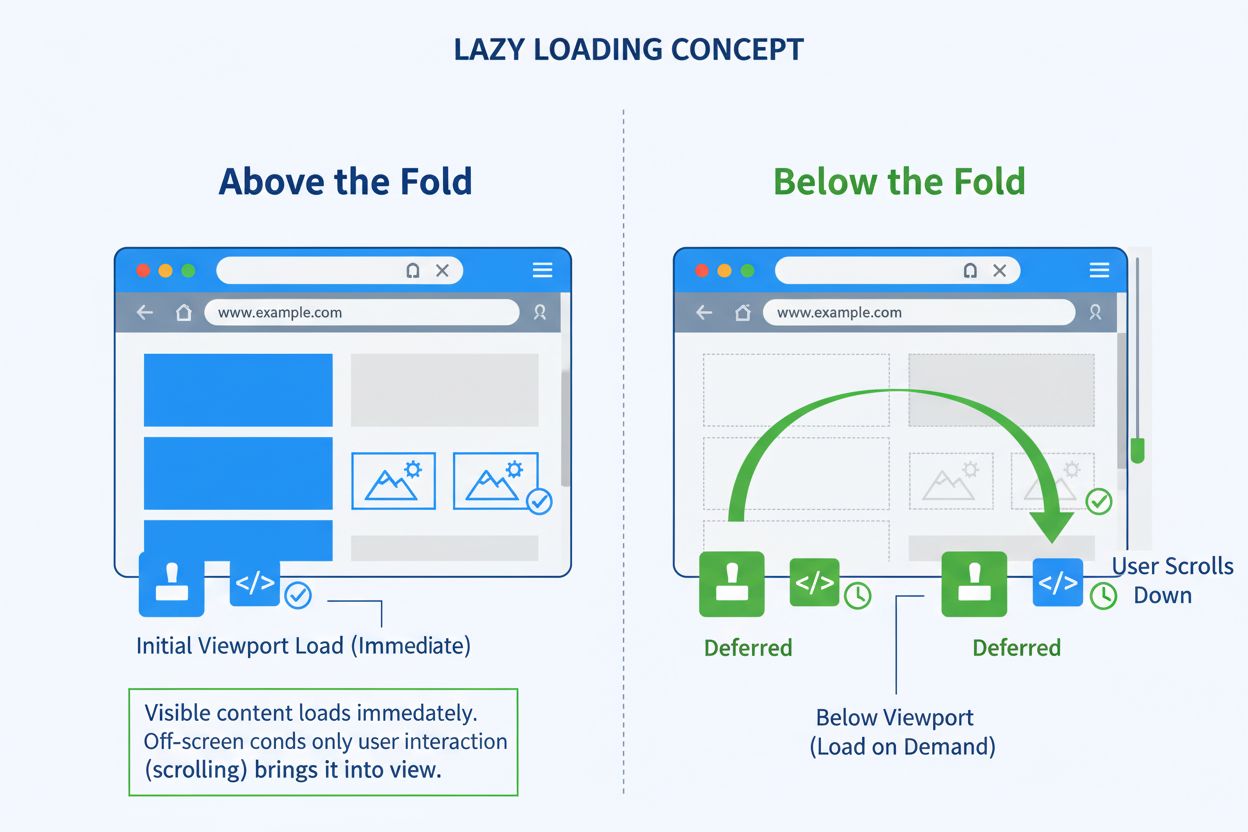

Lazy Loading ist eine Performance-Optimierungstechnik, bei der das Laden nicht-kritischer Ressourcen solange aufgeschoben wird, bis sie tatsächlich benötigt werden. Anstatt beim Aufruf einer Webseite sämtliche Inhalte sofort zu laden, priorisiert Lazy Loading ausschließlich die essenziellen Inhalte, die im anfänglichen Viewport erscheinen, und verzögert alles andere, bis der Nutzer scrollt oder mit der Seite interagiert. Dieses Vorgehen verkürzt die anfängliche Ladezeit erheblich, verbessert die Core Web Vitals und optimiert das Nutzererlebnis durch effizientere Inhaltsauslieferung.

Die Technik arbeitet, indem Ressourcen als nicht-blockierend (nicht-kritisch) gekennzeichnet und nur bei Bedarf geladen werden. Zwischen 2011 und 2019 stieg das durchschnittliche Ressourcen-Gewicht von etwa 100KB auf 400KB für Desktop und von 50KB auf 350KB für Mobilgeräte, während Bildgrößen von 250KB auf 900KB (Desktop) und 100KB auf 850KB (Mobil) zunahmen. Lazy Loading begegnet dieser Herausforderung, indem es den kritischen Rendering-Pfad verkürzt und schnellere Seitenladezeiten ermöglicht, ohne Qualität oder visuelle Fülle der Inhalte zu opfern.

Lazy Loading arbeitet mit mehreren Mechanismen, die bestimmen, wann und wie Ressourcen geladen werden. Die gängigste Implementierung nutzt die IntersectionObserver API, die erkennt, wann ein Element in den Viewport des Browsers eintritt, und das Laden in diesem Moment auslöst. Dieser Ansatz ist effizienter als ältere Scroll-Event-Listener, weil er keine Nutzerinteraktion benötigt, die KI-Crawler nicht ausführen können.

Der Ablauf ist einfach: Zuerst lädt die Seite nur essenzielle Inhalte wie Above-the-Fold-Bilder, Hauptskripte und kritische Stylesheets. Nicht-essenzielle Elemente bleiben als Platzhalter sichtbar, häufig als unscharfe oder niedrig aufgelöste Versionen. Wenn der Nutzer scrollt oder bestimmte Bereiche ansieht, werden die lazy-geladenen Elemente dynamisch nachgeladen. Der Browser holt und zeigt diese Inhalte also nur dann an, wenn sie tatsächlich gebraucht werden – was Ladezeit und Bandbreite spart.

Moderne Browser unterstützen natives Lazy Loading mit dem Attribut loading="lazy" bei Bildern und iframes. Diese eingebaute Funktion ermöglicht Entwicklern Lazy Loading ohne komplexes JavaScript und ist zuverlässiger und zugänglicher für Suchmaschinen und KI-Crawler. JavaScript-basierte Lazy-Loading-Implementierungen, die auf Nutzerinteraktionen oder Scroll-Events setzen, können hingegen erhebliche Probleme verursachen, da KI-Systeme Seiten nicht wie Menschen bedienen.

Wird Lazy Loading falsch implementiert, entsteht eine große Barriere zwischen Ihren Inhalten und KI-Crawlern von Systemen wie ChatGPT, Perplexity, Bing AI, Googles KI-Funktionen und anderen Antwortmaschinen. Diese KI-basierten Systeme durchsuchen Websites ähnlich wie traditionelle Suchmaschinen, unterliegen aber besonderen Einschränkungen, die fehlerhaftes Lazy Loading besonders problematisch machen.

KI-Crawler und Antwortmaschinen arbeiten unter folgenden Bedingungen:

| Crawler-Verhalten | Auswirkung auf Lazy Loading | Konsequenz |

|---|---|---|

| Begrenzte JavaScript-Ausführung | JavaScript-abhängiges Lazy Loading wird evtl. nicht ausgelöst | Inhalte bleiben für Crawler unsichtbar |

| Keine Nutzerinteraktion | Scrollen oder Klicken zur Inhaltsanzeige nicht möglich | Inhalte unterhalb der ersten Ansicht werden nie geladen |

| Einmaliges Crawling | Warten nicht auf verzögerte Ressourcen | Inhalte fehlen beim initialen Crawl |

| Einschränkungen von Headless-Browsern | Manche JavaScript-Frameworks rendern nicht | Strukturierte Daten und semantische Markups gehen verloren |

| Zeitlich begrenzte Crawls | Warten nicht auf alle Ressourcen | Unvollständige Inhaltsindexierung |

Das Grundproblem ist, dass KI-Crawler Seiten nicht wie Menschen bedienen. Sie scrollen nicht, klicken keine Buttons und warten nicht auf bedarfsgesteuertes JavaScript. Wenn für Ihre Inhalte Nutzerinteraktion notwendig ist, werden viele KI-Crawler sie nie sehen. Bedeutet: Wesentliche Produktinfos, Rezensionen, strukturierte Daten und ganze Seitenbereiche bleiben für KI-Systeme, die über Sichtbarkeit in KI-generierten Antworten entscheiden, komplett unsichtbar.

Falsch verwendet, behindert Lazy Loading Ihre Sichtbarkeit aktiv, indem Suchmaschinen und KI-Crawler keinen Zugriff auf Ihre Inhalte haben. Das führt zu einer Kette von Problemen, die Ihre Chancen auf KI-basierte Antworten und Sprachassistenten direkt beeinträchtigen.

Inhalte werden beim initialen Crawl nicht gerendert, weil KI-Systeme meist nur einen einzigen Crawl-Durchlauf machen, ohne auf JavaScript-Ausführung oder Nutzerinteraktionen zu warten. Ist Ihr wichtiger Content hinter Lazy Loading versteckt, das Scrollen oder Klicken erfordert, fehlt er dem Crawler komplett – und gelangt nie in die Wissensbasis der KI.

JavaScript-gesteuertes Nachladen scheitert in Headless-Browsern, die viele KI-Crawler nutzen. Zwar können diese Browser manches JavaScript ausführen, aber komplexe Frameworks oder asynchrones Laden funktionieren oft nicht zuverlässig. Wenn Ihr Lazy Loading auf solchen Mustern basiert, kann der Crawler den Code nicht richtig ausführen – Ihre Inhalte bleiben unsichtbar.

Wichtige Elemente landen nie im HTML-DOM, wenn Lazy Loading falsch implementiert wird. KI-Crawler analysieren das gerenderte HTML, um die Seitenstruktur zu verstehen. Wenn Ihre Inhalte erst nach Nutzerinteraktion in den DOM gelangen, sind sie beim Crawl nicht sichtbar – die KI kann Kontext und Relevanz Ihres Contents nicht erfassen.

Strukturierte Daten und semantische Markups gehen verloren, wenn Lazy Loading das ordnungsgemäße Rendering verhindert. Schema-Markup, JSON-LD und semantische HTML-Elemente, die KI-Systemen Bedeutung und Kontext vermitteln, werden möglicherweise nie ausgelesen, wenn sie erst nach dem initialen Crawl geladen werden. Wichtige Signale für Autorität und Relevanz Ihrer Inhalte entfallen.

Rich Snippets und KI-Antworten übergehen Ihre Seite komplett, wenn Ihre Inhalte beim Crawl unsichtbar sind. KI-Antwortmaschinen bevorzugen gut strukturierte, leicht auffindbare Inhalte von vertrauenswürdigen Seiten. Ist Ihr Content für Crawler unsichtbar, wird er für Featured Answers, Sprachassistenten oder KI-Zusammenfassungen gar nicht erst berücksichtigt.

Nehmen wir einen Online-Händler, der Lazy Loading zur Verbesserung der Seitenladezeit einsetzt. Produktbilder, Spezifikationen, Kundenbewertungen und Preisinformationen werden erst nach dem Scrollen geladen. Für menschliche Besucher funktioniert das hervorragend: Die Seite lädt schnell, das Nutzererlebnis ist flüssig.

Kommt jedoch ein KI-Crawler von Perplexity auf der Suche nach „bester wasserdichter Wanderrucksack mit Lendenwirbelstütze“, entsteht ein Problem: Ohne menschliches Scrollen werden die Rucksack-Listings, Spezifikationen und Bewertungen nie geladen. Der Crawler sieht keinerlei Produktinhalte. Ein Wettbewerber, der natives Lazy Loading mit serverseitig gerendertem Markup verwendet, erhält hingegen die Antwortmaschinenplatzierung, Erwähnungen durch Sprachassistenten und Top-Positionen. Das Inventar des ersten Händlers bleibt in unsichtbaren JavaScript-Aufrufen verborgen und für KI-Systeme, die relevanten Traffic und Umsatz bringen könnten, vollkommen unsichtbar.

Natives Lazy Loading mit dem Attribut loading="lazy" ist der zuverlässigste Weg, um Sichtbarkeit für Nutzer und KI-Crawler zu gewährleisten. Diese Browserfunktion lädt Bilder und iframes effizient und versteckt sie nicht vor Crawlern. Natives Lazy Loading stellt sicher, dass wichtige Seitenelemente im HTML-Quelltext verbleiben und KI-Systeme Ihre Inhalte zuverlässig indexieren können.

<img src="backpack.jpg" loading="lazy" alt="Wanderrucksack mit Lendenwirbelstütze">

<iframe src="map.html" loading="lazy" title="Standortkarte"></iframe>

Beim nativen Lazy Loading sind die Ressourcen im HTML-Quelltext, den Crawler auslesen. Auch wenn das Laden des eigentlichen Bildes oder iframes erst beim Bedarf erfolgt, ist das Element im DOM vorhanden, sodass Crawler die Seitenstruktur und Metadaten erkennen. So bleibt die Balance zwischen Performance und Sichtbarkeit gewahrt.

Falls Lazy Loading per JavaScript notwendig ist, stellen Sie sicher, dass Schlüsselinformationen beim ersten Seitenaufruf im DOM sind. Crawler warten nicht immer auf das Client-Side Rendering, deshalb muss kritischer Content direkt im initialen HTML-Antwort enthalten sein. Mit Pre-Rendering-Tools oder Frameworks wie Next.js mit Server-Side Rendering (SSR) liefern Sie für Crawler eine vollständig aufgebaute HTML-Version aus, während Nutzer weiter von Dynamik profitieren.

Zusätzlich unterstützen Dienste wie Prerender.io mit vorgerenderten Snapshots, die an Bots ausgeliefert werden, sodass beim Crawl keine Inhalte verloren gehen. So entstehen zwei Seitenversionen: statisch für Crawler, dynamisch für Nutzer. Der Crawler bekommt sofort alle Inhalte, der Nutzer genießt Performance-Vorteile.

Vermeiden Sie Infinite Scrolling, das Inhalte nur per JavaScript nachlädt und keine dauerhaften URLs bereitstellt. KI-Crawler benötigen Standard-HTML-Links, um Ihre Seite zu durchsuchen. Schlüsselseiten sollten per statischer Verlinkung oder crawlbarer Paginierung („Seite 1“, „Seite 2“ etc.) erreichbar sein. Erstellen Sie auch XML-Sitemaps für dynamisch geladene Seiten, um deren Indexierung zu gewährleisten.

Jeder Inhalt, der per Infinite Scroll geladen wird, sollte eine eigene, permanente URL besitzen. Verwenden Sie absolute Seitenzahlen in URLs (z.B. ?page=12) statt relative wie ?date=yesterday. So finden Crawler konsistent die gleichen Inhalte und KI-Systeme können sie besser einordnen.

Auch wenn Teile Ihrer Seite später geladen werden, sollten strukturierte Daten im initialen Quelltext verfügbar sein. So verstehen Crawler Beziehungen in Ihren Inhalten und können diese indexieren. Implementieren Sie Schema-Markup für Produkte, FAQs, Artikel und andere Inhaltstypen. Kurz gesagt: So viele SEO-relevante Metadaten wie möglich vor dem Lazy Loading bereitstellen.

<script type="application/ld+json">

{

"@context": "https://schema.org",

"@type": "Product",

"name": "Wasserdichter Wanderrucksack",

"description": "Robuster Rucksack mit Lendenwirbelstütze",

"image": "backpack.jpg",

"offers": {

"@type": "Offer",

"price": "129.99"

}

}

</script>

Strukturierte Daten im initialen Quelltext sorgen dafür, dass KI-Crawler Bedeutung und Kontext Ihrer Inhalte sofort erkennen, ohne auf Lazy-Loaded-Elemente warten zu müssen. Das ist besonders für Shops, FAQ-Seiten und KI-relevante Inhalte wichtig.

Verlassen Sie sich nicht auf Annahmen – testen Sie die Sichtbarkeit wie KI-Systeme. Nutzen Sie Google Search Console URL-Prüfung, Google Lighthouse, Screaming Frog SEO Spider und Bing Webmaster Tools. Überprüfen Sie speziell, ob Lazy-Loaded-Elemente im gerenderten HTML erscheinen. Fehlen sie, haben Sie ein Discovery-Problem, das KI-Systeme vom Crawlen abhält.

Das URL-Prüftool in der Google Search Console zeigt genau, welche Inhalte der Googlebot sieht. Fehlen wichtige Inhalte im gerenderten HTML, werden sie auch von KI-Crawlern nicht erkannt. Solche Tests sollten fester Bestandteil Ihrer Qualitätskontrolle sein – besonders bei der Einführung oder Überarbeitung von Lazy Loading.

Answer Engine Optimization (AEO) verschärft die Anforderungen an Lazy Loading. Während klassische SEO auf Suchrankings abzielte, geht es bei AEO darum, die maßgebliche Antwort zu liefern, die KI-Systeme zitieren und empfehlen. Dazu braucht es nicht nur guten Inhalt, sondern klar strukturierten, leicht auffindbaren und sofort zugänglichen Content für Crawler.

Tools wie ChatGPT, Alexa, Perplexity und Googles KI beziehen Antworten aus gut strukturierten, crawlbaren Quellen. Ist Ihr Content hinter träge ladenden Oberflächen oder reinen JavaScript-Schichten versteckt, taucht er in KI-Antworten nicht auf. Viele Marken verpassen diese Chance – nicht weil die Inhalte schlecht wären, sondern weil sie für die entscheidenden Systeme unsichtbar sind.

Der Unterschied ist erheblich: In der klassischen Suche bekommen Sie auch auf Seite zwei noch ein paar Besucher. Bei KI-Antworten gibt es nur noch Sichtbarkeit oder gar nichts – wenn Ihr Content nicht erfasst wird, erhalten Sie null Traffic. Es gibt kein „Seite zwei“ für KI-Antworten – nur das, was die KI findet und als maßgeblich ansieht.

Mehrere bewährte Plattformen und Tools helfen beim Lazy Loading ohne Sichtbarkeitsverlust für Crawler. Gatsby Image und Next.js Image sind React-Bibliotheken mit eingebautem, SEO-sicherem Lazy Loading, das automatisch für Nutzer und Crawler optimiert. Lazysizes.js ist eine flexible, weitverbreitete Lazy-Loading-Bibliothek, die gut mit Suchmaschinen und KI-Crawlern funktioniert.

Für fortgeschrittene Umsetzungen ermöglichen Cloudflare Workers und Akamai Edge Workers Pre-Rendering und serverseitige Auslieferung, sodass Crawler vollständiges HTML bekommen, während Nutzer von Performance profitieren. Diese Edge-Computing-Lösungen können unterschiedliche Seitenversionen an verschiedene Besucher ausliefern – vorgerendert für Crawler, dynamisch für Menschen.

Dynamic Rendering ist eine bewährte Technik, die Lazy Loading mit Crawler-Optimierung kombiniert. Dabei erhalten Bots vorgerendertes HTML, während Nutzer eine JavaScript-reiche Oberfläche sehen. Moderne Frameworks wie Next.js und Nuxt unterstützen hybride Builds, bei denen serverseitig gerenderte Inhalte und dynamische UI-Elemente koexistieren – für optimale Performance und Crawlability.

Lazy Loading von Above-the-Fold-Inhalten ist ein schwerwiegender Fehler, der Ihre Core Web Vitals und das Nutzererlebnis direkt verschlechtert. Wird Lazy Loading auf Hero-Bilder, Logos oder zentrale Call-to-Action-Buttons angewendet, erscheinen diese verzögert und der Largest Contentful Paint (LCP) steigt. Solche Elemente sollten immer vorab geladen werden, damit sie sofort sichtbar sind.

Kein Platzhalter für Lazy-Loaded-Elemente verursacht einen Cumulative Layout Shift (CLS), wenn Bilder und Videos ohne explizite Breiten- und Höhenangaben geladen werden. Legen Sie immer die Maße für Bilder, Videos und iframes fest, damit das Layout stabil bleibt und kein unerwartetes „Verrutschen“ auftritt.

Lazy Loading von zu vielen JavaScript- und CSS-Dateien kann Render-Blocking verursachen, sodass der Browser die Seite nicht korrekt anzeigen kann, weil er auf kritische Ressourcen wartet. Laden Sie kritisches CSS inline für sofortiges Styling und verzögern Sie nur nicht-essenzielle Skripte. Nutzen Sie Tools für Critical CSS, um die wichtigsten Styles für Above-the-Fold-Inhalte zu extrahieren.

Lazy Loading externer Ressourcen ohne Optimierung kann die Seitenladezeit erheblich verlangsamen. Drittanbieter-Ressourcen wie Werbebanner, Social-Media-Feeds und Tracking-Skripte sollten verzögert und nach Möglichkeit über ein CDN geladen werden. Lazy Loaden Sie nur nicht-essentielle Drittanbieter-Inhalte, die die Kernfunktionalität nicht beeinträchtigen.

Lazy Loading für nicht-scrollbare Inhalte wie feststehende Navigationsleisten oder Karussells kann verhindern, dass diese Elemente jemals geladen werden, da kein Viewport-Event ausgelöst wird. Schließen Sie fest positionierte Inhalte vom Lazy Loading aus, damit sie sofort beim Seitenaufruf erscheinen.

Angesichts der enormen Bedeutung von KI-Sichtbarkeit im modernen Marketing ist die Überwachung Ihrer KI-Präsenz unerlässlich. AmICited bietet eine umfassende Überwachung der Markenpräsenz in KI-Antwortgeneratoren wie ChatGPT, Perplexity, Bing AI und anderen KI-Suchmaschinen. So sehen Sie, ob Ihre Lazy-Loading-Strategie die Sichtbarkeit für KI-Systeme erhält oder versehentlich Inhalte verbirgt.

Durch das Monitoring Ihrer Marke in KI-Antworten erkennen Sie, welche Inhalte erscheinen sollten, aber nicht gefunden werden, ob Lazy Loading die Ursache ist und ob Ihre Optimierungen greifen. So stellen Sie sicher, dass Ihre Performance-Optimierungen nicht auf Kosten der KI-Sichtbarkeit gehen – dem wichtigsten Entdeckungskanal für moderne Zielgruppen.

Stellen Sie sicher, dass Ihre Inhalte in KI-generierten Antworten auf ChatGPT, Perplexity und anderen KI-Suchmaschinen erscheinen. Verfolgen Sie die Präsenz Ihrer Marke und optimieren Sie für KI-Sichtbarkeit.

Lazy Loading verschiebt das Laden nicht-kritischer Ressourcen, bis sie benötigt werden. Erfahren Sie, wie diese Optimierungstechnik die Seitenladegeschwindigkei...

Community-Diskussion darüber, ob das Lazy Loading von Bildern und Inhalten die Sichtbarkeit für KI-Crawler beeinflusst. Entwickler teilen Erfahrungen und Best P...

Die Seitenladegeschwindigkeit misst, wie schnell eine Webseite lädt. Erfahren Sie mehr über Core Web Vitals-Kennzahlen, warum Seitenladegeschwindigkeit für SEO ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.