Definition von Erkennung von KI-Inhalten

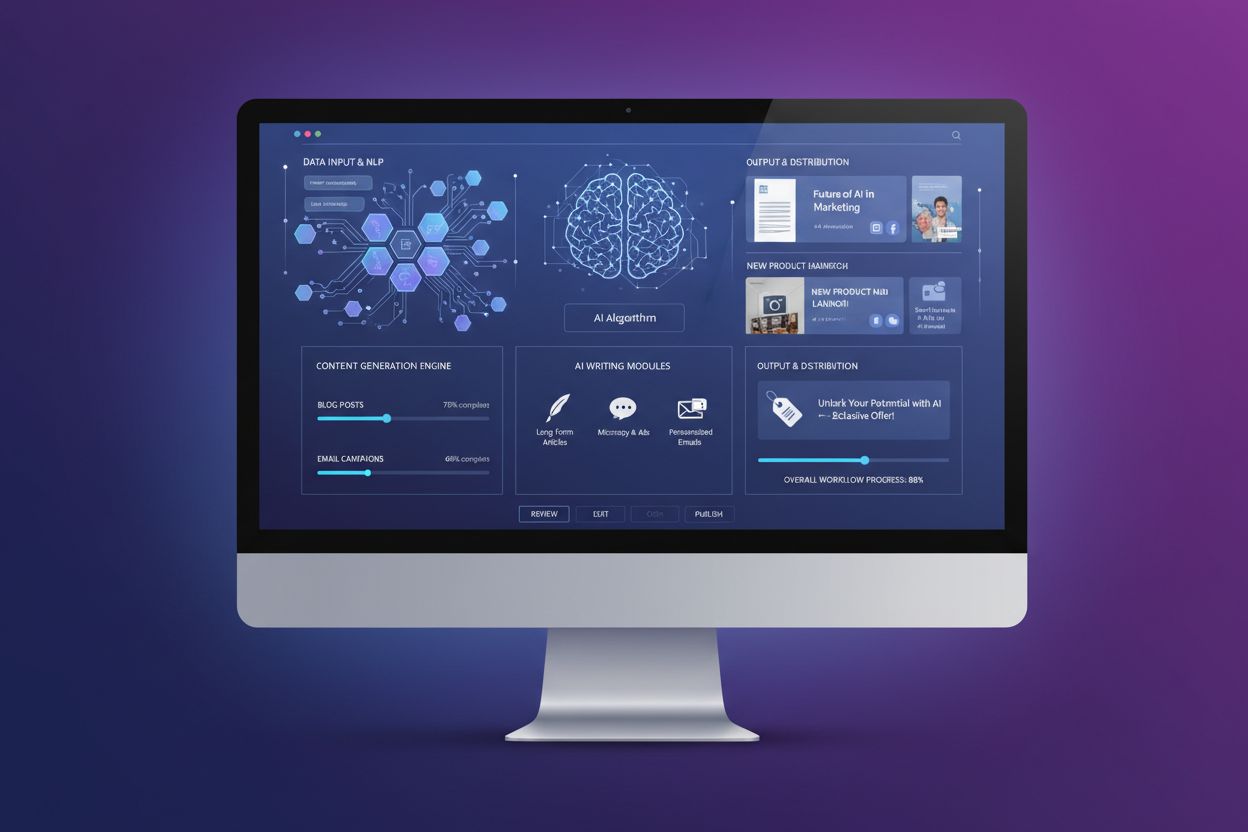

Erkennung von KI-Inhalten ist der Prozess, bei dem spezialisierte Algorithmen, Modelle des maschinellen Lernens und Methoden der natürlichen Sprachverarbeitung verwendet werden, um digitale Inhalte zu analysieren und zu bestimmen, ob sie von künstlichen Intelligenzsystemen erstellt oder von Menschen verfasst wurden. Diese Erkennungstools untersuchen sprachliche Muster, statistische Eigenschaften und semantische Merkmale von Texten, Bildern und Videos, um Inhalte als KI-generiert, menschlich geschrieben oder als hybride Kombination einzuordnen. Die Technologie ist zunehmend entscheidend geworden, da generative KI-Systeme wie ChatGPT, Claude, Gemini und Perplexity immer ausgefeiltere Inhalte produzieren, die menschliches Schreiben täuschend echt nachahmen. Erkennung von KI-Inhalten wird in verschiedenen Branchen eingesetzt, darunter Bildung, Verlagswesen, Personalwesen, Content Marketing und Markenmonitoring-Plattformen, die die Authentizität von Inhalten überprüfen und nachverfolgen müssen, wie Marken in KI-gestützten Such- und Antwortsystemen erscheinen.

Kontext und Hintergrund

Das Aufkommen fortschrittlicher generativer KI-Modelle in den Jahren 2022–2023 schuf einen dringenden Bedarf an zuverlässigen Erkennungsmechanismen. Wie Forscher des Stanford HAI berichteten, nutzten 2024 bereits 78 % der Organisationen KI, gegenüber 55 % im Vorjahr, was zu enormen Mengen KI-generierter Inhalte im Internet führte. Bis 2026 schätzen Experten, dass 90 % der Online-Inhalte von KI generiert sein könnten, wodurch Erkennungsfähigkeiten für die Wahrung der Inhaltsintegrität und Authentizitätsprüfung unerlässlich werden. Der Markt für KI-Detektoren wächst rasant, mit einem Wert von 583,6 Mrd. USD im Jahr 2025 und einer erwarteten jährlichen Wachstumsrate von 27,9 %, sodass er bis 2032 3.267,5 Mrd. USD erreichen soll. Diese Marktexpansion spiegelt die steigende Nachfrage von Bildungseinrichtungen, denen akademische Integrität wichtig ist, von Verlagen, die Qualitätsstandards sichern wollen, und von Unternehmen wider, die eine Verifizierung der Inhaltsechtheit benötigen. Die Entwicklung von Erkennungstools für KI-Inhalte stellt ein kritisches Wettrennen zwischen Detektionstechnologie und immer ausgefeilteren KI-Modellen dar, die durch menschenähnlichere Schreibmuster eine Erkennung erschweren sollen.

Wie Erkennung von KI-Inhalten funktioniert

Erkennung von KI-Inhalten erfolgt durch eine ausgeklügelte Kombination aus maschinellem Lernen und Methoden der natürlichen Sprachverarbeitung. Grundlegend werden Klassifikatoren trainiert – maschinelle Lernmodelle, die Texte in die vorgegebenen Kategorien „KI-generiert“ und „menschlich geschrieben“ einordnen. Diese Klassifikatoren werden mit riesigen Datensätzen trainiert, die Millionen von Dokumenten enthalten, die entweder als KI-generiert oder als von Menschen verfasst gekennzeichnet sind, sodass sie die charakteristischen Muster beider Kategorien erlernen. Im Erkennungsprozess werden verschiedene sprachliche Merkmale analysiert, darunter Wortfrequenz, Satzlänge, grammatische Komplexität und semantische Kohärenz. Embeddings spielen hierbei eine zentrale Rolle, indem Wörter und Phrasen in numerische Vektoren umgewandelt werden, die Bedeutung, Kontext und Beziehungen zwischen Konzepten abbilden. Diese mathematische Darstellung ermöglicht es KI-Systemen, semantische Beziehungen zu erkennen – zum Beispiel, dass „König“ und „Königin“ konzeptionell verwandt sind, auch wenn es unterschiedliche Wörter sind.

Zwei Schlüsselmetriken, die Erkennungstools für KI-Inhalte messen, sind Perplexity und Burstiness. Perplexity dient als eine Art „Überraschungsmesser“, der bewertet, wie vorhersehbar ein Text ist; KI-generierte Inhalte weisen typischerweise eine niedrige Perplexity auf, da Sprachmodelle darauf trainiert sind, statistisch wahrscheinliche Wortfolgen zu produzieren – das resultiert in vorhersehbaren und einheitlichen Schreibmustern. Im Gegensatz dazu enthält menschliches Schreiben mehr unerwartete Wortwahlen und kreative Ausdrücke, was zu höheren Perplexity-Werten führt. Burstiness misst die Variation der Satzlänge und der strukturellen Komplexität im gesamten Dokument. Menschliche Autoren wechseln natürlich zwischen kurzen, prägnanten Sätzen und längeren, komplexeren Konstruktionen, was zu hoher Burstiness führt. KI-Systeme, die auf Vorhersagealgorithmen beruhen, erzeugen meist gleichmäßigere Satzstrukturen mit niedriger Burstiness. Führende Plattformen wie GPTZero gehen über diese beiden Metriken hinaus und nutzen mehrschichtige Systeme mit sieben oder mehr Komponenten zur Bestimmung der KI-Wahrscheinlichkeit, einschließlich Satzklassifikation, Internetsuche nach Text und Abwehrmechanismen gegen Erkennungsumgehungen.

| Erkennungsmethode | Funktionsweise | Stärken | Einschränkungen |

|---|

| Analyse von Perplexity & Burstiness | Misst Vorhersehbarkeit und Satzvariationsmuster | Schnell, recheneffizient, grundlegender Ansatz | Kann bei formalem Schreiben Falsch-Positive erzeugen; eingeschränkte Genauigkeit bei kurzen Texten |

| Maschinelle Lernklassifikatoren | Auf gelabelten Datensätzen trainiert, um KI- vs. Menschentext zu kategorisieren | Sehr genau auf Trainingsdaten, anpassungsfähig an neue Modelle | Erfordert kontinuierliches Nachtrainieren; Schwierigkeiten mit neuen KI-Architekturen |

| Embeddings & Semantikanalyse | Wandelt Text in numerische Vektoren zur Bedeutungs- und Beziehungsanalyse um | Erfasst nuancierte semantische Muster, versteht Kontext | Rechenintensiv; benötigt große Trainingsdatensätze |

| Watermarking-Ansatz | Versteckte Signale werden beim Generieren in KI-Text eingebettet | Theoretisch narrensicher, wenn bei der Generierung implementiert | Leicht durch Bearbeitung entfernbar; kein Branchenstandard; Kooperation des KI-Modells erforderlich |

| Multimodale Erkennung | Analysiert Text, Bilder und Videos gleichzeitig auf KI-Merkmale | Umfassende Abdeckung verschiedener Inhaltstypen | Komplexe Implementierung; spezielles Training pro Modalität erforderlich |

| Internetsuche | Vergleicht Inhalte mit Datenbanken bekannter KI-Ausgaben und Internetarchiven | Erkennt plagiierte oder wiederverwendete KI-Inhalte | Auf bereits indizierte Inhalte beschränkt; erkennt keine neuen KI-Generierungen |

Technische Architektur von KI-Erkennungssystemen

Die technische Grundlage der Erkennung von KI-Inhalten beruht auf Deep-Learning-Architekturen, die Texte durch mehrere Analyseebenen verarbeiten. Moderne Systeme verwenden transformatorbasierte neuronale Netze, ähnlich wie sie in generativen KI-Modellen selbst eingesetzt werden, wodurch sie komplexe sprachliche Muster und Kontextbeziehungen verstehen können. Die Erkennungspipeline beginnt typischerweise mit der Vorverarbeitung, bei der Inhalte in einzelne Wörter oder Subworteinheiten zerlegt werden. Diese Tokens werden dann in Embeddings – dichte numerische Repräsentationen mit semantischer Bedeutung – konvertiert. Die Embeddings durchlaufen mehrere Netzwerkschichten, die zunehmend abstraktere Merkmale extrahieren, von einfachen Wortmustern bis hin zu komplexen Dokumenteigenschaften. Eine abschließende Klassifikationsschicht liefert eine Wahrscheinlichkeitsbewertung, ob Inhalte KI-generiert wurden. Fortgeschrittene Systeme wie GPTZero implementieren Satzklassifikation, analysieren also jeden Satz einzeln, um zu erkennen, welche Teile eines Dokuments KI-Merkmale aufweisen. Dieser detaillierte Ansatz gibt Nutzern gezieltes Feedback, welche Abschnitte potenziell KI-generiert sind, statt nur das gesamte Dokument binär zu klassifizieren.

Um die Erkennungsgenauigkeit bei der Weiterentwicklung von KI-Modellen zu erhalten, wurden dynamische Erkennungsmodelle entwickelt, die sich in Echtzeit an neue KI-Systeme anpassen können. Anstelle statischer Benchmarks, die schnell veralten, werden kontinuierlich die Ausgaben der neuesten KI-Modelle – darunter GPT-4o, Claude 3, Gemini 1.5 und weitere – in die Trainingspipelines integriert. Dieser Ansatz entspricht den neuen Transparenzrichtlinien der OECD und UNESCO für verantwortungsvolle KI-Entwicklung. Die fortschrittlichsten Plattformen verfügen über 1.300+ Lehrbotschafter-Communities und kooperieren mit Bildungseinrichtungen, um Algorithmen unter realen Bedingungen zu verfeinern – so bleiben die Tools auch bei fortschreitender Entwicklung von KI-Generierung und -Erkennung effektiv.

Genauigkeit, Zuverlässigkeit und Grenzen

Erkennungstools für KI-Inhalte haben in kontrollierten Tests beeindruckende Genauigkeitswerte erreicht. Führende Plattformen berichten von 99 % Genauigkeit bei Falsch-Positiv-Raten von nur 1 %, das heißt, sie erkennen KI-generierte Inhalte korrekt und minimieren das Risiko, menschliche Texte fälschlich zu markieren. Unabhängige Benchmarks wie der RAID-Datensatz – mit 672.000 Texten aus 11 Domänen, 12 Sprachmodellen und 12 adversarialen Angriffen – haben diese Angaben bestätigt: Top-Detektoren erzielten 95,7 % Genauigkeit bei der Erkennung von KI-Text und klassifizierten nur 1 % menschlicher Texte falsch. Allerdings sind diese Werte mit wichtigen Einschränkungen verbunden. Kein KI-Detektor ist zu 100 % genau, und die Leistung im realen Einsatz unterscheidet sich oft von Testszenarien. Die Zuverlässigkeit hängt von vielen Faktoren ab, darunter Textlänge, Themengebiet, Sprache und Bearbeitungsgrad des KI-Textes.

Kurze Texte stellen eine besondere Herausforderung für die Erkennung von KI-Inhalten dar, da sie zu wenige sprachliche Muster für eine zuverlässige Analyse bieten. Ein einzelner Satz oder kurzer Absatz enthält womöglich nicht genug charakteristische Merkmale, um KI- von menschlicher Autorschaft zu unterscheiden. Forschungen zeigen, dass Umformulieren KI-generierter Inhalte mit Tools wie GPT-3.5 die Erkennungsgenauigkeit um 54,83 % verringern kann – bearbeitete KI-Texte sind also deutlich schwerer zu identifizieren. Mehrsprachige Inhalte und Texte von Nicht-Muttersprachlern stellen ein weiteres Problem dar, da die meisten Tools überwiegend auf englischsprachigen Datensätzen trainiert werden. Das kann zu Voreingenommenheit gegenüber Nicht-Muttersprachlern führen, deren Schreibmuster von englischen Konventionen abweichen und so Falsch-Positive auslösen. Zudem werden mit immer ausgefeilteren KI-Modellen und Trainings auf hochwertigen menschlichen Texten die Unterschiede zwischen KI- und Menschenschreiben kleiner, was die Erkennung erschwert.

Erkennung von KI-Inhalten ist heute in vielen Sektoren und Anwendungsfällen unverzichtbar. Im Bildungsbereich setzen Institutionen Erkennungstools ein, um akademische Integrität zu wahren und zu erkennen, ob studentische Arbeiten von KI-Systemen erstellt oder maßgeblich unterstützt wurden. Eine Pew Research-Umfrage zeigte, dass 2024 bereits 26 % der US-Teenager ChatGPT für Schulaufgaben nutzten – doppelt so viele wie im Vorjahr –, was die Bedeutung effektiver Erkennung für Lehrkräfte unterstreicht. Verlage und Medienhäuser nutzen Erkennung, um redaktionelle Qualität zu sichern und die Google Search Quality Rater Guidelines 2025 einzuhalten, die Transparenz über KI-generierte Inhalte verlangen. Recruiter prüfen, ob Bewerbungsunterlagen, Motivationsschreiben und persönliche Statements tatsächlich von den Kandidaten selbst stammen. Content Creators und Texter lassen ihre Arbeit vor Veröffentlichung durch Detektoren prüfen, um nicht durch Suchmaschinen oder Algorithmen als KI-Text markiert zu werden und die menschliche Originalität ihrer Inhalte zu sichern.

Für Markenmonitoring- und KI-Tracking-Plattformen wie AmICited ist Erkennung von KI-Inhalten eine spezialisierte, aber zentrale Funktion. Diese Plattformen überwachen, wie Marken in Antworten von ChatGPT, Perplexity, Google KI-Überblicke und Claude erscheinen, und verfolgen Zitate und Erwähnungen in KI-Systemen. Die Erkennung hilft, zu verifizieren, ob Markennennungen authentisch sind oder KI-generiert wurden und gewährleistet so ein präzises Markenreputations-Monitoring. Forensiker und Juristen setzen Erkennung bei der Überprüfung der Herkunft strittiger Dokumente in Ermittlungen und Gerichtsverfahren ein. KI-Forscher und Entwickler nutzen Detektoren, um zu untersuchen, wie Erkennung funktioniert, künftige KI-Modelle verantwortungsvoll zu trainieren und Transparenz sowie ethische Entwicklung zu fördern.

Zentrale Erkennungsindikatoren und -muster

Erkennungssysteme für KI-Inhalte identifizieren verschiedene charakteristische Muster, die für KI-generierte Texte typisch sind. Wiederholungen und Redundanzen treten häufig auf, wobei Wörter, Phrasen oder Ideen in leicht abgewandelter Form mehrfach genannt werden. Übermäßig höfliche und formale Sprache ist typisch, da generative KI als „freundlicher Assistent“ konzipiert ist und standardmäßig förmliche, höfliche Formulierungen nutzt, sofern nicht anders vorgegeben. KI-Texte fehlen oft umgangssprachlicher Ton und natürliche Redewendungen, die authentische menschliche Kommunikation auszeichnen. Unsichere Sprache tritt häufig auf – KI verwendet gerne passive Konstruktionen und absichernde Floskeln wie „Es ist wichtig zu beachten, dass“, „Man könnte sagen“ oder „X gilt allgemein als“, anstatt mutige, klare Aussagen zu treffen. Inkonsistenz in Stimme und Tonfall kann entstehen, wenn KI versucht, einen bestimmten Autorenstil zu imitieren, ohne genügend Kontext oder Trainingsdaten. Unterbenutzung stilistischer Mittel wie Metaphern, Vergleiche und Analogien ist typisch für KI-Texte, die meist wörtlich und vorhersehbar formulieren. Logische oder faktische Fehler und „Halluzinationen“ – also plausible, aber falsche Informationen – können Hinweise auf KI-Autorschaft sein, wobei auch Menschen Fehler machen.

- Perplexity-Analyse: Bewertet die Vorhersehbarkeit von Wortwahl und Satzstruktur

- Burstiness-Messung: Erfasst Variation in Satzlänge und -komplexität

- Semantische Kohärenzbewertung: Analysiert logischen Fluss und Konzeptzusammenhänge

- Erkennung sprachlicher Muster: Identifiziert charakteristische Wortfrequenzen und Grammatikstrukturen

- Embeddings-basierte Analyse: Wandelt Text in numerische Vektoren zum Mustervergleich um

- Satzklassenbasierte Erkennung: Markiert einzelne Sätze oder Absätze als wahrscheinlich KI-generiert

- Internetsuche: Vergleicht Inhalte mit Datenbanken bekannter KI-Ausgaben

- Resistenz gegen adversariale Angriffe: Testet Robustheit gegen Umformulierung und Synonymaustausch

- Multimodale Analyse: Untersucht Bilder und Videos auf KI-Erzeugungsmerkmale

- Echtzeit-Modellanpassung: Aktualisiert Algorithmen mit neuen KI-Systemen

Unterschied zwischen KI-Erkennung und Plagiatsprüfung

Ein wichtiger Unterschied besteht zwischen Erkennung von KI-Inhalten und Plagiatsprüfung, auch wenn beide der Sicherung von Inhaltsintegrität dienen. KI-Erkennung fokussiert darauf, wie Inhalte erstellt wurden – ob sie durch künstliche Intelligenz generiert oder von Menschen verfasst wurden. Die Analyse untersucht Textstruktur, Wortwahl, sprachliche Muster und Stil, um Übereinstimmungen mit bekannten KI- oder Menschmustern festzustellen. Plagiatsprüfungen hingegen konzentrieren sich darauf, woher Inhalte stammen – ob Texte ohne Quellenangabe kopiert wurden. Plagiatsdetektoren vergleichen eingereichte Inhalte mit riesigen Datenbanken veröffentlichter Arbeiten, wissenschaftlicher Artikel, Webseiten und anderer Quellen, um Übereinstimmungen zu entdecken. Die Leitlinien des International Center for Academic Integrity 2024 empfehlen, beide Ansätze gemeinsam für eine umfassende Inhaltsprüfung zu nutzen. Ein Text kann vollständig menschlich geschrieben, aber plagiiert sein, oder KI-generiert und originell. Kein Tool allein bietet vollständige Informationen zu Authentizität und Originalität – gemeinsam liefern beide ein umfassenderes Bild der Entstehung und Originalität von Inhalten.

Entwicklung und Zukunft der KI-Erkennungstechnologie

Das Feld der Erkennung von KI-Inhalten entwickelt sich rasant weiter, da sowohl Erkennungs- als auch Umgehungstechniken fortschreiten. Watermarking-Ansätze – das Einbetten versteckter Signale in KI-Texte während der Erstellung – sind theoretisch vielversprechend, stoßen aber praktisch auf erhebliche Hürden. Wasserzeichen können durch Bearbeitung, Umformulierung oder Übersetzung entfernt werden und erfordern die Mitwirkung der KI-Entwickler bereits bei der Generierung. Weder OpenAI noch Anthropic haben Watermarking als Standard eingeführt, was seine praktische Anwendbarkeit einschränkt. Die Zukunft der Erkennung liegt wahrscheinlich in multimodalen Systemen, die Text, Bilder und Videos gleichzeitig analysieren, da KI-Generierung zunehmend alle Inhaltstypen umfasst. Forschende entwickeln dynamische Erkennungsmodelle, die sich in Echtzeit an neue KI-Architekturen anpassen, statt auf schnell veraltende Benchmarks zu setzen. Diese Systeme werden kontinuierlich aus den neuesten KI-Outputs lernen, damit die Erkennung mit der Entwicklung generativer KI Schritt hält.

Die vielversprechendste Richtung ist der Einbau von Transparenz und Herkunftsnachweis direkt in KI-Systeme, statt nur auf nachträgliche Erkennung zu setzen. Dieser Ansatz würde Metadaten, Herkunftsinformationen und klare Kennzeichnungen KI-generierter Inhalte bereits bei der Erstellung einbinden, sodass eine Erkennung überflüssig wird. Bis solche Standards jedoch verbreitet sind, bleiben Erkennungstools für KI-Inhalte unentbehrlich für die Wahrung von Integrität im Bildungswesen, Verlagssektor, Recruiting und Markenmonitoring. Die Verbindung von Detektionstechnologie mit Markenmonitoring-Plattformen wie AmICited ist ein neues Feld, bei dem Erkennungsfunktionen ein präzises Tracking ermöglichen, wie Marken in KI-generierten Antworten auf verschiedenen Plattformen erscheinen. Mit der zunehmenden Verbreitung von KI in Suche, Inhaltserstellung und Informationsvermittlung wird die Fähigkeit, KI-generierte Inhalte zuverlässig zu erkennen und zu überwachen, für Unternehmen immer wertvoller, die ihre Sichtbarkeit im KI-getriebenen Informationsökosystem verstehen wollen.

Der effektive Einsatz von Erkennungstools für KI-Inhalte erfordert ein Verständnis ihrer Möglichkeiten und Grenzen. Organisationen sollten die Einschränkungen einzelner Tools anerkennen und Erkennungsergebnisse als einen Hinweis, nicht als endgültigen Beweis betrachten. Abgleich mit mehreren Tools liefert ein verlässlicheres Gesamtbild, da verschiedene Systeme je nach Training und Algorithmus unterschiedliche Resultate liefern können. Wer KI-Schreibmuster manuell erkennt – etwa Perplexity, Burstiness, Wiederholungen und andere Merkmale – kann Detektionsergebnisse besser interpretieren. Kontext und Absicht müssen berücksichtigt werden; ein markiertes Ergebnis sollte eine genauere Prüfung des Stils, der Übereinstimmung mit der bekannten Autorenstimme und der Zielsetzung auslösen. Transparenz über die Erkennung in Schule und Beruf stärkt Vertrauen und verhindert eine Überbetonung der Automatisierung. Am zuverlässigsten ist KI-Erkennung als Teil einer umfassenden Originalitätsprüfung mit Plagiatscheckern, Quellenvalidierung und menschlicher Kontrolle. Ein verantwortungsvoller Ansatz sieht Detektionstools als wertvolle Assistenten, die menschliches Urteil ergänzen, aber nicht ersetzen – besonders dort, wo Falsch-Positive oder Falsch-Negative gravierende Folgen für Einzelne oder Organisationen haben könnten.

+++