Wie KI-Suchmaschinen funktionieren: Architektur, Retrieval und Generierung

Erfahren Sie, wie KI-Suchmaschinen wie ChatGPT, Perplexity und Google AI Overviews funktionieren. Entdecken Sie LLMs, RAG, semantische Suche und Echtzeit-Retrie...

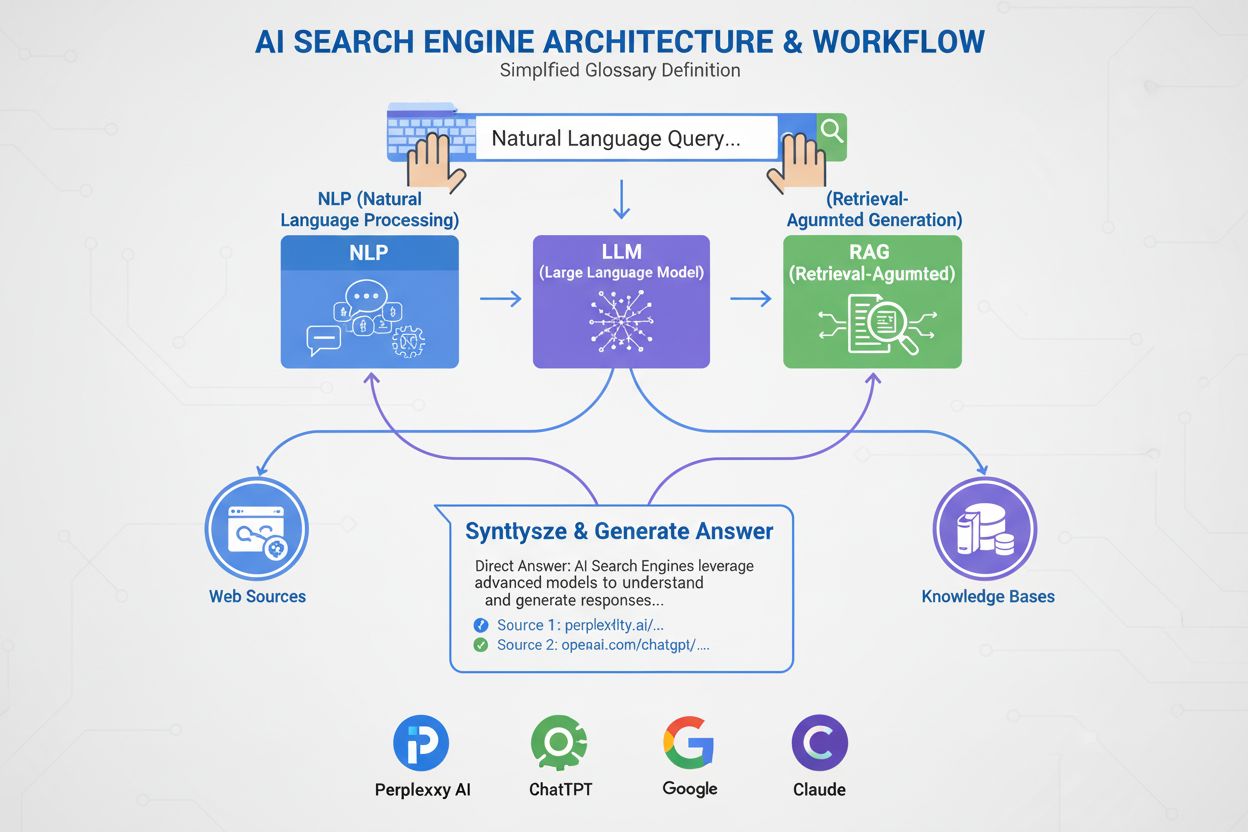

Eine KI-Suchmaschine ist eine Plattform, die künstliche Intelligenz, natürliche Sprachverarbeitung und große Sprachmodelle nutzt, um Benutzeranfragen zu interpretieren und direkte, konversationelle Antworten zu generieren, die aus Webquellen synthetisiert werden, anstatt traditionelle Linklisten anzuzeigen. Diese Plattformen nutzen Retrieval-Augmented Generation (RAG), um aktuelle, zitierte Informationen mit Echtzeit-Webzugriff bereitzustellen.

Eine KI-Suchmaschine ist eine Plattform, die künstliche Intelligenz, natürliche Sprachverarbeitung und große Sprachmodelle nutzt, um Benutzeranfragen zu interpretieren und direkte, konversationelle Antworten zu generieren, die aus Webquellen synthetisiert werden, anstatt traditionelle Linklisten anzuzeigen. Diese Plattformen nutzen Retrieval-Augmented Generation (RAG), um aktuelle, zitierte Informationen mit Echtzeit-Webzugriff bereitzustellen.

Eine KI-Suchmaschine ist eine Plattform, die künstliche Intelligenz, natürliche Sprachverarbeitung (NLP) und große Sprachmodelle (LLMs) nutzt, um Benutzeranfragen zu interpretieren und direkte, konversationelle Antworten zu generieren, die aus Webquellen synthetisiert werden. Im Gegensatz zu traditionellen Suchmaschinen, die Linklisten anzeigen, liefern KI-Suchmaschinen prägnante, leicht verständliche Zusammenfassungen, die gezielt auf die Benutzerabsicht eingehen. Diese Plattformen nutzen Retrieval-Augmented Generation (RAG), um Echtzeit-Webabruf mit generativer KI-Synthese zu kombinieren und so aktuelle, zitierte Informationen bereitzustellen. KI-Suchmaschinen stellen einen grundlegenden Wandel in der Art und Weise dar, wie Menschen online Informationen entdecken, indem sie von schlüsselwortbasierten Linklisten zu semantischem Verständnis und direkten Antworten übergehen. Die Technologie hinter diesen Systemen integriert verschiedene KI-Disziplinen – darunter semantische Suche, Entitätenerkennung und konversationelle KI – um ein intuitiveres und effizienteres Sucherlebnis zu schaffen.

Das Aufkommen von KI-Suchmaschinen markiert eine bedeutende Weiterentwicklung der Information-Retrieval-Technologie. Jahrzehntelang arbeiteten Suchmaschinen nach dem Prinzip der Stichwortübereinstimmung, wobei die Relevanz durch das Vorkommen und die Häufigkeit von Suchbegriffen in indexierten Dokumenten bestimmt wurde. Doch der Aufstieg von großen Sprachmodellen und Fortschritte im Bereich natürliches Sprachverständnis haben die Möglichkeiten grundlegend verändert. Der weltweite Markt für KI-Suchmaschinen erreichte 15,23 Milliarden USD im Jahr 2024 und soll laut Marktforschung bis 2032 eine jährliche Wachstumsrate (CAGR) von 16,8 % verzeichnen. Dieses explosive Wachstum spiegelt sowohl die Unternehmensadoption als auch die Verbrauchernachfrage nach intelligenteren, konversationellen Sucherfahrungen wider.

Generative KI hat die Art und Weise, wie Menschen online Informationen entdecken, grundlegend verändert und treibt die Suche über die bekannte Liste blauer Links hinaus zu direkteren, konversationellen Antworten. Branchenführer wie Google und Microsoft Bing haben KI rasch in ihre Plattformen integriert, um mit aufstrebenden Anbietern wie Perplexity und You.com Schritt zu halten. Laut McKinsey verfügen bereits ca. 50 % der Google-Suchen über KI-Zusammenfassungen – bis 2028 soll dieser Wert auf über 75 % steigen. Dieser Wandel ist mehr als eine Veränderung der Benutzeroberfläche – er definiert Content-Strategie und Suchmaschinenoptimierung neu und leitet eine neue Ära namens „Generative Engine Optimization“ (GEO) ein.

Der Wandel spiegelt die breite organisatorische Einführung von KI-Technologien wider. 78 % der Unternehmen gaben 2024 an, KI einzusetzen, gegenüber 55 % im Vorjahr, wie der AI Index Report der Stanford University zeigt. Für Such- und Marketingprofis bedeutet das: Sichtbarkeit hängt nun davon ab, wie KI-Systeme Inhalte analysieren, verdichten und in leicht verständliche Zusammenfassungen umwandeln. Die Herausforderung besteht darin, dass KI-generierte Antworten oft den Traffic komplett von den Originalseiten abziehen, was sowohl Chancen als auch Herausforderungen für Content-Ersteller und Marken in diesem neuen Umfeld bedeutet.

KI-Suchmaschinen arbeiten mit einer ausgeklügelten mehrstufigen Pipeline, die Abruf, Ranking und Synthese kombiniert. Der Prozess beginnt mit dem Query Understanding, bei dem das System die Benutzereingabe mittels natürlicher Sprachverarbeitung analysiert, um Bedeutung, Absicht und Kontext zu extrahieren. Anstatt die Anfrage als bloße Zeichenkette zu behandeln, erstellt das System mehrere Repräsentationen: eine lexikalische Form für exakte Übereinstimmungen, ein dichtes Embedding für semantische Suche und eine Entitätsform für Knowledge-Graph-Abgleiche.

Sobald die Anfrage verstanden ist, setzen die meisten KI-Suchmaschinen Retrieval-Augmented Generation (RAG) ein, ein zentrales Architekturprinzip, das die grundlegenden Schwächen großer Sprachmodelle adressiert. RAG führt einen Live-Abruf durch, durchsucht Webindizes oder APIs, um relevante Dokumente und Passagen zu finden. Diese Kandidaten werden mithilfe ausgefeilterer Modelle neu bewertet, die Anfrage und Kandidat gemeinsam analysieren, um verbesserte Relevanzwerte zu erzielen. Die am höchsten bewerteten Ergebnisse werden einem großen Sprachmodell als Grounding-Kontext zugeführt, das daraus eine konversationelle Antwort generiert und die Verbindung zu den Quellen beibehält.

Hybride Retrieval-Pipelines sind Standard bei führenden Plattformen. Sie kombinieren lexikalische Suche (Stichwort-basiert, etwa BM25) mit semantischer Suche (Embedding-basiert, mittels Vektorähnlichkeit). Lexikalische Suche punktet bei exakten Treffern, seltenen Begriffen und Eigennamen, während semantische Suche bei der Auffindung konzeptuell verwandter Inhalte überzeugt. Durch diese Kombination und Cross-Encoder-Reranking erreichen KI-Suchmaschinen eine höhere Genauigkeit als mit nur einer Methode. Am Ende generiert das große Sprachmodell eine kohärente, menschenähnliche Antwort, die Informationen aus mehreren Quellen integriert, die Genauigkeit wahrt und Zitate bereitstellt.

| Aspekt | Traditionelle Suchmaschinen | KI-Suchmaschinen |

|---|---|---|

| Ergebnisformat | Linklisten mit kurzen Snippets | Konversationelle Zusammenfassungen mit direkten Antworten |

| Anfrageverarbeitung | Stichwortabgleich und Ranking | Semantisches Verständnis und Intent-Analyse |

| Lernmechanismus | Beginnt bei jeder Anfrage von vorne | Lernt kontinuierlich aus Interaktionen und Feedback |

| Informationsabruf | Lexikalisch/Stichwort-basiert | Hybrid (lexikalisch + semantisch + entitätsbasiert) |

| Eingabeformate | Nur Text | Text, Bilder, Sprache und Video (multimodal) |

| Echtzeit-Updates | Index-basiert, periodisches Crawlen | Echtzeit-Webzugriff über RAG |

| Zitierverhalten | Keine Zitate; Nutzer finden Quellen selbst | Integrierte Zitate und Quellennachweise |

| Nutzerinteraktion | Einzelne Anfrage, statische Ergebnisse | Mehrstufige Gespräche mit Folgeanfragen |

| Bias-Handling | Kuratoren ordnen Informationen | KI-Synthese kann Entwickler-Bias einführen |

| Halluzinationsrisiko | Gering (Links sind faktisch) | Höher (LLMs können Falschinhalte generieren) |

Unterschiedliche KI-Suchmaschinen setzen verschiedene Architekturansätze um, die jeweils eigene Optimierungsimplikationen haben. Googles AI Overviews und AI Mode nutzen eine Query-Fan-Out-Strategie, bei der eine Benutzeranfrage in mehrere Teilanfragen zerlegt wird, die unterschiedliche Absichtsrichtungen abdecken. Diese laufen parallel gegen verschiedene Datenquellen – Webindex, Knowledge Graph, YouTube-Transkripte, Google-Shopping-Feeds und Spezialindizes. Ergebnisse werden aggregiert, dedupliziert, gerankt und anschließend zu einer Übersicht synthetisiert. Für GEO-Praktiker bedeutet das: Inhalte müssen verschiedene Aspekte einer Anfrage in extrahierbarer Form abdecken, um den Fan-Out-Prozess zu überstehen.

Bing Copilot steht für einen suchbasierten Ansatz, der Microsofts ausgereifte Bing-Ranking-Infrastruktur nutzt und eine GPT-basierte Synthese darüberlegt. Die Plattform verwendet Dual-Lane-Retrieval, das BM25-lexikalische Suche mit dichten Vektor-Suchverfahren kombiniert. Ergebnisse durchlaufen einen kontextbasierten Cross-Encoder-Reranker, der auf Passage-Ebene statt Seitenniveau bewertet. Das bedeutet: Klassische SEO-Signale – Crawlability, Canonical-Tags, sauberes HTML, Seitengeschwindigkeit – bleiben wichtig, da sie bestimmen, welche Kandidaten ins Grounding-Set gelangen. Bing Copilot betont zudem die Extrahierbarkeit: Passagen mit klarer Struktur, Listen, Tabellen und Definitionsstil werden bevorzugt zitiert.

Perplexity AI setzt auf bewusste Transparenz und zeigt Quellen auffällig vor der generierten Antwort an. Die Plattform führt Echtzeit-Suchen durch, oft basierend auf Google- und Bing-Indizes, und bewertet Kandidaten anhand einer Mischung aus lexikalischer und semantischer Relevanz, thematischer Autorität und Antwort-Extrahierbarkeit. Untersuchungen zu 59 Faktoren, die das Ranking-Verhalten von Perplexity beeinflussen, zeigen: Direkte Antwortformate werden bevorzugt – Seiten, die die Anfrage explizit in einer Überschrift wiederholen und direkt darunter eine prägnante, informationsdichte Antwort liefern, sind überproportional in den Zitatsets vertreten. Die Prominenz und Verlinkung von Entitäten spielt ebenfalls eine große Rolle; Perplexity bevorzugt Passagen, in denen Schlüsselfiguren klar benannt und kontextuell mit verwandten Konzepten verknüpft sind.

ChatGPT Search verfolgt einen opportunistischen Ansatz, generiert Suchanfragen dynamisch und nutzt Bings API, um gezielt URLs abzurufen. Im Gegensatz zu Plattformen mit persistenten Indizes ruft ChatGPT Inhalte in Echtzeit ab – die Aufnahme hängt also vollständig von der aktuellen Auffindbarkeit ab. Ist eine Seite durch robots.txt blockiert, langsam, durch clientseitiges Rendering verborgen oder semantisch undurchsichtig, wird sie nicht für die Synthese genutzt. Diese Architektur priorisiert Zugänglichkeit und Klarheit: Seiten müssen technisch crawlbar, leichtgewichtig und semantisch transparent sein, damit on-the-fly-Abrufe sauberen, parsierbaren Text liefern.

Natürliche Sprachverarbeitung (NLP) ist die Basistechnologie, die KI-Suchmaschinen ermöglicht, über Stichwortsuche hinauszugehen. NLP erlaubt Systemen, die Struktur, Semantik und Absicht hinter Suchanfragen zu analysieren, Kontext zu verstehen und Synonyme sowie verwandte Begriffe zu erkennen. Wenn ein Nutzer beispielsweise „beste Restaurants in meiner Nähe mit Außensitz“ sucht, versteht ein NLP-basiertes System, dass nach Restaurants mit Terrasse gefragt wird – auch ohne diese Begriffe explizit zu nennen. Dieses semantische Verständnis ermöglicht KI-Suchmaschinen, auch bei weniger offensichtlicher oder konversationeller Formulierung hilfreiche Ergebnisse zu liefern.

Große Sprachmodelle (LLMs) treiben die Synthesephase von KI-Suchmaschinen an. Sie werden mit riesigen Textmengen trainiert und sagen das jeweils wahrscheinlichste nächste Wort basierend auf dem Kontext voraus, sodass sie kohärente, grammatikalisch korrekte Texte generieren, die menschlichen Inhalten ähneln. Allerdings bergen LLMs auch Risiken: Sie können halluzinieren – also Falschaussagen als Fakten präsentieren –, da sie Inhalte probabilistisch generieren und nicht live zitieren. Daher ist Retrieval-Augmented Generation (RAG) entscheidend: Indem LLM-Synthesen auf aktuell abgerufene, autoritative Quellen gestützt werden, verringern KI-Suchmaschinen das Halluzinationsrisiko und verbessern die Faktengenauigkeit. Einige Plattformen haben sogar artikelweise Zitate integriert, um Halluzinationen weiter zu minimieren – doch auch hier stimmt der zitierte Artikel nicht immer und existiert mitunter gar nicht.

KI-Suchmaschinen unterscheiden sich in mehreren grundlegenden Punkten von traditionellen Suchmaschinen. Erstens bieten sie Zusammenfassungen statt Links. Herkömmliche Suchmaschinen zeigen Ergebnisse als Linklisten mit kurzen Snippets, während KI-Suchmaschinen prägnante Zusammenfassungen generieren, die Anfragen direkt beantworten, sodass Nutzer nicht mehr viele Websites durchsuchen müssen. Zweitens lernt KI-Suche im Zeitverlauf, während traditionelle Suche bei jeder Anfrage neu beginnt. KI-Suchmaschinen sind darauf ausgelegt, kontinuierlich aus Nutzerinteraktionen und neuen Daten zu lernen und ihre Leistung zu verbessern. Traditionelle Suchmaschinen bearbeiten jede neue Anfrage unabhängig von früheren Suchvorgängen oder Nutzerinteraktionen.

Drittens setzt KI-Suche auf Semantik, während traditionelle Suche auf Keywords basiert. Klassische Suchmaschinen verlassen sich vor allem auf Stichwortabgleich, während KI-Suchmaschinen die Bedeutung von Wörtern im Kontext betrachten. So können sie die Nutzerabsicht besser verstehen und Ergebnisse liefern, die genauer dem tatsächlichen Informationsbedarf entsprechen. Viertens akzeptiert KI-Suche mehrere Eingabeformate, traditionelle Suche nur Text. Manche KI-Suchmaschinen bieten multimodale Fähigkeiten, können also Informationen aus anderen Formaten wie Bildern, Videos und Audio verarbeiten. Das sorgt für ein intuitiveres und flexibleres Sucherlebnis als reine Texteingabe.

Das Aufkommen von KI-Suchmaschinen verändert die Herangehensweise von Marken an Sichtbarkeit und Content-Strategie. Anstatt nur um Keyword-Rankings zu konkurrieren, müssen Publisher und Unternehmen jetzt berücksichtigen, wie KI-Systeme ihre Inhalte analysieren, verdichten und als leicht verständliche Zusammenfassungen wiedergeben. Dieser Wandel hat eine neue Ära der „Generative Engine Optimization“ (GEO) eingeläutet, bei der das Ziel nicht nur das Ranking, sondern das Auffinden, die Synthese und das Zitiertwerden durch KI-Systeme ist.

Studien zeigen, dass selbst Branchenführer bei GEO-Leistungen um 20 bis 50 Prozent hinter der SEO zurückliegen können, so McKinsey. Diese Lücke spiegelt die noch junge GEO-Strategie und die Komplexität der Optimierung für mehrere KI-Plattformen gleichzeitig wider. Für Marken sind die Folgen gravierend: Sichtbarkeit in KI-Suchmaschinen hängt davon ab, dass Inhalte auffindbar (in Suchergebnissen erscheinen), extrahierbar (so strukturiert, dass KI-Systeme sie einfach parsen und zitieren können) und vertrauenswürdig (Expertise, Autorität und Vertrauenswürdigkeit demonstrieren) sind. Monitoring-Tools wie AmICited erfassen inzwischen Marken-Erwähnungen auf KI-Plattformen – darunter Perplexity, ChatGPT, Google AI Overviews und Claude –, um diese neue Form der Sichtbarkeit zu messen und Optimierungspotenziale zu erkennen.

Der KI-Suchmarkt entwickelt sich rasant und hat erhebliche Auswirkungen darauf, wie Informationen gefunden, verteilt und monetarisiert werden. Der weltweite Markt für KI-Suchmaschinen soll bis 2032 mit einer jährlichen Wachstumsrate von 16,8 % wachsen, getrieben durch zunehmende Unternehmensadoption und die Nachfrage nach konversationellen, intelligenten Sucherlebnissen. Mit der Reife der KI-Suchmaschinen zeichnen sich mehrere Schlüsseltrends ab.

Erstens werden sich Konsolidierung und Spezialisierung beschleunigen. Während Generalisten wie Google, Bing und Perplexity weiterhin dominieren, werden spezialisierte KI-Suchmaschinen für einzelne Branchen – Recht, Medizin, Technik, E-Commerce – zunehmen. Diese spezialisierten Engines bieten für Nischenanfragen tiefere Expertise und präzisere Synthesen. Zweitens werden Zitier- und Attributionsmechanismen ausgefeilter und standardisierter. Mit steigendem Regulierungsdruck und Forderungen nach klarer Attribution werden KI-Suchmaschinen granularere Zitierungssysteme implementieren, die es Nutzern und Publishern leichter machen, Ansprüche zu prüfen und Sichtbarkeit zu messen.

Drittens wird sich die Definition und Messung von „Sichtbarkeit“ grundlegend verändern. In der traditionellen SEO-Ära bedeutete Sichtbarkeit Ranking-Position und Klickrate. In der GEO-Ära heißt Sichtbarkeit: abgerufen, synthetisiert und zitiert zu werden – Kennzahlen, die neue Messwerkzeuge erfordern. AmICited und ähnliche Plattformen sind Vorreiter in diesem Bereich, indem sie Marken-Erwähnungen auf verschiedenen KI-Plattformen erfassen und analysieren, wie oft und in welchem Kontext Marken in KI-generierten Antworten erscheinen.

Viertens wird sich die Spannung zwischen KI- und traditioneller Suche verschärfen. Während KI-Suchmaschinen mehr Aufmerksamkeit und Traffic binden, geraten klassische Suchmaschinen unter Druck, sich weiterzuentwickeln oder in die Bedeutungslosigkeit zu geraten. Googles Integration von KI ins Kerngeschäft ist eine strategische Antwort auf diese Bedrohung, doch der langfristige Gewinner ist offen. Publisher und Marken müssen für beide Suchtypen gleichzeitig optimieren – eine komplexere und ressourcenintensivere Content-Strategie.

Zuletzt werden Vertrauen und Genauigkeit entscheidend. Mit zunehmender Bedeutung von KI-Suchmaschinen als Hauptinformationsquelle steigen die Anforderungen an Genauigkeit und Bias-Minimierung. Regulierungsrahmen für KI-Transparenz und Nachvollziehbarkeit werden entstehen und Suchmaschinen verpflichten, Trainingsdaten, Rankingfaktoren und Zitiermethoden offen zu legen. Für Marken und Publisher bedeutet das: E-E-A-T-Signale – Expertise, Erfahrung, Autorität und Vertrauenswürdigkeit – werden noch wichtiger für Sichtbarkeit in traditionellen wie KI-Suchumgebungen.

+++ showCTA = true ctaHeading = “Überwachen Sie die Sichtbarkeit Ihrer Marke in KI-Suchmaschinen” ctaDescription = “Das Verständnis von KI-Suchmaschinen ist nur der erste Schritt. Verfolgen Sie, wo und wie Ihre Marke in ChatGPT, Perplexity, Google AI Overviews und Claude mit der KI-Such-Monitoring-Plattform von AmICited erscheint. Messen Sie Ihre GEO-Leistung, erkennen Sie Zitiermöglichkeiten und optimieren Sie Ihre Inhalte für die nächste Suchmaschinen-Generation.” ctaPrimaryText = “Kontaktieren Sie uns” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Jetzt testen” ctaSecondaryURL = “https://app.amicited.com ” +++

Traditionelle Suchmaschinen zeigen Ergebnisse als Linklisten mit Snippets an, während KI-Suchmaschinen konversationelle Zusammenfassungen generieren, die Anfragen direkt beantworten. KI-Suchmaschinen nutzen natürliche Sprachverarbeitung und große Sprachmodelle, um die Benutzerabsicht semantisch zu verstehen, anstatt sich nur auf die Stichwortübereinstimmung zu verlassen. Sie lernen kontinuierlich aus Nutzerinteraktionen und können mehrere Eingabeformate wie Text, Bilder und Sprache verarbeiten. Darüber hinaus bieten KI-Suchmaschinen oft Echtzeit-Webzugriff durch Retrieval-Augmented Generation (RAG), sodass sie aktuelle Informationen mit Quellennachweisen liefern können.

Retrieval-Augmented Generation (RAG) ist eine Technik, die es großen Sprachmodellen ermöglicht, aktuelle Informationen aus externen Quellen abzurufen und in die Antwortgenerierung einzubeziehen. RAG adressiert die grundlegenden Schwächen von LLMs – Halluzinationen und Wissensgrenzen – indem Antworten auf Echtzeitdaten gestützt werden. In KI-Suchmaschinen funktioniert RAG, indem zunächst eine Live-Suche oder ein Abruf durchgeführt wird, um relevante Dokumente oder Ausschnitte zu finden, aus denen dann eine auf diesen Inhalten basierende Antwort synthetisiert wird. Dieser Ansatz stellt sicher, dass die Antworten sowohl aktuell als auch auf bestimmte Quellen zurückführbar sind, was Zitate möglich macht und die faktische Genauigkeit erhöht.

Führende KI-Suchmaschinen sind Perplexity (bekannt für transparente Zitate), ChatGPT Search (betrieben von GPT-4o mit Echtzeit-Webzugriff), Google Gemini und AI Overviews (integriert in Googles Suchinfrastruktur), Bing Copilot (auf Microsofts Suchindex basierend) und Claude (Anthropics Modell mit selektiver Websuche). Perplexity priorisiert Echtzeitabruf und sichtbare Quellenangaben, während ChatGPT Suchanfragen opportunistisch generiert. Googles Ansatz nutzt Query Fan-Out, um mehrere Absichtsdimensionen abzudecken, und Bing CoPilot kombiniert traditionelle SEO-Signale mit generativer Synthese. Jede Plattform hat eigene Abruf-Architekturen, Zitierverhalten und Optimierungsanforderungen.

KI-Suchmaschinen folgen einem mehrstufigen Prozess: Zuerst wird die Benutzeranfrage mittels natürlicher Sprachverarbeitung analysiert, um die Absicht zu erkennen; dann werden relevante Dokumente oder Passagen aus Webindizes oder APIs per Hybrid-Retrieval (Kombination aus lexikalischer und semantischer Suche) abgerufen; anschließend werden Kandidaten nach Relevanz und Extrahierbarkeit neu bewertet; schließlich wird mit einem großen Sprachmodell eine konversationelle Antwort generiert, in die Quellennachweise eingefügt werden. Die Zitiermechanismen unterscheiden sich je nach Plattform – manche zeigen Inline-Zitate, andere Quelllisten oder integrieren Zitate direkt in den Antworttext. Die Qualität und Genauigkeit der Zitate hängt davon ab, wie gut die abgerufenen Passagen zu den synthetisierten Aussagen passen.

Generative Engine Optimization (GEO) ist die Praxis, Inhalte und Markenpräsenz gezielt für KI-Suchmaschinen zu optimieren – im Gegensatz zur traditionellen SEO, die auf Keyword-Rankings in Link-basierten Suchergebnissen abzielt. GEO konzentriert sich darauf, Inhalte auffindbar, extrahierbar und zitierbar für KI-Systeme zu machen. Zu den wichtigsten GEO-Strategien gehören die klare Strukturierung von Inhalten und direkten Antworten, die Nutzung natürlicher Sprache passend zur Benutzerabsicht, die Implementierung von Entity-Markup und Schema, schnelle Ladezeiten sowie der Aufbau thematischer Autorität. Laut McKinsey haben etwa 50 % der Google-Suchen bereits KI-Zusammenfassungen – bis 2028 werden es voraussichtlich über 75 % sein, was GEO für die Markenpräsenz immer wichtiger macht.

KI-Suchmaschinen können den Website-Traffic sowohl erhöhen als auch verringern, je nachdem, wie Inhalte optimiert sind. Wenn Inhalte in KI-generierten Antworten zitiert werden, gewinnen sie an Sichtbarkeit und Glaubwürdigkeit, aber Nutzer erhalten ihre Antwort oft direkt, ohne die Quelle zu besuchen. Studien zeigen, dass AI Overviews den Traffic von den Originalseiten abziehen können, aber gleichzeitig Attribution und Quellenlinks bieten. Für Marken bedeutet dies, dass Sichtbarkeit jetzt davon abhängt, von KI-Systemen abgerufen, synthetisiert und zitiert zu werden – nicht nur vom Ranking in traditionellen Suchergebnissen. Monitoring-Tools wie AmICited verfolgen Marken-Erwähnungen auf KI-Plattformen (Perplexity, ChatGPT, Google AI Overviews, Claude), um diese neue Sichtbarkeit zu messen und gezielt zu optimieren.

Natural Language Processing (NLP) ist grundlegend dafür, wie KI-Suchmaschinen Benutzeranfragen verstehen und verarbeiten. NLP ermöglicht es Systemen, die Struktur, Semantik und Absicht hinter Suchanfragen zu erfassen, anstatt nur Keywords abzugleichen. So können KI-Suchmaschinen den Kontext verstehen, Bedeutungen entschlüsseln sowie Synonyme und verwandte Konzepte erkennen. NLP treibt auch die Synthesephase an, in der Sprachmodelle grammatikalisch korrekte, kohärente Antworten generieren, die für Nutzer natürlich klingen. Außerdem hilft NLP KI-Suchmaschinen, Informationen aus Webseiten zu extrahieren und zu strukturieren, indem Schlüsselinhalte, Beziehungen und Aussagen erkannt und in generierte Antworten eingebunden werden.

KI-Suchmaschinen verarbeiten Echtzeitinformationen durch Retrieval-Augmented Generation (RAG), das Live-Suchen oder API-Abrufe durchführt, um aktuelle Daten zum Zeitpunkt der Anfrage zu erhalten, anstatt sich nur auf Trainingsdaten zu verlassen. Plattformen wie Perplexity und Googles AI Mode durchsuchen das Web aktiv in Echtzeit, um sicherzustellen, dass Antworten die neuesten Informationen widerspiegeln. ChatGPT nutzt Bings Search API, um bei aktiviertem Browsing aktuelle Webinhalte abzurufen. Aktualitätssignale fließen auch in die Ranking-Algorithmen ein – Seiten mit kürzlichem Veröffentlichungsdatum und aktualisierten Inhalten werden bei zeitkritischen Anfragen stärker gewichtet. Allerdings verlassen sich einige KI-Suchmaschinen noch teilweise auf Trainingsdaten, die hinter realen Ereignissen zurückliegen können, was das Echtzeit-Retrieval zu einem wichtigen Unterscheidungsmerkmal macht.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, wie KI-Suchmaschinen wie ChatGPT, Perplexity und Google AI Overviews funktionieren. Entdecken Sie LLMs, RAG, semantische Suche und Echtzeit-Retrie...

Verstehen Sie die Unterschiede zwischen Sprachsuche und KI-Suche. Lernen Sie, wie Sprachabfragen, ChatGPT, Perplexity, Google AI Overviews und Claude sich in Te...

Lernen Sie Strategien der KI-Suchoptimierung, um die Markenpräsenz in ChatGPT, Google AI Overviews und Perplexity zu steigern. Optimieren Sie Inhalte für LLM-Zi...