So konfigurieren Sie robots.txt für KI-Crawler: Vollständiger Leitfaden

Erfahren Sie, wie Sie robots.txt konfigurieren, um den Zugriff von KI-Crawlern wie GPTBot, ClaudeBot und Perplexity zu steuern. Verwalten Sie die Sichtbarkeit I...

Konfiguration der robots.txt mit User-Agent-Regeln, die gezielt auf KI-Crawler abzielen. Die AI-spezifische robots.txt ermöglicht es Website-Betreibern, zu steuern, wie künstliche Intelligenzen, große Sprachmodelle und KI-Trainingsbots auf ihre Inhalte zugreifen und diese nutzen. Sie unterscheidet zwischen verschiedenen Arten von KI-Crawlern – Trainingscrawler, Suchcrawler und nutzerinitiierte Crawler – und ermöglicht eine granulare Kontrolle über die Sichtbarkeit der Inhalte für KI-Systeme. Diese Konfiguration ist entscheidend geworden, da KI-Crawler mittlerweile etwa 80 % des Bot-Traffics auf vielen Websites ausmachen.

Konfiguration der robots.txt mit User-Agent-Regeln, die gezielt auf KI-Crawler abzielen. Die AI-spezifische robots.txt ermöglicht es Website-Betreibern, zu steuern, wie künstliche Intelligenzen, große Sprachmodelle und KI-Trainingsbots auf ihre Inhalte zugreifen und diese nutzen. Sie unterscheidet zwischen verschiedenen Arten von KI-Crawlern – Trainingscrawler, Suchcrawler und nutzerinitiierte Crawler – und ermöglicht eine granulare Kontrolle über die Sichtbarkeit der Inhalte für KI-Systeme. Diese Konfiguration ist entscheidend geworden, da KI-Crawler mittlerweile etwa 80 % des Bot-Traffics auf vielen Websites ausmachen.

Die AI-spezifische robots.txt-Konfiguration bezieht sich auf die Praxis, gezielte Regeln innerhalb Ihrer robots.txt-Datei zu erstellen, die speziell auf künstliche Intelligenz-Crawler und Trainings-Bots abzielen – im Unterschied zu traditionellen Suchmaschinen-Crawlern wie Googlebot. Während sich die klassische robots.txt historisch auf die Steuerung von Googlebot, Bingbot und ähnliche Suchindexer konzentrierte, hat das Aufkommen großer Sprachmodelle und KI-Trainingssysteme eine völlig neue Kategorie von Bot-Traffic geschaffen, die eine eigene Verwaltungsstrategie erfordert. Nach aktuellen Daten vom November 2025 machen KI-Crawler mittlerweile etwa 80 % des gesamten Bot-Traffics auf vielen Publisher-Websites aus, was die Bedeutung der robots.txt-Konfiguration von einem netten SEO-Tool zu einem kritischen Mechanismus für den Schutz von Inhalten verschoben hat. Die Unterscheidung ist wichtig, weil KI-Trainingscrawler unter anderen Geschäftsmodellen arbeiten als Suchmaschinen – sie sammeln Daten, um proprietäre Modelle zu trainieren, nicht um Referral-Traffic zu generieren – sodass die klassische Abwägung „Crawler zulassen gegen Sichtbarkeit in der Suche“ nicht mehr gilt. Für Publisher bedeutet dies, dass robots.txt-Entscheidungen nun direkt die Sichtbarkeit der Inhalte für KI-Systeme, den potenziell unbefugten Einsatz proprietärer Inhalte in Trainingsdatensätzen und die Auswirkungen für Traffic und Umsatz durch KI-Discovery beeinflussen.

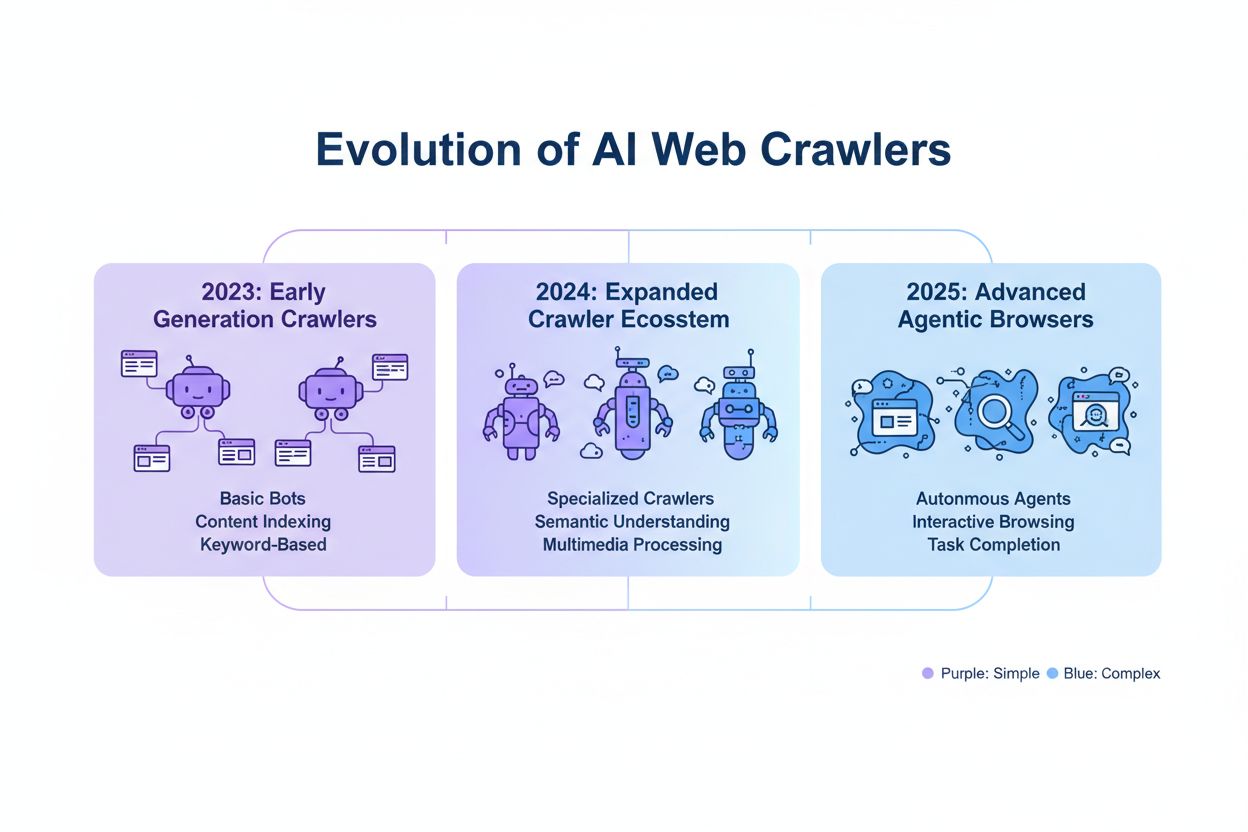

KI-Crawler lassen sich in drei klar abgegrenzte Betriebskategorien einteilen, die sich hinsichtlich Eigenschaften, Traffic-Auswirkungen und strategischer Überlegungen für Publisher unterscheiden. Trainingscrawler sind so konzipiert, dass sie große Mengen Textdaten für die Entwicklung von Machine-Learning-Modellen sammeln; sie haben typischerweise hohe Bandbreitenanforderungen, erzeugen erhebliche Serverlast und liefern keinerlei Referral-Traffic zurück – Beispiele sind OpenAIs GPTBot und Anthropics ClaudeBot. Such- und Zitationscrawler funktionieren ähnlich wie klassische Suchmaschinen, indem sie Inhalte indexieren und Attribution bereitstellen; sie erzeugen mittlere Traffic-Volumina und können über Zitate und Links Referral-Traffic bringen – hierzu zählen etwa OpenAIs OAI-SearchBot und Googles AI Overviews-Crawler. Nutzerinitiierte Crawler werden auf Anfrage aktiv, wenn Endnutzer explizit eine KI-Analyse einer Webseite anstoßen, etwa ChatGPTs Fähigkeit zum Web-Browsing oder Claudes Dokumentenanalyse; diese erzeugen weniger Traffic, stellen aber eine direkte Nutzerinteraktion mit Ihren Inhalten dar. Die Kategorisierung ist strategisch relevant, weil Trainingscrawler das höchste Inhaltschutzrisiko bei minimalem Geschäftsnutzen darstellen, Suchcrawler einen Mittelweg mit Referral-Potenzial bieten und nutzerinitiierte Crawler meist mit Nutzerintention und Sichtbarkeit korrespondieren.

| Crawler-Kategorie | Zweck | Traffic-Volumen | Referral-Potenzial | Inhaltsrisiko | Beispiele |

|---|---|---|---|---|---|

| Training | Modell-Entwicklung | Sehr hoch | Keins | Sehr hoch | GPTBot, ClaudeBot |

| Suche/Zitation | Inhaltsindexierung & Attribution | Mittel | Mittel | Mittel | OAI-SearchBot, Google AI |

| Nutzerinitiiert | On-Demand-Analyse | Niedrig | Niedrig | Niedrig | ChatGPT Web Browse, Claude |

Zu den wichtigsten KI-Unternehmen, die Crawler betreiben, gehören OpenAI, Anthropic, Google, Meta, Apple und Amazon – jeweils mit eigenen User-Agent-Strings, die in Server-Logs und der robots.txt-Konfiguration identifiziert werden können. OpenAI betreibt mehrere Crawler: GPTBot (User-Agent: GPTBot/1.0) für Trainingsdatensammlung, OAI-SearchBot (User-Agent: OAI-SearchBot/1.0) für Suche und Zitationsindexierung, sowie ChatGPT-User (User-Agent: ChatGPT-User/1.0) für nutzerinitiiertes Web-Browsing. Anthropics Hauptcrawler ist ClaudeBot (User-Agent: Claude-Web/1.0 oder anthropic-ai), eingesetzt für Training und Wissensbasisaufbau. Google betreibt Google-Extended (User-Agent: Google-Extended/1.1) für Gemini und andere KI-Produkte, Meta verwendet facebookexternalhit zur Inhaltsanalyse, Apple betreibt AppleBot für Siri und Suchfunktionen, Amazon nutzt Amazonbot für Alexa und die Suche. Um diese Crawler in Ihren Server-Logs zu identifizieren, prüfen Sie den User-Agent-Header in HTTP-Anfragen – die meisten legitimen KI-Crawler führen ihren Firmennamen und die Versionsnummer in diesem Feld. Für mehr Sicherheit können Sie die Legitimität eines Crawlers überprüfen, indem Sie die anfragende IP-Adresse mit den von den Unternehmen veröffentlichten IP-Ranges abgleichen; OpenAI, Google und andere große Anbieter veröffentlichen diese Bereiche, sodass Sie legitime Crawler von gefälschten User-Agents unterscheiden können.

Die grundlegende Syntax für AI-spezifische robots.txt-Regeln folgt dem Standardformat mit User-Agent-Matching und Allow/Disallow-Direktiven für bestimmte Crawler. Um beispielsweise OpenAIs GPTBot für Trainingsdatensammlung zu blockieren, aber deren Suchcrawler zuzulassen, würde Ihre robots.txt so aussehen:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Für noch gezieltere Steuerung können Sie pfadspezifische Regeln anwenden, die beispielsweise KI-Crawler vom Zugriff auf Ihre Paywall-Inhalte oder Bereiche mit nutzergenerierten Inhalten ausschließen:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Sie können mehrere User-Agents zu einer Regelgruppe zusammenfassen, um identische Einschränkungen für verschiedene Crawler gleichzeitig anzuwenden und so die Konfiguration zu vereinfachen. Das Testen und Validieren Ihrer robots.txt-Konfiguration ist entscheidend; Tools wie der robots.txt-Tester der Google Search Console und Drittanbieter-Validatoren helfen dabei, die syntaktische Korrektheit und die korrekte Interpretation Ihrer Regeln durch die Crawler zu überprüfen. Denken Sie daran, dass robots.txt eine Empfehlung ist und nicht durchgesetzt werden kann – konforme Crawler halten sich an diese Regeln, böswillige oder nicht-konforme Bots können sie jedoch ignorieren, sodass für sensible Inhalte zusätzliche Maßnahmen auf Serverebene notwendig sind.

Die Entscheidung, KI-Crawler zu blockieren oder zuzulassen, ist eine grundlegende Abwägung zwischen Inhaltschutz und Sichtbarkeit, die je nach Geschäftsmodell und Content-Strategie stark variiert. Das vollständige Blockieren von Trainingscrawlern wie GPTBot eliminiert das Risiko, dass Ihre Inhalte ohne Kompensation in proprietäre KI-Modelle einfließen – Ihre Inhalte erscheinen dann aber nicht in KI-generierten Antworten, was die Auffindbarkeit über KI-Systeme und damit Traffic potenziell vermindert. Umgekehrt erhöht das Zulassen von Trainingscrawlern die Wahrscheinlichkeit, dass Ihre Inhalte in KI-Trainingsdatensätze eingehen, oftmals ohne Attribution oder Kompensation – kann aber die Sichtbarkeit erhöhen, falls diese KI-Systeme Ihre Inhalte später zitieren oder referenzieren. Die strategische Entscheidung sollte sich daran orientieren, wo Ihr Content einen Wettbewerbsvorteil bietet: Proprietäre Forschung, originelle Analysen und einzigartige Daten erfordern strengere Blockierungen, während allgemeine Lehrinhalte oder Standardinformationen von einer größeren KI-Sichtbarkeit profitieren können. Unterschiedliche Publisher-Typen haben unterschiedliche Kalküle: Nachrichtenportale lassen Suchcrawler meist zu, um Zitations-Traffic zu erhalten, blockieren aber Trainingscrawler; Bildungsanbieter gewähren mitunter breiteren Zugang zur Reichweitenerhöhung; SaaS-Unternehmen blockieren oft alle KI-Crawler, um proprietäre Dokumentation zu schützen. Überwachen Sie die Auswirkungen Ihrer Blockierungsentscheidungen durch Server-Logs und Traffic-Analysen, um sicherzustellen, dass Ihre Konfiguration Ihre Geschäftsziele erfüllt.

Obwohl robots.txt einen klaren Mechanismus zur Kommunikation von Crawler-Richtlinien bietet, ist sie lediglich eine Empfehlung und nicht rechtlich durchsetzbar – konforme Crawler respektieren Ihre Regeln, nicht-konforme Akteure können sie ignorieren und erfordern zusätzliche technische Schutzmaßnahmen. IP-Verifizierung und Allowlisting ist die zuverlässigste Durchsetzungsmethode: Durch Pflege einer Liste legitimer IP-Adressen, die von OpenAI, Google, Anthropic und anderen großen KI-Unternehmen veröffentlicht werden, können Sie sicherstellen, dass Anfragen, die angeblich von deren Crawlern stammen, tatsächlich von deren Infrastruktur ausgehen. Firewall-Regeln und Blockierungen auf Serverebene bieten den stärksten Schutz, da Sie damit Anfragen von bestimmten User-Agents oder IP-Bereichen auf Netzwerkebene abweisen können, bevor sie Serverressourcen verbrauchen. Für Apache-Server kann eine .htaccess-Konfiguration Crawler-Einschränkungen erzwingen:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta-Tags im HTML-Head-Bereich ermöglichen eine granulare, seitenbezogene Steuerung des Crawler-Zugriffs, ohne robots.txt zu ändern:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Regelmäßiges Prüfen der Server-Logs auf Crawler-Aktivitäten ermöglicht es, neue Crawler zu identifizieren, die Einhaltung Ihrer Regeln zu überprüfen und gefälschte User-Agents zu erkennen, die versuchen, Ihre Einschränkungen zu umgehen. Tools wie Knowatoa und Merkle bieten automatisierte Validierung und Überwachung Ihrer robots.txt-Konfiguration und des Crawler-Verhaltens und schaffen Transparenz darüber, welche Crawler Ihre Seite aufrufen und ob sie Ihre Direktiven einhalten.

Die laufende Pflege Ihrer AI-spezifischen robots.txt-Konfiguration ist entscheidend, da sich das KI-Crawler-Umfeld rasant entwickelt, regelmäßig neue Crawler auftauchen und bestehende Crawler ihre User-Agent-Strings und Verhaltensweisen ändern. Ihre Überwachungsstrategie sollte beinhalten:

Die schnelle Entwicklung von KI-Crawler-Technologien bedeutet, dass eine robots.txt-Konfiguration, die vor sechs Monaten angemessen war, heute womöglich nicht mehr zu Ihren aktuellen Anforderungen oder der aktuellen Bedrohungslage passt – regelmäßige Überprüfung und Anpassung sind daher essenziell für wirksamen Inhaltschutz.

Die nächste Generation von KI-Crawlern bringt Herausforderungen mit sich, die sich mit klassischer robots.txt-Konfiguration oft nicht mehr ausreichend adressieren lassen. Agentische Browser-Crawler wie ChatGPT Atlas und Google Project Mariner agieren als vollwertige Webbrowser statt als einfache HTTP-Clients, führen JavaScript aus, simulieren Nutzerinteraktionen und verhalten sich nicht von menschlichen Usern unterscheidbar – sie identifizieren sich oft nicht mit eindeutigen User-Agent-Strings, sodass eine Blockierung per robots.txt wirkungslos bleibt. Viele neue Crawler verwenden bewusst Standard-Chrome-User-Agent-Strings, um Erkennung und Blockierung zu umgehen und ihre Identität zu verschleiern. Dadurch wächst die Bedeutung von IP-basierten Blockierungen als neue Notwendigkeit: Publisher müssen Allowlists legitimer Crawler-IP-Adressen pflegen und sämtlichen sonstigen Traffic aus verdächtigen Quellen blockieren – das verschiebt die Durchsetzung von User-Agent-Matching auf netzwerkbasierte Zugriffskontrolle. Gefälschte User-Agents und Umgehungstechniken nehmen zu, indem Angreifer legitime Crawler imitieren oder generische User-Agents nutzen, um Erkennung zu entgehen. Die Zukunft des KI-Crawler-Managements wird voraussichtlich einen mehrschichtigen Ansatz erfordern, der robots.txt-Konfiguration, IP-Verifizierung, Firewall-Regeln und gegebenenfalls Verhaltensanalysen verbindet, um legitime Crawler von böswilligen Akteuren zu unterscheiden. Es ist wichtig, sich über neue Crawler-Technologien zu informieren und an Branchendiskussionen zu Ethik und Standards für Crawler teilzunehmen, um einen effektiven Inhaltschutz zu gewährleisten.

Eine effektive AI-spezifische robots.txt-Konfiguration erfordert einen umfassenden Ansatz, der Inhaltschutz und strategische Sichtbarkeitsziele ausbalanciert. Beginnen Sie mit einer klaren Inhaltschutz-Policy, die definiert, welche Inhaltskategorien geblockt werden müssen (proprietäre Forschung, Premium-Inhalte, nutzergenerierte Inhalte) und welche für KI-Crawler zugänglich sein können (öffentliche Artikel, Lehrinhalte, Standardinformationen). Setzen Sie auf eine gestufte Blockierungsstrategie, die zwischen Trainingscrawlern (meist blockieren), Suchcrawlern (meist mit Monitoring erlauben) und nutzerinitiierten Crawlern (meist erlauben) unterscheidet, statt pauschal alle KI-Crawler zu blockieren oder zuzulassen. Kombinieren Sie robots.txt mit Maßnahmen auf Serverebene, indem Sie für besonders schützenswerte Inhalte Firewall-Regeln und IP-Verifizierung implementieren – robots.txt allein reicht für starken Schutz nicht aus. Integrieren Sie das Management von KI-Crawlern in Ihre übergreifende SEO- und Content-Strategie, indem Sie überlegen, wie sich Blockierungsentscheidungen auf Ihre Sichtbarkeit in KI-generierten Antworten, Zitationen und KI-basierter Suche auswirken – so stellen Sie sicher, dass Ihre robots.txt-Konfiguration Ihre Geschäftsziele unterstützt. Etablieren Sie einen festen Monitoring- und Wartungsrhythmus mit wöchentlichen Log-Reviews, monatlicher IP-Verifizierung und vierteljährlichen Audits, damit Ihre Konfiguration auch im wandelnden Crawler-Umfeld effektiv bleibt. Nutzen Sie Tools wie AmICited.com, um die Sichtbarkeit Ihrer Inhalte in KI-Systemen zu überwachen und die Auswirkungen Ihrer Blockierungen auf KI-Discovery und Zitation zu verstehen. Für verschiedene Publisher-Typen gilt: Nachrichtenportale sollten in der Regel Suchcrawler zulassen und Trainingscrawler blockieren, um Zitations-Traffic zu maximieren; Bildungsanbieter sollten über breiteren Zugang zur Reichweitenerhöhung nachdenken; SaaS-Unternehmen sollten für proprietäre Dokumentation eine konsequente Blockierung umsetzen. Falls robots.txt-Blockierung wegen gefälschter User-Agents oder nicht-konformer Crawler nicht ausreicht, sollten Sie auf Firewall-Regeln und IP-basierte Blockierungen umsteigen, um Ihre Schutzrichtlinien auf Netzwerkebene durchzusetzen.

Trainingscrawler wie GPTBot und ClaudeBot sammeln Daten für die Modellentwicklung und liefern keinerlei Referral-Traffic, was sie zu einem hohen Risiko für den Inhaltschutz macht. Suchcrawler wie OAI-SearchBot und PerplexityBot indexieren Inhalte für KI-basierte Suche und können durch Zitationen Referral-Traffic bringen. Die meisten Publisher blockieren Trainingscrawler, während sie Suchcrawler zulassen, um den Schutz der Inhalte mit der Sichtbarkeit auszubalancieren.

Google erklärt offiziell, dass das Blockieren von Google-Extended keine Auswirkungen auf das Suchranking oder die Aufnahme in AI Overviews hat. Einige Webmaster äußern dennoch Bedenken, daher sollten Sie nach dem Blockieren Ihre Such-Performance beobachten. AI Overviews in der Google-Suche folgen den Standardregeln für Googlebot, nicht für Google-Extended.

Ja, robots.txt ist eine Empfehlung und nicht durchsetzbar. Sich korrekt verhaltende Crawler großer Unternehmen respektieren robots.txt-Direktiven in der Regel, aber manche Crawler ignorieren sie. Für stärkeren Schutz implementieren Sie Sperrungen auf Serverebene über .htaccess oder Firewall-Regeln und verifizieren Sie legitime Crawler anhand veröffentlichter IP-Adressbereiche.

Überprüfen und aktualisieren Sie Ihre Blockliste mindestens vierteljährlich. Es tauchen regelmäßig neue KI-Crawler auf, daher sollten Sie monatlich Ihre Server-Logs prüfen, um neue Crawler zu identifizieren. Verfolgen Sie Community-Ressourcen wie das ai.robots.txt GitHub-Projekt, um Updates zu aufkommenden Crawlern und User-Agent-Strings zu erhalten.

Das hängt von Ihren geschäftlichen Prioritäten ab. Das Blockieren von Trainingscrawlern schützt Ihre Inhalte davor, ohne Vergütung in KI-Modelle einzugehen. Das Blockieren von Suchcrawlern kann Ihre Sichtbarkeit auf KI-basierten Discovery-Plattformen wie ChatGPT Search oder Perplexity verringern. Viele Publisher entscheiden sich für selektives Blockieren, indem sie Trainingscrawler blockieren und Such- sowie Zitationscrawler zulassen.

Überprüfen Sie Ihre Server-Logs auf Crawler-User-Agent-Strings und stellen Sie sicher, dass geblockte Crawler nicht auf Ihre Inhaltsseiten zugreifen. Nutzen Sie Analysetools, um Bot-Traffic-Muster zu überwachen. Testen Sie Ihre Konfiguration mit Knowatoa AI Search Console oder dem Merkle robots.txt Tester, um zu validieren, dass Ihre Regeln wie beabsichtigt funktionieren.

Agentische Browser-Crawler wie ChatGPT Atlas und Google Project Mariner agieren als vollwertige Webbrowser statt als einfache HTTP-Clients. Sie nutzen oft Standard-Chrome-User-Agent-Strings, sodass sie von regulärem Browserverkehr nicht zu unterscheiden sind. Für die Kontrolle solcher fortgeschrittener Crawler ist IP-basiertes Blockieren notwendig.

AI-spezifische robots.txt steuert den Zugriff auf Ihre Inhalte, während Tools wie AmICited überwachen, wie KI-Plattformen Ihre Inhalte referenzieren und zitieren. Zusammen bieten sie vollständige Sichtbarkeit und Kontrolle: robots.txt regelt den Crawler-Zugriff, Überwachungstools verfolgen die Wirkung Ihrer Inhalte auf KI-Systemen.

AmICited verfolgt, wie KI-Systeme wie ChatGPT, Claude, Perplexity und Google AI Overviews Ihre Marke zitieren und referenzieren. Kombinieren Sie robots.txt-Konfiguration mit KI-Sichtbarkeitsüberwachung, um die Wirkung Ihrer Inhalte auf KI-Plattformen zu verstehen.

Erfahren Sie, wie Sie robots.txt konfigurieren, um den Zugriff von KI-Crawlern wie GPTBot, ClaudeBot und Perplexity zu steuern. Verwalten Sie die Sichtbarkeit I...

Community-Diskussion zur Konfiguration von robots.txt für KI-Crawler wie GPTBot, ClaudeBot und PerplexityBot. Echte Erfahrungen von Webmastern und SEO-Spezialis...

Erfahren Sie, was robots.txt ist, wie sie Suchmaschinen-Crawler anweist, sowie bewährte Praktiken zur Verwaltung des Crawler-Zugriffs auf Ihre Website-Inhalte u...