Überschriften-Hierarchie für KI: So strukturieren Sie Inhalte, die LLMs verstehen

Erfahren Sie, wie Sie die Überschriften-Hierarchie für das Parsing durch LLMs optimieren. Beherrschen Sie die Struktur H1, H2, H3, um die Sichtbarkeit, Zitation...

Ein Aufmerksamkeitsmechanismus ist eine Komponente eines neuronalen Netzwerks, die die Bedeutung verschiedener Eingabeelemente dynamisch gewichtet und es Modellen ermöglicht, sich bei Vorhersagen auf die relevantesten Teile der Daten zu konzentrieren. Er berechnet Aufmerksamkeitsgewichte durch gelernte Transformationen von Abfragen, Schlüsseln und Werten, wodurch Deep-Learning-Modelle langfristige Abhängigkeiten und kontextbewusste Beziehungen in sequenziellen Daten erfassen können.

Ein Aufmerksamkeitsmechanismus ist eine Komponente eines neuronalen Netzwerks, die die Bedeutung verschiedener Eingabeelemente dynamisch gewichtet und es Modellen ermöglicht, sich bei Vorhersagen auf die relevantesten Teile der Daten zu konzentrieren. Er berechnet Aufmerksamkeitsgewichte durch gelernte Transformationen von Abfragen, Schlüsseln und Werten, wodurch Deep-Learning-Modelle langfristige Abhängigkeiten und kontextbewusste Beziehungen in sequenziellen Daten erfassen können.

Aufmerksamkeitsmechanismus ist eine Machine-Learning-Technik, die Deep-Learning-Modelle dazu anleitet, bei Vorhersagen die relevantesten Teile der Eingangsdaten zu priorisieren (oder ihnen „Aufmerksamkeit zu schenken“). Anstatt alle Eingabeelemente gleich zu behandeln, berechnen Aufmerksamkeitsmechanismen Aufmerksamkeitsgewichte, die die relative Bedeutung jedes Elements für die jeweilige Aufgabe widerspiegeln, und wenden diese Gewichte dann an, um bestimmte Eingaben dynamisch zu betonen oder abzuschwächen. Diese grundlegende Innovation ist zum Eckpfeiler moderner Transformer-Architekturen und großer Sprachmodelle (LLMs) wie ChatGPT, Claude und Perplexity geworden und ermöglicht es ihnen, sequenzielle Daten mit beispielloser Effizienz und Genauigkeit zu verarbeiten. Der Mechanismus ist von der menschlichen kognitiven Aufmerksamkeit inspiriert – der Fähigkeit, sich selektiv auf auffällige Details zu konzentrieren und irrelevante Informationen herauszufiltern – und überträgt dieses biologische Prinzip auf eine mathematisch rigorose und lernbare Komponente neuronaler Netzwerke.

Das Konzept der Aufmerksamkeitsmechanismen wurde 2014 erstmals von Bahdanau und Kollegen eingeführt, um kritische Einschränkungen von rekurrenten neuronalen Netzwerken (RNNs) bei der maschinellen Übersetzung zu adressieren. Vor der Einführung von Aufmerksamkeit stützten sich Seq2Seq-Modelle auf einen einzigen Kontextvektor, um ganze Quellsätze zu kodieren, wodurch ein Informationsengpass entstand, der die Leistung bei längeren Sequenzen stark einschränkte. Der ursprüngliche Aufmerksamkeitsmechanismus ermöglichte es dem Decoder, auf alle verborgenen Zustände des Encoders statt nur auf den letzten zuzugreifen und so bei jedem Decodierschritt dynamisch die relevantesten Teile der Eingabe auszuwählen. Dieser Durchbruch verbesserte die Übersetzungsqualität dramatisch, insbesondere bei längeren Sätzen. 2015 führten Luong und Kollegen die Dot-Product-Attention ein, die die rechenintensive additive Aufmerksamkeit durch effiziente Matrixmultiplikation ersetzte. Der Wendepunkt kam 2017 mit der Veröffentlichung von „Attention is All You Need“, das die Transformer-Architektur einführte, die vollständig auf Rekurrenz verzichtete und stattdessen ausschließlich auf Aufmerksamkeitsmechanismen setzte. Dieses Paper revolutionierte das Deep Learning und ermöglichte die Entwicklung von BERT, GPT-Modellen und dem gesamten modernen generativen KI-Ökosystem. Heute sind Aufmerksamkeitsmechanismen allgegenwärtig in der Verarbeitung natürlicher Sprache, Computer Vision und multimodalen KI-Systemen, wobei über 85 % der State-of-the-Art-Modelle irgendeine Form von auf Aufmerksamkeit basierender Architektur einbeziehen.

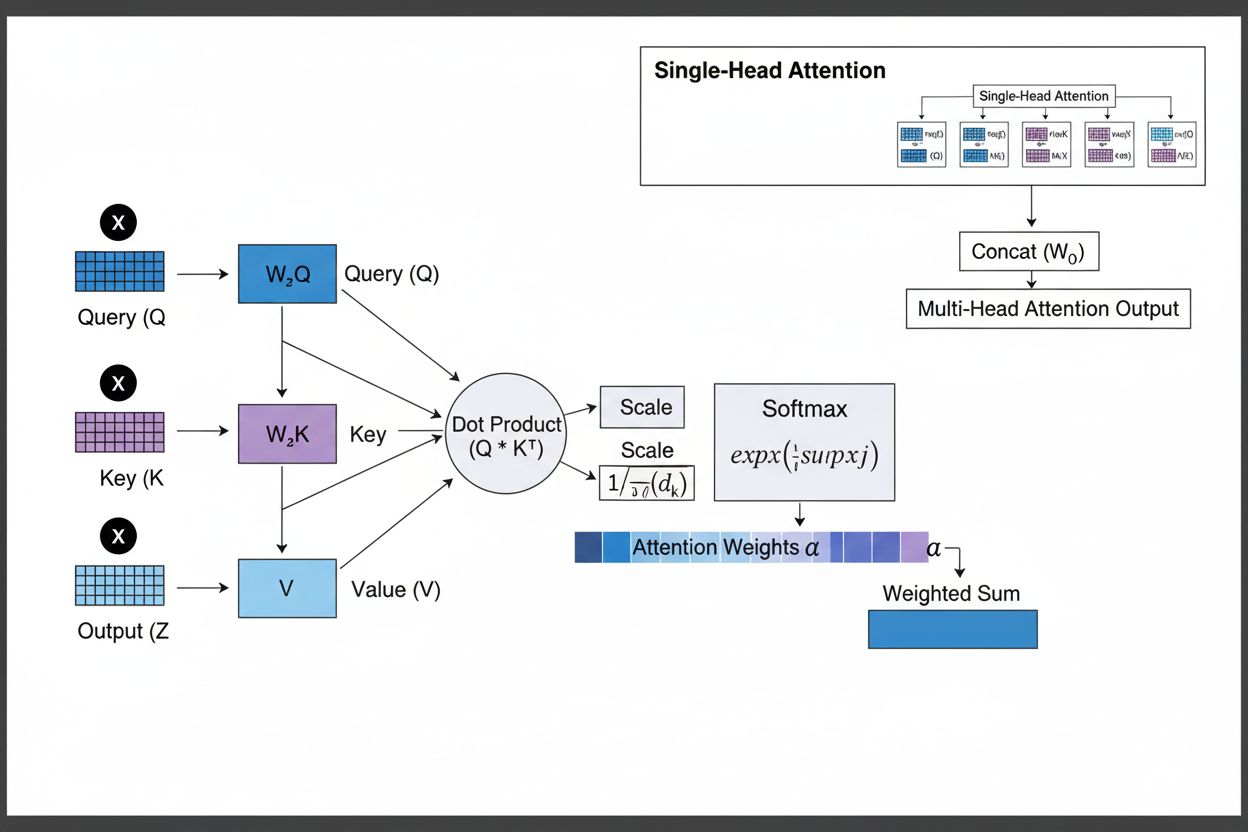

Der Aufmerksamkeitsmechanismus funktioniert durch ein raffiniertes Zusammenspiel von drei zentralen mathematischen Komponenten: Abfragen (Q), Schlüssel (K) und Werte (V). Jedes Eingabeelement wird durch gelernte lineare Projektionen in diese drei Repräsentationen überführt und bildet so eine strukturähnliche Datenbank, in der Schlüssel als Identifikatoren und Werte den eigentlichen Informationsinhalt darstellen. Der Mechanismus berechnet Ausrichtungswerte, indem er die Ähnlichkeit zwischen einer Abfrage und allen Schlüsseln misst, typischerweise mithilfe der skalierten Punktprodukt-Aufmerksamkeit, wobei der Wert als QK^T/√d_k berechnet wird. Diese Rohwerte werden anschließend mit der Softmax-Funktion normalisiert, die sie in eine Wahrscheinlichkeitsverteilung umwandelt, bei der alle Gewichte zusammen 1 ergeben, sodass jedes Element ein Gewicht zwischen 0 und 1 erhält. Im letzten Schritt wird eine gewichtete Summe der Wertvektoren unter Verwendung dieser Aufmerksamkeitsgewichte berechnet, was einen Kontextvektor ergibt, der die relevantesten Informationen der gesamten Eingabesequenz repräsentiert. Dieser Kontextvektor wird dann über Residualverbindungen mit der ursprünglichen Eingabe kombiniert und durch Feedforward-Schichten weiterverarbeitet, wodurch das Modell seine Interpretation der Eingabe iterativ verfeinern kann. Die mathematische Eleganz dieses Designs – die Verbindung aus lernbaren Transformationen, Ähnlichkeitsberechnungen und probabilistischer Gewichtung – ermöglicht es Aufmerksamkeitsmechanismen, komplexe Abhängigkeiten zu erfassen und gleichzeitig vollständig differenzierbar für gradientenbasierte Optimierung zu bleiben.

| Aufmerksamkeitstyp | Rechenmethode | Rechenkomplexität | Bester Anwendungsfall | Hauptvorteil |

|---|---|---|---|---|

| Additive Aufmerksamkeit | Feed-Forward-Netzwerk + tanh-Aktivierung | O(n·d) pro Abfrage | Kürzere Sequenzen, variable Dimensionen | Unterstützt unterschiedliche Query/Key-Dimensionen |

| Dot-Product-Attention | Einfache Matrixmultiplikation | O(n·d) pro Abfrage | Standardsequenzen | Rechnerisch effizient |

| Skalierte Punktprodukt | QK^T/√d_k + softmax | O(n·d) pro Abfrage | Moderne Transformer | Verhindert Gradientenauslöschung |

| Multi-Head-Attention | Mehrere parallele Aufmerksamkeitsköpfe | O(h·n·d) mit h=Köpfe | Komplexe Beziehungen | Erfasst vielfältige semantische Aspekte |

| Selbstaufmerksamkeit | Abfragen, Schlüssel, Werte aus derselben Sequenz | O(n²·d) | Intra-Sequenz-Beziehungen | Ermöglicht parallele Verarbeitung |

| Kreuzaufmerksamkeit | Abfragen aus einer Sequenz, Schlüssel/Werte aus einer anderen | O(n·m·d) | Encoder-Decoder, multimodal | Richtet verschiedene Modalitäten aus |

| Grouped Query Attention | Teilt Schlüssel/Werte über Abfrageköpfe hinweg | O(n·d) | Effizientes Inferenz | Reduziert Speicher und Berechnung |

| Sparse Attention | Begrenzte Aufmerksamkeit auf lokale/abgestufte Positionen | O(n·√n·d) | Sehr lange Sequenzen | Bewältigt extrem lange Sequenzen |

Der Aufmerksamkeitsmechanismus arbeitet durch eine präzise abgestimmte Abfolge mathematischer Transformationen, die es neuronalen Netzwerken ermöglichen, sich dynamisch auf relevante Informationen zu konzentrieren. Beim Verarbeiten einer Eingabesequenz wird jedes Element zunächst in einen hochdimensionalen Vektorraum eingebettet, der semantische und syntaktische Informationen erfasst. Diese Einbettungen werden dann durch gelernte Gewichtsmatrizen in drei separate Räume projiziert: den Abfrage-Raum (welche Information gesucht wird), den Schlüssel-Raum (welche Information jedes Element enthält) und den Werte-Raum (die eigentlichen zu aggregierenden Informationen). Für jede Abfrageposition berechnet der Mechanismus einen Ähnlichkeitswert mit jedem Schlüssel durch deren Punktprodukt und erzeugt so einen Vektor roher Ausrichtungswerte. Diese Werte werden durch Division durch die Quadratwurzel der Schlüsseldimension (√d_k) skaliert – ein wichtiger Schritt, der verhindert, dass Punktprodukte bei hohen Dimensionen zu groß werden und dadurch Gradienten beim Backpropagation-Prozess verschwinden. Die skalierten Werte werden durch eine Softmax-Funktion geführt, die jeden Wert exponentiert und so normalisiert, dass alle zusammen 1 ergeben – das ergibt eine Wahrscheinlichkeitsverteilung über alle Positionen. Schließlich werden diese Aufmerksamkeitsgewichte verwendet, um einen gewichteten Durchschnitt der Wertevektoren zu berechnen, wobei Positionen mit höheren Gewichten stärker zum endgültigen Kontextvektor beitragen. Dieser Kontextvektor wird über Residualverbindungen mit der ursprünglichen Eingabe kombiniert und durch Feedforward-Schichten weiterverarbeitet, sodass das Modell seine Repräsentationen iterativ verfeinert. Der gesamte Prozess ist differenzierbar, sodass das Modell optimale Aufmerksamkeitsmuster während des Trainings per Gradientenabstieg lernen kann.

Aufmerksamkeitsmechanismen bilden den grundlegenden Baustein der Transformer-Architekturen, die sich zum dominanten Ansatz im Deep Learning entwickelt haben. Im Gegensatz zu RNNs, die Sequenzen sequenziell verarbeiten, und CNNs, die auf festen lokalen Fenstern operieren, nutzen Transformer Selbstaufmerksamkeit, sodass jede Position direkt auf alle anderen Positionen gleichzeitig achten kann, was massive Parallelisierung auf GPUs und TPUs ermöglicht. Die Transformer-Architektur besteht aus abwechselnden Schichten von Multi-Head-Selbstaufmerksamkeit und Feedforward-Netzwerken, wobei jede Aufmerksamkeitslage das Modell befähigt, die Eingabe selektiv auf verschiedene Aspekte hin zu analysieren. Multi-Head-Attention führt mehrere Aufmerksamkeitsmechanismen parallel aus, wobei jeder Kopf lernt, sich auf unterschiedliche Beziehungstypen zu fokussieren – ein Kopf kann sich auf grammatische Abhängigkeiten spezialisieren, ein anderer auf semantische Beziehungen und ein dritter auf Langstrecken-Koreferenz. Die Ausgaben aller Köpfe werden zusammengefügt und projiziert, sodass das Modell mehrere linguistische Phänomene gleichzeitig erfassen kann. Diese Architektur hat sich als äußerst effektiv für große Sprachmodelle wie GPT-4, Claude 3 und Gemini erwiesen, die ausschließlich Decoder-basierte Transformer-Architekturen einsetzen, wobei jedes Token nur auf vorherige Token achten darf (kausales Maskieren), um die autoregressive Generierungseigenschaft zu bewahren. Die Fähigkeit des Aufmerksamkeitsmechanismus, Langstreckenabhängigkeiten ohne die von RNNs bekannten vanishing gradients zu erfassen, war entscheidend, um Kontextfenster von über 100.000 Token zu ermöglichen und dabei Kohärenz und Konsistenz über große Textmengen aufrechtzuerhalten. Forschungen zeigen, dass etwa 92 % der modernen NLP-Modelle auf Transformer-Architekturen mit Aufmerksamkeitsmechanismen basieren, was ihre fundamentale Bedeutung für heutige KI-Systeme unterstreicht.

Im Kontext von KI-Suchplattformen wie ChatGPT, Perplexity, Claude und Google AI Overviews spielen Aufmerksamkeitsmechanismen eine entscheidende Rolle dabei, welche Teile abgerufener Dokumente und Wissensbasen für Nutzeranfragen am relevantesten sind. Wenn diese Systeme Antworten generieren, gewichten ihre Aufmerksamkeitsmechanismen verschiedene Quellen und Passagen dynamisch nach Relevanz und ermöglichen es ihnen, kohärente Antworten aus mehreren Quellen zu synthetisieren, während die faktische Genauigkeit erhalten bleibt. Die während der Generierung berechneten Aufmerksamkeitsgewichte können analysiert werden, um zu verstehen, welche Informationen das Modell priorisiert hat, und geben Aufschluss darüber, wie KI-Systeme Anfragen interpretieren und beantworten. Für das Brand Monitoring und GEO (Generative Engine Optimization) ist das Verständnis von Aufmerksamkeitsmechanismen essenziell, weil sie bestimmen, welchen Inhalten und Quellen in KI-generierten Antworten Gewicht verliehen wird. Inhalte, die so strukturiert sind, dass sie mit der Gewichtung der Aufmerksamkeitsmechanismen harmonieren – etwa durch klare Entitätsdefinitionen, autoritative Quellen und kontextuelle Relevanz – werden mit höherer Wahrscheinlichkeit prominent in KI-Antworten genannt und zitiert. AmICited nutzt Erkenntnisse über Aufmerksamkeitsmechanismen, um zu verfolgen, wie Marken und Domains in KI-Plattformen erscheinen, und erkennt, dass durch Aufmerksamkeitsgewichte gewichtete Zitate die einflussreichsten Erwähnungen in KI-generierten Inhalten darstellen. Während Unternehmen verstärkt ihre Präsenz in KI-Antworten überwachen, ist das Verständnis, dass Aufmerksamkeitsmechanismen die Zitiermuster steuern, entscheidend für die Optimierung der Content-Strategie und die Sicherung der Markenpräsenz im Zeitalter generativer KI.

Das Feld der Aufmerksamkeitsmechanismen entwickelt sich rasant weiter: Forscher entwickeln immer ausgefeiltere Varianten, um Rechenbeschränkungen zu adressieren und die Leistung zu steigern. Sparse-Attention-Muster beschränken die Aufmerksamkeit auf lokale Nachbarschaften oder abgestufte Positionen, reduzieren die Komplexität von O(n²) auf O(n·√n) und ermöglichen dennoch gute Leistungen bei sehr langen Sequenzen. Effiziente Aufmerksamkeitsmechanismen wie FlashAttention optimieren die Speicherzugriffsmuster der Berechnung und erreichen durch bessere GPU-Auslastung Beschleunigungen um den Faktor 2-4. Grouped Query Attention und Multi-Query Attention verringern die Anzahl der Key-Value-Köpfe bei gleichbleibender Leistung und senken so den Speicherbedarf im Inferenzbetrieb – ein wichtiger Aspekt für den produktiven Einsatz großer Modelle. Mixture-of-Experts-Architekturen kombinieren Aufmerksamkeit mit sparsamen Routen und ermöglichen es Modellen, auf Billionen von Parametern zu skalieren, ohne die Recheneffizienz zu beeinträchtigen. Neue Forschungen untersuchen gelernte Aufmerksamkeitsmuster, die sich dynamisch an die Eingabe anpassen, sowie hierarchische Aufmerksamkeit, die auf mehreren Abstraktionsebenen arbeitet. Die Integration von Aufmerksamkeitsmechanismen mit Retrieval-Augmented Generation (RAG) ermöglicht es Modellen, dynamisch auf relevantes externes Wissen zu achten, was die Faktentreue steigert und Halluzinationen reduziert. Da KI-Systeme zunehmend in kritischen Anwendungen eingesetzt werden, werden Aufmerksamkeitsmechanismen mit Erklärbarkeitsfunktionen erweitert, die klarere Einblicke in die Entscheidungsfindung liefern. Die Zukunft dürfte hybride Architekturen beinhalten, die Aufmerksamkeit mit alternativen Mechanismen wie State-Space-Modellen (wie bei Mamba) kombinieren, die lineare Komplexität bei wettbewerbsfähiger Leistung bieten. Das Verständnis dieser sich weiterentwickelnden Aufmerksamkeitsmechanismen ist essenziell für Praktiker, die nächste KI-Systeme entwickeln, sowie für Organisationen, die ihre Präsenz in KI-generierten Inhalten überwachen, da die Mechanismen, die Zitiermuster und Inhaltsgewichtung bestimmen, sich stetig weiterentwickeln.

Für Organisationen, die AmICited zur Überwachung der Markenpräsenz in KI-Antworten nutzen, liefert das Verständnis von Aufmerksamkeitsmechanismen entscheidenden Kontext zur Interpretation von Zitiermustern. Wenn ChatGPT, Claude oder Perplexity Ihre Domain in ihren Antworten zitieren, haben die während der Generierung berechneten Aufmerksamkeitsgewichte bestimmt, dass Ihre Inhalte für die Nutzeranfrage am relevantesten waren. Hochwertige, gut strukturierte Inhalte, die Entitäten klar definieren und autoritative Informationen bieten, erhalten von Natur aus höhere Aufmerksamkeitsgewichte und werden so mit größerer Wahrscheinlichkeit für Zitate ausgewählt. Die Visualisierungsfunktionen für Aufmerksamkeit in einigen KI-Plattformen zeigen, welche Quellen während der Antwortgenerierung den größten Fokus erhalten haben und machen so sichtbar, welche Zitate am einflussreichsten waren. Diese Erkenntnis ermöglicht es Organisationen, ihre Content-Strategie gezielt zu optimieren, denn Aufmerksamkeitsmechanismen belohnen Klarheit, Relevanz und autoritative Quellen. Mit dem Wachstum der KI-Suche – über 60 % der Unternehmen investieren inzwischen in generative KI-Initiativen – wird die Fähigkeit, Aufmerksamkeitsmechanismen zu verstehen und zu optimieren, immer wertvoller für die Markenpräsenz und eine korrekte Darstellung in KI-generierten Inhalten. Der Schnittpunkt von Aufmerksamkeitsmechanismen und Markenüberwachung bildet eine neue Grenze im GEO, bei der das Verständnis der mathematischen Grundlagen, wie KI-Systeme Informationen gewichten und zitieren, direkt zu verbesserter Sichtbarkeit und Einfluss im generativen KI-Ökosystem führt.

Traditionelle RNNs verarbeiten Sequenzen seriell, was es schwierig macht, langfristige Abhängigkeiten zu erfassen, während CNNs feste lokale Rezeptivfelder haben, die ihre Fähigkeit einschränken, entfernte Beziehungen zu modellieren. Aufmerksamkeitsmechanismen überwinden diese Einschränkungen, indem sie Beziehungen zwischen allen Eingabepositionen gleichzeitig berechnen, was parallele Verarbeitung und das Erfassen von Abhängigkeiten unabhängig von der Entfernung ermöglicht. Diese Flexibilität über Zeit und Raum macht Aufmerksamkeitsmechanismen deutlich effizienter und effektiver für komplexe sequenzielle und räumliche Daten.

Abfragen (Queries) repräsentieren, welche Informationen das Modell aktuell sucht, Schlüssel (Keys) stehen für die Informationsinhalte, die jedes Eingabeelement enthält, und Werte (Values) enthalten die eigentlichen Daten, die aggregiert werden sollen. Das Modell berechnet Ähnlichkeitswerte zwischen Abfragen und Schlüsseln, um zu bestimmen, welche Werte am stärksten gewichtet werden sollten. Diese von Datenbanken inspirierte Terminologie, die durch das Paper 'Attention is All You Need' populär wurde, bietet einen intuitiven Rahmen zum Verständnis, wie Aufmerksamkeitsmechanismen relevante Informationen selektiv aus Eingabesequenzen abrufen und kombinieren.

Selbstaufmerksamkeit berechnet Beziehungen innerhalb einer einzelnen Eingabesequenz, wobei Abfragen, Schlüssel und Werte alle aus derselben Quelle stammen, sodass das Modell verstehen kann, wie verschiedene Elemente miteinander in Beziehung stehen. Kreuzaufmerksamkeit dagegen verwendet Abfragen aus einer Sequenz und Schlüssel/Werte aus einer anderen, sodass das Modell Informationen aus mehreren Quellen ausrichten und kombinieren kann. Kreuzaufmerksamkeit ist essenziell in Encoder-Decoder-Architekturen wie der maschinellen Übersetzung und in multimodalen Modellen wie Stable Diffusion, die Text- und Bildinformationen kombinieren.

Skalierte Punktprodukt-Aufmerksamkeit verwendet Multiplikation anstelle von Addition zur Berechnung der Ausrichtungswerte, was durch Matrixoperationen, die die GPU-Parallelisierung nutzen, rechnerisch effizienter ist. Der Skalierungsfaktor 1/√dk verhindert, dass Punktprodukte bei hoher Schlüsseldimension zu groß werden, was beim Backpropagation-Prozess zum Verschwinden der Gradienten führen würde. Während additive Aufmerksamkeit bei sehr großen Dimensionen manchmal besser abschneidet, macht die überlegene rechnerische Effizienz und praktische Leistung der skalierten Punktprodukt-Aufmerksamkeit sie zum Standard in modernen Transformer-Architekturen.

Multi-Head-Attention führt mehrere Aufmerksamkeitsmechanismen parallel aus, wobei jeder Kopf lernt, sich auf verschiedene Aspekte der Eingabe wie grammatische Beziehungen, semantische Bedeutungen oder Langstreckenabhängigkeiten zu konzentrieren. Jeder Kopf arbeitet auf verschiedenen linearen Projektionen der Eingabe, sodass das Modell gleichzeitig unterschiedliche Beziehungstypen erfassen kann. Die Ausgaben aller Köpfe werden zusammengefügt und projiziert, sodass das Modell umfassende Kenntnisse über mehrere sprachliche und kontextuelle Eigenschaften gleichzeitig behält, was die Repräsentationsqualität und die Leistung bei Folgeaufgaben erheblich verbessert.

Softmax normalisiert die rohen Ausrichtungswerte, die zwischen Abfragen und Schlüsseln berechnet wurden, zu einer Wahrscheinlichkeitsverteilung, bei der alle Gewichte zusammen 1 ergeben. Diese Normalisierung stellt sicher, dass Aufmerksamkeitsgewichte als Bedeutungswerte interpretierbar sind, wobei höhere Werte auf größere Relevanz hinweisen. Die Softmax-Funktion ist differenzierbar und ermöglicht das gradientenbasierte Lernen des Aufmerksamkeitsmechanismus während des Trainings. Ihre exponentielle Natur betont Unterschiede zwischen den Werten, wodurch der Fokus des Modells selektiver und interpretierbarer wird.

Aufmerksamkeitsmechanismen ermöglichen es diesen Modellen, verschiedene Teile der Eingabeaufforderung dynamisch nach ihrer Relevanz für den aktuellen Generierungsschritt zu gewichten. Bei der Generierung einer Antwort nutzt das Modell Aufmerksamkeit, um zu bestimmen, welche vorherigen Token und Eingabeelemente den nächsten Token am stärksten beeinflussen sollten. Diese kontextbewusste Gewichtung befähigt die Modelle, Kohärenz zu bewahren, Entitäten über lange Dokumente hinweg zu verfolgen, Mehrdeutigkeiten aufzulösen und Antworten zu generieren, die sich angemessen auf spezifische Teile der Eingabe beziehen, wodurch ihre Ausgaben genauer und kontextuell passender werden.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, wie Sie die Überschriften-Hierarchie für das Parsing durch LLMs optimieren. Beherrschen Sie die Struktur H1, H2, H3, um die Sichtbarkeit, Zitation...

Relevanzsignale sind Indikatoren, die KI-Systeme zur Bewertung der Anwendbarkeit von Inhalten nutzen. Erfahren Sie, wie Keyword-Übereinstimmung, semantische Rel...

Meistere die Optimierung der Consideration-Phase in der KI mit Strategien für Content-Struktur, E-E-A-T-Signale und thematische Autorität. Erfahre, wie du zur m...