Robots.txt für KI: Wie Sie steuern, welche Bots auf Ihre Inhalte zugreifen

Erfahren Sie, wie Sie mit robots.txt steuern, welche KI-Bots auf Ihre Inhalte zugreifen. Vollständiger Leitfaden zum Blockieren von GPTBot, ClaudeBot und andere...

Ein strategischer Ansatz, der es Website-Betreibern ermöglicht, bestimmten KI-Crawlern selektiv Zugang zu gewähren und andere zu blockieren – basierend auf Geschäftszielen, Content-Lizenzverträgen und Wertbeurteilung. Anstatt Pauschalregeln anzuwenden, wird beim differenziellen Zugang jeder Crawler einzeln bewertet, um zu entscheiden, ob er Traffic bringt, Lizenzbedingungen einhält oder zu Monetarisierungszielen passt. Publisher nutzen Tools wie robots.txt, HTTP-Header und plattformspezifische Steuerungen, um granulare Zugriffsrichtlinien umzusetzen. Diese Methode balanciert Innovationschancen mit Content-Schutz und fairer Vergütung.

Ein strategischer Ansatz, der es Website-Betreibern ermöglicht, bestimmten KI-Crawlern selektiv Zugang zu gewähren und andere zu blockieren – basierend auf Geschäftszielen, Content-Lizenzverträgen und Wertbeurteilung. Anstatt Pauschalregeln anzuwenden, wird beim differenziellen Zugang jeder Crawler einzeln bewertet, um zu entscheiden, ob er Traffic bringt, Lizenzbedingungen einhält oder zu Monetarisierungszielen passt. Publisher nutzen Tools wie robots.txt, HTTP-Header und plattformspezifische Steuerungen, um granulare Zugriffsrichtlinien umzusetzen. Diese Methode balanciert Innovationschancen mit Content-Schutz und fairer Vergütung.

Die explosionsartige Zunahme von KI-Crawlern hat die jahrzehntelange Beziehung zwischen Website-Betreibern und Bots grundlegend gestört. Lange Zeit funktionierte das Internet nach einem einfachen Prinzip: Suchmaschinen wie Google indexierten Inhalte und leiteten Besucher zurück zur Originalquelle – ein symbiotisches Verhältnis, das die Erstellung hochwertiger Inhalte belohnte. Heute arbeitet eine neue Generation von KI-Crawlern – darunter GPTBot, ClaudeBot, PerplexityBot und Dutzende weitere – nach anderen Regeln. Diese Bots durchsuchen Inhalte nicht zur Indexierung, sondern speisen sie direkt in KI-Modelle, die Antworten generieren, ohne Nutzer zur Ursprungsquelle zurückzuleiten. Die Auswirkungen sind drastisch: Laut Daten von Cloudflare liegt das Crawl-zu-Referral-Verhältnis von OpenAIs GPTBot bei etwa 1.700:1, bei Anthropics ClaudeBot sogar bei 73.000:1 – das heißt, für jeden Besucher, der zur Publisher-Seite zurückkehrt, werden Tausende von Seiten für Trainingsdaten gecrawlt. Dieser gestörte Austausch zwingt Publisher dazu, ihre Crawler-Zugriffsrichtlinien zu überdenken und von der binären Wahl „alle zulassen“ oder „alle blockieren“ zu einer differenzierteren Strategie zu wechseln: differenzieller Crawler-Zugang. Statt Pauschalregeln zu erlassen, bewerten clevere Publisher jetzt jeden Crawler einzeln und stellen sich kritische Fragen zu Wert, Lizenzierung und Ausrichtung auf die Geschäftsziele.

Die verschiedenen Arten von KI-Crawlern zu verstehen, ist entscheidend für die erfolgreiche Umsetzung einer differenziellen Zugriffsstrategie, da jeder Typ unterschiedliche Zwecke verfolgt und unterschiedlich auf Ihr Geschäft wirkt. KI-Crawler lassen sich grob in drei Hauptkategorien einteilen: Trainingscrawler (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider), die Inhalte für das Modelltraining sammeln; Suchcrawler (OAI-SearchBot, PerplexityBot, Google-Extended), die Inhalte für KI-gestützte Suchergebnisse indexieren; und nutzergetriebene Agents (ChatGPT-User, Claude-Web, Perplexity-User), die Inhalte nur dann abrufen, wenn Nutzer sie explizit anfordern. Das Wertversprechen variiert dabei stark. Trainingscrawler generieren in der Regel kaum Traffic zurück auf Ihre Seite – sie entnehmen Wert, ohne Gegenleistung zu bieten – und sind daher meist Kandidaten für eine Blockierung. Suchcrawler hingegen können relevanten Referral-Traffic und Abonnenten gewinnen, ähnlich wie klassische Suchmaschinen. Nutzergetriebene Agents bewegen sich dazwischen: Sie werden nur aktiv, wenn Nutzer explizit mit KI-Systemen interagieren. The Atlantic, einer der größten Digitalpublisher, hat einen ausgefeilten Scorecard-Ansatz zur Bewertung von Crawlern entwickelt und verfolgt sowohl das Traffic-Volumen als auch die Abonnentengewinnung pro Bot. Ihre Analyse zeigte, dass einige Crawler echten Mehrwert bringen, andere hingegen praktisch keinen Traffic generieren, aber erhebliche Bandbreite verbrauchen. Diese datenbasierte Herangehensweise ermöglicht Publishern fundierte Entscheidungen statt Annahmen zu treffen.

| Crawler-Typ | Beispiele | Hauptzweck | Typischer Traffic-Wert | Empfohlener Zugang |

|---|---|---|---|---|

| Training | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Trainingsdatensätze für Modelle | Sehr gering (1.700:1 bis 73.000:1 Verhältnis) | Häufig blockiert |

| Suche | OAI-SearchBot, PerplexityBot, Google-Extended | KI-basierte Suchindexierung | Mittel bis hoch | Häufig erlaubt |

| Nutzergetrieben | ChatGPT-User, Claude-Web, Perplexity-User | Direkte Nutzeranfragen | Variabel | Einzelfallentscheidung |

Die Umsetzung von differenziellen Crawler-Zugriffsrichtlinien erfordert eine Kombination aus technischen Tools und strategischer Entscheidungsfindung – mit mehreren Methoden, je nach technischer Ausstattung und Geschäftsanforderungen. Das grundlegendste Tool ist die robots.txt, eine einfache Textdatei im Root-Verzeichnis Ihrer Website, die Crawlern über User-agent-Anweisungen Zugriffspräferenzen mitteilt. Obwohl robots.txt freiwillig ist und nur 40–60 % der KI-Bots sie respektieren, bleibt sie die erste Verteidigungslinie und ist kostenlos zu implementieren. Für Publisher, die stärkere Durchsetzung suchen, erstellt und aktualisiert Cloudflares verwaltete robots.txt automatisch Crawler-Anweisungen, setzt sie vor Ihre bestehende Datei und macht manuelle Pflege überflüssig. Darüber hinaus gibt es weitere Mechanismen zur Durchsetzung:

Am effektivsten ist ein mehrschichtiger Ansatz: robots.txt für regelkonforme Crawler, WAF-Regeln zur Durchsetzung und Monitoring-Tools zur Erfolgskontrolle und Erkennung neuer Bedrohungen.

Differenzieller Crawler-Zugang verlangt mehr als nur technische Umsetzung: Es gilt, eine stimmige Geschäftsstrategie zu entwickeln, die zum Umsatzmodell und zur Wettbewerbsposition passt. The Atlantics Ansatz liefert einen praktischen Rahmen: Jeder Crawler wird anhand von zwei Hauptmetriken bewertet – Traffic-Volumen und Abonnentengewinnung – mit der Frage, ob der Crawler genug Wert generiert, um den Zugriff auf Inhalte zu rechtfertigen. Für einen Publisher mit 80 € jährlichem Abonnentenwert bedeutet ein Crawler, der 1.000 Abonnenten bringt, einen Jahresumsatz von 80.000 € – das ändert die Zugriffsentscheidung fundamental. Allerdings sind Traffic- und Abonnentenmetriken nur ein Teil der Gleichung. Publisher müssen außerdem berücksichtigen:

Die strategischsten Publisher setzen gestufte Zugriffsrichtlinien um: Suchcrawler, die Traffic bringen, werden erlaubt, Trainingscrawler ohne Gegenwert blockiert und mit KI-Unternehmen mit hohem Wert wird über Lizenzverträge verhandelt. So werden Sichtbarkeit und Umsatz maximiert und geistiges Eigentum geschützt.

Trotz der Vorteile ist differenzieller Crawler-Zugang in der Praxis komplexer als in der Theorie und mit mehreren grundlegenden Herausforderungen verbunden. Die kritischste Einschränkung: robots.txt ist freiwillig – Crawler respektieren sie nur aus freien Stücken, nicht aus Verpflichtung. Studien zeigen, dass robots.txt nur 40–60 % der KI-Bots stoppt, 30–40 % werden durch User-Agent-Blocking abgefangen, sodass 10–30 % der Crawler ungehindert agieren. Manche KI-Unternehmen und böswillige Akteure ignorieren robots.txt absichtlich, weil ihnen der Inhalt wertvoller als Regelkonformität ist. Hinzu kommen Evasionsmethoden von Crawlern: Fortgeschrittene Bots fälschen User-Agents, erscheinen als Browser, nutzen verteilte IPs zur Tarnung und setzen Headless-Browser ein, um menschliches Verhalten zu imitieren. Das Google-Extended-Dilemma verdeutlicht die Komplexität: Das Blockieren von Google-Extended verhindert, dass Ihre Inhalte für Gemini AI genutzt werden. Google AI Overviews (in den Suchergebnissen) folgen jedoch den Standard-Googlebot-Regeln – ein Opt-out ist nicht möglich, ohne die Suchsichtbarkeit zu verlieren. Monitoring und Durchsetzung erfordern zudem erhebliche Ressourcen – das Erkennen neuer Crawler, die Aktualisierung von Richtlinien und die Wirksamkeitsprüfung sind Daueraufgaben. Und schließlich ist die rechtliche Lage ungewiss: Theoretisch schützt das Urheberrecht Inhalte, doch die Durchsetzung gegenüber KI-Unternehmen ist teuer und die Erfolgsaussichten unklar – Publisher haben technische Kontrolle, aber keine Rechtssicherheit.

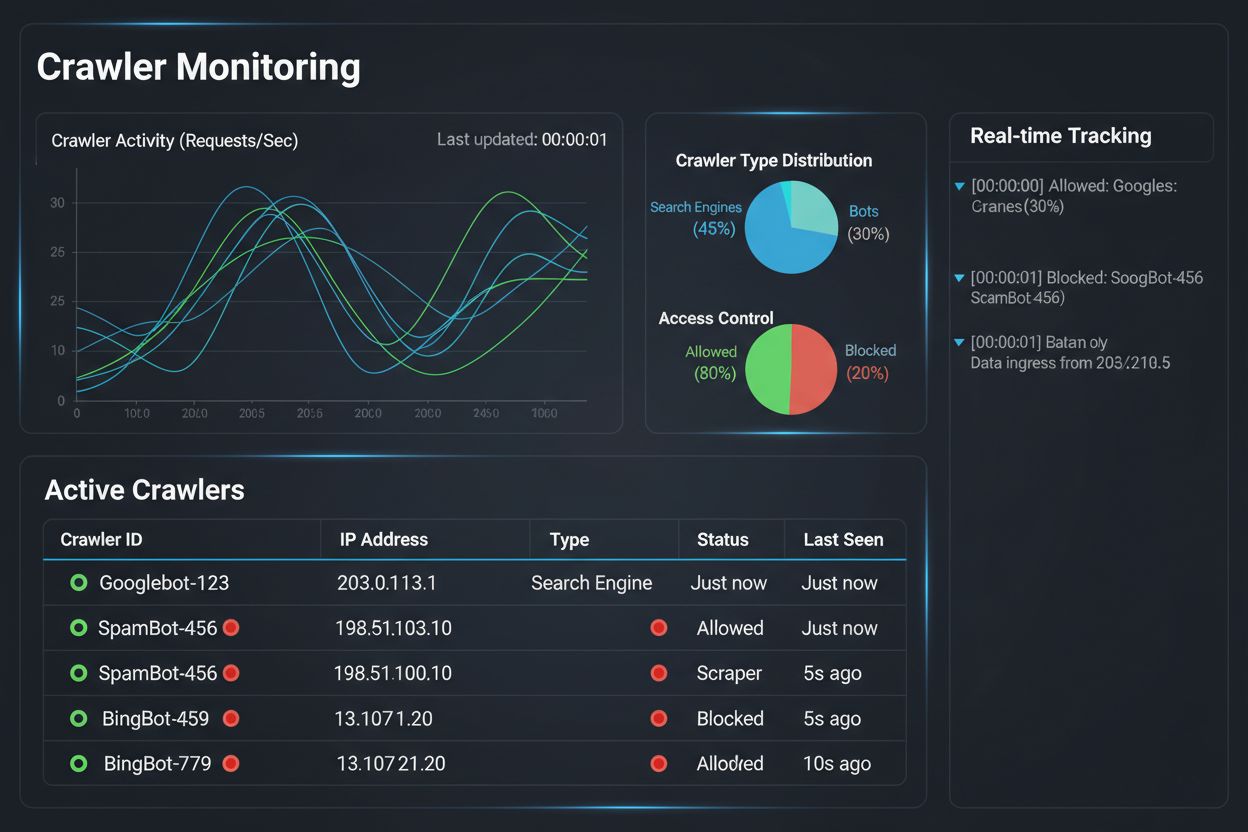

Die Umsetzung einer differenziellen Crawler-Zugriffsstrategie ist nur die halbe Miete – genauso wichtig ist es, die tatsächlichen Auswirkungen Ihrer Richtlinien durch umfassendes Monitoring und Messung zu verstehen. Hier wird AmICited.com zum unverzichtbaren Bestandteil Ihrer Crawler-Management-Strategie. AmICited ist auf das Monitoring spezialisiert, wie KI-Systeme Ihre Marke und Inhalte über GPTs, Perplexity, Google AI Overviews und andere KI-Plattformen referenzieren und zitieren – und bietet Ihnen Einblick, welche Crawler Ihre Inhalte tatsächlich nutzen und wie diese in KI-generierten Antworten erscheinen. Statt auf Server-Logs und Mutmaßungen zu vertrauen, zeigt das AmICited-Monitoring-Dashboard genau, welche KI-Systeme auf Ihre Inhalte zugegriffen haben, wie oft und vor allem, ob Ihre Inhalte zitiert werden oder einfach ohne Attribution ins Training einfließen. Diese Erkenntnisse sind direkt entscheidungsrelevant: Greift ein Crawler Ihre Inhalte ab, ohne sie je in KI-Antworten zu nennen, ist das Blockieren eine klare geschäftliche Entscheidung. AmICited ermöglicht zudem Wettbewerbs-Benchmarking: Sie sehen, wie Ihre Sichtbarkeit in KI-Systemen im Vergleich zur Konkurrenz ausfällt und erkennen, ob Ihre Richtlinien zu restriktiv oder zu offen sind. Die Plattform sendet Echtzeit-Benachrichtigungen, wenn neue KI-Systeme auf Ihre Inhalte zugreifen, sodass Sie umgehend Richtlinien anpassen können. In Kombination mit Cloudflares Durchsetzungstools erhalten Publisher so vollständige Kontrolle: Sie sehen, welche Crawler auf Inhalte zugreifen, messen den Geschäftseffekt und passen Richtlinien gezielt an. Das macht Crawler-Management von einer technischen Pflicht zu einer strategischen Geschäftsfunktion.

Das Feld des differenziellen Crawler-Zugangs entwickelt sich rasant – mit neuen Standards und Geschäftsmodellen, die das Zusammenspiel zwischen Publishern und KI-Unternehmen verändern. Der IETF-Vorschlag zu KI-Präferenzen ist ein bedeutender Schritt: Er schafft standardisierte Wege, wie Websites ihre Wünsche zu KI-Training, Inferenz und Suchnutzung mitteilen können. Statt auf robots.txt – einen 30 Jahre alten Standard für Suchmaschinen – zu setzen, bietet dieses neue Framework explizite, granulare Kontrolle darüber, wie KI-Systeme Inhalte verwenden dürfen. Gleichzeitig gewinnen zustimmungsbasierte Geschäftsmodelle an Bedeutung, etwa Cloudflares Pay Per Crawl-Initiative, die eine Bezahlstruktur für KI-Unternehmen aufbaut und Crawler so von Bedrohungen zu Umsatzbringern macht. Diese Verschiebung vom Blockieren hin zur Lizenzierung ist ein fundamentaler Wandel der Internet-Ökonomie: Anstatt um Zugriff zu streiten, verhandeln Publisher und KI-Unternehmen über faire Vergütung. Auch Authentifizierungs- und Verifizierungsstandards für Crawler schreiten voran – kryptografische Verfahren ermöglichen es Publishern, Crawler-Identitäten zu prüfen und gefälschte Anfragen zu verhindern. In Zukunft ist zudem mit stärkeren regulatorischen Rahmenwerken für KI-Trainingsdaten zu rechnen, die möglicherweise explizite Zustimmung und Vergütung für Content-Nutzung verlangen. Das Zusammenwirken dieser Trends – technische Standards, Lizenzmodelle, Authentifizierungsmechanismen und regulatorischer Druck – lässt erwarten, dass sich differenzieller Crawler-Zugang von einer Abwehrstrategie zu einer ausgereiften Geschäftsdisziplin entwickelt, bei der Publisher KI-Zugriff aktiv managen, monitoren und monetarisieren. Wer heute umfassendes Monitoring und strategische Richtlinien etabliert, ist optimal auf die neuen Chancen vorbereitet.

Wenn Sie alle Crawler blockieren, werden Ihre Inhalte vollständig aus KI-Systemen entfernt – Risiken und Chancen entfallen gleichermaßen. Beim differenziellen Zugang bewerten Sie jeden Crawler einzeln und blockieren diejenigen, die keinen Mehrwert bieten, während Sie solche zulassen, die Traffic generieren oder Lizenzchancen darstellen. Dieser differenzierte Ansatz maximiert sowohl Sichtbarkeit als auch Umsatz und schützt gleichzeitig das geistige Eigentum.

Sie können die Aktivitäten von Crawlern über Server-Logs, das Analytics-Dashboard von Cloudflare oder spezialisierte Monitoring-Tools wie AmICited.com überwachen. AmICited erfasst speziell, welche KI-Systeme auf Ihre Inhalte zugreifen und wie Ihre Marke in KI-generierten Antworten erscheint, und liefert so Geschäftseinblicke, die über technische Logs hinausgehen.

Nein. Das Blockieren von KI-Trainings-Crawlern wie GPTBot, ClaudeBot und CCBot hat keinen Einfluss auf Ihr Google- oder Bing-Suchergebnis-Ranking. Klassische Suchmaschinen verwenden andere Crawler (Googlebot, Bingbot), die unabhängig arbeiten. Blockieren Sie diese nur, wenn Sie komplett aus den Suchergebnissen verschwinden möchten.

Ja, das ist für viele Publisher der strategischste Ansatz. Sie können suchorientierte Crawler wie OAI-SearchBot und PerplexityBot (die Traffic bringen) zulassen und Trainingscrawler wie GPTBot und ClaudeBot (die in der Regel keinen Traffic bringen) blockieren. So bleibt Ihre Sichtbarkeit in KI-Suchergebnissen erhalten und Ihre Inhalte werden vor der Aufnahme in Trainingsdatensätze geschützt.

Während große Crawler von OpenAI, Anthropic und Google robots.txt respektieren, ignorieren manche Bots diese absichtlich. Wenn ein Crawler Ihre robots.txt nicht beachtet, benötigen Sie zusätzliche Maßnahmen wie WAF-Regeln, IP-Blockierung oder die Bot-Management-Funktionen von Cloudflare. Deshalb sind Monitoring-Tools wie AmICited essenziell – sie zeigen, welche Crawler Ihre Richtlinien tatsächlich respektieren.

Überprüfen Sie Ihre Richtlinien mindestens vierteljährlich, da KI-Unternehmen regelmäßig neue Crawler einführen. Anthropic zum Beispiel hat ihre Bots 'anthropic-ai' und 'Claude-Web' in 'ClaudeBot' zusammengeführt, wodurch der neue Bot vorübergehend uneingeschränkten Zugriff auf Seiten erhielt, die ihre Regeln nicht aktualisiert hatten. Regelmäßiges Monitoring mit Tools wie AmICited hilft Ihnen, immer auf dem neuesten Stand zu bleiben.

Googlebot ist der Suchcrawler von Google, der Inhalte für Suchergebnisse indexiert. Google-Extended ist ein Kontroll-Token, das steuert, ob Ihre Inhalte für das Training von Gemini AI genutzt werden. Sie können Google-Extended blockieren, ohne Ihr Suchranking zu beeinflussen. Beachten Sie jedoch, dass Google AI Overviews (die in Suchergebnissen erscheinen) die normalen Googlebot-Regeln verwenden – Sie können sich also nicht von AI Overviews abmelden, ohne Ihre Sichtbarkeit in der Suche zu verlieren.

Ja, aufkommende Lizenzmodelle wie Cloudflares Pay Per Crawl ermöglichen es Publishern, KI-Unternehmen für den Zugriff auf Inhalte bezahlen zu lassen. Dadurch werden Crawler von Bedrohungen zu Umsatzquellen. Dies erfordert jedoch Verhandlungen mit KI-Unternehmen und kann rechtliche Vereinbarungen umfassen. Das Monitoring von AmICited hilft Ihnen, herauszufinden, welche Crawler die wertvollsten Lizenzchancen darstellen.

Verfolgen Sie, welche KI-Systeme auf Ihre Inhalte zugreifen und wie Ihre Marke in KI-generierten Antworten erscheint. Erhalten Sie Echtzeiteinblicke in das Verhalten der Crawler und messen Sie den geschäftlichen Effekt Ihrer differenziellen Zugriffsrichtlinien.

Erfahren Sie, wie Sie mit robots.txt steuern, welche KI-Bots auf Ihre Inhalte zugreifen. Vollständiger Leitfaden zum Blockieren von GPTBot, ClaudeBot und andere...

Erfahren Sie, wie Web Application Firewalls fortschrittliche Kontrolle über KI-Crawler bieten – weit über robots.txt hinaus. Implementieren Sie WAF-Regeln, um I...

Lernen Sie bewährte Strategien, um die Besuchshäufigkeit von KI-Crawlern auf Ihrer Website zu steigern und die Auffindbarkeit Ihrer Inhalte in ChatGPT, Perplexi...