Edge SEO

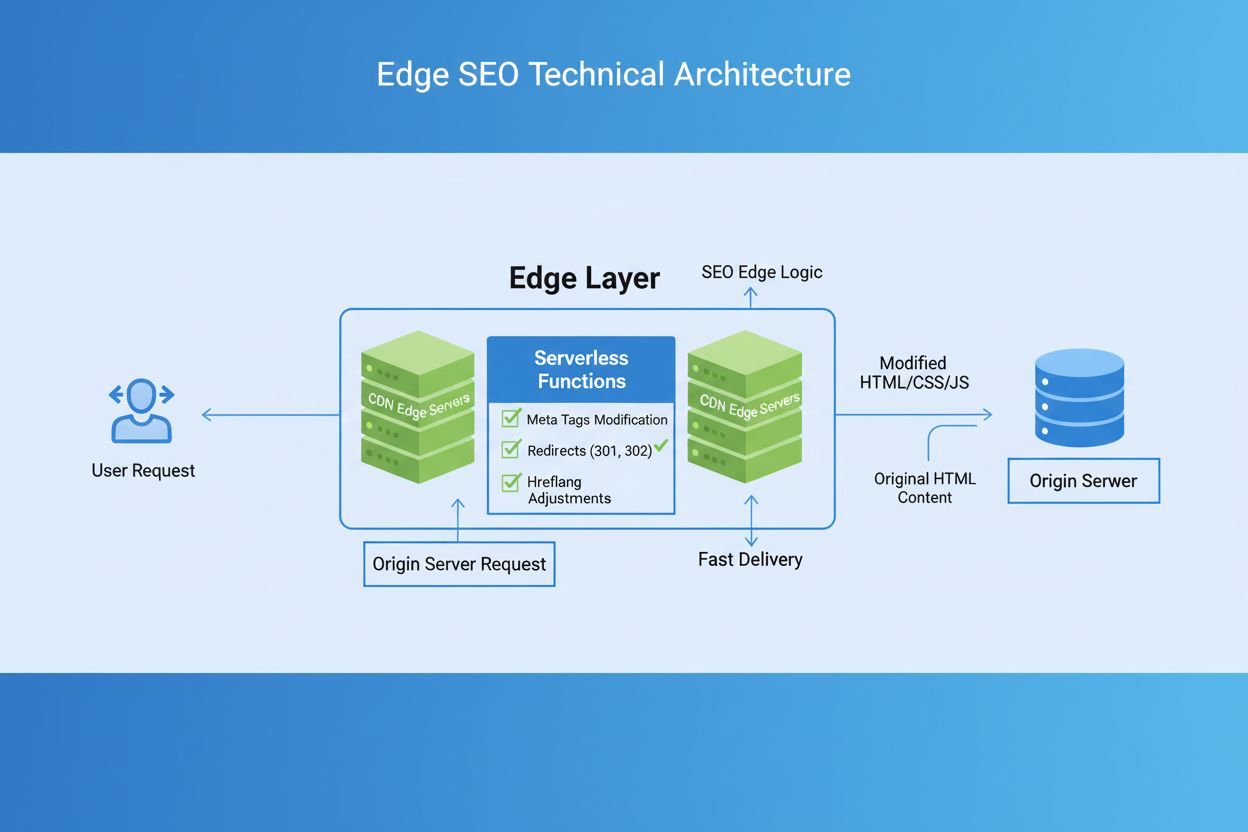

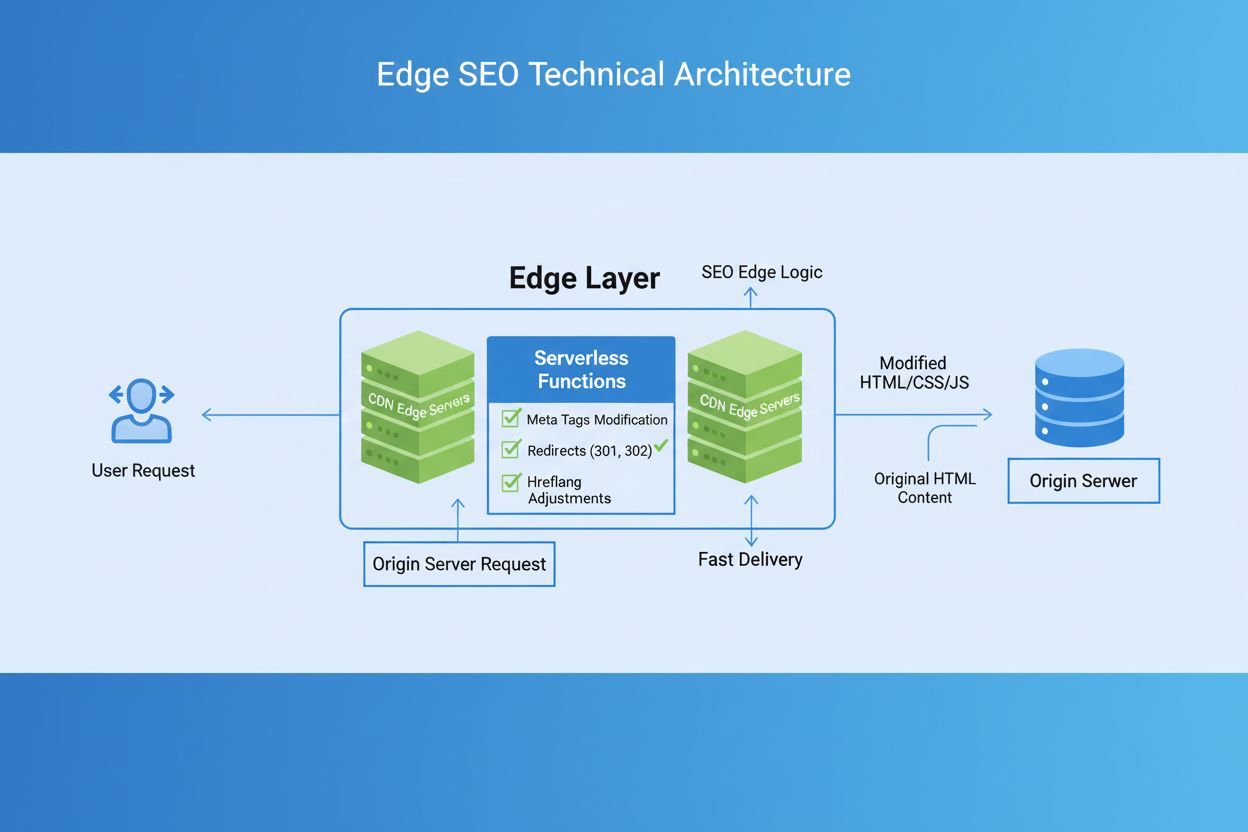

Edge SEO ist die Praxis, technische SEO-Änderungen am Netzwerkrand mit serverlosen Funktionen auf CDNs zu implementieren. Erfahren Sie, wie dadurch die Leistung...

Edge AI Processing bezeichnet die Bereitstellung von Algorithmen der künstlichen Intelligenz direkt auf lokalen Geräten oder Edge-Servern, wodurch eine Echtzeitdatenverarbeitung und -analyse ohne ständige Abhängigkeit von Cloud-Infrastrukturen ermöglicht wird. Dieser Ansatz reduziert die Latenz, verbessert den Datenschutz und erlaubt sofortige Entscheidungen für Anwendungen wie Markenüberwachung, IoT-Geräte und autonome Systeme.

Edge AI Processing bezeichnet die Bereitstellung von Algorithmen der künstlichen Intelligenz direkt auf lokalen Geräten oder Edge-Servern, wodurch eine Echtzeitdatenverarbeitung und -analyse ohne ständige Abhängigkeit von Cloud-Infrastrukturen ermöglicht wird. Dieser Ansatz reduziert die Latenz, verbessert den Datenschutz und erlaubt sofortige Entscheidungen für Anwendungen wie Markenüberwachung, IoT-Geräte und autonome Systeme.

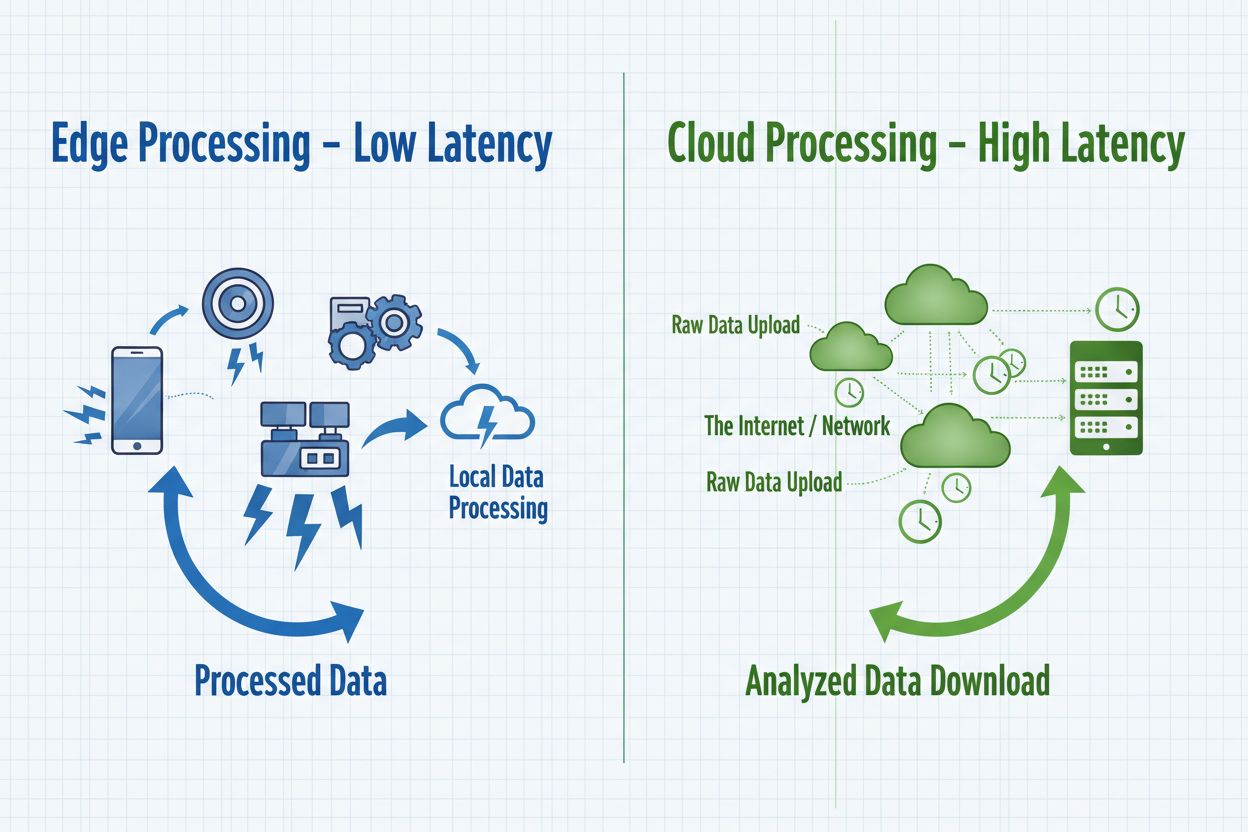

Edge AI Processing stellt einen Paradigmenwechsel in der Bereitstellung künstlicher Intelligenz dar, bei dem Rechenaufgaben direkt auf Edge-Geräten – wie Smartphones, IoT-Sensoren, Kameras und eingebetteten Systemen – ausgeführt werden, anstatt ausschließlich auf zentralisierte Cloud-Server zu setzen. Dieser Ansatz verarbeitet Daten an der Quelle, ermöglicht sofortige Analysen und Entscheidungen, ohne Rohdaten an entfernte Rechenzentren zu übertragen. Im Gegensatz zur traditionellen Cloud AI, bei der Daten zur Verarbeitung an entfernte Server geschickt und Ergebnisse nach Netzwerkverzögerung zurückgesandt werden, bringt Edge AI Intelligenz an den Rand des Netzwerks, wo die Daten entstehen. Die Verarbeitung findet auf lokaler Hardware mit eingebetteten Machine-Learning-Modellen statt, wodurch Geräte autonom agieren und Echtzeitentscheidungen treffen können. Edge AI kombiniert schlanke neuronale Netze, optimierte Algorithmen und spezialisierte Hardware-Beschleuniger, um KI-Fähigkeiten unter strengen Ressourcenbeschränkungen zu liefern. Dieses verteilte Intelligenzmodell verändert grundlegend, wie Organisationen mit Datenschutz, Systemreaktionsfähigkeit und Infrastrukturkosten umgehen. Durch die lokale Verarbeitung sensibler Informationen entfällt die Übertragung potenziell vertraulicher Daten über Netzwerke, was wachsenden Datenschutzanforderungen in regulierten Branchen Rechnung trägt.

Edge AI und Cloud AI stehen für komplementäre Ansätze der KI-Bereitstellung, die jeweils spezifische Vorteile für unterschiedliche Anwendungsfälle und Organisationsanforderungen bieten. Cloud AI brilliert bei der Verarbeitung riesiger Datenmengen, dem Training komplexer Modelle und der Ausführung rechenintensiver Aufgaben, die von zentraler Rechenleistung und unbegrenzter Skalierbarkeit profitieren. Allerdings verursachen Cloud-Lösungen inhärente Latenz, da Daten über Netzwerke übertragen werden, was sie für Anwendungen mit unmittelbarem Reaktionsbedarf ungeeignet macht. Edge AI hingegen setzt auf Geschwindigkeit und Reaktionsfähigkeit durch die lokale Datenverarbeitung, ermöglicht Entscheidungsfindungen im Sub-Millisekundenbereich – entscheidend für autonome Systeme und Echtzeitüberwachung. Die Wahl zwischen diesen Ansätzen hängt von den Anforderungen ab: Cloud AI eignet sich für Batch-Verarbeitung, Modelltraining und Anwendungen, bei denen leichte Verzögerungen akzeptabel sind, während Edge AI für Echtzeitanwendungen, datenschutzsensible Vorgänge und Szenarien mit unzuverlässiger Netzwerkverbindung optimal ist. Organisationen setzen zunehmend auf hybride Architekturen, die beide Ansätze nutzen – Edge-Geräte für sofortige Verarbeitung und Cloud-Infrastruktur für Training, Analytik und langfristige Datenspeicherung. Das Verständnis dieser grundlegenden Unterschiede ermöglicht es, Lösungen zu konzipieren, die Leistung, Sicherheit und Betriebseffizienz ausbalancieren.

| Aspekt | Edge AI | Cloud AI |

|---|---|---|

| Latenz | Reaktionszeiten im Sub-Millisekundenbereich; unmittelbare lokale Verarbeitung | 50-500 ms+ durch Netzübertragung und Serververarbeitung |

| Bandbreite | Minimale Datenübertragung; Verarbeitung lokal | Hoher Bandbreitenbedarf; kontinuierliche Übertragung von Rohdaten |

| Sicherheit & Datenschutz | Daten bleiben lokal; geringere Gefahr von Datenlecks | Daten reisen über Netzwerke; zentrale Speicherung als Single Point of Failure |

| Rechenleistung | Durch Hardware des Geräts begrenzt; optimierte, leichte Modelle | Unbegrenzte Skalierbarkeit; Verarbeitung komplexer Modelle und großer Datenmengen |

| Skalierbarkeit | Horizontale Skalierung über verteilte Geräte | Vertikale Skalierung durch Server-Infrastruktur; zentrale Verwaltung |

Edge-AI-Systeme bestehen aus vier zentralen technischen Komponenten, die gemeinsam intelligente Verarbeitung am Netzwerk-Rand ermöglichen. Die Inference Engine führt vortrainierte Machine-Learning-Modelle auf Edge-Geräten aus und liefert Vorhersagen und Klassifikationen ohne Cloud-Anbindung. Diese Engines nutzen optimierte Frameworks wie TensorFlow Lite, ONNX Runtime und PyTorch Mobile, die Modelle für den begrenzten Gerätespeicher komprimieren und dennoch akzeptable Genauigkeit bieten. Hardware-Beschleuniger – darunter GPUs, TPUs und spezialisierte KI-Chips – ermöglichen die effiziente Ausführung neuronaler Netze auf ressourcenbeschränkten Geräten. Edge-Geräte setzen Modelloptimierungstechniken wie Quantisierung, Pruning und Wissensdistillation ein, um Modellgröße und Rechenbedarf zu reduzieren, ohne die Leistung wesentlich zu beeinträchtigen. Die Datenmanagement-Schicht übernimmt die lokale Datenerfassung, Vorverarbeitung und selektive Übertragung relevanter Erkenntnisse an Cloud-Systeme zur Aggregation und langfristigen Analyse. Schließlich verwaltet das Konnektivitätsmodul intermittierende Netzwerkverbindungen, sodass Geräte offline arbeiten und Daten synchronisieren können, sobald eine Verbindung verfügbar ist.

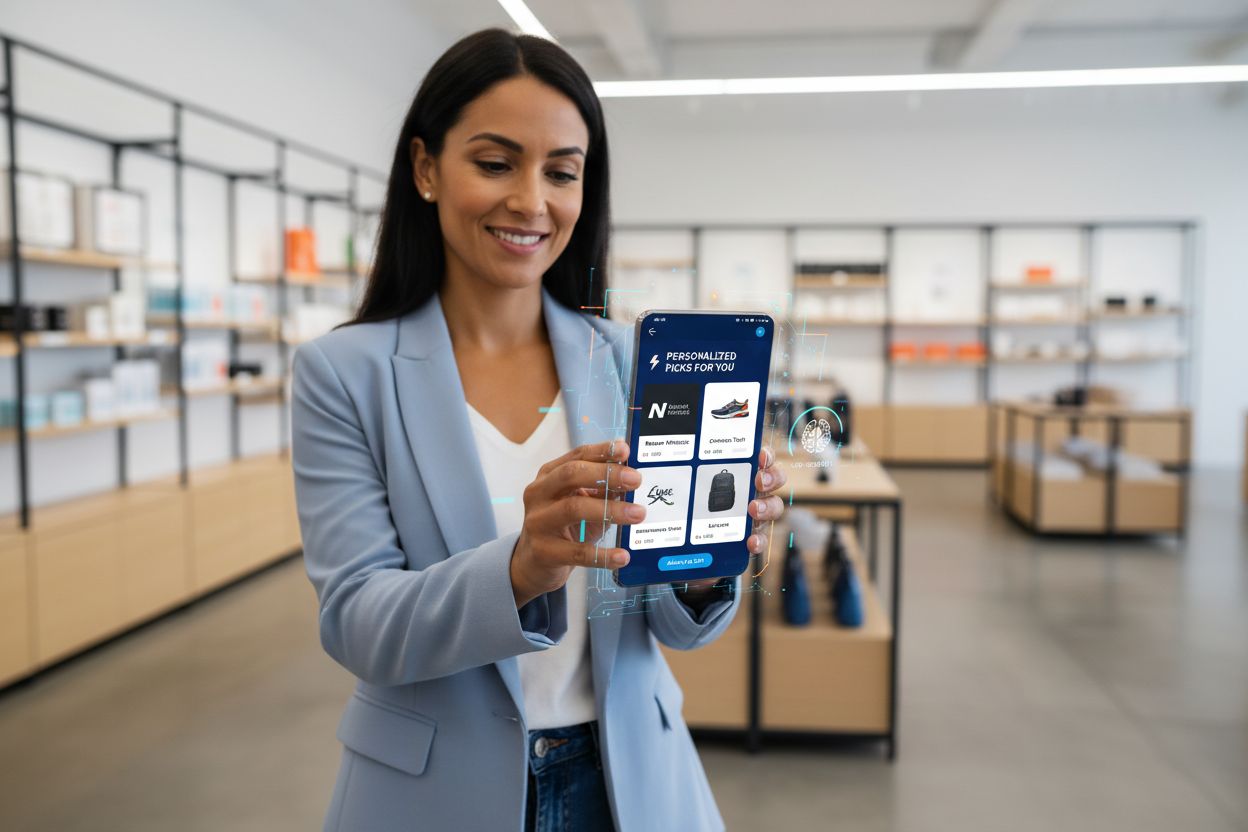

Edge AI Processing ermöglicht nie dagewesene Fähigkeiten bei Echtzeit-Markenempfehlungen und der Überwachung von KI-Ergebnissen und unterstützt Organisationen dabei, KI-Entscheidungen am Ausführungspunkt zu verfolgen und zu überprüfen. Einzelhandelsanwendungen nutzen Edge AI, um personalisierte Produktempfehlungen sofort beim Browsen zu liefern, indem Verhaltensmuster lokal analysiert werden, ohne sensible Einkaufsdaten an externe Server zu übertragen. Echtzeitüberwachung von KI-Ergebnissen wird möglich, wenn Inferenz auf Edge-Geräten erfolgt, sodass Organisationen Anomalien, verzerrte Vorhersagen oder Modell-Drift sofort erkennen, bevor Empfehlungen den Kunden erreichen. Diese lokale Verarbeitung schafft Prüfpfade und Entscheidungsprotokolle, die Compliance-Anforderungen unterstützen und Marken ermöglichen, exakt nachzuvollziehen, warum bestimmte Empfehlungen generiert wurden. Edge-AI-Monitoringsysteme können verdächtige Muster – wie Empfehlungen, die bestimmte Produkte oder Gruppen übermäßig bevorzugen – markieren und so schnelle Eingriffe und Modellanpassungen ermöglichen. Für Markensicherheit und Reputationsmanagement stellt die Überwachung auf Edge-Basis sicher, dass automatisierte Systeme innerhalb definierter Parameter arbeiten und mit Markenwerten übereinstimmen, bevor sie beim Kunden eingesetzt werden. Die Fähigkeit, KI-Ausgaben in Echtzeit am Rand zu überwachen, revolutioniert die Qualitätskontrolle von algorithmischen Entscheidungen, unterstützt Transparenzinitiativen und stärkt das Kundenvertrauen durch überprüfbare KI-Governance.

Edge AI Processing bietet erhebliche Vorteile in verschiedenen Bereichen, die zentrale Herausforderungen moderner digitaler Organisationen adressieren. Reduzierte Latenz ist der Hauptvorteil und ermöglicht Anwendungen mit unmittelbarem Reaktionsbedarf – etwa autonome Fahrzeuge bei der Navigation, Industrieroboter bei Sicherheitsgefahren oder medizinische Geräte bei der Erkennung kritischer Zustände. Verbesserter Datenschutz ist ein weiterer Vorteil, da sensible Daten auf lokalen Geräten verbleiben, statt über Netzwerke zu reisen oder in zentralisierter Cloud gespeichert zu werden – ein wichtiger Beitrag zur Einhaltung von DSGVO, HIPAA und anderen Vorgaben. Bandbreitenoptimierung reduziert Netzwerkauslastung und -kosten, da nur relevante Erkenntnisse statt Rohdaten übertragen werden. Offline-Funktionalität ermöglicht Edge-Geräten, auch bei Netzausfällen intelligent zu agieren – unverzichtbar für abgelegene Standorte und kritische Anwendungen. Zuverlässigkeit verbessert sich durch dezentrale Verarbeitung – Ausfälle einzelner Geräte wirken sich nicht auf das Gesamtsystem aus, und lokale Prozesse laufen unabhängig von Cloud-Diensten weiter. Kosteneffizienz entsteht durch geringere Cloud-Ausgaben, da Daten lokal verarbeitet werden und weniger Cloud-Infrastruktur benötigt wird. Skalierbarkeit zeigt sich anders als bei Cloud-Systemen: Edge AI skaliert horizontal über viele Geräte, ohne zentrale Infrastruktur erweitern zu müssen – ideal für IoT-Szenarien mit tausenden Devices.

Edge AI Processing revolutioniert Abläufe in unterschiedlichsten Branchen, indem intelligente Entscheidungen direkt am Entstehungspunkt der Daten möglich werden. Fertigungsbetriebe setzen Edge AI für Predictive Maintenance ein, analysieren Vibrationen und Temperaturmuster lokal, um Ausfälle frühzeitig zu erkennen und Stillstandszeiten zu reduzieren. Gesundheitsdienstleister nutzen Edge AI in bildgebenden Geräten für erste Analysen vor Ort, beschleunigen Diagnosen und schützen Patientendaten durch lokale Speicherung. Einzelhandelsumgebungen implementieren Edge AI für Bestandsmanagement, Analyse des Kundenverhaltens und sofortige, personalisierte Empfehlungen ohne Cloud-Latenz. Autonome Fahrzeuge sind vollständig auf Edge AI angewiesen, um Sensordaten aus Kameras, Lidar und Radar lokal auszuwerten und in Millisekunden Navigations- sowie Sicherheitsentscheidungen zu treffen. Smart-Home-Systeme nutzen Edge AI zur Spracherkennung, Bedrohungsdetektion und Automatisierung, ohne Audio- oder Videodaten in die Cloud zu senden. Sicherheits- und Überwachungsanwendungen setzen Edge AI ein, um Anomalien oder Bedrohungen lokal zu erkennen und Alarmierungen intelligent zu filtern, bevor sie an Leitstellen gesendet werden. Landwirtschaftliche Betriebe verwenden Edge AI auf IoT-Sensoren, um Bodenbedingungen, Wetter und Pflanzenzustand zu überwachen und Entscheidungen zur Bewässerung oder Düngung lokal zu treffen – bei minimalem Datenaufkommen, was gerade in ländlichen Gebieten mit schlechter Netzabdeckung wichtig ist.

Trotz der zahlreichen Vorteile steht Edge AI Processing vor erheblichen technischen und betrieblichen Herausforderungen, die bei der Implementierung beachtet werden müssen. Stromverbrauch ist ein zentrales Problem, da das Ausführen neuronaler Netze auf batteriebetriebenen Geräten viel Energie benötigt, den Einsatz limitiert und eine sorgfältige Modelloptimierung erfordert. Rechenbeschränkungen setzen der Komplexität der einsetzbaren Modelle Grenzen; Organisationen müssen zwischen vereinfachten, weniger genauen Modellen oder längeren Inferenzzeiten auf schwacher Hardware abwägen. Komplexität beim Modellmanagement steigt in verteilten Umgebungen erheblich, da Updates auf tausenden Edge-Geräten robuste Versionierung, Rollbacks und Konsistenzmechanismen erfordern. Datenheterogenität erschwert die Modellperformance, da Edge-Geräte in unterschiedlichsten Umgebungen mit variierenden Daten arbeiten und zentral trainierte Modelle lokal schlechter funktionieren können. Fehlerdiagnose und Monitoring sind durch die Verteilung komplex, was die Analyse von Ausfällen, das Verständnis des Modellverhaltens und die Messung der Performance erschwert. Sicherheitslücken auf Edge-Geräten vergrößern die Angriffsfläche, da kompromittierte Devices Schadcode ausführen oder Modelle manipulieren könnten – robuste Security und regelmäßige Updates sind daher unerlässlich. Integrationskomplexität mit bestehender Cloud-Infrastruktur erfordert durchdachte Architektur, damit Edge-Systeme effektiv mit zentralen Analytics- und Training-Pipelines kommunizieren.

Die Verbindung von Edge AI Processing und KI-Monitoring eröffnet Organisationen neue Möglichkeiten, algorithmische Entscheidungen im großen Maßstab zu überwachen. Klassische Monitoring-Ansätze stoßen bei Cloud-Systemen an Grenzen, da Latenz und Übertragungskosten die Sicht auf Echtzeitergebnisse einschränken; Edge-AI-Monitoring ermöglicht dagegen die lokale Analyse von Vorhersagen, bevor sie Kunden betreffen. Ausgabeverifikationssysteme auf Edge-Geräten können Vorhersagen sofort gegen Geschäftsregeln prüfen, Anomalien erkennen und Entscheidungen zur manuellen Überprüfung markieren, bevor sie ausgeführt werden. Dieser lokale Monitoring-Ansatz unterstützt Markensicherheitsinitiativen, indem sichergestellt wird, dass KI-Empfehlungen, Content-Entscheidungen und Kundeninteraktionen mit Werten und Compliance-Anforderungen der Organisation übereinstimmen. Edge-basierte Monitoringsysteme erzeugen detaillierte Prüfpfade, die dokumentieren, warum bestimmte Entscheidungen getroffen wurden, unterstützen Transparenz und erlauben nachträgliche Analysen des Algorithmusverhaltens. Bias-Detection-Mechanismen am Edge können erkennen, wenn Modelle unverhältnismäßige Ergebnisse für bestimmte Gruppen liefern, und ermöglichen so ein schnelles Eingreifen, bevor Vorurteile bei Kunden ankommen. Die Kombination von Edge AI und Monitoring schafft einen Feedback-Loop, in dem lokale Entscheidungsprotokolle das Modell-Training verbessern und so gewährleisten, dass Systeme sich kontinuierlich optimieren – bei gleichzeitiger Kontrolle ihres Verhaltens. Organisationen erhalten durch Edge-AI-Monitoring beispiellose Einblicke in algorithmische Entscheidungen und machen KI von einer Blackbox zu einem transparenten, prüfbaren System, das sowohl Performance als auch verantwortungsvolle Governance unterstützt.

Edge AI Processing steht an der Spitze des technologischen Wandels, wobei neue Trends die Bereitstellung und Verwaltung verteilter Intelligenz prägen. Federated Learning stellt einen wegweisenden Ansatz dar, bei dem Edge-Geräte Modelle gemeinsam trainieren, ohne Rohdaten an zentrale Server zu senden – das ermöglicht datenschutzfreundliches Machine Learning im großen Stil. 5G-Netzausbau wird die Edge-AI-Adoption erheblich beschleunigen, da zuverlässige, latenzarme Konnektivität die nahtlose Synchronisation zwischen Edge-Geräten und Cloud bei gleichzeitigen Vorteilen der lokalen Verarbeitung ermöglicht. Spezialisierte Hardware-Entwicklung schreitet stetig voran: Hersteller entwickeln immer effizientere KI-Chips für Edge-Anwendungen, was die Leistung pro Watt insbesondere bei batteriebetriebenen Geräten verbessert. Prognosen erwarten ein explosives Wachstum – der weltweite Edge-AI-Markt soll bis 2030 auf 15,7 Milliarden US-Dollar steigen, mit einer jährlichen Wachstumsrate von 38,3 % (2023–2030). TinyML (Machine Learning auf Mikrocontrollern) ist ein bedeutender Trend: KI wird auf Geräten mit minimalem Speicher und Rechenleistung möglich, sodass Edge-AI-Anwendungen völlig neue Einsatzgebiete erschließen. Containerisierung und Orchestrierung (z. B. Kubernetes) passen sich Edge-Umgebungen an und ermöglichen die Verwaltung verteilter Deployments mit den bekannten Cloud-Tools. Das Zusammenspiel dieser Trends deutet auf eine Zukunft hin, in der intelligente Verarbeitung nahtlos über verteilte Netzwerke erfolgt – Edge-Geräte treffen Echtzeitentscheidungen, während Cloud-Systeme Training, Aggregation und langfristige Analysen bieten.

Eine erfolgreiche Einführung von Edge AI Processing erfordert sorgfältige Planung in mehreren Dimensionen, um erwartete Performance und geschäftlichen Nutzen zu gewährleisten. Modellauswahl ist die erste kritische Entscheidung: Organisationen müssen verfügbare vortrainierte Modelle auf ihre Genauigkeit für die Zielanwendung prüfen und entscheiden, ob eigene Modellentwicklung nötig ist. Optimierungsstrategien müssen Genauigkeit und Gerätebeschränkungen ausbalancieren – Quantisierung, Pruning und Architektur-Suche helfen, Modelle für die Hardware zu optimieren. Hardwareauswahl richtet sich nach Anwendung, Rechenbedarf und Energieverbrauch; Optionen reichen von Standardprozessoren bis zu spezialisierten KI-Beschleunigern. Deployment-Mechanismen erfordern robuste Prozesse für die Modellverteilung auf Edge-Geräten, Versionierung und Rollback bei Problemen. Monitoring und Observability müssen die Modellleistung überwachen, Daten-Drift erkennen, Anomalien identifizieren und bei Abweichungen alarmieren. Security-Hardening schützt Edge-Geräte gegen unbefugten Zugriff, Modell-Diebstahl und Manipulation mittels Verschlüsselung, Authentifizierung und regelmäßigen Updates. Integrationsplanung stellt sicher, dass Edge-Systeme effektiv mit der Cloud für Updates, Analytik und Langzeitspeicherung kommunizieren, und schafft so hybride Architekturen, die die Vorteile beider Ansätze nutzen. Organisationen sollten klare Erfolgskriterien definieren, Pilotprojekte im kleinen Maßstab starten und flexibel auf reale Performance-Daten reagieren.

Edge AI verarbeitet Daten lokal auf Geräten mit unmittelbaren Reaktionszeiten (Latenz im Sub-Millisekundenbereich), während Cloud AI Daten zur Verarbeitung an entfernte Server sendet, was Netzwerkverzögerungen verursacht. Edge AI legt Wert auf Geschwindigkeit und Datenschutz, während Cloud AI unbegrenzte Rechenleistung für komplexe Aufgaben bietet.

Edge AI hält sensible Daten auf lokalen Geräten, anstatt sie über Netzwerke zu übertragen oder in zentralisierten Cloud-Servern zu speichern. Dieser Ansatz reduziert die Gefahr von Datenverletzungen, unterstützt die Einhaltung von DSGVO und HIPAA und stellt sicher, dass persönliche Informationen unter der Kontrolle der Organisation bleiben.

Edge AI erreicht Reaktionszeiten im Sub-Millisekundenbereich, indem Daten lokal verarbeitet werden, im Vergleich zu 50-500 ms oder mehr bei cloudbasierten Systemen. Diese drastische Latenzreduzierung ermöglicht Echtzeitanwendungen wie autonome Fahrzeuge, Industrieroboter und medizinische Geräte, die sofortige Entscheidungen erfordern.

Ja, Edge-AI-Systeme können vollständig offline arbeiten, da die Verarbeitung lokal auf den Geräten erfolgt. Diese Offline-Funktionalität ist entscheidend für abgelegene Standorte mit unzuverlässiger Verbindung und für kritische Anwendungen, bei denen Netzwerkausfälle den Betrieb nicht unterbrechen dürfen.

Edge AI läuft auf verschiedensten Geräten, darunter Smartphones, IoT-Sensoren, Industrieanlagen, Sicherheitskameras, Smartwatches, autonome Fahrzeuge und eingebettete Systeme. Moderne Edge-Geräte reichen von Mikrocontrollern mit minimalen Ressourcen bis hin zu leistungsstarken Einplatinencomputern mit speziellen KI-Beschleunigern.

Edge AI verarbeitet Daten lokal und überträgt nur relevante Erkenntnisse statt Rohdatenströmen. Diese selektive Übertragung reduziert den Bandbreitenverbrauch drastisch, senkt Netzwerkkosten und verbessert die Systemleistung durch Minimierung des Datentransfers über Netzwerke.

Edge AI ermöglicht die Echtzeitüberwachung von KI-generierten Empfehlungen und Entscheidungen am Ort der Ausführung, sodass Organisationen sofort Anomalien erkennen, Markensicherheit überprüfen und sicherstellen können, dass algorithmische Ergebnisse mit den Unternehmenswerten übereinstimmen, bevor sie zum Kunden gelangen.

Wichtige Herausforderungen sind der Stromverbrauch bei batteriebetriebenen Geräten, rechnerische Einschränkungen, die eine Modelloptimierung erfordern, die Komplexität beim Management verteilter Systeme, Sicherheitslücken auf Edge-Geräten und Integrationsprobleme mit bestehender Cloud-Infrastruktur.

Edge AI Processing ermöglicht die sofortige Analyse von KI-Ergebnissen und Markenzitaten. AmICited verfolgt in Echtzeit, wie Ihre Marke in KI-generierten Inhalten über GPTs, Perplexity und Google AI Overviews erscheint.

Edge SEO ist die Praxis, technische SEO-Änderungen am Netzwerkrand mit serverlosen Funktionen auf CDNs zu implementieren. Erfahren Sie, wie dadurch die Leistung...

Erfahren Sie, wie RAG LLMs mit externen Datenquellen kombiniert, um präzise KI-Antworten zu generieren. Verstehen Sie den fünfstufigen Prozess, die Komponenten ...

Erfahren Sie, welche Inhalte Sie für KI-Sichtbarkeit priorisieren sollten. Entdecken Sie, wie Sie für KI-Suchmaschinen optimieren, Zitierquoten steigern und sic...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.