Definition von Google Gemini

Google Gemini ist eine Familie multimodaler Large Language Models (LLMs), die von Google DeepMind entwickelt wurde und den Nachfolger früherer Modelle wie LaMDA und PaLM 2 darstellt. Im Gegensatz zu klassischen Sprachmodellen, die nur Text verarbeiten, ist Gemini grundlegend darauf ausgelegt, mehrere Datenmodalitäten gleichzeitig zu verarbeiten – darunter Text, Bilder, Audio, Video und Software-Code. Das Modell treibt den Gemini-AI-Chatbot (ehemals Bard) an und wird zunehmend in das Produkt- und Service-Ökosystem von Google integriert. Die multimodale Architektur von Gemini ermöglicht es, komplexe Zusammenhänge zwischen unterschiedlichen Informationsarten zu verstehen, wodurch Aufgaben von der Bildanalyse und Code-Generierung bis hin zu Echtzeitübersetzungen und Dokumentenverständnis möglich werden. Der Begriff „Gemini“ stammt aus dem Lateinischen und bedeutet „Zwillinge“ – ein Verweis auf die Zusammenarbeit zwischen Google DeepMind und Google Brain sowie eine Anlehnung an das Gemini-Raumfahrtprogramm der NASA.

Historischer Kontext und Entwicklung

Googles Weg zur Entwicklung von Gemini spiegelt jahrelange Grundlagenforschung zu großen Sprachmodellen und neuronaler Netzwerkarchitektur wider. 2017 führten Google-Forscher:innen die Transformer-Architektur ein – ein bahnbrechendes neuronales Netzwerkdesign, das zur Grundlage moderner LLMs wurde. Es folgte Meena (2020), eine konversationelle KI mit 2,6 Milliarden Parametern, und LaMDA (Language Model for Dialogue Applications, 2021), spezialisiert auf Dialogaufgaben. Die Veröffentlichung von PaLM (Pathways Language Model, 2022) brachte verbesserte Coding-, Multilingual- und Reasoning-Fähigkeiten. Anfang 2023 startete Google Bard, zunächst mit einer leichten LaMDA-Variante, später mit PaLM 2. Im Dezember 2023 wurde Gemini 1.0 offiziell vorgestellt – ein großer Sprung in den multimodalen Fähigkeiten. 2024 erfolgte das Rebranding von Bard zu Gemini sowie die Veröffentlichung von Gemini 1.5 mit revolutionärem 2-Millionen-Token-Kontextfenster. Zuletzt führten Gemini 2.0 und 2.5 (Dezember 2024) agentische KI-Funktionen ein, wodurch das Modell eigenständig handeln und über längere Kontexte hinweg argumentieren kann. Diese Entwicklung zeigt Googles Engagement, KI-Fähigkeiten praxisnah und anwendungsorientiert voranzutreiben.

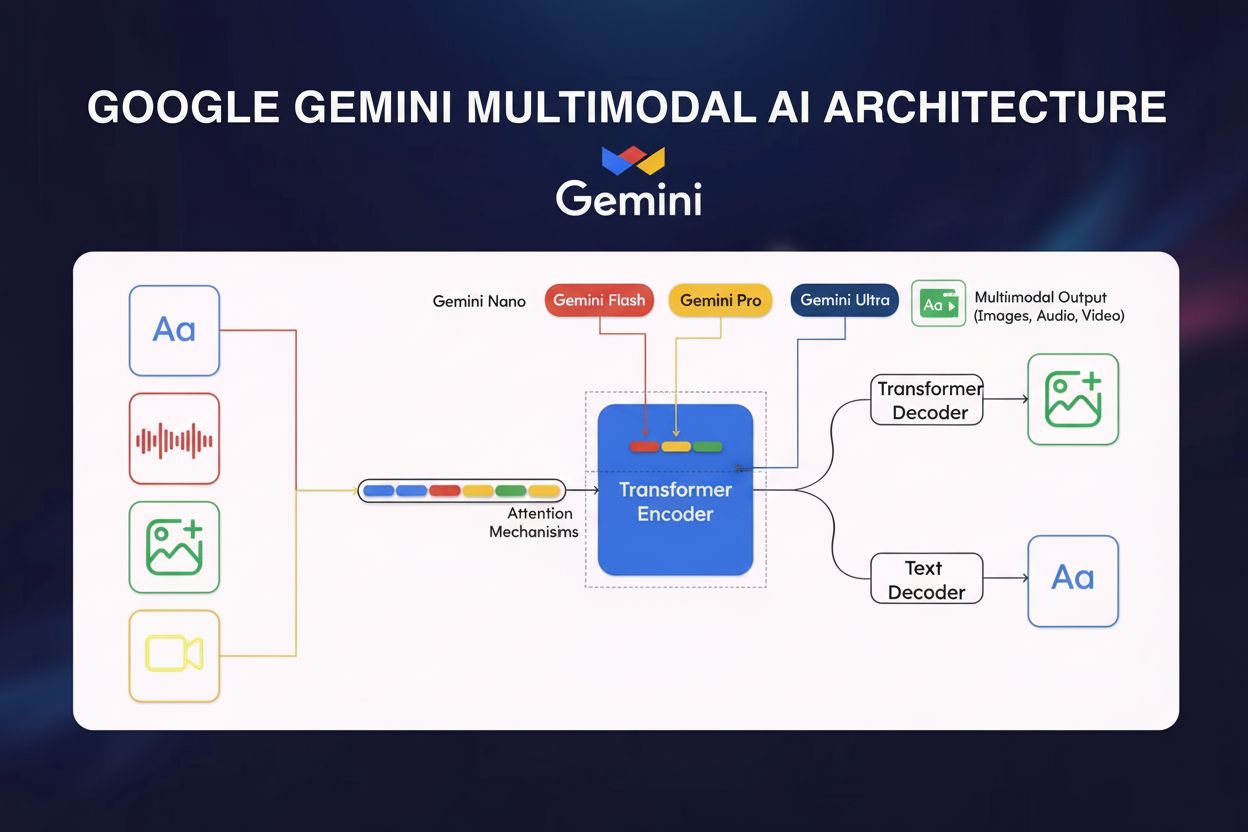

Technische Architektur und Kernkomponenten

Die technische Basis von Google Gemini beruht auf mehreren fortgeschrittenen architektonischen Innovationen, die es von anderen Modellen abheben. Im Zentrum steht eine Transformer-basierte neuronale Netzwerkarchitektur, optimiert durch Cloud TPU v5p (Tensor Processing Units) für Hochleistungs-Training und -Inference. Der Multimodal-Encoder des Modells integriert visuelle Daten, Sprache und Text über spezialisierte Verarbeitungspfade, die in einen einheitlichen Repräsentationsraum zusammenlaufen. Eine Schlüsselinnovation ist der Cross-Modal-Attention-Mechanismus, der es ermöglicht, bedeutungsvolle Verbindungen zwischen Datentypen herzustellen – etwa indem visuelle Elemente mit Textbeschreibungen verknüpft oder Audioinhalte im Kontext von Bildern verstanden werden. Gemini 1.5 Pro führte die Mixture-of-Experts-(MoE)-Architektur ein, einen Paradigmenwechsel in Sachen Effizienz: Statt bei jedem Input alle Parameter zu aktivieren, teilt MoE das Modell in spezialisierte Expert:innen-Netzwerke, die auf bestimmte Domänen oder Datentypen fokussiert sind. Das Modell lernt, je nach Eingabe nur relevante Expert:innen zu aktivieren, was die Rechenlast deutlich senkt und die Leistung erhält oder verbessert. So erreicht Gemini 1.5 Flash vergleichbare Ergebnisse wie Gemini 1.0 Ultra, ist dabei aber durch Knowledge Distillation – die Wissensübertragung vom großen Pro-Modell auf das kompakte Flash-Modell – wesentlich effizienter. Das Kontextfenster, also die Zahl der Tokens, die ein Modell gleichzeitig verarbeiten kann, wurde massiv erweitert: von 32.000 Tokens bei Gemini 1.0 auf 1 Million bei Gemini 1.5 Flash und 2 Millionen bei Gemini 1.5 Pro – so lassen sich ganze Bücher, lange Videos oder tausende Zeilen Code in einer einzigen Interaktion analysieren.

Gemini-Modellvarianten und ihre Anwendungen

| Modellvariante | Größe/Stufe | Kontextfenster | Hauptanwendungen | Einsatz | Schlüsselvorteil |

|---|

| Gemini 1.0 Nano | Kleinste | 32.000 Tokens | Mobile Aufgaben, On-Device-Verarbeitung, Bildbeschreibung, Chat-Antworten | Android-Geräte (Pixel 8 Pro+), Chrome Desktop | Funktioniert ohne Internetverbindung |

| Gemini 1.0 Ultra | Größte | 32.000 Tokens | Komplexes Reasoning, fortgeschrittenes Coding, mathematische Analyse, multimodales Reasoning | Cloud-basiert, Enterprise | Höchste Genauigkeit in Benchmarks |

| Gemini 1.5 Pro | Mittlere Größe | 2 Millionen Tokens | Dokumentenanalyse, Code-Repositories, Long-Form-Inhalte, Unternehmensanwendungen | Google Cloud, API | Längstes Kontextfenster, ausgewogene Performance |

| Gemini 1.5 Flash | Leichtgewicht | 1 Million Tokens | Schnelle Antworten, kosteneffiziente Verarbeitung, Echtzeitanwendungen | Cloud, Mobile, Edge | Geschwindigkeit und Effizienzoptimierung |

| Gemini 2.0/2.5 | Next-Gen | Variabel | Agentische KI, autonome Aufgabenbearbeitung, fortgeschrittenes Reasoning, Echtzeitinteraktion | Cloud, integrierte Dienste | Agentische Fähigkeiten, verbessertes Reasoning |

Multimodale Verarbeitung und Cross-Modal-Verständnis

Die multimodale Natur von Google Gemini markiert einen grundlegenden Wandel gegenüber früheren KI-Modellen, die meist nur eine Modalität verarbeiteten. Geminis Fähigkeit, verschachtelte Sequenzen aus Audio, Bild, Text und Video sowohl als Eingaben wie als Ausgaben zu nutzen, ermöglicht anspruchsvolle Reasoning-Aufgaben, die für Single-Mode-Modelle unmöglich wären. So kann Gemini beispielsweise ein Video analysieren, relevanten Text aus Frames extrahieren, gesprochene Dialoge verstehen und umfassende Zusammenfassungen über alle Modalitäten hinweg generieren. Das hat große Auswirkungen auf die Praxis: In der medizinischen Diagnostik kann Gemini Patientenakten (Text), medizinische Bilder (visuell) und Interviews (Audio) gleichzeitig auswerten. Im Kundenservice verarbeitet es Anfragen (Text), Produktbilder, Videodemonstrationen und erstellt kontextgerechte Antworten. Der Cross-Modal-Attention-Mechanismus schafft dazu gemeinsame Repräsentationen, in denen sich Informationen gegenseitig beeinflussen: Beim Analysieren eines Bildes mit Begleittext hilft der Text, den Fokus im Bild zu setzen, während visuelle Daten die Textinterpretation verfeinern. Diese Wechselwirkung führt zu einem umfassenderen Verständnis als bei getrennter Verarbeitung der Modalitäten. Für KI-Monitoring und Marken-Tracking ist das besonders relevant: Wenn Gemini Antworten gibt, die Bilder, Text und Audio enthalten, müssen Monitoring-Systeme Marken über alle Modalitäten hinweg nachverfolgen – nicht nur in Textausgaben.

Leistungsbenchmarks und Wettbewerbspositionierung

Google Gemini Ultra hat in zahlreichen standardisierten KI-Benchmarks außergewöhnliche Leistungen gezeigt und sich als sehr leistungsfähiges Modell im Wettbewerb der LLMs etabliert. Im MMLU-Benchmark (Massive Multitask Language Understanding) übertraf Gemini Ultra sogar menschliche Expert:innen – ein bedeutender Meilenstein in der KI-Entwicklung. Für mathematisches Reasoning (GSM8K-Benchmark) überbot Gemini Ultra Konkurrenten wie Claude 2, GPT-4 und Llama 2. In der Code-Generierung (HumanEval-Benchmark) bewies Gemini fortschrittliche Programmierunterstützung und Code-Analyse-Fähigkeiten. Die Performance variiert jedoch je nach Messkriterium: Während Gemini Ultra in Dokumenten- und Bildverständnis sowie automatischer Spracherkennung führend ist, erzielt es bei Common-Sense-Reasoning (HellaSwag-Benchmark) noch moderate Verbesserungen – hier bleibt GPT-4 vorn. Die Gemini 1.5-Serie überzeugt besonders: Sowohl Flash als auch Pro erreichen oder übertreffen Gemini 1.0 Ultra, bieten aber viel höhere Effizienz und größere Kontextfenster. Diese Entwicklung ist für das KI-Zitationsmonitoring relevant: Mit wachsender Nutzerzahl (350 Millionen monatlich aktiv) beeinflussen Genauigkeit und Vollständigkeit der Gemini-Antworten direkt, wie Marken und Domains in KI-Inhalten dargestellt werden. Über Plattformen wie AmICited können Unternehmen überprüfen, ob Gemini-Antworten zur eigenen Marke korrekt und angemessen kontextualisiert sind.

Integration im Google-Ökosystem

Die strategische Integration von Google Gemini im gesamten Google-Produktportfolio ist eine der umfassendsten KI-Einbettungen eines Tech-Unternehmens. Gemini ist nun der Standard-KI-Assistent auf Google Pixel 9 und Pixel 9 Pro und ersetzt den bisherigen Google Assistant – der primäre KI-Zugangspunkt für Millionen Nutzer:innen. In Google Workspace hilft Gemini in der Docs-Seitenleiste beim Schreiben und Bearbeiten, unterstützt in Gmail beim Verfassen und Vorschlagen von Nachrichten und ist in weiteren Produktivitätsanwendungen präsent. Google Maps nutzt Gemini, um intelligente Zusammenfassungen von Orten und Regionen zu erstellen. Die Google-Suche hat Gemini über AI Overviews integriert, die umfassende Antworten aus mehreren Quellen generieren. Die Gemini-API ist über Google AI Studio und Google Cloud Vertex AI verfügbar und ermöglicht Entwickler:innen, Gemini in eigene Anwendungen zu integrieren. Diese Integration hat große Auswirkungen auf das Markenmonitoring und KI-Zitations-Tracking: Sucht jemand nach einem Unternehmen in Google Search, generiert Gemini eine KI-Übersicht, in der die Marke genannt werden kann – oder eben nicht. Nutzt jemand Gmail mit Gemini, kann das Modell Unternehmensinfos in Vorschlägen referenzieren. Entwickler:innen schaffen mit der Gemini-API neue Touchpoints, an denen Marken in KI-Inhalten erscheinen. Diese weite Integration macht umfassendes Monitoring aller Plattformen essenziell, um Markenintegrität und korrekte Darstellung in KI-Antworten sicherzustellen.

Zentrale Fähigkeiten und Anwendungsfälle

- Fortschrittliche Code-Generierung und -Analyse: Gemini versteht, erklärt und generiert Code in mehreren Programmiersprachen (C++, Java, Python usw.), maßgeschneiderte Versionen treiben AlphaCode2 zur Lösung von Programmierwettbewerben an

- Bild- und Textverständnis: Extrahiert Text aus Bildern ohne OCR, beschreibt Bilder, analysiert Diagramme und führt komplexe visuelle Reasoning-Aufgaben aus

- Mehrsprachige Übersetzungen: Nutzt multimodale Fähigkeiten für Echtzeitübersetzungen, integriert in Google Meet mit übersetzten Untertiteln

- Malware-Analyse: Sowohl Gemini 1.5 Pro als auch Flash analysieren Code-Snippets und Dateien auf Schadhaftigkeit und erstellen Sicherheitsberichte

- Personalisierte KI-Expert:innen (Gems): Erstellen individueller KI-Assistenten für spezielle Aufgaben oder Themen, mit Vorlagen wie Lerncoach, Brainstorming-Partner oder Schreibeditor

- Universelle KI-Agent:innen: Über Project Astra verarbeitet Gemini multimodale Informationen in Echtzeit und ermöglicht KI-Assistenten, die Objekte erklären, Orte erkennen und sich an Interaktionen erinnern

- Sprachunterhaltungen: Gemini Live ermöglicht natürliche, anpassbare Dialoge, die auf individuelle Sprechweisen und Vorlieben reagieren

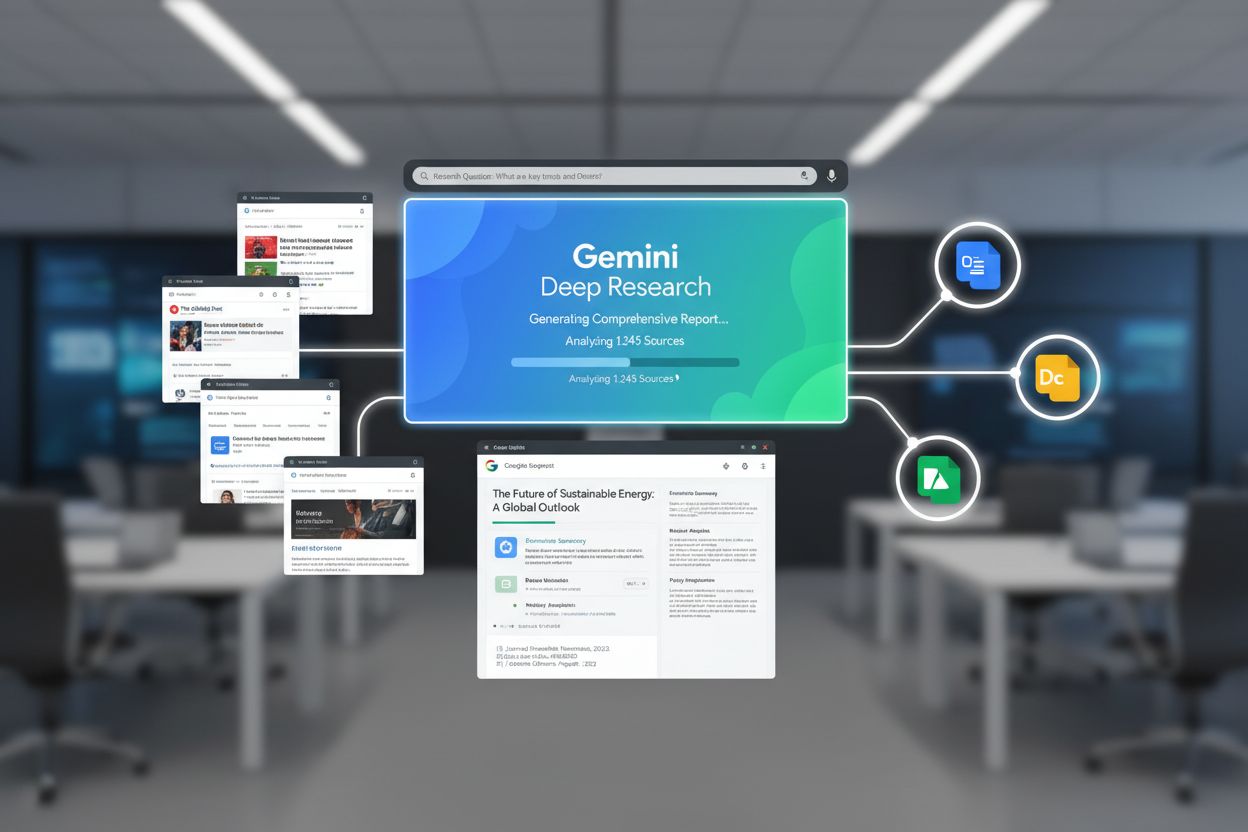

- Tiefgehende Recherche: Analysiert hunderte Websites, fasst Erkenntnisse zusammen und erstellt umfassende Berichte zu komplexen Themen

Geminis Rolle im KI-Monitoring und Markenbild

Mit dem Aufstieg von Google Gemini zur bedeutenden KI-Plattform mit 350 Millionen monatlich aktiven Nutzer:innen entsteht neuer Handlungsbedarf für Markenmonitoring und KI-Zitations-Tracking. Anders als klassische Suchmaschinen, bei denen Marken in Listen erscheinen, generiert Gemini synthetisierte Antworten, in denen Unternehmen, Produkte oder Domains genannt werden können – oder auch nicht. Fragt ein:e Nutzer:in Gemini nach einer Branche oder einem Thema, entscheidet das Modell, welche Quellen referenziert und wie Marken erwähnt und kontextualisiert werden. Dies ist ein fundamentaler Wandel gegenüber klassischem SEO: Sichtbarkeit ergibt sich nicht mehr aus Rankings, sondern durch gezielte „KI-Zitationsoptimierung“ – also die Sicherstellung, dass Marken korrekt und angemessen in KI-Antworten erscheinen. Geminis multimodale Natur erschwert das Monitoring: Marken tauchen nicht nur in Text, sondern auch in Bildern, Audiotranskripten oder Videoverweisen auf. Durch die Integration in viele Google-Produkte können Markenerwähnungen an unterschiedlichsten Touchpoints erfolgen: in Google Search AI Overviews, Gmail-Vorschlägen, Maps-Zusammenfassungen oder Anwendungen auf Basis der Gemini-API. Unternehmen müssen nachvollziehen, wie Gemini ihre Marke in diesen Kontexten darstellt und ob die Informationen akkurat und angemessen sind. Plattformen wie AmICited schaffen hier Abhilfe, indem sie Markenerwähnungen in Gemini-Antworten und weiteren großen KI-Plattformen wie ChatGPT, Perplexity, Claude und Google AI Overviews überwachen und so umfassende Sichtbarkeit ermöglichen.

Risiken, Einschränkungen und ethische Aspekte

Trotz ihrer beeindruckenden Fähigkeiten ist Google Gemini mit mehreren dokumentierten Herausforderungen konfrontiert, die beim Einsatz zu berücksichtigen sind. KI-Bias zeigte sich deutlich im Februar 2024, als Google die Bildgenerierung pausierte, weil das Modell historische Persönlichkeiten ungenau und voreingenommen darstellte – oft unter Ausblendung historischer Kontexte. Das verdeutlicht, wie multimodale KI-Systeme vorhandene Trainingsdaten-Bias verstärken oder reproduzieren können. Halluzinationen – also faktisch falsche Ausgaben – betreffen Gemini weiterhin, besonders in AI Overviews, bei denen Nutzer:innen synthetisierten Informationen oft ohne Prüfung vertrauen. Google räumt selbst ein, dass Gemini-gestützte Suchergebnisse gelegentlich Fehl- oder Desinformationen liefern. Urheberrechtsverletzungen sind ein weiteres Problem: Google wurde in Frankreich mit 250 Millionen Euro Strafe belegt, weil Gemini mit urheberrechtlich geschützten Nachrichteninhalten ohne Wissen oder Zustimmung der Verlage trainiert wurde. Diese Einschränkungen wirken sich direkt auf das Markenmonitoring aus: Unternehmen können nicht davon ausgehen, dass Gemini-Informationen zu Wettbewerbern oder Branchenthemen korrekt sind, und müssen prüfen, wie die eigene Marke dargestellt wird. Die Gefahr, dass Gemini Fehlinformationen zu Produkten, Geschichte oder Marktstellung generiert, macht Monitoring über klassische Suchmaschinen hinaus erforderlich. Zudem kann das Modell Informationen aus mehreren Quellen zusammenfügen, ohne immer klar zuzuordnen, woher die Aussagen stammen – Markenerwähnungen in Gemini-Antworten können somit Kontext oder Quellenangabe fehlen.

Zukünftige Entwicklung und strategischer Ausblick

Der Entwicklungspfad von Google Gemini lässt einen weiteren Ausbau der Fähigkeiten, Effizienz und Integration im Google-Ökosystem und darüber hinaus erwarten. Gemini 2.0 und 2.5 brachten agentische KI-Funktionen: Das Modell kann eigenständig agieren, mehrschrittige Aufgaben planen und über längere Kontexte hinweg argumentieren – ein großer Sprung von der reinen Beantwortung von Nutzeranfragen. Künftige Versionen werden das Reasoning weiter verbessern, noch größere Kontexte verarbeiten und auf Spezialaufgaben optimiert werden. Project Astra – Googles Initiative zu universellen KI-Agent:innen – gibt die langfristige Richtung vor: KI-Systeme, die multimodale Informationen in Echtzeit verarbeiten, erinnern und verstehen und so natürlichere Interaktionen ermöglichen. Projekte wie Project Mariner zeigen, dass Google auch die Unterstützung komplexer Wissensarbeit durch Gemini erforscht, etwa automatisierte Recherche, Analysen und Entscheidungsfindung. Die Integration in immer mehr Google-Produkte wird zunehmen und die Zahl der Touchpoints für Markenerwähnungen in KI-Inhalten weiter erhöhen. Verbesserte On-Device-Effizienz macht Gemini künftig für mobile Geräte und Edge-Computing breiter verfügbar und steigert die Nutzerbasis über die derzeitigen 350 Millionen hinaus. Auch die Konkurrenz beeinflusst die Entwicklung: Während Plattformen wie ChatGPT, Claude und Perplexity weiter voranschreiten, muss Google Geminis Vorsprung in Multimodalität, Integration und Echtzeit-Wissenszugang sichern. Für Unternehmen im KI-Monitoring und Markenmanagement wird das Tracking von Markenerwähnungen in Gemini umso wichtiger, je leistungsfähiger und verbreiteter die Plattform wird. Die Entwicklung hin zu agentischer KI wirft zudem neue Fragen auf, wie autonome Systeme Marken referenzieren und Entscheidungen in ihrem Namen treffen.

Fazit: Geminis Einfluss auf KI-basiertes Markenmonitoring

Google Gemini steht für einen grundlegenden Wandel in der Informationsverarbeitung und Antwortgenerierung durch KI – mit weitreichenden Auswirkungen auf Markenmonitoring und KI-Zitations-Tracking. Als multimodales KI-Modell mit 350 Millionen monatlich aktiven Nutzer:innen, nahtlos im Google-Ökosystem integriert und mit stetig wachsender agentischer Intelligenz, ist Gemini für Unternehmen zu einer zentralen Plattform geworden. Im Unterschied zu klassischen Suchmaschinen, wo die Sichtbarkeit von Rankings abhängt, entstehen durch Geminis synthetisierte Antworten neue Dynamiken: Marken werden erwähnt – oder nicht –, und wenn doch, dann im besten Fall korrekt. Die dokumentierten Einschränkungen des Modells – darunter Bias, Halluzinationen und Urheberrechtsprobleme – unterstreichen die Notwendigkeit aktiven Monitorings statt blindem Vertrauen in KI-Antworten. Unternehmen, die Markenintegrität und korrekte Darstellung in KI-Inhalten sichern wollen, brauchen umfassende Strategien, die Markenerwähnungen in Gemini und anderen führenden KI-Plattformen nachverfolgen. Damit beginnt eine neue Ära im digitalen Marketing und Markenmanagement, in der der Erfolg nicht mehr nur von klassischem SEO und Suchsichtbarkeit abhängt, sondern davon, wie KI-Systeme Marken in ihren Antworten darstellen und referenzieren.