AI-Index-Abdeckung

Erfahren Sie, was KI-Index-Abdeckung ist und warum sie für die Sichtbarkeit Ihrer Marke in ChatGPT, Google AI Overviews und Perplexity wichtig ist. Entdecken Si...

Indexabdeckung bezieht sich auf den Prozentsatz und Status der Webseiten, die von Suchmaschinen entdeckt, gecrawlt und in den Index aufgenommen wurden. Sie misst, welche Seiten in den Suchergebnissen erscheinen können und identifiziert technische Probleme, die eine Indexierung verhindern.

Indexabdeckung bezieht sich auf den Prozentsatz und Status der Webseiten, die von Suchmaschinen entdeckt, gecrawlt und in den Index aufgenommen wurden. Sie misst, welche Seiten in den Suchergebnissen erscheinen können und identifiziert technische Probleme, die eine Indexierung verhindern.

Indexabdeckung misst, wie viele Seiten Ihrer Website von Suchmaschinen entdeckt, gecrawlt und in den Index aufgenommen wurden. Sie gibt den Prozentsatz der Seiten Ihrer Website an, die in den Suchergebnissen erscheinen können, und zeigt auf, welche Seiten technische Probleme haben, die eine Indexierung verhindern. Im Kern beantwortet die Indexabdeckung die entscheidende Frage: „Wie viel von meiner Website können Suchmaschinen tatsächlich finden und bewerten?“ Diese Kennzahl ist grundlegend für das Verständnis der Sichtbarkeit Ihrer Website in Suchmaschinen und wird über Tools wie die Google Search Console überwacht, die detaillierte Berichte zu indexierten Seiten, ausgeschlossenen Seiten und Seiten mit Fehlern liefert. Ohne eine ordnungsgemäße Indexabdeckung bleibt selbst der bestoptimierte Inhalt für Suchmaschinen und Nutzer unsichtbar.

Indexabdeckung bedeutet nicht bloß Quantität – es geht darum, dass die richtigen Seiten indexiert werden. Eine Website kann Tausende von Seiten haben, aber wenn viele davon Duplikate, dünner Content oder durch robots.txt blockiert sind, kann die tatsächliche Indexabdeckung deutlich geringer ausfallen als erwartet. Dieser Unterschied zwischen Gesamtseiten und indexierten Seiten ist entscheidend für die Entwicklung einer effektiven SEO-Strategie. Organisationen, die die Indexabdeckung regelmäßig überwachen, können technische Probleme frühzeitig erkennen und beheben, bevor sie den organischen Traffic beeinträchtigen – und machen die Indexabdeckung so zu einer der wichtigsten Metriken im technischen SEO.

Das Konzept der Indexabdeckung entstand, als sich Suchmaschinen von einfachen Crawlern zu komplexen Systemen entwickelten, die täglich Millionen von Seiten verarbeiten können. In den Anfangstagen der SEO hatten Webmaster nur begrenzte Einblicke, wie Suchmaschinen mit ihren Seiten interagierten. Die Google Search Console, ursprünglich 2006 als Google Webmaster Tools eingeführt, brachte hier Transparenz, indem sie direktes Feedback zum Crawling- und Indexierungsstatus lieferte. Der Index Coverage Report (früher „Page Indexing“-Bericht) wurde zum Hauptinstrument, um zu verstehen, welche Seiten von Google indexiert wurden und warum andere ausgeschlossen sind.

Mit der steigenden Komplexität von Websites – durch dynamische Inhalte, Parameter und doppelte Seiten – wurden Indexabdeckungsprobleme immer häufiger. Studien zeigen, dass etwa 40-60 % der Websites erhebliche Indexabdeckungsprobleme haben und viele Seiten unentdeckt oder absichtlich vom Index ausgeschlossen bleiben. Der Aufstieg von JavaScript-lastigen Webseiten und Single-Page-Applications erschwerte die Indexierung zusätzlich, da Suchmaschinen Inhalte rendern müssen, bevor sie die Indexierbarkeit bestimmen können. Heute gilt die Überwachung der Indexabdeckung als essenziell für alle Organisationen, die auf organischen Such-Traffic angewiesen sind – und Branchenexperten empfehlen mindestens monatliche Audits.

Die Beziehung zwischen Indexabdeckung und Crawl-Budget ist besonders bei großen Websites wichtig. Das Crawl-Budget bezeichnet die Anzahl der Seiten, die Googlebot in einem bestimmten Zeitraum auf Ihrer Website crawlt. Große Websites mit schlechter Seitenarchitektur oder übermäßig vielen Duplikaten verschwenden das Crawl-Budget an wenig wertvolle Seiten, wodurch wichtige Inhalte unentdeckt bleiben. Studien zeigen, dass über 78 % der Unternehmen Content-Monitoring-Tools nutzen, um ihre Sichtbarkeit in Suchmaschinen und auf AI-Plattformen zu verfolgen – und erkennen, dass die Indexabdeckung die Grundlage jeder Sichtbarkeitsstrategie ist.

| Konzept | Definition | Hauptsteuerung | Verwendete Tools | Auswirkung auf Rankings |

|---|---|---|---|---|

| Indexabdeckung | Prozentsatz der von Suchmaschinen indexierten Seiten | Meta-Tags, robots.txt, Inhaltsqualität | Google Search Console, Bing Webmaster Tools | Direkt – nur indexierte Seiten können ranken |

| Crawlability | Fähigkeit von Bots, Seiten zu erreichen und zu navigieren | robots.txt, Seitenstruktur, interne Links | Screaming Frog, ZentroAudit, Server-Logs | Indirekt – Seiten müssen crawlbar sein, um indexiert zu werden |

| Indexierbarkeit | Fähigkeit gecrawlter Seiten, in den Index aufgenommen zu werden | Noindex-Direktiven, Canonical-Tags, Inhalte | Google Search Console, URL Inspection Tool | Direkt – bestimmt, ob Seiten in den Ergebnissen erscheinen |

| Crawl-Budget | Anzahl der Seiten, die Googlebot pro Zeitraum crawlt | Seitenautorität, Seitenqualität, Crawl-Fehler | Google Search Console, Server-Logs | Indirekt – beeinflusst, welche Seiten gecrawlt werden |

| Duplicate Content | Mehrere Seiten mit identischem oder ähnlichem Inhalt | Canonical-Tags, 301-Redirects, Noindex | SEO-Audit-Tools, manuelle Prüfung | Negativ – verwässert das Ranking-Potenzial |

Die Indexabdeckung funktioniert in drei Stufen: Entdeckung, Crawling und Indexierung. In der Entdeckungsphase finden Suchmaschinen URLs über verschiedene Wege wie XML-Sitemaps, interne Links, externe Backlinks und direkte Einreichung via Google Search Console. Nach der Entdeckung werden URLs für das Crawling in eine Warteschlange gestellt, bei dem Googlebot die Seite anfordert und ihren Inhalt analysiert. Schließlich prüft Google während der Indexierung den Seiteninhalt, bewertet Relevanz und Qualität und entscheidet, ob die Seite in den durchsuchbaren Index aufgenommen wird.

Der Indexabdeckungsbericht in der Google Search Console unterteilt Seiten in vier Hauptstatus: Gültig (indexierte Seiten), Gültig mit Warnungen (indexiert, aber mit Problemen), Ausgeschlossen (absichtlich nicht indexiert) und Fehler (Seiten, die nicht indexiert werden konnten). Jeder Status enthält spezifische Problematiken, die aufzeigen, warum Seiten indexiert wurden oder nicht. Seiten können zum Beispiel ausgeschlossen werden, weil sie ein noindex-Meta-Tag enthalten, durch robots.txt blockiert sind, Duplikate ohne korrekte Canonical-Tags sind oder 4xx- bzw. 5xx-HTTP-Statuscodes zurückgeben.

Um die technischen Mechanismen der Indexabdeckung zu verstehen, sind einige Schlüsselelemente wichtig. Die robots.txt-Datei im Root-Verzeichnis Ihrer Website weist Suchmaschinen-Crawler an, welche Verzeichnisse und Dateien sie crawlen dürfen und welche nicht. Fehlkonfigurationen in der robots.txt sind eine der häufigsten Ursachen für Indexabdeckungsprobleme – das versehentliche Blockieren wichtiger Verzeichnisse verhindert, dass Google diese Seiten überhaupt entdeckt. Das Meta-Robots-Tag im Head-Bereich einer Seite gibt Seiten-bezogene Anweisungen, etwa index, noindex, follow und nofollow. Das Canonical-Tag (rel=“canonical”) zeigt Suchmaschinen bei Duplikaten die bevorzugte Seitenversion an, verhindert Index-Bloat und bündelt Ranking-Signale.

Für Unternehmen, die auf organischen Such-Traffic setzen, wirkt sich die Indexabdeckung direkt auf Umsatz und Sichtbarkeit aus. Wenn wichtige Seiten nicht indexiert werden, können sie nicht in Suchergebnissen erscheinen – potenzielle Kunden finden sie über Google nicht. E-Commerce-Websites mit schlechter Indexabdeckung haben möglicherweise Produktseiten im Status „Gefunden – zurzeit nicht indexiert“ und verlieren dadurch Verkäufe. Content-Marketing-Plattformen mit Tausenden von Artikeln benötigen eine robuste Indexabdeckung, damit ihre Inhalte Reichweite erzielen. SaaS-Unternehmen sind auf indexierte Dokumentationen und Blogbeiträge angewiesen, um organische Leads zu generieren.

Die praktischen Auswirkungen reichen über die klassische Suche hinaus. Mit dem Aufstieg generativer AI-Plattformen wie ChatGPT, Perplexity und Google AI Overviews wird die Indexabdeckung auch für die AI-Sichtbarkeit relevant. Diese Systeme greifen häufig auf indexierte Webinhalte als Trainingsdaten und Zitationsquellen zurück. Wenn Ihre Seiten nicht korrekt von Google indexiert werden, ist es unwahrscheinlicher, dass sie in AI-Trainingsdaten aufgenommen oder in AI-generierten Antworten zitiert werden. Es entsteht ein doppeltes Sichtbarkeitsproblem: Schlechte Indexabdeckung beeinträchtigt sowohl die klassischen Suchrankings als auch die Sichtbarkeit in AI-generierten Inhalten.

Organisationen, die die Indexabdeckung proaktiv überwachen, erzielen messbare Verbesserungen beim organischen Traffic. Typischerweise wird festgestellt, dass 30-40 % der eingereichten URLs wegen Noindex-Tags, doppelter Inhalte oder Crawl-Fehler ausgeschlossen sind. Nach der Behebung – Entfernung unnötiger Noindex-Tags, korrekte Kanonisierung und Behebung von Crawl-Fehlern – steigt die Zahl der indexierten Seiten oft um 20-50 %, was sich direkt in besserer organischer Sichtbarkeit niederschlägt. Untätigkeit kostet: Jede nicht indexierte Seite bedeutet einen Monat verlorenes Potenzial an Traffic und Conversions.

Die Google Search Console bleibt das wichtigste Tool zur Überwachung der Indexabdeckung und liefert die maßgeblichen Daten zu den Indexierungsentscheidungen von Google. Der Indexabdeckungsbericht zeigt indexierte Seiten, Seiten mit Warnungen, ausgeschlossene Seiten und Fehlerseiten – mit detaillierten Angaben zu den jeweiligen Problematiken. Google stellt außerdem das URL Inspection Tool bereit, mit dem Sie den Indexierungsstatus einzelner Seiten prüfen und die Indexierung für neue oder geänderte Inhalte anfordern können. Dieses Tool ist unverzichtbar, um einzelne Seiten zu prüfen und zu verstehen, warum Google sie nicht indexiert hat.

Bing Webmaster Tools bietet mit dem Index Explorer und der URL-Übermittlung ähnliche Funktionen. Auch wenn Bing einen geringeren Marktanteil als Google hat, ist es dennoch wichtig, Nutzer zu erreichen, die Bing bevorzugen. Die Indexabdeckungsdaten von Bing unterscheiden sich teilweise von denen von Google und zeigen Probleme, die spezifisch für Bings Crawler oder Indexierungsalgorithmen sind. Betreiber großer Websites sollten beide Plattformen überwachen, um eine vollständige Abdeckung sicherzustellen.

Für AI-Monitoring und Marken-Sichtbarkeit bieten Plattformen wie AmICited die Möglichkeit, zu verfolgen, wie Ihre Marke und Domain auf ChatGPT, Perplexity, Google AI Overviews und Claude erscheinen. Diese Plattformen verbinden klassische Indexabdeckung mit der AI-Sichtbarkeit und helfen Organisationen zu verstehen, wie sich indexierte Inhalte auf Erwähnungen in AI-generierten Antworten auswirken. Diese Integration ist für moderne SEO-Strategien entscheidend, da Sichtbarkeit in AI-Systemen den Markenaufbau und Traffic zunehmend beeinflusst.

Drittanbieter-SEO-Audit-Tools wie Ahrefs, SEMrush und Screaming Frog liefern zusätzliche Einblicke zur Indexabdeckung, indem sie Ihre Website unabhängig durchsuchen und ihre Ergebnisse mit den von Google gemeldeten Werten vergleichen. Abweichungen zwischen eigenem Crawl und Google können auf Probleme wie JavaScript-Rendering, Server-Probleme oder Crawl-Budget-Engpässe hinweisen. Diese Tools erkennen auch verwaiste Seiten (ohne interne Links), die häufig Probleme mit der Indexabdeckung haben.

Die Verbesserung der Indexabdeckung erfordert ein systematisches Vorgehen, das technische und strategische Aspekte berücksichtigt. Erstens: Analysieren Sie den aktuellen Stand mit dem Indexabdeckungsbericht der Google Search Console. Identifizieren Sie die Hauptprobleme Ihrer Seite – seien es Noindex-Tags, robots.txt-Blockierungen, doppelte Inhalte oder Crawl-Fehler. Priorisieren Sie nach Auswirkung: Seiten, die indexiert werden sollten, aber es nicht sind, haben Vorrang vor korrekt ausgeschlossenen Seiten.

Zweitens: Beheben Sie robots.txt-Fehlkonfigurationen, indem Sie die Datei überprüfen und sicherstellen, dass Sie nicht versehentlich wichtige Verzeichnisse blockieren. Ein häufiger Fehler ist das Blockieren von /admin/, /staging/ oder /temp/ (was korrekt ist), aber auch versehentlich von /blog/, /products/ oder anderen öffentlichen Inhalten. Nutzen Sie den robots.txt-Tester der Google Search Console, um zu prüfen, dass wichtige Seiten nicht blockiert sind.

Drittens: Setzen Sie eine korrekte Kanonisierung bei doppelten Inhalten um. Wenn Sie mehrere URLs mit ähnlichen Inhalten haben (z.B. Produktseiten über verschiedene Kategoriepfade), setzen Sie selbstreferenzierende Canonical-Tags auf jeder Seite oder nutzen Sie 301-Redirects auf eine bevorzugte Version. So vermeiden Sie Index-Bloat und bündeln die Ranking-Signale auf die gewünschte Seite.

Viertens: Entfernen Sie unnötige Noindex-Tags von Seiten, die indexiert werden sollen. Prüfen Sie Ihre Website auf Noindex-Direktiven, insbesondere auf Staging-Umgebungen, die versehentlich live geschaltet wurden. Überprüfen Sie mit dem URL Inspection Tool, dass wichtige Seiten keine Noindex-Tags haben.

Fünftens: Reichen Sie eine XML-Sitemap in der Google Search Console ein, die nur indexierbare URLs enthält. Halten Sie die Sitemap sauber, indem Sie Seiten mit Noindex-Tags, Weiterleitungen oder 404-Fehlern ausschließen. Bei großen Websites empfiehlt sich die Aufteilung der Sitemaps nach Inhaltstyp oder Bereich, um bessere Organisation und detailliertere Fehlerberichte zu ermöglichen.

Sechstens: Beheben Sie Crawl-Fehler wie defekte Links (404), Serverfehler (5xx) und Redirect-Ketten. Nutzen Sie die Google Search Console zur Identifikation betroffener Seiten und beheben Sie die Probleme systematisch. Bei wichtigen Seiten mit 404-Fehlern stellen Sie entweder den Inhalt wieder her oder leiten Sie per 301-Redirect auf relevante Alternativen weiter.

Die Zukunft der Indexabdeckung entwickelt sich mit den Veränderungen der Suchtechnologien und dem Aufkommen generativer AI-Systeme weiter. Während Google die Anforderungen an die Core Web Vitals und die E-E-A-T-Standards (Experience, Expertise, Authoritativeness, Trustworthiness) weiter verschärft, wird die Indexabdeckung zunehmend von Inhaltsqualität und Nutzererlebnis abhängen. Seiten mit schlechten Core Web Vitals oder dünnem Inhalt könnten selbst bei technischer Crawlability Indexierungsprobleme bekommen.

Der Aufstieg AI-generierter Suchergebnisse und Antwortmaschinen verändert die Bedeutung der Indexabdeckung: Klassische Rankings hängen von indexierten Seiten ab, aber AI-Systeme zitieren indexierte Inhalte möglicherweise anders oder bevorzugen bestimmte Quellen. Organisationen müssen künftig nicht nur überwachen, ob Seiten von Google indexiert werden, sondern auch, ob sie von AI-Plattformen zitiert und referenziert werden. Diese doppelte Sichtbarkeitsanforderung bedeutet, dass Indexabdeckungsmonitoring über die Google Search Console hinaus auf AI-Monitoring-Plattformen erweitert werden muss, die Marken-Erwähnungen auf ChatGPT, Perplexity und anderen generativen AI-Systemen verfolgen.

JavaScript-Rendering und dynamische Inhalte werden die Indexabdeckung weiterhin erschweren. Immer mehr Websites nutzen JavaScript-Frameworks oder Single-Page-Applications – Suchmaschinen müssen JavaScript rendern, um Inhalte zu verstehen. Google hat seine JavaScript-Rendering-Fähigkeiten verbessert, dennoch bestehen weiterhin Probleme. Zukünftige Best Practices werden vermutlich auf Server-Side Rendering oder Dynamic Rendering setzen, damit Inhalte sofort für Crawler zugänglich sind und nicht auf JavaScript-Ausführung angewiesen sind.

Die Integration von strukturierten Daten und Schema-Markup wird für die Indexabdeckung immer wichtiger. Suchmaschinen nutzen strukturierte Daten, um Seiteninhalte und -kontext besser zu verstehen und damit Indexierungsentscheidungen zu verbessern. Organisationen, die umfassendes Schema-Markup für ihre Inhaltstypen – Artikel, Produkte, Events, FAQs – umsetzen, können von einer verbesserten Indexabdeckung und erhöhter Sichtbarkeit in Rich Results profitieren.

Schließlich wird sich das Konzept der Indexabdeckung künftig von Seiten auf Entitäten und Themen ausweiten. Die Überwachung beschränkt sich nicht mehr nur darauf, ob Seiten indexiert werden, sondern darauf, ob Ihre Marke, Produkte und Themen korrekt in Suchmaschinen-Knowledge-Graphs und AI-Trainingsdaten repräsentiert sind. Das bedeutet einen grundlegenden Wandel von der Seiten- zur Entitäten-Ebene und verlangt neue Monitoring-Ansätze und Strategien.

+++

Crawlability beschreibt, ob Suchmaschinen-Bots auf Ihre Webseiten zugreifen und diese navigieren können, was durch Faktoren wie robots.txt und Seitenstruktur gesteuert wird. Indexierbarkeit hingegen bestimmt, ob gecrawlte Seiten tatsächlich in den Index der Suchmaschine aufgenommen werden, beeinflusst durch Meta-Robots-Tags, Canonical-Tags und Inhaltsqualität. Eine Seite muss crawlbar sein, um indexierbar zu sein, aber Crawlability garantiert keine Indexierung.

Für die meisten Websites reicht eine monatliche Überprüfung der Indexabdeckung aus, um größere Probleme zu erkennen. Wenn Sie jedoch bedeutende Änderungen an der Seitenstruktur vornehmen, regelmäßig neue Inhalte veröffentlichen oder Migrationen durchführen, sollten Sie den Bericht wöchentlich oder alle zwei Wochen überwachen. Google versendet zwar E-Mail-Benachrichtigungen zu dringenden Problemen, diese sind jedoch oft verzögert – proaktives Monitoring ist daher entscheidend, um optimale Sichtbarkeit zu erhalten.

Dieser Status zeigt an, dass Google eine URL gefunden hat (meist über Sitemaps oder interne Links), sie aber noch nicht gecrawlt wurde. Dies kann durch Crawl-Budget-Limitierungen auftreten, bei denen Google andere Seiten Ihrer Website priorisiert. Bleiben wichtige Seiten längere Zeit in diesem Status, kann dies auf Crawl-Budget-Probleme oder eine geringe Seitenautorität hinweisen, die behoben werden sollten.

Ja, das Einreichen einer XML-Sitemap in der Google Search Console hilft Suchmaschinen, Ihre Seiten zu entdecken und für das Crawling und die Indexierung zu priorisieren. Eine gut gepflegte Sitemap, die nur indexierbare URLs enthält, kann die Indexabdeckung erheblich verbessern, indem sie das Crawl-Budget von Google auf die wichtigsten Inhalte lenkt und die Entdeckungszeit reduziert.

Häufige Probleme sind Seiten, die durch robots.txt blockiert werden, Noindex-Meta-Tags auf wichtigen Seiten, doppelte Inhalte ohne richtige Kanonisierung, Serverfehler (5xx), Redirect-Ketten und dünne Inhalte. Darüber hinaus tauchen in Indexabdeckungsberichten oft 404-Fehler, Soft-404s und Seiten mit Autorisierungsanforderungen (401/403-Fehler) auf, die behoben werden müssen, um die Sichtbarkeit zu verbessern.

Die Indexabdeckung wirkt sich direkt darauf aus, ob Ihre Inhalte in AI-generierten Antworten von Plattformen wie ChatGPT, Perplexity und Google AI Overviews erscheinen. Wenn Ihre Seiten von Google nicht richtig indexiert werden, ist es unwahrscheinlicher, dass sie in Trainingsdaten aufgenommen oder von AI-Systemen zitiert werden. Die Überwachung der Indexabdeckung stellt sicher, dass Ihre Markeninhalte sowohl in der klassischen Suche als auch auf generativen AI-Plattformen auffindbar und zitierbar sind.

Das Crawl-Budget ist die Anzahl der Seiten, die Googlebot innerhalb eines bestimmten Zeitraums auf Ihrer Website crawlt. Websites mit einer schlechten Crawl-Budget-Effizienz haben oft viele Seiten im Status „Gefunden – zurzeit nicht indexiert“. Durch die Optimierung des Crawl-Budgets – z. B. durch das Beheben von Crawl-Fehlern, das Entfernen doppelter URLs und den gezielten Einsatz der robots.txt – stellen Sie sicher, dass Google sich auf die Indexierung Ihrer wertvollsten Inhalte konzentriert.

Nein, nicht alle Seiten sollten indexiert werden. Seiten wie Staging-Umgebungen, doppelte Produktvarianten, interne Suchergebnisse und Datenschutzarchivseiten sollten in der Regel mit Noindex-Tags oder robots.txt vom Index ausgeschlossen werden. Ziel ist es, nur hochwertigen, einzigartigen Content zu indexieren, der der Nutzerintention entspricht und zur SEO-Performance Ihrer Website beiträgt.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, was KI-Index-Abdeckung ist und warum sie für die Sichtbarkeit Ihrer Marke in ChatGPT, Google AI Overviews und Perplexity wichtig ist. Entdecken Si...

Indexierbarkeit ist die Fähigkeit von Suchmaschinen, Seiten in ihren Index aufzunehmen. Erfahren Sie, wie Crawlability, technische Faktoren und Inhaltsqualität ...

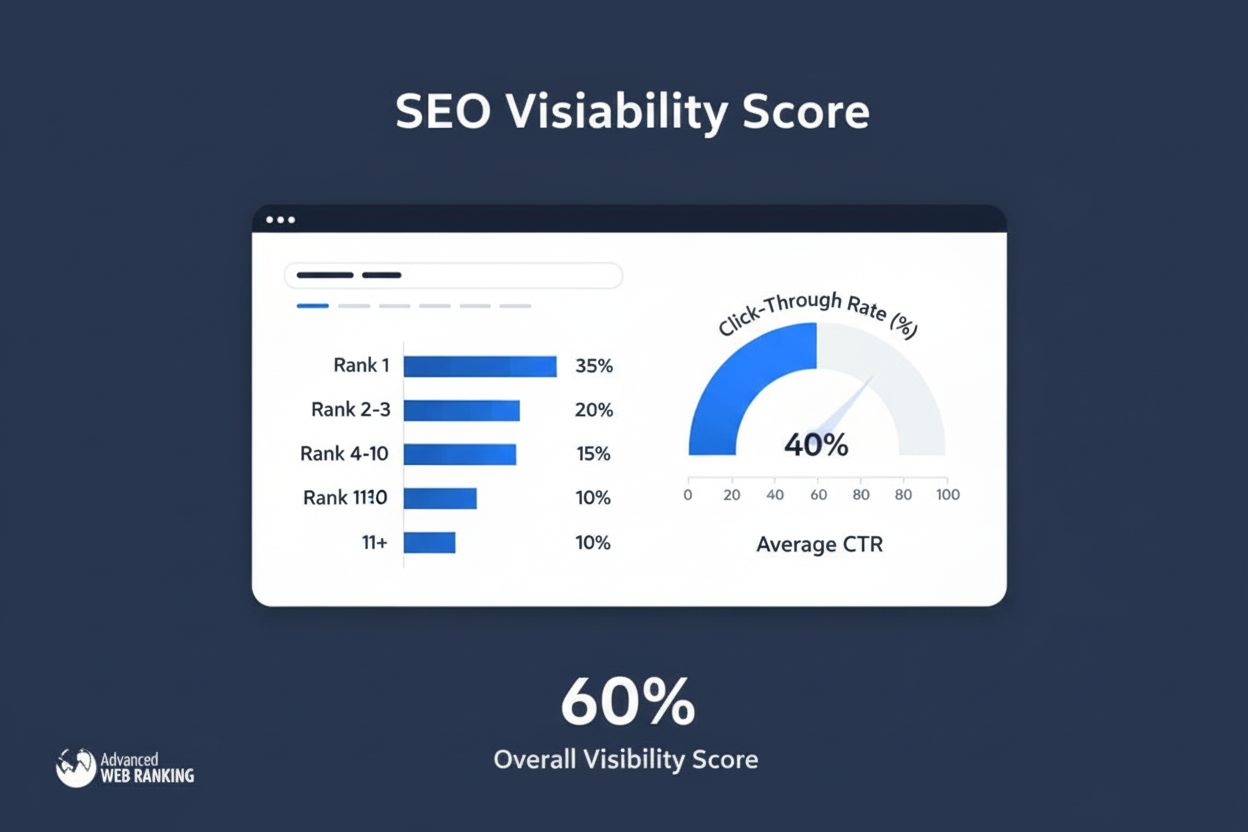

Der Sichtbarkeitsindex misst die Suchpräsenz, indem er geschätzte Klicks aus organischen Rankings berechnet. Erfahren Sie, wie diese Kennzahl funktioniert, wie ...