Indexabdeckung

Die Indexabdeckung misst, welche Webseiten von Suchmaschinen indexiert werden. Erfahren Sie, was das bedeutet, warum es für SEO wichtig ist und wie Sie Indexier...

Indexierbarkeit bezieht sich darauf, ob eine Webseite erfolgreich von einer Suchmaschine gecrawlt, analysiert und im Index gespeichert werden kann, sodass sie potenziell in den Suchergebnissen erscheint. Sie hängt von technischen Faktoren ab, wie robots.txt-Direktiven, noindex-Tags, kanonischen URLs und Qualitätssignalen, die bestimmen, ob eine Seite für das Indexieren geeignet ist.

Indexierbarkeit bezieht sich darauf, ob eine Webseite erfolgreich von einer Suchmaschine gecrawlt, analysiert und im Index gespeichert werden kann, sodass sie potenziell in den Suchergebnissen erscheint. Sie hängt von technischen Faktoren ab, wie robots.txt-Direktiven, noindex-Tags, kanonischen URLs und Qualitätssignalen, die bestimmen, ob eine Seite für das Indexieren geeignet ist.

Indexierbarkeit ist die Fähigkeit einer Webseite, von einer Suchmaschine erfolgreich gecrawlt, analysiert und im Index gespeichert zu werden, sodass sie potenziell in den Suchergebnissen erscheint. Im Gegensatz zur Crawlability – die darauf abzielt, ob Suchmaschinen auf eine Seite zugreifen können – bestimmt die Indexierbarkeit, ob diese erreichte Seite für die Aufnahme in die Datenbank der Suchmaschine geeignet ist. Eine Seite kann vollständig crawlbar, aber dennoch nicht indexierbar sein, wenn sie eine noindex-Direktive enthält, Qualitätsanforderungen nicht erfüllt oder andere Indexierungsregeln verletzt. Indexierbarkeit ist die entscheidende Brücke zwischen technischer Zugänglichkeit und tatsächlicher Sichtbarkeit in Suchmaschinen und damit eines der wichtigsten Konzepte in der Suchmaschinenoptimierung und der generativen Engine-Optimierung (GEO). Ohne korrekte Indexierbarkeit bleibt selbst hochwertigster Inhalt für klassische Suchmaschinen und KI-gestützte Discovery-Plattformen unsichtbar.

Obwohl sie oft verwechselt werden, erfüllen Crawlability und Indexierbarkeit unterschiedliche Zwecke in der Suchmaschinen-Pipeline. Crawlability bezeichnet, ob Googlebot und andere Suchmaschinen-Crawler eine Webseite über Links, Sitemaps oder externe Verweise entdecken und aufrufen können. Sie beantwortet die Frage: „Kann der Suchmaschinen-Bot diese Seite erreichen?“ Indexierbarkeit hingegen beantwortet: „Soll diese Seite im Suchmaschinenindex gespeichert werden?“ Eine Seite kann sehr gut crawlbar, also leicht für Bots zugänglich sein, aber dennoch nicht indexiert werden, wenn sie etwa ein noindex-Meta-Tag enthält, doppelte Inhalte aufweist oder nicht ausreichend Qualitätssignale bietet. Laut einer Studie von Botify, die in 30 Tagen 413 Millionen einzigartige Webseiten analysierte, wurden 51 % der Seiten nicht gecrawlt, und 37 % der gecrawlten Seiten waren aufgrund von Qualitäts- oder technischen Problemen nicht indexierbar. Diese Unterscheidung ist entscheidend, denn das Beheben von Crawlability-Problemen allein garantiert keine Indexierung; sowohl technische Faktoren als auch Inhaltsqualität müssen für eine erfolgreiche Indexierung zusammenpassen.

Mehrere technische Mechanismen steuern direkt, ob eine Seite indexiert werden kann. Das noindex-Meta-Tag ist die expliziteste Steuerung, implementiert als <meta name="robots" content="noindex"> im HTML-Head einer Seite oder als X-Robots-Tag: noindex HTTP-Header. Wenn Suchmaschinen auf diese Direktive stoßen, wird die Seite unabhängig von ihrer Qualität oder externen Links nicht indexiert. Die robots.txt-Datei steuert den Crawl-Zugriff, verhindert aber nicht direkt die Indexierung; ist eine Seite durch robots.txt blockiert, können Crawler das noindex-Tag nicht sehen, sodass die Seite unter Umständen über externe Links dennoch indexiert bleibt. Kanonische Tags geben an, welche Version einer Seite indexiert werden soll, wenn doppelte oder ähnliche Inhalte über mehrere URLs existieren. Falsche Implementierung von Canonicals – z. B. Verweis auf die falsche URL oder zirkuläre Referenzen – kann verhindern, dass die gewünschte Seite indexiert wird. HTTP-Statuscodes beeinflussen ebenfalls die Indexierbarkeit: Seiten mit 200 OK sind indexierbar, 301-Weiterleitungen zeigen eine dauerhafte Verschiebung an, 302-Weiterleitungen eine temporäre, und 404-Fehler bedeuten, dass Seiten nicht indexiert werden können. Das Verstehen und die korrekte Umsetzung dieser technischen Faktoren sind essenziell, um eine starke Indexierbarkeit Ihrer Website sicherzustellen.

| Konzept | Definition | Hauptfokus | Auswirkung auf Suchsichtbarkeit | Steuerungsmethode |

|---|---|---|---|---|

| Indexierbarkeit | Ob eine gecrawlte Seite im Suchindex gespeichert werden kann | Aufnahme in die Suchdatenbank | Direkt – indexierte Seiten sind für Ranking berechtigt | noindex-Tags, Qualitätssignale, Canonicals |

| Crawlability | Ob Bots auf eine Seite zugreifen und sie lesen können | Bot-Zugriff und Auffindbarkeit | Voraussetzung für Indexierbarkeit | robots.txt, interne Links, Sitemaps |

| Renderbarkeit | Ob Suchmaschinen JavaScript und dynamische Inhalte verarbeiten können | Sichtbarkeit von Inhalten für Crawler | Beeinflusst, welche Inhalte indexiert werden | Server-seitiges Rendering, Pre-Rendering-Tools |

| Rankbarkeit | Ob eine indexierte Seite für bestimmte Keywords ranken kann | Position in den Suchergebnissen | Bestimmt Sichtbarkeit für Suchanfragen | Inhaltsqualität, Autorität, Relevanzsignale |

| Auffindbarkeit | Ob Nutzer eine Seite über Suche oder Links finden können | Nutzerzugang zu Inhalten | Abhängig von Indexierung und Ranking | SEO-Optimierung, Linkaufbau, Promotion |

Die Entscheidung über die Indexierbarkeit erfolgt in mehreren Bewertungsstufen nach dem Crawlen einer Seite. Zunächst führen Suchmaschinen das Rendering durch, wobei sie JavaScript ausführen und dynamische Inhalte verarbeiten, um die vollständige Seitenstruktur und den gesamten Inhalt zu verstehen. In dieser Phase prüft Google, ob wichtige Elemente wie Überschriften, Meta-Tags und strukturierte Daten korrekt implementiert sind. Danach bewerten die Suchmaschinen die Inhaltsqualität, indem sie analysieren, ob eine Seite originelle, hilfreiche und relevante Informationen bietet. Seiten mit dünnem Inhalt – wenig Text, geringer Wortanzahl oder generischen Informationen – bestehen diese Qualitätsprüfung oft nicht. Anschließend prüfen Suchmaschinen auf Duplicate-Content-Probleme; enthalten mehrere URLs identische oder nahezu identische Inhalte, wird eine kanonische Version für den Index ausgewählt, während andere möglicherweise ausgeschlossen werden. Danach wird die semantische Relevanz mittels natürlicher Sprachverarbeitung bewertet, um festzustellen, ob der Inhalt tatsächlich die Nutzerintention und Suchanfragen adressiert. Schließlich werden Vertrauens- und Autoritätssignale geprüft, darunter Seitenstruktur, interne Verlinkung, externe Zitate und die Gesamt-Domainautorität. Laut HTTP Archive Web Almanac 2024 enthalten 53,4 % der Desktop-Seiten und 53,9 % der mobilen Seiten Indexierungsdirektiven in ihren Robots-Meta-Tags, was ein verbreitetes Bewusstsein für Indexierbarkeitskontrollen zeigt. Dennoch kämpfen viele Seiten weiterhin mit Indexierbarkeitsproblemen aufgrund fehlerhafter technischer Umsetzung.

Die Inhaltsqualität ist in Indexierbarkeitsentscheidungen immer wichtiger geworden, insbesondere seit Googles Fokus auf E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness)-Signale. Suchmaschinen bewerten nun, ob Inhalte echte Expertise zeigen, originelle Einblicke bieten und einen klaren Nutzen für Nutzer haben. Seiten, die automatisch generiert wirken, von anderen Quellen kopiert wurden oder hauptsächlich zur Manipulation von Suchmaschinen erstellt wurden, werden häufig trotz technischer Korrektheit nicht indexiert. Hohe Indexierbarkeit setzt voraus, dass Inhalte gut strukturiert, mit klaren Überschriften, logischem Aufbau und umfassender Themenabdeckung gestaltet sind. Seiten sollten unterstützende Belege wie Statistiken, Fallstudien, Expertenzitate oder eigene Forschung enthalten. Die Verwendung von Schema-Markup und strukturierten Daten hilft Suchmaschinen, den Kontext von Inhalten zu erfassen und erhöht die Wahrscheinlichkeit der Indexierung. Auch Aktualität ist wichtig: Regelmäßig aktualisierte Seiten signalisieren Suchmaschinen, dass Informationen aktuell und relevant sind. Seiten, die seit Jahren nicht aktualisiert wurden, werden insbesondere in dynamischen Branchen für die Indexierung oft zurückgestuft. Die Beziehung zwischen Inhaltsqualität und Indexierbarkeit bedeutet, dass SEO-Profis nicht nur auf technische Umsetzung, sondern auch auf wertvollen, nutzerorientierten Content setzen müssen.

Der Aufstieg von AI Overviews, ChatGPT, Perplexity und anderen Large Language Models (LLMs) hat die Bedeutung der Indexierbarkeit über klassische Suchergebnisse hinaus erweitert. Diese KI-Systeme nutzen indexierte Inhalte aus Suchmaschinen als Trainingsdaten und Quellen für ihre Antworten. Wird eine Seite von Google indexiert, ist sie auch für KI-Crawler wie OAI-SearchBot (der Crawler von ChatGPT) und andere KI-Plattformen auffindbar. Allerdings erfordert Indexierbarkeit für die KI-Suche zusätzliche Überlegungen gegenüber klassischem SEO. KI-Systeme bewerten Inhalte hinsichtlich semantischer Klarheit, Faktenkorrektheit und Zitierfähigkeit. Seiten, die zwar indexiert sind, aber keine klare Struktur, korrekte Zitate oder Autoritätssignale aufweisen, werden möglicherweise nicht für KI-generierte Antworten ausgewählt. Laut einer Studie von Prerender.io verzeichnete ein Kunde eine Steigerung des Referral-Traffics von ChatGPT um 800 %, nachdem die Indexierbarkeit der Seite optimiert und das Rendering für KI-Crawler sichergestellt wurde. Dies zeigt, dass eine starke Indexierbarkeit direkt die Sichtbarkeit auf verschiedenen Discovery-Oberflächen beeinflusst. Organisationen müssen Indexierbarkeit also nicht nur für Google Search, sondern für das gesamte Ökosystem KI-gestützter Such- und Discovery-Plattformen betrachten, die auf indexierte Inhalte angewiesen sind.

Mehrere häufige Probleme verhindern, dass Seiten indexiert werden, obwohl sie crawlbar sind. Ungewollte noindex-Tags sind eine häufige Ursache, oft von CMS-Templates übernommen oder versehentlich bei Website-Relaunches gesetzt. Prüfen Sie Ihre Seite mit der Google Search Console, um Seiten mit noindex-Kennzeichnung zu identifizieren, und kontrollieren Sie, ob dies beabsichtigt war. Dünner oder doppelter Inhalt ist ein weiterer Hauptblocker; Seiten mit wenig Originalinhalt oder Inhalten, die anderen Seiten Ihrer Website stark ähneln, werden oft nicht indexiert. Konsolidieren Sie doppelte Seiten per 301-Weiterleitung oder setzen Sie Canonical-Tags, um die bevorzugte Version anzugeben. Defekte interne Verlinkungen und verwaiste Seiten – also Seiten ohne interne Links – erschweren es Crawlern, diese Seiten zu entdecken und für die Indexierung zu priorisieren. Stärken Sie Ihre interne Linkstruktur, indem Sie wichtige Seiten aus der Navigation und von autoritätsstarken Seiten verlinken. Weiterleitungsketten und Redirect-Loops verschwenden Crawl-Budget und verwirren Suchmaschinen darüber, welche Seite indexiert werden soll. Prüfen Sie Ihre Weiterleitungen und stellen Sie sicher, dass sie direkt auf das Zieldokument zeigen. JavaScript-Rendering-Probleme verhindern, dass Suchmaschinen wichtige Inhalte sehen, wenn diese nur clientseitig geladen werden. Nutzen Sie Server-Side Rendering (SSR) oder Pre-Rendering-Tools wie Prerender.io, damit der komplette Inhalt im initialen HTML sichtbar ist. Langsame Ladezeiten und Serverfehler (5xx-Statuscodes) können die Indexierung verhindern; überwachen Sie Ihre Seitenperformance und beheben Sie technische Probleme zügig.

Effizientes Indexierbarkeits-Management erfordert fortlaufende Überwachung und Messung. Google Search Console ist das wichtigste Tool zur Indexierbarkeitsüberwachung; der Bericht „Seitenindexierung“ (früher „Indexabdeckung“) zeigt genau, wie viele Seiten indexiert oder ausgeschlossen sind und warum. Der Bericht kategorisiert Seiten als „Indexiert“, „Gecrawlt – derzeit nicht indexiert“, „Gefunden – derzeit nicht indexiert“ oder „Durch noindex-Tag ausgeschlossen“. Die Verfolgung dieser Kennzahlen im Zeitverlauf zeigt Trends und hilft, systemische Probleme zu erkennen. Das Index-Effizienz-Verhältnis (IER) ist eine wichtige Kennzahl und wird als indexierte Seiten geteilt durch beabsichtigte indexierbare Seiten berechnet. Wenn Sie 10.000 Seiten haben, die indexierbar sein sollten, aber nur 6.000 indexiert sind, beträgt Ihr IER 0,6 – das bedeutet, 40 % Ihrer Inhalte sind nicht sichtbar. Die Überwachung des IER im Zeitverlauf misst den Erfolg von Optimierungsmaßnahmen. Server-Log-Analysen liefern eine weitere wichtige Perspektive und zeigen, welche Seiten Googlebot tatsächlich anfordert und wie häufig. Tools wie der Log File Analyzer von Semrush zeigen, ob Ihre wichtigsten Seiten regelmäßig gecrawlt werden oder Crawl-Budget auf unwichtige Inhalte verschwendet wird. Site-Crawler wie Screaming Frog und Sitebulb helfen, technische Indexierbarkeitsprobleme wie defekte Links, Weiterleitungsketten und fehlerhafte Canonicals zu identifizieren. Regelmäßige Audits – monatlich für kleine, quartalsweise für große Seiten – helfen, Indexierbarkeitsprobleme frühzeitig zu erkennen.

Eine starke Indexierbarkeit erfordert einen systematischen Ansatz aus technischer Umsetzung und Content-Strategie. Erstens: Priorisieren Sie relevante Seiten: Konzentrieren Sie Ihre Indexierbarkeitsbemühungen auf Seiten mit Geschäftswert, wie Produktseiten, Serviceangebote und zentrale Inhalte. Nicht jede Seite muss indexiert werden; gezielter Ausschluss von Seiten mit geringem Wert per noindex-Tag verbessert sogar die Crawling-Effizienz. Zweitens: Sorgen Sie für korrekte Kanonisierung: Verwenden Sie auf den meisten Seiten selbstreferenzierende Canonical-Tags und nur dann domänenübergreifende Canonicals, wenn Sie Inhalte gezielt konsolidieren. Drittens: Setzen Sie robots.txt korrekt ein: Blockieren Sie technische Ordner und Ressourcen mit geringer Priorität, aber nie Seiten, die indexiert werden sollen. Viertens: Erstellen Sie qualitativ hochwertige, originelle Inhalte: Setzen Sie auf Tiefe, Klarheit und Mehrwert statt auf Keyword-Dichte. Fünftens: Optimieren Sie die Seitenstruktur: Halten Sie eine logische Hierarchie ein, führen Sie wichtige Seiten innerhalb von drei Klicks von der Startseite erreichbar und sorgen Sie für klare interne Verlinkung. Sechstens: Fügen Sie strukturierte Daten hinzu: Implementieren Sie Schema-Markup für Inhaltstypen wie Artikel, FAQs, Produkte und Organisationen, damit Suchmaschinen Ihren Content besser verstehen. Siebtens: Achten Sie auf technische Korrektheit: Beheben Sie defekte Links, entfernen Sie Weiterleitungsketten, optimieren Sie die Ladegeschwindigkeit und überwachen Sie Serverfehler. Schließlich: Halten Sie Inhalte aktuell: Aktualisieren Sie wichtige Seiten regelmäßig, um Suchmaschinen zu signalisieren, dass Informationen relevant und aktuell sind. Diese Maßnahmen schaffen gemeinsam eine Umgebung, in der Suchmaschinen Ihre wichtigsten Inhalte zuverlässig indexieren können.

Indexierbarkeit entwickelt sich mit den Fortschritten der Suchtechnologie weiter. Der Aufstieg des Mobile-First-Indexing bedeutet, dass Google in erster Linie die mobile Version von Seiten crawlt und indexiert – Mobile-Optimierung ist also für die Indexierbarkeit essenziell. Die zunehmende Bedeutung der Core Web Vitals und Page-Experience-Signale weist darauf hin, dass technische Performance künftig eine größere Rolle bei Indexierungsentscheidungen spielen wird. Da KI-Suche immer wichtiger wird, könnten Indexierbarkeitsanforderungen sich hin zu semantischer Klarheit, Faktenkorrektheit und Zitierfähigkeit verschieben, statt auf klassische Rankingfaktoren zu setzen. Das Aufkommen von Zero-Click-Suchen und Featured Snippets bedeutet, dass selbst indexierte Seiten für Extraktion und Zusammenfassung durch Suchmaschinen und KI-Systeme optimiert sein müssen. Unternehmen sollten damit rechnen, dass die Indexierbarkeitsstandards immer selektiver werden und Suchmaschinen künftig weniger, aber hochwertigere Seiten indexieren. Dieser Trend macht es umso wichtiger, wirklich wertvolle Inhalte zu schaffen und technisch korrekt umzusetzen, statt jede mögliche Seitenvariante zu indexieren. Die Zukunft der Indexierbarkeit liegt im Prinzip „Qualität statt Quantität“, wobei Suchmaschinen und KI-Systeme immer besser darin werden, Inhalte zu identifizieren und zu priorisieren, die den Nutzerbedürfnissen wirklich dienen.

Für Unternehmen, die KI-Monitoring-Plattformen wie AmICited nutzen, ist das Verständnis der Indexierbarkeit entscheidend, um die Marken-Sichtbarkeit über verschiedene Discovery-Oberflächen hinweg zu verfolgen. Sind Ihre Seiten von Google korrekt indexiert, sind sie grundsätzlich für Zitate in KI-generierten Antworten auf Plattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude geeignet. Doch Indexierbarkeit allein garantiert noch keine KI-Sichtbarkeit; Ihre Inhalte müssen auch semantisch relevant, autoritativ und für KI-Systeme richtig strukturiert sein, damit sie als Quelle ausgewählt werden. AmICited hilft Unternehmen zu überwachen, ob ihre indexierten Inhalte tatsächlich in KI-Antworten zitiert und referenziert werden, und liefert Erkenntnisse, wie sich Indexierbarkeit in reale Sichtbarkeit im KI-Such-Ökosystem übersetzt. Durch die Kombination klassischer Indexierbarkeitsüberwachung mit KI-Zitations-Tracking gewinnen Organisationen einen vollständigen Überblick über ihre Suchsichtbarkeit und können datenbasierte Entscheidungen zur Content-Optimierung und technischen SEO treffen.

Crawlability bezeichnet, ob Suchmaschinen-Bots auf eine Webseite zugreifen und sie lesen können, während Indexierbarkeit bestimmt, ob diese gecrawlte Seite im Suchmaschinenindex gespeichert werden kann. Eine Seite kann crawlbar, aber nicht indexierbar sein, wenn sie ein noindex-Tag enthält oder Qualitätsbewertungen nicht besteht. Beide sind für die Sichtbarkeit in Suchmaschinen essenziell, aber Crawlability ist die Voraussetzung für Indexierbarkeit.

Das noindex-Meta-Tag oder HTTP-Header weist Suchmaschinen ausdrücklich an, eine Seite nicht in ihren Index aufzunehmen, auch wenn die Seite crawlbar ist. Wenn Googlebot eine noindex-Direktive findet, wird die Seite vollständig aus den Suchergebnissen entfernt. Dies ist nützlich für Seiten wie Dankeseiten oder doppelte Inhalte, die zwar einen Zweck erfüllen, aber nicht in den Suchergebnissen erscheinen sollten.

Die robots.txt-Datei steuert, welche Seiten Suchmaschinen crawlen dürfen, verhindert aber nicht direkt das Indexieren. Ist eine Seite durch robots.txt blockiert, können Crawler das noindex-Tag nicht sehen, sodass die Seite möglicherweise dennoch erscheint, wenn andere Seiten auf sie verlinken. Um die Indexierbarkeit effektiv zu steuern, sollten Sie für auszuschließende Seiten noindex-Tags statt robots.txt verwenden.

Suchmaschinen bewerten die Inhaltsqualität als Teil der Indexierbarkeitsentscheidung. Seiten mit dünnem Inhalt, doppelten Informationen oder geringem Mehrwert können zwar gecrawlt, aber nicht indexiert werden. Die Indexierungsalgorithmen von Google prüfen, ob Inhalte originell, hilfreich und relevant für die Nutzerintention sind. Hochwertige, einzigartige Inhalte mit klarer Struktur und korrektem Format werden eher indexiert.

Das Index-Effizienz-Verhältnis (IER) wird berechnet als indexierte Seiten geteilt durch beabsichtigte indexierbare Seiten. Wenn z. B. 10.000 Seiten indexierbar sein sollten, aber nur 6.000 indexiert sind, beträgt Ihr IER 0,6. Diese Kennzahl hilft dabei, die Effektivität der Aufnahme Ihrer Inhalte in Suchindizes zu messen und Lücken zwischen potenzieller und tatsächlicher Sichtbarkeit zu identifizieren.

Kanonische Tags sagen Suchmaschinen, welche Version einer Seite als maßgebliche Quelle behandelt werden soll, wenn doppelte oder ähnliche Inhalte existieren. Falsche Implementierung von Canonicals kann verhindern, dass die richtige Seite indexiert wird oder dazu führen, dass Google eine nicht beabsichtigte Version indexiert. Selbstreferenzierende Canonicals (wo das Canonical mit der eigenen URL der Seite übereinstimmt) sind für die meisten Seiten Best Practice.

Ja, eine Seite kann indexiert sein, ohne für ein Keyword zu ranken. Indexierung bedeutet, dass die Seite in der Datenbank der Suchmaschine gespeichert und grundsätzlich in den Ergebnissen erscheinen kann. Ranking ist ein separater Prozess, bei dem Suchmaschinen entscheiden, welche indexierten Seiten für bestimmte Suchanfragen angezeigt werden. Viele indexierte Seiten ranken nie, weil sie nicht zur Suchintention passen oder nicht genügend Autoritätssignale haben.

KI-Suchmaschinen wie ChatGPT, Perplexity und Claude nutzen indexierte Inhalte traditioneller Suchmaschinen als Trainingsdaten und Quellenmaterial. Wenn Ihre Seiten nicht von Google indexiert sind, werden sie eher nicht von KI-Systemen gefunden und zitiert. Eine starke Indexierbarkeit in klassischen Suchmaschinen ist die Grundlage für Sichtbarkeit auf KI-basierten Suchplattformen.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Die Indexabdeckung misst, welche Webseiten von Suchmaschinen indexiert werden. Erfahren Sie, was das bedeutet, warum es für SEO wichtig ist und wie Sie Indexier...

Crawlability ist die Fähigkeit von Suchmaschinen, auf Website-Seiten zuzugreifen und sie zu navigieren. Erfahren Sie, wie Crawler arbeiten, was sie blockiert un...

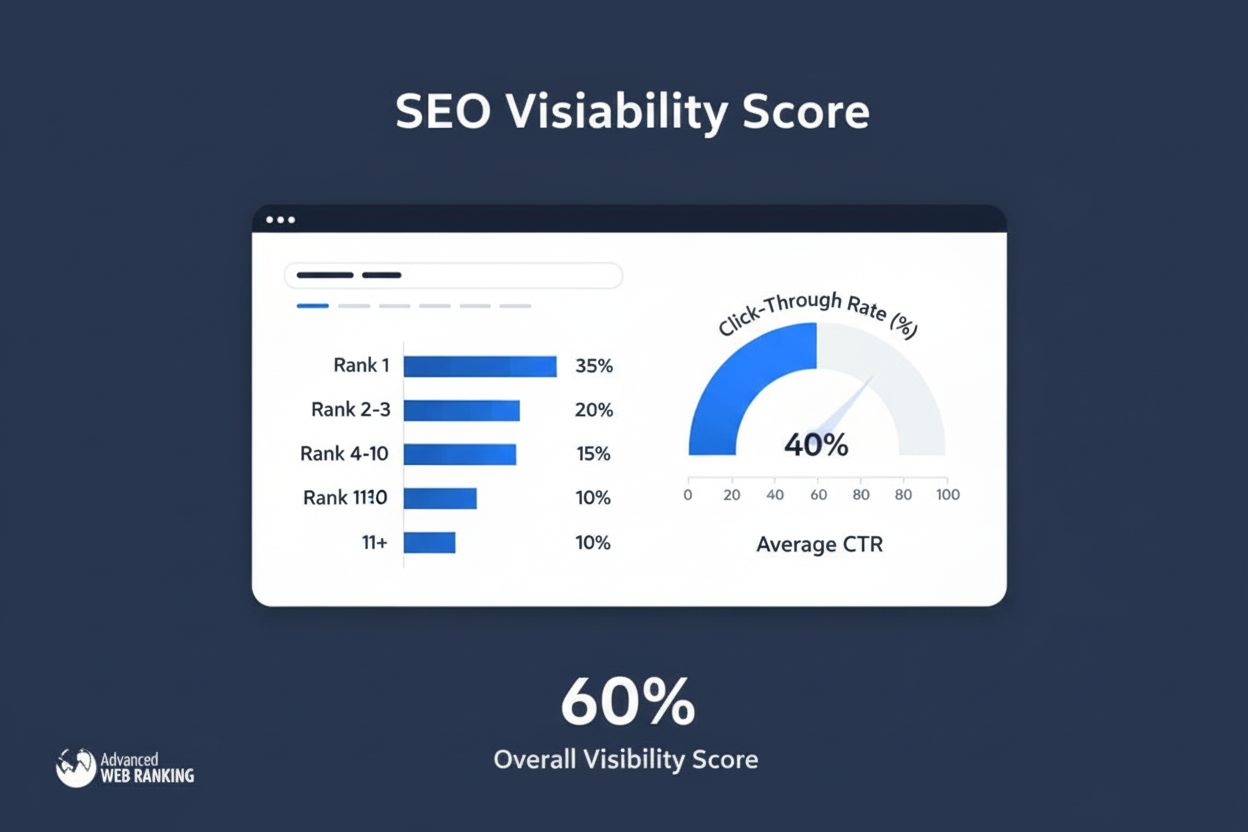

Der Sichtbarkeitsindex misst die Suchpräsenz, indem er geschätzte Klicks aus organischen Rankings berechnet. Erfahren Sie, wie diese Kennzahl funktioniert, wie ...