Prerendering für KI-Crawler: JavaScript-Inhalte zugänglich machen

Erfahren Sie, wie Prerendering JavaScript-Inhalte für KI-Crawler wie ChatGPT, Claude und Perplexity sichtbar macht. Entdecken Sie die besten technischen Lösunge...

JavaScript-Rendering für KI bezieht sich auf den Prozess, dynamisch von JavaScript erstellte Inhalte auch für KI-Crawler zugänglich zu machen, die keinen JavaScript-Code ausführen können. Da große KI-Systeme wie ChatGPT, Perplexity und Claude kein JavaScript ausführen, muss der Inhalt als statisches HTML bereitgestellt werden, damit er in KI-generierten Antworten sichtbar ist. Lösungen wie Prerendering wandeln JavaScript-lastige Seiten in statische HTML-Snapshots um, auf die KI-Crawler sofort zugreifen und die sie verstehen können.

JavaScript-Rendering für KI bezieht sich auf den Prozess, dynamisch von JavaScript erstellte Inhalte auch für KI-Crawler zugänglich zu machen, die keinen JavaScript-Code ausführen können. Da große KI-Systeme wie ChatGPT, Perplexity und Claude kein JavaScript ausführen, muss der Inhalt als statisches HTML bereitgestellt werden, damit er in KI-generierten Antworten sichtbar ist. Lösungen wie Prerendering wandeln JavaScript-lastige Seiten in statische HTML-Snapshots um, auf die KI-Crawler sofort zugreifen und die sie verstehen können.

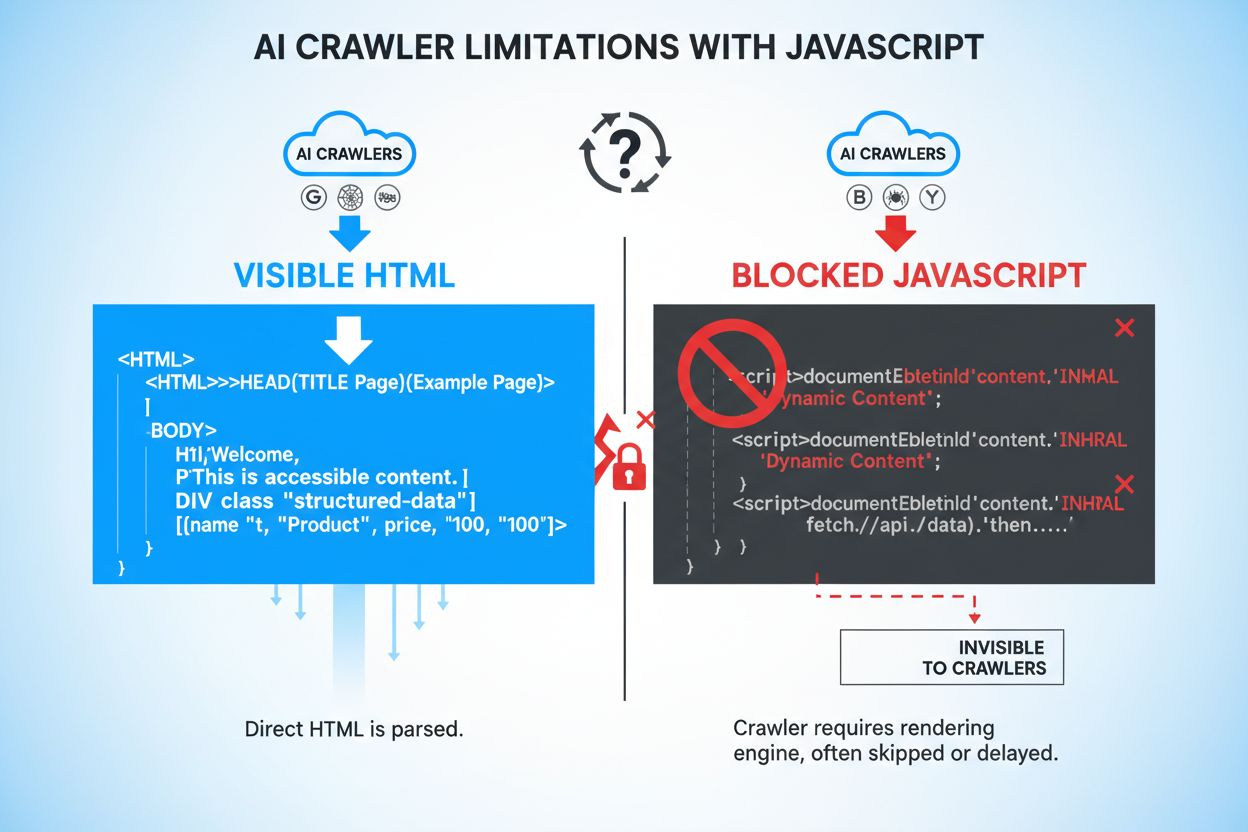

JavaScript ist eine Programmiersprache, die dynamische, interaktive Web-Erlebnisse ermöglicht, indem Code direkt im Browser der Nutzer ausgeführt wird. Websites nutzen JavaScript, um reaktionsschnelle Interfaces zu schaffen, Inhalte bei Bedarf zu laden und personalisierte Nutzererfahrungen zu bieten. KI-Crawler wie GPTBot, ChatGPT-User und OAI-SearchBot arbeiten jedoch grundlegend anders als klassische Webcrawler – sie setzen Geschwindigkeit und Effizienz über Rendering-Fähigkeiten. Während Googlebot und andere Suchmaschinen-Crawler JavaScript ausführen können (wenn auch mit Einschränkungen), tun KI-Crawler dies meist nicht, weil das Rendern von JavaScript erhebliche Rechenleistung und Zeit benötigt. Diese KI-Systeme arbeiten mit strikten Timeout-Beschränkungen, oft zwischen 1-5 Sekunden pro Seite, was die vollständige Ausführung von JavaScript unpraktisch macht. Außerdem sind KI-Crawler darauf ausgelegt, Informationen schnell zu extrahieren statt eine vollständige Browserumgebung zu simulieren. Sie erfassen daher nur das initial vom Server gelieferte HTML, nicht die dynamisch nach JavaScript-Ausführung gerenderten Inhalte.

Wenn KI-Crawler auf Ihre Website zugreifen, entgeht ihnen entscheidender Inhalt, der erst nach der Ausführung von JavaScript erscheint. Produktinformationen wie Preise, Verfügbarkeitsstatus und Variantenoptionen werden häufig erst durch JavaScript-Rendering sichtbar und bleiben so für KI-Systeme unsichtbar. Lazy-geladene Inhalte – Bilder, Kundenbewertungen, Kommentare und zusätzliche Produktdetails, die beim Scrollen geladen werden – sind für KI-Crawler, die kein JavaScript ausführen, vollständig unzugänglich. Interaktive Elemente wie Tabs, Karussells, Akkordeons und Modalfenster enthalten wertvolle Informationen, auf die KI-Systeme ohne Rendering nicht zugreifen können. Clientseitig gerenderter Text und dynamisch erzeugte Metadaten sind ebenso unsichtbar, wodurch erhebliche Lücken bei dem entstehen, was KI-Systeme über Ihre Inhalte verstehen.

| Inhaltstyp | Sichtbarkeit für KI-Crawler | Auswirkung |

|---|---|---|

| Statischer HTML-Text | ✓ Sichtbar | Hohe Zugänglichkeit |

| JavaScript-gerenderter Text | ✗ Verborgen | Vollständig übersehen |

| Lazy-geladene Bilder | ✗ Verborgen | Produktpräsenz verloren |

| Produktpreise/-verfügbarkeit | ✗ Verborgen (bei JS-Rendering) | Kritische Geschäftsdaten fehlen |

| Kundenbewertungen | ✗ Verborgen (bei Lazy-Loading) | Social Proof nicht verfügbar |

| Tab-Inhalte | ✗ Verborgen | Wichtige Infos unzugänglich |

| Schema-Markup im HTML | ✓ Sichtbar | Strukturierte Daten erfasst |

| Dynamische Meta-Beschreibungen | ✗ Verborgen | SEO-Wirkung reduziert |

Die Unfähigkeit von KI-Crawlern, JavaScript-gerenderte Inhalte zu erfassen, hat erhebliche geschäftliche Konsequenzen in einer zunehmend KI-getriebenen Suchlandschaft. Wenn Ihre Produktinformationen, Preise und Verfügbarkeiten für KI-Systeme verborgen bleiben, verlieren Sie Sichtbarkeit in KI-generierten Suchergebnissen und KI-basierten Antwortmaschinen wie Perplexity, Google AI Overviews und der Browsing-Funktion von ChatGPT. Diese Unsichtbarkeit führt direkt zu weniger Traffic von KI-Plattformen, die für Konsumenten schnell zu primären Entdeckungskanälen werden. E-Commerce-Unternehmen sind besonders betroffen – wenn Produktpreise und Verfügbarkeiten nicht in KI-Antworten erscheinen, erhalten potenzielle Kunden unvollständige Informationen und kaufen womöglich bei der Konkurrenz. SaaS-Unternehmen stehen vor ähnlichen Herausforderungen: Feature-Beschreibungen, Preismodelle und Integrationsdetails, die von JavaScript verborgen werden, erreichen nie die KI-Systeme, die ihre Lösungen empfehlen könnten. Versteckte Inhalte führen zudem zu Vertrauensproblemen beim Kunden; wenn Nutzer unvollständige oder veraltete Informationen in KI-Antworten sehen, zweifeln sie an der Zuverlässigkeit sowohl des KI-Systems als auch Ihrer Marke. Insgesamt entsteht so ein erheblicher Wettbewerbsnachteil, da KI-bewusste Konkurrenten ihre Inhalte voll zugänglich für diese neuen Entdeckungskanäle machen.

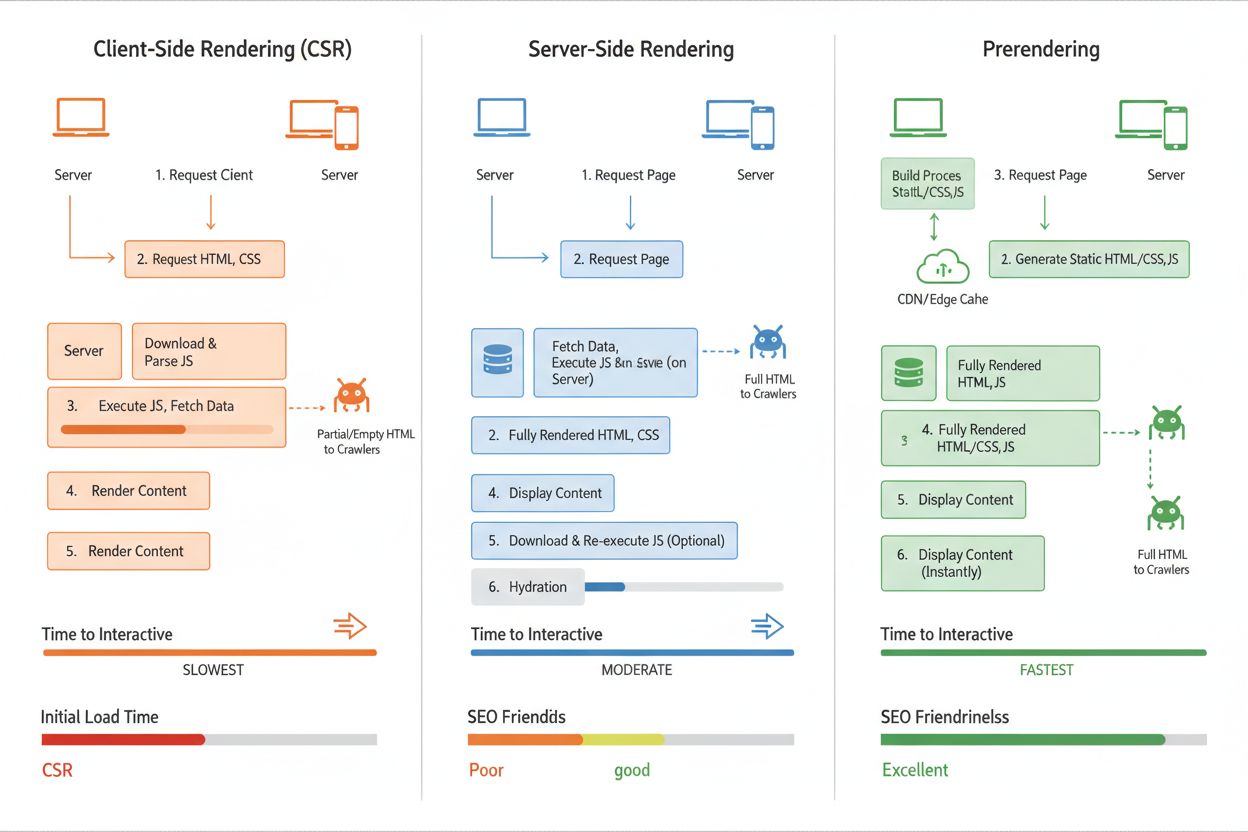

Prerendering ist eine serverseitige Technik, die das JavaScript-Sichtbarkeitsproblem löst, indem sie statische HTML-Snapshots Ihrer Seiten generiert, bevor diese von Crawlern angefragt werden. Im Gegensatz zum Client-Side Rendering (CSR), bei dem Inhalte im Browser des Nutzers generiert werden, führt Prerendering JavaScript auf Ihrem Server aus und speichert das vollständig gerenderte HTML. Dieses statische HTML wird dann KI-Crawlern bereitgestellt, sodass sie vollständige, gerenderte Inhalte erhalten, ohne selbst JavaScript ausführen zu müssen. Prerender.io ist ein Beispiel dafür – es dient als Middleware-Service, der Anfragen von KI-Crawlern abfängt, ihnen prerenderte HTML-Versionen Ihrer Seiten liefert und gleichzeitig normalen Nutzern die dynamische, JavaScript-lastige Version bereitstellt. Der entscheidende Vorteil für KI-Crawler ist, dass sie Inhalte im erwarteten und verarbeitbaren Format erhalten: reines HTML mit bereits aufgelösten dynamischen Inhalten. Das unterscheidet sich von Server-Side Rendering (SSR), bei dem Seiten bei jeder Anfrage gerendert werden und das deutlich mehr Serverressourcen erfordert – für Seiten mit viel Traffic ist das weniger effizient. Prerendering ist besonders elegant, da es nur minimale Anpassungen am bestehenden Code erfordert und dennoch die Zugänglichkeit für KI-Crawler enorm verbessert.

Client-Side Rendering (CSR) ist der gängigste Ansatz für moderne Webanwendungen, bei dem JavaScript im Browser ausgeführt wird, um die Seite dynamisch zu erstellen. Genau hier liegt das Hauptproblem: KI-Crawler erhalten nur leeres oder minimales HTML und alle JavaScript-Inhalte gehen verloren – die KI-Sichtbarkeit leidet stark. Server-Side Rendering (SSR) löst dieses Problem, indem Seiten auf dem Server vor dem Versand an den Client gerendert werden, sodass alle Inhalte im initialen HTML enthalten sind, das KI-Crawler erhalten. Der Nachteil: SSR benötigt erhebliche Serverressourcen, erhöht die Latenz bei jeder Seitenanfrage und wird bei viel Traffic teuer – besonders für stark frequentierte Seiten problematisch. Prerendering bietet das beste Gleichgewicht für KI-Sichtbarkeit: Seiten werden einmalig gerendert und als statisches HTML gecached, das KI-Crawlern bereitgestellt wird, während normale Nutzer weiterhin dynamische JavaScript-Erlebnisse erhalten. So werden Serverlast minimiert, schnelle Ladezeiten für Nutzer beibehalten und KI-Crawler erhalten stets vollständige, gerenderte Inhalte. Für die meisten Unternehmen ist Prerendering die optimale Lösung – es vereint Kosten, Performance und KI-Zugänglichkeit, ohne die Architektur grundlegend ändern zu müssen.

Prerender.io ist der führende Prerendering-Service, der mittels Middleware automatisch KI-Crawler-Anfragen erkennt und ihnen prerenderte HTML-Versionen Ihrer Seiten ausliefert. AmICited.com bietet umfassendes Monitoring der KI-Sichtbarkeit und verfolgt, wie Ihre Marke in Antworten von ChatGPT, Perplexity, Google AI Overviews und anderen großen KI-Systemen erscheint – damit ist es unerlässlich, um die tatsächliche Wirkung Ihrer JavaScript-Rendering-Strategie zu verstehen. Neben Prerendering helfen Tools wie Screaming Frog und Lighthouse dabei, zu prüfen, welche JavaScript-Inhalte für Crawler verborgen bleiben, und Problemstellen zu identifizieren. Wählen Sie eine Lösung passend zu Traffic-Aufkommen, technischer Infrastruktur und den KI-Plattformen, die Sie erreichen wollen; Prerendering eignet sich am besten für inhaltsreiche Seiten mit mittlerem bis hohem Traffic, während SSR für kleinere Anwendungen mit einfachen Anforderungen geeignet ist. Die Integration ist meist unkompliziert – die meisten Prerendering-Services arbeiten als transparente Middleware und erfordern nur minimale Codeänderungen. Für eine ganzheitliche KI-Sichtbarkeitsstrategie sollten Sie eine Prerendering-Lösung mit dem Monitoring von AmICited.com kombinieren, um Ihre Inhalte nicht nur KI-Crawlern zugänglich zu machen, sondern auch den tatsächlichen Geschäftsnutzen dieser Verbesserungen zu messen.

Um die Effektivität Ihrer JavaScript-Rendering-Strategie zu messen, sollten Sie sowohl Crawler-Aktivitäten als auch Geschäftsergebnisse überwachen. KI-Crawler-Access-Logs zeigen, wie häufig GPTBot, ChatGPT-User und OAI-SearchBot Ihre Seite besuchen und welche Seiten sie anfragen – eine steigende Frequenz deutet auf bessere Zugänglichkeit hin. Sichtbarkeitsmetriken durch Tools wie AmICited.com zeigen, ob Ihre Marke, Produkte und Informationen tatsächlich in KI-generierten Antworten erscheinen, und liefern damit einen direkten Nachweis für den Rendering-Erfolg. Prerendering-Verifikationstools können bestätigen, dass KI-Crawler vollständig gerendertes HTML erhalten, indem sie zeigen, wie sich deren Sicht gegenüber der normalen Nutzeransicht unterscheidet. Erwartete Verbesserungen umfassen mehr Erwähnungen in KI-Suchergebnissen, genauere Produktinfos in KI-Antworten und höhere Klickraten von KI-Plattformen auf Ihre Website. Traffic-Attribution von KI-Quellen sollte innerhalb von 2-4 Wochen nach Implementierung des Prerenderings deutlich steigen, besonders bei wichtigen Keywords und Produktanfragen. ROI-Berechnungen sollten den Zuwachs an KI-Traffic, verbesserte Conversion-Raten durch vollständige Produktinfos in KI-Antworten und weniger Support-Anfragen wegen Informationslücken berücksichtigen. Regelmäßiges Monitoring mit AmICited.com stellt sicher, dass Ihre Sichtbarkeit auch bei der Weiterentwicklung von KI-Systemen erhalten bleibt und hilft, neue Optimierungsmöglichkeiten für KI-Zugänglichkeit zu erkennen.

KI-Crawler wie GPTBot und ChatGPT-User setzen Prioritäten auf Geschwindigkeit und Effizienz statt auf Rendering-Fähigkeiten. Die Ausführung von JavaScript erfordert erhebliche Rechenressourcen und Zeit, was im Widerspruch zu ihrem Design steht, Informationen schnell zu extrahieren. Diese Systeme arbeiten mit strengen Timeout-Vorgaben (typischerweise 1-5 Sekunden pro Seite), was die vollständige Ausführung von JavaScript unpraktisch macht. Sie sind darauf ausgelegt, nur das initial vom Server gelieferte HTML zu erfassen, nicht dynamisch gerenderte Inhalte.

Produktinformationen (Preise, Verfügbarkeit, Varianten), lazy-geladene Inhalte (Bilder, Bewertungen, Kommentare), interaktive Elemente (Tabs, Karussells, Modals) und clientseitig gerenderter Text sind am meisten betroffen. Besonders E-Commerce-Seiten leiden darunter, da Produktdetails und Preise oft auf JavaScript basieren. Auch SaaS-Unternehmen stehen vor Herausforderungen, wenn Feature-Beschreibungen und Preismodelle erst durch JavaScript sichtbar werden.

Client-Side Rendering (CSR) generiert Inhalte im Browser des Nutzers mittels JavaScript, worauf KI-Crawler keinen Zugriff haben. Server-Side Rendering (SSR) rendert Seiten bei jeder Anfrage auf Ihrem Server, sodass die Inhalte im initialen HTML enthalten sind – das erfordert jedoch erhebliche Serverressourcen. Prerendering erstellt statische HTML-Snapshots einmalig und cached sie, sodass KI-Crawler sie erhalten, während Nutzer weiterhin dynamische Erlebnisse haben – das bietet die beste Balance zwischen Performance und KI-Zugänglichkeit.

Nutzen Sie Monitoring-Tools wie AmICited.com, um die Aktivitäten von KI-Crawlern zu verfolgen und zu sehen, wie Ihre Inhalte in KI-generierten Antworten erscheinen. Sie können auch KI-Crawler-Anfragen simulieren, indem Sie Browser-Entwicklertools oder Dienste verwenden, die mit GPTBot- und ChatGPT-User-Agents testen. Prerendering-Services bieten häufig Verifikationstools, die zeigen, was KI-Crawler tatsächlich erhalten im Vergleich zu normalen Nutzern.

Ja, JavaScript-Rendering wirkt sich auf beides aus. Während Googlebot JavaScript ausführen kann (mit Einschränkungen), dauert es dennoch länger, JavaScript-lastige Seiten zu crawlen und zu indexieren. Server-Side Rendering oder Prerendering verbessert sowohl die klassische SEO-Performance als auch die KI-Sichtbarkeit, da Inhalte sofort im initialen HTML verfügbar sind, was Crawl-Zeit und Indexierungsdauer verringert.

Prerendering-Services wie Prerender.io berechnen in der Regel nach Anzahl der gerenderten Seiten, mit Preisen ab etwa 50-100 $/Monat für kleine Seiten. Server-Side Rendering erfordert mehr Entwicklungsressourcen, hat aber keine laufenden Servicekosten. Der ROI ist meist innerhalb weniger Wochen positiv durch mehr KI-getriebenen Traffic und bessere Conversion-Raten, weil vollständige Produktinformationen in KI-Antworten erscheinen.

KI-Crawler greifen innerhalb von 24 Stunden auf neu prerenderte Inhalte zu; manche Systeme besuchen Seiten mehrmals täglich. Sie sollten messbare Zuwächse beim KI-getriebenen Traffic innerhalb von 2-4 Wochen nach Umsetzung sehen. Mit AmICited.com können Sie Ihre Sichtbarkeit in Echtzeit überwachen, sobald Ihre Inhalte für KI-Systeme zugänglich werden.

Fokussieren Sie Prerendering auf besonders wertvolle Seiten: Produktseiten, Service-Seiten, wichtige Blogposts, FAQ-Seiten und Standortseiten. Diese Seiten erzielen die größte Sichtbarkeit und Conversion, wenn sie in KI-generierten Antworten erscheinen. Vermeiden Sie das Prerendern von 404-Seiten oder Inhalten mit geringem Wert. So optimieren Sie Ihr Prerendering-Budget und maximieren die Wirkung auf die Seiten, die am ehesten KI-Traffic und Conversions erzeugen.

Verfolgen Sie, wie Ihre Marke in ChatGPT, Perplexity, Google AI Overviews und anderen KI-Systemen erscheint. Erhalten Sie Echtzeit-Einblicke in Ihre KI-Suchsichtbarkeit und optimieren Sie Ihre Content-Strategie.

Erfahren Sie, wie Prerendering JavaScript-Inhalte für KI-Crawler wie ChatGPT, Claude und Perplexity sichtbar macht. Entdecken Sie die besten technischen Lösunge...

Erfahren Sie, wie SSR- und CSR-Rendering-Strategien die Sichtbarkeit für KI-Crawler, Markenzitate in ChatGPT und Perplexity sowie Ihre gesamte Präsenz in der KI...

Erfahren Sie, wie Sie Ihre Inhalte für KI-Crawler wie ChatGPT, Perplexity und Googles KI sichtbar machen. Entdecken Sie technische Anforderungen, Best Practices...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.