GEO vs. SEO: Zentrale Unterschiede und wie sie zusammenwirken

Verstehen Sie die entscheidenden Unterschiede zwischen GEO (Generative Engine Optimization) und SEO (Suchmaschinenoptimierung). Erfahren Sie, wie sich KI-Suche ...

JavaScript SEO ist der Prozess der Optimierung von JavaScript-gerenderten Websites, um sicherzustellen, dass Suchmaschinen Inhalte effektiv crawlen, rendern und indexieren können. Es umfasst Best Practices, um JavaScript-basierte Webanwendungen auffindbar und in den Suchergebnissen platzierbar zu machen, während gleichzeitig optimale Leistung und Benutzererfahrung erhalten bleiben.

JavaScript SEO ist der Prozess der Optimierung von JavaScript-gerenderten Websites, um sicherzustellen, dass Suchmaschinen Inhalte effektiv crawlen, rendern und indexieren können. Es umfasst Best Practices, um JavaScript-basierte Webanwendungen auffindbar und in den Suchergebnissen platzierbar zu machen, während gleichzeitig optimale Leistung und Benutzererfahrung erhalten bleiben.

JavaScript SEO ist die spezialisierte Praxis der Optimierung von JavaScript-gerenderten Websites, um sicherzustellen, dass Suchmaschinen Inhalte effektiv crawlen, rendern und indexieren können. Sie umfasst ein umfassendes Set an technischen Strategien, Best Practices und Implementierungsmethoden, um JavaScript-basierte Webanwendungen vollständig auffindbar und in den Suchergebnissen platzierbar zu machen. Im Gegensatz zu klassischen HTML-basierten Websites, bei denen Inhalte sofort in der Serverantwort verfügbar sind, erfordern JavaScript-gerenderte Inhalte zusätzliche Verarbeitungsschritte, die erheblichen Einfluss darauf haben können, wie Suchmaschinen Ihre Seiten verstehen und ranken. Die Disziplin vereint technisches SEO-Know-how mit Verständnis dafür, wie moderne Webframeworks wie React, Vue und Angular mit Suchmaschinen-Crawlern interagieren. JavaScript SEO ist zunehmend kritisch, da inzwischen 98,7 % der Websites in irgendeiner Form JavaScript verwenden – es ist daher essenzielles Wissen für jeden SEO-Profi, der mit modernen Webtechnologien arbeitet.

Der Aufstieg von JavaScript-Frameworks hat grundlegend verändert, wie Websites gebaut werden und wie Suchmaschinen diese verarbeiten müssen. In den frühen Tagen des Webs hat der Googlebot einfach HTML-Antworten vom Server analysiert, was SEO unkompliziert machte – Inhalte im HTML wurden indexiert. Mit der Verbreitung von Client-Side Rendering (CSR) zur Schaffung interaktiverer und dynamischer Nutzererfahrungen standen Suchmaschinen aber vor einer zentralen Herausforderung: Inhalte waren nicht mehr in der initialen HTML-Antwort enthalten, sondern wurden erst durch JavaScript im Browser generiert. Dieser Wandel erzeugte eine große Lücke zwischen dem, was Nutzer sahen, und dem, was Suchmaschinen anfangs erfassen konnten. Google reagierte mit der Entwicklung von headless Chromium Rendering-Fähigkeiten, sodass Googlebot JavaScript ausführen und das gerenderte DOM verarbeiten kann. Doch dieser Rendering-Prozess ist ressourcenintensiv – etwa 100-mal teurer als das reine Parsen von HTML –, weshalb Google nicht jede Seite sofort rendern kann. Diese Ressourcenbeschränkung führte zum Konzept eines Render-Budgets, bei dem Seiten zur späteren Verarbeitung in Warteschlangen gestellt werden, abhängig von ihrer erwarteten Relevanz und Suchtraffic-Potenzial. Das Verständnis dieser Entwicklung ist entscheidend, denn sie erklärt, warum JavaScript SEO heute keine Option mehr, sondern ein Grundpfeiler jeder modernen technischen SEO-Strategie ist.

Googles Ansatz für JavaScript-gerenderte Inhalte folgt einem ausgeklügelten Drei-Phasen-Prozess, der sich grundlegend vom klassischen HTML-Crawling unterscheidet. In der Crawling-Phase fordert der Googlebot eine URL an und erhält die initiale HTML-Antwort. Diese wird sofort analysiert, um Links zu extrahieren und Indexierungsanweisungen wie robots-Meta-Tags und noindex-Deklarationen zu prüfen. Entscheidend: Ist im initialen HTML ein noindex-Tag enthalten, rendert Google die Seite nicht weiter – ein wichtiger Unterschied, der vielen SEOs entgeht. Gleichzeitig wird die URL für die Rendering-Phase vorgemerkt, in der der Web Rendering Service (WRS) das JavaScript mit Headless Chromium ausführt, das DOM aufbaut und das vollständig gerenderte HTML erzeugt. Dieser Schritt kann Sekunden oder länger dauern, je nach JavaScript-Komplexität, und Seiten können bei knappen Google-Ressourcen lange in der Render-Warteschlange verbleiben. In der abschließenden Indexierungsphase verarbeitet Google das gerenderte HTML, um Inhalte, Links und Metadaten für den Suchindex zu extrahieren. Das Entscheidende: Google indexiert auf Basis des gerenderten HTML, nicht der initialen HTML-Antwort – JavaScript kann also komplett beeinflussen, was tatsächlich indexiert wird. Dieser Drei-Phasen-Prozess erklärt, warum JavaScript-Seiten oft langsamer indexiert werden, warum Render-Verzögerungen wichtig sind und warum der Vergleich von Response-HTML mit gerendertem HTML für die Diagnose von JavaScript-SEO-Problemen unerlässlich ist.

| Rendering-Methode | Funktionsweise | SEO-Vorteile | SEO-Nachteile | Empfohlen für |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Inhalt wird vollständig auf dem Server vor der Auslieferung gerendert | Inhalt sofort im initialen HTML verfügbar; schnelle Indexierung; keine Render-Verzögerung; unterstützt alle Crawler | Höhere Serverlast; langsamere Time to First Byte (TTFB); komplexe Implementierung | SEO-kritische Seiten, E-Commerce, Content-Heavy-Sites, Nachrichtenportale |

| Client-Side Rendering (CSR) | Server sendet minimales HTML; JavaScript rendert Inhalt im Browser | Geringere Serverlast; bessere Skalierbarkeit; schnellere Seitenübergänge für Nutzer | Verzögerte Indexierung; Rendering erforderlich; unsichtbar für LLM-Crawler; langsamere Initial-Ladezeit; beansprucht Crawl-Budget | Webanwendungen, Dashboards, Inhalte hinter Login, nicht SEO-abhängige Seiten |

| Dynamisches Rendering | Server erkennt Crawler und liefert vorgerendertes HTML; Nutzer erhalten CSR | Inhalt sofort für Crawler verfügbar; Balance aus Bot- und Nutzererlebnis; einfacher als SSR | Komplexe Einrichtung; Tool-Abhängigkeit; potenzielle Cloaking-Risiken; Bot-Erkennung notwendig; temporäre Lösung | Große JavaScript-lastige Seiten, SPAs mit Suchsichtbarkeit, Übergangslösung |

| Static Site Generation (SSG) | Inhalt wird beim Build vorgerendert und als statisches HTML ausgeliefert | Schnellste Performance; optimales SEO; keine Render-Verzögerung; exzellente Core Web Vitals | Begrenzte Dynamik; Neuaufbau bei Änderungen erforderlich; ungeeignet für Echtzeit-Daten | Blogs, Dokumentationen, Marketingseiten, selten veränderte Inhalte |

JavaScript-gerenderte Websites stellen mehrere technische Hürden dar, die direkt die SEO-Leistung und Sichtbarkeit beeinflussen. Die grundlegendste Herausforderung ist die Render-Verzögerung – da das Rendering ressourcenintensiv ist, kann Google das Rendern von Seiten um Stunden oder sogar Tage verzögern; Ihr Inhalt wird also nicht sofort nach der Veröffentlichung indexiert. Das ist vor allem für zeitkritische Inhalte wie Nachrichtenartikel oder Produkteinführungen problematisch. Ein weiteres zentrales Problem sind Soft-404-Fehler, die auftreten, wenn Single-Page-Applications einen HTTP-Statuscode 200 auch für nicht-existente Seiten liefern und Suchmaschinen verwirren, welche Seiten indexiert werden sollen. Durch JavaScript hervorgerufene Änderungen an kritischen Elementen sind ein weiteres großes Hindernis: Wenn JavaScript Titel, Canonical-Tags, Meta-Robots-Anweisungen oder interne Links nach der initialen HTML-Antwort modifiziert, können Suchmaschinen falsche Versionen indexieren oder wichtige SEO-Signale übersehen. Das Crawl-Budget-Problem ist besonders bei großen Seiten gravierend – JavaScript-Dateien sind groß und ressourcenintensiv, was dazu führt, dass Google weniger Seiten rendert und Ihre Website weniger tief crawlen kann. Zudem führen LLM-Crawler und KI-Suchtools kein JavaScript aus, wodurch JavaScript-only-Inhalte auf neuen KI-Suchplattformen wie Perplexity, Claude und anderen unsichtbar bleiben. Statistiken zeigen, dass 31,9 % der SEOs nicht sicher sind, ob eine Website stark JavaScript-abhängig ist, und 30,9 % fühlen sich beim Untersuchen von JavaScript-bedingten SEO-Problemen unsicher – ein deutlicher Wissensbedarf in der Branche.

Die Optimierung von JavaScript-gerenderten Inhalten erfordert einen vielschichtigen Ansatz aus technischer Umsetzung und strategischen Entscheidungen. Die wichtigste Best Practice ist, essenzielle Inhalte bereits in der initialen HTML-Antwort bereitzustellen – Titel, Meta-Description, Canonical-Tags und kritische Body-Inhalte sollten im Server-Response vorhanden sein, bevor JavaScript ausgeführt wird. So erhalten Suchmaschinen einen vollständigen ersten Eindruck Ihrer Seite und müssen nicht auf das Rendering warten, um den Inhalt zu verstehen. Blockieren Sie keine JavaScript-Dateien in der robots.txt, da dies Google daran hindert, Seiten korrekt zu rendern; erlauben Sie stattdessen den Zugriff auf alle zum Rendern benötigten Ressourcen. Setzen Sie korrekte HTTP-Statuscodes – verwenden Sie 404 für nicht existente Seiten und 301-Weiterleitungen für verschobene Inhalte, anstatt solche Szenarien per JavaScript zu lösen. Für Single-Page-Anwendungen sollten Sie die History API anstelle von URL-Fragmente verwenden, damit jede Ansicht eine eindeutige, crawlbare URL hat – Fragmente wie #/produkte sind für Suchmaschinen unzuverlässig. Minimieren und verzögern Sie nicht-kritisches JavaScript, um die Renderzeit zu verkürzen und die Core Web Vitals zu verbessern – nutzen Sie Code-Splitting, damit auf jeder Seite nur das nötige JavaScript geladen wird. Implementieren Sie Lazy Loading für Bilder mit dem nativen loading="lazy"-Attribut anstelle von JavaScript-Lösungen, damit Suchmaschinen Bilder auch ohne Rendering entdecken können. Verwenden Sie Content Hashing in JavaScript-Dateinamen (z. B. main.2a846fa617c3361f.js), damit Google erkennt, wann Code geändert wurde und neu geladen werden muss. Testen Sie Ihre Umsetzung gründlich mit dem URL-Prüftool der Google Search Console, Screaming Frog mit aktiviertem Rendering oder dem Response-vs-Render-Report von Sitebulb, um initiales HTML und gerendertes HTML zu vergleichen und Abweichungen zu identifizieren.

Die Wahl des richtigen Rendering-Ansatzes ist eine der wichtigsten Entscheidungen für JavaScript SEO. Server-Side Rendering (SSR) ist der Goldstandard für SEO-kritische Websites, da der Inhalt vollständig auf dem Server gerendert wird, was Render-Verzögerungen eliminiert und allen Crawlern Zugriff auf den Inhalt gibt. Frameworks wie Next.js und Nuxt.js erleichtern die SSR-Implementierung für moderne Entwicklungsteams. Allerdings benötigt SSR mehr Serverressourcen und kann zu einer langsameren Time to First Byte (TTFB) führen, was die Nutzererfahrung beeinflusst. Client-Side Rendering (CSR) eignet sich für Webanwendungen, bei denen SEO nicht im Vordergrund steht, etwa Dashboards oder Tools hinter Logins. CSR entlastet den Server und ermöglicht sehr interaktive Nutzererlebnisse, führt aber zu Indexierungsverzögerungen und macht Inhalte für LLM-Crawler unsichtbar. Dynamisches Rendering ist ein pragmatischer Mittelweg: Es erkennt Suchmaschinen-Crawler und liefert ihnen vorgerendertes HTML, während Nutzer das interaktive CSR-Erlebnis erhalten. Tools wie Prerender.io übernehmen dies automatisch, aber Google betont, dass dies nur eine Übergangslösung ist und langfristig SSR angestrebt werden sollte. Static Site Generation (SSG) eignet sich für Inhalte, die sich selten ändern – der Inhalt wird beim Build vorgerendert und als statisches HTML ausgeliefert, was beste Performance und SEO-Eigenschaften bietet. Die Entscheidung hängt von den SEO-Prioritäten, technischen Ressourcen und der Änderungsfrequenz Ihrer Inhalte ab. Daten zeigen, dass 60 % der SEOs inzwischen JavaScript-Crawler für Audits nutzen, was das zunehmende Bewusstsein für das Thema Rendering in der technischen SEO-Analyse verdeutlicht.

Effektives JavaScript SEO erfordert die kontinuierliche Überwachung spezieller Kennzahlen und Indikatoren, die zeigen, wie Suchmaschinen mit Ihren JavaScript-gerenderten Inhalten interagieren. Zentral ist der Vergleich von Response- und gerendertem HTML – mit Tools wie dem Response vs Render Report von Sitebulb können Sie genau sehen, was JavaScript auf Ihren Seiten verändert, inklusive Titel, Meta-Descriptions, Canonicals, interner Links und Robots-Anweisungen. Statistiken zeigen, dass 18,26 % der JavaScript-Crawls H1-Tags nur im gerenderten HTML (nicht in der initialen Antwort) haben und dass 4,60 % der Audits noindex-Tags nur im Response-HTML aufweisen – ein Worst-Case, bei dem Google das noindex sieht, die Seite nie rendert und Inhalte, die indexiert werden sollten, ignoriert. Das Render-Budget sollte über den Abdeckungsbericht der Google Search Console überwacht werden, der zeigt, wie viele Seiten auf das Rendering warten oder bereits gerendert wurden. Core Web Vitals sind bei JavaScript-Seiten besonders wichtig, da die JavaScript-Ausführung direkt Largest Contentful Paint (LCP), First Input Delay (FID) und Cumulative Layout Shift (CLS) beeinflusst. Überwachen Sie die Indexierungs-Latenz – wie lange nach Veröffentlichung erscheint Ihr Inhalt im Google-Index –, denn JavaScript-Seiten haben hier meist längere Verzögerungen als HTML-Seiten. Vergleichen Sie die Crawl-Effizienz, also die Zahl gecrawlter Seiten im Verhältnis zur Gesamtseitenzahl Ihrer Website; JavaScript-Seiten schneiden hier oft schlechter ab, weil das Rendering ressourcenintensiv ist. Nutzen Sie das URL-Prüftool der Google Search Console, um zu verifizieren, dass kritische Inhalte im von Google gerenderten HTML und nicht nur in der initialen Antwort erscheinen.

Das Aufkommen von KI-basierten Suchplattformen wie Perplexity, ChatGPT, Claude und Google AI Overviews erweitert JavaScript SEO um eine neue Dimension, die über klassische Suchmaschinen hinausgeht. Die meisten LLM-Crawler führen kein JavaScript aus – sie konsumieren das rohe HTML und DOM, wie es in der initialen Serverantwort vorliegt. Das bedeutet: Wenn Ihre kritischen Inhalte, Produktinformationen oder Markenbotschaften erst nach JavaScript-Ausführung erscheinen, sind sie für KI-Suchtools komplett unsichtbar. Das schafft ein doppeltes Sichtbarkeitsproblem: Inhalte, die LLM-Crawler nicht erfassen, erscheinen nicht in KI-Antworten, und Nutzer auf KI-Plattformen finden Ihr Angebot nicht. Für AmICited-Nutzer, die Marken- und Domain-Auftritte in KI-Antworten überwachen, ist das besonders kritisch – ist Ihr JavaScript-Content nicht für LLM-Crawler zugänglich, werden Sie in KI-Zitaten gar nicht aufgeführt. Die Lösung: Wichtige Inhalte müssen bereits in der initialen HTML-Antwort stehen, sodass sie sowohl für klassische Suchmaschinen als auch für KI-Crawler erreichbar sind. Deshalb sind Server-Side Rendering oder Dynamisches Rendering im Zeitalter der KI-Suche noch wichtiger – Ihre Inhalte müssen nicht nur für Googlebot, sondern auch für die wachsende Zahl an KI-Suchtools sichtbar sein, die kein JavaScript ausführen.

Das Umfeld für JavaScript SEO entwickelt sich stetig weiter, während Suchmaschinen und Webtechnologien fortschreiten. Google hat erhebliche Investitionen in die Verbesserung der JavaScript-Rendering-Fähigkeiten getätigt und von einem Zwei-Phasen- (Crawl und Index) auf ein Drei-Phasen-Modell (Crawl, Render und Index) umgestellt, das moderne Webanwendungen besser verarbeitet. Dennoch bleibt Rendering ressourcenbegrenzt und es ist nicht absehbar, dass Google jede Seite sofort rendert oder Render-Budgets abschafft. In der Branche zeigt sich ein Trend zu hybriden Rendering-Ansätzen, bei denen kritische Inhalte serverseitig gerendert werden, während interaktive Elemente clientseitig laufen, um SEO-Bedürfnisse und Nutzererlebnis auszubalancieren. Web Components und Shadow DOM verbreiten sich zunehmend – SEOs müssen verstehen, wie diese Technologien das Rendering durch Suchmaschinen beeinflussen. Der Aufstieg der KI-Suche erzeugt neuen Druck, Inhalte ohne JavaScript-Ausführung zugänglich zu machen, was die Nutzung von SSR und SSG fördern dürfte. Core Web Vitals bleiben ein Rankingfaktor, und der Einfluss von JavaScript auf diese Werte macht Performance-Optimierung untrennbar mit JavaScript SEO verbunden. Branchendaten zeigen, dass nur 10,6 % der SEOs genau verstehen, wie Google JavaScript crawlt, rendert und indexiert – es besteht also erheblicher Weiterbildungsbedarf. Je komplexer JavaScript-Frameworks und je verbreiteter KI-Suchplattformen werden, desto wertvoller und notwendiger wird JavaScript-SEO-Expertise für eine wettbewerbsfähige organische Sichtbarkeit.

main.2a846fa617c3361f.js), damit Google erkennt, wann Code geändert wurde und neu geladen werden mussloading="lazy") statt JavaScript-Lösungen nutzen, um beste Kompatibilität für Crawler zu erreichenJavaScript SEO hat sich von einer Spezialdisziplin zu einem Grundpfeiler der modernen Suchmaschinenoptimierung entwickelt. Da 98,7 % der Websites JavaScript einsetzen und 88 % der SEOs regelmäßig mit JavaScript-abhängigen Seiten arbeiten, ist die Fähigkeit zur Optimierung von JavaScript-gerenderten Inhalten keine Option mehr – sie ist unerlässlich. Die Komplexität der Drei-Phasen-Rendering-Pipeline, die Ressourcengrenzen durch Render-Budgets und das Aufkommen von KI-Suchplattformen stellen mehrdimensionale Herausforderungen dar, die sowohl technisches Wissen als auch strategische Entscheidungen erfordern. Die Zahlen sind ernüchternd: 41,6 % der SEOs haben Googles JavaScript-Dokumentation nicht gelesen, 31,9 % wissen nicht, wie man JavaScript-abhängige Seiten erkennt, und 30,9 % fühlen sich unsicher beim Untersuchen von JavaScript-bedingten Problemen. Der Effekt ist gravierend – 4,60 % der JavaScript-Audits zeigen kritische Fehler wie noindex-Tags nur im Response-HTML, die die Indexierung komplett verhindern. Der Weg nach vorn erfordert Investitionen in Weiterbildung, die Wahl passender Rendering-Strategien und die Umsetzung von Best Practices, damit Inhalte sowohl für Suchmaschinen als auch für KI-Crawler zugänglich sind. Ob über Server-Side Rendering, dynamisches Rendering oder gezielte Optimierung von Client-Side Rendering – das Ziel bleibt: Ihre JavaScript-Inhalte sollen in allen Suchplattformen – von Google bis zu neuen KI-Suchtools – vollständig auffindbar, indexierbar und sichtbar sein. Für Unternehmen, die mit AmICited die Marken-Sichtbarkeit in KI-Antworten überwachen, wird JavaScript SEO noch entscheidender, da nicht optimierte JavaScript-Inhalte für LLM-Crawler unsichtbar bleiben und keine Zitate in KI-Suchergebnissen generieren.

Ja, Google rendert und indexiert JavaScript-Inhalte mithilfe von Headless Chromium. Das Rendering ist jedoch ressourcenintensiv und wird erst durchgeführt, wenn Google über die nötigen Ressourcen verfügt. Google verarbeitet Seiten in drei Phasen: Crawling, Rendering und Indexierung. Seiten mit noindex-Tags werden nicht gerendert, und Rendering-Verzögerungen können die Indexierung verlangsamen. Entscheidend ist, dass das gerenderte HTML – und nicht das ursprüngliche Antwort-HTML – für die Indexierungsentscheidungen von Google verwendet wird.

Laut Daten aus dem Jahr 2024 setzen mittlerweile 98,7% der Websites in gewissem Umfang auf JavaScript. Außerdem verwenden 62,3% der Entwickler JavaScript als primäre Programmiersprache, und 88% der SEOs beschäftigen sich zumindest gelegentlich mit JavaScript-abhängigen Seiten. Diese weite Verbreitung macht JavaScript-SEO-Wissen für moderne SEO-Fachleute unerlässlich.

Herausforderungen sind unter anderem Rendering-Verzögerungen, die die Indexierung verlangsamen, ressourcenintensive Verarbeitung, die das Crawl-Budget belastet, potenzielle Soft-404-Fehler bei Single-Page-Anwendungen und durch JavaScript verursachte Änderungen an kritischen Elementen wie Titeln, Canonicals und Meta-Robots-Tags. Darüber hinaus führen die meisten LLM-Crawler und KI-Suchtools kein JavaScript aus, sodass Inhalte, die erst nach dem Rendering erscheinen, für KI-basierte Suchplattformen unsichtbar bleiben.

Response-HTML ist das initiale HTML, das vom Server gesendet wird (sichtbar unter 'Quelltext anzeigen'). Gerendertes HTML ist das endgültige DOM nach JavaScript-Ausführung (sichtbar im Browser-Inspector). JavaScript kann das DOM erheblich verändern, indem es Inhalte einfügt, Meta-Tags ändert, Titel umschreibt sowie Links hinzufügt oder entfernt. Suchmaschinen indexieren auf Basis des gerenderten HTML, nicht des Response-HTML.

Server-Side Rendering (SSR) ist optimal für SEO, da der Inhalt vollständig auf dem Server gerendert wird, bevor er ausgeliefert wird. Client-Side Rendering (CSR) erfordert, dass Suchmaschinen die Seiten rendern, was zu Verzögerungen und Indexierungsproblemen führt. Beim dynamischen Rendering wird vorgerendertes HTML an Crawler geliefert, während Nutzer CSR erhalten, aber Google empfiehlt dies nur als temporäre Lösung. Die Auswahl sollte sich nach den SEO-Prioritäten und technischen Ressourcen Ihrer Website richten.

Verwenden Sie das URL-Prüftool der Google Search Console: Gehen Sie zur URL-Prüfung, klicken Sie auf 'Live-URL testen' und sehen Sie sich dann den Tab 'HTML' an, um das gerenderte HTML zu sehen, das Google verarbeitet hat. Alternativ können Sie Tools wie Screaming Frog mit aktiviertem Rendering, Sitebulbs Response vs Render Report oder Chrome DevTools verwenden, um das initiale HTML mit dem gerenderten DOM zu vergleichen und JavaScript-bezogene Probleme zu erkennen.

Ein Render-Budget ist die Menge an Ressourcen, die Google zum Rendern von Seiten auf Ihrer Website zuweist. Google priorisiert das Rendering für Seiten, von denen mehr Suchverkehr erwartet wird. JavaScript-lastige Seiten mit niedrigerer Priorität können erhebliche Rendering-Verzögerungen erleben, was die Indexierung verlangsamt. Daher ist es entscheidend, JavaScript so zu optimieren, dass die Renderzeit verkürzt wird, und sicherzustellen, dass wichtige Inhalte bereits in der initialen HTML-Antwort enthalten sind.

Die meisten LLM-Crawler und KI-basierten Suchtools (wie Perplexity, Claude und andere) führen kein JavaScript aus – sie konsumieren das rohe HTML. Wenn Ihre wichtigen Inhalte erst nach JavaScript-Ausführung erscheinen, sind sie sowohl für Googles ersten Crawl als auch für KI-Suchplattformen unsichtbar. Daher ist JavaScript SEO nicht nur für die klassische Suche, sondern auch für Sichtbarkeit und Zitationen in der KI-Suche unerlässlich.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Verstehen Sie die entscheidenden Unterschiede zwischen GEO (Generative Engine Optimization) und SEO (Suchmaschinenoptimierung). Erfahren Sie, wie sich KI-Suche ...

Content-SEO ist die strategische Erstellung und Optimierung hochwertiger Inhalte, um Suchmaschinenrankings und organische Sichtbarkeit zu verbessern. Lernen Sie...

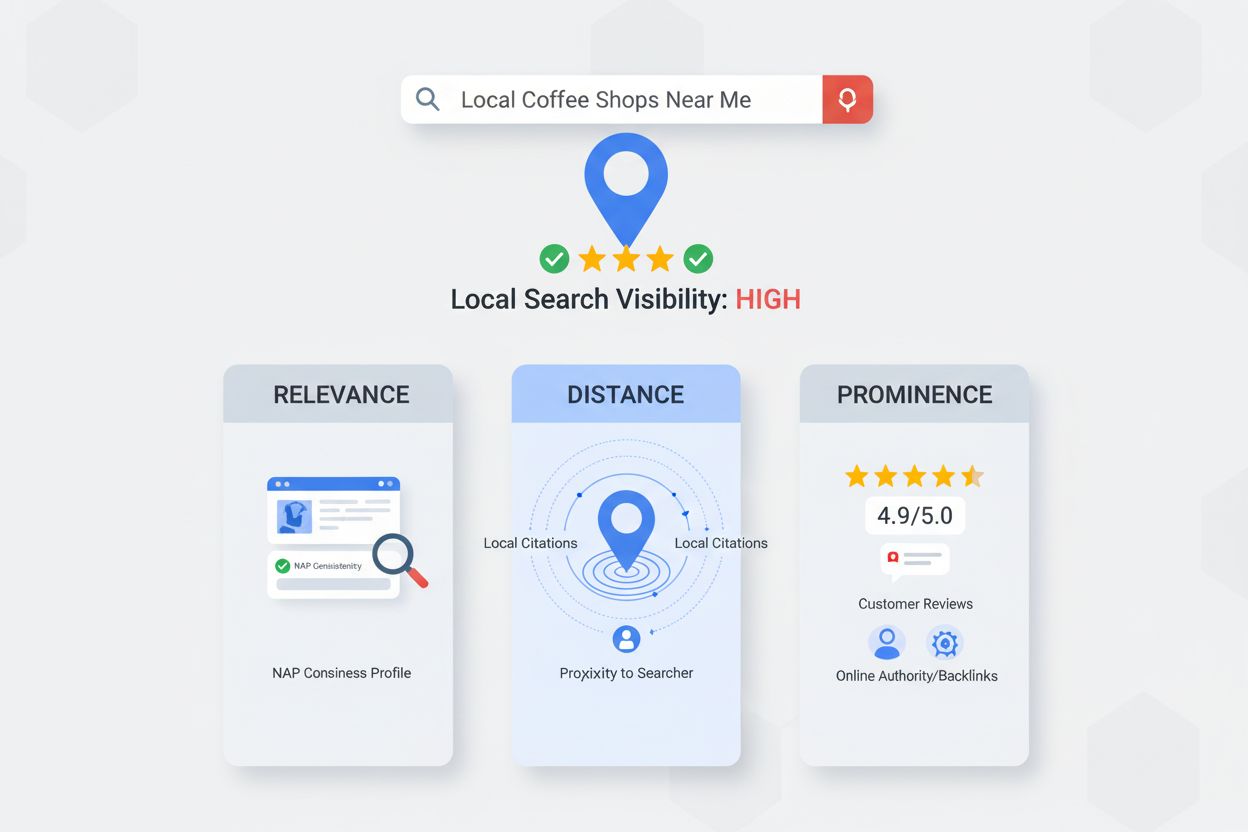

Erfahren Sie, was Google Maps SEO ist, wie es funktioniert und warum es für die lokale Sichtbarkeit von Unternehmen entscheidend ist. Entdecken Sie Ranking-Fakt...