Was ist Large Language Model Optimization (LLMO)? Vollständiger Leitfaden

Erfahren Sie, was LLMO ist, wie es funktioniert und warum es für die Sichtbarkeit im Bereich KI wichtig ist. Entdecken Sie Optimierungstechniken, um Ihre Marke ...

Optimierung großer Sprachmodelle (LLMO) ist die Praxis, Inhalte, Website-Struktur und Markenpräsenz so zu optimieren, dass sie in KI-generierten Antworten von Konversations-KI-Tools wie ChatGPT, Claude, Perplexity und Google Gemini erscheinen. Im Gegensatz zur traditionellen SEO, die sich auf Suchrankings konzentriert, zielt LLMO darauf ab, Marken in LLM-Antworten zu erwähnen, zu zitieren und zu empfehlen, um Sichtbarkeit und Autorität bei KI-gestützter Suche zu steigern.

Optimierung großer Sprachmodelle (LLMO) ist die Praxis, Inhalte, Website-Struktur und Markenpräsenz so zu optimieren, dass sie in KI-generierten Antworten von Konversations-KI-Tools wie ChatGPT, Claude, Perplexity und Google Gemini erscheinen. Im Gegensatz zur traditionellen SEO, die sich auf Suchrankings konzentriert, zielt LLMO darauf ab, Marken in LLM-Antworten zu erwähnen, zu zitieren und zu empfehlen, um Sichtbarkeit und Autorität bei KI-gestützter Suche zu steigern.

Optimierung großer Sprachmodelle (LLMO) ist die strategische Praxis, Inhalte, Website-Architektur und Markenpräsenz so zu optimieren, dass Sichtbarkeit und Zitate innerhalb von KI-generierten Antworten von Konversations-KI-Systemen erreicht werden. Im Gegensatz zur traditionellen Suchmaschinenoptimierung (SEO), die darauf abzielt, Websites in Suchergebnisseiten zu platzieren, richtet sich LLMO auf das wachsende Ökosystem von großen Sprachmodellen wie ChatGPT, Claude, Perplexity und Google Gemini. Das Hauptziel von LLMO ist nicht zwingend, Klicks auf Ihre Website zu generieren, sondern sicherzustellen, dass Ihre Marke erwähnt, empfohlen und zitiert wird, wenn Nutzer mit diesen KI-Systemen interagieren. Dies stellt einen grundlegenden Wandel in der digitalen Sichtbarkeit dar – weg von der Optimierung für Algorithmus-Rankings hin zur Optimierung für KI-gesteuerte Markenbekanntheit und Autorität. Während die KI-Suche weltweit explodiert, mit über 3 Milliarden monatlichen Prompts bei ChatGPT und Google AI Overviews in über 13 % der Suchanfragen, ist LLMO unerlässlich geworden, um wettbewerbsfähig im Discovery-Umfeld der KI-Ära zu bleiben.

Das Aufkommen von großen Sprachmodellen hat die Art und Weise, wie Menschen online suchen und Informationen entdecken, grundlegend verändert. Früher dominierten keywordbasierte Suchanfragen bei Google, Bing und anderen klassischen Suchmaschinen. Nutzer tippten eine Anfrage ein, erhielten eine Liste von Ergebnissen und klickten auf Websites. Dieses Modell schuf klare Anreize: besser ranken, mehr Klicks, mehr Traffic. Die Einführung von Konversations-KI-Systemen hat dieses Paradigma jedoch vollständig verändert. Nutzer stellen heute natürliche Fragen an KI-Assistenten und erhalten direkt zusammengefasste Antworten – ohne verschiedene Links ansehen zu müssen. Diese Verschiebung hat tiefgreifende Auswirkungen auf das digitale Marketing und die Markensichtbarkeit.

Untersuchungen von Semrush zeigen, dass Besucher aus der KI-Suche 4,4-mal besser konvertieren als traditionelle organische Suchbesucher, und LLM-Traffic-Kanäle werden voraussichtlich bis 2027 genauso viel Geschäftsmehrwert liefern wie die traditionelle Suche. Das ist kein Randphänomen – es ist eine grundlegende Transformation des Suchmarktes. Laut Adobe Analytics wuchs der generative KI-Traffic auf US-Einzelhandelsseiten zwischen Juli 2024 und Februar 2025 um 1.200 %, allein in der Weihnachtssaison 2024 gab es einen 1.300%-Anstieg bei KI-Suchverweisen. Gleichzeitig fiel der Marktanteil von Google Search im Oktober 2024 erstmals seit März 2015 unter 90 %, was zeigt, dass alternative Discovery-Kanäle signifikant Marktanteile gewinnen. Der Digital Bloom 2025 AI Citation Report mit über 680 Millionen analysierten Zitaten fand, dass ChatGPT mehr als 3 Milliarden Prompts monatlich verarbeitet, Perplexity über 200 Milliarden URLs indexiert und Google AI Overviews in mehr als 13 % der Suchanfragen erscheinen. Diese Kennzahlen unterstreichen, warum LLMO vom spekulativen Konzept zur operativen Notwendigkeit für Marken geworden ist, die nachhaltige Sichtbarkeit anstreben.

Der Unterschied zwischen parametrischem Wissen (was LLMs während des Trainings gelernt haben) und abgerufenem Wissen (Echtzeitinformationen via Retrieval Augmented Generation, RAG) ist zentral für das Verständnis von LLMO. Etwa 60 % der ChatGPT-Anfragen werden ausschließlich aus parametrischem Wissen beantwortet, ohne Websuche – das bedeutet, dass häufig in autoritativen Quellen erwähnte Entitäten während des Trainings stärkere neuronale Repräsentationen erhalten und wahrscheinlicher abgerufen werden. Für die restlichen 40 % der Anfragen, die Echtzeitinformationen benötigen, nutzen LLMs hybride Abrufsysteme, die semantische Suche und Keyword-Matching kombinieren und so eine 48%ige Verbesserung gegenüber Einzelmethoden erreichen. Diese Dualität erfordert, dass LLMO sowohl Trainingsdaten-Dominanz als auch Echtzeit-Retrieval-Optimierung adressiert.

| Strategie | Hauptfokus | Zielplattformen | Wichtigste Ranking-Signale | Zitationsmechanismus | Messung |

|---|---|---|---|---|---|

| LLMO | Markenerwähnungen in KI-Antworten | ChatGPT, Claude, Perplexity, Gemini | Informationsgewinn, Entitäten-Optimierung, semantische Tiefe | Direkte Zitate in Konversationsantworten | Markenerwähnungen, Share of Voice, Zitierhäufigkeit |

| SEO | Organische Suchrankings | Google, Bing, Yahoo | Backlinks, Keywords, technische Signale | Ranking in SERPs | Keyword-Rankings, organischer Traffic, CTR |

| AEO | Sichtbarkeit in Google AI Overviews | Google-Suchergebnisse | Featured Snippets, strukturierte Daten, E-E-A-T | Aufnahme in KI-generierte Zusammenfassungen | AIO-Erscheinungsrate, Snippet-Position |

| GEO | KI-Sichtbarkeit auf mehreren Plattformen | Alle KI-Antwort-Engines | Plattformübergreifende Autorität, Inhaltsstruktur | Zitate auf verschiedenen KI-Plattformen | Plattformübergreifende Erwähnungsfrequenz, Domainvielfalt |

| Entity SEO | Knowledge Graph-Erkennung | Google Knowledge Graph, Wikidata | Entitätenkonsistenz, Schema-Markup, plattformübergreifende Erwähnungen | Knowledge Panel-Erscheinung | Knowledge Panel-Sichtbarkeit, Entitätenerkennung |

Der Erfolg von LLMO basiert auf fünf miteinander verbundenen Säulen, die unterschiedliche Aspekte abdecken, wie große Sprachmodelle Inhalte entdecken, bewerten und zitieren. Das Verständnis und die systematische Umsetzung dieser Säulen erhöhen die Wahrscheinlichkeit, dass Ihre Marke als Quelle in KI-generierten Antworten ausgewählt wird.

Informationsgewinn bezeichnet, inwieweit Ihre Inhalte originelle, einzigartige Erkenntnisse liefern, die LLMs weder in Trainingsdaten noch in Abrufsystemen sonst gesehen haben. LLMs bevorzugen Inhalte mit neuen Perspektiven, eigenen Daten oder synthetisierten Erkenntnissen gegenüber solchen, die nur bestehende Informationen nacherzählen. Eine Studie der Princeton University zu Generative Engine Optimization zeigt, dass Inhalte mit Zitaten, Statistiken und Links zu glaubwürdigen Datenquellen 30-40 % häufiger von LLMs erwähnt werden als unoptimierte Basisinhalte. Das ist transformativ: Informationsgewinn ist quantifizierbar die wirkungsvollste LLMO-Taktik zur Verbesserung der Sichtbarkeit.

Starker Informationsgewinn entsteht, wenn Sie über Oberflächenabdeckung hinausgehen. Statt „10 Top-SEO-Tipps“ zu schreiben, publizieren Sie beispielsweise „Wie wir unseren organischen Traffic mit unkonventionellen SEO-Taktiken um 300 % gesteigert haben, die Wettbewerber ignorieren“. Solche Inhalte zeigen eigene Methoden, exklusive Erkenntnisse und echten Mehrwert. Praktische Wege für Informationsgewinn sind: (1) Eigene Studien oder Umfragen durchführen; (2) Fallstudien mit konkreten Zahlen und Ergebnissen veröffentlichen; (3) Datenbasierte, kontroverse Standpunkte teilen; (4) Eigene Frameworks oder Methoden vorstellen; (5) Mehrere Quellen zu neuen Einsichten synthetisieren. LLMs erkennen Inhalte mit vielen Originaldaten, Statistiken und Expertenzitaten als autoritativ – und machen sie signifikant wahrscheinlicher zum Bestandteil von KI-Antworten.

Entitäten-Optimierung bedeutet, dass große Sprachmodelle und Suchmaschinen klar erfassen, wer Sie sind, was Sie tun und welche Themen Ihre Autorität ausmachen. Eine Entität ist jede Person, Marke, Ort oder Konzept, das KI-Systeme erkennen und in Wissensgraphen einordnen können. Für Marken bedeutet dies: eine klare „Identitätskarte“ für KI-Systeme schaffen. Dazu gehören: (1) Schema-Markup (Organisation, Person, Produkt, Service) zur expliziten Entitätsdefinition; (2) Google Knowledge Panel beanspruchen und optimieren; (3) Wikidata-Einträge erstellen oder aktualisieren mit Label, Beschreibung, Gründungsjahr, Hauptsitz, Website etc.; (4) Konsistente Erwähnungen auf autoritativen Plattformen wie Wikipedia, LinkedIn, Crunchbase, Branchendirektories aufbauen.

Untersuchungen zeigen: Marken, die auf 4+ Plattformen erwähnt werden, erscheinen 2,8-mal häufiger in ChatGPT-Antworten als solche mit geringerer Präsenz. Dieses Multiplier-Effekt entsteht, weil LLMs Entitätenkonsistenz als Legitimitäts- und Wichtigkeitssignal werten. Wenn Name, Beschreibung und Themen Ihrer Marke plattformübergreifend konsistent erscheinen, entwickeln LLMs stärkere Assoziationen – und empfehlen Ihre Marke wahrscheinlicher. Auch das sameAs-Attribut im Schema-Markup, das Ihre Website mit Wikidata, Wikipedia, LinkedIn etc. verknüpft, stärkt die Entitäts-Erkennung. Ziel ist, dass Ihre Marke als anerkannte Entität im semantischen Netz der KI verankert ist – nicht nur als Website, sondern als eigenständiger, klar verstandener Akteur Ihrer Branche.

Strukturierte Inhalte beschreiben, wie Informationen so organisiert und formatiert werden, dass sie sowohl für Menschen als auch für KI-Systeme leicht verständlich und extrahierbar sind. Eine Analyse von AirOps zu ChatGPT-Zitaten ergab, dass ChatGPT Inhalte mit sequentieller Überschriftenstruktur (H1 > H2 > H3) fast dreimal so häufig zitiert wie schlecht strukturierte Inhalte. Zudem enthalten fast 80 % der in ChatGPT zitierten Artikel mindestens einen Abschnitt mit einer Liste, während dies bei den Top-Ergebnissen von Google nur 28,6 % sind. Erstaunlich: Von ChatGPT zitierte Seiten enthalten durchschnittlich fast 14 Listensektionen – mehr als 17-mal so viele wie typische Google-SERP-Seiten. Das zeigt: LLMs bevorzugen logisch aufgebaute Inhalte mit klaren Orientierungspunkten.

Praktische Umsetzung für LLMO: (1) Beschreibende, fragengestützte Überschriften, die der realen Suche entsprechen („Wie optimiere ich Meta-Beschreibungen für KI-Suche?“ statt „Tipps“); (2) Vergleichstabellen für komplexe Themen; (3) FAQ-Blöcke im Inhalt verteilen (FAQ-Schema ist in LLM-zitierten Inhalten mehr als doppelt so häufig); (4) Nummerierte Listen für Abläufe und Schritt-für-Schritt-Anleitungen; (5) Optimale Absatzlänge von 40-60 Wörtern für KI-Chunking; (6) Definitionslisten für Fachbegriffe („[Begriff] ist [Definition].“). Jeder Abschnitt sollte eigenständig verständlich sein, damit LLMs gezielt Einzelpassagen zitieren können.

Klarheit und Quellenangabe bedeutet, Inhalte verständlich und gut belegt zu schreiben. Eine GEO-Studie der Princeton University und IIT Delhi fand heraus, dass Zitate, Quellen und Verlinkungen die sichtbarkeitssteigerndsten Faktoren für LLMs sind. Intuitiv: KI muss Fakten und Quellen schnell erkennen, um sie in Antworten zu verarbeiten. Klar formulierte, gut belegte Inhalte erleichtern das Zitieren. Praktische Taktiken: (1) Prägnante, faktenbasierte Absätze (2-3 Sätze) mit Schlüsselinformation am Anfang; (2) Korrekte Quellen- und Outbound-Links zu Studien, Regierungsdaten, akademischer Forschung, Expertenmeinungen; (3) Klarheitsförderndes Format – wichtige Wörter fett, nummerierte Listen, Zusammenfassungsboxen, Übergangswörter; (4) Verifizierbare Datenpunkte mit klarer Quellenangabe.

Die Forschung ist eindeutig: Inhalte mit hoher Lesbarkeit und klarer Quellenangabe erhalten deutlich mehr LLM-Zitate. Ein Artikel mit über 10.000 Wörtern und Flesch-Score 55 erhielt 187 Zitate (davon 72 von ChatGPT), während vergleichbare, weniger lesbare kürzere Inhalte nur 3 Zitate bekamen. Klarheit und Quellen sind keine Kür – sie sind Grundvoraussetzung für LLMO-Erfolg. Wenn Sie autoritative Quellen angeben, bauen Sie nicht nur Leser-Vertrauen auf, sondern signalisieren auch den LLMs: Ihr Inhalt ist fundiert und zitierwürdig.

Autorität im LLMO-Kontext beschreibt, wie oft Ihre Marke im Netz, besonders auf von LLMs häufig referenzierten Plattformen, erwähnt und zitiert wird. Eine Analyse von über 7.000 Zitaten ergab: Das Suchvolumen der Marke korreliert mit 0,334 am stärksten mit KI-Sichtbarkeit. Das heißt: Je häufiger nach Ihrem Markennamen gesucht wird, desto wahrscheinlicher erwähnen LLMs Ihre Marke. Autoritätsaufbau erfordert einen Multi-Channel-Ansatz: (1) Erwähnungen auf hochautoritativen Seiten wie Fachpublikationen, Newsportalen und Foren; (2) Unverlinkte Markenerwähnungen durch Journalistenanfragen, HARO, Branchenbeteiligung; (3) Konsistente Publikation in Kernthemenclustern für semantischen Fußabdruck; (4) Authentisches Engagement auf Plattformen wie Reddit und Quora, die LLMs häufig als Quellen nutzen.

Daten zu plattformspezifischen Zitationsmustern zeigen: Reddit dominiert Perplexity-Zitate mit 46,7 %, Wikipedia steht für 47,9 % der ChatGPT-Zitate, und Google AI Overviews zitieren in 93,67 % mindestens ein Top-10-Ergebnis. Das bedeutet: Präsenz auf diesen Plattformen beeinflusst die LLMO-Sichtbarkeit direkt. Zusätzlich zielen 65 % der KI-Bot-Abrufe auf Inhalte, die im letzten Jahr publiziert wurden, und 79 % auf Inhalte, die innerhalb von 2 Jahren aktualisiert wurden – Aktualität ist also entscheidend. Autorität aufzubauen ist ein kontinuierlicher Prozess, der regelmäßige Content-Publikation, Community-Engagement und gezielte Medienarbeit erfordert, damit Ihre Marke auf den von LLMs genutzten Plattformen sichtbar bleibt.

Das Verständnis der technischen Mechanismen, mit denen große Sprachmodelle Quellen abrufen und ranken, ist für eine erfolgreiche LLMO-Strategie unerlässlich. LLMs nutzen zwei Wissenspfade: parametrisches Wissen (im Training gelernt) und abgerufenes Wissen (in Echtzeit via RAG). Für parametrisches Wissen gilt: Häufig in autoritativen Quellen erwähnte Entitäten erhalten stärkere neuronale Repräsentationen und werden eher abgerufen. Rund 22 % der Trainingsdaten großer KI-Modelle stammen von Wikipedia, was die Wikipedia-Dominanz bei ChatGPT-Zitaten erklärt.

Echtzeitabruf erfolgt über hybride Systeme aus semantischer Suche (dichte Vektor-Embeddings) und Keyword-Matching (BM25-Algorithmus), kombiniert via Reciprocal Rank Fusion. Diese Methode bringt eine 48%ige Verbesserung gegenüber Einzelverfahren. Der Ablauf: (1) Query-Encoding – Nutzeranfragen werden als Vektoren kodiert; (2) Hybrider Abruf – semantische und Keyword-Methoden werden kombiniert; (3) Reranking – Cross-Encoder-Modelle bewerten Query-Dokument-Paare gemeinsam, NDCG@10 steigt um 28 %; (4) Generierung – die 5-10 besten Chunks werden als Kontext in den LLM-Prompt eingefügt. Die Chunking-Strategie ist entscheidend: Chunking auf Seitenebene erreicht 0,648 Genauigkeit mit geringster Varianz – Inhalte sollten so strukturiert sein, dass einzelne Absätze (200-500 Wörter) eigenständig zitierbar sind.

Verschiedene LLM-Plattformen nutzen unterschiedliche Architekturen und Zitationsmuster, was maßgeschneiderte Optimierungsansätze erfordert. ChatGPT verlässt sich stark auf parametrisches Wissen aus Trainingsdaten, 87 % der SearchGPT-Zitate entsprechen Bings Top-10-Ergebnissen. Bing-Ranking und Wikipedia-Präsenz sind deshalb für ChatGPT-Sichtbarkeit entscheidend. Perplexity nutzt Echtzeitabruf mit über 200 Milliarden indexierten URLs, Reddit dominiert mit 46,7 % der Zitate – authentisches Reddit-Engagement ist daher essenziell. Google AI Overviews zeigen die stärkste Korrelation mit klassischen Suchrankings, zitieren in 93,67 % mindestens ein Top-10-Ergebnis – starke SEO unterstützt direkt die AIO-Sichtbarkeit. Claude nutzt Brave Search und setzt auf Trust-Signale und faktische Richtigkeit. Da nur 11 % der Domains sowohl von ChatGPT als auch von Perplexity zitiert werden, ist plattformspezifische Optimierung Pflicht.

Die Wirksamkeit von LLMO misst sich an KI-spezifischen Sichtbarkeitsindikatoren statt klassischen SEO-Metriken. Die wichtigsten KPIs sind: (1) Häufigkeit der Markenerwähnungen – wie oft erscheint Ihre Marke plattformübergreifend in LLM-Antworten (monatlich tracken); (2) Share of Voice – Ihr Anteil an Erwähnungen im Vergleich zu Wettbewerbern, Top-Marken erreichen ca. 15 %, Enterprise-Leader 25-30 %; (3) Zitations-Sentiment – sind Erwähnungen positiv, negativ oder neutral (Benchmark >70 % positiv); (4) KI-Verkehr – Besucher von ChatGPT, Perplexity und Co., die 4,4-mal besser konvertieren als traditioneller Traffic; (5) Erweiterung der Themenautorität – Bandbreite der Themen, die LLMs mit Ihrer Marke assoziieren; (6) Zitationsdrift – monatliche Schwankungen, wobei 40-60 % normal sind.

Tools wie Semrush AI Toolkit, Profound, Peec AI und LLMrefs bieten Dashboards für diese KPIs über mehrere Plattformen. Enterprise-Lösungen wie Profound tracken über 240 Mio. ChatGPT-Zitate mit Wettbewerbsvergleich, während Peec AI (89–499 €/Monat) eine schlanke Oberfläche mit Prompt-Reporting bietet. Budget-Optionen wie Otterly.AI und Scrunch AI bieten Freemium-Modelle für kleinere Unternehmen. Entscheidend ist, Basiswerte zu ermitteln, monatliche Ziele zu setzen und anhand plattformspezifischer Daten zu optimieren.

Das LLMO-Umfeld entwickelt sich rasant, wobei mehrere Trends die Zukunft KI-getriebener Markensichtbarkeit prägen. Erstens werden LLM-Plattformen immer spezialisierter – ChatGPT setzt auf Konversationsstärke, Perplexity auf Echtzeitabruf, Google AI Overviews integrieren klassische Suche. Das heißt: One-size-fits-all-LLMO-Strategien werden bald überholt sein, Marken brauchen plattformspezifische Optimierungsansätze. Zweitens werden Zitations-Tracking und Messung datengetrieben, Tools liefern granulare Einblicke zu Zitationsmustern, Sentiment und Wettbewerbspositionierung. Drittens werden Brand-Building-Aktivitäten direkt in der KI-Sichtbarkeit messbar, da Marken-Suchvolumen der stärkste Prädiktor für LLM-Zitate ist – ein Paradigmenwechsel: PR und Markenmarketing sind nicht mehr getrennt von technischer SEO, sondern beeinflussen KI-Sichtbarkeit direkt.

Viertens wird Aktualität immer wichtiger – 65 % der KI-Bot-Abrufe zielen auf Inhalte aus dem letzten Jahr, 79 % auf innerhalb von 2 Jahren aktualisierte Seiten. Statische Evergreen-Strategien werden in der LLMO-Ära unterdurchschnittlich abschneiden, regelmäßige Updates und stetige Optimierung sind gefragt. Fünftens lösen Entitäten-Optimierung und semantische Tiefe die Keyworddichte als Hauptfokus ab. Marken mit starkem semantischen Fußabdruck in mehreren Themen erzielen vielfältigere Zitationschancen. Zuletzt gilt: Plattformübergreifende Präsenz ist unverzichtbar – nur 11 % der Domains werden von ChatGPT und Perplexity gemeinsam zitiert, daher ist Multichannel-Optimierung Pflicht.

Die strategische Konsequenz ist klar: LLMO ist kein einmaliges Optimierungsprojekt, sondern eine kontinuierliche Disziplin mit laufendem Monitoring, plattformspezifischer Strategie-Feinjustierung und Content-Iteration. Organisationen, die LLMO als Kernfunktion auf Augenhöhe mit SEO oder Paid Search etablieren, sichern sich einen überproportionalen Share of Voice in KI-generierten Antworten. Wer LLMO nur als Randtaktik behandelt, verliert im KI-First-Discovery-Umfeld an Sichtbarkeit. Da LLM-Traffic-Kanäle bis 2027 voraussichtlich so wertvoll wie die klassische Suche werden, ist jetzt der Zeitpunkt, LLMO-Kompetenz aufzubauen.

Traditionelle SEO konzentriert sich darauf, Inhalte zu optimieren, um durch Keyword-Targeting, Backlinks und technische Optimierung in Suchmaschinen-Ergebnisseiten (SERPs) besser zu ranken. LLMO hingegen richtet sich an Konversations-KI-Systeme und hat das Ziel, Ihre Marke in KI-generierten Antworten zu erwähnen und zu zitieren. Während SEO darauf abzielt, Klicks aus Suchergebnissen zu erhalten, geht es bei LLMO darum, Markenbekanntheit und Autorität innerhalb von KI-Konversationen aufzubauen. Beide Strategien ergänzen sich – eine starke SEO-Performance korreliert oft mit besserer LLMO-Sichtbarkeit, aber sie erfordern unterschiedliche Optimierungsansätze. LLMO legt mehr Wert auf Informationsgewinn, Entitäten-Optimierung und semantische Tiefe als auf klassische Keyworddichte.

Die fünf Säulen von LLMO sind: (1) Informationsgewinn – Bereitstellung einzigartiger, origineller Erkenntnisse, die LLMs sonst nirgendwo gesehen haben; (2) Entitäten-Optimierung – KI-Systemen helfen, Ihre Marke mit relevanten Themen und Konzepten zu verknüpfen; (3) Strukturierte und semantische Inhalte – Informationen mit klaren Überschriften, Listen und logischem Aufbau organisieren, damit KI sie einfach extrahieren kann; (4) Klarheit und Quellenangabe – prägnante, faktenbasierte Inhalte mit korrekten Zitaten und Quellen verfassen; und (5) Autorität und Erwähnungen – Markenautorität durch Erwähnungen auf hochautoritativen Plattformen und eine konsistente Webpräsenz aufbauen. Studien zeigen, dass die Umsetzung dieser Säulen die KI-Sichtbarkeit im Vergleich zu nicht optimierten Inhalten um 30-40 % steigern kann.

Das Suchvolumen einer Marke ist der stärkste Prädiktor für LLM-Zitate, mit einem Korrelationskoeffizienten von 0,334 – stärker als traditionelle Backlinks. Das bedeutet, dass die Häufigkeit, mit der Menschen nach Ihrem Markennamen suchen, direkt beeinflusst, ob LLMs Sie in Antworten erwähnen. Wenn Nutzer aktiv nach Ihrer Marke suchen, signalisiert dies KI-Systemen, dass Ihre Marke anerkannt und relevant ist. Dies erzeugt einen positiven Kreislauf: Steigende Markenbekanntheit führt zu mehr Marken-Suchanfragen, was die LLM-Sichtbarkeit erhöht und damit wiederum die Markenbekanntheit steigert. Der Aufbau von Marken-Suchvolumen durch digitale PR, Content-Marketing und Community-Engagement ist daher eine entscheidende LLMO-Strategie, die die KI-Sichtbarkeit direkt beeinflusst.

Unterschiedliche LLM-Plattformen verwenden verschiedene Abruf- und Ranking-Mechanismen. ChatGPT verlässt sich stark auf parametrisches Wissen aus den Trainingsdaten, wobei Wikipedia etwa 22 % der wichtigsten LLM-Trainingsdaten und 47,9 % der ChatGPT-Zitate ausmacht. Perplexity verwendet eine Echtzeit-Abrufmethode mit über 200 Milliarden indizierten URLs, wobei Reddit mit 46,7 % der Zitate dominiert. Google AI Overviews weisen eine stärkere Korrelation zu traditionellen Suchrankings auf und zitieren in 93,67 % der Antworten mindestens ein Top-10-Ergebnis. Claude verwendet Brave Search als Backend mit Constitutional AI-Präferenz für vertrauenswürdige Quellen. Das Verständnis dieser plattformspezifischen Muster ist entscheidend – nur 11 % der Domains werden sowohl von ChatGPT als auch von Perplexity zitiert, was bedeutet, dass eine plattformübergreifende Optimierung maßgeschneiderte Strategien für jedes System erfordert.

E-E-A-T (Experience, Expertise, Authoritativeness und Trustworthiness) ist grundlegend für den Erfolg von LLMO. Während E-E-A-T Googles Rahmenwerk zur Bewertung von Inhaltsqualität ist, erkennen auch LLMs diese Signale auf unterschiedliche Weise. Erfahrung wird durch eigene Erkenntnisse und Praxisbeispiele gezeigt. Expertise zeigt sich in Tiefe und umfassender Themenabdeckung. Autorität entsteht durch konsistente Erwähnungen auf hochautoritativen Plattformen und anerkannte Entitäten. Vertrauenswürdigkeit wird durch genaue, gut belegte Inhalte und transparente Urheberschaft aufgebaut. LLMs bewerten E-E-A-T-Signale sprachlich und kontextuell statt über Backlinks – Inhalte, die echte Expertise und Autorität über mehrere Dimensionen hinweg zeigen, werden eher in KI-Antworten zitiert.

Der Erfolg von LLMO wird anhand mehrerer wichtiger Leistungsindikatoren gemessen: (1) Häufigkeit der Markenerwähnungen – wie oft Ihre Marke in LLM-Antworten auf verschiedenen Plattformen erscheint; (2) Share of Voice – Ihr Anteil an Erwähnungen im Vergleich zu Wettbewerbern in Ihrer Branche; (3) Zitations-Sentiment – ob Erwähnungen positiv, negativ oder neutral sind; (4) KI-Verkehr – Besucher, die von ChatGPT, Perplexity und anderen LLMs kommen und 4,4-mal besser konvertieren als traditioneller organischer Traffic; (5) Erweiterung der Themenautorität – die Bandbreite an Themen, mit denen LLMs Ihre Marke verknüpfen; und (6) Zitationsdrift – monatliche Volatilität bei Zitaten (40-60 % normale Schwankung). Tools wie Semrush AI Toolkit, Profound und Peec AI bieten Dashboards, um diese Metriken plattformübergreifend zu verfolgen.

Untersuchungen von über 30 Millionen Zitaten zeigen, dass vergleichende Listicles mit 32,5 % aller KI-Zitate das leistungsstärkste Format sind, gefolgt von How-to-Guides, FAQ/Q&A-Formaten und Produkt-/Servicebeschreibungen. Inhalte, die Fragen direkt im ersten Absatz beantworten, schneiden besser ab als solche, die die Antwort langsam aufbauen. Die optimale Absatzlänge liegt bei 40-60 Wörtern für eine einfache KI-Extraktion und Chunking. Abschnitte mit 100-150 Wörtern zwischen Überschriften haben die höchsten Zitationsraten. Inhalte, die in den letzten 3 Monaten aktualisiert wurden, werden doppelt so häufig zitiert wie ältere Inhalte. Artikel mit über 2.900 Wörtern werden zu 59 % häufiger zitiert als solche unter 800 Wörtern. Die Einbindung von Statistiken erhöht die Sichtbarkeit um 22 %, Zitate steigern sie um 37 %.

Strukturierte Daten (Schema-Markup) beeinflussen den LLM-Abruf zwar nicht direkt wie bei der traditionellen Suche, unterstützen LLMO jedoch indirekt, indem sie Suchmaschinen und Wissensgraphen helfen, Ihre Inhalte besser zu verstehen. Gut implementiertes Schema-Markup hilft, Ihre Entität im Google Knowledge Graph zu etablieren, auf den viele LLMs während des Trainings und Abrufs zugreifen. Priorisierte Schemata für LLMO sind Organization, Person, Article/BlogPosting, HowTo, FAQPage und Product-Schema. Vergleichstabellen mit korrektem HTML-Markup zeigen 47 % höhere KI-Zitationsraten. FAQPage-Schema kommt in LLM-zitierten Inhalten mehr als doppelt so häufig vor wie in traditionellen Google-SERPs. Entscheidend ist, dass Schema LLMs hilft, Inhaltsstruktur und Entitätenbeziehungen zu verstehen, wodurch Ihre Inhalte eher für Zitate in KI-Antworten ausgewählt werden.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, was LLMO ist, wie es funktioniert und warum es für die Sichtbarkeit im Bereich KI wichtig ist. Entdecken Sie Optimierungstechniken, um Ihre Marke ...

Erfahren Sie, wie Sie Ihre Inhalte für die Aufnahme in KI-Trainingsdaten optimieren. Entdecken Sie Best Practices, um Ihre Website durch richtige Inhaltsstruktu...

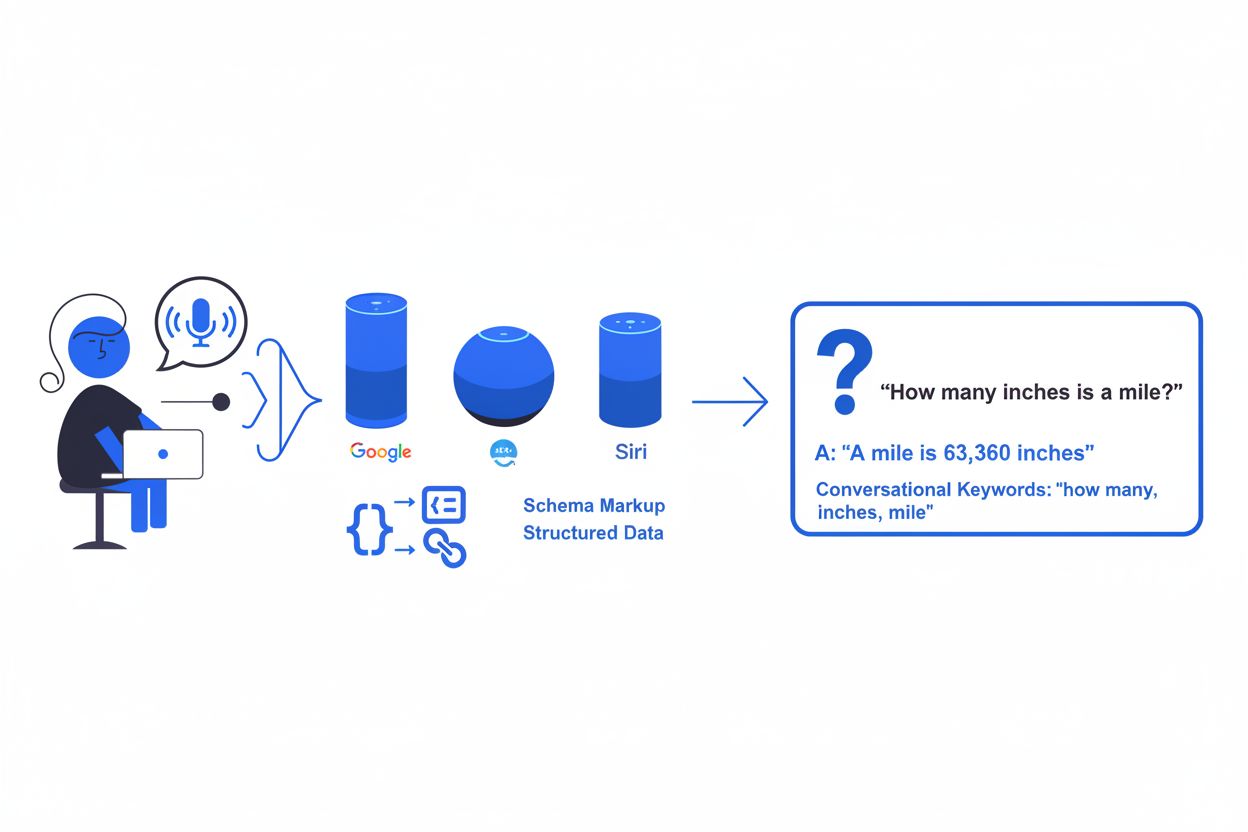

Sprachsuch-Optimierung ist die Praxis, Inhalte gezielt für sprachgesteuerte Suchen aufzubereiten. Erfahren Sie, wie Sie für Alexa, Google Assistant, Siri und an...