AI Crawl Analytics

Erfahren Sie, was KI-Crawl-Analytics ist und wie die Serverprotokollanalyse das Verhalten von KI-Crawlern, Zugriffsmuster auf Inhalte und Sichtbarkeit in KI-ges...

Die Logdateianalyse ist der Prozess der Untersuchung von Serverzugriffsprotokollen, um zu verstehen, wie Suchmaschinen-Crawler und KI-Bots mit einer Website interagieren. Dabei werden Crawling-Muster, technische Probleme und Optimierungspotenziale für die SEO-Leistung aufgedeckt.

Die Logdateianalyse ist der Prozess der Untersuchung von Serverzugriffsprotokollen, um zu verstehen, wie Suchmaschinen-Crawler und KI-Bots mit einer Website interagieren. Dabei werden Crawling-Muster, technische Probleme und Optimierungspotenziale für die SEO-Leistung aufgedeckt.

Die Logdateianalyse ist die systematische Auswertung von Serverzugriffsprotokollen, um zu verstehen, wie Suchmaschinen-Crawler, KI-Bots und Nutzer mit einer Website interagieren. Diese Protokolle werden automatisch vom Webserver erstellt und enthalten detaillierte Aufzeichnungen jeder HTTP-Anfrage an Ihre Seite – einschließlich der IP-Adresse des Anfragenden, Zeitstempel, angeforderter URL, HTTP-Statuscode und User-Agent-String. Für SEO-Profis gilt die Logdateianalyse als maßgebliche Quelle für das Verhalten von Crawlern und deckt Muster auf, die Oberflächentools wie die Google Search Console oder klassische Crawler nicht erfassen können. Anders als simulierte Crawls oder aggregierte Analysedaten liefern Serverprotokolle ungefilterte, primäre Nachweise darüber, was Suchmaschinen und KI-Systeme in Echtzeit auf Ihrer Website tun.

Die Bedeutung der Logdateianalyse ist exponentiell gestiegen, da sich die digitale Landschaft gewandelt hat. Mit über 51 % des weltweiten Internet-Traffics, der inzwischen von Bots erzeugt wird (ACS, 2025), und KI-Crawlern wie GPTBot, ClaudeBot und PerplexityBot, die regelmäßig Websites besuchen, ist das Verständnis des Crawler-Verhaltens nicht mehr optional – es ist essenziell, um die Sichtbarkeit in klassischen und KI-gestützten Suchplattformen zu erhalten. Die Logdateianalyse schließt die Lücke zwischen dem, was Sie über Ihre Website vermuten, und dem, was tatsächlich passiert, und ermöglicht datenbasierte Entscheidungen, die das Ranking, die Indexierungsgeschwindigkeit und die organische Performance direkt beeinflussen.

Die Logdateianalyse ist seit Jahrzehnten ein Grundpfeiler der technischen Suchmaschinenoptimierung, doch ihre Relevanz hat in den letzten Jahren drastisch zugenommen. Historisch stützten sich SEO-Profis vor allem auf die Google Search Console und Drittanbieter-Crawler, um das Verhalten von Suchmaschinen zu verstehen. Diese Tools haben jedoch erhebliche Einschränkungen: Die Search Console liefert lediglich aggregierte, gesampelte Daten vom Google-Crawler; Drittanbieter-Crawler simulieren das Verhalten von Suchmaschinen, statt tatsächliche Interaktionen zu erfassen; und keines der Tools erfasst das Verhalten von Nicht-Google-Suchmaschinen oder KI-Bots zuverlässig.

Das Aufkommen von KI-gestützten Suchplattformen hat das Spielfeld grundlegend verändert. Laut einer Cloudflare-Studie aus 2024 entfallen 39 % des gesamten KI- und Such-Crawler-Traffics auf den Googlebot, während KI-spezifische Crawler das am schnellsten wachsende Segment darstellen. Allein Metas KI-Bots generieren 52 % des KI-Crawler-Traffics – mehr als doppelt so viel wie Google (23 %) oder OpenAI (20 %). Das bedeutet, dass Websites mittlerweile von Dutzenden verschiedener Bot-Typen besucht werden, von denen viele klassische SEO-Protokolle oder robots.txt-Regeln nicht beachten. Die Logdateianalyse ist die einzige Methode, die dieses vollständige Bild erfasst und ist daher unverzichtbar für die moderne SEO-Strategie.

Der weltweite Markt für Log-Management wird voraussichtlich von 3.228,5 Millionen US-Dollar im Jahr 2025 bis 2029 deutlich wachsen und dabei eine durchschnittliche jährliche Wachstumsrate (CAGR) von 14,6 % erreichen. Dieses Wachstum spiegelt das zunehmende Bewusstsein in Unternehmen wider, dass Log-Analysen essenziell für Sicherheit, Performance-Monitoring und SEO-Optimierung sind. Organisationen investieren verstärkt in automatisierte Log-Analyse-Tools und KI-basierte Plattformen, die Millionen von Logeinträgen in Echtzeit verarbeiten und Rohdaten in umsetzbare Erkenntnisse umwandeln, die den Unternehmenserfolg fördern.

Wenn ein Nutzer oder Bot eine Seite Ihrer Website aufruft, verarbeitet der Webserver diese Anfrage und protokolliert detaillierte Informationen über die Interaktion. Dieser Prozess läuft automatisch und fortlaufend ab und erzeugt eine lückenlose Aufzeichnung sämtlicher Serveraktivitäten. Das Verständnis dieses Prozesses ist entscheidend, um Logdaten korrekt interpretieren zu können.

Der typische Ablauf beginnt, wenn ein Crawler (sei es Googlebot, ein KI-Bot oder der Browser eines Nutzers) eine HTTP-GET-Anfrage an Ihren Server sendet, die einen User-Agent-String zur Identifizierung enthält. Ihr Server empfängt die Anfrage, verarbeitet sie und liefert einen HTTP-Statuscode zurück (200 für Erfolg, 404 für nicht gefunden, 301 für permanente Weiterleitung usw.) sowie den angeforderten Inhalt. Jede dieser Interaktionen wird als Zeitstempel-Eintrag im Serverzugriffsprotokoll festgehalten und enthält IP-Adresse, angeforderte URL, HTTP-Methode, Statuscode, Antwortgröße, Referrer und User-Agent-String.

HTTP-Statuscodes sind besonders wichtig für die SEO-Analyse. Ein 200-Statuscode signalisiert eine erfolgreiche Auslieferung; 3xx-Codes stehen für Weiterleitungen; 4xx-Codes für Client-Fehler (z. B. 404 Nicht gefunden); und 5xx-Codes für Serverfehler. Durch die Analyse der Verteilung dieser Statuscodes in Ihren Logs erkennen Sie technische Probleme, die das Crawlen Ihrer Inhalte verhindern. Beispielsweise deuten mehrere 404-Antworten für wichtige Seiten darauf hin, dass Links defekt sind oder Inhalte fehlen, was sofortige Korrekturen erfordert.

User-Agent-Strings sind ebenso entscheidend, um zu identifizieren, welche Bots Ihre Seite besuchen. Jeder Crawler hat einen einzigartigen User-Agent-String. Der Googlebot enthält z. B. „Googlebot/2.1“, der GPTBot „GPTBot/1.0“, und der ClaudeBot „ClaudeBot“. Durch das Parsen dieser Strings können Sie Ihre Logdaten nach Crawler-Typ segmentieren und erkennen, welche Bots welchen Content priorisieren und wie sich ihre Crawling-Muster unterscheiden. Diese granulare Analyse ermöglicht gezielte Optimierungsstrategien für verschiedene Suchplattformen und KI-Systeme.

| Aspekt | Logdateianalyse | Google Search Console | Drittanbieter-Crawler | Analytics-Tools |

|---|---|---|---|---|

| Datenquelle | Serverprotokolle (First-Party) | Google-Crawl-Daten | Simulierte Crawls | Nutzerverhaltenserfassung |

| Vollständigkeit | 100 % aller Anfragen | Gesampelte, aggregierte Daten | Nur simuliert | Nur menschlicher Traffic |

| Bot-Abdeckung | Alle Crawler (Google, Bing, KI-Bots) | Nur Google | Simulierte Crawler | Keine Bot-Daten |

| Historische Daten | Vollständige Historie (je nach Aufbewahrung) | Begrenzter Zeitraum | Einzelner Crawl-Snapshot | Historisch verfügbar |

| Echtzeit-Einblicke | Ja (bei Automatisierung) | Verzögerte Berichte | Nein | Verzögerte Berichte |

| Crawl-Budget-Transparenz | Exakte Crawl-Muster | Zusammenfassende Übersicht | Geschätzt | Nicht anwendbar |

| Technische Probleme | Detailliert (Statuscodes, Antwortzeiten) | Eingeschränkt sichtbar | Simulierte Probleme | Nicht anwendbar |

| KI-Bot-Tracking | Ja (GPTBot, ClaudeBot, usw.) | Nein | Nein | Nein |

| Kosten | Kostenlos (Serverprotokolle) | Kostenlos | Kostenpflichtige Tools | Kostenlos/kostenpflichtig |

| Einrichtungsaufwand | Mittel bis hoch | Einfach | Einfach | Einfach |

Die Logdateianalyse ist unverzichtbar, um zu verstehen, wie Suchmaschinen und KI-Systeme mit Ihrer Website interagieren. Im Gegensatz zur Google Search Console, die nur Googles Sicht und aggregierte Daten liefert, erfassen Logdateien das vollständige Bild aller Crawler-Aktivitäten. Diese umfassende Sicht ist essenziell, um Crawl-Budget-Verschwendung zu erkennen, bei der Suchmaschinen Ressourcen auf weniger wichtige Seiten statt auf relevante Inhalte verwenden. Studien zeigen, dass große Websites häufig 30–50 % ihres Crawl-Budgets auf nicht-essenzielle URLs wie paginierte Archive, Facettensuche oder veraltete Inhalte verschwenden.

Der Aufstieg der KI-gestützten Suche macht die Logdateianalyse noch wichtiger. Da KI-Bots wie GPTBot, ClaudeBot und PerplexityBot zu regelmäßigen Besuchern werden, ist es unerlässlich, deren Verhalten zu verstehen, um die Sichtbarkeit in KI-generierten Antworten zu optimieren. Diese Bots verhalten sich oft anders als klassische Suchmaschinen-Crawler – sie ignorieren möglicherweise robots.txt-Regeln, crawlen aggressiver oder fokussieren bestimmte Content-Typen. Nur die Logdateianalyse deckt diese Muster auf und ermöglicht es, die Seite gezielt für KI-Entdeckung zu optimieren und Bot-Zugriffe durch gezielte Regeln zu steuern.

Technische SEO-Probleme, die sonst unerkannt bleiben, lassen sich durch Loganalysen entdecken. Weiterleitungsketten, 5xx-Fehler, langsame Ladezeiten und JavaScript-Rendering-Probleme hinterlassen alle Spuren in den Serverlogs. Durch die Analyse dieser Muster können Sie Korrekturen priorisieren, die die Zugänglichkeit für Suchmaschinen und die Indexierungsgeschwindigkeit direkt beeinflussen. Zeigen die Logs beispielsweise, dass der Googlebot bei bestimmten Bereichen Ihrer Seite regelmäßig 503-Fehler erhält, wissen Sie sofort, wo Sie technische Optimierungen ansetzen müssen.

Der erste Schritt der Logdateianalyse ist der Zugriff auf Ihre Serverprotokolle – der Prozess variiert je nach Hosting-Umgebung. Für selbst gehostete Server mit Apache oder NGINX liegen die Logs typischerweise in /var/log/apache2/access.log bzw. /var/log/nginx/access.log. Der Zugriff erfolgt direkt per SSH oder über den Dateimanager des Servers. Bei verwalteten WordPress-Hostern wie WP Engine oder Kinsta sind die Logs meist im Hosting-Dashboard oder per SFTP verfügbar, manche Anbieter schränken den Zugriff jedoch zum Schutz der Serverleistung ein.

Content Delivery Networks (CDNs) wie Cloudflare, AWS CloudFront und Akamai erfordern spezielle Konfigurationen für den Logzugriff. Cloudflare bietet Logpush, das HTTP-Anfragelogs an vorgesehene Speicherorte (AWS S3, Google Cloud Storage, Azure Blob Storage) sendet. AWS CloudFront ermöglicht Standardprotokollierung, die in S3-Buckets gespeichert werden kann. Diese CDN-Logs sind essentiell, um zu verstehen, wie Bots mit Ihrer Website interagieren, wenn Inhalte über ein CDN ausgeliefert werden, da sie Anfragen am Rand und nicht am Ursprung protokollieren.

Shared Hosting-Umgebungen bieten oft nur eingeschränkten Logzugriff. Anbieter wie Bluehost und GoDaddy stellen über cPanel meist nur Teilprotokolle bereit, die zudem häufig rotiert werden und wichtige Felder ausschließen können. Wenn Sie auf Shared Hosting umfassende Loganalysen benötigen, ist ein Umstieg auf VPS oder Managed Hosting mit vollem Logzugriff ratsam.

Nach dem Erhalt Ihrer Logs ist eine Datenaufbereitung unerlässlich. Roh-Logdateien enthalten Anfragen aller Quellen – Nutzer, Bots, Scraper und bösartige Akteure. Für SEO-Analysen sollten Sie irrelevanten Traffic herausfiltern und sich auf Suchmaschinen- und KI-Bot-Aktivitäten konzentrieren. Typische Schritte sind:

Die Logdateianalyse liefert Einblicke, die anderen SEO-Tools verborgen bleiben, und ist Basis strategischer Optimierungsentscheidungen. Ein besonders wertvoller Einblick ist die Analyse der Crawling-Muster, die exakt zeigt, welche Seiten von Suchmaschinen wie häufig besucht werden. Das Tracking der Crawl-Frequenz im Zeitverlauf ermöglicht die Erkennung, ob Google bestimmten Bereichen Ihrer Seite mehr oder weniger Aufmerksamkeit schenkt. Plötzliche Rückgänge können auf technische Probleme oder Veränderungen im Seitenwert hindeuten, während Zuwächse positive Reaktionen auf Optimierungen signalisieren.

Effizienz des Crawl-Budgets ist ein weiterer zentraler Punkt. Durch die Auswertung des Verhältnisses erfolgreicher (2xx) zu Fehler-Antworten (4xx, 5xx) erkennen Sie Bereiche Ihrer Seite, in denen Crawler auf Probleme stoßen. Liefert ein bestimmtes Verzeichnis regelmäßig 404-Fehler, wird das Crawl-Budget für defekte Links verschwendet. Verbringen Crawler überproportional viel Zeit auf paginierten URLs oder Facettensuche, wird Budget auf minderwertigen Content verschwendet. Die Loganalyse quantifiziert diese Verschwendung und erlaubt die Berechnung des Optimierungspotentials.

Verwaiste Seiten (Orphaned Pages) zu entdecken, ist ein einzigartiger Vorteil der Logdateianalyse. Orphaned Pages sind URLs ohne interne Verlinkung und liegen außerhalb der Seitenstruktur. Klassische Crawler finden diese Seiten oft nicht, da sie nicht intern verlinkt sind. Logdateien zeigen jedoch, dass Suchmaschinen sie dennoch crawlen – etwa durch externe Links oder alte Sitemaps. Durch die Identifikation dieser Seiten können Sie entscheiden, ob sie wieder in die Navigation aufgenommen, weitergeleitet oder gelöscht werden sollen.

Die Analyse des KI-Bot-Verhaltens gewinnt zunehmend an Bedeutung. Durch die Segmentierung der Logs nach KI-Bot-User-Agents erkennen Sie, welche Inhalte diese Bots priorisieren, wie oft sie kommen und ob sie auf technische Barrieren stoßen. Wenn GPTBot z. B. regelmäßig Ihre FAQ-Seiten, aber selten den Blog crawlt, deutet dies darauf hin, dass KI-Systeme FAQ-Inhalte für Trainingsdaten wertvoller einstufen. Diese Erkenntnisse fließen in Ihre Content-Strategie und helfen, die Sichtbarkeit für KI gezielt zu erhöhen.

Eine erfolgreiche Logdateianalyse erfordert die richtigen Tools und eine strategische Herangehensweise. Screaming Frogs Log File Analyzer ist eines der beliebtesten spezialisierten Tools und bietet benutzerfreundliche Oberflächen zur Verarbeitung großer Logdateien, Erkennung von Bot-Mustern und Visualisierung der Crawldaten. Botify liefert Loganalysen auf Enterprise-Niveau, verknüpft mit SEO-Kennzahlen, sodass Sie Bot-Aktivitäten direkt mit Rankings und Traffic in Beziehung setzen können. seoClaritys Bot Clarity integriert die Loganalyse direkt in die SEO-Plattform und macht es einfach, Crawl-Daten mit anderen SEO-Kennzahlen zu verbinden.

Für Unternehmen mit großem Traffic oder komplexer Infrastruktur bieten KI-basierte Loganalyse-Plattformen wie Splunk, Sumo Logic und Elastic Stack fortschrittliche Funktionalitäten wie automatisierte Mustererkennung, Anomalie-Erkennung und Predictive Analytics. Diese Plattformen verarbeiten Millionen Logeinträge in Echtzeit, erkennen neue Bot-Typen automatisch und melden ungewöhnliche Aktivitäten, die auf Sicherheitsbedrohungen oder technische Probleme hindeuten können.

Best Practices für die Logdateianalyse sind:

Mit wachsender Bedeutung von KI-gestützter Suche ist das KI-Bot-Monitoring per Logdateianalyse zu einer zentralen SEO-Aufgabe geworden. Durch die Nachverfolgung, welche KI-Bots Ihre Seite besuchen, welche Inhalte sie aufrufen und wie oft sie crawlen, erkennen Sie, wie Ihre Inhalte in KI-gestützte Suchsysteme und generative KI-Modelle einfließen. Diese Daten ermöglichen fundierte Entscheidungen darüber, ob Sie bestimmte KI-Bots zulassen, blockieren oder drosseln – etwa über robots.txt oder HTTP-Header.

Die Crawl-Budget-Optimierung ist wohl die wirkungsvollste Anwendung der Logdateianalyse. Für große Websites mit Tausenden oder Millionen Seiten ist das Crawl-Budget eine begrenzte Ressource. Durch die Auswertung der Logs erkennen Sie Seiten, die im Verhältnis zu ihrer Bedeutung übercrawlt werden, und Seiten, die häufiger gecrawlt werden sollten, es aber nicht werden. Häufige Szenarien für Crawl-Budget-Verschwendung sind:

Durch Maßnahmen wie robots.txt, Canonicals, Noindex-Tags oder technische Optimierungen lenken Sie das Crawl-Budget gezielt auf wertvolle Inhalte und verbessern die Indexierungsgeschwindigkeit und Suchsichtbarkeit der für Ihr Unternehmen wichtigsten Seiten.

Die Zukunft der Logdateianalyse wird maßgeblich durch die rasante Entwicklung der KI-gestützten Suche geprägt. Mit dem Eintritt immer neuer KI-Bots und wachsender Komplexität ihres Verhaltens wird die Logdateianalyse noch wichtiger, um zu verstehen, wie Ihre Inhalte von KI-Systemen gefunden, aufgerufen und verwendet werden. Zu den Trends zählen:

Echtzeit-Loganalyse auf Basis von Machine Learning wird es SEOs ermöglichen, Crawl-Probleme innerhalb von Minuten statt Tagen zu erkennen und zu beheben. Automatisierte Systeme identifizieren neue Bot-Typen, melden ungewöhnliche Muster und schlagen Optimierungsmaßnahmen ohne manuelles Eingreifen vor. Dieser Wandel von reaktiver zu proaktiver Analyse ermöglicht es, Crawlbarkeit und Indexierung kontinuierlich optimal zu halten.

Integration mit KI-Sichtbarkeits-Tracking verbindet Logdaten mit Metriken zur KI-Suchperformance. Statt isolierter Loganalyse werden SEOs Crawler-Verhalten mit der tatsächlichen Sichtbarkeit in KI-generierten Antworten verknüpfen und so exakt nachvollziehen, wie Crawl-Muster KI-Suchergebnisse beeinflussen. Diese Integration liefert nie dagewesene Einblicke, wie Inhalte vom Crawl über das Training von KI-Modellen bis zur KI-Antwort an Nutzer gelangen.

Ethik beim Bot-Management wird wichtiger, wenn Unternehmen entscheiden müssen, welchen KI-Bots sie Zugang zu ihren Inhalten gewähren. Die Logdateianalyse ermöglicht eine granulare Steuerung des Bot-Zugriffs, sodass Publisher nützliche KI-Crawler zulassen und jene blockieren können, die keinen Mehrwert oder keine Attribution bieten. Standards wie das entstehende LLMs.txt-Protokoll bieten strukturierte Möglichkeiten zur Kommunikation von Bot-Policies, und die Loganalyse kann die Einhaltung überprüfen.

Datenschutzfreundliche Analysen werden weiterentwickelt, um detaillierte Crawl-Einblicke mit Regularien wie der DSGVO zu vereinen. Fortschrittliche Anonymisierungstechniken und datenschutzorientierte Analysetools ermöglichen es Unternehmen, wertvolle Erkenntnisse aus Logs zu gewinnen, ohne personenbezogene Daten zu speichern oder offenzulegen. Dies wird besonders wichtig, da Loganalysen weiter verbreitet werden und Datenschutzanforderungen steigen.

Durch die Verschmelzung von klassischem SEO und KI-Suchoptimierung bleibt die Logdateianalyse auf Jahre hinaus ein Grundpfeiler der technischen SEO-Strategie. Organisationen, die die Logdateianalyse heute meistern, werden auch künftig Sichtbarkeit und Performance im sich wandelnden Suchumfeld sichern.

Die Logdateianalyse liefert vollständige, ungesampelte Daten direkt von Ihrem Server und erfasst jede Anfrage aller Crawler, während die Crawling-Statistiken der Google Search Console nur aggregierte, gesampelte Daten von Googles Crawlern anzeigen. Logdateien bieten granulare historische Daten und Einblicke in das Verhalten von Nicht-Google-Bots, einschließlich KI-Crawler wie GPTBot und ClaudeBot, wodurch sie umfassender für das Verständnis des tatsächlichen Crawler-Verhaltens sind und technische Probleme aufdecken, die GSC möglicherweise übersieht.

Für stark frequentierte Websites wird eine wöchentliche Logdateianalyse empfohlen, um Probleme frühzeitig zu erkennen und Änderungen im Crawling-Muster zu überwachen. Kleinere Websites profitieren von monatlichen Auswertungen, um Trends zu erkennen und neue Bot-Aktivitäten festzustellen. Unabhängig von der Seitengröße hilft die kontinuierliche Überwachung mit automatisierten Tools, Anomalien in Echtzeit zu erkennen und schnell auf Crawl-Budget-Verschwendung oder technische Probleme zu reagieren, die die Sichtbarkeit in der Suche beeinträchtigen.

Ja, die Logdateianalyse ist eine der effektivsten Methoden, um KI-Bot-Traffic zu verfolgen. Durch die Auswertung von User-Agent-Strings und IP-Adressen in den Serverprotokollen können Sie erkennen, welche KI-Bots Ihre Website besuchen, welche Inhalte sie aufrufen und wie häufig sie crawlen. Diese Daten sind entscheidend, um zu verstehen, wie Ihre Inhalte in KI-gestützte Suchtools und generative KI-Modelle einfließen. So können Sie die Sichtbarkeit für KI optimieren und den Bot-Zugriff gezielt über robots.txt steuern.

Die Logdateianalyse deckt zahlreiche technische SEO-Probleme auf, darunter Crawl-Fehler (4xx- und 5xx-Statuscodes), Weiterleitungsketten, langsame Ladezeiten, verwaiste Seiten ohne interne Verlinkung, Verschwendung des Crawl-Budgets auf minderwertigen URLs, JavaScript-Rendering-Probleme und Duplicate-Content-Probleme. Sie identifiziert auch gefälschte Bot-Aktivitäten und hilft, festzustellen, wann legitime Crawler auf Zugriffsbarrieren stoßen, sodass Sie gezielt Korrekturen priorisieren können, die die Sichtbarkeit und Indexierung verbessern.

Die Logdateianalyse zeigt genau, welche Seiten Suchmaschinen crawlen und wie häufig, und offenbart, wo Crawl-Budget für minderwertige Inhalte wie paginierte Archive, Facettensuche oder veraltete URLs verschwendet wird. Indem Sie diese Ineffizienzen erkennen, können Sie Ihre robots.txt-Datei anpassen, die interne Verlinkung für wichtige Seiten verbessern und Canonicals einsetzen, um die Crawler auf wertvolle Inhalte zu lenken. So stellen Sie sicher, dass Suchmaschinen sich auf die für Ihr Unternehmen wichtigsten Seiten konzentrieren.

Server-Logdateien erfassen typischerweise IP-Adressen (zur Identifizierung der Anfragenquelle), Zeitstempel (wann Anfragen erfolgten), HTTP-Methoden (meist GET oder POST), angeforderte URLs (genau aufgerufene Seiten), HTTP-Statuscodes (200, 404, 301 usw.), Antwortgrößen in Bytes, Referrer-Informationen und User-Agent-Strings (zur Identifizierung des Crawlers oder Browsers). Diese umfassenden Daten ermöglichen es SEOs, jede Serverinteraktion exakt nachzuvollziehen und Muster zu erkennen, die die Crawl- und Indexierbarkeit beeinflussen.

Gefälschte Bots geben sich als legitime Suchmaschinen-Crawler aus, nutzen jedoch IP-Adressen, die nicht mit den offiziellen IP-Bereichen der Suchmaschinen übereinstimmen. Um sie zu identifizieren, gleichen Sie User-Agent-Strings (wie 'Googlebot') mit den von Google, Bing und anderen Suchmaschinen veröffentlichten IP-Bereichen ab. Tools wie der Log File Analyzer von Screaming Frog überprüfen die Echtheit automatisch. Gefälschte Bots verschwenden Crawl-Budget und können Ihren Server belasten, daher empfiehlt sich das Blockieren über robots.txt oder Firewalleinstellungen.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, was KI-Crawl-Analytics ist und wie die Serverprotokollanalyse das Verhalten von KI-Crawlern, Zugriffsmuster auf Inhalte und Sichtbarkeit in KI-ges...

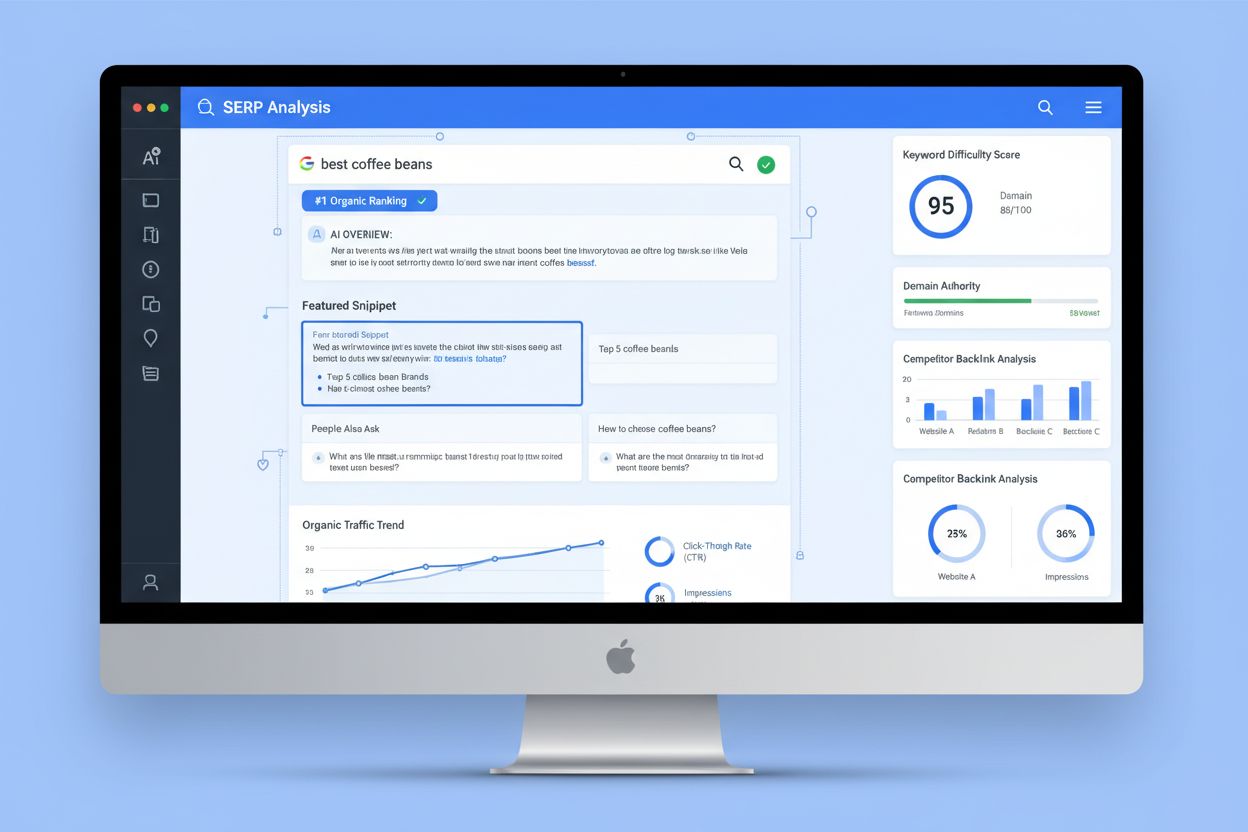

Die SERP-Analyse ist der Prozess, Suchergebnisseiten zu untersuchen, um die Ranking-Schwierigkeit, Suchintention und Wettbewerbsstrategien zu verstehen. Erfahre...

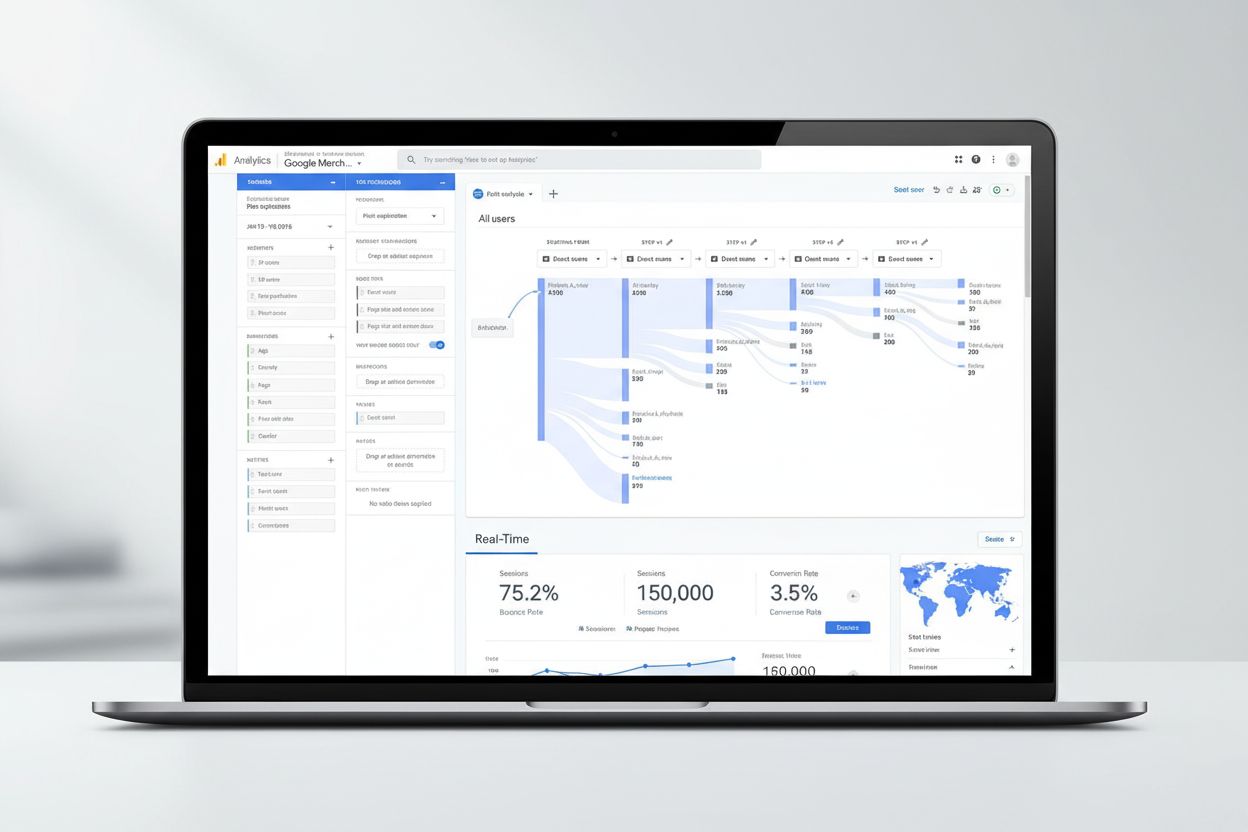

Google Analytics ist Googles kostenlose Webanalyse-Plattform zur Erfassung von Website-Traffic, Nutzerverhalten und Conversions. Erfahren Sie, wie es funktionie...