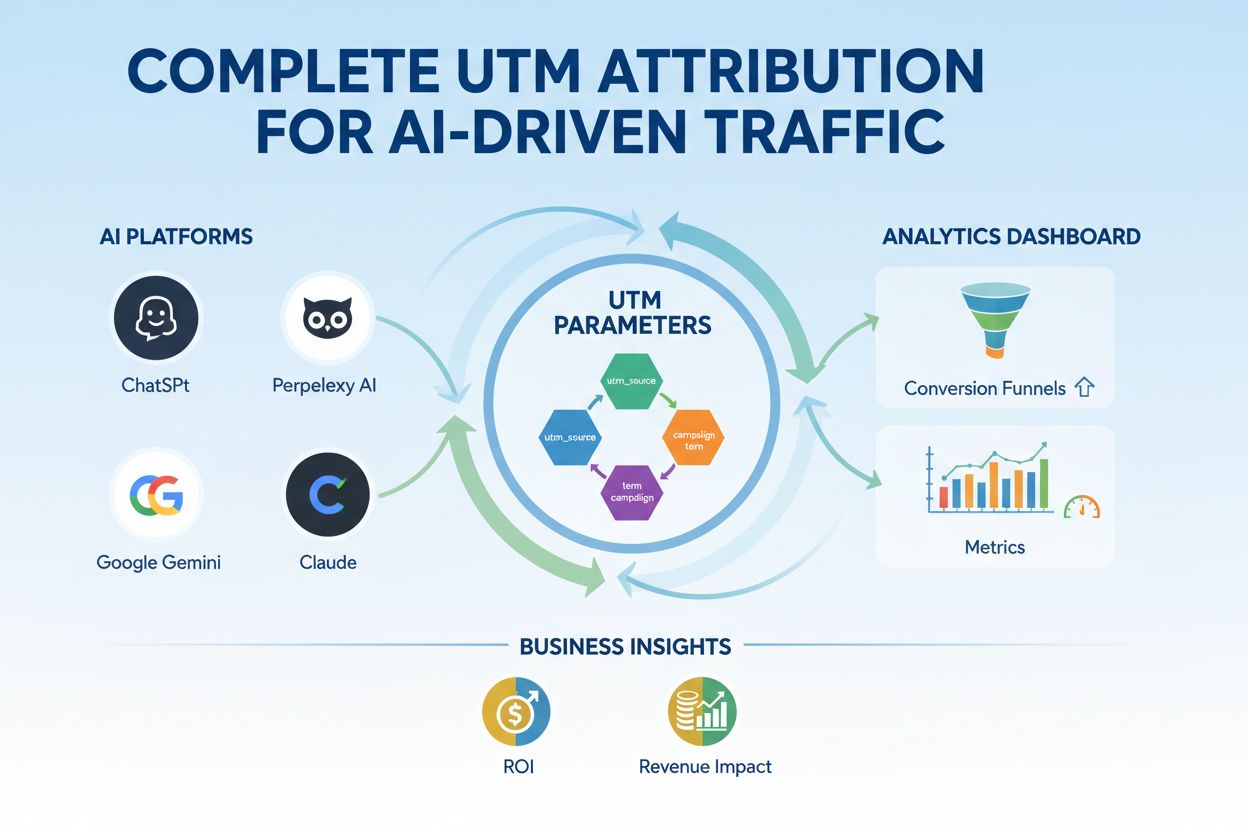

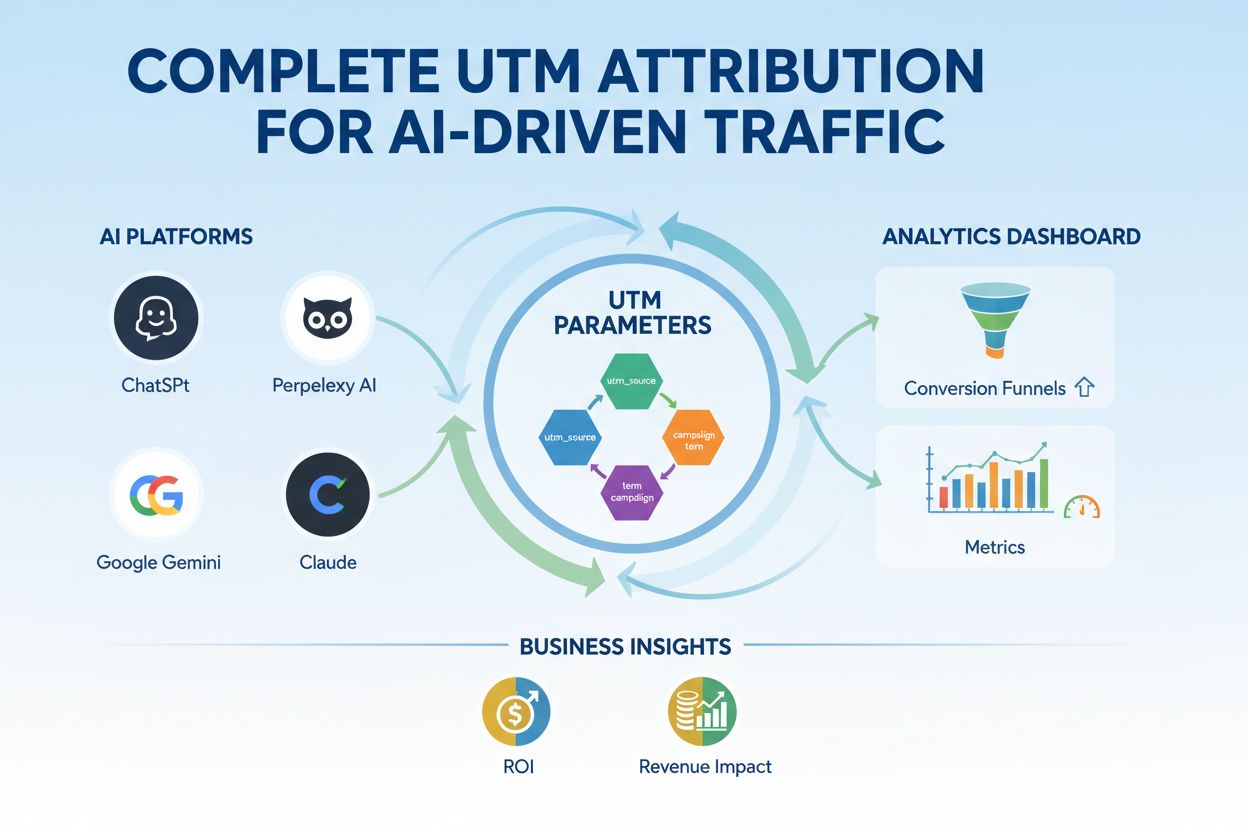

UTM-Parameter für KI-gesteuerten Traffic

Beherrschen Sie das UTM-Tracking für KI-Plattformen wie ChatGPT, Perplexity und Google Gemini. Lernen Sie Einrichtung, Best Practices und wie Sie KI-Traffic in ...

Modellparameter sind lernbare Variablen innerhalb von KI-Modellen, wie Gewichte und Biases, die während des Trainings automatisch angepasst werden, um die Fähigkeit des Modells zu optimieren, genaue Vorhersagen zu treffen, und die bestimmen, wie das Modell Eingabedaten verarbeitet, um Ausgaben zu generieren.

Modellparameter sind lernbare Variablen innerhalb von KI-Modellen, wie Gewichte und Biases, die während des Trainings automatisch angepasst werden, um die Fähigkeit des Modells zu optimieren, genaue Vorhersagen zu treffen, und die bestimmen, wie das Modell Eingabedaten verarbeitet, um Ausgaben zu generieren.

Modellparameter sind lernbare Variablen innerhalb von Modellen der künstlichen Intelligenz, die während des Trainingsprozesses automatisch angepasst werden, um die Fähigkeit des Modells zu optimieren, genaue Vorhersagen zu treffen, und die festlegen, wie das Modell Eingabedaten verarbeitet, um Ausgaben zu erzeugen. Diese Parameter dienen als grundlegende „Regler“ von Machine-Learning-Systemen und bestimmen das genaue Verhalten und die Entscheidungsfindung von KI-Modellen. Im Kontext von Deep Learning und neuronalen Netzen bestehen Parameter hauptsächlich aus Gewichten und Biases – numerischen Werten, die steuern, wie Informationen durch das Netzwerk fließen und wie stark verschiedene Merkmale Vorhersagen beeinflussen. Das Ziel des Trainings besteht darin, die optimalen Werte für diese Parameter zu finden, die Vorhersagefehler minimieren und es dem Modell ermöglichen, gut auf neue, unbekannte Daten zu generalisieren. Das Verständnis von Modellparametern ist entscheidend, um zu verstehen, wie moderne KI-Systeme wie ChatGPT, Claude, Perplexity und Google AI Overviews funktionieren und warum sie unterschiedliche Ausgaben für die gleiche Eingabe erzeugen.

Das Konzept der lernbaren Parameter im maschinellen Lernen geht auf die Anfänge der künstlichen neuronalen Netze in den 1950er und 1960er Jahren zurück, als Forscher erstmals erkannten, dass Netzwerke interne Werte anpassen können, um aus Daten zu lernen. Die praktische Anwendung von Parametern blieb jedoch begrenzt, bis in den 1980er Jahren das Backpropagation-Verfahren eingeführt wurde, das einen effizienten Algorithmus zur Berechnung der Parameteranpassung zur Fehlerreduktion bereitstellte. Die Explosion der Parameteranzahlen beschleunigte sich dramatisch mit dem Aufstieg des Deep Learning in den 2010er Jahren. Frühe Convolutional Neural Networks zur Bilderkennung enthielten Millionen von Parametern, während moderne Large Language Models (LLMs) Hunderte von Milliarden oder sogar Billionen von Parametern umfassen. Laut Forschungen von Our World in Data und Epoch AI ist die Anzahl der Parameter bemerkenswerter KI-Systeme exponentiell gewachsen: GPT-3 enthält 175 Milliarden Parameter, GPT-4o etwa 200 Milliarden Parameter, und einige Schätzungen gehen davon aus, dass GPT-4 bis zu 1,8 Billionen Parameter enthält, wenn man Mixture-of-Experts-Architekturen berücksichtigt. Diese dramatische Skalierung hat grundlegend verändert, was KI-Systeme leisten können, und ermöglicht es ihnen, immer komplexere Muster in Sprache, Bild und logischen Aufgaben zu erfassen.

Modellparameter wirken in einem mathematischen Rahmen, wobei jeder Parameter einen Zahlenwert darstellt, der beeinflusst, wie das Modell Eingaben in Ausgaben umwandelt. In einem einfachen linearen Regressionsmodell bestehen die Parameter aus der Steigung (m) und dem Achsenabschnitt (b) in der Gleichung y = mx + b, wobei diese beiden Werte die Linie bestimmen, die am besten zu den Daten passt. In neuronalen Netzen wird die Situation exponentiell komplexer. Jedes Neuron in einer Schicht erhält Eingaben von der vorhergehenden Schicht, multipliziert jede Eingabe mit einem entsprechenden Gewichtsparameter, summiert diese gewichteten Eingaben, addiert einen Bias-Parameter und gibt das Ergebnis durch eine Aktivierungsfunktion weiter. Diese Ausgabe wird dann zur Eingabe für Neuronen in der nächsten Schicht, wodurch eine Kette von parametergetriebenen Transformationen entsteht. Während des Trainings nutzt das Modell Gradientenabstieg und verwandte Optimierungsalgorithmen, um zu berechnen, wie jeder Parameter angepasst werden sollte, um die Verlustfunktion – ein mathematisches Maß für den Vorhersagefehler – zu verringern. Der Gradient des Verlusts bezüglich jedes Parameters zeigt Richtung und Größe der erforderlichen Anpassung an. Durch Backpropagation fließen diese Gradienten rückwärts durch das Netzwerk und ermöglichen es dem Optimierer, alle Parameter gleichzeitig koordiniert zu aktualisieren. Dieser iterative Prozess wird über mehrere Trainingsepochen wiederholt, bis die Parameter Werte erreicht haben, die den Verlust auf den Trainingsdaten minimieren und gleichzeitig eine gute Generalisierung auf neue Daten gewährleisten.

| Aspekt | Modellparameter | Hyperparameter | Features |

|---|---|---|---|

| Definition | Lernbare Variablen, die während des Trainings angepasst werden | Konfigurationseinstellungen, die vor dem Training festgelegt werden | Eingabedatenmerkmale, die vom Modell verwendet werden |

| Zeitpunkt der Festlegung | Automatisch durch Optimierung gelernt | Manuell von Anwendern konfiguriert | Aus Rohdaten extrahiert oder entwickelt |

| Beispiele | Gewichte, Biases in neuronalen Netzen | Lernrate, Batchgröße, Anzahl der Schichten | Pixelwerte in Bildern, Wort-Embeddings in Texten |

| Auswirkung auf das Modell | Bestimmen, wie das Modell Eingaben auf Ausgaben abbildet | Steuern den Trainingsprozess und die Modellstruktur | Liefern die Rohinformationen, aus denen das Modell lernt |

| Optimierungsmethode | Gradientenabstieg, Adam, AdaGrad | Grid Search, Random Search, Bayessche Optimierung | Feature Engineering, Feature Selection |

| Anzahl in großen Modellen | Milliarden bis Billionen (z. B. 200 Mrd. in GPT-4o) | Typischerweise 5–20 wichtige Hyperparameter | Tausende bis Millionen, je nach Daten |

| Rechenaufwand | Hoch während des Trainings; beeinflusst Inferenzgeschwindigkeit | Minimaler Rechenaufwand bei der Festlegung | Abhängig von Datenerhebung und -vorverarbeitung |

| Übertragbarkeit | Kann durch Fine-Tuning und Transferlernen übertragen werden | Muss für neue Aufgaben neu eingestellt werden | Muss ggf. für neue Domänen neu entwickelt werden |

Modellparameter nehmen je nach Architektur und Art des verwendeten Machine-Learning-Modells unterschiedliche Formen an. In Convolutional Neural Networks (CNNs) zur Bilderkennung umfassen die Parameter die Gewichte in den Faltungsfiltern (auch „Kerne“ genannt), die räumliche Muster wie Kanten, Texturen und Formen auf verschiedenen Skalen erkennen. Recurrent Neural Networks (RNNs) und Long Short-Term Memory (LSTM)-Netze enthalten Parameter, die den Informationsfluss über die Zeit steuern, einschließlich Gate-Parametern, die bestimmen, welche Informationen behalten oder vergessen werden. Transformer-Modelle, die moderne große Sprachmodelle antreiben, enthalten Parameter in mehreren Komponenten: Aufmerksamkeitsgewichte, die bestimmen, auf welche Teile der Eingabe fokussiert wird, Gewichte in Feed-Forward-Netzen und Layer-Normalisierungsparameter. In probabilistischen Modellen wie Naive Bayes definieren Parameter bedingte Wahrscheinlichkeitsverteilungen. Support Vector Machines nutzen Parameter, die die Lage und Ausrichtung von Entscheidungsgrenzen im Merkmalsraum bestimmen. Mixture-of-Experts (MoE)-Modelle, wie sie in einigen Versionen von GPT-4 eingesetzt werden, enthalten Parameter für mehrere spezialisierte Subnetzwerke plus Routing-Parameter, die entscheiden, welche Experten jede Eingabe verarbeiten. Diese architektonische Vielfalt bedeutet, dass Art und Anzahl der Parameter je nach Modelltyp stark variieren, aber das Grundprinzip bleibt gleich: Parameter sind die gelernten Werte, die das Modell zur Ausführung seiner Aufgabe befähigen.

Gewichte und Biases stellen die beiden grundlegenden Parametertypen in neuronalen Netzen dar und bilden die Basis dafür, wie diese Modelle lernen. Gewichte sind numerische Werte, die Verbindungen zwischen Neuronen zugewiesen werden und bestimmen, wie stark und in welche Richtung der Output eines Neurons den Input des nächsten Neurons beeinflusst. In einer voll verbundenen Schicht mit 1.000 Eingabeneuronen und 500 Ausgabeneuronen gibt es 500.000 Gewichtungsparameter – einen für jede Verbindung. Während des Trainings werden die Gewichte angepasst, um den Einfluss bestimmter Merkmale auf Vorhersagen zu verstärken oder zu verringern. Ein großes positives Gewicht bedeutet, dass ein Merkmal das nachfolgende Neuron stark aktiviert, während ein negatives Gewicht es hemmt. Biases sind zusätzliche Parameter, je einer pro Neuron in einer Schicht, die einen konstanten Offset zur Inputsummation eines Neurons vor der Aktivierungsfunktion hinzufügen. Mathematisch ermöglicht der Bias, dass ein Neuron auch dann eine nicht-null Ausgabe erzeugt, wenn die gewichteten Eingaben null sind, was entscheidende Flexibilität bietet. Diese Flexibilität ermöglicht es neuronalen Netzen, komplexe Entscheidungsgrenzen zu lernen und Muster zu erfassen, die allein mit Gewichten nicht möglich wären. In einem Modell mit 200 Milliarden Parametern wie GPT-4o besteht die überwiegende Mehrheit aus Gewichten in den Attention-Mechanismen und Feed-Forward-Netzen, während Biases einen kleineren, aber dennoch bedeutenden Anteil ausmachen. Zusammen ermöglichen Gewichte und Biases dem Modell, die komplexen Muster in Sprache, Bild oder anderen Bereichen zu erlernen, die moderne KI-Systeme so leistungsfähig machen.

Die Anzahl der Parameter in einem Modell hat einen tiefgreifenden Einfluss auf seine Fähigkeit, komplexe Muster zu lernen, und auf seine Gesamtleistung. Forschungen zeigen konsistent, dass Skalierungsgesetze die Beziehung zwischen Parameteranzahl, Trainingsdatengröße und Modellleistung bestimmen. Modelle mit mehr Parametern können komplexere Funktionen abbilden und feinere Muster in Daten erkennen, was im Allgemeinen zu besseren Leistungen bei anspruchsvollen Aufgaben führt. GPT-3 mit 175 Milliarden Parametern zeigte bemerkenswerte Few-Shot-Learning-Fähigkeiten, die kleinere Modelle nicht erreichen konnten. GPT-4o mit 200 Milliarden Parametern zeigt weitere Verbesserungen beim Schlussfolgern, der Codegenerierung und dem multimodalen Verständnis. Die Beziehung zwischen Parametern und Leistung ist jedoch nicht linear und hängt entscheidend von Menge und Qualität der Trainingsdaten ab. Ein Modell mit zu vielen Parametern im Verhältnis zu den Trainingsdaten neigt zu Overfitting, wobei es spezifische Beispiele auswendig lernt, statt generalisierbare Muster zu erfassen, was zu schlechter Leistung bei neuen Daten führt. Umgekehrt kann ein Modell mit zu wenigen Parametern underfitten und wichtige Muster nicht erkennen, was selbst auf Trainingsdaten zu suboptimalen Ergebnissen führt. Die optimale Parameteranzahl für eine bestimmte Aufgabe hängt von Faktoren wie der Komplexität der Aufgabe, der Größe und Vielfalt der Trainingsdaten und den Rechenbeschränkungen ab. Forschungen von Epoch AI zeigen, dass moderne KI-Systeme durch massive Skalierung bemerkenswerte Leistungen erzielen, wobei einige Modelle Billionen von Parametern enthalten, wenn man Mixture-of-Experts-Architekturen berücksichtigt, bei denen nicht alle Parameter für jede Eingabe aktiv sind.

Obwohl große Modelle mit Milliarden von Parametern beeindruckende Leistungen erzielen, ist der Rechenaufwand für das Training und den Einsatz solcher Modelle enorm. Dies hat die Forschung zu parametereffizienten Fine-Tuning-Methoden vorangetrieben, die es ermöglichen, vortrainierte Modelle an neue Aufgaben anzupassen, ohne alle Parameter zu aktualisieren. LoRA (Low-Rank Adaptation) ist eine prominente Technik, bei der die meisten vortrainierten Parameter eingefroren und nur eine kleine Menge zusätzlicher Low-Rank-Matrizen trainiert wird, wodurch die Zahl der trainierbaren Parameter um Größenordnungen reduziert wird, ohne dass die Leistung leidet. Zum Beispiel könnte das Fine-Tuning eines 7-Milliarden-Parameter-Modells mit LoRA nur 1–2 Millionen zusätzliche Parameter trainieren, anstatt aller 7 Milliarden. Adaptermodule fügen zwischen den Schichten eines eingefrorenen vortrainierten Modells kleine trainierbare Netzwerke ein, die nur einen kleinen Prozentsatz an Parametern hinzufügen und dennoch eine aufgabenspezifische Anpassung ermöglichen. Prompt Engineering und In-Context Learning sind alternative Ansätze, bei denen die Parameter gar nicht verändert werden, sondern das bestehende Modell durch sorgfältig gestaltete Eingaben effektiver genutzt wird. Diese parametereffizienten Ansätze haben den Zugang zu großen Sprachmodellen demokratisiert und es Organisationen mit begrenzten Ressourcen ermöglicht, modernste Modelle für ihre spezifischen Anforderungen anzupassen. Der Kompromiss zwischen Parametereffizienz und Leistung bleibt ein aktives Forschungsfeld, wobei Praktiker das Bedürfnis nach Recheneffizienz gegen die Notwendigkeit aufgabenspezifischer Genauigkeit abwägen.

Das Verständnis von Modellparametern ist entscheidend für Plattformen wie AmICited, die überwachen, wie Marken und Domains in KI-generierten Antworten über Systeme wie ChatGPT, Perplexity, Claude und Google AI Overviews erscheinen. Unterschiedliche KI-Modelle mit unterschiedlichen Parameterkonfigurationen erzeugen unterschiedliche Ausgaben für dieselbe Anfrage und bestimmen, wo und wie Marken erwähnt werden. Die 200 Milliarden Parameter in GPT-4o sind anders konfiguriert als die Parameter in Claude 3.5 Sonnet oder den Modellen von Perplexity, was zu Variationen in der Antwortgenerierung führt. Während des Trainings auf unterschiedlichen Datensätzen und mit unterschiedlichen Trainingszielen gelernte Parameter führen dazu, dass Modelle verschiedenes Wissen, unterschiedliche Argumentationsmuster und Zitierverhalten aufweisen. Beim Monitoring von Marken-Erwähnungen in KI-Antworten hilft das Verständnis, dass diese Unterschiede auf Parametervariationen zurückzuführen sind, zu erklären, warum eine Marke in den Antworten eines KI-Systems prominent erscheint, in einem anderen jedoch kaum erwähnt wird. Die Parameter, die die Attention-Mechanismen steuern, bestimmen, welche Teile der Trainingsdaten für eine Anfrage am relevantesten sind und beeinflussen das Zitierverhalten. Parameter in den Ausgabeschichten bestimmen, wie das Modell Informationen strukturiert und präsentiert. Indem AmICited verfolgt, wie verschiedene KI-Systeme mit unterschiedlichen Parameterkonfigurationen Marken erwähnen, liefert es Einblicke, wie das parametergesteuerte Modellverhalten die Sichtbarkeit von Marken in der KI-gestützten Suchlandschaft beeinflusst.

Die Zukunft der Modellparameter wird von mehreren zusammenlaufenden Trends geprägt, die grundlegend verändern werden, wie KI-Systeme entworfen und eingesetzt werden. Mixture-of-Experts (MoE)-Architekturen stellen eine bedeutende Weiterentwicklung dar: Modelle enthalten mehrere spezialisierte Subnetzwerke (Experten) mit eigenen Parametern, und ein Routing-Mechanismus entscheidet, welche Experten eine Eingabe verarbeiten. So können Modelle auf Billionen von Parametern skaliert werden und bleiben dennoch während der Inferenz recheneffizient, da nicht alle Parameter für jede Eingabe aktiv sind. GPT-4 nutzt Berichten zufolge eine MoE-Architektur mit 16 Experten, die jeweils 110 Milliarden Parameter enthalten – insgesamt 1,8 Billionen Parameter, von denen jedoch jeweils nur ein Bruchteil während der Inferenz genutzt wird. Sparsame Parameter und Pruning-Techniken werden entwickelt, um weniger wichtige Parameter zu identifizieren und zu entfernen, sodass die Modellgröße ohne Leistungsverlust reduziert werden kann. Continual Learning-Ansätze zielen darauf ab, Parameter effizient zu aktualisieren, wenn neue Daten verfügbar werden, sodass Modelle sich ohne vollständiges Neutraining anpassen können. Federated Learning verteilt das Parametertraining auf mehrere Geräte, wobei die Privatsphäre gewahrt bleibt, und ermöglicht es Organisationen, von groß angelegtem Training zu profitieren, ohne sensible Daten zu zentralisieren. Das Aufkommen von Small Language Models (SLMs) mit Milliarden statt Hunderten von Milliarden Parametern deutet auf eine Zukunft hin, in der Parametereffizienz ebenso wichtig wird wie die reine Parameteranzahl. Mit zunehmender Integration von KI-Systemen in kritische Anwendungen wird das Verständnis und die Kontrolle von Modellparametern immer wichtiger, um Sicherheit, Fairness und Übereinstimmung mit menschlichen Werten zu gewährleisten. Die Beziehung zwischen Parameteranzahl und Modellverhalten bleibt ein zentraler Fokus der KI-Forschung – mit Auswirkungen von der nachhaltigen Bereitstellung über Interpretierbarkeit bis hin zur Vertrauenswürdigkeit von KI-Systemen.

Modellparameter sind interne Variablen, die während des Trainings durch Optimierungsalgorithmen wie Gradientenabstieg gelernt werden, während Hyperparameter externe Einstellungen sind, die vor dem Training konfiguriert werden. Parameter bestimmen, wie das Modell Eingaben auf Ausgaben abbildet, während Hyperparameter den Trainingsprozess selbst steuern, wie z. B. Lernrate und Anzahl der Epochen. Zum Beispiel sind Gewichte und Biases in neuronalen Netzen Parameter, während die Lernrate ein Hyperparameter ist.

Moderne große Sprachmodelle enthalten Milliarden bis Billionen von Parametern. GPT-4o enthält etwa 200 Milliarden Parameter, während GPT-4o-mini etwa 8 Milliarden Parameter besitzt. Claude 3.5 Sonnet arbeitet ebenfalls mit Hunderten von Milliarden Parametern. Diese enormen Parameterzahlen ermöglichen es den Modellen, komplexe Muster in Sprache zu erfassen und ausgefeilte, kontextuell relevante Antworten zu verschiedensten Themen zu generieren.

Mehr Parameter erhöhen die Kapazität eines Modells, komplexe Muster und Zusammenhänge in Daten zu lernen. Mit zusätzlichen Parametern können Modelle subtilere Merkmale und Interaktionen abbilden, was zu einer höheren Genauigkeit bei Trainingsdaten führt. Es gibt jedoch ein kritisches Gleichgewicht: Zu viele Parameter im Verhältnis zu den Trainingsdaten können zu Overfitting führen, wobei das Modell Rauschen statt generalisierbarer Muster lernt, was zu schlechter Leistung bei neuen, unbekannten Daten führt.

Modellparameter werden durch Backpropagation und Optimierungsalgorithmen wie Gradientenabstieg aktualisiert. Während des Trainings macht das Modell Vorhersagen, berechnet den Verlust (Fehler) zwischen Vorhersagen und tatsächlichen Werten und berechnet dann Gradienten, die zeigen, wie jeder Parameter zu diesem Fehler beigetragen hat. Der Optimierer passt dann die Parameter in die Richtung an, die den Verlust verringert, und wiederholt diesen Prozess über mehrere Trainingsiterationen, bis das Modell zu optimalen Werten konvergiert.

Gewichte bestimmen die Stärke der Verbindungen zwischen Neuronen in neuronalen Netzen und steuern, wie stark Eingabemerkmale die Ausgaben beeinflussen. Biases wirken als Schwellenwertanpasser, sodass Neuronen auch dann aktiviert werden können, wenn gewichtete Eingaben null sind, was Flexibilität bietet und es dem Modell ermöglicht, Grundmuster zu lernen. Zusammen bilden Gewichte und Biases die zentralen lernbaren Parameter, die es neuronalen Netzen ermöglichen, komplexe Funktionen zu approximieren und genaue Vorhersagen zu treffen.

Modellparameter beeinflussen direkt, wie KI-Systeme wie ChatGPT, Perplexity und Claude Anfragen verarbeiten und beantworten. Das Verständnis von Parameteranzahl und -konfigurationen hilft zu erklären, warum verschiedene KI-Modelle unterschiedliche Ausgaben für denselben Prompt erzeugen. Für Brand-Monitoring-Plattformen wie AmICited ist das Nachverfolgen, wie Parameter das Modellverhalten beeinflussen, entscheidend, um vorherzusagen, wo Marken in KI-Antworten erscheinen, und um Konsistenz über verschiedene KI-Systeme hinweg zu verstehen.

Ja, durch Transferlernen können Parameter eines vortrainierten Modells für neue Aufgaben angepasst werden. Dieser Ansatz, genannt Fine-Tuning, besteht darin, ein Modell mit gelernten Parametern zu nehmen und diese auf neuen Daten für spezifische Anwendungen anzupassen. Parameter-effiziente Fine-Tuning-Methoden wie LoRA (Low-Rank Adaptation) ermöglichen selektive Parameter-Updates, wodurch der Rechenaufwand reduziert wird, während die Leistung erhalten bleibt. Diese Technik wird häufig eingesetzt, um große Sprachmodelle für spezialisierte Bereiche anzupassen.

Modellparameter wirken sich direkt auf die Rechenanforderungen sowohl beim Training als auch bei der Inferenz aus. Mehr Parameter benötigen mehr Speicher, Rechenleistung und Zeit für das Training und den Einsatz. Ein Modell mit 175 Milliarden Parametern (wie GPT-3) erfordert erheblich mehr Ressourcen als ein Modell mit 7 Milliarden Parametern. Dieser Zusammenhang ist entscheidend für Organisationen, die KI-Systeme einsetzen, da die Parameteranzahl Infrastrukturkosten, Latenz und Energieverbrauch in Produktionsumgebungen beeinflusst.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Beherrschen Sie das UTM-Tracking für KI-Plattformen wie ChatGPT, Perplexity und Google Gemini. Lernen Sie Einrichtung, Best Practices und wie Sie KI-Traffic in ...

Erfahren Sie, wie die Feinabstimmung von KI-Modellen vortrainierte Modelle an spezifische Branchen- und Markenaufgaben anpasst, die Genauigkeit verbessert und g...

Vergleichen Sie Optimierungsstrategien für Trainingsdaten und Echtzeit-Abfrage für KI. Erfahren Sie, wann Feintuning und wann RAG sinnvoll ist, was die Kosten b...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.