PerplexityBot: Was jeder Website-Betreiber wissen muss

Vollständiger Leitfaden zum PerplexityBot-Crawler – erfahren Sie, wie er funktioniert, wie Sie den Zugriff steuern, Zitate überwachen und die Sichtbarkeit bei P...

PerplexityBot ist der Web-Crawler von Perplexity AI, der Webinhalte indexiert, um die Antwortmaschine zu unterstützen. Er beachtet robots.txt-Anweisungen, liefert transparente Quellennachweise in den Antworten und wird nicht für das Training von KI-Grundlagenmodellen verwendet. Der Crawler hilft Perplexity dabei, genaue und belegte Antworten auf Nutzeranfragen zu liefern.

PerplexityBot ist der Web-Crawler von Perplexity AI, der Webinhalte indexiert, um die Antwortmaschine zu unterstützen. Er beachtet robots.txt-Anweisungen, liefert transparente Quellennachweise in den Antworten und wird nicht für das Training von KI-Grundlagenmodellen verwendet. Der Crawler hilft Perplexity dabei, genaue und belegte Antworten auf Nutzeranfragen zu liefern.

PerplexityBot ist der von Perplexity AI entwickelte Web-Crawler, der Inhalte für die Antwortmaschine indexiert und abruft. Im Gegensatz zu traditionellen Suchmaschinen-Crawlern verfolgt PerplexityBot einen bestimmten Zweck: Er sammelt aktuelle Informationen, um die KI-gesteuerte Suche und Antwortgenerierung von Perplexity zu ermöglichen. Der Crawler identifiziert sich mit einem klaren User-Agent-String: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot). Wichtig ist, dass PerplexityBot das robots.txt-Protokoll respektiert, sodass Website-Betreiber das Crawl-Verhalten auf ihren Domains steuern können. Ein wesentlicher Unterschied: PerplexityBot wird nicht für das Training von KI-Modellen verwendet – er liefert ausschließlich Inhalte an das Antwortgenerierungssystem von Perplexity, und die Plattform bietet transparente Quellennachweise für alle verwendeten Informationen in den Antworten.

PerplexityBot arbeitet als verteilter Web-Crawler, der Webinhalte systematisch indexiert, um eine durchsuchbare Wissensbasis für die Antwortmaschine von Perplexity aufzubauen. Der Crawler verwendet seine charakteristische User-Agent-Kennung, um sich transparent gegenüber Webservern auszuweisen, sodass Administratoren seine Anfragen erkennen und steuern können. Perplexity betreibt spezifische IP-Adressbereiche für PerplexityBot, die in Web Application Firewalls (WAFs) wie Cloudflare und AWS konfiguriert werden können, um den Zugriff nach Bedarf zu erlauben oder einzuschränken. Es ist wichtig, zwischen PerplexityBot (dem Inhalts-Crawler) und Perplexity-User (der tatsächlichen Nutzer-Traffic von der Perplexity-Plattform repräsentiert) zu unterscheiden, da beide unterschiedliche Funktionen erfüllen und entsprechend unterschiedlich behandelt werden sollten. Im Gegensatz zu GoogleBot, der für Suchindexierung und Ranking crawlt, konzentriert sich PerplexityBot ausschließlich auf das Abrufen von Inhalten für die Antwortgenerierung, ohne das Suchranking zu beeinflussen. Die Architektur des Crawlers spiegelt einen modernen Ansatz des Web-Crawlings wider, der den Bedarf an umfassendem Inhaltszugang mit der Achtung der Präferenzen und technischen Einschränkungen von Website-Betreibern in Einklang bringt.

| Crawler-Name | Zweck | Beachtet robots.txt | Für KI-Training verwendet | Quellenangabe |

|---|---|---|---|---|

| PerplexityBot | Antwortmaschinen-Inhaltsabruf | Ja | Nein | Ja, transparente Zitate |

| ChatGPT-User | Nutzertraffic von ChatGPT | N/A | Nein | N/A |

| GoogleBot | Suchindexierung und Ranking | Ja | Nein | N/A |

Perplexity verfolgt einen transparenten Crawling-Ansatz, der sich von einigen Wettbewerbern abhebt, die auf Stealth-Techniken setzen. Untersuchungen von Cloudflare zeigten, dass manche KI-Unternehmen versucht haben, ihre Crawler durch das Fälschen legitimer User-Agent-Strings zu tarnen, was es Website-Betreibern erschwert, ihren Traffic zu identifizieren und zu steuern. Die klare Identifikation von PerplexityBot und die Einhaltung von RFC 9309 (dem Standard für verantwortungsvolles Web-Crawling) zeigen das Engagement für ethische Praktiken im KI-Zeitalter. Transparenz beim Web-Crawling dient mehreren Zielen: Website-Betreiber können fundierte Entscheidungen über ihre Inhalte treffen, es ermöglicht eine korrekte Traffic-Zuordnung in Analyseplattformen und baut Vertrauen im Web-Ökosystem auf. Die Unterscheidung zwischen transparentem und verdecktem Crawling wird immer wichtiger, da KI-Unternehmen um den Zugang zu Inhalten konkurrieren – transparente Ansätze erweisen sich dabei als nachhaltiger und respektvoller gegenüber der Autonomie der Website-Betreiber.

Best Practices für ethisches Web-Crawling sind:

Die Crawling-Infrastruktur von Perplexity hat sich seit den Anfangstagen, als die Plattform noch auf den Bing-Index setzte, erheblich weiterentwickelt. Das Unternehmen entwickelte einen eigenen Crawler, um mehr Kontrolle über Aktualität, Qualität und Relevanz der Inhalte für die Antwortgenerierung zu gewinnen. Statt das gesamte Web wahllos zu indexieren, konzentriert sich Perplexity auf den „Kopf der Verteilungskurve“ – es werden vor allem populäre, autoritative und hochwertige Inhalte priorisiert, die mit hoher Wahrscheinlichkeit präzise Antworten auf Nutzerfragen liefern. Der Crawler nutzt fortschrittliche Inhalts-Parsing-Techniken, um relevante Informationen zu extrahieren, Schlüsselaussagen zu identifizieren und semantische Zusammenhänge in Dokumenten zu verstehen. Perplexity vergibt Vertrauenswerte für Domains anhand von Faktoren wie Inhaltsqualität, Genauigkeitshistorie und Autoritätssignalen, die das Gewicht von Quellen bei der Antwortgenerierung beeinflussen. Die Plattform führt einen Re-Crawling-Plan durch, der Aktualität und Serverlast ausbalanciert – hochautoritative Domains werden häufiger besucht, weniger häufig aktualisierte Seiten entsprechend seltener.

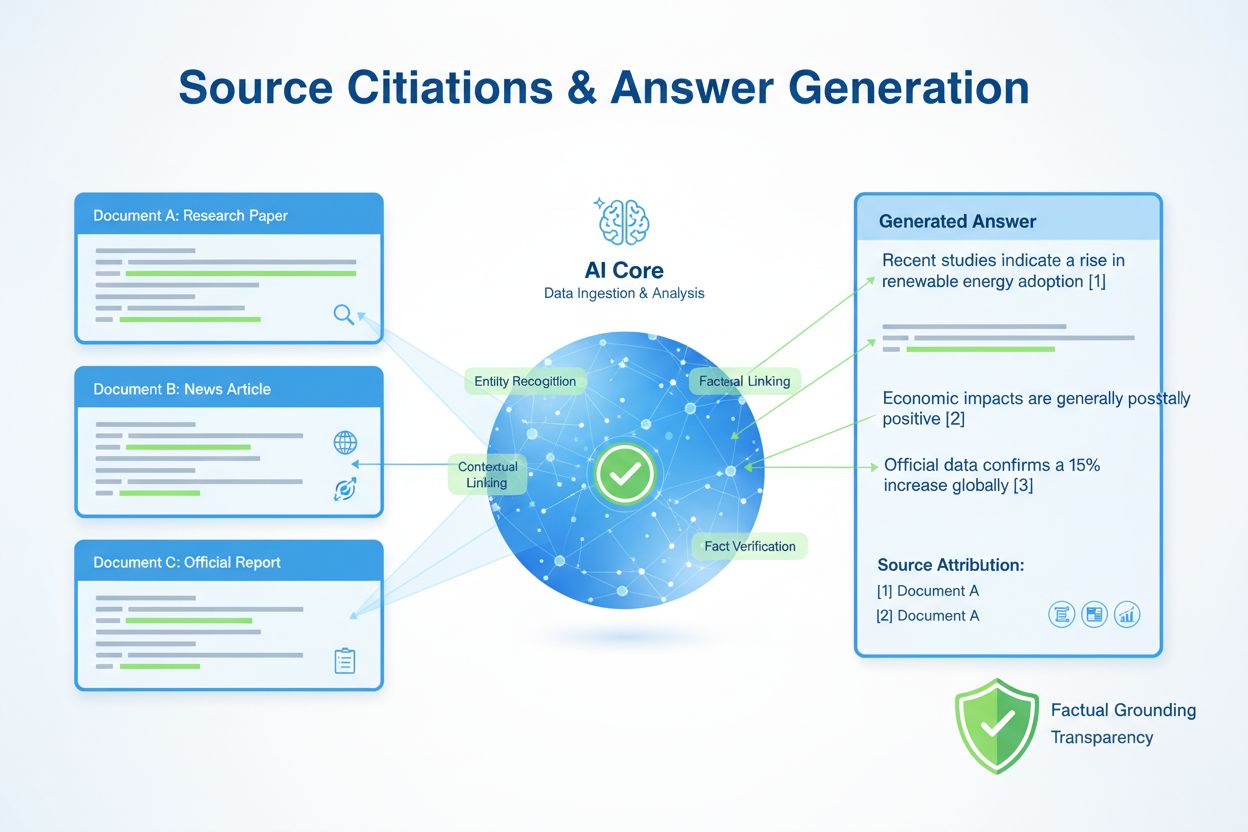

Wenn PerplexityBot Inhalte crawlt und indexiert, fließen diese Informationen direkt in die Antwortgenerierungspipeline von Perplexity, wo die KI Informationen aus mehreren Quellen synthetisiert, um umfassende Antworten zu erstellen. Der Zitiermechanismus der Plattform ist grundlegend: Jede Antwort enthält transparente Links zu den verwendeten Quellen, sodass Nutzer Informationen überprüfen und Themen vertiefen können. Dieser Ansatz unterscheidet sich deutlich von traditionellen Suchmaschinen, die Seiten hauptsächlich ranken, statt Informationen zu synthetisieren, und von KI-Systemen, die Antworten ohne klare Quellenangabe generieren. Website-Betreiber können den PerplexityBot-Traffic über Google Analytics 4 und andere Analyseplattformen verfolgen, wo er als eigener Crawler erscheint und so Einblicke in das Zugriffsvolumen und die abgerufenen Inhalte bietet. Die Nutzererfahrung profitiert erheblich von dieser Transparenz: Lesende sehen genau, welche Quellen in die jeweilige Antwort eingeflossen sind – das stärkt das Vertrauen in die Informationen und führt qualifizierte Besucher zurück auf autoritative Websites. Dieses zitatorientierte Modell schafft eine Symbiose: Content-Ersteller profitieren von Sichtbarkeit und Traffic, während Nutzende vertrauenswürdige, belegte Informationen erhalten.

Website-Betreiber, die verhindern möchten, dass PerplexityBot ihre Inhalte crawlt, können dies über die robots.txt-Datei – den Standardmechanismus zur Kommunikation von Crawler-Präferenzen – tun. Mit folgender einfachen Anweisung blockieren Sie den Crawler für Ihre Website:

User-agent: PerplexityBot

Disallow: /

Für eine feinere Steuerung können Sie PerplexityBot nur für bestimmte Verzeichnisse oder Dateitypen blockieren und den Zugriff auf andere Bereiche zulassen. Web Application Firewalls wie Cloudflare und AWS bieten zusätzliche Konfigurationsmöglichkeiten, um Anfragen von den IP-Bereichen von PerplexityBot auf Infrastrukturebene zu blockieren. Prüfen Sie vor der Blockierung, ob Anfragen tatsächlich von PerplexityBot stammen, indem Sie den User-Agent-String und die IP-Adressen mit den veröffentlichten Bereichen von Perplexity abgleichen. Änderungen an robots.txt werden in der Regel innerhalb von 24 Stunden wirksam, allerdings kann es bei manchen Crawlern länger dauern, bis sie neue Anweisungen vollständig respektieren. Überlegen Sie vor einer vollständigen Blockierung von PerplexityBot, welche Vorteile eine Indexierung bietet: Die Aufnahme in die Antwortmaschine von Perplexity kann erheblichen qualifizierten Traffic und Sichtbarkeit in einem zunehmend wichtigen KI-Suchkanal bringen. Ein differenzierter Ansatz könnte darin bestehen, das Crawling grundsätzlich zu erlauben, aber mit robots.txt sensible oder doppelte Inhalte auszuschließen.

Die Aufnahme in den Index von PerplexityBot stellt eine bedeutende Chance für die Sichtbarkeit Ihrer Website im KI-Suchzeitalter dar. Da Perplexity und ähnliche KI-Antwortmaschinen immer beliebter werden, ist die Indexierung entscheidend für Auffindbarkeit und Traffic. Websites, die in Perplexity-Antworten erscheinen, erhalten direkten Traffic von Nutzenden, die Informationen überprüfen oder Themen vertiefen – ein neuer Kanal zur Zielgruppenansprache jenseits klassischer Suchmaschinen. Die Qualität und Relevanz Ihrer Inhalte beeinflusst direkt, ob PerplexityBot sie crawlt und wie prominent sie in Antworten erscheinen – gut recherchierte, autoritative Inhalte werden mit höherer Wahrscheinlichkeit als Quelle ausgewählt. SEO-Optimierung für KI-Antwortmaschinen unterscheidet sich teilweise von klassischer Suchmaschinenoptimierung: Im Vordergrund stehen klare Struktur, umfassende Themenabdeckung sowie nachgewiesene Expertise und Autorität. Da KI-Suche weiter reift und Marktanteile gewinnt, wird die Platzierung in Antwortmaschinen ebenso wichtig wie das Ranking in klassischen Suchmaschinen – die Indexierung durch PerplexityBot ist damit ein zentraler Bestandteil moderner Content-Strategien.

Sie können Aktivitäten von PerplexityBot in Ihren Server-Logs identifizieren, indem Sie nach Anfragen mit dem charakteristischen User-Agent-String PerplexityBot/1.0 suchen oder nach IP-Adressen aus den veröffentlichten Bereichen von Perplexity filtern. Analyseplattformen wie Google Analytics 4, Matomo und serverseitige Logging-Tools erfassen PerplexityBot-Traffic und ermöglichen es Ihnen, Crawling-Frequenz, aufgerufene Inhalte und das erzeugte Traffic-Volumen zu verstehen. Einblick in die Crawl-Muster hilft Ihnen, die Struktur und die Inhalte Ihrer Seite für eine bessere Indexierung zu optimieren – wenn PerplexityBot bestimmte Inhaltstypen häufig abruft, können Sie sicherstellen, dass diese Seiten gut strukturiert und auffindbar sind. Die Performance-Auswirkungen von PerplexityBot sind typischerweise minimal, da der Crawler ressourcenschonend arbeitet und seine Anfragen über die Zeit verteilt, um Websites nicht zu überlasten. Spezialisierte Monitoring-Tools wie AmICited.com bieten tiefere Einblicke darin, wie Ihre Inhalte in KI-Antwortmaschinen genutzt werden, verfolgen Zitate, Traffic-Zuordnung und Ihre Wettbewerbsposition im KI-Suchumfeld – wertvolle Informationen, um Ihre Sichtbarkeit in diesem aufkommenden Kanal zu verstehen.

PerplexityBot ist der Web-Crawler von Perplexity AI, der dazu entwickelt wurde, Inhalte für die Antwortmaschine von Perplexity zu indexieren und abzurufen. Er durchsucht Websites, um Informationen zu sammeln, die die KI-gesteuerten Suchergebnisse und die Antwortgenerierung von Perplexity antreiben. Im Gegensatz zu einigen KI-Crawlern wird PerplexityBot nicht für das Training von KI-Grundlagenmodellen verwendet – er liefert Inhalte ausschließlich an das Antwortgenerierungssystem von Perplexity, mit transparenten Quellennachweisen.

Sie können PerplexityBot identifizieren, indem Sie in Ihren Server-Logs nach dem User-Agent-String 'PerplexityBot/1.0' suchen. Der vollständige User-Agent-String lautet: Mozilla/5.0 AppleWebKit/537.36 (KHTML, wie Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot). Sie können auch nach IP-Adressen innerhalb der von Perplexity veröffentlichten IP-Bereiche filtern, die unter https://www.perplexity.com/perplexitybot.json verfügbar sind.

Ob Sie PerplexityBot blockieren sollten, hängt von Ihrer Content-Strategie ab. Wenn Sie ihn zulassen, kann dies qualifizierten Traffic von der Antwortmaschine von Perplexity bringen und die Sichtbarkeit Ihrer Inhalte in KI-Suchergebnissen erhöhen. Wenn Sie jedoch Bedenken hinsichtlich der Nutzung Ihrer Inhalte haben oder das Crawlen einschränken möchten, können Sie ihn über robots.txt blockieren. Berücksichtigen Sie die Vorteile der KI-Sichtbarkeit, bevor Sie eine vollständige Blockierung vornehmen.

PerplexityBot und GoogleBot verfolgen unterschiedliche Zwecke. GoogleBot durchsucht das Web für die Indexierung und das Ranking in den Google-Suchergebnissen, während PerplexityBot gezielt Inhalte für die Antwortmaschine von Perplexity abruft. PerplexityBot legt den Fokus auf Inhaltsqualität und Relevanz für die Antwortgenerierung statt auf Suchranking und liefert transparente Quellennachweise in den Antworten.

Ja, PerplexityBot beachtet robots.txt-Anweisungen. Sie können seinen Zugriff steuern, indem Sie spezifische Regeln zu Ihrer robots.txt-Datei hinzufügen. Um beispielsweise das Crawlen durch PerplexityBot komplett zu verhindern, fügen Sie hinzu: User-agent: PerplexityBot gefolgt von Disallow: /. Änderungen an robots.txt werden in der Regel innerhalb von 24 Stunden übernommen.

Nein, PerplexityBot wird ausdrücklich nicht für das Training von KI-Grundlagenmodellen verwendet. Perplexity hat angegeben, dass PerplexityBot ausschließlich zum Indexieren von Inhalten für die Antwortmaschine und zum Bereitstellen belegter Antworten für Nutzer konzipiert ist. Das unterscheidet ihn von einigen anderen KI-Crawlern, die möglicherweise für das Modelltraining genutzt werden.

Um PerplexityBot durch Ihre Web Application Firewall zu lassen, erstellen Sie Regeln, die sowohl den User-Agent-String (PerplexityBot) als auch die IP-Adressen aus den von Perplexity veröffentlichten Bereichen auf die Whitelist setzen. Für Cloudflare verwenden Sie benutzerdefinierte Regeln, um Anfragen mit dem PerplexityBot-User-Agent und entsprechenden IP-Bedingungen zu erlauben. Für AWS WAF erstellen Sie IP-Sets und String-Match-Bedingungen für dieselben Kennungen. Nutzen Sie immer die offiziellen IP-Bereiche von https://www.perplexity.com/perplexitybot.json.

PerplexityBot ist der automatisierte Crawler, der Webinhalte für den Suchindex von Perplexity indexiert. Perplexity-User steht für tatsächlichen Nutzer-Traffic von der Perplexity-Plattform, wenn Nutzer von den Perplexity-Antworten aus auf Websites klicken. PerplexityBot beachtet robots.txt, während Perplexity-User robots.txt in der Regel ignoriert, da es sich um nutzerinitiierte Anfragen handelt. Beide können Sie anhand ihrer jeweiligen User-Agent-Strings in Ihren Logs identifizieren.

Verfolgen Sie, wie Ihre Inhalte in Perplexity, ChatGPT, Google AI Overviews und anderen KI-Systemen mit AmICited erscheinen. Erhalten Sie Einblicke in Ihre KI-Zitate und Sichtbarkeit.

Vollständiger Leitfaden zum PerplexityBot-Crawler – erfahren Sie, wie er funktioniert, wie Sie den Zugriff steuern, Zitate überwachen und die Sichtbarkeit bei P...

Perplexity AI ist eine KI-basierte Antwortmaschine, die Echtzeit-Websuche mit LLMs kombiniert, um zitierte, genaue Antworten zu liefern. Erfahren Sie, wie es fu...

Erfahre, wie du KI-Bots wie GPTBot, PerplexityBot und ClaudeBot das Crawlen deiner Website erlaubst. Konfiguriere robots.txt, richte llms.txt ein und optimiere ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.