Was ist Prompt Engineering für KI-Suche – Kompletter Leitfaden

Erfahren Sie, was Prompt Engineering ist, wie es mit KI-Suchmaschinen wie ChatGPT und Perplexity funktioniert, und entdecken Sie wichtige Techniken, um Ihre KI-...

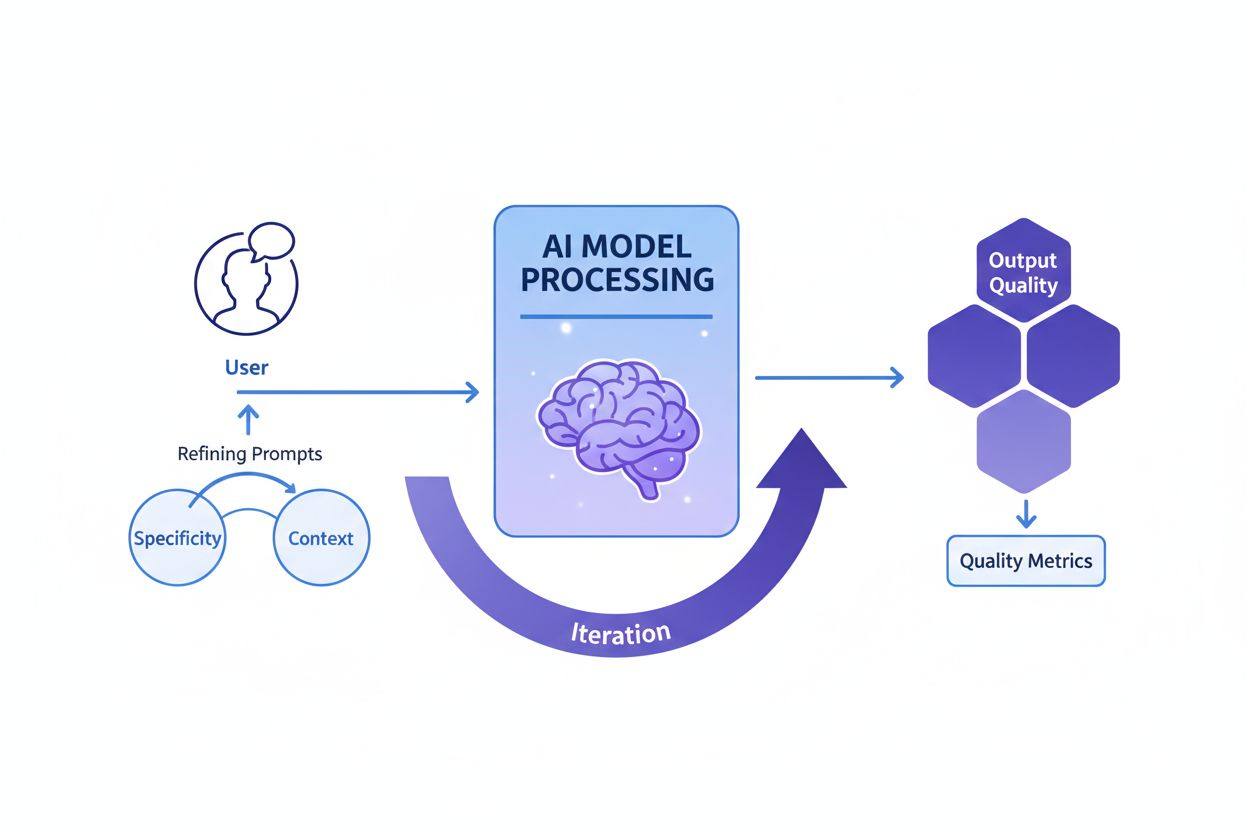

Prompt Engineering ist der Prozess des Gestaltens, Verfeinerns und Optimierens von Anweisungen in natürlicher Sprache, um generative KI-Modelle dazu zu bringen, gewünschte, genaue und relevante Ausgaben zu erzeugen. Dabei wird durch wiederholte Experimente mit Formulierungen, Kontext und Struktur die Leistungsfähigkeit der KI maximiert, ohne das zugrundeliegende Modell zu verändern.

Prompt Engineering ist der Prozess des Gestaltens, Verfeinerns und Optimierens von Anweisungen in natürlicher Sprache, um generative KI-Modelle dazu zu bringen, gewünschte, genaue und relevante Ausgaben zu erzeugen. Dabei wird durch wiederholte Experimente mit Formulierungen, Kontext und Struktur die Leistungsfähigkeit der KI maximiert, ohne das zugrundeliegende Modell zu verändern.

Prompt Engineering ist der systematische Prozess, Anweisungen in natürlicher Sprache – sogenannte Prompts – so zu gestalten, zu verfeinern und zu optimieren, dass generative KI-Modelle gewünschte, genaue und kontextuell relevante Ausgaben erzeugen. Anstatt das zugrundeliegende KI-Modell selbst zu verändern, arbeiten Prompt Engineers mit den bestehenden Fähigkeiten des Modells, indem sie ihre Eingaben sorgfältig strukturieren, um zu beeinflussen, wie das Modell Informationen verarbeitet und Antworten generiert. Diese Disziplin entwickelte sich während des KI-Booms der Jahre 2023–2025 zu einer entscheidenden Fähigkeit, als Organisationen erkannten, dass der Zugang zu leistungsstarken KI-Tools wie ChatGPT, Claude, Perplexity und Google AI ohne Expertise in der effektiven Kommunikation mit diesen Systemen nicht ausreicht. Prompt Engineering schlägt eine Brücke zwischen menschlicher Intention und KI-Fähigkeit, indem es vage Geschäftsziele in umsetzbare, hochwertige KI-Ausgaben verwandelt. Die Praxis ist grundsätzlich iterativ und erfordert kontinuierliches Experimentieren, Testen und Verfeinern, um für spezifische Anwendungsfälle optimale Ergebnisse zu erzielen.

Das Konzept des Prompt Engineering entstand organisch nach der öffentlichen Veröffentlichung von ChatGPT im November 2022, als Millionen von Nutzern begannen, mit verschiedenen Formulierungen bessere Ergebnisse aus großen Sprachmodellen zu erzielen. Frühe Anwender entdeckten, dass die Qualität von KI-Ausgaben stark davon abhing, wie Fragen formuliert wurden, welcher Kontext geliefert wurde und wie spezifisch die Anweisungen waren. Diese Beobachtung führte zur Formalisierung von Prompt Engineering als eigenständige Disziplin. Ab 2023 begannen große Technologiekonzerne wie OpenAI, Google, Microsoft und Anthropic, gezielt Prompt Engineers einzustellen – einige Positionen mit Gehältern von über 300.000 US-Dollar. Der weltweite Markt für Prompt Engineering wurde 2023 auf etwa 222,1 Millionen US-Dollar geschätzt und soll bis 2030 auf 2,06 Milliarden US-Dollar wachsen, was eine erhebliche jährliche Wachstumsrate (CAGR) bedeutet. Dieses rasante Marktwachstum spiegelt die zunehmende Erkenntnis wider, dass Prompt Engineering keine kurzfristige Modeerscheinung, sondern eine grundlegende Fähigkeit für Unternehmen ist, die KI in großem Maßstab nutzen. Die Disziplin hat sich von einfachem Ausprobieren zu einer ausgefeilten Praxis mit etablierten Techniken, Evaluierungsrahmen und Best Practices entwickelt, wie sie von führenden KI-Forschungsinstituten und Branchenpraktikern dokumentiert werden.

Wirksames Prompt Engineering basiert auf mehreren Grundprinzipien, die hochwertige Prompts von ineffektiven unterscheiden. Spezifität ist entscheidend – je detaillierter und präziser ein Prompt ist, desto besser versteht das KI-Modell die Anforderungen und kann passende Ausgaben generieren. Statt die KI zu bitten, „über Hunde zu schreiben“, könnte ein spezifischer Prompt etwa lauten: „Erstellen Sie einen 300 Wörter umfassenden veterinärmedizinischen Ratgeber zu Gesundheitsproblemen bei Golden Retrievern für Tierhalter auf dem Niveau der 8. Klasse, mit Schwerpunkt auf Prävention.“ Kontextbereitstellung ist ebenso kritisch; relevante Hintergrundinformationen, Beispiele oder Einschränkungen helfen dem Modell, den Fokus zu schärfen und relevantere Antworten zu liefern. Klarheit stellt sicher, dass Anweisungen eindeutig und direkt sind, ohne dass das Modell vage Formulierungen interpretieren muss. Iterative Verfeinerung bedeutet, dass der erste Prompt selten optimale Ergebnisse bringt; erfolgreiche Prompt Engineers testen kontinuierlich Variationen, analysieren Ausgaben und passen ihren Ansatz an. Ton- und Stilabgleich beinhaltet, die gewünschte Stimme, das Sprachniveau und das Format zu spezifizieren, um Ausgaben an die Erwartungen von Organisation oder Nutzer anzupassen. Diese Prinzipien gelten plattformübergreifend – egal ob für ChatGPT, Perplexity, Claude oder Google AI Overviews – und sind universell wertvoll für alle, die KI-Interaktionen optimieren wollen.

Das Feld des Prompt Engineering hat zahlreiche ausgefeilte Techniken entwickelt, um unterschiedliche Aufgaben- und Komplexitätsgrade zu adressieren. Zero-Shot Prompting ist der direkteste Ansatz, bei dem das KI-Modell eine klare Anweisung oder Frage ohne zusätzliche Beispiele oder Kontext erhält. Diese Methode eignet sich für einfache Aufgaben, stößt aber bei komplexen Anforderungen an ihre Grenzen. Few-Shot Prompting verbessert die Leistung, indem das Modell mit ein oder mehreren Beispielen versorgt wird, die das gewünschte Ausgabeformat oder Argumentationsmuster demonstrieren – das Modell lernt so durch Vorführung. Chain-of-Thought (CoT) Prompting zerlegt komplexe Probleme in Zwischenschritte, regt das Modell an, seinen Denkweg offenzulegen, und verbessert so die Genauigkeit bei mehrstufigen Aufgaben. Prompt Chaining teilt eine komplexe Aufgabe in kleinere, aufeinanderfolgende Teilaufgaben – die Ausgabe eines Prompts dient dabei als Input für den nächsten, was die Zuverlässigkeit und Konsistenz bei anspruchsvollen Workflows erhöht. Tree-of-Thought Prompting generalisiert Chain-of-Thought, indem mehrere mögliche Lösungswege gleichzeitig verfolgt werden, sodass das Modell verschiedene Ansätze bewerten und den vielversprechendsten auswählen kann. Maieutisches Prompting besteht darin, das Modell zu bitten, seine Argumentation zu erklären, und anschließend gezielt Nachfragen zu einzelnen Aspekten zu stellen, um Inkonsistenzen aufzudecken und zu korrigieren. Generated Knowledge Prompting weist das Modell an, zunächst relevante Fakten oder Hintergrundinformationen zu generieren, bevor es die eigentliche Aufgabe löst – das Modell wird so mit nützlichem Kontext konditioniert. Self-Refine Prompting bedeutet, dass das Modell ein Problem löst, seine eigene Lösung kritisch hinterfragt und auf Basis des Feedbacks überarbeitet – dieser Zyklus wird bis zum gewünschten Ergebnis wiederholt. Jede Technik erfüllt spezifische Zwecke; die wirksamste Anwendung von Prompt Engineering kombiniert oft mehrere Methoden, die strategisch auf die jeweilige Aufgabe zugeschnitten sind.

| Technik | Optimal für | Komplexität | Typischer Anwendungsfall | Wirksamkeit |

|---|---|---|---|---|

| Zero-Shot Prompting | Einfache, direkte Aufgaben | Niedrig | Basisfragen, einfache Anweisungen | Gut für einfache Aufgaben, eingeschränkt bei komplexen Anforderungen |

| Few-Shot Prompting | Aufgaben mit Format-Konsistenz | Mittel | Inhaltserstellung, Klassifizierung, Formatierung | Hervorragend für gewünschte Ausgabemuster |

| Chain-of-Thought | Mehrschrittige Denkaufgaben | Mittel-Hoch | Rechenaufgaben, logische Deduktion, Analyse | Deutlich bessere Genauigkeit bei komplexen Aufgaben |

| Prompt Chaining | Komplexe Workflows mit Abhängigkeiten | Hoch | Mehrstufige Inhaltserstellung, Datenverarbeitung | Sehr gut zur Zerlegung komplexer Probleme |

| Tree-of-Thought | Probleme mit mehreren Lösungswegen | Hoch | Strategische Planung, kreatives Problemlösen | Überlegen bei der Erkundung alternativer Ansätze |

| Generated Knowledge | Aufgaben mit Hintergrundwissen | Mittel | Fachspezifische Fragen, technische Erklärungen | Bessere Relevanz und Genauigkeit durch Kontext |

| Self-Refine | Qualitätskritische Anwendungen | Hoch | Professionelles Schreiben, technische Dokumentation | Höchste Qualitätsausgaben durch Iteration |

Um zu verstehen, wie Prompts das Verhalten von KI-Modellen beeinflussen, ist Grundwissen darüber nötig, wie große Sprachmodelle (LLMs) funktionieren. Diese Modelle zerlegen Texte in Token (kleine Texteinheiten) und sagen dann anhand erlernter Muster das wahrscheinlich nächste Token voraus. Das Prompt dient als initialer Kontext, der alle weiteren Vorhersagen prägt. Enthält das Prompt spezifische Anweisungen, Beispiele oder Einschränkungen, verengt es die Wahrscheinlichkeitsverteilung der möglichen Ausgaben und lenkt das Modell auf die gewünschte Intention. Temperatur- und Top-p-Sampling-Parameter beeinflussen zusätzlich die Variabilität – niedrigere Temperaturen erzeugen deterministischere, fokussierte Antworten, höhere steigern Kreativität und Vielfalt. Das Kontextfenster (die Textmenge, die das Modell berücksichtigen kann) begrenzt, wie viele Informationen in ein Prompt passen; längere Prompts füllen das Fenster und reduzieren den Platz für die eigentliche Aufgabe. Effektive Prompt Engineers kennen diese technischen Grenzen und gestalten Prompts entsprechend. Für Organisationen, die ihre Markensichtbarkeit mit Tools wie AmICited plattformübergreifend überwachen, ist dieses Wissen entscheidend, da die eingegebenen Prompts bestimmen, welche Informationen KI-Systeme abrufen und zitieren. Ein gut gestaltetes Prompt wie „Nenne die drei führenden Unternehmen im Cloud Computing“ erzeugt andere Ergebnisse als „Nenne innovative Cloud-Computing-Unternehmen, die nach 2015 gegründet wurden“ – dies beeinflusst, welche Marken in KI-Antworten sichtbar werden.

Die wirksame Umsetzung von Prompt Engineering im Unternehmen erfordert die Beachtung etablierter Best Practices, die sich aus Forschung und Praxiserfahrung ergeben haben. Einfach beginnen und iterieren ist das Grundprinzip – zunächst ein einfaches Prompt erstellen und schrittweise Komplexität hinzufügen, wobei jede Änderung getestet wird, um Verbesserungen zu erkennen. Anforderungen klar benennen: Gewünschtes Ausgabeformat, Länge, Ton und Einschränkungen klar formulieren; vage Prompts führen zu vagen Ergebnissen. Relevanten Kontext bereitstellen, ohne das Modell zu überfordern; Hintergrundinfos helfen, aber unnötige Details verbrauchen das Kontextfenster. Klare Trennzeichen wie „###“ oder „—“ nutzen, um verschiedene Prompt-Abschnitte (Anweisungen, Kontext, Beispiele) zu kennzeichnen – das erleichtert dem Modell das Strukturverständnis. Verneinungen vermeiden: Besser „verwende einen lockeren Ton“ als „sei nicht zu förmlich“. Varianten systematisch testen, jeweils nur ein Element ändern, um den Einfluss zu erkennen. Erfolgreiche Prompts dokumentieren und zentral speichern, sodass Teams geprüfte Vorlagen wiederverwenden und anpassen können. Leistungsmetriken überwachen (Genauigkeit, Relevanz, Konsistenz, Nutzerzufriedenheit), um objektiv zu prüfen, ob die Prompts die Ziele erreichen. Feedbackschleifen integrieren, damit Nutzerfeedback direkt in die Prompt-Optimierung einfließt. Unternehmen, die diese Praktiken anwenden, berichten von deutlich verbesserter Qualität und Konsistenz der KI-Ausgaben und weniger manuellen Korrekturen.

Die Verbindung zwischen Prompt Engineering und KI-Sichtbarkeitsmonitoring gewinnt für Unternehmen zunehmend an Bedeutung, die nachvollziehen möchten, wie ihre Marken, Produkte und Inhalte in KI-generierten Antworten erscheinen. Plattformen wie AmICited verfolgen Markenerwähnungen auf ChatGPT, Perplexity, Google AI Overviews und Claude – doch die eingegebenen Prompts bestimmen direkt, welche Informationen die KI abruft und zitiert. Unternehmen mit Prompt-Engineering-Kompetenz können gezielte Anfragen formulieren, um ihre Markenrepräsentation, die Nennung von Wettbewerbern und die Korrektheit von Zitaten zu analysieren. Beispielsweise kann ein Unternehmen Prompts wie „Was sind die besten Lösungen für Enterprise Data Management?“ gestalten, um zu sehen, wie KI-Systeme seine Angebote im Vergleich zu Mitbewerbern positionieren. Durch die Analyse der Prompts, die zu positiven oder negativen Markenerwähnungen führen, können Unternehmen Content-Strategien entwickeln, um ihre Sichtbarkeit in KI-Antworten zu verbessern. Das eröffnet eine neue Dimension im Suchmaschinenmarketing (SEO) und Markenmanagement, bei der das Verständnis für die Kommunikation mit KI-Systemen genauso wichtig wird wie klassische Keyword-Optimierung. Unternehmen, die in Prompt-Engineering-Expertise investieren, sichern sich strategische Vorteile im KI-getriebenen Informationsumfeld und stellen sicher, dass ihre Marke angemessen und korrekt vertreten wird.

Ob ein Prompt wirklich effektiv ist, muss anhand klarer, objektiver Kriterien bewertet werden, die den Geschäftszielen entsprechen. Genauigkeit misst, ob die Ausgaben faktisch korrekt sind – unerlässlich in sensiblen Bereichen wie Gesundheit, Finanzen oder Recht. Relevanz prüft, wie eng das Ergebnis zur ursprünglichen Nutzerintention passt, oft gemessen durch semantische Ähnlichkeit oder manuelle Bewertung. Konsistenz bewertet, ob identische Prompts mehrfach ähnliche Antworten erzeugen – kritisch für verlässliches, vorhersagbares Verhalten. Vollständigkeit prüft, ob alle geforderten Informationen enthalten sind, gemessen als Anteil der abgedeckten Bestandteile. Spezifizität beurteilt den Detailgrad, wichtig für technische Dokumentation und Spezialgebiete. Lesbarkeit und Kohärenz messen Klarheit und logischen Aufbau, mit Lesbarkeitsformeln oder durch Menschen bewertet. Nutzerzufriedenheit spiegelt wider, wie zufrieden Endnutzer mit den Ergebnissen sind – meist über Umfragen oder integrierte Feedbackmechanismen erfasst. Unternehmen, die umfassende Bewertungsrahmen einsetzen, berichten von 40–60 % besseren Promptergebnissen durch systematisches Messen und Optimieren. Tools wie Portkey, DSPy und Hugging Face Evaluate Library bieten automatisierte Metriken; A/B-Testing-Plattformen ermöglichen den Vergleich von Prompt-Versionen. Die besten Unternehmen kombinieren mehrere Bewertungsmethoden und gewichten die Metriken nach eigenen Prioritäten zu einem umfassenden Qualitätswert.

Der Arbeitsmarkt für Prompt Engineering ist explosionsartig gewachsen und spiegelt die zentrale Bedeutung dieser Fähigkeit im KI-Zeitalter wider. 2025 berichtet Glassdoor von einem durchschnittlichen Grundgehalt von rund 123.274 US-Dollar jährlich für Prompt Engineers, mit Gehaltsspannen von 90.000 (25. Perzentil) bis über 335.000 US-Dollar bei Spezialistenrollen führender KI-Anbieter wie Anthropic. Auf Indeed sind über 110.000 Prompt-Engineer-Stellen ausgeschrieben – ein anhaltend hoher Bedarf über alle Branchen hinweg. Big Tech-Unternehmen wie Google, Microsoft, Amazon und Meta werben aktiv um Prompt Engineers mit Gehältern zwischen 110.000 und 250.000 US-Dollar. KI-Spezialisten wie OpenAI, Anthropic, Cohere und Midjourney bieten herausfordernde Aufgaben mit Remote-Kultur und attraktiven Beteiligungen. Großunternehmen aus Finanz-, Gesundheits-, Versicherungs- und anderen regulierten Branchen stellen Prompt Engineers für die KI-Integration ein, oft mit Titeln wie „AI Solutions Architect“. Beratungen – von den Big Four bis zu Spezialisten wie Booz Allen Hamilton – bieten bis zu 212.000 US-Dollar für Projekte im staatlichen und Unternehmensumfeld. Freelance-Möglichkeiten auf Plattformen wie Upwork und Toptal bringen erfahrenen Profis 100 bis 300 US-Dollar pro Stunde. Die Karriere erfordert meist ein Informatikstudium oder einen verwandten Abschluss, aber auch Quereinsteiger aus Journalismus, Schreiben und kreativen Berufen sind erfolgreich. Entscheidend sind nachweisliche Praxis mit KI-Tools, ein Portfolio mit Prompt-Engineering-Beispielen und die Bereitschaft zum lebenslangen Lernen.

Prompt Engineering steht vor einem bedeutenden Wandel, da KI-Technologie und Unternehmenspraxis reifer werden. Multimodales Prompting wird zunehmend Text, Code, Bilder und weitere Datentypen in einzelnen Prompts kombinieren, wodurch Ingenieure das Zusammenspiel verschiedener Modalitäten verstehen müssen. Adaptive Prompts, die sich dynamisch an Kontext, Nutzerverhalten und Echtzeit-Feedback anpassen, werden immer ausgereifter – der Übergang von statischen Vorlagen zu dynamischen, reaktiven Systemen schreitet voran. Context Engineering entwickelt sich als Erweiterung von Prompt Engineering und betont den umfassenden Kontext jenseits des reinen Prompt-Texts. Ethik- und Fairness-orientiertes Prompting gewinnt an Bedeutung, da Organisationen Wert auf verantwortungsvollen KI-Einsatz legen und Prompts gezielt Bias mindern, Transparenz sicherstellen und regulatorische Vorgaben erfüllen müssen. Integration mit KI-Agenten verwischt die Grenzen zwischen Prompt Engineering und umfassender KI-Orchestrierung, da Prompts Bausteine größerer autonomer Systeme werden. Die Rolle des „Prompt Engineer“ könnte sich weiterentwickeln oder mit angrenzenden Rollen wie „AI Strategist“, „Context Engineer“ oder „AI Product Manager“ verschmelzen – ein Zeichen für die Reife des Felds. Unternehmen, die heute in Prompt-Engineering-Know-how investieren, sind in der KI-getriebenen Wirtschaft gut aufgestellt, denn die Fähigkeit, effektiv mit KI-Systemen zu kommunizieren und sie zu steuern, wird zunehmend zum Wettbewerbsfaktor. Für Unternehmen, die mit AmICited die Markensichtbarkeit in KI-Antworten überwachen, wird Prompt-Engineering-Know-how unverzichtbar, um die eigene Präsenz in der KI-Suche zu optimieren und eine korrekte Darstellung auf Plattformen wie ChatGPT, Perplexity, Google AI und Claude sicherzustellen.

Prompt Engineering unterscheidet sich grundsätzlich von traditioneller Programmierung: Anstatt expliziten Code zu schreiben, der das Verhalten direkt steuert, führen Prompt Engineers KI-Modelle durch Anweisungen in natürlicher Sprache. Traditionelle Programmierung erfordert präzise Syntax und Logik, während Prompt Engineering auf iterativer Verfeinerung, Kontextbereitstellung und strategischer Formulierung beruht, um KI-Ausgaben in die gewünschte Richtung zu lenken. Beide benötigen Problemlösungskompetenz, aber Prompt Engineering legt mehr Wert auf Kommunikation und Experimentieren als auf strikte Code-Syntax.

Prompt Engineering beeinflusst direkt, wie Marken in KI-generierten Antworten auf Plattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude erscheinen. Gut gestaltete Prompts können beeinflussen, ob und wie KI-Systeme Marken zitieren, erwähnen oder empfehlen. Für Organisationen, die Tools wie AmICited zur Überwachung der KI-Sichtbarkeit nutzen, hilft das Verständnis von Prompt Engineering dabei, vorherzusagen und zu optimieren, wie ihre Marke in KI-Antworten erscheint, sodass eine genaue Darstellung und eine wettbewerbsfähige Positionierung in der KI-Suchlandschaft sichergestellt werden.

Zu den wichtigsten Techniken gehören Chain-of-Thought Prompting (komplexe Probleme in Schritte aufteilen), Few-Shot Prompting (Beispiele geben), Zero-Shot Prompting (direkte Anweisungen), Prompt Chaining (Aufgaben in Teilaufgaben unterteilen) und Tree-of-Thought Prompting (mehrere Denkwege gleichzeitig verfolgen). Die Wirksamkeit der einzelnen Technik hängt von der Aufgabenkomplexität, den Modellfähigkeiten und dem gewünschten Ausgabetyp ab. Erfolgreiche Implementierungen kombinieren meist mehrere Techniken, die auf den jeweiligen Anwendungsfall zugeschnitten sind.

Die Effektivität von Prompts wird anhand von Kennzahlen wie Genauigkeit (faktische Korrektheit), Relevanz (Ausrichtung auf die Intention), Konsistenz (Reproduzierbarkeit), Vollständigkeit (Abdeckung der erforderlichen Elemente) und Nutzerzufriedenheit gemessen. Evaluierungsmethoden umfassen manuelle Überprüfung, automatisierte Bewertung mit Tools wie BLEU und ROUGE Scores, A/B-Tests verschiedener Prompt-Varianten und das Sammeln von direktem Nutzerfeedback. Organisationen kombinieren oft mehrere Kennzahlen zu einem gewichteten Score, der ihre spezifischen Prioritäten widerspiegelt.

Prompt Engineers benötigen starke Kommunikations- und Schreibfähigkeiten, Verständnis dafür, wie große Sprachmodelle funktionieren, Vertrautheit mit KI-Konzepten wie Tokenisierung und Kontextfenster sowie kreative Problemlösungsfähigkeiten. Technische Fähigkeiten in Python, SQL oder JavaScript sind oft bevorzugt, aber nicht zwingend erforderlich. Fachexpertise in bestimmten Branchen (Gesundheitswesen, Finanzen, Recht) wird überdurchschnittlich vergütet. Am wichtigsten ist, dass erfolgreiche Prompt Engineers kontinuierliches Lernen und Experimentieren zeigen.

Prompt Engineering ist entscheidend für die KI-Überwachung, da die Prompts, die Nutzer in KI-Systeme eingeben, bestimmen, welche Informationen diese Systeme abrufen und zitieren. Durch das Verständnis von Prompt Engineering können Organisationen gezielt Anfragen formulieren, um herauszufinden, wie ihre Marke, Inhalte oder Domäne in KI-Antworten erscheint. AmICited verfolgt diese Erwähnungen über mehrere KI-Plattformen hinweg, sodass Prompt-Engineering-Kenntnisse wesentlich für die Optimierung der Markensichtbarkeit in KI-generierten Inhalten sind.

Der Arbeitsmarkt für Prompt Engineering bleibt robust, mit Durchschnittsgehältern von etwa 123.274 US-Dollar jährlich laut Glassdoor; die Gehälter reichen von 90.000 bis über 335.000 US-Dollar, abhängig von Erfahrung und Unternehmen. Über 110.000 Prompt-Engineer-Stellen sind derzeit auf Jobbörsen ausgeschrieben. Das Feld entwickelt sich von einer Spezialistenrolle hin zu umfassenderen Aufgaben im Bereich KI-Integration, mit Möglichkeiten bei Technologieunternehmen, Großunternehmen, Beratungen und auf Freelancer-Plattformen. Remote-Arbeit ist weit verbreitet, sodass der geografische Standort weniger einschränkend ist.

Prompt Engineering wird sich voraussichtlich in Richtung multimodales Prompting (Kombination von Text, Code und Bildern), adaptive Prompts, die sich je nach Kontext anpassen, und einen stärkeren Fokus auf KI-Ethik und Fairness entwickeln. Mit zunehmenden Fähigkeiten der KI-Modelle kann sich Prompt Engineering mit übergeordneten KI-Strategie- und Kontext-Engineering-Rollen verschmelzen. Das Feld wird verantwortungsvolle KI-Praktiken, die Minderung von Bias und Transparenz bei KI-generierten Ausgaben — insbesondere auf von AmICited überwachten Plattformen — weiter betonen.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, was Prompt Engineering ist, wie es mit KI-Suchmaschinen wie ChatGPT und Perplexity funktioniert, und entdecken Sie wichtige Techniken, um Ihre KI-...

Erfahren Sie, wie Prompt Engineering Ihre GEO-Strategie verbessert, damit Ihre Marke von KI-Suchmaschinen wie ChatGPT, Perplexity und Google AI Overviews zitier...

Diskussion in der Community darüber, ob Marketer Prompt-Engineering-Kenntnisse benötigen, um für die KI-Suche zu optimieren. Verstehen, wie Nutzer KI-Systeme ab...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.