Quality Rater Guidelines

Erfahren Sie mehr über Googles Quality Rater Guidelines, das Bewertungsframework, das von über 16.000 Bewertern verwendet wird, um Suchqualität, E-E-A-T-Signale...

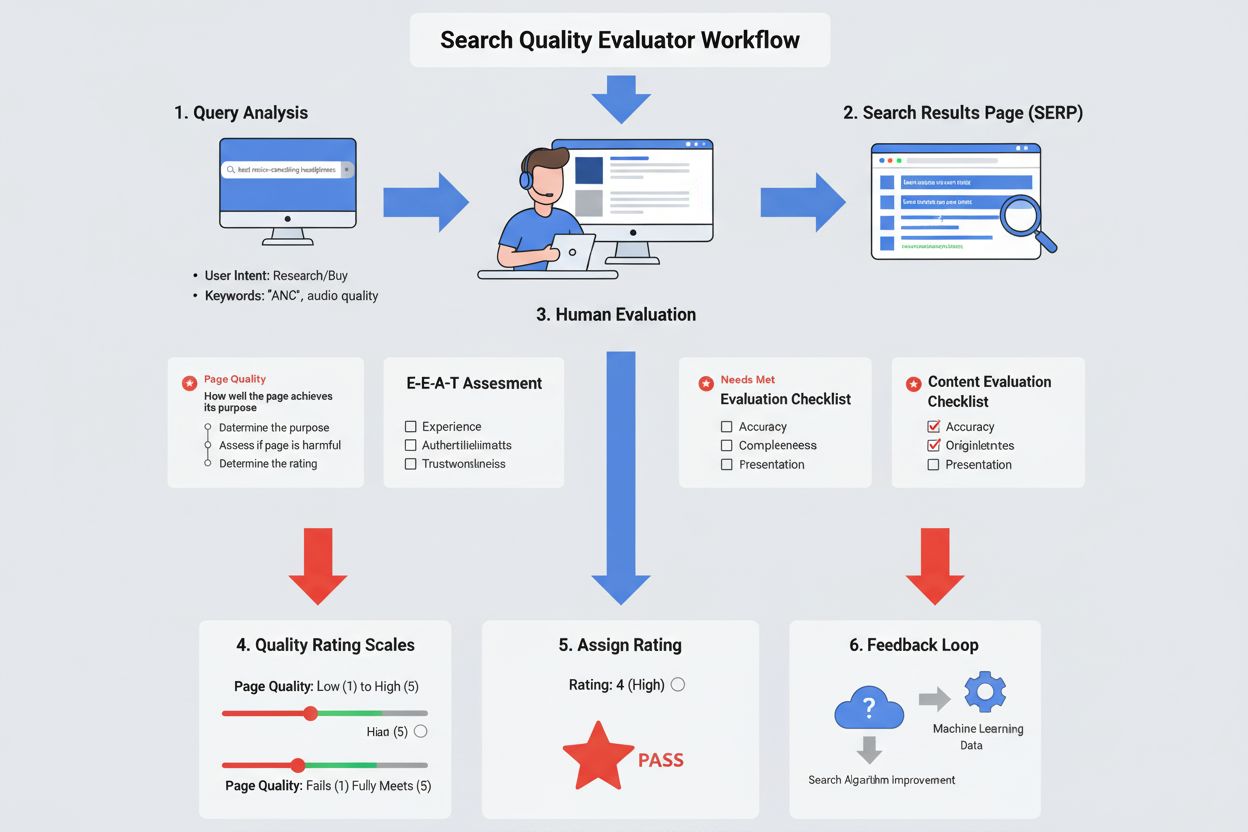

Ein Search Quality Evaluator ist ein menschlicher Prüfer, der von Google (meistens über Drittanbieter-Unternehmen) beschäftigt wird und die Qualität und Relevanz von Suchergebnissen auf Grundlage festgelegter Richtlinien bewertet. Diese Evaluatoren bewerten Suchergebnisse anhand von Kriterien wie E-E-A-T (Erfahrung, Fachwissen, Autorität, Vertrauenswürdigkeit), Inhaltsqualität und Erfüllung der Nutzerintention, um Google dabei zu unterstützen, die Leistung seines Suchalgorithmus zu messen und zu verbessern.

Ein Search Quality Evaluator ist ein menschlicher Prüfer, der von Google (meistens über Drittanbieter-Unternehmen) beschäftigt wird und die Qualität und Relevanz von Suchergebnissen auf Grundlage festgelegter Richtlinien bewertet. Diese Evaluatoren bewerten Suchergebnisse anhand von Kriterien wie E-E-A-T (Erfahrung, Fachwissen, Autorität, Vertrauenswürdigkeit), Inhaltsqualität und Erfüllung der Nutzerintention, um Google dabei zu unterstützen, die Leistung seines Suchalgorithmus zu messen und zu verbessern.

Ein Search Quality Evaluator ist ein menschlicher Prüfer, der von Google (in der Regel über Drittanbieter-Unternehmen) beschäftigt wird und systematisch die Qualität, Relevanz und Nützlichkeit von Suchergebnissen bewertet. Diese Evaluatoren, rund 16.000 weltweit, wenden standardisierte Richtlinien an, um Suchergebnisse nach verschiedenen Kriterien wie Inhaltsqualität, Erfüllung der Nutzerintention und Einhaltung der E-E-A-T-Prinzipien (Erfahrung, Fachwissen, Autorität und Vertrauenswürdigkeit) zu bewerten. Ihre Hauptfunktion besteht nicht darin, Rankings direkt zu bestimmen, sondern menschliches Feedback zu liefern, das Google dabei hilft, die Effektivität seiner Suchalgorithmen hinsichtlich der Bereitstellung nützlicher, autoritativer und vertrauenswürdiger Informationen für Nutzer in verschiedenen Regionen und Sprachen zu messen. Search Quality Evaluators sind eine wichtige Brücke zwischen menschlichem Urteil und maschinellem Lernen und stellen sicher, dass Googles automatisierte Systeme den echten Nutzerbedürfnissen und -erwartungen entsprechen.

Google startete sein Search Quality Rating Program im Jahr 2005 zunächst mit einem kleinen Team von Evaluatoren. Über beinahe zwei Jahrzehnte entwickelte sich das Programm zu einem ausgefeilten Qualitätssicherungsmechanismus mit Tausenden von menschlichen Prüfern. Im August 2022 gab Google das Bestehen und den Umfang dieses Programms offiziell bekannt, indem erstmals ein umfassendes öffentliches Dokument veröffentlicht wurde, das erklärt, wer diese Evaluatoren sind und wie sie arbeiten. Diese Transparenz markierte einen bedeutenden Wandel, da das Programm zuvor weitgehend geheim gehalten wurde. Die Richtlinien wurden kontinuierlich erweitert und verfeinert, mit großen Updates im November 2023 und Januar 2025, die Googles sich wandelnde Prioritäten bezüglich Inhaltsqualität, KI-Generierung, Spam-Erkennung und Nutzerzufriedenheit widerspiegeln. Laut offiziellen Google-Angaben wurden allein im Jahr 2023 über 719.326 Suchqualitäts-Tests durchgeführt – ein Beleg für die Bedeutung und den Umfang dieses Bewertungsprozesses zur Sicherung der Suchqualität.

Search Quality Evaluators führen eine Vielzahl von Bewertungsaufgaben aus, die Googles Verständnis von Suchqualität direkt beeinflussen. Ihre Hauptaufgaben sind die Bewertung der Seitenqualität (ob Seiten ihren angegebenen Zweck erfüllen), die Needs Met-Bewertung (wie gut Suchergebnisse die Nutzerintention erfüllen) und Side-by-Side-Experimente, bei denen zwei Versionen von Suchergebnissen verglichen und die bessere bestimmt wird. Evaluatoren überprüfen verschiedene Aspekte jeder Seite wie die Qualität des Hauptinhalts, den Ruf von Websites und Content-Erstellern, die Platzierung und Häufigkeit von Werbung sowie das gesamte Nutzererlebnis. Sie recherchieren außerdem den Ruf von Websites und Autoren durch unabhängige Bewertungen, Nachrichtenartikel und Expertenmeinungen. Zusätzlich identifizieren und melden sie problematische Inhalte wie Spam, schädliche Informationen, irreführende Praktiken und KI-generierte Inhalte mit minimalem Aufwand. Jede Bewertungsaufgabe erfordert eine sorgfältige Analyse der Suchanfrage, das Verständnis der Nutzerintention, die Überprüfung der Inhaltsgenauigkeit und das Urteil, ob das Ergebnis tatsächlich den Nutzerbedürfnissen dient.

| Aspekt | Search Quality Evaluator | SEO-Profi | Content-Moderator | Algorithmus-Ingenieur |

|---|---|---|---|---|

| Hauptfunktion | Bewertung der Suchergebnisqualität & Nutzerzufriedenheit | Optimierung der Sichtbarkeit von Websites | Überprüfung von Inhalten auf Richtlinienverstöße | Entwicklung und Verbesserung von Ranking-Algorithmen |

| Anstellungsart | Drittanbieter (temporär/kurzfristig) | Website-Besitzer/Agentur-Mitarbeiter | Plattform-Mitarbeiter (Vollzeit) | Google-Mitarbeiter (Vollzeit) |

| Entscheidungsbefugnis | Gibt Bewertungen & Feedback; keine direkte Ranking-Kontrolle | Beeinflusst Rankings durch Optimierung | Entfernt/meldet Verstöße | Kontrolliert algorithmische Ranking-Faktoren |

| Arbeitsumfang | Bewertet Beispielanfragen & Ergebnisse | Optimiert spezifische Websites/Seiten | Überwacht nutzergenerierte Inhalte | Entwickelt systemweite Verbesserungen |

| Auswirkungen auf Rankings | Indirekt (aggregiertes Feedback verbessert Algorithmen) | Direkt (Optimierung beeinflusst Sichtbarkeit) | Indirekt (entfernt schädliche Inhalte) | Direkt (Algorithmen bestimmen Rankings) |

| Schlüsselmetriken | Page Quality, Needs Met, E-E-A-T-Bewertungen | Keyword-Rankings, organischer Traffic | Inhaltsverstöße, Nutzermeldungen | Algorithmus-Leistung, Relevanzwerte |

| Schulungsanforderungen | Richtlinientest, Lokalkompetenz | SEO-Kenntnisse, Branchenerfahrung | Richtlinienschulung, Inhaltsvorgaben | Informatik, maschinelles Lernen |

| Typischer Arbeitsumfang | 50–100+ Bewertungen pro Tag | Laufende Optimierungsprojekte | Kontinuierliche Inhaltsprüfung | Entwicklungszyklen für Algorithmen |

Das E-E-A-T-Framework bildet das Fundament, nach dem Search Quality Evaluators die Glaubwürdigkeit und Qualität von Inhalten beurteilen. Experience meint die eigene oder direkte Erfahrung der Autoren – z.B. wiegt eine Produktbewertung von jemandem, der das Produkt tatsächlich genutzt hat, schwerer als bloße Spekulation. Expertise umfasst Wissen, Fähigkeiten und formale Ausbildung zum Thema; medizinische Ratschläge sollten von Gesundheitsexperten stammen, finanzielle Empfehlungen von qualifizierten Finanzexperten. Authoritativeness bewertet, ob die Autoren oder Websites als anerkannte Quellen für das Thema gelten – z.B. Regierungsseiten für amtliche Informationen, etablierte Nachrichtenorganisationen für Journalismus. Trustworthiness ist vielleicht die wichtigste Dimension und beurteilt, ob die Seite korrekt, ehrlich, sicher und verlässlich ist. Vertrauen ist das wichtigste Element der E-E-A-T-Familie – eine unseriöse Seite hat unabhängig von Erfahrung, Fachwissen oder Autorität niedrige E-E-A-T. Für YMYL-Themen (Your Money or Your Life) wie Gesundheit, Finanzen, Recht und bürgerliche Informationen legen Evaluatoren besonders hohe E-E-A-T-Maßstäbe an, da falsche Angaben Nutzer direkt schädigen könnten.

Search Quality Evaluators verwenden eine fünfstufige Page Quality-Bewertungsskala von Niedrigster bis Höchster Qualität, mit den Zwischenwerten Niedrig, Mittel und Hoch. Die niedrigste Bewertung erhalten Seiten mit schädlichem Zweck, irreführenden Inhalten, unseriösen Informationen oder Spam-Merkmalen. Eine niedrige Bewertung gibt es bei fehlendem E-E-A-T, wenig Aufwand, irreführenden Titeln oder ablenkender Werbung. Mittlere Qualität bedeutet, dass Seiten ihren Zweck ausreichend erfüllen, aber keine besonderen Merkmale aufweisen – das betrifft die meisten Internetseiten. Hohe Qualität zeigen Seiten mit erheblichem Aufwand, Originalität, Talent oder Fachwissen, positivem Ruf und hohem E-E-A-T bezogen auf das jeweilige Thema. Höchste Qualität steht für außergewöhnliche Inhalte mit sehr hohem E-E-A-T, sehr positivem Ruf und herausragendem Engagement und Originalität. Der Bewertungsprozess verlangt, dass Evaluatoren zunächst den Zweck der Seite verstehen, dann prüfen, ob der Zweck schädlich oder irreführend ist, und abschließend eine Bewertung abgeben, wie gut die Seite ihren Zweck unter Einhaltung der Qualitätsstandards erfüllt. Dieser dreistufige Prozess gewährleistet eine konsistente, fundierte Bewertung durch Tausende von Evaluatoren weltweit.

Neben der Bewertung der Seitenqualität beurteilen Search Quality Evaluators auch, wie gut Suchergebnisse die Nutzerintention erfüllen – mittels der Needs Met (NM)-Bewertungsskala. Diese Skala umfasst fünf Hauptbewertungen: Vollständig erfüllt (FullyM) für Ergebnisse, die eine spezifische, eindeutige Suchanfrage komplett erfüllen (typisch bei Navigationsanfragen nach bestimmten Websites); Hoch erfüllt (HM) für sehr hilfreiche Ergebnisse, die dominante, verbreitete oder sinnvolle Nebenintentionen abdecken; Mittelmäßig erfüllt (MM) für hilfreiche, aber weniger zufriedenstellende Ergebnisse; Geringfügig erfüllt (SM) für Ergebnisse, die nur minimal helfen oder unwahrscheinliche Intentionen abdecken; und Erfüllt nicht (FailsM) für Ergebnisse, die die Nutzerbedürfnisse vollständig verfehlen oder thematisch abweichen. Evaluatoren bestimmen zunächst die Nutzerintention durch Analyse der Suchanfrage, berücksichtigen den Standort des Nutzers (falls relevant) und unterschiedliche Interpretationen der Anfrage. Anschließend bewerten sie, ob das Ergebnis die Intention tatsächlich erfüllt, z.B. unter Berücksichtigung von Aktualität, Richtigkeit und Relevanz. Diese Doppelbewertung – Kombination aus Seitenqualität und Needs Met – liefert Google umfassendes Feedback über die intrinsische Qualität von Seiten und deren praktischen Nutzen für spezifische Suchanfragen.

Search Quality Evaluators prüfen verschiedene Dimensionen bei der Bewertung von Inhaltsqualität und Relevanz. Sie untersuchen den Hauptinhalt (MC) darauf, ob er direkt zum Zweck der Seite beiträgt, und bewerten den Aufwand, die Originalität, das Talent und die Fähigkeiten, die in die Erstellung eingeflossen sind. Sie identifizieren ergänzende Inhalte (SC), die das Nutzererlebnis verbessern, aber nicht direkt dem Seitenzweck dienen, etwa Navigationslinks. Sie bewerten das Vorhandensein und die Platzierung von Werbung und Monetarisierung – Werbung ist akzeptabel und für viele Seiten notwendig, darf den Hauptinhalt aber nicht verdecken oder stören. Evaluatoren recherchieren den Ruf von Websites und Autoren durch unabhängige Bewertungen, Nachrichten, Expertenmeinungen und Kundenfeedback. Sie prüfen Autorenqualifikationen und Fachwissen anhand von Ausbildung, beruflicher Erfahrung und bisherigen Veröffentlichungen. Sie überprüfen die Richtigkeit von Inhalten durch Abgleich mit anerkannten Quellen, insbesondere bei YMYL-Themen. Sie bewerten Seitengestaltung und Nutzererlebnis, etwa ob Inhalte leicht zugänglich sind oder von Werbung verdeckt werden. Außerdem identifizieren sie problematische Inhaltsmuster wie kopierte oder umformulierte Inhalte ohne Mehrwert, KI-generierte Texte mit wenig Aufwand, irreführende Überschriften, irreführendes Design und Inhalte, die dem Expertenkonsens widersprechen.

Seit dem Update der Search Quality Rater Guidelines im Januar 2025 beurteilen Evaluatoren gezielt, ob Inhalte mit automatisierten oder generativen KI-Tools erstellt wurden. Seiten mit Hauptinhalten, die „automatisch oder KI-generiert“ und mit „kaum Aufwand, Originalität oder Mehrwert“ erstellt wurden, erhalten die niedrigste Qualitätsbewertung. Evaluatoren suchen nach Hinweisen wie umformulierten Inhalten mit minimalen Änderungen, generischen Sprachmustern, allgemein bekannten Informationen ohne eigene Erkenntnisse, hohem Überlapp mit bestehenden Quellen wie Wikipedia und typischen Formulierungen wie „Als KI-Sprachmodell“. Die Richtlinien stellen aber klar: KI an sich ist nicht problematisch – sie kann ein hilfreiches Werkzeug sein, wenn sie mit erheblichem menschlichem Aufwand, originellen Ergänzungen und echtem Mehrwert eingesetzt wird. Der Unterschied liegt darin, ob KI als Kreativitätswerkzeug oder als Abkürzung für massenhaft minderwertige Inhalte genutzt wird. Das spiegelt Googles Fokussierung auf Massenmissbrauch von Inhalten wider, bei dem große Mengen minderwertiger Texte mit minimaler menschlicher Kontrolle erstellt werden, unabhängig von der Methode.

Auch wenn Search Quality Evaluators Rankings nicht direkt beeinflussen, hat ihre Arbeit erheblichen indirekten Einfluss auf die Weiterentwicklung von Googles Algorithmen. Google nutzt die aggregierten Bewertungen Tausender Evaluatoren, um die Effektivität seiner Rankingsysteme zu messen und Bereiche zu identifizieren, in denen Algorithmen keine hochwertigen Ergebnisse liefern. Werden bestimmte Ergebnisse durchgehend als minderwertig bewertet, signalisiert das an Googles Technikteams, dass der Algorithmus nachgebessert werden muss. Evaluatoren liefern auch positive und negative Beispiele, die beim Training der maschinellen Lernsysteme helfen, Qualitätssignale zu erkennen. 2023 führte Google über 719.326 Suchqualitäts-Tests und mehr als 4.000 Verbesserungen der Suche durch, teils basierend auf Evaluatorenfeedback. Zudem wurden 16.871 Live-Traffic-Experimente und 124.942 Side-by-Side-Experimente mit Qualitätsprüfern durchgeführt. Dieser datenbasierte Ansatz stellt sicher, dass Algorithmus-Verbesserungen auf menschlichem Urteil über Qualität und Nützlichkeit basieren. Die Rückkopplung zwischen menschlichen Evaluatoren und maschinellem Lernen schafft einen kontinuierlichen Verbesserungszyklus, in dem Algorithmen Muster hochwertiger Inhalte erkennen, wie sie von Experten bewertet werden.

Search Quality Evaluators werden über ein Netzwerk von Drittanbieter-Unternehmen rekrutiert, nicht direkt von Google angestellt. Die Auswahl ist anspruchsvoll: Google sucht Kandidaten, die mit ihrer Aufgaben-Sprache und Region sehr vertraut sind, Suchmaschinen sicher nutzen und die Bedürfnisse sowie kulturellen Standards der lokalen Nutzer repräsentieren können. Potenzielle Evaluatoren müssen einen umfassenden Test zu den Search Quality Rater Guidelines bestehen. Diese Richtlinien, mittlerweile über 160 Seiten lang, enthalten detaillierte Kriterien zur Seitenbewertung, Nutzerintention, E-E-A-T, Spam- und Schadinhaltserkennung sowie zur Bewertung der Ergebnisrelevanz. Umfangreiche Beispiele und Fallstudien sorgen für konsistente Auslegung. Evaluatoren arbeiten meist mit kurzfristigen Verträgen, die verlängert werden können, aber nicht unbegrenzt laufen – das verhindert Interessenkonflikte oder Manipulationsversuche. Evaluatoren sind ausdrücklich angewiesen, dass ihre Bewertungen nicht auf persönlichen Meinungen, Vorlieben, religiösen oder politischen Überzeugungen basieren dürfen, sondern objektiv nach den Richtlinien und den kulturellen Standards ihrer Region erfolgen müssen. Diese Betonung von Objektivität und Richtlinientreue sorgt dafür, dass Bewertungen echte Qualitätsbeurteilungen und keine Einzelmeinungen darstellen.

Rund um die Rolle der Search Quality Evaluators gibt es zahlreiche Missverständnisse. Erstes Missverständnis: Evaluatoren bestimmen direkt Rankings oder vergeben Strafen. Fakt: Sie liefern Feedback zur Messung der Algorithmuseffektivität, aber einzelne Bewertungen beeinflussen keine spezifischen Rankings. Zweites Missverständnis: Hohe Seitenqualität garantiert hohe Sichtbarkeit. Fakt: Page Quality ist nur ein Kriterium; auch hochwertige Seiten können schlecht ranken, wenn sie nicht der Nutzerintention entsprechen oder andere Seiten relevanter sind. Drittes Missverständnis: E-E-A-T ist ein Rankingfaktor. Fakt: E-E-A-T ist ein Bewertungsrahmen für Evaluatoren, und auch wenn Algorithmen E-E-A-T-Prinzipien berücksichtigen, ist es kein direktes Ranking-Signal. Viertes Missverständnis: Evaluatoren lassen sich beeinflussen oder manipulieren. Fakt: Kurzfristige Verträge, umfassende Richtlinien und Qualitätssicherung machen Manipulation unwahrscheinlich. Fünftes Missverständnis: Alle KI-generierten Inhalte erhalten die niedrigste Bewertung. Fakt: KI-Tools, die mit erheblichem menschlichem Aufwand, originellen Ergänzungen und echtem Mehrwert genutzt werden, können durchaus bessere Bewertungen erhalten; problematisch ist massenhaft minderwertige KI-Generierung.

Die Rolle der Search Quality Evaluators entwickelt sich weiter, da Google vor neuen Herausforderungen bei der Sicherung der Suchqualität steht. Die zunehmende Verbreitung von KI-generierten Inhalten hat dazu geführt, dass Google KI explizit in den Richtlinien thematisiert und Evaluatoren im Erkennen minderwertiger KI-Texte schult. Mit dem Aufkommen von KI-gestützten Suchoberflächen wie Google AI Overviews und Konkurrenz durch KI-Chatbots wie ChatGPT und Claude wächst Googles Bestreben, die Qualitätssicherung durch den Menschen zu betonen. Künftige Entwicklungen könnten umfassen: ausgefeiltere KI-Erkennungsmethoden, erweiterte Bewertung von multimodalen Inhalten (Bilder, Videos, Audio) und stärkere Betonung von lokaler und kultureller Relevanz. Für Content-Ersteller und Website-Betreiber wird das Verständnis der Bewertungsmaßstäbe der Search Quality Evaluators immer wichtiger. Die Betonung von E-E-A-T, originellen Inhalten, nutzerzentriertem Design und authentischer Fachkompetenz zeigt, dass nachhaltiger SEO-Erfolg auf echter Qualität beruht. Die klaren Warnungen vor minderwertiger KI-Generierung, kopierten Inhalten und irreführenden Praktiken machen deutlich, dass Google echten, wertvollen Content belohnen will. Organisationen sollten Fachwissen durch eigene Recherchen belegen, Autorität durch Qualitätsinhalte und positiven Ruf aufbauen und Vertrauenswürdigkeit durch Transparenz und Genauigkeit sicherstellen.

Search Quality Evaluators sind das entscheidende menschliche Element in Googles ansonsten algorithmischem Suchsystem. Ihre Arbeit zeigt: Trotz der Fortschritte im maschinellen Lernen und in der Künstlichen Intelligenz bleibt menschliches Urteil unerlässlich, um Qualität, Relevanz und Vertrauenswürdigkeit zu bewerten. Die rund 16.000 Evaluatoren weltweit, tätig in verschiedenen Sprachen und Regionen, sorgen dafür, dass Googles Suchergebnisse die unterschiedlichen Nutzerbedürfnisse und kulturellen Kontexte widerspiegeln. Durch systematisches Feedback zu Seitenqualität und Nutzerzufriedenheit helfen Evaluatoren Google, seine Algorithmen stetig zu verbessern und nützlichere, autoritativere und vertrauenswürdigere Informationen zu liefern. Wer verstehen möchte, wie Google Inhalte bewertet – ob als Content-Ersteller, SEO-Profi oder neugieriger Nutzer – gewinnt durch das Verständnis der Rolle und Methodik der Search Quality Evaluators wertvolle Einblicke in Googles Qualitätsverständnis und den ständigen Verbesserungsprozess. Mit der fortschreitenden Digitalisierung, KI-generierten Inhalten, neuen Suchoberflächen und sich wandelnden Nutzererwartungen wird die Rolle menschlicher Prüfer noch wichtiger, um die Integrität und Nützlichkeit der Suchergebnisse zu sichern.

Nein, Search Quality Evaluators bestimmen Rankings nicht direkt und verhängen auch keine Strafen für Websites. Ihre Bewertungen dienen vielmehr als Feedback, um Google bei der Messung der Leistung seiner Algorithmen zu unterstützen. Die aggregierten Bewertungen von Tausenden von Evaluatoren liefern Signale, die Google bei der Verbesserung seiner Systeme helfen, aber einzelne Bewertungen wirken sich nicht direkt auf die Ranking-Position einer bestimmten Seite in den Suchergebnissen aus.

E-E-A-T steht für Experience (Erfahrung), Expertise (Fachwissen), Authoritativeness (Autorität) und Trustworthiness (Vertrauenswürdigkeit). Search Quality Evaluators bewerten diese vier Dimensionen, um festzustellen, ob Content-Ersteller und Websites zuverlässige Quellen für ihre Themen sind. E-E-A-T ist besonders kritisch bei YMYL-Themen (Your Money or Your Life) wie Gesundheit, Finanzen und Recht, bei denen falsche Informationen Nutzern schaden könnten. Evaluatoren recherchieren Qualifikationen der Ersteller, den Ruf der Website und die Inhaltsqualität, um das E-E-A-T-Niveau einzuschätzen.

Google beschäftigt weltweit etwa 16.000 Search Quality Evaluators über ein Netzwerk von Drittanbieter-Unternehmen. Diese Evaluatoren sind über verschiedene Regionen und Länder verteilt, um vielfältige Perspektiven und kulturelles Verständnis zu gewährleisten. Die genaue Anzahl kann sich je nach betrieblichem Bedarf ändern, und Evaluatoren arbeiten in der Regel mit kurzfristigen Verträgen, die verlängert werden können, aber im Allgemeinen nicht unbegrenzt andauern.

Search Quality Evaluators verwenden zwei primäre Bewertungssysteme: Page Quality (PQ)-Bewertungen, die beurteilen, wie gut eine Seite ihren Zweck auf einer Skala von Niedrigster bis Höchster Qualität erfüllt, und Needs Met (NM)-Bewertungen, die einschätzen, wie gut ein Ergebnis die Nutzerintention auf einer Skala von 'Erfüllt nicht' bis 'Vollständig erfüllt' befriedigt. Diese Bewertungen helfen Google zu verstehen, ob die Suchergebnisse die Erwartungen der Nutzer erfüllen und autoritative, vertrauenswürdige Inhalte liefern.

YMYL steht für 'Your Money or Your Life' und bezieht sich auf Themen, die die Gesundheit, finanzielle Stabilität, Sicherheit oder das Wohlbefinden einer Person erheblich beeinflussen können. Seiten zu YMYL-Themen unterliegen strengeren Qualitätsbewertungsstandards, da ungenaue oder unseriöse Informationen echten Schaden verursachen könnten. Beispiele sind medizinische Beratung, Finanz- und Rechtsinformationen sowie bürgerliche Informationen. Evaluatoren wenden höhere E-E-A-T-Standards an und verlangen stärkere Nachweise von Fachwissen für YMYL-Inhalte.

Seit Januar 2025 schreiben Googles Richtlinien vor, dass Evaluatoren Seiten mit Hauptinhalten, die mit automatisierten oder generativen KI-Tools erstellt wurden, als niedrigste Qualität bewerten, falls der Inhalt wenig Aufwand, Originalität und Mehrwert aufweist. Evaluatoren achten auf Hinweise auf KI-Generierung wie umformulierte Inhalte mit minimalen Änderungen, generische Sprachmuster oder Formulierungen wie 'Als KI-Sprachmodell'. Werden KI-Tools hingegen mit erheblichem menschlichem Aufwand und originellen Ergänzungen eingesetzt, muss nicht zwingend die niedrigste Bewertung vergeben werden.

Search Quality Evaluators müssen einen umfassenden Test zu Googles Search Quality Rater Guidelines bestehen, bevor sie mit der Arbeit beginnen. Diese Richtlinien umfassen über 160 Seiten und enthalten detaillierte Kriterien für die Bewertung der Seitenqualität, das Verständnis der Nutzerintention, die Bewertung von E-E-A-T, das Erkennen von Spam und schädlichen Inhalten sowie die Relevanzbewertung von Suchergebnissen. Evaluatoren müssen in ihrer Aufgaben-Sprache und Region nachweislich kompetent sein, um die Bedürfnisse und kulturellen Standards der lokalen Nutzer genau abzubilden.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie mehr über Googles Quality Rater Guidelines, das Bewertungsframework, das von über 16.000 Bewertern verwendet wird, um Suchqualität, E-E-A-T-Signale...

Page Quality Rating ist Googles Bewertungsrahmen zur Einschätzung der Webseitenqualität anhand von E-E-A-T, Originalität der Inhalte und Nutzerzufriedenheit. Er...

Qualitätssignale sind Kennzahlen, die Suchmaschinen zur Bewertung der Inhaltsexzellenz verwenden. Erfahren Sie, wie E-E-A-T, Nutzerengagement und andere Faktore...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.