Content-SEO

Content-SEO ist die strategische Erstellung und Optimierung hochwertiger Inhalte, um Suchmaschinenrankings und organische Sichtbarkeit zu verbessern. Lernen Sie...

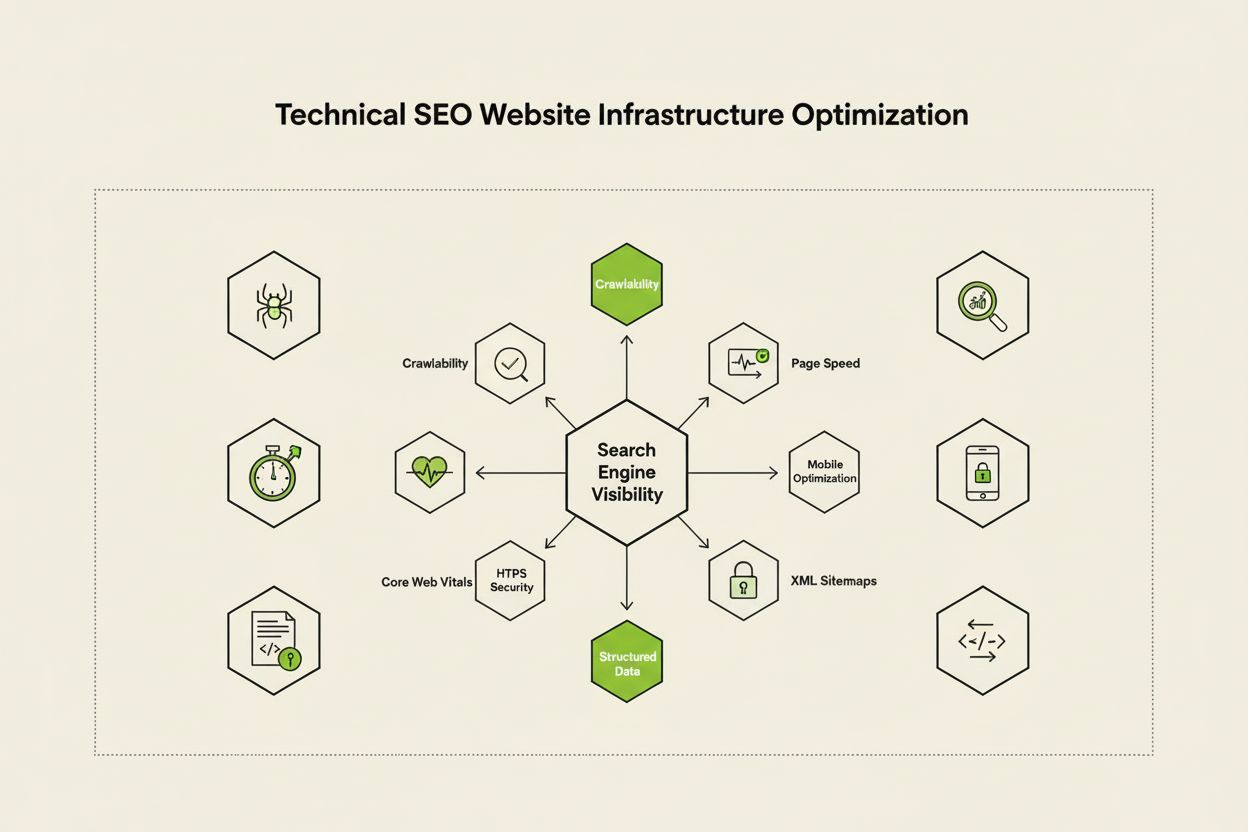

Technisches SEO ist der Prozess der Optimierung der Infrastruktur einer Website, damit Suchmaschinen Inhalte korrekt und effizient crawlen, rendern, indexieren und ausliefern können. Es umfasst Website-Geschwindigkeit, Mobilfreundlichkeit, Seitenarchitektur, Sicherheit und die Implementierung von strukturierten Daten, um sicherzustellen, dass Suchmaschinen Ihre Seiten entdecken und ranken können.

Technisches SEO ist der Prozess der Optimierung der Infrastruktur einer Website, damit Suchmaschinen Inhalte korrekt und effizient crawlen, rendern, indexieren und ausliefern können. Es umfasst Website-Geschwindigkeit, Mobilfreundlichkeit, Seitenarchitektur, Sicherheit und die Implementierung von strukturierten Daten, um sicherzustellen, dass Suchmaschinen Ihre Seiten entdecken und ranken können.

Technisches SEO ist der Prozess der Optimierung der Backend-Infrastruktur einer Website, um sicherzustellen, dass Suchmaschinen Inhalte effizient crawlen, rendern, indexieren und korrekt ausliefern können. Im Gegensatz zum On-Page-SEO, das sich auf Inhaltsqualität und Keyword-Optimierung konzentriert, adressiert technisches SEO die grundlegenden Elemente, die bestimmen, ob Suchmaschinen überhaupt Zugriff auf Ihre Website erhalten und sie verstehen können. Dazu gehören Seitenladegeschwindigkeit, mobile Responsivität, Seitenarchitektur, Sicherheitsprotokolle, Implementierung strukturierter Daten und Faktoren der Crawlability. Technisches SEO bildet das unsichtbare Fundament, auf dem alle anderen SEO-Maßnahmen aufbauen – ohne es bleiben selbst hochwertigste Inhalte für Suchmaschinen und Nutzer unsichtbar. Laut Branchenforschung berichteten 91 % der Marketer im Jahr 2024, dass SEO die Website-Performance verbessert hat, wobei die technische Optimierung eine entscheidende Rolle für messbare Ergebnisse spielt. Die Bedeutung des technischen SEO hat zugenommen, da Suchmaschinen immer ausgefeilter werden und KI-gesteuerte Suchplattformen entstehen, die von Websites immer strengere technische Standards für Sichtbarkeit verlangen.

Technisches SEO basiert auf vier miteinander verbundenen Säulen, die zusammen die Sichtbarkeit in Suchmaschinen maximieren. Crawlability bestimmt, ob Googlebot und andere Suchmaschinen-Crawler auf die Seiten Ihrer Website über Links, Sitemaps und interne Navigationsstrukturen zugreifen können. Indexierbarkeit stellt sicher, dass gecrawlte Seiten tatsächlich im Google-Index gespeichert werden und in den Suchergebnissen erscheinen können. Performance und Core Web Vitals messen, wie schnell Seiten laden und wie reaktionsschnell sie auf Nutzerinteraktionen reagieren – Faktoren, die Rankings und Nutzererfahrung direkt beeinflussen. Mobile Optimierung stellt sicher, dass Ihre Website auf Smartphones und Tablets einwandfrei funktioniert, die laut Sistrix-Studie mittlerweile über 60 % des gesamten Suchtraffics ausmachen. Diese vier Säulen sind voneinander abhängig; Schwächen in einem Bereich können die Wirksamkeit der anderen beeinträchtigen. Beispielsweise wird eine schnell ladende Desktop-Seite, die auf Mobilgeräten schlecht abschneidet, Schwierigkeiten haben, im mobilen Google-Index zu ranken – selbst wenn die Crawlability gut ist. Das Verständnis der Wechselwirkungen dieser Säulen ist unerlässlich, um eine umfassende technische SEO-Strategie zu entwickeln, die alle Aspekte der Sichtbarkeit in Suchmaschinen abdeckt.

Obwohl oft verwechselt, stellen Crawlability und Indexierbarkeit zwei unterschiedliche Phasen im Suchmaschinenprozess dar. Crawlability bezieht sich auf die Fähigkeit einer Suchmaschine, die Seiten Ihrer Website über interne Links, externe Backlinks und XML-Sitemaps zu entdecken und darauf zuzugreifen. Sie beantwortet die Frage: „Kann der Googlebot diese Seite erreichen?“ Ist eine Seite nicht crawlbar – etwa weil sie von robots.txt blockiert, hinter JavaScript versteckt oder als verwaiste Seite ohne interne Links existiert –, kann sie nicht indexiert werden. Indexierbarkeit hingegen bestimmt, ob eine gecrawlte Seite tatsächlich im Google-Index gespeichert wird und in Suchergebnissen erscheinen kann. Eine Seite kann perfekt crawlbar, aber trotzdem nicht indexiert sein, wenn sie ein noindex-Meta-Tag enthält, doppelte Inhalte aufweist oder nicht den Qualitätsanforderungen von Google genügt. Laut dem umfassenden technischen SEO-Leitfaden von Search Engine Land ist es entscheidend, diesen Unterschied zu verstehen, da die Behebung von Crawlability-Problemen andere Lösungen erfordert als die von Indexierbarkeitsproblemen. Crawlability-Probleme betreffen meist die Seitenstruktur, robots.txt-Konfiguration und interne Verlinkung, während Indexierbarkeitsprobleme oft mit Meta-Tags, Canonical-Tags, Inhaltsqualität und Rendering zusammenhängen. Beide Bereiche müssen adressiert werden, um optimale Suchsichtbarkeit zu erreichen.

Core Web Vitals sind drei spezifische Kennzahlen, mit denen Google die reale Nutzererfahrung misst und die das Suchranking direkt beeinflussen. Largest Contentful Paint (LCP) misst, wie schnell das größte sichtbare Element einer Seite lädt – Google empfiehlt einen LCP von höchstens 2,5 Sekunden. Interaction to Next Paint (INP), das 2024 den First Input Delay abgelöst hat, misst, wie reaktionsschnell eine Seite auf Nutzerinteraktionen wie Klicks und Taps reagiert – Zielwert: unter 200 Millisekunden. Cumulative Layout Shift (CLS) misst die visuelle Stabilität, indem unerwartete Layout-Verschiebungen beim Laden der Seite verfolgt werden – ein Wert unter 0,1 gilt als gut. Forschung von DebugBear zeigt, dass Websites 75 % der Nutzer für alle drei Metriken eine „gute“ Performance bieten müssen, um die maximalen Rankingvorteile zu erhalten. Der Übergang zu INP als Rankingfaktor unterstreicht Googles Schwerpunkt auf die Gesamtreaktionsfähigkeit einer Seite während der gesamten Nutzerinteraktion, nicht nur beim initialen Ladevorgang. Die Optimierung der Core Web Vitals erfordert einen ganzheitlichen Ansatz: LCP-Verbesserung durch Bildoptimierung, Nutzung von CDNs und das Verzögern nicht-kritischer JavaScript-Ressourcen; INP-Verbesserung durch das Aufteilen langer JavaScript-Aufgaben und Optimierung von Event-Handlern; und CLS-Reduzierung durch Platzreservierung für dynamische Inhalte und das Vermeiden verschiebender Werbeanzeigen. Diese Metriken sind für wettbewerbsfähiges SEO unverzichtbar, da Seiten mit schlechten Core Web Vitals Rankingstrafen und höhere Absprungraten riskieren.

Seitenarchitektur beschreibt, wie die Seiten Ihrer Website organisiert, strukturiert und durch interne Links miteinander verbunden sind. Eine gut gestaltete Seitenarchitektur erfüllt mehrere entscheidende Funktionen: Sie hilft Suchmaschinen, Ihre Inhalts-Hierarchie zu verstehen, verteilt Linkpower (Rankingkraft) über die gesamte Website, stellt sicher, dass wichtige Seiten einfach auffindbar sind, und verbessert die Nutzerführung. Die ideale Seitenarchitektur folgt einer klaren Hierarchie mit der Startseite an der Spitze, Kategorieseiten auf der zweiten Ebene und einzelnen Inhaltsseiten in tieferen Ebenen. Best Practice ist, dass alle wichtigen Seiten maximal drei Klicks von der Startseite entfernt sein sollten, damit der Googlebot sein Crawlbudget nicht auf tief verschachtelte, isolierte Seiten verschwendet. Interne Verlinkung fungiert als das verbindende Element Ihrer Seitenarchitektur und leitet Nutzer wie Suchmaschinen gezielt durch Ihre Inhalte. Strategische interne Verlinkung bündelt Ranking-Signale auf Prioritätsseiten, stellt thematische Beziehungen zwischen verwandten Inhalten her und hilft Suchmaschinen zu erkennen, welche Seiten am wichtigsten sind. Beispielsweise schafft das Hub-and-Spoke-Modell – eine umfassende Pillar-Seite verlinkt auf mehrere thematisch verwandte Unterseiten, die wiederum zurückverlinken – eine starke Struktur, die Suchmaschinen thematische Autorität signalisiert. Schlechte Seitenarchitektur mit verwaisten Seiten, inkonsistenter Navigation und tiefen Verschachtelungen führt dazu, dass Suchmaschinen Crawlbudget auf weniger relevante Inhalte verschwenden und erschwert den Aufbau thematischer Autorität. Unternehmen, die ihre Seitenarchitektur restrukturieren, verzeichnen häufig deutliche Verbesserungen bei der Indexierungsgeschwindigkeit und im Ranking.

Mobile-First-Indexierung bedeutet, dass Google in erster Linie die mobile Version Ihrer Website zum Crawlen, Indexieren und Ranken verwendet – nicht die Desktop-Version. Dieser grundlegende Wandel spiegelt wider, dass mittlerweile über 60 % der Suchanfragen von mobilen Geräten stammen. Für technisches SEO bedeutet das: Ihr Mobile-Erlebnis muss einwandfrei sein – responsives Design, das sich an alle Bildschirmgrößen anpasst, touchfreundliche Navigation mit ausreichendem Abstand zwischen klickbaren Elementen, lesbare Schriftgrößen ohne Zoom und schnelle Ladezeiten, optimiert für mobile Netze. Responsives Design nutzt flexible Layouts und Bilder, um sich automatisch an verschiedene Bildschirmgrößen anzupassen und so eine konsistente Funktionalität auf allen Geräten zu gewährleisten. Häufige Fehler bei der mobilen Optimierung sind aufdringliche Interstitials (Pop-ups), zu kleine Texte, zu eng beieinanderliegende Schaltflächen und langsame Ladezeiten über mobile Netzwerke. Googles Mobile-Friendly-Test und Lighthouse-Audits erkennen viele dieser Probleme, aber Tests auf echten Mobilgeräten bleiben unerlässlich. Der Zusammenhang zwischen mobiler Optimierung und Rankings ist direkt: Seiten mit schlechtem Mobile-Erlebnis werden im Ranking abgestraft, während mobil optimierte Seiten an Sichtbarkeit gewinnen. Für E-Commerce, SaaS und Content-Publisher ist mobile Optimierung kein Extra, sondern die Grundlage für Wettbewerbsfähigkeit in der Suche.

XML-Sitemaps dienen als Roadmap für Suchmaschinen und listen alle URLs auf, die indexiert werden sollen, inklusive Metadaten wie letztes Änderungsdatum und Priorität. Eine gepflegte Sitemap sollte ausschließlich kanonische, indexierbare URLs enthalten – Weiterleitungen, 404-Seiten und doppelte Inhalte sind auszuschließen. Robots.txt ist eine Textdatei im Root-Verzeichnis Ihrer Website, die Suchmaschinen-Bots Anweisungen gibt, welche Verzeichnisse und Dateien gecrawlt werden dürfen oder nicht. Während robots.txt das Crawlen blockieren kann, verhindert es nicht das Indexieren, falls die Seite auf anderem Wege entdeckt wird – für einen vollständigen Ausschluss nutzen Sie noindex-Meta-Tags. Crawlbudget beschreibt die Anzahl der Seiten, die der Googlebot in einem bestimmten Zeitraum auf Ihrer Website crawlt – ein begrenztes Gut, das strategisch verwaltet werden muss. Große Websites mit Millionen von Seiten müssen ihr Crawlbudget so steuern, dass Googlebot sich auf hochwertige Inhalte konzentriert, anstatt Ressourcen auf wenig wichtige, doppelte oder facettierte Navigationsvarianten zu verschwenden. Häufige Crawlbudget-Verschwendung entsteht durch Suchparameter, die endlose URL-Varianten generieren, durch öffentlich zugängliche Staging- oder Entwicklungsumgebungen oder durch dünne Inhalte mit übermäßiger interner Verlinkung. Laut offizieller Google-Richtlinie ist das Crawlbudget-Management besonders für große Websites wichtig, da ineffizientes Crawlen die Entdeckung und Indexierung neuer oder aktualisierter Inhalte verzögert. Tools wie der Crawl-Statistik-Bericht der Google Search Console und die Analyse von Server-Logs zeigen, welche Seiten Googlebot wie häufig besucht, und ermöglichen eine datengetriebene Optimierung des Crawlbudgets.

Strukturierte Daten, implementiert durch Schema-Markup, helfen Suchmaschinen, die Bedeutung und den Kontext Ihrer Inhalte über die reine Textanalyse hinaus zu verstehen. Schema-Markup verwendet standardisierte Vokabulare (von schema.org), um verschiedene Inhaltstypen zu kennzeichnen – Produkte, Artikel, Rezepte, Veranstaltungen, lokale Unternehmen und mehr. Bei korrekter Implementierung ermöglicht Schema-Markup erweiterte Suchergebnisse („Rich Results“), bei denen Google zusätzliche Informationen wie Sternebewertungen, Preise, Kochzeiten oder Veranstaltungsdaten direkt in den Suchergebnissen anzeigt. Diese erhöhte Sichtbarkeit kann die Klickraten und das Nutzerengagement signifikant steigern. Verschiedene Inhaltstypen erfordern unterschiedliche Schema-Implementierungen: Article-Schema für Blogposts und Nachrichten, Product-Schema für E-Commerce-Seiten, FAQ-Schema für häufig gestellte Fragen, Local-Business-Schema für stationäre Standorte und Event-Schema für bevorstehende Veranstaltungen. Die Implementierung erfolgt in der Regel im JSON-LD-Format, das von Google bevorzugt wird. Das Schema-Markup muss jedoch den tatsächlichen Inhalt der Seite korrekt widerspiegeln – irreführendes oder erfundenes Schema kann zu manuellen Strafen führen. Laut Search Engine Land qualifizieren sich nur Seiten mit validem, relevantem Schema-Markup für Rich Results, weshalb die Genauigkeit bei der Implementierung unerlässlich ist. Organisationen, die umfassendes Schema-Markup auf ihren wichtigsten Seiten einsetzen, erzielen häufig eine bessere Sichtbarkeit sowohl in klassischen Suchergebnissen als auch auf KI-Plattformen, da diese auf strukturierte Daten zur korrekten inhaltlichen Zuordnung und Zitierung angewiesen sind.

HTTPS (Hypertext Transfer Protocol Secure) verschlüsselt die Datenübertragung zwischen Browsern der Nutzer und Ihrem Webserver, schützt sensible Informationen und signalisiert sowohl Nutzern als auch Suchmaschinen Vertrauenswürdigkeit. Google hat bestätigt, dass HTTPS ein Rankingfaktor ist, und Seiten ohne HTTPS müssen mit direkten Rankingverlusten sowie indirekten Folgen wie Browserwarnungen rechnen, die das Nutzerengagement beeinträchtigen. Die Implementierung von HTTPS erfordert ein SSL/TLS-Zertifikat einer vertrauenswürdigen Zertifizierungsstelle und eine Serverkonfiguration, die den Abruf aller Seiten über HTTPS ermöglicht. Über die reine HTTPS-Implementierung hinaus bieten Security-Header wie Content-Security-Policy, Strict-Transport-Security und X-Content-Type-Options zusätzlichen Schutz vor typischen Web-Sicherheitslücken. Mixed-Content-Fehler – wenn HTTPS-Seiten unsichere HTTP-Ressourcen laden – untergraben die Sicherheit und können Browserwarnungen auslösen. Die Verbindung von Sicherheit und SEO reicht weiter als nur bis zum Ranking: Sichere Seiten bauen Nutzervertrauen auf, senken die Absprungraten und steigern die Konversionsraten. Für E-Commerce-Seiten mit Zahlungsdaten, SaaS-Plattformen mit Nutzerdaten und alle Seiten, die persönliche Informationen sammeln, ist Sicherheit unverzichtbar. Regelmäßige Sicherheits-Audits mit Tools wie dem Sicherheitsbericht der Google Search Console und externen Schwachstellen-Scannern helfen, Probleme frühzeitig zu erkennen und zu beheben, bevor sie Rankings oder Nutzervertrauen gefährden.

| Aspekt | Technisches SEO | On-Page-SEO | Off-Page-SEO |

|---|---|---|---|

| Hauptfokus | Website-Infrastruktur, Geschwindigkeit, Crawlability, Indexierbarkeit | Inhaltsqualität, Keywords, Meta-Tags, Überschriften | Backlinks, Markenerwähnungen, Social Signals |

| Suchmaschinenzugang | Stellt sicher, dass Suchmaschinen Seiten crawlen und indexieren können | Hilft Suchmaschinen, die Relevanz der Seite zu verstehen | Baut Autorität und Vertrauenssignale auf |

| Schlüsselelemente | Seitenladegeschwindigkeit, mobile Optimierung, Core Web Vitals, Seitenarchitektur, HTTPS, strukturierte Daten | Keyword-Platzierung, Content-Tiefe, interne Verlinkung, Meta-Beschreibungen | Backlink-Profil, Domain Authority, Markenerwähnungen |

| Verwendete Tools | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Auswirkung auf Rankings | Grundlegend – ohne sie können Seiten nicht ranken | Direkt – verbessert Relevanz für Ziel-Keywords | Bedeutend – baut Autorität und Vertrauen auf |

| Einfluss auf Nutzererfahrung | Hoch – beeinflusst Seitenladegeschwindigkeit, mobile Nutzbarkeit, Barrierefreiheit | Mittel – beeinflusst Lesbarkeit und Engagement | Gering – indirekt durch Markenwahrnehmung |

| Implementierungszeitraum | Laufend – erfordert kontinuierliche Überwachung und Optimierung | Laufend – erfordert Inhaltsupdates und Optimierung | Langfristig – erfordert stetigen Linkaufbau |

| ROI-Messung | Crawl-Effizienz, Indexierungsrate, Core Web Vitals Scores, Rankings | Keyword-Rankings, organischer Traffic, Klickraten | Backlink-Wachstum, Domain Authority, Referral-Traffic |

JavaScript-SEO adressiert die besonderen Herausforderungen von JavaScript-lastigen Websites, Single-Page-Applications (SPAs) und dynamischer Inhaltsdarstellung. Historisch gesehen hatte der Googlebot Schwierigkeiten mit JavaScript, da das Rendern – also das Ausführen von JavaScript zur Erzeugung der finalen Seite – Komplexität und Verzögerung beim Crawlen verursachte. Der moderne Googlebot rendert inzwischen die meisten Seiten vor dem Indexieren, was jedoch neue technische SEO-Aspekte mit sich bringt. Server-Side-Rendering (SSR) erzeugt vollständiges HTML bereits auf dem Server, sodass Suchmaschinen alle Inhalte sofort sehen, ohne auf JavaScript-Ausführung zu warten. Static Site Generation (SSG) rendert Seiten bereits beim Build-Prozess vor und liefert statische HTML-Dateien aus, die sofort geladen werden. Dynamisches Rendering liefert Suchmaschinen vorgerendertes HTML, während Nutzern JavaScript-basierte Seiten angezeigt werden – laut Google jedoch nur als temporäre Lösung gedacht. Das entscheidende Prinzip: Alle wichtigen Inhalte, Meta-Tags und strukturierten Daten sollten im initialen HTML sichtbar sein, nicht erst nach JavaScript-Ausführung. Seiten, die relevante Inhalte hinter JavaScript verstecken, riskieren eine unvollständige oder verzögerte Indexierung. React-, Vue- und Angular-Frameworks benötigen besondere Aufmerksamkeit – viele Organisationen setzen Next.js oder Nuxt.js gezielt für SSR ein, um die SEO-Performance zu verbessern. Mit dem URL-Inspektions- und Rendering-Tool der Google Search Console lässt sich prüfen, ob JavaScript-abhängige Inhalte korrekt indexiert werden.

Die effektive Implementierung von technischem SEO erfordert einen systematischen Ansatz, der Optimierungen mit hohem Impact priorisiert. Beginnen Sie mit den Grundlagen: Stellen Sie die Crawlability sicher, indem Sie robots.txt und interne Verlinkung prüfen, vergewissern Sie sich, dass wichtige Seiten indexierbar sind (keine versehentlichen noindex-Tags, keine Canonical-Konflikte) und schaffen Sie einen Performance-Baseline für die Core Web Vitals. Als Nächstes folgt die Performance-Optimierung: Bilder komprimieren und optimieren, Lazy Loading für unterhalb des sichtbaren Bereichs implementieren, nicht-kritisches JavaScript verzögern und CDNs für schnellere Auslieferung nutzen. Dann optimieren Sie die Seitenstruktur: Sorgen Sie dafür, dass wichtige Seiten maximal drei Klicks von der Startseite entfernt sind, implementieren Sie Breadcrumb-Navigation mit Schema-Markup und schaffen Sie klare interne Verlinkungsmuster für Nutzer und Suchmaschinen. Implementieren Sie strukturierte Daten für Ihre wichtigsten Inhaltstypen – Produkte, Artikel, lokale Unternehmensinformationen oder Veranstaltungen – im JSON-LD-Format und validieren Sie diese mit dem Rich Results Test von Google. Überwachen Sie kontinuierlich mit der Google Search Console (Indexierungsprobleme), PageSpeed Insights (Core Web Vitals) und Server-Logs (Crawl-Muster). Schaffen Sie Verantwortlichkeit, indem Sie Kennzahlen wie die Anzahl indexierter Seiten, Core Web Vitals Scores und Crawl-Effizienz regelmäßig tracken. Organisationen, die technisches SEO als fortlaufenden Prozess und nicht als einmaliges Audit verstehen, übertreffen Wettbewerber langfristig in Sichtbarkeit und Nutzererfahrung.

Mit dem Aufstieg KI-gesteuerter Suchplattformen wie Google AI Overviews, Perplexity, ChatGPT und Claude ist die Bedeutung des technischen SEO über die klassische Google-Suche hinausgewachsen. Diese KI-Systeme stützen sich auf korrekt indexierte, gut strukturierte Inhalte aus Suchmaschinenindizes, um Antworten und Zitate zu generieren. Technisches SEO stellt sicher, dass Ihre Inhalte von KI-Systemen auffindbar und korrekt interpretiert werden, und zwar über mehrere Mechanismen: Korrekte Indexierung macht Inhalte für KI-Training und -Abfrage verfügbar, strukturierte Daten helfen KI-Systemen, Kontext und Bedeutung zu erfassen, und semantische Tiefe ermöglicht es der KI, Ihre Inhalte als autoritativ und relevant zu erkennen. Laut Forschung von Conductor und Botify stammen Seiten in AI Overviews meist von technisch einwandfreien, semantisch starken Websites. Die Beziehung ist bidirektional: Während klassisches SEO auf das Ranking für bestimmte Keywords abzielt, bieten KI-Suchen umfassende Antworten, die oft mehrere Quellen zitieren. Das bedeutet, technisches SEO muss beide Paradigmen unterstützen – Seiten für klassische Suche indexieren lassen und sie semantisch so reich machen, dass KI-Systeme sie erkennen und zitieren. Unternehmen, die ihre Sichtbarkeit auf verschiedenen KI-Plattformen (z.B. mit Tools wie AmICited) überwachen, können herausfinden, welche technischen Optimierungen die Zitierhäufigkeit und Sichtbarkeit in generativen Suchergebnissen am stärksten steigern.

Wirksames technisches SEO setzt das Tracking spezifischer Metriken voraus, die die Website-Gesundheit und Zugänglichkeit für Suchmaschinen anzeigen. Anzahl indexierter Seiten zeigt, wie viele Ihrer gewünschten Seiten tatsächlich im Google-Index sind – der Vergleich mit allen indexierbaren Seiten ergibt die Indexierungs-Effizienz. Crawl-Effizienz misst, wie effektiv Googlebot das Crawlbudget nutzt (gecrawle Seiten geteilt durch Gesamtseitenzahl). Core Web Vitals Scores zeigen die Nutzererfahrungsqualität in Bezug auf Ladegeschwindigkeit (LCP), Interaktivität (INP) und visuelle Stabilität (CLS). Mobile Usability-Probleme in der Google Search Console weisen auf Schwierigkeiten wie kleine Touch-Ziele, fehlerhafte Viewport-Konfiguration oder aufdringliche Interstitials hin. Länge von Redirect-Ketten sollte minimiert werden, um Linkpower zu erhalten und Crawl-Verzögerungen zu vermeiden. Abdeckung strukturierter Daten zeigt, auf wie viel Prozent Ihrer Seiten valides Schema-Markup implementiert ist. Pagespeed-Metriken wie First Contentful Paint (FCP), Time to Interactive (TTI) und Total Blocking Time (TBT) liefern detaillierte Performance-Insights. Organisationen sollten für diese Metriken Baselines erfassen, Verbesserungsziele setzen und den Fortschritt monatlich oder vierteljährlich messen. Plötzliche Änderungen weisen oft auf technische Probleme hin, bevor Rankings betroffen sind, und ermöglichen proaktives Gegensteuern. Tools wie Google Search Console, PageSpeed Insights, Lighthouse und Enterprise-Plattformen wie Semrush bieten umfassende Dashboards zur Überwachung dieser Metriken über die gesamte Website hinweg.

Die Welt des technischen SEO entwickelt sich stetig weiter – getrieben durch Algorithmus-Updates, neue Technologien und veränderte Nutzererwartungen. KI-gesteuertes Indexieren und Ranking wird zunehmend bestimmen, welche Seiten indexiert und wie sie gerankt werden, sodass technisches SEO semantisches Verständnis und Entity-Erkennung unterstützen muss. Edge Computing und serverlose Architekturen ermöglichen schnellere Inhaltsauslieferung und Echtzeit-Optimierung am Netzwerkrand, was die Core Web Vitals verbessert. Stärkerer Fokus auf E-E-A-T-Signale (Erfahrung, Expertise, Autorität, Vertrauenswürdigkeit) bedeutet, dass technisches SEO durch korrekte Autorenangaben, Veröffentlichungsdaten und Vertrauenssignale zur Glaubwürdigkeit beitragen muss. Multi-Surface-Optimierung wird mit der Verbreitung von KI-Suchplattformen Standard, sodass Websites für Sichtbarkeit auf Google, Perplexity, ChatGPT, Claude und anderen Plattformen zugleich optimieren müssen. Privacy-First-Analytics und First-Party-Datenerhebung verändern die Erfolgsmessung im technischen SEO – Tracking wandert weg von Third-Party-Cookies hin zu serverseitigem Tracking und einwilligungsbasierten Analysen. Reifung der JavaScript-Frameworks verbessert laufend die SEO-Tauglichkeit, mit Next.js, Nuxt.js und Remix als Standard für SEO-freundliche Anwendungen. Automatisiertes technisches SEO auf KI-Basis ermöglicht künftig eine schnellere Erkennung und Behebung von Problemen, indem Plattformen selbstständig Crawlability-, Indexierbarkeits- und Performance-Issues aufspüren und Lösungsvorschläge anbieten. Unternehmen, die diesen Trends durch kontinuierliche technische Weiterentwicklung und das Monitoring neuer Best Practices voraus sind, werden sich Wettbewerbsvorteile bei der organischen Sichtbarkeit sichern.

Technisches SEO konzentriert sich auf die Optimierung der Backend-Infrastruktur einer Website – wie Seitenladegeschwindigkeit, Crawlability, Indexierbarkeit und Serverkonfiguration –, um Suchmaschinen das Entdecken und Verarbeiten von Inhalten zu erleichtern. On-Page-SEO hingegen konzentriert sich auf die Optimierung einzelner Seitenelemente wie Keyword-Platzierung, Meta-Tags, Überschriften und Inhaltsqualität, um die Relevanz für bestimmte Suchanfragen zu erhöhen. Während technisches SEO sicherstellt, dass Suchmaschinen auf Ihre Seite zugreifen können, sorgt On-Page-SEO dafür, dass sie verstehen, worum es in Ihren Inhalten geht und warum sie für Nutzer relevant sind.

Core Web Vitals – Largest Contentful Paint (LCP), Interaction to Next Paint (INP) und Cumulative Layout Shift (CLS) – sind bestätigte Rankingfaktoren, die reale Nutzererfahrungen messen. Laut DebugBear-Forschung müssen Websites 75 % der Nutzer eine „gute“ Erfahrung über alle drei Metriken hinweg bieten, um den maximalen Ranking-Boost zu erhalten. Schlechte Core Web Vitals können zu Rankingverlusten, geringeren Klickraten und höheren Absprungraten führen und so die organische Sichtbarkeit und Nutzerbindung direkt beeinflussen.

Crawlability bestimmt, ob Suchmaschinen-Bots auf Ihre Website und deren Links zugreifen und ihnen folgen können. Wenn der Googlebot Ihre Seiten aufgrund blockierter Ressourcen, schlechter Seitenstruktur oder robots.txt-Beschränkungen nicht crawlen kann, können diese Seiten nicht indexiert oder gerankt werden. Ohne ordnungsgemäße Crawlability bleiben selbst hochwertige Inhalte für Suchmaschinen unsichtbar, was eine organische Sichtbarkeit unabhängig von Inhaltsqualität oder Backlink-Profil unmöglich macht.

Mit dem Aufkommen KI-gesteuerter Suchplattformen wie Google AI Overviews und Perplexity bleibt technisches SEO grundlegend. Diese KI-Systeme verlassen sich auf korrekt indexierte, gut strukturierte Inhalte aus dem Google-Index, um Antworten zu generieren. Technisches SEO stellt sicher, dass Ihre Inhalte auffindbar, korrekt gerendert und semantisch reich genug sind, damit KI-Systeme sie zitieren und referenzieren können. Ohne solide technische Grundlagen erscheinen Ihre Inhalte weder in AI Overviews noch in anderen generativen Suchergebnissen.

Für die meisten Websites wird ein umfassendes technisches SEO-Audit vierteljährlich empfohlen, mit monatlicher Überwachung kritischer Probleme. Größere Unternehmensseiten mit häufigen Updates sollten monatlich prüfen oder kontinuierliche Überwachungssysteme implementieren. Nach größeren Änderungen, Migrationen oder Redesigns sind sofortige Audits unerlässlich. Regelmäßige Audits helfen, Probleme frühzeitig zu erkennen, bevor sie das Ranking beeinträchtigen, und sorgen dafür, dass Ihre Seite optimale Crawlability, Indexierbarkeit und Performance beibehält.

Die Seitenarchitektur bestimmt, wie Suchmaschinen die Inhalts-Hierarchie Ihrer Website erkennen und navigieren. Eine gut optimierte Architektur stellt sicher, dass wichtige Seiten maximal drei Klicks von der Startseite entfernt sind, Linkpower effektiv verteilt wird und Suchmaschinen beim Crawlen von hochwertigem Content priorisieren. Schlechte Seitenarchitektur kann zu verwaisten Seiten, verschwendetem Crawlbudget und Schwierigkeiten beim Aufbau thematischer Autorität führen – alles Faktoren, die Rankings und Sichtbarkeit negativ beeinflussen.

Die Seitenladegeschwindigkeit wirkt sich direkt auf Suchrankings und Nutzerverhalten aus. Google hat bestätigt, dass Core Web Vitals – die Ladegeschwindigkeit, Interaktivität und visuelle Stabilität messen – Rankingfaktoren sind. Langsam ladende Seiten haben höhere Absprungraten, geringeres Engagement und weniger Konversionen. Studien zeigen, dass Seiten, die in unter 2,5 Sekunden laden, eine deutlich bessere Nutzerbindung und Ranking-Performance aufweisen als langsamere Seiten – daher ist die Optimierung der Ladegeschwindigkeit entscheidend für den SEO-Erfolg.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Content-SEO ist die strategische Erstellung und Optimierung hochwertiger Inhalte, um Suchmaschinenrankings und organische Sichtbarkeit zu verbessern. Lernen Sie...

JavaScript SEO optimiert JavaScript-gerenderte Websites für das Crawling und die Indexierung durch Suchmaschinen. Lernen Sie Best Practices, Rendering-Methoden ...

YouTube-SEO ist der Prozess der Optimierung von Videos und Kanälen, um in den YouTube-Suchergebnissen höher zu ranken. Erfahren Sie mehr über Rankingfaktoren, O...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.