Token-Limits und Inhaltsoptimierung: Technische Überlegungen

Erfahren Sie, wie sich Token-Limits auf die KI-Leistung auswirken, und entdecken Sie praktische Strategien zur Inhaltsoptimierung, einschließlich RAG-, Chunking...

Ein Token ist die grundlegende Einheit von Text, die von Sprachmodellen verarbeitet wird. Es repräsentiert Wörter, Teilwörter, Zeichen oder Satzzeichen, die in numerische Kennungen umgewandelt wurden. Tokens bilden die Basis dafür, wie KI-Systeme wie ChatGPT, Claude und Perplexity Text verstehen und generieren, wobei jedem Token innerhalb des Modellwortschatzes ein eindeutiger ganzzahliger Wert zugewiesen wird.

Ein Token ist die grundlegende Einheit von Text, die von Sprachmodellen verarbeitet wird. Es repräsentiert Wörter, Teilwörter, Zeichen oder Satzzeichen, die in numerische Kennungen umgewandelt wurden. Tokens bilden die Basis dafür, wie KI-Systeme wie ChatGPT, Claude und Perplexity Text verstehen und generieren, wobei jedem Token innerhalb des Modellwortschatzes ein eindeutiger ganzzahliger Wert zugewiesen wird.

Ein Token ist die grundlegende Einheit von Text, die Sprachmodelle verarbeiten und verstehen. Tokens repräsentieren Wörter, Teilwörter, Zeichenfolgen oder Satzzeichen, von denen jedes innerhalb des Modellwortschatzes eine eindeutige numerische Kennung erhält. Anstatt Rohtext direkt zu verarbeiten, wandeln KI-Systeme wie ChatGPT, Claude, Perplexity und Google AI Overviews sämtlichen Eingabetext in Token-Sequenzen um – sie übersetzen menschliche Sprache also im Wesentlichen in ein numerisches Format, das neuronale Netzwerke berechnen können. Dieser Tokenisierungsprozess ist der entscheidende erste Schritt, der es Sprachmodellen ermöglicht, semantische Beziehungen zu analysieren, kohärente Antworten zu generieren und rechnerische Effizienz zu wahren. Das Verständnis von Tokens ist für alle, die mit KI-Systemen arbeiten, unerlässlich, da die Token-Anzahl die API-Kosten, die Antwortqualität und die Fähigkeit des Modells, Kontext über Gespräche hinweg zu behalten, direkt beeinflusst.

Tokenisierung ist der systematische Prozess, Rohtext in diskrete Tokens zu zerlegen, die ein Sprachmodell verarbeiten kann. Wenn Sie Text in ein KI-System eingeben, analysiert der Tokenizer zunächst den Text und teilt ihn in überschaubare Einheiten auf. Zum Beispiel könnte der Satz „I heard a dog bark loudly“ in die einzelnen Tokens I, heard, a, dog, bark, loudly zerlegt werden. Jedes Token erhält dann eine eindeutige numerische Kennung – vielleicht wird I zu Token-ID 1, heard zu 2, a zu 3 und so weiter. Diese numerische Darstellung ermöglicht es dem neuronalen Netzwerk, mathematische Operationen auf den Tokens durchzuführen, Beziehungen und Muster zu berechnen und so die Bedeutung zu verstehen und passende Antworten zu generieren.

Die Art und Weise, wie Text tokenisiert wird, hängt vom Tokenisierungsalgorithmus des jeweiligen Modells ab. Verschiedene Sprachmodelle verwenden unterschiedliche Tokenizer, weshalb derselbe Text auf verschiedenen Plattformen unterschiedliche Token-Anzahlen ergeben kann. Der Wortschatz des Tokenizers – die Gesamtheit aller eindeutigen Tokens, die er erkennt – reicht typischerweise von Zehntausenden bis Hunderttausenden Tokens. Wenn der Tokenizer auf ihm unbekannten Text oder Wörter außerhalb seines Wortschatzes trifft, wendet er spezielle Strategien an, etwa die Aufteilung in kleinere Teilwort-Tokens oder die Darstellung als Kombination bekannter Tokens. Diese Flexibilität ist entscheidend, um vielfältige Sprachen, Fachjargon, Tippfehler und neue Wortkombinationen aus realen Texten verarbeiten zu können.

Verschiedene Tokenisierungsansätze bieten jeweils spezifische Vorteile und Kompromisse. Das Verständnis dieser Methoden ist wichtig, um zu begreifen, wie verschiedene KI-Plattformen Informationen unterschiedlich verarbeiten:

| Tokenisierungsmethode | Funktionsweise | Vorteile | Nachteile | Verwendet von |

|---|---|---|---|---|

| Wortebene | Teilt Text anhand von Leerzeichen und Satzzeichen in vollständige Wörter | Einfach zu verstehen; erhält vollständige Wortbedeutung; kleinere Token-Sequenzen | Großer Wortschatz; kann unbekannte oder seltene Wörter (OOV) nicht verarbeiten; unflexibel bei Tippfehlern | Traditionelle NLP-Systeme |

| Zeichenebene | Behandelt jedes einzelne Zeichen, auch Leerzeichen, als Token | Verarbeitet allen möglichen Text; keine OOV-Probleme; sehr feinkörnig | Sehr lange Token-Sequenzen; mehr Rechenaufwand; geringe semantische Dichte pro Token | Einige Spezialmodelle; Modelle für chinesische Sprache |

| Teilwortebene (BPE) | Verschmilzt häufige Zeichen-/Teilwortpaare schrittweise zu größeren Tokens | Balanciert Wortschatzgröße und Abdeckung; verarbeitet seltene Wörter effektiv; reduziert OOV-Fehler | Komplexere Implementierung; kann bedeutungstragende Einheiten aufspalten; erfordert Training | GPT-Modelle, ChatGPT, Claude |

| WordPiece | Beginnt mit Zeichen und verschmilzt häufige Kombinationen progressiv | Hervorragend für unbekannte Wörter; effizienter Wortschatz; gute Semantikerhaltung | Erfordert Pre-Training; rechnerisch aufwendiger | BERT, Google-Modelle |

| SentencePiece | Sprachunabhängige Methode, behandelt Text als Rohbytes | Hervorragend für mehrsprachige Modelle; verarbeitet jedes Unicode-Zeichen; keine Vorverarbeitung nötig | Weniger intuitiv; benötigt spezielle Tools | Mehrsprachige Modelle, T5 |

Nach der Umwandlung von Text in Tokens verarbeiten Sprachmodelle diese numerischen Sequenzen durch mehrere Schichten neuronaler Netzwerke. Jedes Token wird als mehrdimensionaler Vektor (sogenanntes Embedding) dargestellt, der semantische Bedeutung und Kontextbeziehungen abbildet. Während der Trainingsphase lernt das Modell, Muster in der gemeinsamen Auftretenswahrscheinlichkeit von Tokens zu erkennen – etwa, dass bestimmte Tokens häufig zusammen oder in ähnlichen Kontexten erscheinen. So entwickeln die Tokens für „king“ und „queen“ ähnliche Embeddings, weil sie semantische Eigenschaften teilen, während „king“ und „paper“ aufgrund unterschiedlicher Bedeutung und Verwendung weiter auseinanderliegen.

Der Aufmerksamkeitsmechanismus (Attention) des Modells ist dabei entscheidend. Die Attention ermöglicht es dem Modell, die Wichtigkeit einzelner Tokens im Kontext anderer Tokens zu gewichten, wenn eine Antwort generiert wird. Beim Satz „The bank executive sat by the river bank“ hilft die Attention dem Modell zu verstehen, dass das erste „bank“ eine Bank als Finanzinstitut meint, während das zweite „bank“ ein Flussufer bezeichnet – basierend auf Kontext-Tokens wie „executive“ und „river“. Dieses kontextuelle Verständnis entsteht durch die gelernten Beziehungen zwischen Token-Embeddings und ermöglicht anspruchsvolles Sprachverständnis, das weit über einfaches Wort-Matching hinausgeht.

Während der Inferenz (Antwortgenerierung) sagt das Modell das nächste Token in einer Sequenz auf Basis aller bisherigen Tokens voraus. Es berechnet Wahrscheinlichkeitswerte für jedes Token im Wortschatz und wählt das wahrscheinlichste nächste Token aus. Dieser Prozess wiederholt sich iterativ – das neu generierte Token wird zur Sequenz hinzugefügt, und das Modell verwendet diesen erweiterten Kontext zur Vorhersage des nächsten Tokens. Diese Token-für-Token-Generierung läuft, bis das Modell ein spezielles „Ende-der-Sequenz“-Token erzeugt oder das Token-Limit erreicht. Daher ist es wichtig, die Token-Limits zu kennen: Überschreiten Prompt und gewünschte Antwort zusammen das Kontextfenster des Modells, kann keine vollständige Antwort erzeugt werden.

Jedes Sprachmodell hat ein Kontextfenster – die maximale Anzahl an Tokens, die es gleichzeitig verarbeiten kann. Dieses Limit umfasst sowohl Input-Tokens (Prompt) als auch Output-Tokens (Antwort des Modells). Beispielsweise verfügt GPT-3.5-Turbo über ein Kontextfenster von 4.096 Tokens, während GPT-4 je nach Version Fenster von 8.000 bis 128.000 Tokens bietet. Claude 3-Modelle unterstützen Kontextfenster bis zu 200.000 Tokens, was die Analyse ganzer Bücher oder umfangreicher Dokumente ermöglicht. Das Verständnis des Kontextfensters Ihres Modells ist essentiell, um Prompts zu planen und Token-Budgets effektiv zu verwalten.

Tools zur Token-Zählung sind unverzichtbar zur Optimierung der KI-Nutzung. OpenAI stellt die Open-Source-Bibliothek tiktoken bereit, mit der Entwickler Tokens vor API-Aufrufen zählen können. So werden unerwartete Kosten vermieden und Prompts präzise optimiert. Wenn Sie zum Beispiel GPT-4 mit 8.000 Token Kontext nutzen und Ihr Prompt 2.000 Tokens verbraucht, stehen Ihnen 6.000 Tokens für die Antwort zur Verfügung. Dieses Wissen hilft, Prompts zu gestalten, die in den verfügbaren Tokenraum passen und dennoch umfassende Antworten liefern. Verschiedene Modelle nutzen unterschiedliche Tokenizer – Claude verwendet ein eigenes System, Perplexity hat einen eigenen Ansatz, und Google AI Overviews nutzt eine weitere Methode. Deshalb produziert derselbe Text auf verschiedenen Plattformen unterschiedliche Token-Anzahlen – Plattform-spezifische Token-Zählung ist für genaue Kostenschätzung und Leistungsprognose unerlässlich.

Tokens sind zur zentralen ökonomischen Einheit der KI-Branche geworden. Die meisten KI-Anbieter berechnen nach Token-Verbrauch, mit getrennten Sätzen für Input- und Output-Tokens. Die Preisstruktur von OpenAI ist beispielhaft: Stand 2024 kostet GPT-4 rund 0,03 $ pro 1.000 Input-Tokens und 0,06 $ pro 1.000 Output-Tokens – Output-Tokens sind also etwa doppelt so teuer wie Input-Tokens. Dieses Preismodell spiegelt die Realität wider, dass die Generierung neuer Tokens mehr Rechenleistung erfordert als die Verarbeitung von Input-Tokens. Claude folgt einem ähnlichen Muster, während Perplexity und andere Anbieter eigene tokenbasierte Preismodelle haben.

Das Verständnis der Token-Ökonomie ist entscheidend für das Management von KI-Kosten im großen Maßstab. Ein einziger ausschweifender Prompt kann 500 Tokens verbrauchen, während ein prägnanter, gut strukturierter Prompt dasselbe Ziel mit nur 200 Tokens erreicht. Über Tausende von API-Aufrufen macht diese Effizienz einen erheblichen Kostenvorteil aus. Untersuchungen zeigen, dass Unternehmen durch den Einsatz KI-gestützter Monitoring-Tools den Token-Verbrauch durch Prompt-Optimierung und intelligentes Caching um 20–40 % senken können. Viele Plattformen setzen zudem Ratenlimits in Tokens pro Minute (TPM) ein, um zu begrenzen, wie viele Tokens ein Nutzer in einem bestimmten Zeitraum verarbeiten kann. Diese Limits verhindern Missbrauch und stellen eine faire Ressourcenverteilung sicher. Für Organisationen, die ihre Markenpräsenz in KI-Antworten über Plattformen wie AmICited überwachen, geben Token-Verbrauchsmuster nicht nur Aufschluss über Kosten, sondern auch über die Tiefe und Breite des KI-Engagements mit ihren Inhalten.

Für Plattformen, die das Auftreten von Marken und Domains in KI-Antworten überwachen, sind Tokens ein entscheidender Messwert für Engagement und Einfluss. Wenn AmICited verfolgt, wie Ihre Marke in ChatGPT, Claude, Perplexity und Google AI Overviews erscheint, zeigen die Token-Zählungen, wie viel Rechenressourcen diese Systeme Ihren Inhalten widmen. Eine Nennung, die 50 Tokens verbraucht, zeigt deutlich mehr Engagement als eine kurze Erwähnung mit nur 5 Tokens. Durch die Analyse der Token-Muster auf verschiedenen KI-Plattformen können Organisationen nachvollziehen, welche KI-Systeme ihre Inhalte priorisieren, wie umfassend verschiedene Modelle die Marke behandeln und ob Inhalte tiefergehend analysiert oder nur oberflächlich behandelt werden.

Die Token-Verfolgung ermöglicht auch eine ausgefeilte Analyse der Antwortqualität und -relevanz von KIs. Wenn ein KI-System eine ausführliche, detaillierte Antwort zu Ihrer Marke generiert und dabei Hunderte von Tokens verwendet, deutet dies auf hohe Sicherheit und umfassendes Wissen hin. Kurze Antworten mit wenigen Tokens können dagegen auf begrenzte Informationen oder eine geringere Relevanzbewertung hinweisen. Diese Unterscheidung ist für das Markenmanagement in der KI-Ära entscheidend. Organisationen können mit Token-basiertem Monitoring erkennen, welche Aspekte ihrer Marke am meisten KI-Aufmerksamkeit erhalten, welche Plattformen die Inhalte priorisieren und wie die Sichtbarkeit im Vergleich zu Wettbewerbern ausfällt. Zudem lassen sich durch Token-Verbrauchstrends neue Entwicklungen erkennen – steigt der Token-Verbrauch für Ihre Marke plötzlich auf mehreren KI-Plattformen, kann dies auf steigende Relevanz oder aktuelle Berichterstattung hindeuten, die in KI-Trainingsdaten einfließt.

Die Tokenisierungslandschaft entwickelt sich weiter, da Sprachmodelle immer leistungsfähiger und ausgefeilter werden. Frühe Sprachmodelle verwendeten relativ einfache Tokenisierung auf Wortebene, während moderne Systeme fortschrittliche Teilwort-Tokenisierungsmethoden einsetzen, die Effizienz und semantische Erhaltung ausbalancieren. Byte-Pair-Encoding (BPE), von OpenAI eingeführt und inzwischen Industriestandard, stellt einen bedeutenden Fortschritt gegenüber früheren Ansätzen dar. Neue Forschungsergebnisse deuten jedoch darauf hin, dass bei der Skalierung auf längere Kontexte und vielfältigere Datentypen noch effizientere Methoden entstehen könnten.

Die Zukunft der Tokenisierung geht über Text hinaus. Multimodale Modelle wie GPT-4 Vision und Claude 3 tokenisieren neben Text auch Bilder, Audio und Video und schaffen so eine einheitliche Token-Repräsentation über verschiedene Modalitäten hinweg. Dadurch kann ein einzelner Prompt Text-, Bild- und Audio-Tokens enthalten, die alle durch dieselbe neuronale Netzwerkarchitektur verarbeitet werden. Mit der Reife dieser multimodalen Systeme wird das Verständnis des Token-Verbrauchs über verschiedene Datentypen hinweg immer wichtiger. Zudem entstehen Reasoning-Modelle, die unsichtbare „Denk-Tokens“ als Zwischenschritte generieren – ein weiterer Evolutionsschritt. Solche Modelle verbrauchen während der Inferenz deutlich mehr Tokens – teils das Hundertfache klassischer Modelle –, um qualitativ hochwertigere Argumentationen und Problemlösungen zu liefern. Diese Entwicklung deutet darauf hin, dass die KI-Branche künftig nicht nur Output-Tokens, sondern den gesamten Rechenaufwand inklusive versteckter Denkprozesse als Wertmaßstab heranziehen könnte.

Die Standardisierung der Token-Zählung plattformübergreifend bleibt eine Herausforderung. Während OpenAIs tiktoken-Bibliothek weit verbreitet ist, pflegen verschiedene Plattformen proprietäre Tokenizer, die unterschiedliche Ergebnisse liefern. Diese Fragmentierung erschwert Unternehmen die Überwachung ihrer Präsenz auf mehreren KI-Systemen. Zukünftige Entwicklungen könnten branchenweite Token-Standards hervorbringen, ähnlich wie standardisierte Zeichencodierungen (UTF-8) die Textrepräsentation vereinheitlichten. Solche Standards würden Kostenprognosen vereinfachen, einen fairen Vergleich von KI-Services ermöglichen und das Monitoring der Markenpräsenz im KI-Ökosystem erleichtern. Für Plattformen wie AmICited, die auf die Nachverfolgung von Markenauftritten in KI-Antworten spezialisiert sind, würden standardisierte Token-Metriken eine noch präzisere Messung ermöglichen, wie unterschiedlich KI-Systeme mit Inhalten interagieren und Rechenressourcen zuteilen.

+++

Im Durchschnitt repräsentiert ein Token etwa 4 Zeichen oder ungefähr drei Viertel eines englischen Wortes. Dies variiert jedoch stark je nach verwendeter Tokenisierungsmethode. Kurze Wörter wie „the“ oder „a“ verbrauchen typischerweise ein Token, während längere oder komplexe Wörter zwei oder mehr Tokens benötigen können. Zum Beispiel könnte das Wort „darkness“ in „dark“ und „ness“ als zwei getrennte Tokens aufgeteilt werden.

Sprachmodelle sind neuronale Netzwerke, die numerische Daten und keinen Text verarbeiten. Tokens wandeln Text in numerische Repräsentationen (Embeddings) um, die neuronale Netzwerke verstehen und effizient verarbeiten können. Dieser Tokenisierungsschritt ist essentiell, da er die Eingabe standardisiert, die rechnerische Komplexität reduziert und dem Modell ermöglicht, semantische Zusammenhänge zwischen verschiedenen Textteilen durch mathematische Operationen auf Token-Vektoren zu erlernen.

Input-Tokens sind die Tokens aus Ihrem Prompt oder Ihrer Frage, die an das KI-Modell gesendet werden, während Output-Tokens die Tokens sind, die das Modell in seiner Antwort generiert. Die meisten KI-Dienste berechnen unterschiedlich für Input- und Output-Tokens, wobei Output-Tokens typischerweise mehr kosten, da die Generierung neuer Inhalte mehr Rechenressourcen erfordert als die Verarbeitung vorhandenen Texts. Ihre gesamte Token-Nutzung ist die Summe aus Input- und Output-Tokens.

Die Token-Anzahl bestimmt direkt die API-Kosten für Sprachmodelle. Dienste wie OpenAI, Claude und andere berechnen pro Token, wobei die Preise je nach Modell und Token-Typ variieren. Ein längerer Prompt mit mehr Tokens kostet mehr in der Verarbeitung, und das Generieren längerer Antworten verbraucht mehr Output-Tokens. Das Verständnis der Token-Effizienz hilft, Kosten zu optimieren – prägnante Prompts, die notwendige Informationen enthalten, minimieren den Token-Verbrauch und erhalten gleichzeitig die Antwortqualität.

Ein Kontextfenster ist die maximale Anzahl an Tokens, die ein Sprachmodell gleichzeitig verarbeiten kann – einschließlich Input- und Output-Tokens. GPT-4 hat zum Beispiel ein Kontextfenster von 8.000 bis 128.000 Tokens, abhängig von der Version. Dieses Limit bestimmt, wie viel Text das Modell beim Generieren von Antworten „sehen“ und sich merken kann. Größere Kontextfenster ermöglichen die Verarbeitung längerer Dokumente, erfordern aber auch mehr Rechenressourcen.

Die drei wichtigsten Tokenisierungsmethoden sind: Wortebene (Text wird in vollständige Wörter aufgeteilt), Zeichenebene (jedes Zeichen ist ein Token) und Teilwort-Tokenisierung wie Byte-Pair-Encoding (BPE), das von GPT-Modellen verwendet wird. Teilwort-Tokenisierung ist in modernen LLMs am gebräuchlichsten, da sie den Wortschatz ausbalanciert, seltene Wörter effektiv behandelt und OOV-Fehler reduziert, während die semantische Bedeutung erhalten bleibt.

Für Plattformen wie AmICited, die KI-Antworten auf ChatGPT, Perplexity, Claude und Google AI Overviews überwachen, ist die Token-Verfolgung entscheidend, um zu verstehen, wie viel Ihrer Markeninhalte oder URLs von KI-Systemen verarbeitet und zitiert werden. Token-Zählungen zeigen die Tiefe des KI-Engagements mit Ihren Inhalten – höherer Token-Verbrauch weist auf umfangreichere Zitate oder Referenzen hin und hilft Ihnen, die Sichtbarkeit und den Einfluss Ihrer Marke in KI-generierten Antworten zu messen.

Ja, absolut. Verschiedene Sprachmodelle verwenden unterschiedliche Tokenizer und Wortschätze, sodass derselbe Text unterschiedliche Token-Anzahlen ergibt. Zum Beispiel erzeugt das Wort „antidisestablishmentarianism“ 5 Tokens in GPT-3, aber 6 Tokens in GPT-4 aufgrund unterschiedlicher Tokenisierungsalgorithmen. Deshalb ist es wichtig, modell-spezifische Token-Zähler zu verwenden, wenn Sie Kosten schätzen oder Prompts für bestimmte KI-Systeme planen.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, wie sich Token-Limits auf die KI-Leistung auswirken, und entdecken Sie praktische Strategien zur Inhaltsoptimierung, einschließlich RAG-, Chunking...

Erfahren Sie, wie KI-Modelle Text durch Tokenisierung, Embeddings, Transformer-Blöcke und neuronale Netze verarbeiten. Verstehen Sie die vollständige Pipeline v...

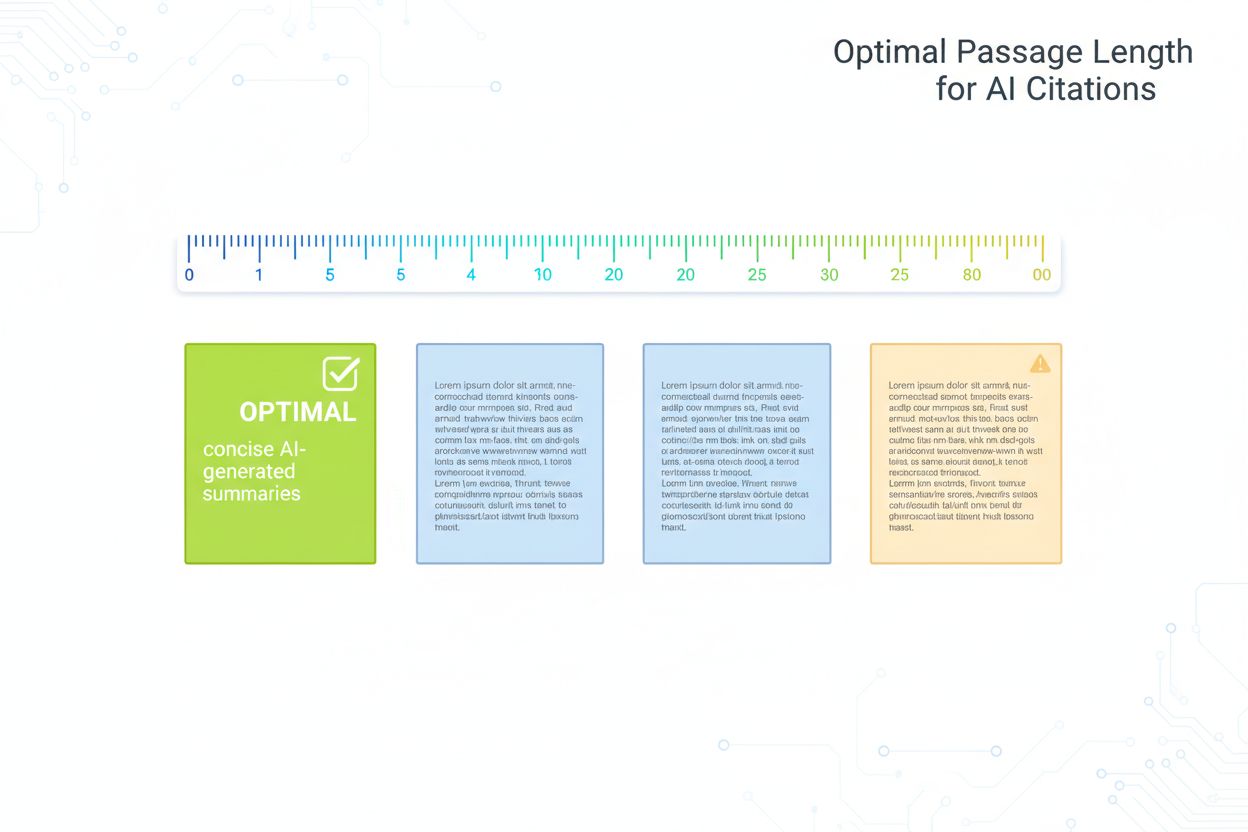

Forschungsbasierter Leitfaden zur optimalen Abschnittslänge für KI-Zitate. Erfahren Sie, warum 75-150 Wörter ideal sind, wie Tokens die KI-Retrieval beeinflusse...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.