GPT-4

GPT-4 ist OpenAIs fortschrittliches multimodales LLM, das Text- und Bildverarbeitung kombiniert. Erfahren Sie mehr über seine Fähigkeiten, Architektur und Auswi...

Eine neuronale Netzwerkarchitektur, die auf Multi-Head-Self-Attention-Mechanismen basiert und sequentielle Daten parallel verarbeitet. Dies ermöglicht die Entwicklung moderner großer Sprachmodelle wie ChatGPT, Claude und Perplexity. Eingeführt im Jahr 2017 im Paper ‘Attention is All You Need’, sind Transformer zur grundlegenden Technologie geworden, die nahezu allen modernen KI-Systemen zugrunde liegt.

Eine neuronale Netzwerkarchitektur, die auf Multi-Head-Self-Attention-Mechanismen basiert und sequentielle Daten parallel verarbeitet. Dies ermöglicht die Entwicklung moderner großer Sprachmodelle wie ChatGPT, Claude und Perplexity. Eingeführt im Jahr 2017 im Paper 'Attention is All You Need', sind Transformer zur grundlegenden Technologie geworden, die nahezu allen modernen KI-Systemen zugrunde liegt.

Die Transformer-Architektur ist ein revolutionäres neuronales Netzwerkdesign, das 2017 im Paper „Attention is All You Need“ von Google-Forschern eingeführt wurde. Sie basiert grundlegend auf Multi-Head-Self-Attention-Mechanismen, die es Modellen ermöglichen, ganze Sequenzen von Daten parallel statt sequenziell zu verarbeiten. Die Architektur besteht aus gestapelten Encoder- und Decoder-Schichten, die jeweils Self-Attention-Subschichten und Feed-Forward-Neuronale-Netzwerke enthalten und über Residualverbindungen und Layer-Normalisierung verbunden sind. Die Transformer-Architektur ist zur grundlegenden Technologie nahezu aller modernen Large Language Models (LLMs) geworden, darunter ChatGPT, Claude, Perplexity und Google AI Overviews, und gilt als die wohl wichtigste neuronale Netzwerkinnovation des vergangenen Jahrzehnts.

Die Bedeutung der Transformer-Architektur reicht weit über ihre technische Eleganz hinaus. Das Paper „Attention is All You Need“ von 2017 wurde über 208.000 Mal zitiert und ist eines der einflussreichsten Forschungsarbeiten der Geschichte des maschinellen Lernens. Diese Architektur hat grundlegend verändert, wie KI-Systeme Sprache verarbeiten und verstehen, und die Entwicklung von Modellen mit Milliarden von Parametern ermöglicht, die zu anspruchsvollem Schlussfolgern, kreativem Schreiben und komplexer Problemlösung in der Lage sind. Der Enterprise-LLM-Markt, der fast vollständig auf Transformer-Technologie basiert, hatte im Jahr 2024 einen Wert von 6,7 Milliarden US-Dollar und wird mit einer jährlichen Wachstumsrate von 26,1 % bis 2034 prognostiziert – ein Beleg für die zentrale Bedeutung dieser Architektur für die moderne KI-Infrastruktur.

Die Entwicklung der Transformer-Architektur stellt einen Wendepunkt in der Geschichte des Deep Learning dar und ist das Ergebnis jahrzehntelanger Forschung zu neuronalen Netzen zur Verarbeitung sequentieller Daten. Vor den Transformern dominierten rekurrente neuronale Netze (RNNs) und insbesondere deren Varianten, die Long Short-Term Memory (LSTM) Netzwerke, die Aufgaben der natürlichen Sprachverarbeitung. Diese Architekturen hatten jedoch grundlegende Einschränkungen: Sie verarbeiteten Sequenzen sequenziell, ein Element nach dem anderen, was das Training langsam machte und es erschwerte, Abhängigkeiten zwischen weit entfernten Elementen in langen Sequenzen zu erfassen. Das Vanishing-Gradient-Problem begrenzte zusätzlich die Fähigkeit von RNNs, Langzeitbeziehungen zu lernen, da Gradienten beim Rückwärtsdurchlauf durch viele Schichten exponentiell kleiner wurden.

Die Einführung von Attention-Mechanismen 2014 durch Bahdanau und Kollegen war ein Durchbruch, da sie Modellen erlaubte, sich unabhängig von der Entfernung auf relevante Teile von Eingabesequenzen zu konzentrieren. Anfangs wurde Attention jedoch nur als Ergänzung zu RNNs eingesetzt, nicht als Ersatz. Das Transformer-Paper von 2017 ging einen Schritt weiter und postulierte, dass Attention alles ist, was man braucht – dass man eine komplette neuronale Netzwerkarchitektur allein auf Attention-Mechanismen und Feed-Forward-Schichten aufbauen kann, ganz ohne Rekurrenz. Diese Erkenntnis war wegweisend. Durch den Verzicht auf sequentielle Verarbeitung ermöglichten Transformer massive Parallelisierung, sodass Forscher mit GPUs und TPUs auf nie dagewesenen Datenmengen trainieren konnten. Das größte Transformer-Modell im Original-Paper, das auf 8 GPUs für 3,5 Tage trainiert wurde, zeigte, dass Skalierung und Parallelisierung zu dramatisch verbesserten Leistungen führen können.

Nach dem ursprünglichen Transformer-Paper entwickelte sich die Architektur rasant weiter. BERT (Bidirectional Encoder Representations from Transformers), 2019 von Google veröffentlicht, zeigte, dass man Transformer-Encoder auf riesigen Textkorpora vortrainieren und für verschiedene Aufgaben feinjustieren kann. Das größte BERT-Modell enthielt 345 Millionen Parameter und wurde auf 64 spezialisierten TPUs für vier Tage (Kosten: $7.000) trainiert – und erreichte dennoch Bestleistungen bei zahlreichen Sprachverständnis-Benchmarks. Gleichzeitig beschritt die GPT-Serie von OpenAI einen anderen Weg und nutzte reine Decoder-Architekturen für Sprachmodellierungsaufgaben. GPT-2 mit 1,5 Milliarden Parametern überraschte die Community, da Sprachmodellierung allein zu bemerkenswert leistungsfähigen Systemen führen kann. GPT-3 mit 175 Milliarden Parametern zeigte emergente Fähigkeiten – Fähigkeiten, die erst durch Skalierung auftreten, darunter Few-Shot-Lernen und komplexes Schlussfolgern – und veränderte so die Erwartungen an KI-Systeme grundlegend.

Die Transformer-Architektur besteht aus mehreren miteinander verbundenen technischen Komponenten, die effiziente Parallelverarbeitung und ein ausgefeiltes Kontextverständnis ermöglichen. Die Input-Embedding-Schicht wandelt diskrete Tokens (Wörter oder Subworteinheiten) in kontinuierliche Vektor-Repräsentationen (typischerweise mindestens 512 Dimensionen) um. Diese Embeddings werden mit einer Positionskodierung angereichert, die Informationen über die Position jedes Tokens in der Sequenz mittels Sinus- und Kosinusfunktionen unterschiedlicher Frequenzen hinzufügt. Diese Positionsinformation ist essentiell, da Transformer – im Gegensatz zu RNNs, die die Reihenfolge durch ihre rekurrente Struktur erhalten – alle Tokens gleichzeitig verarbeiten und explizite Positionssignale benötigen, um Wortreihenfolge und relative Abstände zu verstehen.

Der Self-Attention-Mechanismus ist die architektonische Innovation, die Transformer von allen vorherigen neuronalen Netzwerkdesigns unterscheidet. Für jedes Token in der Eingabesequenz berechnet das Modell drei Vektoren: einen Query-Vektor (stellt dar, nach welchen Informationen das Token sucht), Key-Vektoren (geben an, welche Informationen jedes Token enthält) und Value-Vektoren (repräsentieren die tatsächlichen weiterzugebenden Informationen). Der Attention-Mechanismus berechnet einen Ähnlichkeitswert zwischen dem Query eines Tokens und den Keys aller Tokens mittels Skalarprodukt, normalisiert diese Werte per Softmax zu Attention-Gewichten zwischen 0 und 1 und erzeugt so eine gewichtete Summe der Value-Vektoren. Dadurch kann sich jedes Token selektiv auf andere relevante Tokens fokussieren und das Modell Kontext und Zusammenhänge erfassen.

Multi-Head-Attention erweitert dieses Konzept, indem mehrere parallele Attention-Mechanismen gleichzeitig ausgeführt werden, typischerweise 8, 12 oder 16 Heads. Jeder Head arbeitet auf unterschiedlichen linearen Projektionen der Query-, Key- und Value-Vektoren, sodass das Modell verschiedene Arten von Beziehungen und Mustern in unterschiedlichen Repräsentationsräumen erfassen kann. Beispielsweise konzentriert sich ein Attention-Head auf syntaktische Beziehungen zwischen Wörtern, ein anderer auf semantische Zusammenhänge oder Langzeitabhängigkeiten. Die Ausgaben aller Heads werden zusammengefügt und linear transformiert, wodurch das Modell reichhaltige, vielschichtige Kontextinformationen erhält. Dieser Ansatz ist äußerst effektiv, und Forschungen zeigen, dass verschiedene Heads sich auf unterschiedliche linguistische Phänomene spezialisieren.

Die Encoder-Decoder-Struktur organisiert diese Attention-Mechanismen zu einer hierarchischen Verarbeitungspipeline. Der Encoder besteht aus mehreren gestapelten Schichten (typischerweise 6 oder mehr), die jeweils eine Multi-Head-Self-Attention-Subschicht und ein positionsweises Feed-Forward-Netzwerk enthalten. Residualverbindungen um jede Subschicht ermöglichen einen direkten Gradientenfluss beim Training, verbessern die Stabilität und erlauben tiefere Architekturen. Layer-Normalisierung wird nach jeder Subschicht angewendet, um die Aktivierungen auf ein konsistentes Niveau zu bringen. Der Decoder ist ähnlich aufgebaut, enthält jedoch eine zusätzliche Encoder-Decoder-Attention-Schicht, die es dem Decoder ermöglicht, sich beim Generieren jedes Tokens auf relevante Teile der Encoder-Ausgabe zu konzentrieren. Bei reinen Decoder-Architekturen wie GPT werden Ausgabetokens autoregressiv generiert, wobei jedes neue Token auf allen zuvor generierten Tokens basiert.

| Aspekt | Transformer-Architektur | RNN/LSTM | Convolutional Neural Networks (CNN) |

|---|---|---|---|

| Verarbeitungsmethode | Parallele Verarbeitung ganzer Sequenzen mittels Attention | Sequentielle Verarbeitung, ein Element nach dem anderen | Lokale Faltung auf festen Fenstergrößen |

| Langzeitabhängigkeiten | Exzellent; Attention verbindet entfernte Tokens direkt | Schwach; limitiert durch Vanishing Gradients und sequentielle Engpässe | Limitiert; lokale Rezeptivfelder benötigen viele Schichten |

| Trainingsgeschwindigkeit | Sehr schnell; massive Parallelisierung auf GPUs/TPUs | Langsam; keine Parallelisierung durch sequentielle Verarbeitung | Schnell bei fixen Eingaben; weniger geeignet für variable Sequenzen |

| Speicherbedarf | Hoch; quadratisch zur Sequenzlänge wegen Attention | Geringer; linear in der Sequenzlänge | Mittel; abhängig von Kernelgröße und Tiefe |

| Skalierbarkeit | Exzellent; skaliert auf Milliarden Parameter | Limitiert; schwer sehr große Modelle zu trainieren | Gut für Bilder; weniger geeignet für Sequenzen |

| Typische Anwendungen | Sprachmodellierung, maschinelle Übersetzung, Textgenerierung | Zeitreihen, sequentielle Vorhersagen (heute weniger verbreitet) | Bildklassifikation, Objekterkennung, Computer Vision |

| Gradientenfluss | Stabil; Residualverbindungen ermöglichen tiefe Netze | Problematisch; Vanishing/Exploding Gradients | Meist stabil; lokale Verbindungen helfen dem Gradientenfluss |

| Positionsinformation | Explizite Positionskodierung notwendig | Implizit durch sequentielle Verarbeitung | Implizit durch räumliche Struktur |

| State-of-the-Art-LLMs | GPT, Claude, Llama, Granite, Perplexity | Kaum noch in modernen LLMs | Nicht für Sprachmodellierung verwendet |

Das Verhältnis zwischen Transformer-Architektur und modernen großen Sprachmodellen ist fundamental und untrennbar. Jedes große LLM der letzten fünf Jahre – darunter OpenAIs GPT-4, Anthropics Claude, Metas Llama, Googles Gemini, IBMs Granite und Perplexitys KI-Modelle – basiert auf der Transformer-Architektur. Die effiziente Skalierbarkeit hinsichtlich Modellgröße und Trainingsdaten ist entscheidend für die Fähigkeiten moderner KI-Systeme. Als Forscher die Modellgröße von Millionen auf Milliarden und schließlich auf Hunderte von Milliarden Parametern erhöhten, ermöglichte die Parallelisierung und das Aufmerksamkeitsprinzip der Transformer diese Skalierung ohne proportional steigende Trainingszeiten.

Der autoregressive Dekodierprozess, wie er in den meisten modernen LLMs genutzt wird, ist eine direkte Anwendung der Transformer-Decoder-Architektur. Beim Generieren von Text verarbeitet das Modell die Eingabe zunächst durch den Encoder (bzw. bei Decoder-only-Modellen durch den vollständigen Decoder) und generiert dann die Ausgabetokens einzeln. Jedes neue Token wird erzeugt, indem Wahrscheinlichkeitsverteilungen über das gesamte Vokabular mittels Softmax berechnet werden; das Modell wählt dann das wahrscheinlichste Token aus (oder sampelt entsprechend Temperatureinstellungen). Dieser Prozess wiederholt sich Hunderte oder Tausende Male und erzeugt kohärenten, kontextuell passenden Text. Der Self-Attention-Mechanismus ermöglicht es dem Modell, den Kontext über die gesamte generierte Sequenz hinweg zu bewahren und lange, zusammenhängende Passagen mit konsistenten Themen, Figuren und logischem Aufbau zu erzeugen.

Die bei großen Transformer-Modellen beobachteten emergenten Fähigkeiten – Fähigkeiten, die erst ab einer gewissen Skalierung auftreten, wie Few-Shot-Lernen, Chain-of-Thought-Reasoning und In-Context-Learning – sind direkte Konsequenzen des Designs der Transformer-Architektur. Die Multi-Head-Attention kann vielfältige Zusammenhänge erfassen; kombiniert mit enormen Parameterzahlen und Training auf vielfältigen Daten ermöglicht dies Aufgaben, für die das Modell nie explizit trainiert wurde. Beispielsweise konnte GPT-3 Rechenaufgaben lösen, Code schreiben und Wissensfragen beantworten, obwohl es nur auf Sprachmodellierung trainiert wurde. Diese emergenten Eigenschaften haben Transformer-basierte LLMs zur Grundlage der modernen KI-Revolution gemacht – mit Anwendungen von Conversational AI und Content-Generierung bis hin zu Code-Synthese und wissenschaftlicher Rechercheunterstützung.

Der Self-Attention-Mechanismus ist die architektonische Innovation, die Transformer grundlegend von früheren Ansätzen unterscheidet und ihre überlegene Leistung erklärt. Um Self-Attention zu verstehen, betrachten Sie das Problem der Interpretation von Pronomen in Sprache. Im Satz „Der Pokal passt nicht in den Koffer, weil er zu groß ist“ kann sich „er“ auf Pokal oder Koffer beziehen – der Kontext macht klar, es ist der Pokal. Im Satz „Der Pokal passt nicht in den Koffer, weil er zu klein ist“ bezieht sich das Pronomen auf den Koffer. Ein Transformer-Modell muss solche Mehrdeutigkeiten auflösen, indem es die Beziehungen zwischen den Wörtern versteht.

Self-Attention erreicht dies auf mathematisch elegante Weise. Für jedes Token berechnet das Modell einen Query-Vektor, indem das Token-Embedding mit einer gelernten Gewichtsmatrix WQ multipliziert wird. Analog werden Key-Vektoren (mit WK) und Value-Vektoren (mit WV) für alle Tokens berechnet. Der Attention-Score zwischen dem Query eines Tokens und dem Key eines anderen wird als Skalarprodukt berechnet und durch die Quadratwurzel der Key-Dimension (meist √64 ≈ 8) normalisiert. Diese Rohwerte werden durch eine Softmax-Funktion geschickt, die sie in normierte Attention-Gewichte umwandelt, deren Summe 1 ergibt. Schließlich wird für jedes Token eine gewichtete Summe aller Value-Vektoren gebildet, wobei die Gewichte die Attention-Scores darstellen. So kann jedes Token gezielt Informationen von allen anderen aggregieren – die Gewichte werden beim Training gelernt und erfassen sinnvolle Beziehungen.

Die mathematische Eleganz von Self-Attention ermöglicht effiziente Berechnung. Der gesamte Prozess lässt sich als Matrixoperation ausdrücken: Attention(Q, K, V) = softmax(QK^T / √d_k)V, wobei Q, K und V Matrizen mit allen Query-, Key- und Value-Vektoren sind. Diese Matrixformulierung erlaubt GPU-Beschleunigung und macht es möglich, ganze Sequenzen parallel statt sequentiell zu verarbeiten. Eine Sequenz mit 512 Tokens kann so in etwa der gleichen Zeit verarbeitet werden wie ein einzelnes Token in einem RNN – Transformer sind damit um Größenordnungen schneller trainierbar. Diese Recheneffizienz, kombiniert mit der Fähigkeit, Langzeitabhängigkeiten zu erfassen, erklärt die Dominanz der Transformer bei Sprachmodellen.

Multi-Head-Attention erweitert Self-Attention, indem mehrere parallele Attention-Operationen laufen, die jeweils verschiedene Aspekte von Token-Beziehungen lernen. In einem typischen Transformer mit 8 Attention-Heads werden die Eingabe-Embeddings linear in 8 verschiedene Repräsentationsräume projiziert, jede mit eigenen Query-, Key- und Value-Gewichtsmatrizen. Jeder Head berechnet unabhängig Attention-Gewichte und erzeugt Output-Vektoren. Diese Outputs werden dann zusammengefügt und durch eine finale Gewichtsmatrix linear transformiert, um das endgültige Multi-Head-Attention-Resultat zu liefern. Dadurch kann das Modell gleichzeitig Informationen aus unterschiedlichen Repräsentationsräumen an unterschiedlichen Positionen beachten.

Untersuchungen an trainierten Transformer-Modellen zeigen, dass verschiedene Attention-Heads sich auf unterschiedliche linguistische Phänomene spezialisieren. Manche Heads fokussieren auf syntaktische Beziehungen, etwa zwischen Verb und Subjekt/Objekt. Andere Heads erfassen semantische Beziehungen oder Langzeitabhängigkeiten zwischen weit entfernten, aber zusammengehörigen Wörtern. Einige Heads lernen sogar, sich hauptsächlich auf das aktuelle Token selbst zu konzentrieren (Identitätsfunktion). Diese Spezialisierung entsteht beim Training ohne explizite Vorgaben und verdeutlicht die Leistungsfähigkeit des Multi-Head-Ansatzes für das Lernen vielfältiger, komplementärer Repräsentationen.

Die Anzahl an Attention-Heads ist ein wichtiger Architektur-Hyperparameter. Größere Modelle nutzen meist mehr Heads (16, 32 oder mehr), um vielfältigere Beziehungen zu erfassen. Die Gesamtdimensionalität der Attention bleibt aber meist konstant, sodass mit mehr Heads die Dimensionalität pro Head sinkt – ein Kompromiss zwischen Vielseitigkeit und Effizienz. Der Multi-Head-Ansatz ist heute Standard in praktisch allen modernen Transformer-Implementierungen – von BERT und GPT bis zu spezialisierten Architekturen für Vision, Audio und Multimodalität.

Die in „Attention is All You Need“ beschriebene Original-Transformer-Architektur nutzt eine Encoder-Decoder-Struktur, optimiert für Sequenz-zu-Sequenz-Aufgaben wie maschinelle Übersetzung. Der Encoder verarbeitet die Eingabesequenz und erzeugt eine Sequenz kontextreicher Repräsentationen. Jede Encoder-Schicht besteht aus zwei Hauptkomponenten: einer Multi-Head-Self-Attention-Subschicht, die es Tokens ermöglicht, auf andere Tokens der Eingabe zu achten, und einem positionsweisen Feed-Forward-Netzwerk, das auf jede Position unabhängig angewandt wird. Diese Subschichten sind durch Residualverbindungen (auch Skip Connections genannt) verbunden, die dem Vorbild der Residual-Netze aus der Computer Vision folgen und tiefe Netze trainierbar machen, da Gradienten direkt durchfließen können.

Der Decoder generiert die Ausgabesequenz Token für Token, unter Nutzung der Encoder-Informationen und der bereits generierten Tokens. Jede Decoder-Schicht hat drei Hauptkomponenten: eine maskierte Self-Attention-Subschicht, die jedem Token nur erlaubt, auf vorherige Tokens zu achten (so wird „Vorausspicken“ beim Training verhindert), eine Encoder-Decoder-Attention-Subschicht zum Bezug auf die Encoder-Ausgaben, und ein positionsweises Feed-Forward-Netzwerk. Das Maskieren in der Self-Attention ist entscheidend: Es verhindert, dass Informationen von zukünftigen zu vergangenen Positionen fließen, sodass Vorhersagen für Position i nur von bekannten Ausgaben auf niedrigeren Positionen abhängen. Diese autoregressive Struktur ist essenziell für die sequenzielle Ausgabeerzeugung.

Die Encoder-Decoder-Architektur ist besonders effektiv für Aufgaben, bei denen Eingabe und Ausgabe unterschiedliche Strukturen oder Längen haben, etwa maschinelle Übersetzung, Zusammenfassung oder Fragebeantwortung. Moderne LLMs wie GPT nutzen jedoch reine Decoder-Architekturen, bei denen ein einzelner Stack von Decoder-Schichten sowohl den Input verarbeitet als auch die Ausgabe generiert. Diese Vereinfachung reduziert die Modellkomplexität und ist für Sprachmodellierungsaufgaben mindestens ebenso effektiv, wahrscheinlich weil das Modell gelernt hat, Self-Attention einheitlich für Input und Output zu nutzen.

Eine zentrale Herausforderung der Transformer-Architektur ist die Repräsentation der Reihenfolge von Tokens in einer Sequenz. RNNs speichern die Reihenfolge durch ihre rekurrente Struktur implizit, Transformer verarbeiten alle Tokens parallel und haben keine eingebaute Positionsinformation. Ohne explizite Positionsangabe würde ein Transformer die Sequenz „Die Katze saß auf der Matte“ genauso behandeln wie „Matte der auf saß Katze Die“ – was für das Sprachverständnis katastrophal wäre. Die Lösung ist die Positionskodierung, die positionsabhängige Vektoren zu den Token-Embeddings addiert.

Das Original-Transformer-Paper nutzt sinusförmige Positionskodierungen, wobei der Positionsvektor für Position pos und Dimension i wie folgt berechnet wird:

Diese Sinus- und Kosinusfunktionen erzeugen für jede Position ein einzigartiges Muster mit unterschiedlichen Frequenzen pro Dimension. Die niederfrequenten Komponenten (kleines i) variieren langsam mit der Position und erfassen Langzeit-Positionsinformation, während die hochfrequenten schnell variieren und feine Positionsdetails kodieren. Vorteile dieser Methode: Sie generalisiert natürlich auf längere Sequenzen als im Training, sorgt für sanfte Übergänge und erlaubt dem Modell, relative Positionen zu lernen. Die Positionskodierungsvektoren werden einfach zu den Embeddings addiert, bevor sie in den ersten Attention-Layer gehen; das Modell lernt, die Positionsinformation zu nutzen.

Es wurden alternative Positionskodierungen erforscht, darunter relative Positionsrepräsentationen (kodieren Abstände statt absolute Positionen) und Rotary Position Embeddings (RoPE) (rotieren Embedding-Vektoren positionsabhängig). Solche Methoden verbessern das Modell insbesondere bei sehr langen Sequenzen oder beim Feintuning auf längere Sequenzen. Die Wahl der Positionskodierung beeinflusst die Modellleistung erheblich und bleibt ein aktives Forschungsfeld der Transformer-Optimierung.

Das Verständnis der Transformer-Architektur ist zentral, um zu begreifen, wie moderne KI-Systeme Antworten generieren, die auf Plattformen wie ChatGPT, Claude, Perplexity und Google AI Overviews erscheinen. Diese Systeme – alle gebaut auf Transformer-Technologie – verarbeiten Nutzeranfragen durch mehrere Self-Attention-Schichten, um Kontext zu verstehen und kohärente, relevante Antworten zu generieren. Wird eine Frage zu einer Marke, einem Produkt oder einer Domain gestellt, bestimmen die Attention-Mechanismen des Transformers, welche Teile der Trainingsdaten relevant sind, und der Decoder erzeugt eine Antwort, die ggf. die Marke erwähnt oder referenziert.

Für Unternehmen, die KI-Monitoring-Plattformen wie AmICited nutzen, liefert das Verständnis der Transformer-Architektur entscheidende Hinweise, wie und warum Marken in KI-generierten Inhalten erscheinen. Die Fähigkeit des Self-Attention-Mechanismus, Beziehungen zwischen Konzepten zu erfassen, bedeutet, dass Marken, die in den Trainingsdaten erwähnt werden, mit bestimmten Themen, Branchen oder Anwendungsfällen assoziiert werden können. Fragt ein Nutzer eine KI zu diesen Themen, können die Attention-Mechanismen Verbindungen zu Ihrer Marke aktivieren, sodass diese in der Antwort erscheint. Durch die Multi-Head-Attention werden unterschiedliche Aspekte der Markenpräsenz in den Trainingsdaten von verschiedenen Heads abgedeckt, was beeinflusst, wie umfassend das Modell Ihre Marke versteht und darstellt.

Der Trainingsdatenfokus der Transformer-Architektur erklärt auch, warum Markensichtbarkeit in KI-Ausgaben stark von der Qualität und Quantität Ihrer Online-Präsenz abhängt. Modelle, die auf Internettexten trainiert werden, haben reichhaltigere Repräsentationen von Marken mit umfangreichen, hochwertigen Webinhalten, häufigen Erwähnungen in seriösen Quellen und starken semantischen Verknüpfungen zu relevanten Themen. Wer die Sichtbarkeit seiner Marke in KI-Antworten steigern möchte, sollte verstehen, dass letztlich die Aufnahme in die Trainingsdaten zukünftiger Transformer entscheidend ist. Dieses Verständnis schlägt die Brücke zwischen traditionellem SEO und dem, was man „GEO“ (Generative Engine Optimization) nennen könnte – Optimierung für Sichtbarkeit in KI-Systemen.

Die Transformer-Architektur entwickelt sich rasant weiter. Forscher untersuchen zahlreiche Verbesserungen und Varianten. Effiziente Transformer adressieren die quadratische Speicherkomplexität der Standard-Attention (die mit dem Quadrat der Sequenzlänge skaliert) durch Techniken wie Sparse Attention, lokale Attention-Fenster und lineare Approximierungen. Dadurch lassen sich Transformer auf sehr langen Sequenzen (tausende bis Millionen Tokens) anwenden – etwa für ganze Dokumente, Codebasen oder Wissensdatenbanken in einem Vorwärtspass. Mixture-of-Experts (MoE)-Architekturen, wie im Switch Transformer von Google, ersetzen dichte Feed-Forward-Netze durch spärliche Netze, bei denen pro Token nur ein Teil der Parameter aktiviert wird. Dadurch steigt die Modellkapazität enorm, ohne dass der Rechenaufwand proportional wächst.

Multimodale Transformer erweitern die Architektur auf verschiedene Datentypen. Vision Transformer (ViT) wenden die Transformer-Architektur auf Bilder an, indem sie diese in Patches teilen und die Patches als Tokens behandeln – und so Bestleistungen bei Klassifikation und Detektion erzielen. Multimodale Modelle wie GPT-4V und Claude 3 verarbeiten Text und Bilder gemeinsam mit einheitlicher Transformer-Architektur und ermöglichen Fähigkeiten wie Bildverständnis und visuelles Question Answering. Audio-Transformer bearbeiten Sprache und Musik, Video-Transformer verarbeiten zeitliche Sequenzen von Bildern. Diese multimodale Fähigkeit lässt vermuten, dass Transformer zur universellen Architektur für alle KI-Aufgaben werden könnten, unabhängig vom Datenmodus.

Die strategischen Auswirkungen der Dominanz der Transformer-Architektur sind tiefgreifend. Wer KI-Systeme entwickelt, muss die Möglichkeiten und Grenzen der Transformer verstehen, um fundierte Entscheidungen zu Modellauswahl, Feintuning und Deployment zu treffen. Die Datenhungrigkeit der Architektur macht Qualität und Diversität der Trainingsdaten zum entscheidenden Wettbewerbsvorteil. Die Interpretierbarkeit der Attention (gegenüber anderen Deep-Learning-Ansätzen) eröffnet Chancen für erklärbare KI und Bias-Erkennung – wenngleich Attention-Gewichte allein das Modellverhalten nicht vollständig erklären. Die Effizienz der Architektur bei großer Skalierung legt nahe, dass immer größere Modelle dominieren werden, zumindest bis es grundlegende Durchbrüche bei Alternativarchitekturen gibt. Für Markenmonitoring und KI-Sichtbarkeit bedeutet die Trainingsdatenabhängigkeit, dass langfristiger Markenaufbau und Content-Strategie essenziell bleiben, um Sichtbarkeit in KI-generierten Antworten zu behalten.

Der globale LLM-Markt, der fast vollständig auf Transformer-Architektur basiert, wird voraussichtlich von 8,07 Milliarden US-Dollar im Jahr 2025 auf 84,25 Milliarden US-Dollar bis 2033 wachsen – das entspricht einer jährlichen Wachstumsrate von über 30 %. Dieses explosive Wachstum spiegelt den transformativen Einfluss der Transformer-Architektur auf KI-Fähigkeiten und Anwendungen wider. Während sich Transformer weiter verbessern und neue Varianten entstehen, wird ihre Rolle als Grundlagentechnologie moderner KI weiter zunehmen – und das Verständnis dieser Architektur ist für alle, die in KI, Data Science oder Digitalstrategie tätig sind, unerlässlich.

Die Transformer-Architektur verarbeitet ganze Sequenzen parallel mithilfe von Self-Attention, während RNNs und LSTMs Sequenzen sequentiell, also ein Element nach dem anderen, verarbeiten. Diese Parallelisierung macht Transformer deutlich schneller im Training und besser darin, Langzeitabhängigkeiten zwischen weit entfernten Wörtern oder Token zu erfassen. Zudem vermeiden Transformer das Vanishing-Gradient-Problem, das RNNs plagt, und ermöglichen so das effektive Lernen aus viel längeren Sequenzen.

Self-Attention berechnet für jedes Token in der Eingabesequenz drei Vektoren (Query, Key und Value). Der Query-Vektor eines Tokens wird mit den Key-Vektoren aller Tokens verglichen, um Relevanzwerte zu bestimmen, die mittels Softmax normalisiert werden. Diese Aufmerksamkeitsgewichte werden dann auf die Value-Vektoren angewendet, um kontextbezogene Repräsentationen zu erzeugen. Dieser Mechanismus ermöglicht es jedem Token, sich auf andere relevante Tokens in der Sequenz zu 'konzentrieren', sodass das Modell Kontext und Zusammenhänge versteht.

Zu den Hauptkomponenten gehören: (1) Input-Embeddings und Positionskodierung zur Darstellung von Tokens und deren Positionen, (2) Multi-Head-Self-Attention-Schichten, die Aufmerksamkeit über mehrere Repräsentationsräume berechnen, (3) Feed-Forward-Neuronale-Netze, die auf jede Position unabhängig angewendet werden, (4) Encoder-Stack, der Eingabesequenzen verarbeitet, (5) Decoder-Stack, der Ausgabesequenzen generiert, und (6) Residualverbindungen und Layer-Normalisierung für Trainingsstabilität. Diese Komponenten ermöglichen effizientes paralleles Verarbeiten und Kontextverständnis.

Die Transformer-Architektur ist für LLMs so überzeugend, weil sie die parallele Verarbeitung ganzer Sequenzen ermöglicht und dadurch die Trainingszeit im Vergleich zu sequentiellen RNNs drastisch verkürzt. Mithilfe von Self-Attention kann sie Langzeitabhängigkeiten viel effektiver erfassen und so Kontext über ganze Dokumente hinweg verstehen. Die Architektur skaliert zudem effizient mit größeren Datensätzen und mehr Parametern – entscheidend für das Training von Modellen mit Milliarden von Parametern, die emergente Fähigkeiten zeigen.

Multi-Head-Attention führt mehrere parallele Aufmerksamkeitsmechanismen (typischerweise 8 oder 16 Heads) gleichzeitig aus, wobei jeder in einem anderen Repräsentationsraum arbeitet. Jeder Head lernt, sich auf unterschiedliche Arten von Zusammenhängen und Mustern in den Daten zu konzentrieren. Die Ausgaben aller Heads werden zusammengefügt und linear transformiert, sodass das Modell vielfältige Kontextinformationen erfassen kann. Dieser Ansatz verbessert das Verständnis komplexer Beziehungen und insgesamt die Modellleistung erheblich.

Die Positionskodierung fügt den Input-Embeddings Informationen über Token-Positionen hinzu, indem Sinus- und Kosinusfunktionen mit unterschiedlichen Frequenzen verwendet werden. Da Transformer alle Tokens parallel verarbeiten (im Gegensatz zu sequentiellen RNNs), benötigen sie explizite Positionsinformationen, um die Wortreihenfolge zu verstehen. Die Positionskodierungsvektoren werden zu den Token-Embeddings addiert, sodass das Modell lernt, wie Position Bedeutung beeinflusst, und es generalisiert auf längere Sequenzen als im Training gesehen.

Der Encoder verarbeitet die Eingabesequenz und erzeugt durch mehrere Schichten von Self-Attention und Feed-Forward-Netzen reichhaltige Kontextrepräsentationen. Der Decoder generiert die Ausgabesequenz Token für Token und verwendet Encoder-Decoder-Attention, um sich auf relevante Teile der Eingabe zu konzentrieren. Diese Struktur ist besonders nützlich für Sequenz-zu-Sequenz-Aufgaben wie maschinelle Übersetzung, während moderne LLMs oft nur Decoder-Architekturen zur Textgenerierung nutzen.

Die Transformer-Architektur steckt hinter den KI-Systemen, die Antworten auf Plattformen wie ChatGPT, Claude, Perplexity und Google AI Overviews generieren. Zu verstehen, wie Transformer Text verarbeiten und erzeugen, ist entscheidend für KI-Monitoring-Plattformen wie AmICited, die verfolgen, wo Marken und Domains in KI-generierten Antworten erscheinen. Die Fähigkeit der Architektur, Kontext zu erfassen und kohärenten Text zu generieren, wirkt sich direkt darauf aus, wie Marken in KI-Ausgaben erwähnt und dargestellt werden.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

GPT-4 ist OpenAIs fortschrittliches multimodales LLM, das Text- und Bildverarbeitung kombiniert. Erfahren Sie mehr über seine Fähigkeiten, Architektur und Auswi...

Erfahren Sie, wie KI-Suchmaschinen wie ChatGPT, Perplexity und Google AI Overviews funktionieren. Entdecken Sie LLMs, RAG, semantische Suche und Echtzeit-Retrie...

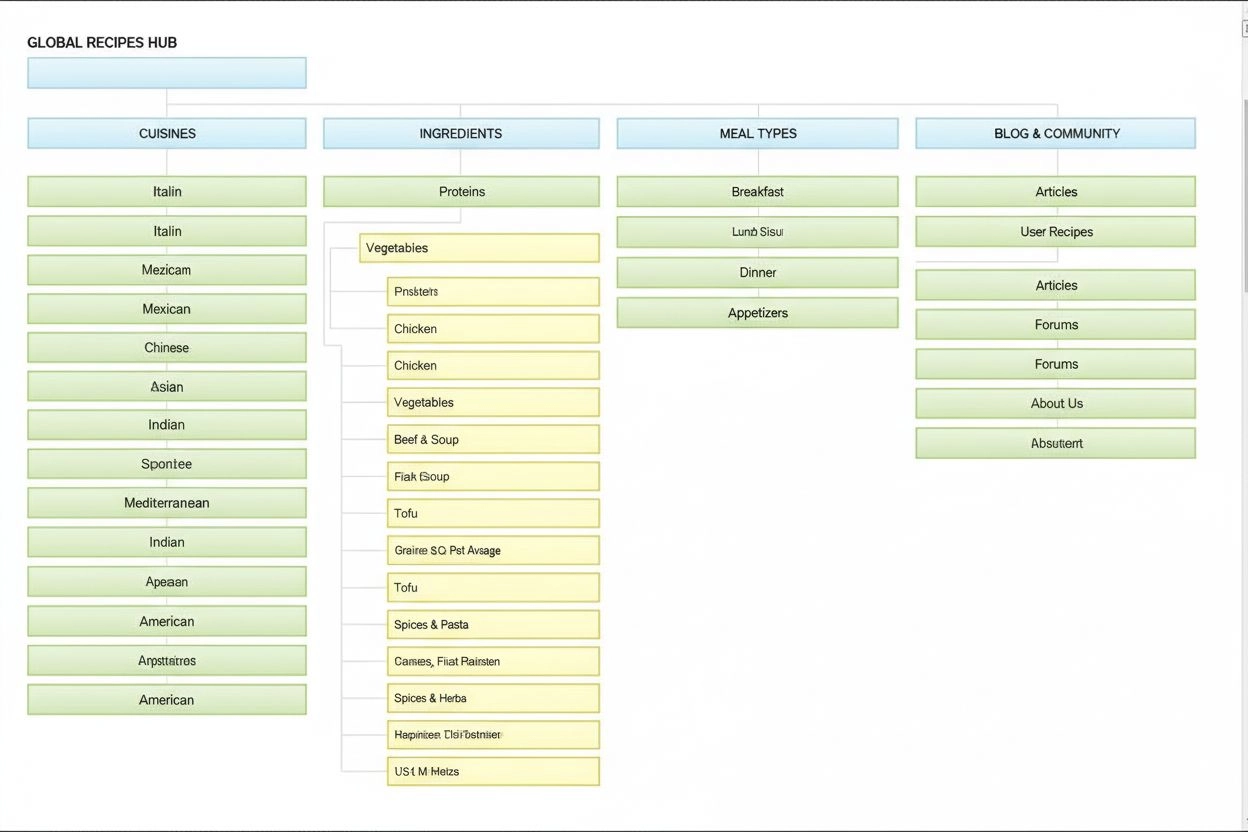

Informationsarchitektur ist die Praxis, Inhalte für optimale Nutzbarkeit zu organisieren und zu strukturieren. Erfahren Sie, wie IA die Auffindbarkeit, Benutzer...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.