Was ist Vektorensuche und wie funktioniert sie?

Erfahren Sie, wie die Vektorensuche maschinelle Lern-Einbettungen nutzt, um ähnliche Elemente anhand von Bedeutung statt exakter Schlüsselwörter zu finden. Vers...

Die Vektorsuche ist eine Methode, um ähnliche Elemente in einem Datensatz zu finden, indem Daten als mathematische Vektoren dargestellt und mittels Distanzmetriken wie Kosinusähnlichkeit oder euklidischer Distanz verglichen werden. Dieser Ansatz ermöglicht ein semantisches Verständnis jenseits der Stichwortsuche, sodass Systeme Beziehungen und Ähnlichkeiten auf Basis der Bedeutung und nicht nur auf exakten Textübereinstimmungen entdecken können.

Die Vektorsuche ist eine Methode, um ähnliche Elemente in einem Datensatz zu finden, indem Daten als mathematische Vektoren dargestellt und mittels Distanzmetriken wie Kosinusähnlichkeit oder euklidischer Distanz verglichen werden. Dieser Ansatz ermöglicht ein semantisches Verständnis jenseits der Stichwortsuche, sodass Systeme Beziehungen und Ähnlichkeiten auf Basis der Bedeutung und nicht nur auf exakten Textübereinstimmungen entdecken können.

Vektorsuche ist eine Methode, um ähnliche Elemente in einem Datensatz zu finden, indem Daten als mathematische Vektoren dargestellt und mittels Distanzmetriken verglichen werden, um semantische Ähnlichkeit zu messen. Im Gegensatz zur traditionellen stichwortbasierten Suche, die auf exakten Textübereinstimmungen beruht, versteht die Vektorsuche die Bedeutung und den Kontext der Daten, indem sie diese in hochdimensionale numerische Repräsentationen namens Vektorembeddings umwandelt. Dieser Ansatz ermöglicht es Systemen, Beziehungen und Ähnlichkeiten auf Basis des semantischen Inhalts statt nur oberflächlicher Merkmale zu entdecken und ist besonders leistungsstark für Anwendungen, die kontextuelles Verständnis erfordern. Die Vektorsuche ist zu einer Grundlage moderner KI-Systeme geworden und ermöglicht semantische Suche, Empfehlungssysteme, Anomalieerkennung und Retrieval-Augmented Generation (RAG) auf Plattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude.

Im Kern wandelt die Vektorsuche Daten in numerische Repräsentationen um, wobei die Nähe im Raum auf semantische Ähnlichkeit hinweist. Jeder Datenpunkt – egal ob Text, Bild oder Audio – wird in einen Vektor umgewandelt, also eine Zahlenreihe, die Merkmale oder Bedeutung repräsentiert. Zum Beispiel könnte das Wort „Restaurant“ als [0.2, -0.5, 0.8, 0.1] dargestellt werden, wobei jede Zahl verschiedene Aspekte der semantischen Bedeutung einfängt. Das grundlegende Prinzip ist, dass semantisch ähnliche Elemente im hochdimensionalen Raum nahe beieinander liegen, während unähnliche weit voneinander entfernt sind. Diese mathematische Struktur ermöglicht Computern, Konzepte anhand ihrer Bedeutung statt nur anhand exakter Stichwortübereinstimmungen zu vergleichen – so liefert eine Suche nach „beste Essenslokale“ auch Ergebnisse zu „top-bewertete Restaurants“, selbst wenn keine exakten Wortüberschneidungen vorliegen.

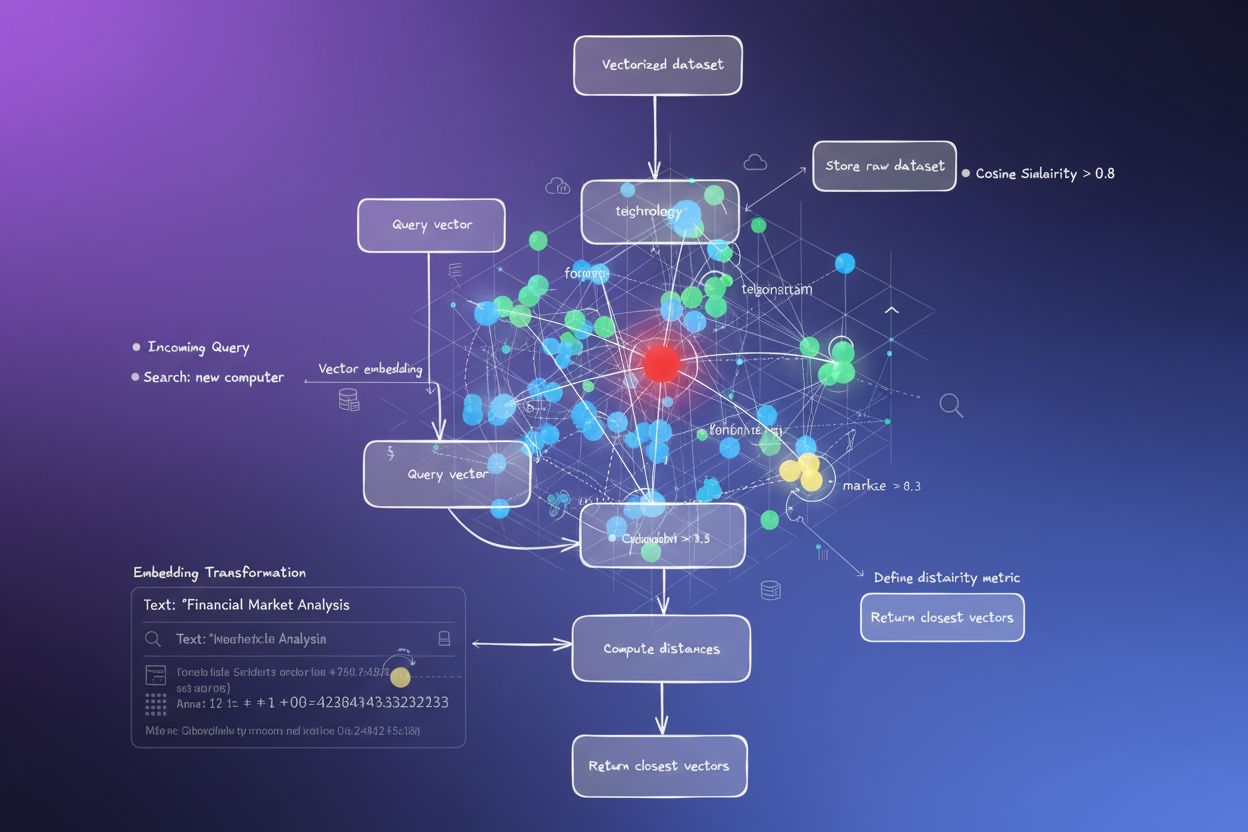

Der Prozess der Umwandlung von Daten in Vektoren wird Embedding genannt und von Machine-Learning-Modellen durchgeführt, die auf großen Datensätzen trainiert wurden. Diese Modelle lernen, ähnliche Konzepte an nahe beieinanderliegende Orte im Vektorraum abzubilden, indem sie Milliarden von Beispielen ausgesetzt werden. Gängige Embedding-Modelle sind Word2Vec, das Wortbeziehungen aus dem Kontext lernt, BERT (Bidirectional Encoder Representations from Transformers), das kontextuelle Bedeutung erfasst, und CLIP (Contrastive Language-Image Pre-training), das multimodale Daten verarbeitet. Die resultierenden Embeddings umfassen typischerweise 100 bis über 1.000 Dimensionen und schaffen eine reichhaltige mathematische Darstellung semantischer Beziehungen. Führt ein Nutzer eine Suche durch, wird seine Anfrage mit demselben Embedding-Modell in einen Vektor umgewandelt, und das System berechnet dann die Distanzen zwischen diesem Anfragevektor und allen gespeicherten Vektoren, um die ähnlichsten Elemente zu identifizieren.

Die Vektorsuche stützt sich auf Distanzmetriken, um die Ähnlichkeit zweier Vektoren zu quantifizieren. Die drei wichtigsten Metriken sind Kosinusähnlichkeit, euklidische Distanz und Skalarprodukt-Ähnlichkeit, jede mit eigenen mathematischen Eigenschaften und Einsatzgebieten. Kosinusähnlichkeit misst den Winkel zwischen zwei Vektoren und reicht von -1 bis 1, wobei 1 identische Richtung (maximale Ähnlichkeit) und 0 orthogonale Vektoren (keine Beziehung) bedeutet. Diese Metrik ist besonders wertvoll für NLP-Anwendungen, weil sie sich auf die semantische Richtung unabhängig vom Vektorbetrag konzentriert und sich daher ideal zum Vergleich von Dokumenten unterschiedlicher Länge eignet. Euklidische Distanz berechnet die Luftlinie zwischen Vektoren im mehrdimensionalen Raum und bezieht sowohl Betrag als auch Richtung mit ein. Diese Metrik ist empfindlich gegenüber dem Maßstab und eignet sich, wenn der Betrag der Vektoren eine bedeutungsvolle Information trägt, etwa in Empfehlungssystemen, bei denen Kaufhäufigkeiten zählen.

Skalarprodukt-Ähnlichkeit verbindet Aspekte beider Metriken, berücksichtigt Betrag und Richtung und bietet gleichzeitig eine hohe Recheneffizienz. Viele große Sprachmodelle verwenden das Skalarprodukt für das Training, weshalb diese Metrik dort die richtige Wahl ist. Die Auswahl der korrekten Distanzmetrik ist entscheidend – Studien zeigen, dass die Nutzung der Metrik, mit der das Embedding-Modell trainiert wurde, zu optimalen Ergebnissen führt. So wurde etwa das all-MiniLM-L6-v2-Modell mit Kosinusähnlichkeit trainiert, weshalb die Verwendung der Kosinusähnlichkeit im Index die genauesten Resultate liefert. Organisationen, die Vektorsuche implementieren, müssen ihre gewählte Metrik sorgfältig an ihr Embedding-Modell und ihren Anwendungsfall anpassen, um sowohl Genauigkeit als auch Performance sicherzustellen.

| Aspekt | Vektorsuche | Stichwortsuche | Hybride Suche |

|---|---|---|---|

| Matching-Methode | Semantische Ähnlichkeit basierend auf Bedeutung | Exakte Wort- oder Phrasenübereinstimmung | Kombiniert semantische und Stichwortübereinstimmung |

| Verständnis der Anfrage | Versteht Absicht und Kontext | Benötigt exakte Stichwörter | Nutzt beide Ansätze für umfassende Ergebnisse |

| Umgang mit Synonymen | Findet automatisch Synonyme und verwandte Begriffe | Verpasst Synonyme, sofern nicht explizit indexiert | Erfasst Synonyme durch beide Methoden |

| Leistung bei vagen Anfragen | Hervorragend – versteht Absichten | Schwach – benötigt präzise Stichwörter | Sehr gut – deckt beide Interpretationen ab |

| Rechenaufwand | Höher – benötigt Embedding und Ähnlichkeitsberechnung | Geringer – einfache Zeichenfolgenabgleiche | Mittel – führt beide Suchen parallel aus |

| Skalierbarkeit | Erfordert spezialisierte Vektordatenbanken | Funktioniert mit traditionellen Datenbanken | Setzt hybride-fähige Systeme voraus |

| Anwendungsfälle | Semantische Suche, Empfehlungen, RAG, Anomalieerkennung | Exakte Phrasensuche, strukturierte Daten | Enterprisesuche, KI-Monitoring, Marken-Tracking |

| Beispiel | Suche nach „gesunde Abendessen-Ideen“ findet „nahrhafte Meal-Prep“ | Findet nur Treffer mit den exakten Worten „gesund“ und „Abendessen“ | Findet sowohl exakte Treffer als auch semantisch verwandte Inhalte |

Die Implementierung der Vektorsuche umfasst mehrere miteinander verbundene Schritte, die Rohdaten in durchsuchbare semantische Repräsentationen verwandeln. Der erste Schritt ist die Datenaufnahme und Vorverarbeitung, bei der Rohdokumente, Bilder oder andere Daten bereinigt und normalisiert werden. Anschließend folgt die Vektortransformation, wobei ein Embedding-Modell jedes Datenelement in einen numerischen Vektor – typischerweise mit 100 bis über 1.000 Dimensionen – umwandelt. Diese Vektoren werden dann in einer Vektordatenbank oder einer für hochdimensionale Daten optimierten Indexstruktur gespeichert. Kommt eine Suchanfrage, wird diese ebenfalls mit dem Embedding-Modell in einen Anfragevektor umgewandelt. Das System berechnet danach mittels Distanzmetriken die Ähnlichkeitswerte zwischen Anfragevektor und allen gespeicherten Vektoren und sortiert die Ergebnisse nach ihrer Nähe zur Anfrage.

Um diesen Prozess im großen Maßstab effizient zu gestalten, setzen Systeme auf Approximate Nearest Neighbor (ANN)-Algorithmen wie HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) oder ScaNN (Scalable Nearest Neighbors). Diese Algorithmen tauschen perfekte Genauigkeit gegen Geschwindigkeit ein und ermöglichen Suchen über Millionen oder Milliarden Vektoren in Millisekunden statt Sekunden. HNSW beispielsweise organisiert Vektoren in einer mehrschichtigen Graphstruktur, in der die oberen Ebenen über weitreichende Verbindungen für schnelle Traversierung und die unteren Ebenen über präzise, kurzreichweitige Verbindungen verfügen. Dieser hierarchische Ansatz reduziert die Suchkomplexität von linear O(n) auf logarithmisch O(log n) und macht großskalige Vektorsuche praktikabel. Die Wahl des Algorithmus hängt von Faktoren wie Datensatzgröße, Anfragevolumen, Latenzanforderungen und verfügbaren Rechenressourcen ab.

Vektorsuche ist für KI-Monitoring-Plattformen wie AmICited unerlässlich geworden, die Marken-Erwähnungen über KI-Systeme hinweg verfolgen. Herkömmliches, stichwortbasiertes Monitoring würde umformulierte Erwähnungen, kontextuelle Bezüge und semantische Variationen von Markennamen oder Domain-URLs übersehen. Vektorsuche ermöglicht es diesen Plattformen, zu erkennen, wann Ihre Marke in KI-generierten Antworten erwähnt wird – auch wenn die genaue Wortwahl abweicht. Hat Ihre Domain beispielsweise „amicited.com“, erkennt die Vektorsuche auch Erwähnungen wie „KI-Prompt-Monitoring-Plattform“ oder „Markensichtbarkeit in generativer KI“ als kontextuell zu Ihrem Unternehmen gehörig, selbst ohne explizite URL-Nennung. Dieses semantische Verständnis ist entscheidend für umfassendes KI-Zitattracking über ChatGPT, Perplexity, Google AI Overviews und Claude hinweg.

Der Markt für Vektorsuchtechnologie wächst rasant, was die Wertschätzung in Unternehmen widerspiegelt. Laut Marktforschung lag der Markt für Vektordatenbanken 2024 bei 1,97 Milliarden US-Dollar und soll bis 2032 auf 10,60 Milliarden US-Dollar ansteigen, was einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 23,38 % entspricht. Databricks meldete zudem ein Wachstum der Vektordatenbank-Adoption um 186 % allein im ersten Jahr nach dem Public Preview der Vektorsuche im Dezember 2023. Diese schnelle Verbreitung zeigt, dass Unternehmen die Vektorsuche zunehmend als kritische Infrastruktur für KI-Anwendungen betrachten. Für Organisationen, die ihre Präsenz in KI-Systemen überwachen, liefert die Vektorsuche das semantische Verständnis, um alle relevanten Erwähnungen zu erfassen – nicht nur exakte Stichworttreffer.

Die Performance der Vektorsuche im großen Maßstab hängt entscheidend von ausgefeilten Indizierungstechniken ab, die Geschwindigkeit, Genauigkeit und Speicherbedarf in Einklang bringen. HNSW (Hierarchical Navigable Small World) hat sich dabei als eine der populärsten Methoden etabliert. Es organisiert Vektoren in einem mehrschichtigen Graphen, wobei jede Ebene zunehmend kurzreichweitige Verbindungen enthält. Die Suche startet auf der obersten Ebene mit weitreichenden Verbindungen für schnelle Traversierung und steigt über Ebenen mit immer präziseren Verbindungen hinab. Studien zeigen, dass HNSW eine Spitzenleistung mit Recall-Raten von über 99 % bei gleichzeitigen Abfrage-Latenzen unter einer Millisekunde erreicht. Allerdings benötigt HNSW viel Speicher – Benchmarks zeigen, dass das Indizieren von 1 Million Vektoren je nach Parametern 0,5 GB bis 5 GB beanspruchen kann, was Speicheroptimierung für den großskaligen Einsatz wichtig macht.

IVF (Inverted File Index) bietet einen alternativen Ansatz, indem Vektoren geclustert und nach Cluster-Zentroiden indexiert werden. Diese Technik reduziert den Suchraum, indem sie sich auf relevante Cluster konzentriert, statt alle Vektoren zu durchsuchen. ScaNN (Scalable Nearest Neighbors) von Google Research ist speziell für die Innere-Produkt-Suche optimiert und liefert hervorragende Leistungen in Empfehlungssystemen. Product Quantization (PQ) komprimiert Vektoren, indem sie in Subvektoren aufgeteilt und jeweils unabhängig quantisiert werden, wodurch der Speicherbedarf um das 10- bis 100-Fache reduziert werden kann – auf Kosten eines gewissen Genauigkeitsverlustes. Organisationen, die Vektorsuche implementieren, müssen Indizierungstechniken sorgfältig nach ihren spezifischen Anforderungen auswählen – je nachdem, ob Priorität auf Recall-Genauigkeit, Suchgeschwindigkeit, Speichereffizienz oder einer Kombination daraus liegt. Das Feld entwickelt sich rasant weiter, und es entstehen regelmäßig neue Algorithmen und Optimierungstechniken, um die rechnerischen Herausforderungen hochdimensionaler Vektoroperationen zu bewältigen.

Die Definition und Anwendung der Vektorsuche entwickelt sich weiter, da KI-Systeme immer ausgefeilter werden und die Akzeptanz in Unternehmen zunimmt. Die Zukunft weist auf hybride Suchsysteme hin, die Vektorsuche mit traditioneller Stichwortsuche und erweiterten Filtermöglichkeiten kombinieren. Solche hybriden Ansätze nutzen das semantische Verständnis der Vektorsuche, behalten aber die Präzision und Vertrautheit der Stichwortsuche bei und liefern so überlegene Ergebnisse für komplexe Anfragen. Darüber hinaus gewinnt die multimodale Vektorsuche an Bedeutung, bei der Systeme gleichzeitig über Text, Bilder, Audio und Video in einheitlichen Embedding-Räumen suchen können. Diese Entwicklung ermöglicht intuitivere und umfassendere Sucherlebnisse über verschiedene Datentypen hinweg.

Für Organisationen, die ihre Präsenz in KI-Systemen überwachen, hat die Weiterentwicklung der Vektorsuche tiefgreifende Auswirkungen. Da Plattformen wie ChatGPT, Perplexity, Google AI Overviews und Claude zunehmend auf Vektorsuche zur Inhaltsabfrage und -bewertung setzen, wird es ebenso wichtig zu verstehen, wie Ihre Marke semantisch erscheint, wie die traditionelle Sichtbarkeit über Stichwörter. Der Wandel hin zur semantischen Erfassung bedeutet, dass Marken-Monitoring und KI-Zitattracking über die bloße Stichworterkennung hinausgehen müssen, um auch kontextuelle Erwähnungen und semantische Beziehungen zu erfassen. Organisationen, die sich mit der Vektorsuche und ihren Anwendungen auseinandersetzen, sind besser positioniert, um ihre Sichtbarkeit in generativen KI-Systemen zu optimieren. Die Konvergenz von Vektorsuchtechnologie und KI-Monitoring-Plattformen markiert einen grundlegenden Wandel darin, wie Marken ihre Präsenz in der KI-gesteuerten Informationslandschaft verstehen und steuern.

Die traditionelle Stichwortsuche sucht nach exakten Wortübereinstimmungen in Dokumenten, während die Vektorsuche semantische Bedeutung und Kontext versteht. Vektorsuche wandelt Text in numerische Repräsentationen, sogenannte Embeddings, um und kann so relevante Ergebnisse finden, auch wenn die exakten Stichwörter nicht übereinstimmen. Beispielsweise liefert eine Suche nach 'kabellosen Kopfhörern' mit Vektorsuche auch Ergebnisse für 'Bluetooth-Ohrhörer', da diese eine ähnliche semantische Bedeutung teilen, während die Stichwortsuche diese Verbindung übersehen würde.

Vektorembeddings sind numerische Repräsentationen von Daten (Text, Bilder, Audio), die in Zahlenreihen umgewandelt werden und semantische Bedeutung erfassen. Sie werden mithilfe von Machine-Learning-Modellen wie Word2Vec, BERT oder transformerbasierten Modellen erzeugt, die lernen, ähnliche Konzepte im hochdimensionalen Raum nahe beieinander abzubilden. Zum Beispiel würden die Wörter 'König' und 'Königin' Embeddings haben, die nah beieinander liegen, weil sie semantische Beziehungen teilen, während 'König' und 'Banane' weit auseinander liegen würden.

Die drei wichtigsten Distanzmetriken sind Kosinusähnlichkeit (misst den Winkel zwischen Vektoren), euklidische Distanz (misst die Luftlinie zwischen Vektoren) und Skalarprodukt-Ähnlichkeit (berücksichtigt sowohl Betrag als auch Richtung). Die Kosinusähnlichkeit ist bei NLP-Anwendungen am gebräuchlichsten, da sie sich auf die semantische Richtung unabhängig vom Betrag konzentriert. Die Wahl der Metrik sollte mit der beim Training des Embedding-Modells verwendeten übereinstimmen, um optimale Genauigkeit zu gewährleisten.

Die Vektorsuche ermöglicht es KI-Monitoring-Plattformen wie AmICited, Marken-Erwähnungen über KI-Systeme (ChatGPT, Perplexity, Google AI Overviews, Claude) hinweg zu verfolgen, indem sie semantischen Kontext statt exakter Stichwortübereinstimmungen versteht. Dadurch können auch umformulierte Erwähnungen, verwandte Konzepte und kontextuelle Bezüge zu Ihrer Marke erkannt werden, was eine umfassende Sichtbarkeit darüber bietet, wie Ihre Domain in KI-generierten Antworten auf verschiedenen Plattformen erscheint.

ANN-Algorithmen wie HNSW (Hierarchical Navigable Small World) ermöglichen schnelle Ähnlichkeitssuchen über Millionen von Vektoren, indem sie ungefähre statt exakte nächste Nachbarn finden. Sie nutzen hierarchische Graphstrukturen, um die Suchkomplexität von linear auf logarithmisch zu reduzieren und machen so die Vektorsuche für groß angelegte Anwendungen praktikabel. HNSW organisiert Vektoren in mehrschichtigen Graphen, wobei auf höheren Ebenen weiterreichende Verbindungen für schnellere Traversierung bestehen.

Unternehmen generieren riesige Mengen unstrukturierter Daten (E-Mails, Dokumente, Support-Tickets), die mit herkömmlicher Stichwortsuche schwer zu organisieren sind. Vektorsuche ermöglicht ein semantisches Verständnis dieser Daten und treibt Anwendungen wie intelligente Suche, Empfehlungssysteme, Anomalieerkennung und Retrieval-Augmented Generation (RAG) an. Laut Marktforschung soll der Markt für Vektordatenbanken von 2,65 Milliarden US-Dollar im Jahr 2025 auf 8,95 Milliarden US-Dollar bis 2030 wachsen, was die Akzeptanz in Unternehmen widerspiegelt.

Vektordatenbanken sind spezialisierte Systeme, die für die Speicherung, Indizierung und Abfrage hochdimensionaler Vektordaten optimiert sind. Sie implementieren effiziente Indizierungstechniken wie HNSW, IVF (Inverted File Index) und ScaNN, um schnelle Ähnlichkeitssuchen im großen Maßstab zu ermöglichen. Beispiele sind Milvus, Pinecone, Weaviate und Zilliz Cloud. Diese Datenbanken bewältigen die rechnerische Komplexität von Vektoroperationen, sodass Unternehmen produktionsreife semantische Such- und KI-Anwendungen ohne Infrastrukturaufwand entwickeln können.

Beginnen Sie zu verfolgen, wie KI-Chatbots Ihre Marke auf ChatGPT, Perplexity und anderen Plattformen erwähnen. Erhalten Sie umsetzbare Erkenntnisse zur Verbesserung Ihrer KI-Präsenz.

Erfahren Sie, wie die Vektorensuche maschinelle Lern-Einbettungen nutzt, um ähnliche Elemente anhand von Bedeutung statt exakter Schlüsselwörter zu finden. Vers...

Semantische Suche interpretiert die Bedeutung und den Kontext von Anfragen mithilfe von NLP und maschinellem Lernen. Erfahren Sie, wie sie sich von der Schlüsse...

Erfahren Sie, wie die semantische Suche mithilfe von KI die Benutzerabsicht und den Kontext versteht. Entdecken Sie die Unterschiede zur Schlüsselwortsuche und ...