¿A qué rastreadores de IA debo permitir el acceso? Guía completa para 2025

Descubre qué rastreadores de IA permitir o bloquear en tu robots.txt. Guía completa que cubre GPTBot, ClaudeBot, PerplexityBot y más de 25 rastreadores de IA co...

Guía de referencia completa de rastreadores y bots de IA. Identifica GPTBot, ClaudeBot, Google-Extended y más de 20 rastreadores de IA con user agents, tasas de rastreo y estrategias de bloqueo.

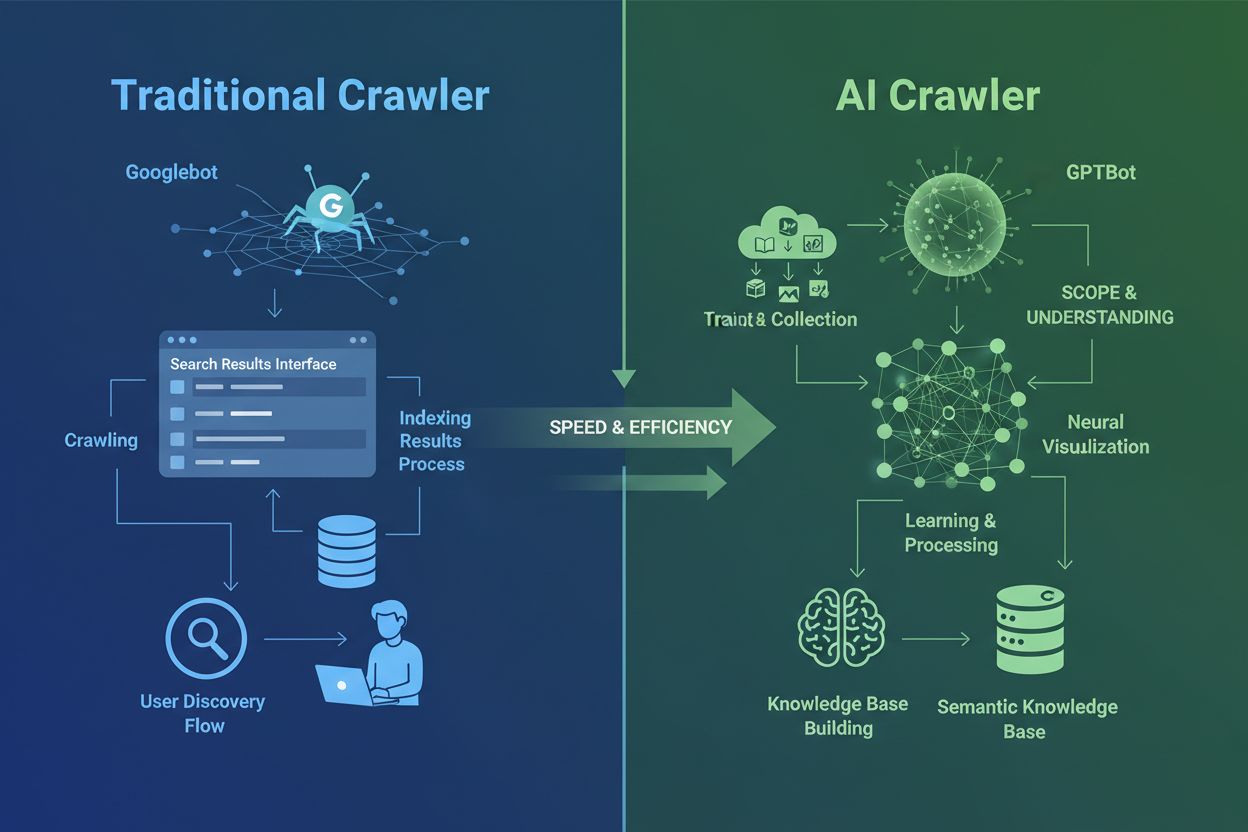

Los rastreadores de IA son fundamentalmente diferentes de los rastreadores de motores de búsqueda tradicionales que has conocido durante décadas. Mientras que Googlebot y Bingbot indexan contenido para ayudar a los usuarios a encontrar información mediante resultados de búsqueda, los rastreadores de IA como GPTBot y ClaudeBot recopilan datos específicamente para entrenar grandes modelos de lenguaje. Esta distinción es crucial: los rastreadores tradicionales crean caminos para el descubrimiento humano, mientras que los rastreadores de IA alimentan las bases de conocimiento de los sistemas de inteligencia artificial. Según datos recientes, los rastreadores de IA ahora representan casi el 80% de todo el tráfico de bots hacia los sitios web, con rastreadores de entrenamiento consumiendo grandes cantidades de contenido y enviando un tráfico de referencia mínimo a los editores. A diferencia de los rastreadores tradicionales que tienen dificultades con sitios dinámicos cargados de JavaScript, los rastreadores de IA utilizan aprendizaje automático avanzado para comprender el contenido de forma contextual, como lo haría un lector humano. Pueden interpretar significado, tono y propósito sin necesidad de actualizaciones manuales de configuración. Esto representa un salto cuántico en la tecnología de indexación web que requiere que los propietarios de sitios web replanteen por completo sus estrategias de gestión de rastreadores.

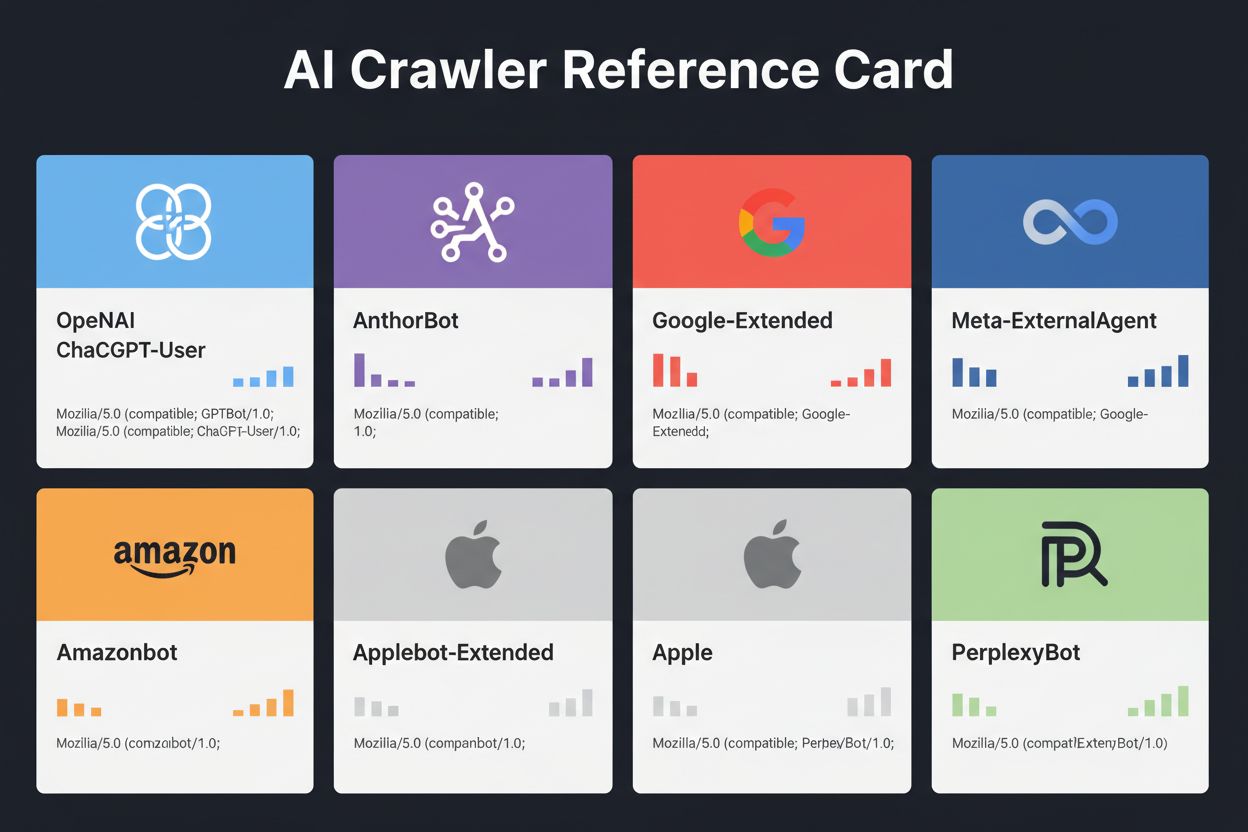

El panorama de los rastreadores de IA se ha vuelto cada vez más concurrido a medida que las grandes empresas tecnológicas compiten por construir sus propios grandes modelos de lenguaje. OpenAI, Anthropic, Google, Meta, Amazon, Apple y Perplexity tienen cada uno múltiples rastreadores especializados, que cumplen funciones distintas dentro de sus respectivos ecosistemas de IA. Las empresas despliegan varios rastreadores porque diferentes propósitos requieren diferentes comportamientos: algunos rastreadores se enfocan en la recolección masiva de datos de entrenamiento, otros manejan la indexación de búsqueda en tiempo real y otros obtienen contenido bajo demanda cuando los usuarios lo solicitan. Comprender este ecosistema requiere reconocer tres categorías principales de rastreadores: rastreadores de entrenamiento que recopilan datos para mejorar modelos, rastreadores de búsqueda y citación que indexan contenido para experiencias de búsqueda impulsadas por IA, y fetchers activados por el usuario que se activan cuando los usuarios solicitan contenido a través de asistentes de IA. La siguiente tabla ofrece una visión general rápida de los actores principales:

| Empresa | Nombre del rastreador | Propósito principal | Tasa de rastreo | Datos de entrenamiento |

|---|---|---|---|---|

| OpenAI | GPTBot | Entrenamiento de modelos | 100 páginas/hora | Sí |

| OpenAI | ChatGPT-User | Solicitudes de usuarios en tiempo real | 2400 páginas/hora | No |

| OpenAI | OAI-SearchBot | Indexación de búsqueda | 150 páginas/hora | No |

| Anthropic | ClaudeBot | Entrenamiento de modelos | 500 páginas/hora | Sí |

| Anthropic | Claude-User | Acceso web en tiempo real | <10 páginas/hora | No |

| Google-Extended | Entrenamiento de Gemini AI | Variable | Sí | |

| Gemini-Deep-Research | Función de investigación | <10 páginas/hora | No | |

| Meta | Meta-ExternalAgent | Entrenamiento de modelos de IA | 1100 páginas/hora | Sí |

| Amazon | Amazonbot | Mejora de servicios | 1050 páginas/hora | Sí |

| Perplexity | PerplexityBot | Indexación de búsqueda | 150 páginas/hora | No |

| Apple | Applebot-Extended | Entrenamiento de IA | <10 páginas/hora | Sí |

| Common Crawl | CCBot | Conjunto de datos abierto | <10 páginas/hora | Sí |

OpenAI opera tres rastreadores distintos, cada uno con funciones específicas en el ecosistema de ChatGPT. Entender estos rastreadores es esencial porque GPTBot de OpenAI es uno de los rastreadores de IA más agresivos y ampliamente desplegados en internet:

GPTBot - El rastreador principal de entrenamiento de OpenAI que recopila sistemáticamente datos públicos para entrenar y mejorar los modelos GPT, incluyendo ChatGPT y GPT-4o. Este rastreador opera a aproximadamente 100 páginas por hora y respeta las directivas de robots.txt. OpenAI publica direcciones IP oficiales en https://openai.com/gptbot.json para fines de verificación.

ChatGPT-User - Este rastreador aparece cuando un usuario real interactúa con ChatGPT y le solicita que navegue por una página web específica. Opera a tasas mucho más altas (hasta 2400 páginas/hora) porque es activado por acciones de usuarios en vez de rastreo sistemático. El contenido accedido por ChatGPT-User no se usa para entrenamiento de modelos, siendo valioso para la visibilidad en tiempo real en los resultados de búsqueda de ChatGPT.

OAI-SearchBot - Diseñado específicamente para la funcionalidad de búsqueda de ChatGPT, este rastreador indexa contenido para resultados de búsqueda en tiempo real sin recolectar datos de entrenamiento. Opera a aproximadamente 150 páginas por hora y ayuda a que tu contenido aparezca en resultados de búsqueda de ChatGPT cuando los usuarios hacen preguntas relevantes.

Los rastreadores de OpenAI respetan las directivas de robots.txt y operan desde rangos de IP verificados, lo que los hace relativamente sencillos de gestionar en comparación con competidores menos transparentes.

Anthropic, la empresa detrás de Claude AI, opera múltiples rastreadores con diferentes propósitos y niveles de transparencia. La empresa ha sido menos abierta con la documentación comparada con OpenAI, pero el comportamiento de sus rastreadores está bien documentado mediante análisis de registros de servidores:

ClaudeBot - El principal rastreador de entrenamiento de Anthropic que recopila contenido web para mejorar la base de conocimiento y capacidades de Claude. Este rastreador opera a aproximadamente 500 páginas por hora y es el objetivo principal si deseas evitar que tu contenido se utilice para el entrenamiento del modelo de Claude. La cadena completa de user agent es Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com).

Claude-User - Se activa cuando los usuarios de Claude solicitan acceso web en tiempo real, este rastreador obtiene contenido bajo demanda con volumen mínimo. Respeta la autenticación y no intenta eludir restricciones de acceso, siendo relativamente benigno en cuanto a recursos.

Claude-SearchBot - Soporta las capacidades de búsqueda interna de Claude, ayudando a que tu contenido aparezca en los resultados de búsqueda de Claude cuando los usuarios hacen preguntas. Este rastreador opera a volúmenes muy bajos y sirve principalmente para indexación, no para entrenamiento.

Una preocupación crítica con los rastreadores de Anthropic es la proporción de rastreo a referencia: datos de Cloudflare indican que por cada referencia que Anthropic envía de regreso a un sitio web, sus rastreadores ya han visitado aproximadamente entre 38,000 y 70,000 páginas. Este enorme desequilibrio significa que tu contenido se consume mucho más agresivamente de lo que se cita, planteando preguntas importantes sobre la compensación justa por el uso del contenido.

El enfoque de Google para el rastreo de IA difiere significativamente de sus competidores porque la empresa mantiene una separación estricta entre la indexación de búsqueda y el entrenamiento de IA. Google-Extended es el rastreador específico responsable de recopilar datos para entrenar Gemini (antes Bard) y otros productos de IA de Google, completamente separado del Googlebot tradicional:

La cadena de user agent para Google-Extended es: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0. Esta separación es intencional y beneficiosa para los propietarios de sitios web porque puedes bloquear Google-Extended mediante robots.txt sin afectar tu visibilidad en Google Search en absoluto. Google afirma oficialmente que bloquear Google-Extended no tiene impacto en el ranking de búsqueda ni en la inclusión en AI Overviews, aunque algunos webmasters han reportado preocupaciones que vale la pena monitorear. Gemini-Deep-Research es otro rastreador de Google que soporta la función de investigación de Gemini, operando a volúmenes muy bajos y con mínimo impacto en los recursos del servidor. Una ventaja técnica significativa de los rastreadores de Google es su capacidad para ejecutar JavaScript y renderizar contenido dinámico, a diferencia de la mayoría de los competidores. Esto significa que Google-Extended puede rastrear aplicaciones React, Vue y Angular de manera efectiva, mientras que GPTBot de OpenAI y ClaudeBot de Anthropic no pueden. Para propietarios de sitios con aplicaciones pesadas en JavaScript, esta distinción es muy relevante para la visibilidad en IA.

Más allá de los gigantes tecnológicos, numerosas organizaciones operan rastreadores de IA que merecen atención. Meta-ExternalAgent, lanzado discretamente en julio de 2024, recopila contenido web para entrenar los modelos de IA de Meta y mejorar productos en Facebook, Instagram y WhatsApp. Este rastreador opera a aproximadamente 1100 páginas por hora y ha recibido menos atención pública que sus competidores a pesar de su comportamiento agresivo. Bytespider, operado por ByteDance (empresa matriz de TikTok), ha surgido como uno de los rastreadores más agresivos en internet desde su lanzamiento en abril de 2024. Monitoreos de terceros sugieren que Bytespider rastrea mucho más agresivamente que GPTBot o ClaudeBot, aunque los multiplicadores exactos varían. Algunos reportes indican que puede no respetar consistentemente las directivas de robots.txt, por lo que el bloqueo basado en IP es más confiable.

Los rastreadores de Perplexity incluyen PerplexityBot para indexación de búsqueda y Perplexity-User para obtención de contenido en tiempo real. Perplexity ha enfrentado reportes anecdóticos de ignorar las directivas de robots.txt, aunque la empresa afirma cumplirlas. Amazonbot potencia las capacidades de respuesta de Alexa y respeta el protocolo robots.txt, operando a aproximadamente 1050 páginas por hora. Applebot-Extended, introducido en junio de 2024, determina cómo se usará el contenido ya indexado por Applebot para el entrenamiento de IA de Apple, aunque no rastrea páginas web directamente. CCBot, operado por Common Crawl (una organización sin fines de lucro), construye archivos abiertos de la web utilizados por múltiples empresas de IA incluyendo OpenAI, Google, Meta y Hugging Face. Rastreadores emergentes de empresas como xAI (Grok), Mistral y DeepSeek están comenzando a aparecer en los registros del servidor, señalando una expansión continua del ecosistema de rastreadores de IA.

A continuación se muestra una tabla completa de referencia de rastreadores de IA verificados, sus propósitos, cadenas de user agent y sintaxis de bloqueo en robots.txt. Esta tabla se actualiza regularmente con base en análisis de registros del servidor y documentación oficial. Cada entrada ha sido verificada contra listas oficiales de IP cuando están disponibles:

| Nombre del rastreador | Empresa | Propósito | User Agent | Tasa de rastreo | Verificación IP | Sintaxis robots.txt |

|---|---|---|---|---|---|---|

| GPTBot | OpenAI | Recolección de datos de entrenamiento | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot) | 100/h | ✓ Oficial | User-agent: GPTBot Disallow: / |

| ChatGPT-User | OpenAI | Solicitudes de usuarios en tiempo real | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0 | 2400/h | ✓ Oficial | User-agent: ChatGPT-User Disallow: / |

| OAI-SearchBot | OpenAI | Indexación de búsqueda | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36; compatible; OAI-SearchBot/1.3 | 150/h | ✓ Oficial | User-agent: OAI-SearchBot Disallow: / |

| ClaudeBot | Anthropic | Recolección de datos de entrenamiento | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com) | 500/h | ✓ Oficial | User-agent: ClaudeBot Disallow: / |

| Claude-User | Anthropic | Acceso web en tiempo real | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-User/1.0) | <10/h | ✗ No disponible | User-agent: Claude-User Disallow: / |

| Claude-SearchBot | Anthropic | Indexación de búsqueda | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-SearchBot/1.0) | <10/h | ✗ No disponible | User-agent: Claude-SearchBot Disallow: / |

| Google-Extended | Entrenamiento de Gemini AI | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0) | Variable | ✓ Oficial | User-agent: Google-Extended Disallow: / | |

| Gemini-Deep-Research | Función de investigación | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Gemini-Deep-Research) | <10/h | ✓ Oficial | User-agent: Gemini-Deep-Research Disallow: / | |

| Bingbot | Microsoft | Búsqueda Bing & Copilot | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; bingbot/2.0) | 1300/h | ✓ Oficial | User-agent: Bingbot Disallow: / |

| Meta-ExternalAgent | Meta | Entrenamiento de modelos de IA | meta-externalagent/1.1 (+https://developers.facebook.com/docs/sharing/webmasters/crawler) | 1100/h | ✗ No disponible | User-agent: Meta-ExternalAgent Disallow: / |

| Amazonbot | Amazon | Mejora de servicios | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Amazonbot/0.1) | 1050/h | ✓ Oficial | User-agent: Amazonbot Disallow: / |

| Applebot-Extended | Apple | Entrenamiento de IA | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15; compatible; Applebot-Extended | <10/h | ✓ Oficial | User-agent: Applebot-Extended Disallow: / |

| PerplexityBot | Perplexity | Indexación de búsqueda | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0) | 150/h | ✓ Oficial | User-agent: PerplexityBot Disallow: / |

| Perplexity-User | Perplexity | Obtención en tiempo real | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Perplexity-User/1.0) | <10/h | ✓ Oficial | User-agent: Perplexity-User Disallow: / |

| Bytespider | ByteDance | Entrenamiento de IA | Mozilla/5.0 (Linux; Android 5.0) AppleWebKit/537.36; compatible; Bytespider | <10/h | ✗ No disponible | User-agent: Bytespider Disallow: / |

| CCBot | Common Crawl | Conjunto de datos abierto | CCBot/2.0 (https://commoncrawl.org/faq/ ) | <10/h | ✓ Oficial | User-agent: CCBot Disallow: / |

| DuckAssistBot | DuckDuckGo | Búsqueda de IA | DuckAssistBot/1.2; (+http://duckduckgo.com/duckassistbot.html) | 20/h | ✓ Oficial | User-agent: DuckAssistBot Disallow: / |

| Diffbot | Diffbot | Extracción de datos | Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.9.1.2) Gecko/20090729 Firefox/3.5.2 Diffbot/0.1 | <10/h | ✗ No disponible | User-agent: Diffbot Disallow: / |

| MistralAI-User | Mistral | Obtención en tiempo real | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; MistralAI-User/1.0) | <10/h | ✗ No disponible | User-agent: MistralAI-User Disallow: / |

| ICC-Crawler | NICT | Entrenamiento IA/ML | ICC-Crawler/3.0 (Mozilla-compatible; https://ucri.nict.go.jp/en/icccrawler.html ) | <10/h | ✗ No disponible | User-agent: ICC-Crawler Disallow: / |

No todos los rastreadores de IA cumplen el mismo propósito, y entender estas diferencias es fundamental para tomar decisiones informadas de bloqueo. Los rastreadores de entrenamiento representan aproximadamente el 80% de todo el tráfico de bots de IA y recopilan contenido específicamente para construir conjuntos de datos para el desarrollo de grandes modelos de lenguaje. Una vez que tu contenido entra en un conjunto de entrenamiento, se convierte en parte de la base de conocimiento permanente del modelo, potencialmente reduciendo la necesidad de los usuarios de visitar tu sitio para obtener respuestas. Rastreadores de entrenamiento como GPTBot, ClaudeBot y Meta-ExternalAgent operan con alto volumen y patrones sistemáticos de rastreo, devolviendo un tráfico de referencia mínimo o nulo a los editores.

Los rastreadores de búsqueda y citación indexan contenido para experiencias de búsqueda impulsadas por IA y pueden enviar algo de tráfico de regreso a los editores mediante citaciones. Cuando los usuarios hacen preguntas en ChatGPT o Perplexity, estos rastreadores ayudan a mostrar fuentes relevantes. A diferencia de los de entrenamiento, los rastreadores de búsqueda como OAI-SearchBot y PerplexityBot operan a un volumen moderado y con un comportamiento enfocado en la recuperación, e incluso pueden incluir atribución y enlaces. Los fetchers activados por el usuario se activan solo cuando los usuarios solicitan contenido mediante asistentes de IA. Cuando alguien pega una URL en ChatGPT o le pide a Perplexity que analice una página específica, estos fetchers obtienen el contenido bajo demanda. Los fetchers activados por usuarios operan a volúmenes muy bajos con solicitudes puntuales, no rastreo automatizado sistemático, y la mayoría de las empresas de IA confirman que no se utilizan para entrenamiento de modelos. Comprender estas categorías te ayuda a tomar decisiones estratégicas sobre qué rastreadores permitir y cuáles bloquear según tus prioridades de negocio.

El primer paso para gestionar rastreadores de IA es comprender cuáles están realmente visitando tu sitio web. Tus registros de acceso del servidor contienen detalles de cada solicitud, incluido el user agent que identifica al rastreador. La mayoría de los paneles de control de hosting ofrecen herramientas de análisis de registros, pero también puedes acceder a los registros sin procesar directamente. En servidores Apache, los registros suelen estar en /var/log/apache2/access.log, mientras que en Nginx suelen estar en /var/log/nginx/access.log. Puedes filtrar estos registros usando grep para encontrar actividad de rastreadores:

grep -i "gptbot\|claudebot\|google-extended\|bytespider" /var/log/apache2/access.log | head -20

Este comando muestra las 20 solicitudes más recientes de los principales rastreadores de IA. Google Search Console proporciona estadísticas de rastreadores para los bots de Google, aunque solo muestra los de Google. Cloudflare Radar ofrece información global sobre patrones de tráfico de bots de IA y puede ayudar a identificar qué rastreadores están más activos. Para verificar si un rastreador es legítimo o suplantado, revisa la dirección IP de la solicitud contra listas oficiales publicadas por las principales compañías. OpenAI publica IPs verificadas en https://openai.com/gptbot.json, Amazon en https://developer.amazon.com/amazonbot/ip-addresses/, y otros mantienen listas similares. Un rastreador falso que suplanta un user agent legítimo desde una IP no verificada debe ser bloqueado de inmediato, ya que probablemente representa una actividad de scraping maliciosa.

El archivo robots.txt es tu herramienta principal para controlar el acceso de los rastreadores. Este simple archivo de texto, ubicado en el directorio raíz de tu sitio web, le indica a los rastreadores qué partes de tu sitio pueden acceder. Para bloquear rastreadores de IA específicos, agrega entradas como esta:

# Bloquear GPTBot de OpenAI

User-agent: GPTBot

Disallow: /

# Bloquear ClaudeBot de Anthropic

User-agent: ClaudeBot

Disallow: /

# Bloquear el entrenamiento de IA de Google (no búsqueda)

User-agent: Google-Extended

Disallow: /

# Bloquear Common Crawl

User-agent: CCBot

Disallow: /

También puedes permitir rastreadores pero establecer límites de velocidad para evitar sobrecargar el servidor:

User-agent: GPTBot

Crawl-delay: 10

Disallow: /private/

Esto le indica a GPTBot que espere 10 segundos entre solicitudes y que no acceda a tu directorio privado. Para un enfoque equilibrado que permita rastreadores de búsqueda mientras bloquea rastreadores de entrenamiento:

# Permitir motores de búsqueda tradicionales

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# Bloquear todos los rastreadores de entrenamiento de IA

User-agent: GPTBot

User-agent: ClaudeBot

User-agent: CCBot

User-agent: Google-Extended

User-agent: Bytespider

User-agent: Meta-ExternalAgent

Disallow: /

# Permitir rastreadores de búsqueda de IA

User-agent: OAI-SearchBot

Allow: /

User-agent: PerplexityBot

Allow: /

La mayoría de los rastreadores de IA reputados respetan las directivas de robots.txt, aunque algunos rastreadores agresivos las ignoran completamente. Por eso, robots.txt por sí solo es insuficiente para una protección completa.

Robots.txt es una sugerencia y no una obligación, lo que significa que los rastreadores pueden ignorar tus directivas si lo desean. Para una protección más fuerte contra rastreadores que no respetan robots.txt, implementa bloqueo basado en IP a nivel de servidor. Este enfoque es más fiable porque es más difícil suplantar una dirección IP que una cadena de user agent. Puedes permitir solo IPs verificadas de fuentes oficiales y bloquear todas las demás solicitudes que se hagan pasar por rastreadores de IA.

Para servidores Apache, usa reglas .htaccess para bloquear rastreadores a nivel de servidor:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (GPTBot|ClaudeBot|anthropic-ai|Bytespider|CCBot) [NC]

RewriteRule .* - [F,L]

</IfModule>

Esto devuelve una respuesta 403 Forbidden a los user agents coincidentes, sin importar la configuración de robots.txt. Las reglas de firewall ofrecen otra capa de protección permitiendo solo rangos de IP verificados de fuentes oficiales. La mayoría de los firewalls de aplicaciones web y proveedores de hosting permiten crear reglas que permitan solicitudes de IPs verificadas y bloqueen otras que se hagan pasar por rastreadores de IA. Las meta etiquetas HTML ofrecen control granular a nivel de página. Amazon y otros rastreadores respetan la directiva noarchive:

<meta name="robots" content="noarchive">

Esto le indica a los rastreadores que no usen la página para entrenamiento de modelos, aunque puede permitir otras actividades de indexación. Elige tu método de bloqueo según tus capacidades técnicas y los rastreadores específicos que quieras bloquear. El bloqueo basado en IP es el más fiable pero requiere una configuración más técnica, mientras que robots.txt es más fácil de implementar pero menos efectivo contra rastreadores no conformes.

Implementar bloqueos a rastreadores es solo la mitad de la solución; debes verificar que realmente funcionen. El monitoreo regular te ayuda a detectar problemas temprano e identificar nuevos rastreadores que no hayas visto antes. Revisa los registros de tu servidor semanalmente en busca de actividad inusual de bots, buscando cadenas de user agent que contengan “bot”, “crawler”, “spider” o nombres de empresas como “GPT”, “Claude” o “Perplexity”. Configura alertas para aumentos repentinos en tráfico de bots que puedan indicar nuevos rastreadores o comportamientos agresivos de los existentes. Google Search Console muestra estadísticas de rastreo para los bots de Google, ayudándote a monitorear la actividad de Googlebot y Google-Extended. Cloudflare Radar proporciona información global sobre patrones de tráfico de rastreadores de IA y puede ayudar a identificar rastreadores emergentes en tu sitio.

Para verificar que tus bloqueos robots.txt funcionan, accede a tu archivo robots.txt directamente en tusitio.com/robots.txt y confirma que todos los user agents y directivas aparecen correctamente. Para bloqueos a nivel de servidor, monitorea los registros de acceso en busca de solicitudes de rastreadores bloqueados. Si ves solicitudes de rastreadores que has bloqueado, es que están ignorando tus directivas o suplantando sus user agents. Prueba tus implementaciones revisando el acceso de rastreadores en tu analítica y registros del servidor. Revisiones trimestrales son esenciales porque el panorama de rastreadores de IA evoluciona rápidamente. Aparecen nuevos rastreadores regularmente, los existentes actualizan sus user agents y las empresas introducen nuevos bots sin aviso. Programa revisiones regulares de tu lista de bloqueo para detectar novedades y asegurar que tu implementación siga actualizada.

Mientras que gestionar el acceso de rastreadores es importante, entender cómo los sistemas de IA realmente citan y referencian tu contenido es igualmente fundamental. AmICited.com proporciona un monitoreo completo de cómo tu marca y contenido aparecen en respuestas generadas por IA a través de ChatGPT, Perplexity, Google Gemini y otras plataformas de IA. En lugar de solo bloquear rastreadores, AmICited.com te ayuda a entender el verdadero impacto de los rastreadores de IA en tu visibilidad y autoridad. La plataforma rastrea qué sistemas de IA citan tu contenido, con qué frecuencia aparece tu marca en respuestas de IA y cómo esa visibilidad se traduce en tráfico y autoridad. Al monitorear tus citaciones en IA, puedes tomar decisiones informadas sobre qué rastreadores permitir basadas en datos reales de visibilidad y no suposiciones. AmICited.com se integra con tu estrategia de contenido mostrando qué temas y tipos de contenido generan más citaciones de IA. Este enfoque basado en datos te ayuda a optimizar tu contenido para el descubrimiento en IA mientras proteges tu propiedad intelectual más valiosa. Entender tus métricas de citación en IA te permite tomar decisiones estratégicas sobre el acceso de rastreadores que se alineen con tus objetivos de negocio.

Decidir si permitir o bloquear rastreadores de IA depende completamente de tu situación y prioridades de negocio. Permite rastreadores de IA si: tienes un sitio de noticias o blog donde la visibilidad en respuestas de IA genera tráfico significativo, tu empresa se beneficia de ser citada como fuente en respuestas generadas por IA, deseas participar en el entrenamiento de IA para influir en cómo los modelos comprenden tu industria, o te sientes cómodo con que tu contenido sea usado para el desarrollo de IA. Los editores de noticias, creadores de contenido educativo y líderes de opinión suelen beneficiarse de la visibilidad en IA porque las citaciones generan tráfico y establecen autoridad.

Bloquea rastreadores de IA si: tienes contenido propietario o secretos comerciales que deseas proteger, tus recursos de servidor son limitados y no pueden soportar rastreo agresivo, te preocupa que tu contenido se use sin compensación, deseas mantener el control sobre cómo se utiliza tu propiedad intelectual, o has experimentado problemas de rendimiento por tráfico de bots. Sitios de comercio electrónico con información de productos, empresas SaaS con documentación propietaria y editores con contenido de pago suelen optar por bloquear rastreadores de entrenamiento. La clave está en equilibrar la protección del contenido y la visibilidad en plataformas de descubrimiento impulsadas por IA. Blo

Los rastreadores de IA como GPTBot y ClaudeBot recopilan contenido específicamente para entrenar grandes modelos de lenguaje, mientras que los rastreadores de motores de búsqueda como Googlebot indexan contenido para que las personas lo encuentren a través de los resultados de búsqueda. Los rastreadores de IA alimentan las bases de conocimiento de los sistemas de IA, mientras que los rastreadores de búsqueda ayudan a los usuarios a descubrir tu contenido. La diferencia clave es el propósito: entrenamiento versus recuperación.

No, bloquear rastreadores de IA no afectará tu posicionamiento tradicional en los motores de búsqueda. Los rastreadores de IA como GPTBot y ClaudeBot están completamente separados de los rastreadores de motores de búsqueda como Googlebot. Puedes bloquear Google-Extended (para entrenamiento de IA) y seguir permitiendo Googlebot (para búsqueda). Cada rastreador cumple un propósito diferente y bloquear uno no afecta al otro.

Revisa los registros de acceso de tu servidor para ver qué user agents están visitando tu sitio. Busca nombres de bots como GPTBot, ClaudeBot, CCBot y Bytespider en las cadenas de user agent. La mayoría de los paneles de control de hosting ofrecen herramientas de análisis de registros. También puedes usar Google Search Console para monitorear la actividad de rastreo, aunque solo muestra los rastreadores de Google.

No todos los rastreadores de IA respetan robots.txt de la misma manera. GPTBot de OpenAI, ClaudeBot de Anthropic y Google-Extended generalmente siguen las reglas de robots.txt. Bytespider y PerplexityBot han recibido reportes que sugieren que pueden no respetar consistentemente las directivas de robots.txt. Para rastreadores que no respetan robots.txt, deberás implementar bloqueos basados en IP a nivel de servidor mediante tu firewall o archivo .htaccess.

La decisión depende de tus objetivos. Bloquea los rastreadores de entrenamiento si tienes contenido propietario o recursos de servidor limitados. Permite los rastreadores de búsqueda si quieres visibilidad en resultados de búsqueda impulsados por IA y chatbots, que pueden generar tráfico y establecer autoridad. Muchas empresas adoptan un enfoque selectivo permitiendo ciertos rastreadores mientras bloquean los más agresivos como Bytespider.

Aparecen nuevos rastreadores de IA regularmente, por lo que revisa y actualiza tu lista de bloqueo al menos trimestralmente. Sigue recursos como el proyecto ai.robots.txt en GitHub para listas mantenidas por la comunidad. Revisa los registros del servidor mensualmente para identificar nuevos rastreadores que lleguen a tu sitio y no estén en tu configuración actual. El panorama de los rastreadores de IA evoluciona rápidamente y tu estrategia debe evolucionar junto a él.

Sí, revisa la dirección IP de la solicitud contra las listas oficiales publicadas por las principales compañías. OpenAI publica IPs verificadas en https://openai.com/gptbot.json, Amazon en https://developer.amazon.com/amazonbot/ip-addresses/, y otros mantienen listas similares. Un rastreador que suplanta un user agent legítimo desde una IP no verificada debe ser bloqueado de inmediato, ya que probablemente representa scraping malicioso.

Los rastreadores de IA pueden consumir un ancho de banda y recursos de servidor significativos. Bytespider y Meta-ExternalAgent están entre los rastreadores más agresivos. Algunos editores reportan reducir el consumo de ancho de banda de 800GB a 200GB diarios al bloquear rastreadores de IA, ahorrando aproximadamente $1,500 por mes. Monitorea tus recursos de servidor durante los picos de rastreo e implementa límites de velocidad para bots agresivos si es necesario.

Haz seguimiento de qué rastreadores de IA citan tu contenido y optimiza tu visibilidad en ChatGPT, Perplexity, Google Gemini y más.

Descubre qué rastreadores de IA permitir o bloquear en tu robots.txt. Guía completa que cubre GPTBot, ClaudeBot, PerplexityBot y más de 25 rastreadores de IA co...

Aprende cómo los rastreadores de búsqueda por IA determinan la frecuencia de rastreo de tu sitio web. Descubre cómo ChatGPT, Perplexity y otros motores de IA ra...

Comprende cómo funcionan los rastreadores de IA como GPTBot y ClaudeBot, sus diferencias con los rastreadores de búsqueda tradicionales y cómo optimizar tu siti...