Tasas de Conversión de Tráfico de IA: Por Qué la Calidad Supera a la Cantidad

Descubre por qué el tráfico de IA convierte 23 veces mejor que la búsqueda orgánica. Aprende a optimizar para plataformas de IA y medir el verdadero ROI de los ...

Descubre por qué la calidad de los datos importa más que la cantidad para los modelos de IA. Aprende estrategias de asignación de recursos, implicaciones de costes y marcos prácticos para optimizar tu inversión en datos de entrenamiento de IA.

La sabiduría convencional en aprendizaje automático ha sido durante mucho tiempo “más datos siempre es mejor”. Sin embargo, investigaciones recientes desafían esta suposición con pruebas convincentes de que la calidad de los datos supera significativamente la cantidad al determinar el rendimiento de los modelos de IA. Un estudio de arxiv de 2024 (2411.15821) que examinó pequeños modelos de lenguaje descubrió que la calidad de los datos de entrenamiento juega un papel mucho más importante que el simple volumen, revelando que la relación entre la cantidad de datos y la precisión del modelo es mucho más matizada de lo que se creía. Las implicaciones de coste son sustanciales: las organizaciones que invierten mucho en la recopilación de datos sin priorizar la calidad suelen desperdiciar recursos en almacenamiento, procesamiento y sobrecarga computacional, logrando rendimientos decrecientes en el desempeño del modelo.

La calidad de los datos no es un concepto monolítico sino un marco multidimensional que abarca varios aspectos críticos. Precisión se refiere a cuán correctamente los datos representan la realidad y si las etiquetas se asignan correctamente. Consistencia asegura que los datos sigan formatos y estándares uniformes en todo el conjunto. Integridad mide si toda la información necesaria está presente sin vacíos o valores faltantes significativos. Relevancia determina si los datos abordan directamente el problema que el modelo de IA está diseñado para resolver. Fiabilidad indica la confiabilidad de la fuente de datos y su estabilidad en el tiempo. Finalmente, el ruido representa variaciones no deseadas o errores que pueden confundir el entrenamiento del modelo. Comprender estas dimensiones ayuda a las organizaciones a priorizar estratégicamente sus esfuerzos de curación de datos.

| Dimensión de calidad | Definición | Impacto en IA |

|---|---|---|

| Precisión | Corrección de etiquetas y representación de datos | Afecta directamente la fiabilidad de las predicciones; datos mal etiquetados provocan errores sistemáticos |

| Consistencia | Formato uniforme y estructura de datos estandarizada | Permite un entrenamiento estable; las inconsistencias confunden los algoritmos de aprendizaje |

| Integridad | Presencia de toda la información necesaria sin vacíos | Valores faltantes reducen datos útiles para entrenamiento; afecta la generalización |

| Relevancia | Los datos abordan directamente el dominio del problema | Datos altamente relevantes superan grandes volúmenes de datos genéricos |

| Fiabilidad | Confiabilidad y estabilidad de las fuentes de datos | Fuentes no confiables introducen sesgos sistemáticos; afecta la robustez del modelo |

| Ruido | Variaciones no deseadas y errores de medición | Un ruido controlado mejora la robustez; el exceso de ruido degrada el rendimiento |

La búsqueda de la cantidad de datos sin salvaguardas de calidad genera una cascada de problemas que van mucho más allá de las métricas de rendimiento del modelo. La investigación de Rishabh Iyer demuestra que experimentos con ruido en las etiquetas revelan caídas drásticas de precisión: los datos mal etiquetados degradan activamente el rendimiento del modelo en lugar de proporcionar ejemplos neutrales. Más allá de la precisión, las organizaciones enfrentan crecientes costes de almacenamiento y procesamiento para conjuntos de datos que no mejoran los resultados del modelo, junto con costes medioambientales significativos por la sobrecarga computacional innecesaria. La imagen médica es un ejemplo real contundente: un conjunto de miles de radiografías mal etiquetadas puede entrenar un modelo que cometa errores diagnósticos peligrosos y confiados, poniendo en riesgo a los pacientes. La falsa economía de recopilar datos baratos y de baja calidad se hace evidente cuando se consideran los costes de reentrenamiento del modelo, depuración y fallos de despliegue causados por datos de entrenamiento deficientes.

La calidad específica del dominio supera consistentemente al volumen genérico en aplicaciones de IA prácticas. Considera un clasificador de sentimientos entrenado para reseñas de películas: un conjunto cuidadosamente curado de 10,000 reseñas de películas superará sustancialmente a un conjunto genérico de 100,000 ejemplos extraídos de noticias financieras, redes sociales y reseñas de productos. La relevancia de los datos de entrenamiento para el dominio del problema es mucho más importante que la escala, ya que los modelos aprenden patrones específicos de su distribución de entrenamiento. Cuando los datos carecen de relevancia para la aplicación objetivo, el modelo aprende correlaciones espurias y no logra generalizar a casos reales. Las organizaciones deben priorizar la recopilación de conjuntos de datos más pequeños que coincidan exactamente con su dominio de problema en lugar de acumular conjuntos masivos y genéricos que requieran extensos filtrados y preprocesamientos.

El enfoque óptimo de la estrategia de datos no está en ninguno de los extremos, sino en encontrar la “zona Goldilocks”, el punto ideal donde la cantidad y calidad de datos se equilibran para el problema específico. Muy pocos datos, aunque estén perfectamente etiquetados, dejan a los modelos subajustados e incapaces de captar la complejidad de patrones reales. Por el contrario, un exceso de datos con problemas de calidad genera desperdicio computacional e inestabilidad en el entrenamiento. El estudio de arxiv revela este equilibrio concretamente: una duplicación mínima mejoró la precisión en un 0,87% con niveles de duplicación del 25%, mientras que una duplicación excesiva al 100% provocó una caída catastrófica del 40% en la precisión. El equilibrio ideal depende de factores como el tipo de algoritmo, la complejidad del problema, los recursos computacionales disponibles y la variabilidad natural en tu dominio objetivo. La distribución de los datos debe reflejar la variabilidad real y no ser artificialmente uniforme, pues esto enseña a los modelos a manejar la variabilidad que encontrarán en producción.

No todos los datos adicionales son iguales: la diferencia entre una aumentación beneficiosa y una degradación perjudicial es crucial para una estrategia de datos eficaz. Las perturbaciones controladas y técnicas de aumentación mejoran la robustez del modelo al enseñar a los algoritmos a manejar variaciones reales como pequeñas rotaciones, cambios de iluminación o ligeras variaciones en las etiquetas. El conjunto MNIST de dígitos manuscritos demuestra este principio: los modelos entrenados con versiones aumentadas (dígitos rotados, escalados o ligeramente distorsionados) generalizan mejor a variaciones reales de escritura que los entrenados solo con imágenes originales. Sin embargo, la corrupción severa (ruido aleatorio, etiquetado sistemático erróneo o inyección de datos irrelevantes) degrada activamente el rendimiento y desperdicia recursos computacionales. La diferencia clave radica en la intencionalidad: la aumentación es diseñada para reflejar variaciones realistas, mientras que los datos basura son ruido indiscriminado que confunde los algoritmos de aprendizaje. Las organizaciones deben distinguir entre estos enfoques al expandir sus conjuntos de datos.

Para organizaciones con recursos limitados, el aprendizaje activo ofrece una solución potente que reduce los requerimientos de datos manteniendo o mejorando el rendimiento del modelo. En lugar de recopilar y etiquetar pasivamente todos los datos disponibles, los algoritmos de aprendizaje activo identifican qué ejemplos sin etiquetar serían más informativos para el modelo, reduciendo drásticamente la carga de anotación humana. Este enfoque permite a las organizaciones lograr un rendimiento sólido del modelo con mucho menos datos etiquetados, enfocando el esfuerzo humano en los ejemplos más impactantes. El aprendizaje activo democratiza el desarrollo de IA al hacerlo accesible para equipos sin grandes presupuestos de etiquetado, permitiéndoles construir modelos efectivos mediante una selección estratégica de datos en vez de volumen masivo. Al aprender eficientemente con menos datos, las organizaciones pueden iterar más rápido, reducir costes y asignar recursos a asegurar la calidad en vez de a una recolección interminable de datos.

La asignación estratégica de recursos requiere priorizar la calidad sobre la cantidad en las decisiones de estrategia de datos. Las organizaciones deben invertir en canalizaciones robustas de validación de datos que detecten errores antes de que entren a los conjuntos de entrenamiento, implementando comprobaciones automáticas de consistencia, integridad y precisión. Las herramientas de perfilado de datos pueden identificar problemas de calidad a gran escala, revelando patrones de etiquetado incorrecto, valores faltantes o ejemplos irrelevantes que deben abordarse antes del entrenamiento. Las implementaciones de aprendizaje activo reducen el volumen de datos que requieren revisión humana, asegurando que los ejemplos revisados sean los más informativos. El monitoreo continuo del rendimiento del modelo en producción revela si los problemas de calidad de los datos de entrenamiento se manifiestan como fallos reales, permitiendo bucles de retroalimentación rápidos para la mejora. La estrategia óptima equilibra la recolección de datos con una rigurosa curación, reconociendo que 1,000 ejemplos perfectamente etiquetados suelen superar a 100,000 ruidosos tanto en rendimiento como en coste total de propiedad.

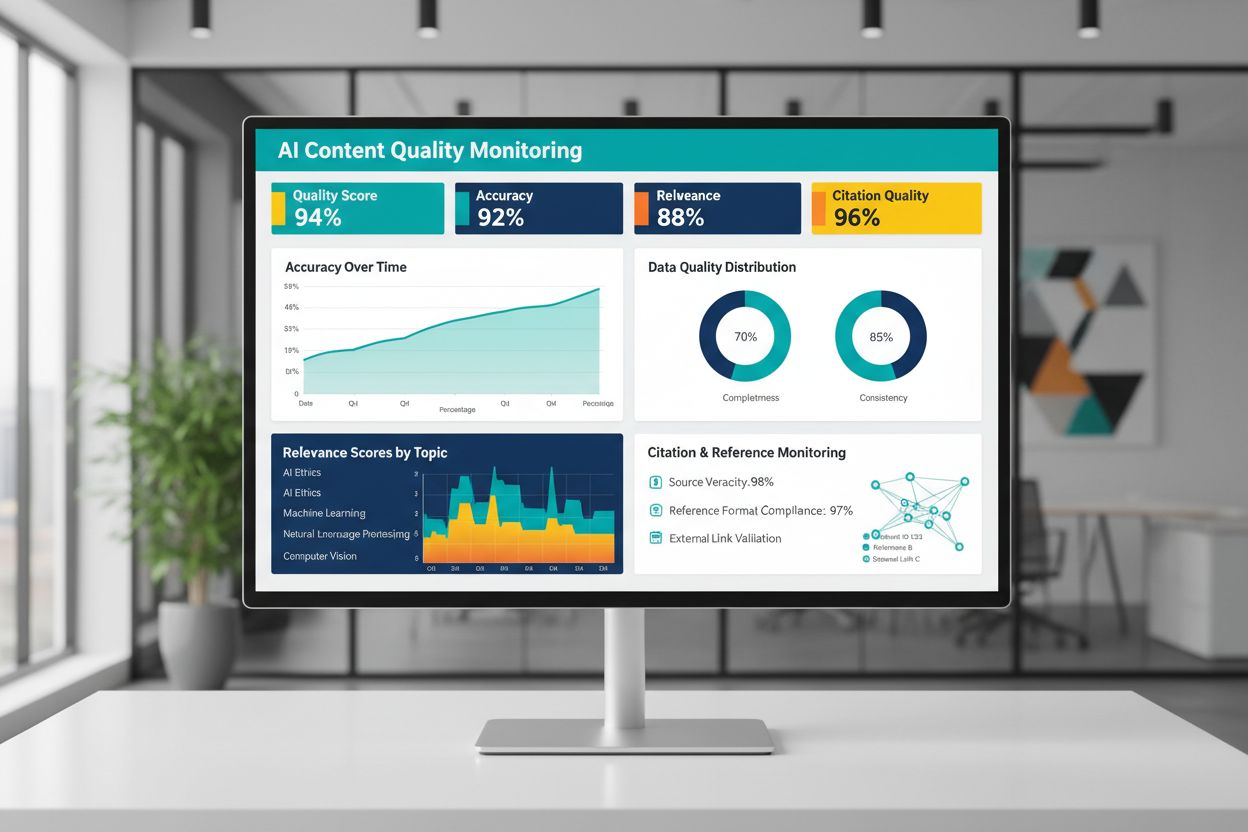

La calidad del contenido generado o entrenado por IA depende fundamentalmente de la calidad de los datos de entrenamiento, lo que hace que el monitoreo continuo de las salidas de IA sea esencial para mantener la fiabilidad. Plataformas como AmICited.com abordan esta necesidad crítica al monitorear las respuestas de IA y rastrear la precisión de las citas, un indicador directo de la calidad y confiabilidad del contenido. Cuando los sistemas de IA se entrenan con datos de baja calidad, con malas citas o información inexacta, sus salidas heredan estos defectos, pudiendo difundir desinformación a escala. Las herramientas de monitoreo deben rastrear no solo métricas de precisión sino también relevancia, consistencia y la presencia de evidencia de respaldo para las afirmaciones hechas por los sistemas de IA. Las organizaciones que implementan IA deben establecer bucles de retroalimentación que identifiquen cuando las salidas se desvían de los estándares de calidad esperados, permitiendo un reentrenamiento rápido o ajuste de los datos subyacentes. La inversión en infraestructura de monitoreo se traduce en beneficios al detectar la degradación de calidad temprano, antes de que impacte a los usuarios o dañe la credibilidad de la organización.

Llevar los principios de calidad de datos a la acción requiere un enfoque estructurado que comienza con la evaluación y progresa hacia la medición y la iteración. Comienza por evaluar tu línea base actual: comprende la calidad existente de tus datos de entrenamiento mediante auditorías y perfilado. Define métricas de calidad claras alineadas con tu caso de uso, ya sean umbrales de precisión, estándares de consistencia o criterios de relevancia. Implementa prácticas de gobernanza de datos que establezcan la propiedad, procedimientos de validación y filtros de calidad antes de que los datos entren a las canalizaciones de entrenamiento. Inicia con conjuntos de datos pequeños y cuidadosamente curados en vez de intentar procesar grandes volúmenes de inmediato, lo que te permite establecer estándares y procesos de calidad a una escala manejable. Mide rigurosamente las mejoras comparando el rendimiento del modelo antes y después de las intervenciones de calidad, creando justificación basada en evidencia para una inversión continua. Escala gradualmente a medida que perfeccionas tus procesos, ampliando la recolección de datos solo después de demostrar que las mejoras de calidad se traducen en ganancias reales de rendimiento.

No. Investigaciones recientes muestran que la calidad de los datos suele importar más que la cantidad. Datos de baja calidad, mal etiquetados o irrelevantes pueden degradar activamente el rendimiento del modelo, incluso a gran escala. La clave es encontrar el equilibrio adecuado entre tener suficientes datos para entrenar eficazmente y mantener altos estándares de calidad.

La calidad de los datos abarca múltiples dimensiones: precisión (etiquetas correctas), consistencia (formateo uniforme), integridad (sin valores faltantes), relevancia (alineación con tu problema), fiabilidad (fuentes confiables) y niveles de ruido. Define métricas específicas para tu caso de uso e implementa validaciones para detectar problemas de calidad antes del entrenamiento.

El tamaño ideal depende de la complejidad de tu algoritmo, el tipo de problema y los recursos disponibles. En lugar de buscar el tamaño máximo, apunta a la 'zona Goldilocks', es decir, suficientes datos para captar patrones reales sin sobrecargarse con ejemplos irrelevantes o redundantes. Comienza con datos curados y escala gradualmente según las mejoras en el rendimiento.

La aumentación de datos aplica perturbaciones controladas (rotaciones, pequeñas distorsiones, variaciones de iluminación) que conservan la etiqueta verdadera mientras enseñan a los modelos a manejar variabilidad real. Esto difiere de los datos basura: la aumentación es intencional y refleja variaciones realistas, haciendo que los modelos sean más robustos en condiciones de despliegue.

El aprendizaje activo identifica qué ejemplos no etiquetados serían más informativos para que el modelo aprenda, reduciendo drásticamente la carga de anotación. En vez de etiquetar todos los datos disponibles, enfocas el esfuerzo humano en los ejemplos más impactantes, logrando un buen rendimiento con mucho menos datos etiquetados.

Prioriza la calidad sobre la cantidad. Invierte en canalizaciones de validación de datos, herramientas de perfilado y procesos de gobernanza que aseguren datos de entrenamiento de alta calidad. La investigación muestra que 1,000 ejemplos perfectamente etiquetados suelen superar a 100,000 ruidosos tanto en rendimiento del modelo como en coste total de propiedad.

Los datos de baja calidad generan múltiples costes: reentrenamiento del modelo, depuración, fallos en despliegue, sobrecostes de almacenamiento y desperdicio computacional. En dominios críticos como la imagen médica, los datos de entrenamiento de baja calidad pueden dar lugar a errores peligrosos. La falsa economía de los datos baratos se hace evidente al considerar estos costes ocultos.

Implementa monitoreo continuo de las salidas de IA rastreando precisión, relevancia, consistencia y calidad de las citas. Plataformas como AmICited monitorean cómo los sistemas de IA referencian la información y rastrean la precisión de las citas. Establece bucles de retroalimentación que conecten el rendimiento en producción con la calidad de los datos de entrenamiento para una mejora rápida.

Supervisa cómo los sistemas de IA hacen referencia a tu marca y asegura la precisión del contenido con la plataforma de monitoreo de IA de AmICited. Comprende la calidad de las respuestas generadas por IA sobre tu negocio.

Descubre por qué el tráfico de IA convierte 23 veces mejor que la búsqueda orgánica. Aprende a optimizar para plataformas de IA y medir el verdadero ROI de los ...

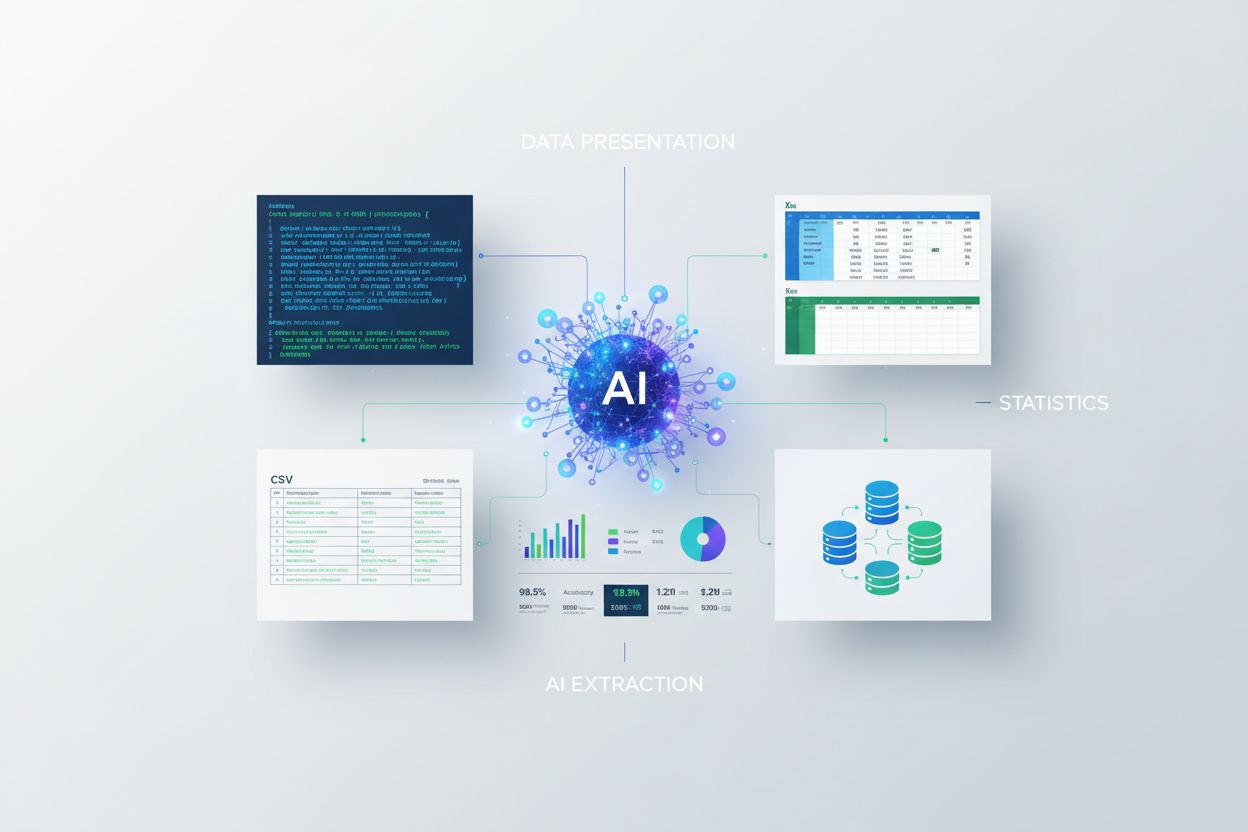

Aprende a presentar estadísticas para la extracción por IA. Descubre las mejores prácticas para el formateo de datos, JSON vs CSV y cómo asegurar que tus datos ...

Aprende cómo crear investigaciones originales y contenido de PR basado en datos que los sistemas de IA citan activamente. Descubre los 5 atributos del contenido...